Saat mengevaluasi model, metrik yang dihitung terhadap seluruh pengujian atau validasi tidak selalu memberikan gambaran akurat tentang seberapa adil model tersebut. Performa model yang baik secara keseluruhan untuk sebagian besar contoh dapat menyamarkan performa pada sebagian kecil contoh, yang dapat mengakibatkan bias terhadap prediksi model. Menggunakan metrik performa gabungan seperti presisi, penarikan, dan akurasi belum tentu sesuai untuk mengungkap masalah ini.

Kita dapat membuka kembali model tiket masuk dan mempelajari beberapa teknik baru untuk mengevaluasi prediksinya terhadap bias, dengan mempertimbangkan keadilan.

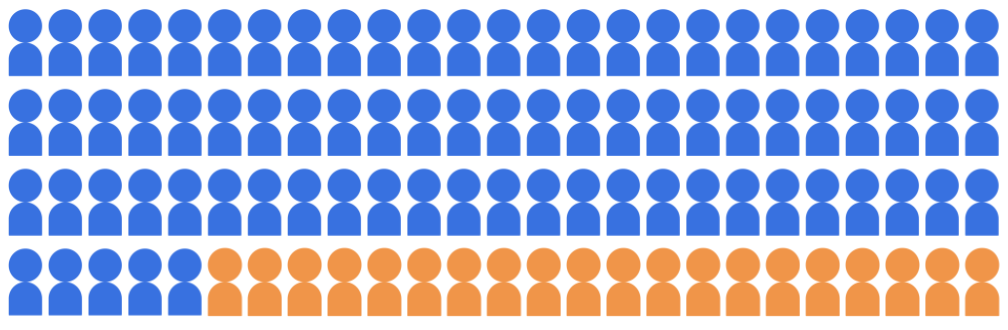

Misalkan model klasifikasi penerimaan memilih 20 siswa yang akan diterima universitas yang terdiri dari 100 kandidat, yang termasuk dalam dua kelompok demografis: kelompok mayoritas (biru, 80 siswa) dan kelompok minoritas (oranye, 20 siswa).

Model harus menerima siswa yang memenuhi syarat dengan cara yang adil terhadap di kedua kelompok demografis.

Bagaimana cara mengevaluasi prediksi model terkait keadilan? Ada berbagai metrik yang dapat kita pertimbangkan, yang masing-masing memberikan definisi "keadilan". Di bagian berikut ini, kita akan mempelajari tiga dari metrik keadilan ini secara mendalam: paritas demografis, kesetaraan kesempatan, dan keadilan kontrafaktual.