Rastgele ormanlar

Rastgele orman (RF), her karar ağacının belirli bir rastgele gürültüyle eğitildiği bir karar ağacı topluluğudur. Rastgele ormanlar, karar ağacı topluluğunun en popüler biçimidir. Bu birimde, etkili bir rastgele orman oluşturma olasılığını artırmak için bağımsız karar ağaçları oluşturmaya yönelik çeşitli teknikler ele alınmaktadır.

Torba

Bagging (bootstrap aggregating), her karar ağacını eğitim veri kümesindeki örneklerin rastgele bir alt kümesinde eğitmek anlamına gelir. Diğer bir deyişle, rastgele ormandaki her karar ağacı, örneklerin farklı bir alt kümesinde eğitilir.

Çanta taşımak tuhaf. Her karar ağacı, orijinal eğitim veri kümesinde olduğu gibi aynı sayıda örnekle eğitilir. Örneğin, orijinal eğitim veri kümesi 60 örnek içeriyorsa her karar ağacı 60 örnek üzerinde eğitilir. Ancak torba oluşturma, her karar ağacını yalnızca bu örneklerin bir alt kümesinde (genellikle %67'sinde) eğitir. Bu nedenle, belirli bir karar ağacını eğitirken alt kümedeki 40 örnekten bazıları yeniden kullanılmalıdır. Bu yeniden kullanıma "yerine koyma ile eğitim" adı verilir.

Örneğin, Tablo 6'da, torbalama işleminin altı örneği üç karar ağacına nasıl dağıtabileceği gösterilmektedir. Aşağıdakilere dikkat edin:

- Her karar ağacı toplam altı örnekle eğitilir.

- Her karar ağacı farklı bir örnek grubuyla eğitilir.

- Her karar ağacı belirli örnekleri yeniden kullanır. Örneğin, 4. örnek, 1. karar ağacını eğitirken iki kez kullanılır. Bu nedenle, 4. örneğin öğrenilmiş ağırlığı 1. karar ağacında etkili bir şekilde iki katına çıkar.

Tablo 6. Üç karar ağacında altı eğitim örneğini paketleme. Her sayı, belirli bir eğitim örneğinin (#1-6) belirli bir karar ağacının eğitim veri kümesindeki tekrar sayısını (1-3) gösterir.

| eğitim örnekleri | ||||||

|---|---|---|---|---|---|---|

| #1 | #2 | #3 | #4 | #5 | #6 | |

| orijinal veri kümesi | 1 | 1 | 1 | 1 | 1 | 1 |

| karar ağacı 1 | 1 | 1 | 0 | 2 | 1 | 1 |

| karar ağacı 2 | 3 | 0 | 1 | 0 | 2 | 0 |

| karar ağacı 3 | 0 | 1 | 3 | 1 | 0 | 1 |

Torbalamada her karar ağacı neredeyse her zaman orijinal eğitim veri kümesindeki toplam örnek sayısıyla eğitilir. Her karar ağacını daha fazla veya daha az örnekle eğitmek, rastgele ormanın kalitesini düşürür.

Orijinal rastgele orman makalesinde yer almamasına rağmen, örneklerin örneklenmesi bazen "yer değiştirmeden" yapılır. Yani bir eğitim örneği, karar ağacı eğitim veri kümesinde birden fazla kez bulunamaz. Örneğin, önceki tabloda tüm değerler 0 veya 1 olur.

bootstrap_training_dataset=False

Özellik örnekleme

Özellik örnekleme, mevcut tüm özellikler için en iyi koşulu aramak yerine her düğümde yalnızca rastgele bir özellik alt kümesinin test edilmesi anlamına gelir. Test edilen özellik grubu, karar ağacının her düğümünde rastgele örneklenir.

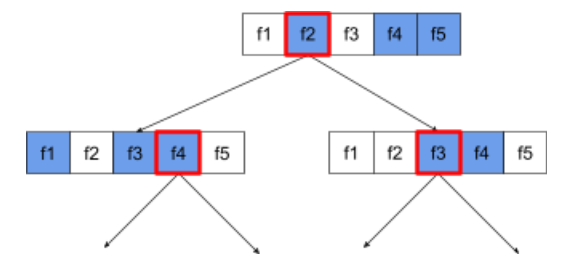

Aşağıdaki karar ağacı, özellik / özellik örneklemeyi göstermektedir. Burada bir karar ağacı 5 özellik (f1-f5) üzerinde eğitilmektedir. Mavi düğümler test edilen özellikleri, beyaz düğümler ise test edilmeyen özellikleri temsil eder. Koşul, en iyi test edilen özelliklerden (kırmızı bir dış çizgiyle gösterilir) oluşur.

Şekil 21. Özellik örnekleme.

Özellik örnekleme oranı, önemli bir normalleştirme hiper parametresidir. Önceki Şekilde yaklaşık ⅗ oranı kullanılmıştır. Birçok rastgele orman uygulaması, varsayılan olarak regresyon için özelliklerin 1/3'ünü ve sınıflandırma için sqrt(özellik sayısı) değerini test eder.

TF-DF'de aşağıdaki hiper parametreler özellik örneklemeyi kontrol eder:

num_candidate_attributesnum_candidate_attributes_ratio

Örneğin, num_candidate_attributes_ratio=0.5 ise özelliklerin yarısı her düğümde test edilir.

Karar ağacı normalleştirmesini devre dışı bırakma

Rastgele ormandaki bireysel karar ağaçları budama olmadan eğitilir. (Aşırı uyum ve budama bölümüne bakın.) Bu, tahmin kalitesi düşük, aşırı karmaşık ağaçlar oluşturur. Ağaçlar tek tek normalleştirilmek yerine bir araya getirilerek daha doğru genel tahminler elde edilir.

Rastgele ormanın eğitim ve test doğruluğunun farklı olmasını bekleyebiliriz. Rastgele ormanın eğitim doğruluğu genellikle çok daha yüksektir (bazen %100'e eşittir). Ancak rastgele ormanda çok yüksek bir eğitim doğruluğu normaldir ve rastgele ormanın aşırı uyum sağladığını göstermez.

İki rastgelelik kaynağı (topraklama ve özellik örnekleme), karar ağaçları arasında göreceli bağımsızlık sağlar. Bu bağımsızlık, bağımsız karar ağaçlarının aşırı uyumunu düzeltir. Sonuç olarak, topluluk aşırı uyumlu değildir. Bu sezgisel olmayan etkiyi bir sonraki birimde açıklayacağız.

Saf rastgele ormanlar, maksimum derinlik veya yaprak başına minimum gözlem sayısı olmadan eğitilir. Uygulamada, maksimum derinliği ve yaprak başına minimum gözlem sayısını sınırlamak faydalıdır. Varsayılan olarak birçok rastgele orman aşağıdaki varsayılanları kullanır:

- Maksimum derinlik: yaklaşık 16

- Yaprak başına minimum gözlem sayısı yaklaşık 5 olmalıdır.

Bu hiper parametreleri ayarlayabilirsiniz.

Gürültünün netliği

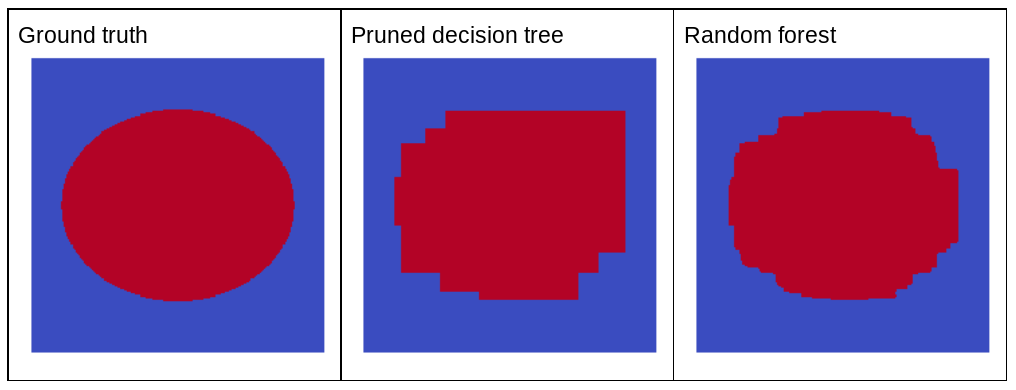

Rastgele gürültü neden rastgele bir ormanın kalitesini iyileştirir? Şekil 22'de, rastgele gürültünün avantajlarını göstermek için elips desenli birkaç basit iki boyutlu problem örneği üzerinde eğitilmiş klasik (budanmış) bir karar ağacının ve rastgele bir ormanın tahminleri gösterilmektedir.

Elips kalıpları, karar ağacı ve karar ormanı algoritmalarının eksenle hizalanmış koşullarla öğrenmesi zor olduğu bilinen bir durumdur. Bu nedenle, iyi bir örnektir. Budanmış karar ağacının, rastgele ormanla aynı kalitede tahmin sağlayamadığını unutmayın.

Şekil 22. Kesin referans, tek bir budanmış karar ağacı tarafından oluşturulan tahminler ve rastgele orman tarafından oluşturulan tahminler.

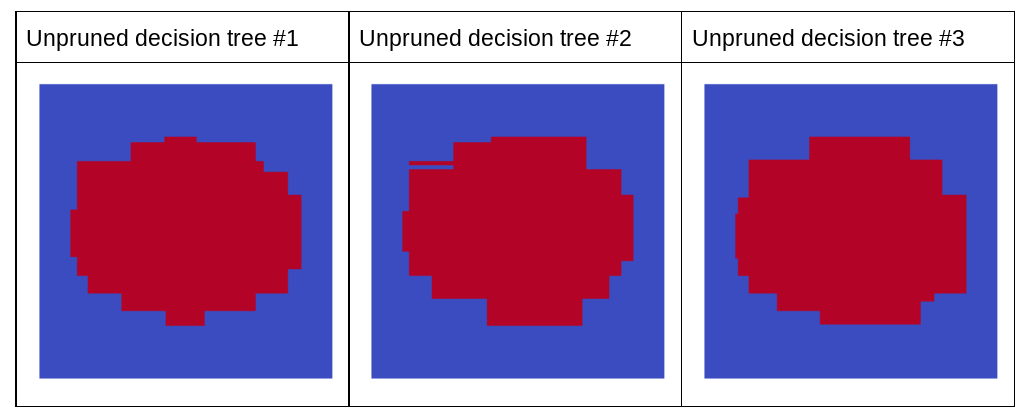

Sonraki grafikte, rastgele ormanın ilk üç budanmamış karar ağacının tahminleri gösterilmektedir. Yani karar ağaçlarının tümü aşağıdakilerin bir kombinasyonuyla eğitilmiştir:

- paketleme

- özellik örnekleme

- budamayı devre dışı bırakma

Bu üç karar ağacının ayrı ayrı tahminlerinin, önceki görselde gösterilen budanmış karar ağacının tahminlerinden daha kötü olduğunu fark edin. Ancak bağımsız karar ağaçlarının hataları yalnızca zayıf bir şekilde ilişkili olduğundan, üç karar ağacı etkili tahminler oluşturmak için bir toplulukta birleştirilir.

Şekil 23. Etkili bir topluluk oluşturacak üç budanmamış karar ağacı.

Rastgele ormanın karar ağaçları budanmadığı için rastgele orman eğitimi için doğrulama veri kümesi gerekmez. Pratikte, özellikle küçük veri kümelerinde modeller mevcut tüm verilerle eğitilmelidir.

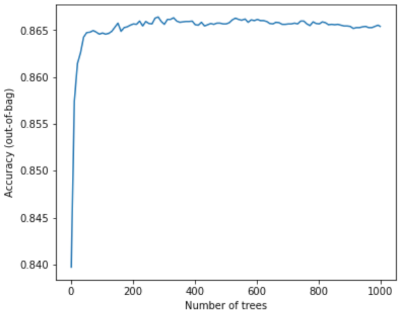

Rastgele orman eğitilirken daha fazla karar ağacı eklendikçe hata neredeyse her zaman azalır. Yani modelin kalitesi neredeyse her zaman artar. Evet, daha fazla karar ağacı eklemek neredeyse her zaman rastgele ormanın hatasını azaltır. Diğer bir deyişle, daha fazla karar ağacı eklemek rastgele ormanın aşırı uyum sağlamasına neden olmaz. Bir noktada modelin iyileşmesi durur. Leo Breiman'ın "Daha fazla ağaç eklendikçe rastgele ormanlar aşırı uyum sağlamaz" sözü meşhurdur.

Örneğin, aşağıdaki grafikte daha fazla karar ağacı eklendikçe rastgele orman modelinin test değerlendirmesi gösterilmektedir. Doğruluk, 0,865 civarında sabitlenene kadar hızla artar. Ancak daha fazla karar ağacı eklemek doğruluğu düşürmez. Diğer bir deyişle, model aşırı uyum sağlamaz. Bu davranış (genellikle) her zaman doğrudur ve hiper parametrelerden bağımsızdır.

Şekil 24. Rastgele ormana daha fazla karar ağacı eklendikçe doğruluk sabit kalır.