Explorar no Dialogflow

Clique em Continue para importar a amostra "Responses" para o Dialogflow. Depois, siga as etapas abaixo para implantar e testar a amostra:

- Digite um nome de agente e crie um novo agente do Dialogflow para a amostra.

- Depois que a importação do agente terminar, clique em Go to agent.

- No menu de navegação principal, acesse Fulfillment.

- Ative o Editor in-line e clique em Implantar. O editor contém a amostra o código-fonte.

- No menu de navegação principal, acesse Integrações e clique em Google Google Assistente.

- Na janela modal exibida, ative a opção Mudanças na visualização automática e clique em Testar. para abrir o simulador do Actions.

- No simulador, insira

Talk to my test apppara testar a amostra.

Use uma resposta avançada se quiser mostrar elementos visuais para melhorar interações com sua ação. Esses elementos visuais podem dar dicas para continuar a conversa.

Respostas avançadas podem aparecer em experiências somente de tela ou de áudio e tela. Eles pode conter os seguintes componentes:

- Uma ou duas respostas simples (balões de chat).

- Um card básico opcional.

- Ícones de sugestão opcionais.

- Um ícone de link externo opcional.

Confira também nossas diretrizes de criação de conversas para saber mais como incorporar esses elementos visuais à sua ação.

Propriedades

As respostas completas têm os seguintes requisitos e opções que você pode configurar:

- Compatível com plataformas com o recurso

actions.capability.SCREEN_OUTPUT. - O primeiro item em uma resposta detalhada precisa ser uma resposta simples.

- No máximo, duas respostas simples.

- No máximo um cartão básico ou

StructuredResponse. - No máximo 8 ícones de sugestão.

- Não é permitido usar ícones de sugestão em um

FinalResponse. - No momento, não é possível criar links para a Web usando smart displays.

As seções a seguir mostram como criar vários tipos de respostas avançadas.

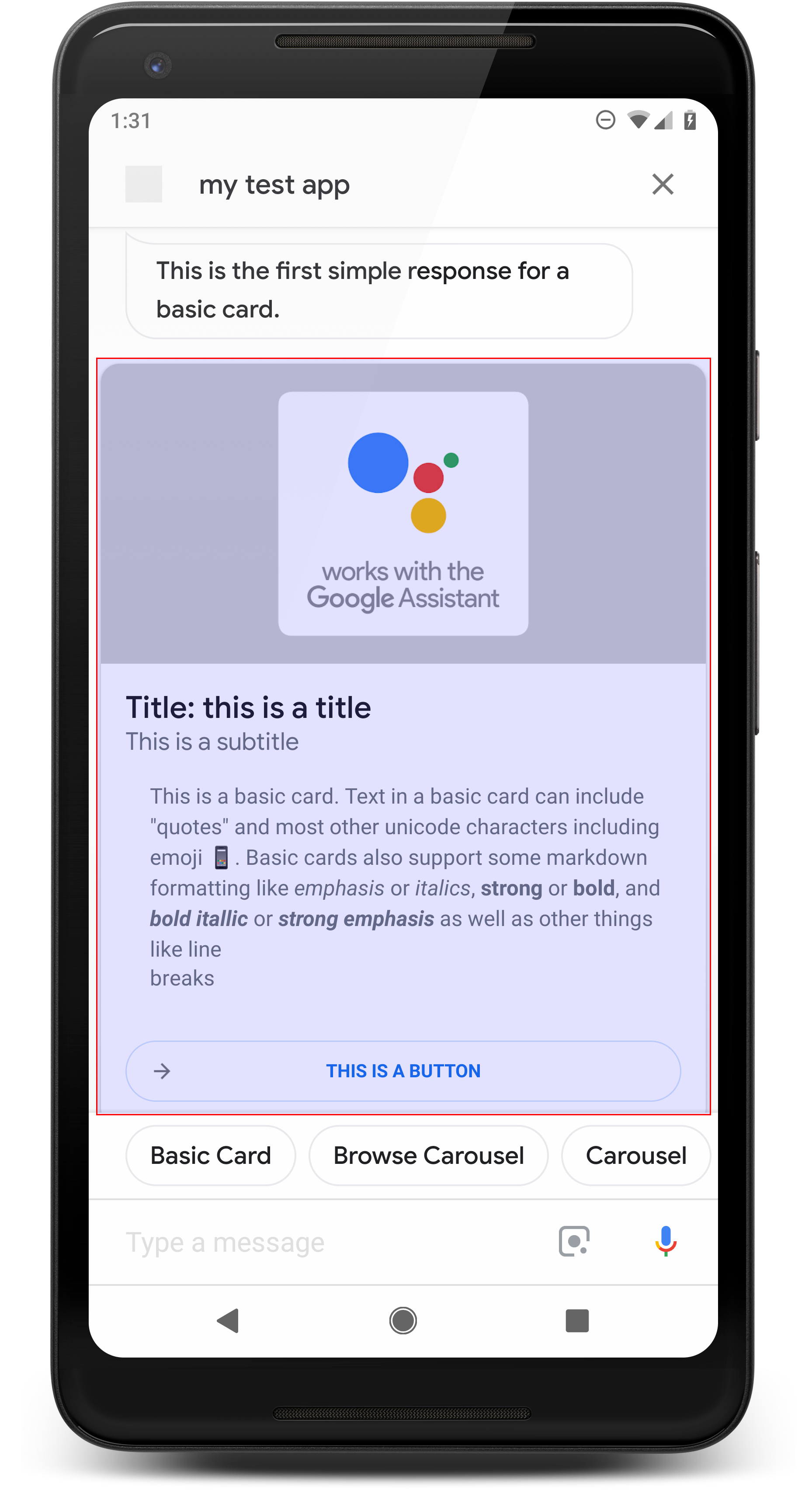

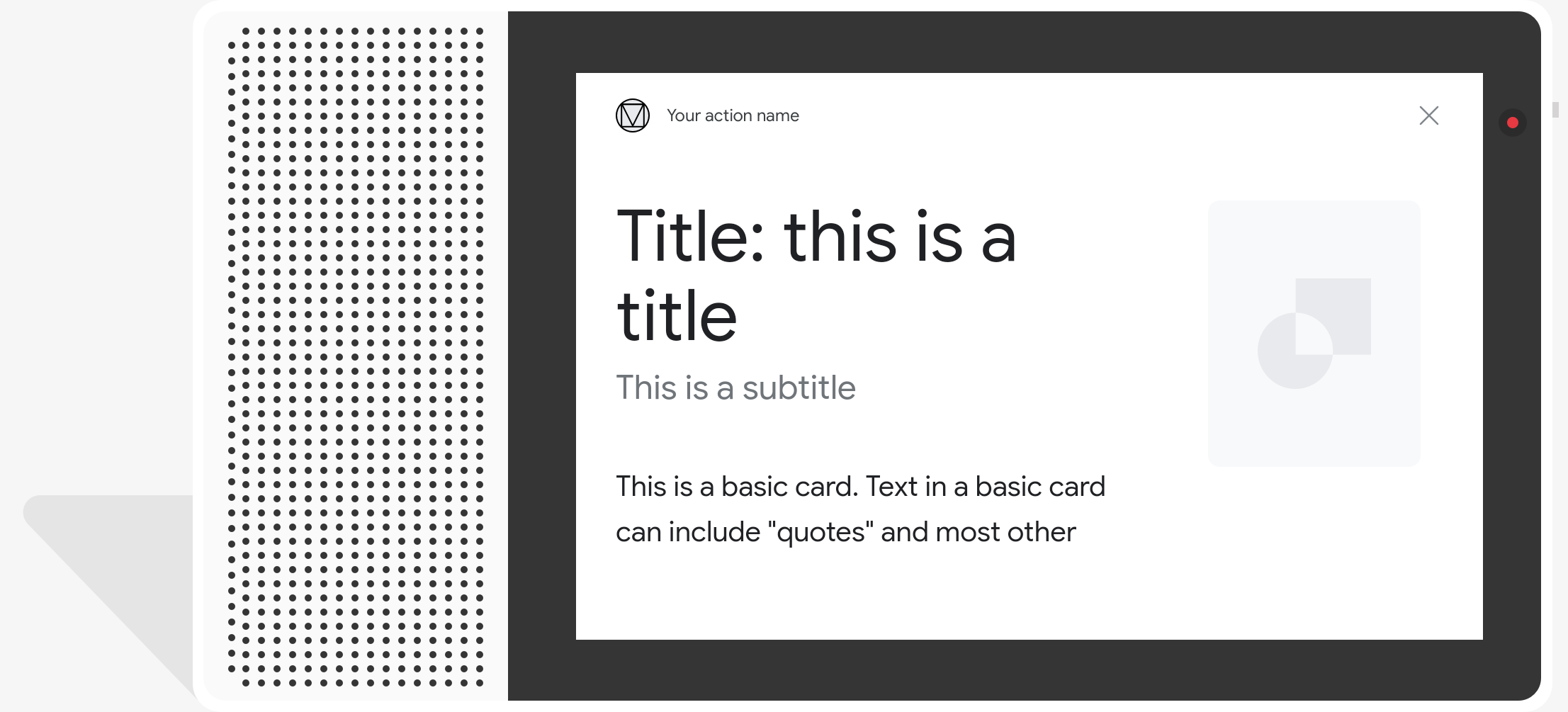

Cartão básico

.

Um card básico exibe informações que podem incluir o seguinte:

- Imagem

- Título

- Subtítulo

- Corpo do texto

- Botão "Vincular"

- Borda

Use cards básicos principalmente para fins de exibição. Eles são projetados para ser concisos, apresentar informações importantes (ou resumidas) aos usuários e permitir que eles aprendam mais se você quiser (usando um link da Web).

Na maioria das situações, você precisa adicionar os ícones de sugestão abaixo para continuar ou alternar a conversa.

Evite repetir as informações apresentadas no card no balão de chat. custos.

Propriedades

O tipo de resposta básico de cartão tem os seguintes requisitos e opções que você pode configurar:

- Compatível com plataformas com o recurso

actions.capability.SCREEN_OUTPUT. - Texto formatado (obrigatório se não houver uma imagem)

- Texto simples por padrão.

- Não pode conter um link.

- Limite de 10 linhas com uma imagem e de 15 linhas sem uma imagem. Trata-se de 500 (com imagem) ou 750 (sem imagem). Smartphones com tela menor também truncam o texto mais cedo do que celulares com telas maiores. Se o texto contiver muito muitas linhas, é truncado na última quebra de palavra com reticências.

- Um subconjunto limitado de markdown é compatível:

- Nova linha com um espaço duplo seguido por \n

**bold***italics*

- Imagem (obrigatória se não houver texto formatado)

- Todas as imagens precisam ter 192 dp de altura.

- Se a proporção da imagem for diferente da tela, a imagem será centralizada com barras cinza nas bordas vertical ou horizontal.

- A origem da imagem é um URL.

- GIFs com movimento são permitidos.

Opcional

- Título

- Texto simples.

- Fonte e tamanho fixos.

- No máximo uma linha; caracteres extras ficam truncados.

- A altura do card será recolhida se nenhum título for especificado.

- Subtítulo

- Texto simples.

- Fonte e tamanho da fonte corrigidos.

- No máximo uma linha; caracteres extras ficam truncados.

- A altura do card será recolhida se nenhuma legenda for especificada.

- Botão de link

- O título do link é obrigatório

- No máximo um link

- Links para sites fora do domínio do desenvolvedor são permitidos.

- O texto do link não pode ser enganoso. Isso é verificado no processo de aprovação.

- Um card básico não pode ser usado para interagir sem um link. Tocando em o link direciona o usuário para o link, enquanto o corpo principal do card permanece inativo.

- Borda

- A borda entre o card e o contêiner da imagem pode ser ajustada para personalizar a apresentação do seu card básico.

- Configurado pela definição da propriedade de string JSON

imageDisplayOptions

Código de amostra

Node.js

app.intent('Basic Card', (conv) => { if (!conv.screen) { conv.ask('Sorry, try this on a screen device or select the ' + 'phone surface in the simulator.'); conv.ask('Which response would you like to see next?'); return; } conv.ask(`Here's an example of a basic card.`); conv.ask(new BasicCard({ text: `This is a basic card. Text in a basic card can include "quotes" and most other unicode characters including emojis. Basic cards also support some markdown formatting like *emphasis* or _italics_, **strong** or __bold__, and ***bold itallic*** or ___strong emphasis___ as well as other things like line \nbreaks`, // Note the two spaces before '\n' required for // a line break to be rendered in the card. subtitle: 'This is a subtitle', title: 'Title: this is a title', buttons: new Button({ title: 'This is a button', url: 'https://assistant.google.com/', }), image: new Image({ url: 'https://storage.googleapis.com/actionsresources/logo_assistant_2x_64dp.png', alt: 'Image alternate text', }), display: 'CROPPED', })); conv.ask('Which response would you like to see next?'); });

Java

@ForIntent("Basic Card") public ActionResponse basicCard(ActionRequest request) { ResponseBuilder responseBuilder = getResponseBuilder(request); if (!request.hasCapability(Capability.SCREEN_OUTPUT.getValue())) { return responseBuilder .add("Sorry, try ths on a screen device or select the phone surface in the simulator.") .add("Which response would you like to see next?") .build(); } // Prepare formatted text for card String text = "This is a basic card. Text in a basic card can include \"quotes\" and\n" + " most other unicode characters including emoji \uD83D\uDCF1. Basic cards also support\n" + " some markdown formatting like *emphasis* or _italics_, **strong** or\n" + " __bold__, and ***bold itallic*** or ___strong emphasis___ as well as other\n" + " things like line \\nbreaks"; // Note the two spaces before '\n' required for // a line break to be rendered in the card. responseBuilder .add("Here's an example of a basic card.") .add( new BasicCard() .setTitle("Title: this is a title") .setSubtitle("This is a subtitle") .setFormattedText(text) .setImage( new Image() .setUrl( "https://storage.googleapis.com/actionsresources/logo_assistant_2x_64dp.png") .setAccessibilityText("Image alternate text")) .setImageDisplayOptions("CROPPED") .setButtons( new ArrayList<Button>( Arrays.asList( new Button() .setTitle("This is a Button") .setOpenUrlAction( new OpenUrlAction().setUrl("https://assistant.google.com")))))) .add("Which response would you like to see next?"); return responseBuilder.build(); }

Node.js

if (!conv.screen) { conv.ask('Sorry, try this on a screen device or select the ' + 'phone surface in the simulator.'); conv.ask('Which response would you like to see next?'); return; } conv.ask(`Here's an example of a basic card.`); conv.ask(new BasicCard({ text: `This is a basic card. Text in a basic card can include "quotes" and most other unicode characters including emojis. Basic cards also support some markdown formatting like *emphasis* or _italics_, **strong** or __bold__, and ***bold itallic*** or ___strong emphasis___ as well as other things like line \nbreaks`, // Note the two spaces before '\n' required for // a line break to be rendered in the card. subtitle: 'This is a subtitle', title: 'Title: this is a title', buttons: new Button({ title: 'This is a button', url: 'https://assistant.google.com/', }), image: new Image({ url: 'https://storage.googleapis.com/actionsresources/logo_assistant_2x_64dp.png', alt: 'Image alternate text', }), display: 'CROPPED', })); conv.ask('Which response would you like to see next?');

Java

ResponseBuilder responseBuilder = getResponseBuilder(request); if (!request.hasCapability(Capability.SCREEN_OUTPUT.getValue())) { return responseBuilder .add("Sorry, try ths on a screen device or select the phone surface in the simulator.") .add("Which response would you like to see next?") .build(); } // Prepare formatted text for card String text = "This is a basic card. Text in a basic card can include \"quotes\" and\n" + " most other unicode characters including emoji \uD83D\uDCF1. Basic cards also support\n" + " some markdown formatting like *emphasis* or _italics_, **strong** or\n" + " __bold__, and ***bold itallic*** or ___strong emphasis___ as well as other\n" + " things like line \\nbreaks"; // Note the two spaces before '\n' required for // a line break to be rendered in the card. responseBuilder .add("Here's an example of a basic card.") .add( new BasicCard() .setTitle("Title: this is a title") .setSubtitle("This is a subtitle") .setFormattedText(text) .setImage( new Image() .setUrl( "https://storage.googleapis.com/actionsresources/logo_assistant_2x_64dp.png") .setAccessibilityText("Image alternate text")) .setImageDisplayOptions("CROPPED") .setButtons( new ArrayList<Button>( Arrays.asList( new Button() .setTitle("This is a Button") .setOpenUrlAction( new OpenUrlAction().setUrl("https://assistant.google.com")))))) .add("Which response would you like to see next?"); return responseBuilder.build();

JSON

O JSON abaixo descreve uma resposta do webhook.

{ "payload": { "google": { "expectUserResponse": true, "richResponse": { "items": [ { "simpleResponse": { "textToSpeech": "Here's an example of a basic card." } }, { "basicCard": { "title": "Title: this is a title", "subtitle": "This is a subtitle", "formattedText": "This is a basic card. Text in a basic card can include \"quotes\" and\n most other unicode characters including emojis. Basic cards also support\n some markdown formatting like *emphasis* or _italics_, **strong** or\n __bold__, and ***bold itallic*** or ___strong emphasis___ as well as other\n things like line \nbreaks", "image": { "url": "https://storage.googleapis.com/actionsresources/logo_assistant_2x_64dp.png", "accessibilityText": "Image alternate text" }, "buttons": [ { "title": "This is a button", "openUrlAction": { "url": "https://assistant.google.com/" } } ], "imageDisplayOptions": "CROPPED" } }, { "simpleResponse": { "textToSpeech": "Which response would you like to see next?" } } ] } } } }

JSON

O JSON abaixo descreve uma resposta do webhook.

{ "expectUserResponse": true, "expectedInputs": [ { "possibleIntents": [ { "intent": "actions.intent.TEXT" } ], "inputPrompt": { "richInitialPrompt": { "items": [ { "simpleResponse": { "textToSpeech": "Here's an example of a basic card." } }, { "basicCard": { "title": "Title: this is a title", "subtitle": "This is a subtitle", "formattedText": "This is a basic card. Text in a basic card can include \"quotes\" and\n most other unicode characters including emojis. Basic cards also support\n some markdown formatting like *emphasis* or _italics_, **strong** or\n __bold__, and ***bold itallic*** or ___strong emphasis___ as well as other\n things like line \nbreaks", "image": { "url": "https://storage.googleapis.com/actionsresources/logo_assistant_2x_64dp.png", "accessibilityText": "Image alternate text" }, "buttons": [ { "title": "This is a button", "openUrlAction": { "url": "https://assistant.google.com/" } } ], "imageDisplayOptions": "CROPPED" } }, { "simpleResponse": { "textToSpeech": "Which response would you like to see next?" } } ] } } } ] }

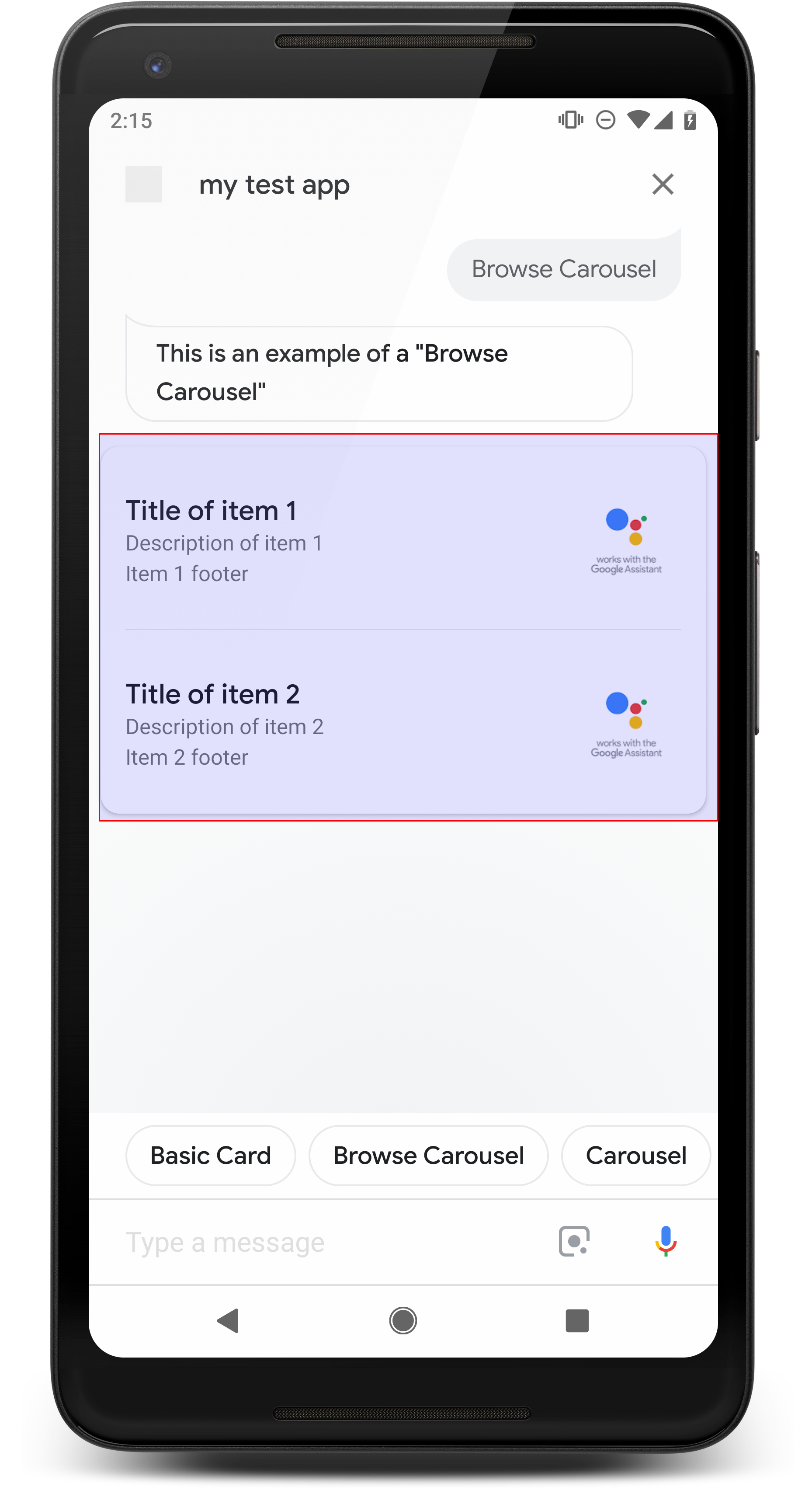

Carrossel de navegação

.

Um carrossel de navegação é uma resposta avançada que permite aos usuários rolar a tela verticalmente e selecione um bloco em uma coleção. Os carrosséis de navegação são projetados especificamente para conteúdo da Web abrindo o bloco selecionado em um navegador da Web (ou um navegador AMP) se todos os blocos forem compatíveis com AMP). O carrossel de navegação também persiste no Google Assistente do usuário para navegar mais tarde.

Propriedades

O tipo de resposta do carrossel de navegação tem os seguintes requisitos e que você pode configurar:

- Disponível em plataformas que têm

actions.capability.SCREEN_OUTPUTe recursos doactions.capability.WEB_BROWSER. Este tipo de resposta é não está disponível em smart displays no momento. - Carrossel de navegação

- Máximo de dez blocos.

- Mínimo de dois blocos.

- Todos os blocos no carrossel precisam estar vinculados ao conteúdo da Web (conteúdo AMP

recomendado).

- Para que o usuário seja direcionado a um visualizador de AMP, o

urlHintTypeem blocos de conteúdo AMP precisam ser definidos como "AMP_CONTENT".

- Para que o usuário seja direcionado a um visualizador de AMP, o

- Navegação pelos blocos de carrossel

- Consistência do bloco (obrigatório):

- Todos os blocos em um carrossel de navegação precisam ter os mesmos componentes. Por exemplo, se um bloco tem um campo de imagem, o restante dos blocos no carrossel também devem ter campos de imagem.

- Se todos os blocos no carrossel de navegação estiverem vinculados a conteúdo compatível com AMP, o usuário é direcionado para um navegador AMP com funcionalidade adicional. Se algum bloco direcionar para conteúdo não AMP, todos os blocos vão direcionar os usuários a um navegador da Web.

- Imagem (opcional)

- A imagem precisa ter 128 dp de altura x 232 dp de largura.

- Se a proporção da imagem não corresponder à caixa delimitadora da imagem, ela é centralizada com barras em ambos os lados. Em smartphones, a imagem é centralizada em um quadrado com cantos arredondados.

- Se um link de imagem estiver corrompido, uma imagem de marcador será usada.

- A imagem precisa ter texto alternativo.

- Título (obrigatório)

- As mesmas opções de formatação do cartão de texto básico.

- Os títulos precisam ser exclusivos para oferecer suporte à seleção de voz.

- Máximo de duas linhas de texto.

- Tamanho da fonte: 16 sp.

- Descrição (opcional)

- As mesmas opções de formatação do cartão de texto básico.

- Máximo de quatro linhas de texto.

- Truncada com reticências (...)

- Tamanho da fonte 14 sp, cor cinza.

- Rodapé (opcional)

- Fonte e tamanho da fonte corrigidos.

- Use no máximo uma linha de texto.

- Truncada com reticências (...)

- Ancorados na parte inferior, os blocos com menos linhas de corpo de texto podem espaço em branco acima do subtexto.

- Tamanho da fonte 14 sp, cor cinza.

- Consistência do bloco (obrigatório):

- Interação

- O usuário pode rolar verticalmente para visualizar itens.

- Tocar no cartão: tocar em um item leva o usuário a um navegador, exibindo o página vinculada.

- Entrada de texto por voz

- Comportamento do microfone

- O microfone não reabre quando um carrossel de navegação é enviado ao usuário.

- O usuário ainda pode tocar no microfone ou invocar o Google Assistente ("Ok Google"). para reabrir o microfone.

- Comportamento do microfone

Orientação

Por padrão, o microfone permanece fechado depois que um carrossel de navegação é enviado. Se você quiser para continuar a conversa depois, recomendamos adicionar os ícones de sugestão abaixo do carrossel.

Nunca repita as opções apresentadas na lista como ícones de sugestão. Ícones na entrada esse contexto são usados para dinamizar a conversa (não para a seleção de escolha).

Assim como as listas, o balão do chat que acompanha o cartão do carrossel é um subconjunto do áudio (TTS/SSML). O áudio (TTS/SSML) aqui integra a primeira bloco do carrossel, e também desencorajamos fortemente a leitura de todos os elementos do carrossel. É melhor mencionar o primeiro item e o motivo ele está lá (por exemplo, o mais popular, o que foi comprado mais recentemente, o que mencionamos).

Código de amostra

Node.js

app.intent('Browsing Carousel', (conv) => { if (!conv.screen || !conv.surface.capabilities.has('actions.capability.WEB_BROWSER')) { conv.ask('Sorry, try this on a phone or select the ' + 'phone surface in the simulator.'); conv.ask('Which response would you like to see next?'); return; } conv.ask(`Here's an example of a browsing carousel.`); conv.ask(new BrowseCarousel({ items: [ new BrowseCarouselItem({ title: 'Title of item 1', url: 'https://example.com', description: 'Description of item 1', image: new Image({ url: 'https://storage.googleapis.com/actionsresources/logo_assistant_2x_64dp.png', alt: 'Image alternate text', }), footer: 'Item 1 footer', }), new BrowseCarouselItem({ title: 'Title of item 2', url: 'https://example.com', description: 'Description of item 2', image: new Image({ url: 'https://storage.googleapis.com/actionsresources/logo_assistant_2x_64dp.png', alt: 'Image alternate text', }), footer: 'Item 2 footer', }), ], })); });

Java

@ForIntent("Browsing Carousel") public ActionResponse browseCarousel(ActionRequest request) { ResponseBuilder responseBuilder = getResponseBuilder(request); if (!request.hasCapability(Capability.SCREEN_OUTPUT.getValue()) || !request.hasCapability(Capability.WEB_BROWSER.getValue())) { return responseBuilder .add("Sorry, try this on a phone or select the phone surface in the simulator.") .add("Which response would you like to see next?") .build(); } responseBuilder .add("Here's an example of a browsing carousel.") .add( new CarouselBrowse() .setItems( new ArrayList<CarouselBrowseItem>( Arrays.asList( new CarouselBrowseItem() .setTitle("Title of item 1") .setDescription("Description of item 1") .setOpenUrlAction(new OpenUrlAction().setUrl("https://example.com")) .setImage( new Image() .setUrl( "https://storage.googleapis.com/actionsresources/logo_assistant_2x_64dp.png") .setAccessibilityText("Image alternate text")) .setFooter("Item 1 footer"), new CarouselBrowseItem() .setTitle("Title of item 2") .setDescription("Description of item 2") .setOpenUrlAction(new OpenUrlAction().setUrl("https://example.com")) .setImage( new Image() .setUrl( "https://storage.googleapis.com/actionsresources/logo_assistant_2x_64dp.png") .setAccessibilityText("Image alternate text")) .setFooter("Item 2 footer"))))); return responseBuilder.build(); }

Node.js

if (!conv.screen || !conv.surface.capabilities.has('actions.capability.WEB_BROWSER')) { conv.ask('Sorry, try this on a phone or select the ' + 'phone surface in the simulator.'); conv.ask('Which response would you like to see next?'); return; } conv.ask(`Here's an example of a browsing carousel.`); conv.ask(new BrowseCarousel({ items: [ new BrowseCarouselItem({ title: 'Title of item 1', url: 'https://example.com', description: 'Description of item 1', image: new Image({ url: 'https://storage.googleapis.com/actionsresources/logo_assistant_2x_64dp.png', alt: 'Image alternate text', }), footer: 'Item 1 footer', }), new BrowseCarouselItem({ title: 'Title of item 2', url: 'https://example.com', description: 'Description of item 2', image: new Image({ url: 'https://storage.googleapis.com/actionsresources/logo_assistant_2x_64dp.png', alt: 'Image alternate text', }), footer: 'Item 2 footer', }), ], }));

Java

ResponseBuilder responseBuilder = getResponseBuilder(request); if (!request.hasCapability(Capability.SCREEN_OUTPUT.getValue()) || !request.hasCapability(Capability.WEB_BROWSER.getValue())) { return responseBuilder .add("Sorry, try this on a phone or select the phone surface in the simulator.") .add("Which response would you like to see next?") .build(); } responseBuilder .add("Here's an example of a browsing carousel.") .add( new CarouselBrowse() .setItems( new ArrayList<CarouselBrowseItem>( Arrays.asList( new CarouselBrowseItem() .setTitle("Title of item 1") .setDescription("Description of item 1") .setOpenUrlAction(new OpenUrlAction().setUrl("https://example.com")) .setImage( new Image() .setUrl( "https://storage.googleapis.com/actionsresources/logo_assistant_2x_64dp.png") .setAccessibilityText("Image alternate text")) .setFooter("Item 1 footer"), new CarouselBrowseItem() .setTitle("Title of item 2") .setDescription("Description of item 2") .setOpenUrlAction(new OpenUrlAction().setUrl("https://example.com")) .setImage( new Image() .setUrl( "https://storage.googleapis.com/actionsresources/logo_assistant_2x_64dp.png") .setAccessibilityText("Image alternate text")) .setFooter("Item 2 footer"))))); return responseBuilder.build();

JSON

O JSON abaixo descreve uma resposta do webhook.

{ "payload": { "google": { "expectUserResponse": true, "richResponse": { "items": [ { "simpleResponse": { "textToSpeech": "Here's an example of a browsing carousel." } }, { "carouselBrowse": { "items": [ { "title": "Title of item 1", "openUrlAction": { "url": "https://example.com" }, "description": "Description of item 1", "footer": "Item 1 footer", "image": { "url": "https://storage.googleapis.com/actionsresources/logo_assistant_2x_64dp.png", "accessibilityText": "Image alternate text" } }, { "title": "Title of item 2", "openUrlAction": { "url": "https://example.com" }, "description": "Description of item 2", "footer": "Item 2 footer", "image": { "url": "https://storage.googleapis.com/actionsresources/logo_assistant_2x_64dp.png", "accessibilityText": "Image alternate text" } } ] } } ] } } } }

JSON

O JSON abaixo descreve uma resposta do webhook.

{ "expectUserResponse": true, "expectedInputs": [ { "inputPrompt": { "richInitialPrompt": { "items": [ { "simpleResponse": { "textToSpeech": "Here's an example of a browsing carousel." } }, { "carouselBrowse": { "items": [ { "description": "Description of item 1", "footer": "Item 1 footer", "image": { "accessibilityText": "Image alternate text", "url": "https://storage.googleapis.com/actionsresources/logo_assistant_2x_64dp.png" }, "openUrlAction": { "url": "https://example.com" }, "title": "Title of item 1" }, { "description": "Description of item 2", "footer": "Item 2 footer", "image": { "accessibilityText": "Image alternate text", "url": "https://storage.googleapis.com/actionsresources/logo_assistant_2x_64dp.png" }, "openUrlAction": { "url": "https://example.com" }, "title": "Title of item 2" } ] } } ] } }, "possibleIntents": [ { "intent": "actions.intent.TEXT" } ] } ] }

Processando o item selecionado

Nenhum fulfillment de acompanhamento é necessário para interações do usuário com o carrossel de navegação itens, já que o carrossel lida com a transferência do navegador. Lembre-se de que o microfone não serão reabertos depois que o usuário interagir com um item de carrossel de navegação. Portanto, você deve encerrar a conversa ou incluir ícones de sugestão na sua resposta, conforme a orientação acima.

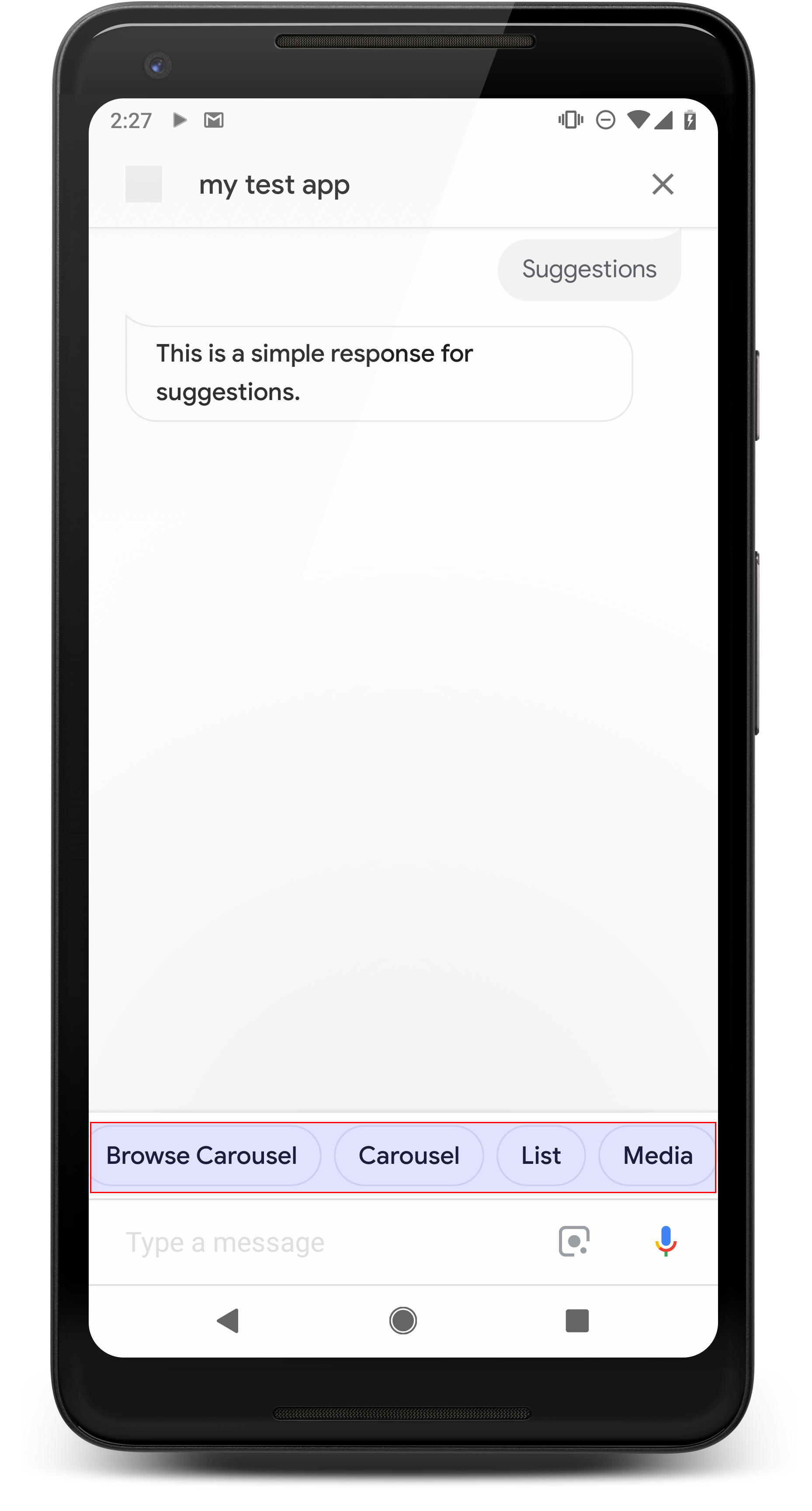

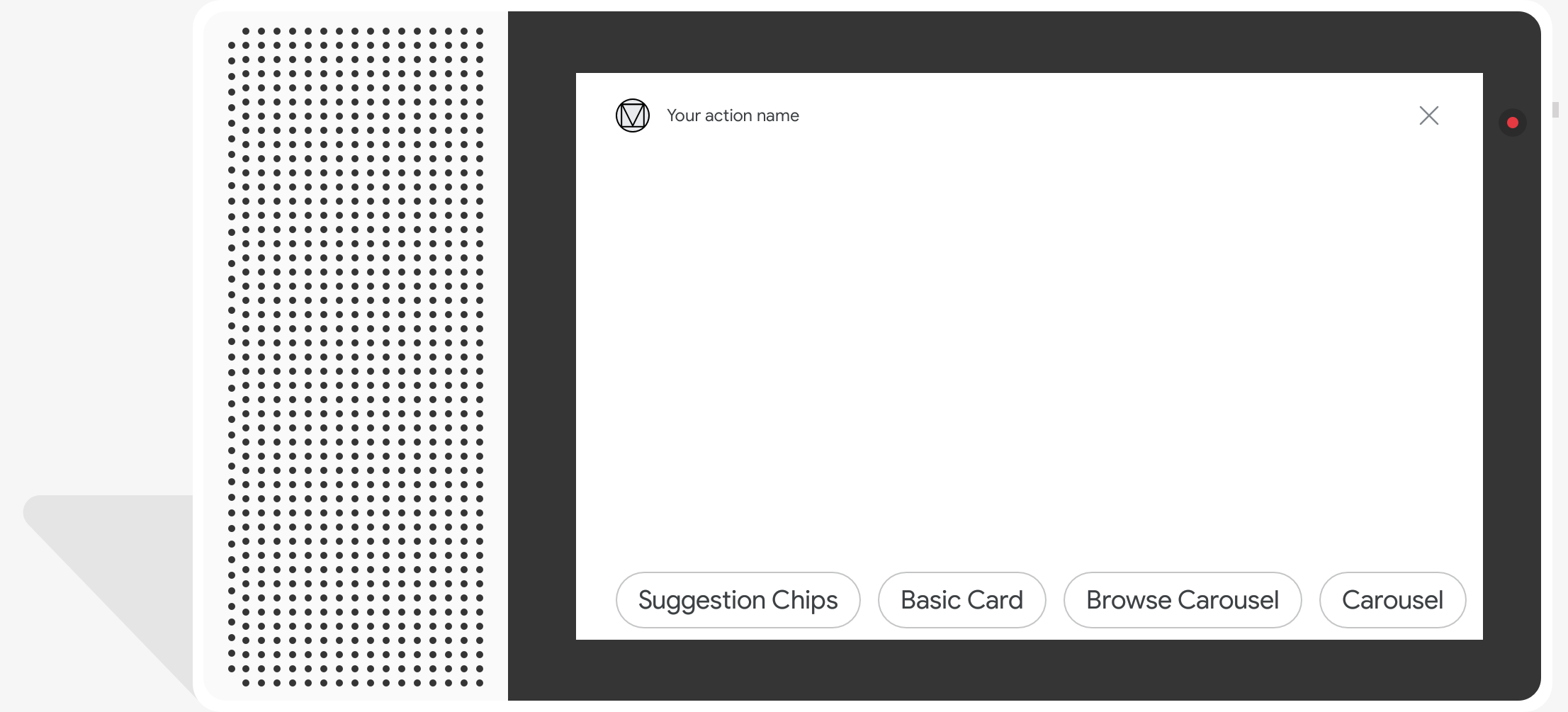

Ícones de sugestão

.

Use os ícones de sugestão para sugerir respostas e continuar ou mudar a conversa. Se, durante a conversa, houver uma call-to-action principal, considere listar ele será o primeiro chip de sugestão.

Sempre que possível, incorpore uma sugestão importante no chat. balão, mas faça isso apenas se a resposta ou conversa for natural.

Propriedades

Os ícones de sugestão têm os seguintes requisitos e opções que você pode configurar:

- Compatível com plataformas com o recurso

actions.capability.SCREEN_OUTPUT. - Para vincular ícones de sugestão à Web, as plataformas também precisam ter o

actions.capability.WEB_BROWSER. No momento, esse recurso não está disponível disponíveis em smart displays. - Máximo de oito ícones.

- Tamanho máximo do texto de 25 caracteres.

Compatível apenas com texto simples.

Código de amostra

Node.js

app.intent('Suggestion Chips', (conv) => { if (!conv.screen) { conv.ask('Chips can be demonstrated on screen devices.'); conv.ask('Which response would you like to see next?'); return; } conv.ask('These are suggestion chips.'); conv.ask(new Suggestions('Suggestion 1')); conv.ask(new Suggestions(['Suggestion 2', 'Suggestion 3'])); conv.ask(new LinkOutSuggestion({ name: 'Suggestion Link', url: 'https://assistant.google.com/', })); conv.ask('Which type of response would you like to see next?'); ; });

Java

@ForIntent("Suggestion Chips") public ActionResponse suggestionChips(ActionRequest request) { ResponseBuilder responseBuilder = getResponseBuilder(request); if (!request.hasCapability(Capability.SCREEN_OUTPUT.getValue())) { return responseBuilder .add("Sorry, try ths on a screen device or select the phone surface in the simulator.") .add("Which response would you like to see next?") .build(); } responseBuilder .add("These are suggestion chips.") .addSuggestions(new String[] {"Suggestion 1", "Suggestion 2", "Suggestion 3"}) .add( new LinkOutSuggestion() .setDestinationName("Suggestion Link") .setUrl("https://assistant.google.com/")) .add("Which type of response would you like to see next?"); return responseBuilder.build(); }

Node.js

if (!conv.screen) { conv.ask('Chips can be demonstrated on screen devices.'); conv.ask('Which response would you like to see next?'); return; } conv.ask('These are suggestion chips.'); conv.ask(new Suggestions('Suggestion 1')); conv.ask(new Suggestions(['Suggestion 2', 'Suggestion 3'])); conv.ask(new LinkOutSuggestion({ name: 'Suggestion Link', url: 'https://assistant.google.com/', })); conv.ask('Which type of response would you like to see next?');

Java

ResponseBuilder responseBuilder = getResponseBuilder(request); if (!request.hasCapability(Capability.SCREEN_OUTPUT.getValue())) { return responseBuilder .add("Sorry, try ths on a screen device or select the phone surface in the simulator.") .add("Which response would you like to see next?") .build(); } responseBuilder .add("These are suggestion chips.") .addSuggestions(new String[] {"Suggestion 1", "Suggestion 2", "Suggestion 3"}) .add( new LinkOutSuggestion() .setDestinationName("Suggestion Link") .setUrl("https://assistant.google.com/")) .add("Which type of response would you like to see next?"); return responseBuilder.build();

JSON

O JSON abaixo descreve uma resposta do webhook.

{ "payload": { "google": { "expectUserResponse": true, "richResponse": { "items": [ { "simpleResponse": { "textToSpeech": "These are suggestion chips." } }, { "simpleResponse": { "textToSpeech": "Which type of response would you like to see next?" } } ], "suggestions": [ { "title": "Suggestion 1" }, { "title": "Suggestion 2" }, { "title": "Suggestion 3" } ], "linkOutSuggestion": { "destinationName": "Suggestion Link", "url": "https://assistant.google.com/" } } } } }

JSON

O JSON abaixo descreve uma resposta do webhook.

{ "expectUserResponse": true, "expectedInputs": [ { "possibleIntents": [ { "intent": "actions.intent.TEXT" } ], "inputPrompt": { "richInitialPrompt": { "items": [ { "simpleResponse": { "textToSpeech": "These are suggestion chips." } }, { "simpleResponse": { "textToSpeech": "Which type of response would you like to see next?" } } ], "suggestions": [ { "title": "Suggestion 1" }, { "title": "Suggestion 2" }, { "title": "Suggestion 3" } ], "linkOutSuggestion": { "destinationName": "Suggestion Link", "url": "https://assistant.google.com/" } } } } ] }

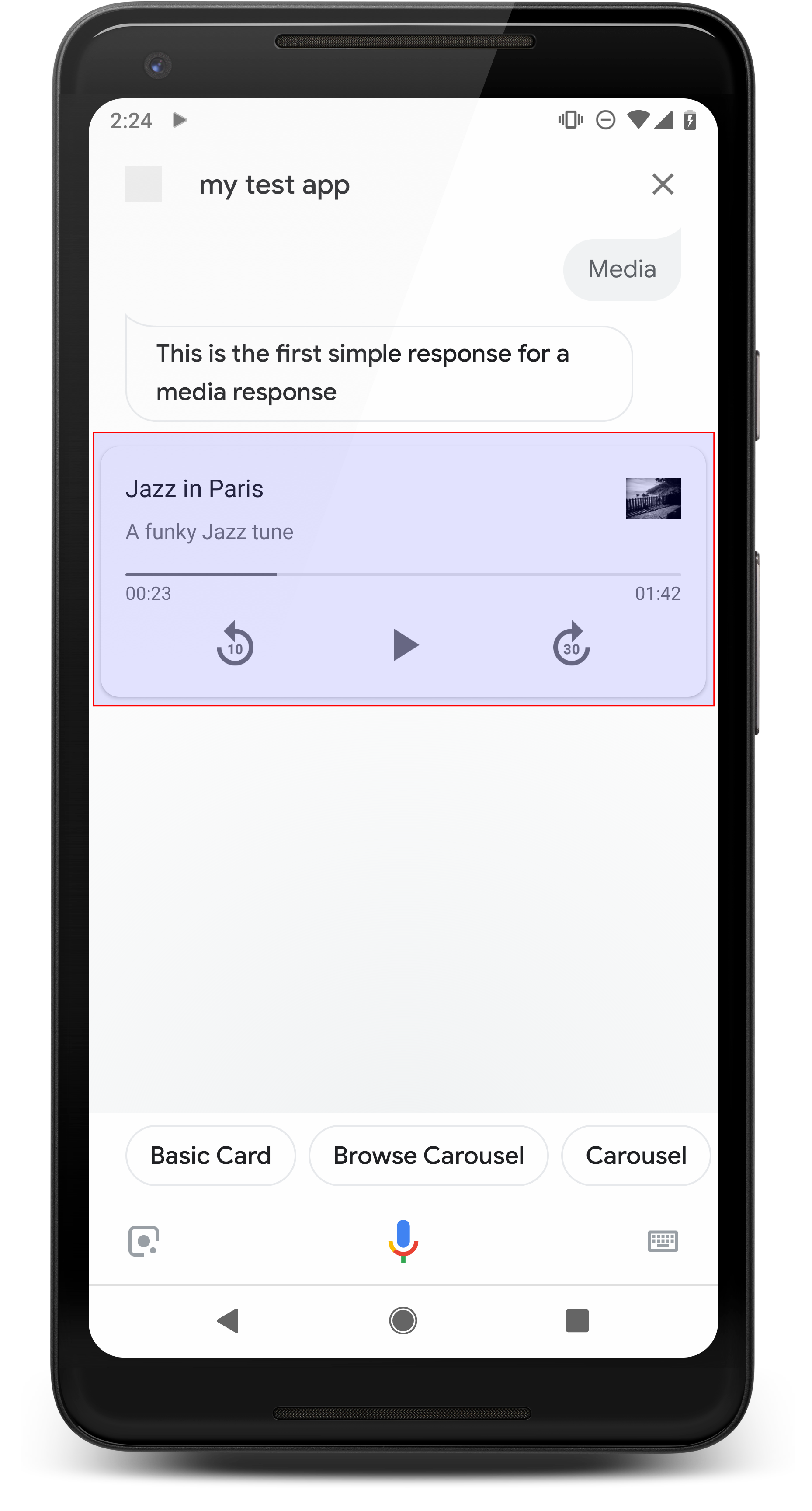

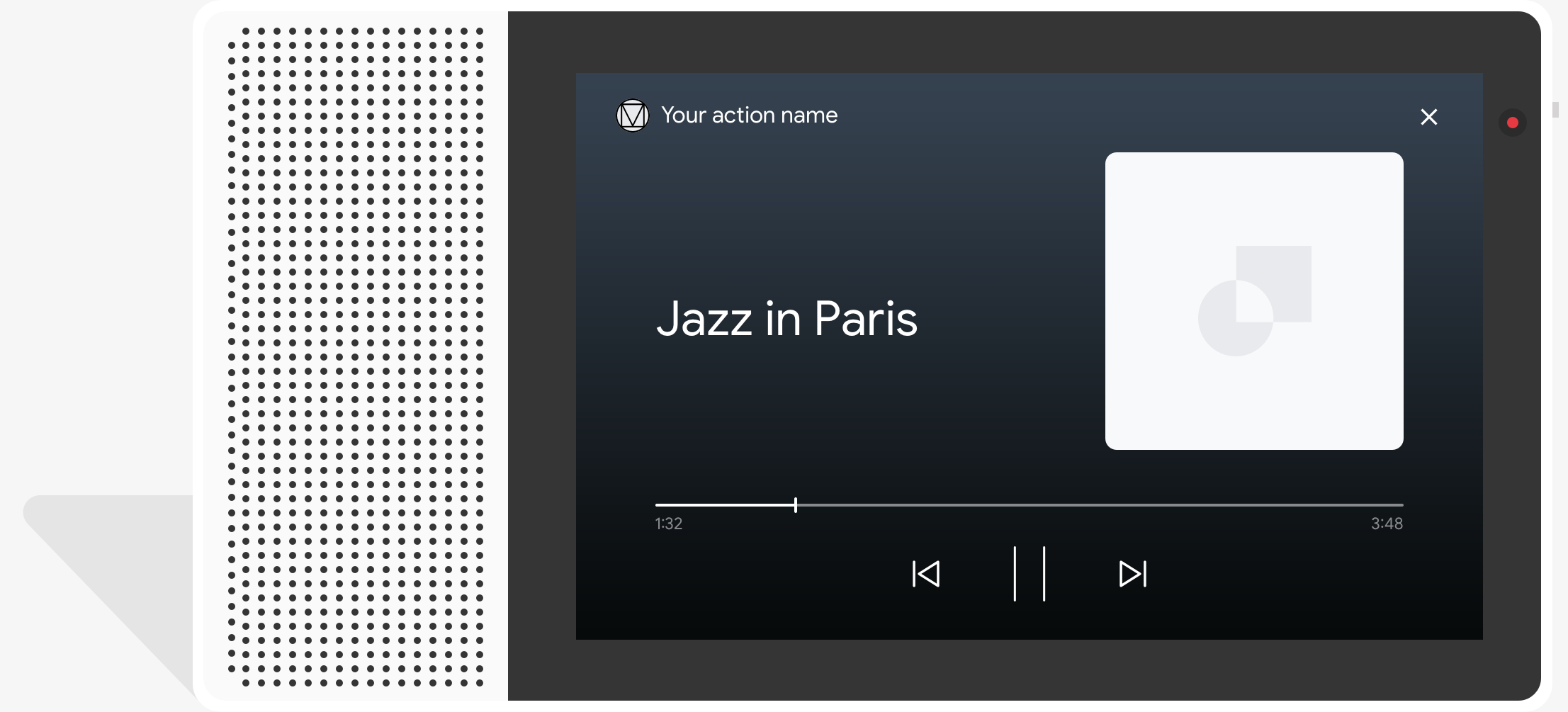

Respostas da mídia

.

As respostas de mídia permitem que suas ações reproduzam conteúdo de áudio com uma duração de reprodução além do limite de 240 segundos de SSML. O principal componente de uma mídia resposta é o card de faixa única. O card permite que o usuário realize essas ações operações:

- Repetir os últimos 10 segundos.

- Avance por 30 segundos.

- Confira a duração total do conteúdo de mídia.

- Ver um indicador de progresso para a reprodução de áudio.

- Ver o tempo de reprodução decorrido.

As respostas de mídia têm suporte aos seguintes controles de áudio para interação por voz:

- "Ok Google, abrir."

- "Ok Google, pausar."

- "Ok Google, pare."

- "Ok Google, começar de novo."

Os usuários também podem controlar o volume dizendo frases como "Ok Google, ligue o aumentar volume" ou "Ok Google, ajuste o volume para 50%". Intents na sua A ação tem precedência se elas processarem frases de treinamento semelhantes. Permitir que o Google Assistente processar essas solicitações de usuários, a menos que sua ação tenha um motivo específico para isso.

Propriedades

As respostas de mídia têm os seguintes requisitos e propriedades opcionais que você pode configurar:

- Compatível com plataformas com

actions.capability.MEDIA_RESPONSE_AUDIO. capacidade de processamento. - O áudio para reprodução precisa estar em um arquivo

.mp3formatado corretamente. Disponível streaming não é suportado. - O arquivo de mídia para reprodução precisa ser especificado como um URL HTTPS.

- Imagem (opcional)

- Também é possível incluir um ícone ou uma imagem.

- Ícone

- Seu ícone aparece como uma miniatura sem bordas à direita da mídia de jogador.

- O tamanho precisa ser de 36 x 36 dp. Imagens maiores são redimensionadas para caber.

- Imagem

- O contêiner da imagem terá 192 dp de altura.

- Sua imagem aparece na parte superior do card do player de mídia e abrange largura total do cartão. A maioria das imagens aparece com barras ao longo parte superior ou laterais.

- GIFs com movimento são permitidos.

- É necessário especificar a origem da imagem como um URL.

- O texto alternativo é obrigatório em todas as imagens.

Comportamento em superfícies

É possível responder à mídia em smartphones Android e no Google Home. A o comportamento das respostas da mídia depende da superfície em que os usuários interagem com suas ações.

Em smartphones Android, os usuários podem ver respostas de mídia quando qualquer uma dessas condições sejam atendidos:

- O Google Assistente está em primeiro plano, e a tela do smartphone está ativada.

- O usuário sai do Google Assistente enquanto o áudio está tocando e retorna ao Google Assistente até 10 minutos após a reprodução terminar. Ao retornar para Google Assistente, o usuário vê o card de mídia e os ícones de sugestão.

- Com o Assistente, os usuários podem controlar o volume do dispositivo no seu ação conversacional dizendo coisas como "aumentar o volume" ou "definir o o volume em 50%". Se você tem intents que processam frases de treinamento semelhantes, suas intents terão precedência. Recomendamos deixar o Assistente cuidar disso solicitações do usuário, a menos que sua ação tenha um motivo específico.

Os controles de mídia ficam disponíveis enquanto o smartphone está bloqueado. No Android, os controles também aparecem na área de notificação.

Código de amostra

O exemplo de código a seguir mostra como atualizar suas respostas avançadas para incluem mídia.

Node.js

app.intent('Media Response', (conv) => { if (!conv.surface.capabilities .has('actions.capability.MEDIA_RESPONSE_AUDIO')) { conv.ask('Sorry, this device does not support audio playback.'); conv.ask('Which response would you like to see next?'); return; } conv.ask('This is a media response example.'); conv.ask(new MediaObject({ name: 'Jazz in Paris', url: 'https://storage.googleapis.com/automotive-media/Jazz_In_Paris.mp3', description: 'A funky Jazz tune', icon: new Image({ url: 'https://storage.googleapis.com/automotive-media/album_art.jpg', alt: 'Album cover of an ocean view', }), })); conv.ask(new Suggestions(['Basic Card', 'List', 'Carousel', 'Browsing Carousel'])); });

Java

@ForIntent("Media Response") public ActionResponse mediaResponse(ActionRequest request) { ResponseBuilder responseBuilder = getResponseBuilder(request); if (!request.hasCapability(Capability.MEDIA_RESPONSE_AUDIO.getValue())) { return responseBuilder .add("Sorry, this device does not support audio playback.") .add("Which response would you like to see next?") .build(); } responseBuilder .add("This is a media response example.") .add( new MediaResponse() .setMediaObjects( new ArrayList<MediaObject>( Arrays.asList( new MediaObject() .setName("Jazz in Paris") .setDescription("A funky Jazz tune") .setContentUrl( "https://storage.googleapis.com/automotive-media/Jazz_In_Paris.mp3") .setIcon( new Image() .setUrl( "https://storage.googleapis.com/automotive-media/album_art.jpg") .setAccessibilityText("Album cover of an ocean view"))))) .setMediaType("AUDIO")) .addSuggestions(new String[] {"Basic Card", "List", "Carousel", "Browsing Carousel"}); return responseBuilder.build(); }

Node.js

if (!conv.surface.capabilities .has('actions.capability.MEDIA_RESPONSE_AUDIO')) { conv.ask('Sorry, this device does not support audio playback.'); conv.ask('Which response would you like to see next?'); return; } conv.ask('This is a media response example.'); conv.ask(new MediaObject({ name: 'Jazz in Paris', url: 'https://storage.googleapis.com/automotive-media/Jazz_In_Paris.mp3', description: 'A funky Jazz tune', icon: new Image({ url: 'https://storage.googleapis.com/automotive-media/album_art.jpg', alt: 'Album cover of an ocean view', }), })); conv.ask(new Suggestions(['Basic Card', 'List', 'Carousel', 'Browsing Carousel']));

Java

ResponseBuilder responseBuilder = getResponseBuilder(request); if (!request.hasCapability(Capability.MEDIA_RESPONSE_AUDIO.getValue())) { return responseBuilder .add("Sorry, this device does not support audio playback.") .add("Which response would you like to see next?") .build(); } responseBuilder .add("This is a media response example.") .add( new MediaResponse() .setMediaObjects( new ArrayList<MediaObject>( Arrays.asList( new MediaObject() .setName("Jazz in Paris") .setDescription("A funky Jazz tune") .setContentUrl( "https://storage.googleapis.com/automotive-media/Jazz_In_Paris.mp3") .setIcon( new Image() .setUrl( "https://storage.googleapis.com/automotive-media/album_art.jpg") .setAccessibilityText("Album cover of an ocean view"))))) .setMediaType("AUDIO")) .addSuggestions(new String[] {"Basic Card", "List", "Carousel", "Browsing Carousel"}); return responseBuilder.build();

JSON

O JSON abaixo descreve uma resposta do webhook.

{ "payload": { "google": { "expectUserResponse": true, "richResponse": { "items": [ { "simpleResponse": { "textToSpeech": "This is a media response example." } }, { "mediaResponse": { "mediaType": "AUDIO", "mediaObjects": [ { "contentUrl": "https://storage.googleapis.com/automotive-media/Jazz_In_Paris.mp3", "description": "A funky Jazz tune", "icon": { "url": "https://storage.googleapis.com/automotive-media/album_art.jpg", "accessibilityText": "Album cover of an ocean view" }, "name": "Jazz in Paris" } ] } } ], "suggestions": [ { "title": "Basic Card" }, { "title": "List" }, { "title": "Carousel" }, { "title": "Browsing Carousel" } ] } } } }

JSON

O JSON abaixo descreve uma resposta do webhook.

{ "expectUserResponse": true, "expectedInputs": [ { "possibleIntents": [ { "intent": "actions.intent.TEXT" } ], "inputPrompt": { "richInitialPrompt": { "items": [ { "simpleResponse": { "textToSpeech": "This is a media response example." } }, { "mediaResponse": { "mediaType": "AUDIO", "mediaObjects": [ { "contentUrl": "https://storage.googleapis.com/automotive-media/Jazz_In_Paris.mp3", "description": "A funky Jazz tune", "icon": { "url": "https://storage.googleapis.com/automotive-media/album_art.jpg", "accessibilityText": "Album cover of an ocean view" }, "name": "Jazz in Paris" } ] } } ], "suggestions": [ { "title": "Basic Card" }, { "title": "List" }, { "title": "Carousel" }, { "title": "Browsing Carousel" } ] } } } ] }

Orientação

Sua resposta precisa incluir um mediaResponse com um mediaType de AUDIO e

contendo um mediaObject na matriz de itens da resposta avançada. Uma mídia

suporte a um único objeto de mídia. Um objeto de mídia deve incluir o conteúdo

URL do arquivo de áudio. Opcionalmente, um objeto de mídia pode incluir um nome, subtexto

(descrição) e um ícone ou URL de imagem.

Em smartphones e no Google Home, quando a ação concluir a reprodução de áudio,

O Google Assistente verifica se a resposta de mídia é uma FinalResponse.

Caso contrário, ele enviará um callback para o fulfillment, permitindo que você responda ao

usuário.

Sua ação precisa incluir ícones de sugestão se o

a resposta não é FinalResponse.

Processar o callback após o fim da reprodução

Sua ação precisa processar a intent actions.intent.MEDIA_STATUS para enviar a solicitação.

usuário para acompanhamento (por exemplo, para tocar outra música). Sua Ação recebe

esse callback assim que a reprodução de mídia for concluída. No retorno de chamada, o

O argumento MEDIA_STATUS contém informações de status sobre a mídia atual. A

o valor do status será FINISHED ou STATUS_UNSPECIFIED.

Como usar o Dialogflow

Para fazer ramificações conversacionais no Dialogflow, faça o seguinte:

configurou um contexto de entrada de actions_capability_media_response_audio na

para garantir que ela só seja acionada em superfícies com suporte a uma resposta de mídia.

Como criar o fulfillment

O snippet de código abaixo mostra como escrever o código de fulfillment da

Ação. Se você estiver usando o Dialogflow, substitua actions.intent.MEDIA_STATUS

com o nome de ação especificado na intent que recebe o

evento actions_intent_MEDIA_STATUS, por exemplo, "media.status.update".

Node.js

app.intent('Media Status', (conv) => { const mediaStatus = conv.arguments.get('MEDIA_STATUS'); let response = 'Unknown media status received.'; if (mediaStatus && mediaStatus.status === 'FINISHED') { response = 'Hope you enjoyed the tune!'; } conv.ask(response); conv.ask('Which response would you like to see next?'); });

Java

@ForIntent("Media Status") public ActionResponse mediaStatus(ActionRequest request) { ResponseBuilder responseBuilder = getResponseBuilder(request); String mediaStatus = request.getMediaStatus(); String response = "Unknown media status received."; if (mediaStatus != null && mediaStatus.equals("FINISHED")) { response = "Hope you enjoyed the tune!"; } responseBuilder.add(response); responseBuilder.add("Which response would you like to see next?"); return responseBuilder.build(); }

Node.js

app.intent('actions.intent.MEDIA_STATUS', (conv) => { const mediaStatus = conv.arguments.get('MEDIA_STATUS'); let response = 'Unknown media status received.'; if (mediaStatus && mediaStatus.status === 'FINISHED') { response = 'Hope you enjoyed the tune!'; } conv.ask(response); conv.ask('Which response would you like to see next?'); });

Java

@ForIntent("actions.intent.MEDIA_STATUS") public ActionResponse mediaStatus(ActionRequest request) { ResponseBuilder responseBuilder = getResponseBuilder(request); String mediaStatus = request.getMediaStatus(); String response = "Unknown media status received."; if (mediaStatus != null && mediaStatus.equals("FINISHED")) { response = "Hope you enjoyed the tune!"; } responseBuilder.add(response); responseBuilder.add("Which response would you like to see next?"); return responseBuilder.build(); }

JSON

O JSON abaixo descreve uma solicitação de webhook.

{ "responseId": "151b68df-98de-41fb-94b5-caeace90a7e9-21947381", "queryResult": { "queryText": "actions_intent_MEDIA_STATUS", "parameters": {}, "allRequiredParamsPresent": true, "fulfillmentText": "Webhook failed for intent: Media Status", "fulfillmentMessages": [ { "text": { "text": [ "Webhook failed for intent: Media Status" ] } } ], "outputContexts": [ { "name": "projects/df-responses-kohler/agent/sessions/ABwppHHsebncupHK11oKhsCTgyH96GRNYH-xpeeMTqb-cvOxbd67QenbRlZM4bGAIB8_KXdTfI7-7lYVKN1ovAhCaA/contexts/actions_capability_media_response_audio" }, { "name": "projects/df-responses-kohler/agent/sessions/ABwppHHsebncupHK11oKhsCTgyH96GRNYH-xpeeMTqb-cvOxbd67QenbRlZM4bGAIB8_KXdTfI7-7lYVKN1ovAhCaA/contexts/actions_capability_account_linking" }, { "name": "projects/df-responses-kohler/agent/sessions/ABwppHHsebncupHK11oKhsCTgyH96GRNYH-xpeeMTqb-cvOxbd67QenbRlZM4bGAIB8_KXdTfI7-7lYVKN1ovAhCaA/contexts/actions_capability_web_browser" }, { "name": "projects/df-responses-kohler/agent/sessions/ABwppHHsebncupHK11oKhsCTgyH96GRNYH-xpeeMTqb-cvOxbd67QenbRlZM4bGAIB8_KXdTfI7-7lYVKN1ovAhCaA/contexts/actions_capability_screen_output" }, { "name": "projects/df-responses-kohler/agent/sessions/ABwppHHsebncupHK11oKhsCTgyH96GRNYH-xpeeMTqb-cvOxbd67QenbRlZM4bGAIB8_KXdTfI7-7lYVKN1ovAhCaA/contexts/actions_capability_audio_output" }, { "name": "projects/df-responses-kohler/agent/sessions/ABwppHHsebncupHK11oKhsCTgyH96GRNYH-xpeeMTqb-cvOxbd67QenbRlZM4bGAIB8_KXdTfI7-7lYVKN1ovAhCaA/contexts/google_assistant_input_type_voice" }, { "name": "projects/df-responses-kohler/agent/sessions/ABwppHHsebncupHK11oKhsCTgyH96GRNYH-xpeeMTqb-cvOxbd67QenbRlZM4bGAIB8_KXdTfI7-7lYVKN1ovAhCaA/contexts/actions_intent_media_status", "parameters": { "MEDIA_STATUS": { "@type": "type.googleapis.com/google.actions.v2.MediaStatus", "status": "FINISHED" } } } ], "intent": { "name": "projects/df-responses-kohler/agent/intents/068b27d3-c148-4044-bfab-dfa37eebd90d", "displayName": "Media Status" }, "intentDetectionConfidence": 1, "languageCode": "en" }, "originalDetectIntentRequest": { "source": "google", "version": "2", "payload": { "user": { "locale": "en-US", "lastSeen": "2019-08-04T23:57:15Z", "userVerificationStatus": "VERIFIED" }, "conversation": { "conversationId": "ABwppHHsebncupHK11oKhsCTgyH96GRNYH-xpeeMTqb-cvOxbd67QenbRlZM4bGAIB8_KXdTfI7-7lYVKN1ovAhCaA", "type": "ACTIVE", "conversationToken": "[]" }, "inputs": [ { "intent": "actions.intent.MEDIA_STATUS", "rawInputs": [ { "inputType": "VOICE" } ], "arguments": [ { "name": "MEDIA_STATUS", "extension": { "@type": "type.googleapis.com/google.actions.v2.MediaStatus", "status": "FINISHED" } } ] } ], "surface": { "capabilities": [ { "name": "actions.capability.MEDIA_RESPONSE_AUDIO" }, { "name": "actions.capability.ACCOUNT_LINKING" }, { "name": "actions.capability.WEB_BROWSER" }, { "name": "actions.capability.SCREEN_OUTPUT" }, { "name": "actions.capability.AUDIO_OUTPUT" } ] }, "isInSandbox": true, "availableSurfaces": [ { "capabilities": [ { "name": "actions.capability.WEB_BROWSER" }, { "name": "actions.capability.AUDIO_OUTPUT" }, { "name": "actions.capability.SCREEN_OUTPUT" } ] } ], "requestType": "SIMULATOR" } }, "session": "projects/df-responses-kohler/agent/sessions/ABwppHHsebncupHK11oKhsCTgyH96GRNYH-xpeeMTqb-cvOxbd67QenbRlZM4bGAIB8_KXdTfI7-7lYVKN1ovAhCaA" }

JSON

O JSON abaixo descreve uma solicitação de webhook.

{ "user": { "locale": "en-US", "lastSeen": "2019-08-06T07:38:40Z", "userVerificationStatus": "VERIFIED" }, "conversation": { "conversationId": "ABwppHGcqunXh1M6IE0lu2sVqXdpJfdpC5FWMkMSXQskK1nzb4IkSUSRqQzoEr0Ly0z_G3mwyZlk5rFtd1w", "type": "NEW" }, "inputs": [ { "intent": "actions.intent.MEDIA_STATUS", "rawInputs": [ { "inputType": "VOICE" } ], "arguments": [ { "name": "MEDIA_STATUS", "extension": { "@type": "type.googleapis.com/google.actions.v2.MediaStatus", "status": "FINISHED" } } ] } ], "surface": { "capabilities": [ { "name": "actions.capability.SCREEN_OUTPUT" }, { "name": "actions.capability.WEB_BROWSER" }, { "name": "actions.capability.AUDIO_OUTPUT" }, { "name": "actions.capability.MEDIA_RESPONSE_AUDIO" }, { "name": "actions.capability.ACCOUNT_LINKING" } ] }, "isInSandbox": true, "availableSurfaces": [ { "capabilities": [ { "name": "actions.capability.WEB_BROWSER" }, { "name": "actions.capability.AUDIO_OUTPUT" }, { "name": "actions.capability.SCREEN_OUTPUT" } ] } ], "requestType": "SIMULATOR" }

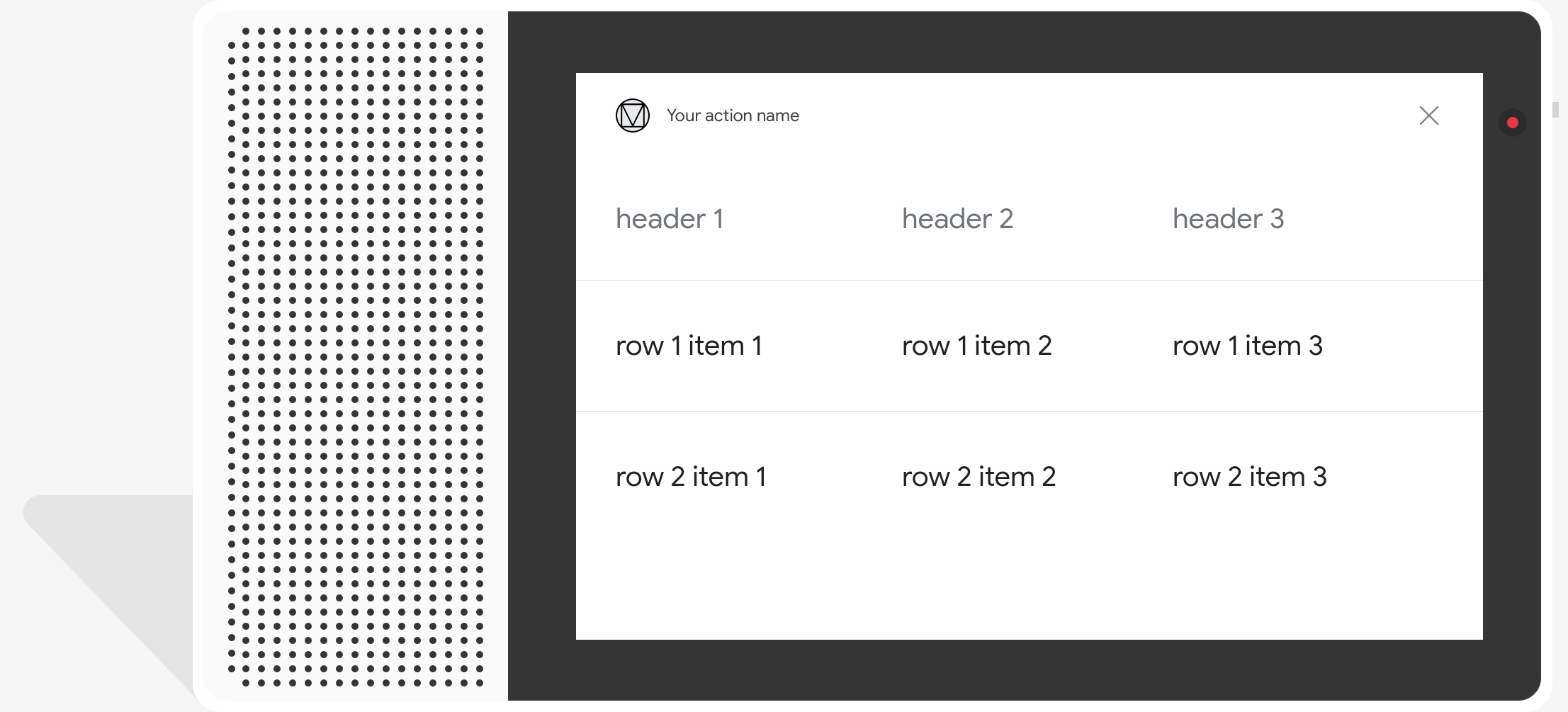

Cards de tabela

Os cards de tabela permitem exibir dados tabulares na sua resposta (por exemplo, classificações esportivas, resultados eleitorais e voos). É possível definir colunas e linhas (até três) que o Assistente precisa mostrar no card da tabela. Você também pode definir colunas e linhas adicionais junto com a priorização delas.

As tabelas são diferentes das listas verticais porque elas exibem dados estáticos e não são interativos, como elementos de lista.

.

Propriedades

Os cards de tabela têm os seguintes requisitos e propriedades opcionais que você pode configurar:

- Compatível com plataformas com o recurso

actions.capability.SCREEN_OUTPUT.

A seção a seguir resume como personalizar os elementos em uma tabela carda.

| Nome | É opcional | É personalizável | Observações de personalização |

|---|---|---|---|

title |

Sim | Sim | Título geral da tabela. Precisa ser definido se o subtítulo estiver definido. Você pode personalizar a família e a cor da fonte. |

subtitle |

Sim | Não | Subtítulo da tabela. |

image |

Sim | Sim | Imagem associada à tabela. |

Row |

Não | Sim |

Dados de linha da tabela. Consiste em uma matriz de As três primeiras linhas vão aparecer, mas outras podem não aparecer aparecem em determinadas superfícies. Faça um teste com o simulador para ver quais linhas são exibidas para um

em uma determinada superfície. Em plataformas compatíveis com |

ColumnProperties |

Sim | Sim | Cabeçalho e alinhamento de uma coluna. Consiste em um header.

, que representa o texto do cabeçalho de uma coluna, e uma propriedade

Propriedade horizontal_alignment (do tipo

HorizontalAlignment). |

Cell |

Não | Sim | Descreve uma célula em uma linha. Cada célula contém uma string que representa de texto. Você pode personalizar o texto na célula. |

Button |

Sim | Sim | Um objeto de botão que geralmente aparece na parte inferior de um cartão. Uma tabela O cartão só pode ter um botão. Você pode personalizar a cor do botão. |

HorizontalAlignment |

Sim | Sim | Alinhamento horizontal do conteúdo dentro da célula. Os valores podem ser

LEADING, CENTER ou TRAILING. Se

não especificado, o conteúdo é alinhado à borda inicial da célula. |

Código de amostra

Os snippets a seguir mostram como implementar um cartão de tabela simples:

Node.js

app.intent('Simple Table Card', (conv) => { if (!conv.screen) { conv.ask('Sorry, try this on a screen device or select the ' + 'phone surface in the simulator.'); conv.ask('Which response would you like to see next?'); return; } conv.ask('This is a simple table example.'); conv.ask(new Table({ dividers: true, columns: ['header 1', 'header 2', 'header 3'], rows: [ ['row 1 item 1', 'row 1 item 2', 'row 1 item 3'], ['row 2 item 1', 'row 2 item 2', 'row 2 item 3'], ], })); conv.ask('Which response would you like to see next?'); });

Java

@ForIntent("Simple Table Card") public ActionResponse simpleTable(ActionRequest request) { ResponseBuilder responseBuilder = getResponseBuilder(request); if (!request.hasCapability(Capability.SCREEN_OUTPUT.getValue())) { return responseBuilder .add("Sorry, try ths on a screen device or select the phone surface in the simulator.") .add("Which response would you like to see next?") .build(); } responseBuilder .add("This is a simple table example.") .add( new TableCard() .setColumnProperties( Arrays.asList( new TableCardColumnProperties().setHeader("header 1"), new TableCardColumnProperties().setHeader("header 2"), new TableCardColumnProperties().setHeader("header 3"))) .setRows( Arrays.asList( new TableCardRow() .setCells( Arrays.asList( new TableCardCell().setText("row 1 item 1"), new TableCardCell().setText("row 1 item 2"), new TableCardCell().setText("row 1 item 3"))), new TableCardRow() .setCells( Arrays.asList( new TableCardCell().setText("row 2 item 1"), new TableCardCell().setText("row 2 item 2"), new TableCardCell().setText("row 2 item 3")))))); return responseBuilder.build(); }

Node.js

if (!conv.screen) { conv.ask('Sorry, try this on a screen device or select the ' + 'phone surface in the simulator.'); conv.ask('Which response would you like to see next?'); return; } conv.ask('This is a simple table example.'); conv.ask(new Table({ dividers: true, columns: ['header 1', 'header 2', 'header 3'], rows: [ ['row 1 item 1', 'row 1 item 2', 'row 1 item 3'], ['row 2 item 1', 'row 2 item 2', 'row 2 item 3'], ], })); conv.ask('Which response would you like to see next?');

Java

ResponseBuilder responseBuilder = getResponseBuilder(request); if (!request.hasCapability(Capability.SCREEN_OUTPUT.getValue())) { return responseBuilder .add("Sorry, try ths on a screen device or select the phone surface in the simulator.") .add("Which response would you like to see next?") .build(); } responseBuilder .add("This is a simple table example.") .add( new TableCard() .setColumnProperties( Arrays.asList( new TableCardColumnProperties().setHeader("header 1"), new TableCardColumnProperties().setHeader("header 2"), new TableCardColumnProperties().setHeader("header 3"))) .setRows( Arrays.asList( new TableCardRow() .setCells( Arrays.asList( new TableCardCell().setText("row 1 item 1"), new TableCardCell().setText("row 1 item 2"), new TableCardCell().setText("row 1 item 3"))), new TableCardRow() .setCells( Arrays.asList( new TableCardCell().setText("row 2 item 1"), new TableCardCell().setText("row 2 item 2"), new TableCardCell().setText("row 2 item 3")))))); return responseBuilder.build();

JSON

O JSON abaixo descreve uma resposta do webhook.

{ "payload": { "google": { "expectUserResponse": true, "richResponse": { "items": [ { "simpleResponse": { "textToSpeech": "This is a simple table example." } }, { "tableCard": { "rows": [ { "cells": [ { "text": "row 1 item 1" }, { "text": "row 1 item 2" }, { "text": "row 1 item 3" } ], "dividerAfter": true }, { "cells": [ { "text": "row 2 item 1" }, { "text": "row 2 item 2" }, { "text": "row 2 item 3" } ], "dividerAfter": true } ], "columnProperties": [ { "header": "header 1" }, { "header": "header 2" }, { "header": "header 3" } ] } }, { "simpleResponse": { "textToSpeech": "Which response would you like to see next?" } } ] } } } }

JSON

O JSON abaixo descreve uma resposta do webhook.

{ "expectUserResponse": true, "expectedInputs": [ { "inputPrompt": { "richInitialPrompt": { "items": [ { "simpleResponse": { "textToSpeech": "This is a simple table example." } }, { "tableCard": { "columnProperties": [ { "header": "header 1" }, { "header": "header 2" }, { "header": "header 3" } ], "rows": [ { "cells": [ { "text": "row 1 item 1" }, { "text": "row 1 item 2" }, { "text": "row 1 item 3" } ], "dividerAfter": true }, { "cells": [ { "text": "row 2 item 1" }, { "text": "row 2 item 2" }, { "text": "row 2 item 3" } ], "dividerAfter": true } ] } }, { "simpleResponse": { "textToSpeech": "Which response would you like to see next?" } } ] } }, "possibleIntents": [ { "intent": "actions.intent.TEXT" } ] } ] }

Os snippets a seguir mostram como implementar um card de tabela complexo:

Node.js

app.intent('Advanced Table Card', (conv) => { if (!conv.screen) { conv.ask('Sorry, try this on a screen device or select the ' + 'phone surface in the simulator.'); conv.ask('Which response would you like to see next?'); return; } conv.ask('This is a table with all the possible fields.'); conv.ask(new Table({ title: 'Table Title', subtitle: 'Table Subtitle', image: new Image({ url: 'https://storage.googleapis.com/actionsresources/logo_assistant_2x_64dp.png', alt: 'Alt Text', }), columns: [ { header: 'header 1', align: 'CENTER', }, { header: 'header 2', align: 'LEADING', }, { header: 'header 3', align: 'TRAILING', }, ], rows: [ { cells: ['row 1 item 1', 'row 1 item 2', 'row 1 item 3'], dividerAfter: false, }, { cells: ['row 2 item 1', 'row 2 item 2', 'row 2 item 3'], dividerAfter: true, }, { cells: ['row 3 item 1', 'row 3 item 2', 'row 3 item 3'], }, ], buttons: new Button({ title: 'Button Text', url: 'https://assistant.google.com', }), })); conv.ask('Which response would you like to see next?'); });

Java

@ForIntent("Advanced Table Card") public ActionResponse advancedTable(ActionRequest request) { ResponseBuilder responseBuilder = getResponseBuilder(request); if (!request.hasCapability(Capability.SCREEN_OUTPUT.getValue())) { return responseBuilder .add("Sorry, try ths on a screen device or select the phone surface in the simulator.") .add("Which response would you like to see next?") .build(); } responseBuilder .add("This is a table with all the possible fields.") .add( new TableCard() .setTitle("Table Title") .setSubtitle("Table Subtitle") .setImage( new Image() .setUrl( "https://storage.googleapis.com/actionsresources/logo_assistant_2x_64dp.png") .setAccessibilityText("Alt text")) .setButtons( Arrays.asList( new Button() .setTitle("Button Text") .setOpenUrlAction( new OpenUrlAction().setUrl("https://assistant.google.com")))) .setColumnProperties( Arrays.asList( new TableCardColumnProperties() .setHeader("header 1") .setHorizontalAlignment("CENTER"), new TableCardColumnProperties() .setHeader("header 2") .setHorizontalAlignment("LEADING"), new TableCardColumnProperties() .setHeader("header 3") .setHorizontalAlignment("TRAILING"))) .setRows( Arrays.asList( new TableCardRow() .setCells( Arrays.asList( new TableCardCell().setText("row 1 item 1"), new TableCardCell().setText("row 1 item 2"), new TableCardCell().setText("row 1 item 3"))) .setDividerAfter(false), new TableCardRow() .setCells( Arrays.asList( new TableCardCell().setText("row 2 item 1"), new TableCardCell().setText("row 2 item 2"), new TableCardCell().setText("row 2 item 3"))) .setDividerAfter(true), new TableCardRow() .setCells( Arrays.asList( new TableCardCell().setText("row 2 item 1"), new TableCardCell().setText("row 2 item 2"), new TableCardCell().setText("row 2 item 3")))))); return responseBuilder.build(); }

Node.js

if (!conv.screen) { conv.ask('Sorry, try this on a screen device or select the ' + 'phone surface in the simulator.'); conv.ask('Which response would you like to see next?'); return; } conv.ask('This is a table with all the possible fields.'); conv.ask(new Table({ title: 'Table Title', subtitle: 'Table Subtitle', image: new Image({ url: 'https://storage.googleapis.com/actionsresources/logo_assistant_2x_64dp.png', alt: 'Alt Text', }), columns: [ { header: 'header 1', align: 'CENTER', }, { header: 'header 2', align: 'LEADING', }, { header: 'header 3', align: 'TRAILING', }, ], rows: [ { cells: ['row 1 item 1', 'row 1 item 2', 'row 1 item 3'], dividerAfter: false, }, { cells: ['row 2 item 1', 'row 2 item 2', 'row 2 item 3'], dividerAfter: true, }, { cells: ['row 3 item 1', 'row 3 item 2', 'row 3 item 3'], }, ], buttons: new Button({ title: 'Button Text', url: 'https://assistant.google.com', }), })); conv.ask('Which response would you like to see next?');

Java

ResponseBuilder responseBuilder = getResponseBuilder(request); if (!request.hasCapability(Capability.SCREEN_OUTPUT.getValue())) { return responseBuilder .add("Sorry, try ths on a screen device or select the phone surface in the simulator.") .add("Which response would you like to see next?") .build(); } responseBuilder .add("This is a table with all the possible fields.") .add( new TableCard() .setTitle("Table Title") .setSubtitle("Table Subtitle") .setImage( new Image() .setUrl( "https://storage.googleapis.com/actionsresources/logo_assistant_2x_64dp.png") .setAccessibilityText("Alt text")) .setButtons( Arrays.asList( new Button() .setTitle("Button Text") .setOpenUrlAction( new OpenUrlAction().setUrl("https://assistant.google.com")))) .setColumnProperties( Arrays.asList( new TableCardColumnProperties() .setHeader("header 1") .setHorizontalAlignment("CENTER"), new TableCardColumnProperties() .setHeader("header 2") .setHorizontalAlignment("LEADING"), new TableCardColumnProperties() .setHeader("header 3") .setHorizontalAlignment("TRAILING"))) .setRows( Arrays.asList( new TableCardRow() .setCells( Arrays.asList( new TableCardCell().setText("row 1 item 1"), new TableCardCell().setText("row 1 item 2"), new TableCardCell().setText("row 1 item 3"))) .setDividerAfter(false), new TableCardRow() .setCells( Arrays.asList( new TableCardCell().setText("row 2 item 1"), new TableCardCell().setText("row 2 item 2"), new TableCardCell().setText("row 2 item 3"))) .setDividerAfter(true), new TableCardRow() .setCells( Arrays.asList( new TableCardCell().setText("row 2 item 1"), new TableCardCell().setText("row 2 item 2"), new TableCardCell().setText("row 2 item 3")))))); return responseBuilder.build();

JSON

O JSON abaixo descreve uma resposta do webhook.

{ "payload": { "google": { "expectUserResponse": true, "richResponse": { "items": [ { "simpleResponse": { "textToSpeech": "This is a table with all the possible fields." } }, { "tableCard": { "title": "Table Title", "subtitle": "Table Subtitle", "image": { "url": "https://storage.googleapis.com/actionsresources/logo_assistant_2x_64dp.png", "accessibilityText": "Alt Text" }, "rows": [ { "cells": [ { "text": "row 1 item 1" }, { "text": "row 1 item 2" }, { "text": "row 1 item 3" } ], "dividerAfter": false }, { "cells": [ { "text": "row 2 item 1" }, { "text": "row 2 item 2" }, { "text": "row 2 item 3" } ], "dividerAfter": true }, { "cells": [ { "text": "row 3 item 1" }, { "text": "row 3 item 2" }, { "text": "row 3 item 3" } ] } ], "columnProperties": [ { "header": "header 1", "horizontalAlignment": "CENTER" }, { "header": "header 2", "horizontalAlignment": "LEADING" }, { "header": "header 3", "horizontalAlignment": "TRAILING" } ], "buttons": [ { "title": "Button Text", "openUrlAction": { "url": "https://assistant.google.com" } } ] } }, { "simpleResponse": { "textToSpeech": "Which response would you like to see next?" } } ] } } } }

JSON

O JSON abaixo descreve uma resposta do webhook.

{ "expectUserResponse": true, "expectedInputs": [ { "possibleIntents": [ { "intent": "actions.intent.TEXT" } ], "inputPrompt": { "richInitialPrompt": { "items": [ { "simpleResponse": { "textToSpeech": "This is a table with all the possible fields." } }, { "tableCard": { "title": "Table Title", "subtitle": "Table Subtitle", "image": { "url": "https://storage.googleapis.com/actionsresources/logo_assistant_2x_64dp.png", "accessibilityText": "Alt Text" }, "rows": [ { "cells": [ { "text": "row 1 item 1" }, { "text": "row 1 item 2" }, { "text": "row 1 item 3" } ], "dividerAfter": false }, { "cells": [ { "text": "row 2 item 1" }, { "text": "row 2 item 2" }, { "text": "row 2 item 3" } ], "dividerAfter": true }, { "cells": [ { "text": "row 3 item 1" }, { "text": "row 3 item 2" }, { "text": "row 3 item 3" } ] } ], "columnProperties": [ { "header": "header 1", "horizontalAlignment": "CENTER" }, { "header": "header 2", "horizontalAlignment": "LEADING" }, { "header": "header 3", "horizontalAlignment": "TRAILING" } ], "buttons": [ { "title": "Button Text", "openUrlAction": { "url": "https://assistant.google.com" } } ] } }, { "simpleResponse": { "textToSpeech": "Which response would you like to see next?" } } ] } } } ] }

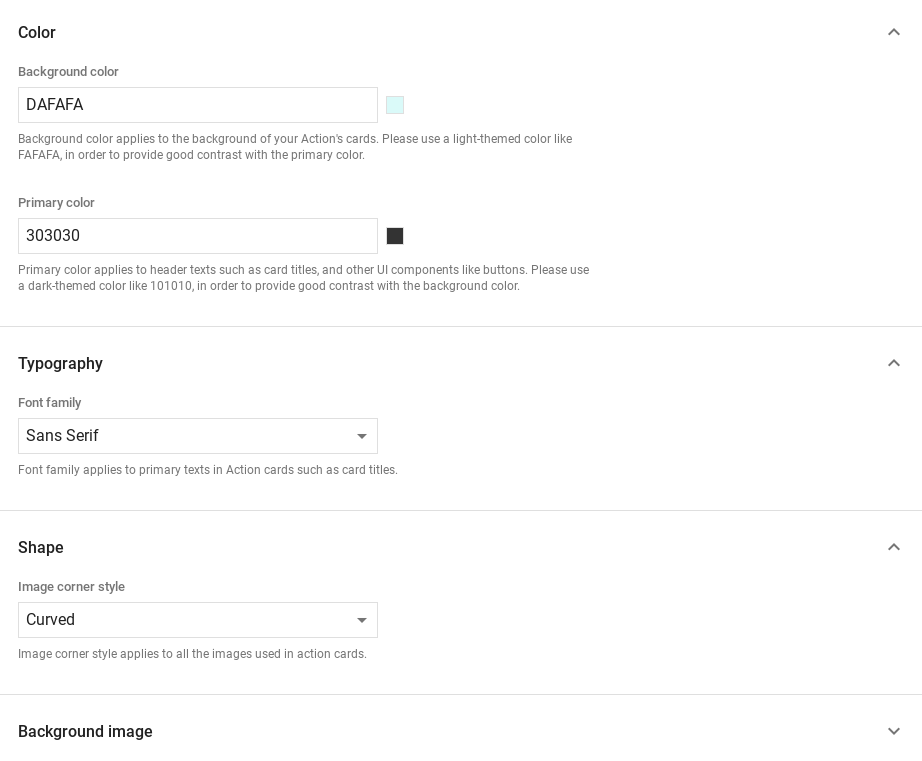

Como personalizar suas respostas

É possível mudar a aparência das suas respostas avançadas criando um tema personalizado. Se você definir um tema para o projeto do Actions, respostas detalhadas as ações do projeto serão estilizadas de acordo com o tema. Esta marca personalizada pode ser útil para definir uma aparência única para a conversa quando os usuários invoque suas ações em uma plataforma com uma tela.

Para definir um tema de resposta personalizado, faça o seguinte:

- No Console do Actions, acesse Desenvolver > Personalização do tema.

- Defina um ou todos os itens a seguir:

- A cor de fundo a ser usada como o plano de fundo dos seus cards. Em em geral, é melhor usar uma cor clara para o fundo, de modo que conteúdo seja fácil de ler.

- Cor primária é a cor principal dos seus cartões. textos de cabeçalho e interface os elementos. Em geral, você deve usar uma cor primária mais escura para contrastar em segundo plano.

- Família de fontes descreve o tipo de fonte usado para títulos e outros elementos de texto proeminentes.

- O estilo do canto da imagem pode alterar a aparência dos cards. cantos

- A imagem de plano de fundo usa uma imagem personalizada no lugar do plano de fundo cor Você precisa fornecer duas imagens diferentes para quando o dispositivo de superfície está no modo paisagem ou retrato, respectivamente. Observe que se você usar uma imagem de plano de fundo, a cor principal será definida como branco.

- Clique em Salvar.