परिचय

इस दस्तावेज़ में, जगहों की अहम जानकारी वाले डेटासेट, BigQuery में मौजूद सार्वजनिक जियोस्पेशल डेटा, और जगह की जानकारी देने वाले API को मिलाकर, साइट चुनने का समाधान बनाने का तरीका बताया गया है.

यह Google Cloud Next 2025 में दिए गए डेमो पर आधारित है. इसे YouTube पर देखा जा सकता है. इसके अलावा, Colab Notebook का एक उदाहरण भी उपलब्ध है. इसमें दस्तावेज़ में बताई गई प्रोसेस का कोड, रन करने के लिए तैयार फ़ॉर्मैट में मौजूद है.

कारोबार से जुड़ी चुनौती

मान लें कि आपकी कॉफ़ी शॉप की एक लोकप्रिय चेन है और आपको इसे किसी नए राज्य, जैसे कि नेवाडा में बढ़ाना है. हालांकि, वहां आपकी कोई कॉफ़ी शॉप नहीं है. नई जगह पर कारोबार शुरू करना एक बड़ा निवेश है. इसलिए, डेटा के आधार पर फ़ैसला लेना कारोबार की सफलता के लिए ज़रूरी है. शुरुआत कहां से करें?

इस गाइड में, कई चरणों में विश्लेषण करने का तरीका बताया गया है. इससे आपको नई कॉफ़ी शॉप के लिए सबसे सही जगह का पता लगाने में मदद मिलेगी. हम राज्य के हिसाब से डेटा देखना शुरू करेंगे. इसके बाद, हम खोज के दायरे को धीरे-धीरे कम करके किसी खास काउंटी और कमर्शियल ज़ोन तक ले जाएंगे. आखिर में, हम किसी इलाके के हिसाब से डेटा का विश्लेषण करेंगे, ताकि अलग-अलग इलाकों को स्कोर किया जा सके. साथ ही, प्रतिस्पर्धियों को मैप करके, मार्केट में मौजूद कमियों का पता लगाया जा सके.

समस्या हल करने से जुड़ा वर्कफ़्लो

इस प्रोसेस में एक लॉजिकल फ़नल का इस्तेमाल किया जाता है. यह फ़नल, बड़े स्तर पर शुरू होता है और खोज के दायरे को बेहतर बनाने के लिए, धीरे-धीरे ज़्यादा बारीकी से काम करता है. इससे, साइट को फ़ाइनल तौर पर चुनने में मदद मिलती है.

ज़रूरी शर्तें और एनवायरमेंट सेट अप करना

विश्लेषण शुरू करने से पहले, आपको कुछ ज़रूरी सुविधाओं वाला एनवायरमेंट चाहिए. इस गाइड में, SQL और Python का इस्तेमाल करके लागू करने का तरीका बताया गया है. हालांकि, सामान्य सिद्धांतों को अन्य टेक्नोलॉजी स्टैक पर भी लागू किया जा सकता है.

ज़रूरी शर्त के तौर पर, पक्का करें कि आपका एनवायरमेंट ये काम कर सकता हो:

- BigQuery में क्वेरी चलाना.

- Places Insights को ऐक्सेस करें. ज़्यादा जानकारी के लिए, Places Insights सेट अप करना लेख पढ़ें

bigquery-public-dataऔर US Census Bureau County Population Totals के सार्वजनिक डेटासेट की सदस्यता लें

आपको मैप पर जियोस्पेशल डेटा को विज़ुअलाइज़ करने की सुविधा भी चाहिए. यह सुविधा, विश्लेषण के हर चरण के नतीजों को समझने के लिए ज़रूरी है. इसे पाने के कई तरीके हैं. BigQuery से सीधे कनेक्ट होने वाले Looker Studio जैसे बीआई टूल का इस्तेमाल किया जा सकता है. इसके अलावा, Python जैसी डेटा साइंस की भाषाओं का भी इस्तेमाल किया जा सकता है.

राज्य के हिसाब से विश्लेषण: सबसे अच्छी काउंटी ढूंढना

हमारा पहला कदम, नेवाडा में सबसे ज़्यादा संभावना वाले काउंटी की पहचान करने के लिए, बड़े पैमाने पर विश्लेषण करना है. हम बेहतरीन जगह को ऐसे इलाके के तौर पर तय करेंगे जहां आबादी ज़्यादा हो और पहले से मौजूद रेस्टोरेंट की संख्या भी ज़्यादा हो. इससे पता चलता है कि वहां खाने-पीने की संस्कृति काफ़ी लोकप्रिय है.

हमारी BigQuery क्वेरी, Places Insights डेटासेट में उपलब्ध पते के कॉम्पोनेंट का इस्तेमाल करके ऐसा करती है. क्वेरी में, administrative_area_level_1_name फ़ील्ड का इस्तेमाल करके, डेटा को फ़िल्टर किया जाता है. इसमें सिर्फ़ नेवाडा राज्य में मौजूद रेस्टोरेंट शामिल होते हैं. इसके बाद, यह इस सेट को और बेहतर बनाता है, ताकि इसमें सिर्फ़ वे जगहें शामिल हों जहां टाइप ऐरे में 'restaurant' शामिल है. आखिर में, यह इन नतीजों को काउंटी के नाम (administrative_area_level_2_name) के हिसाब से ग्रुप करता है, ताकि हर काउंटी के लिए संख्या मिल सके. इस तरीके में, डेटासेट के बिल्ट-इन, पहले से इंडेक्स किए गए पते के स्ट्रक्चर का इस्तेमाल किया जाता है.

इस छोटे से उदाहरण में दिखाया गया है कि हम काउंटी की ज्यामिति को Places Insights के साथ कैसे जोड़ते हैं और किसी खास जगह के टाइप के लिए फ़िल्टर कैसे करते हैं, restaurant:

SELECT WITH AGGREGATION_THRESHOLD

administrative_area_level_2_name,

COUNT(*) AS restaurant_count

FROM

`places_insights___us.places`

WHERE

-- Filter for the state of Nevada

administrative_area_level_1_name = 'Nevada'

-- Filter for places that are restaurants

AND 'restaurant' IN UNNEST(types)

-- Filter for operational places only

AND business_status = 'OPERATIONAL'

-- Exclude rows where the county name is null

AND administrative_area_level_2_name IS NOT NULL

GROUP BY

administrative_area_level_2_name

ORDER BY

restaurant_count DESC

सिर्फ़ रेस्टोरेंट की संख्या से काम नहीं चलेगा. हमें जनसंख्या के डेटा के साथ इसका संतुलन बनाना होगा, ताकि हमें बाज़ार की सही जानकारी मिल सके और यह पता चल सके कि आगे क्या अवसर मिल सकते हैं. हम अमेरिकी जनगणना ब्यूरो के काउंटी की जनसंख्या के कुल डेटा का इस्तेमाल करेंगे.

इन दो अलग-अलग मेट्रिक (जगह की संख्या बनाम बड़ी आबादी की संख्या) की तुलना करने के लिए, हम मिन-मैक्स नॉर्मलाइज़ेशन का इस्तेमाल करते हैं. इस तकनीक से, दोनों मेट्रिक को एक ही रेंज (0 से 1) में स्केल किया जाता है. इसके बाद, हम इन दोनों को एक साथ normalized_score में जोड़ देते हैं. इससे तुलना को संतुलित रखने के लिए, हर मेट्रिक को 50% वेटेज मिलता है.

इस जवाब में, स्कोर का हिसाब लगाने के मुख्य लॉजिक को दिखाया गया है. इसमें सामान्य की गई जनसंख्या और रेस्टोरेंट की संख्या को शामिल किया जाता है:

(

-- Normalize restaurant count (scales to a 0-1 value) and apply 50% weight

SAFE_DIVIDE(restaurant_count - min_restaurants, max_restaurants - min_restaurants) * 0.5

+

-- Normalize population (scales to a 0-1 value) and apply 50% weight

SAFE_DIVIDE(population_2023 - min_pop, max_pop - min_pop) * 0.5

) AS normalized_score

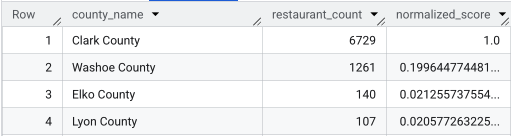

पूरी क्वेरी चलाने के बाद, काउंटी की सूची, रेस्टोरेंट की संख्या, जनसंख्या, और सामान्य स्कोर दिखाया जाता है. normalized_score

DESC के हिसाब से क्रम से लगाने पर, क्लार्क काउंटी को सबसे ज़्यादा वोट मिले हैं. इसलिए, आगे की जांच के लिए इसे सबसे ज़्यादा वोट पाने वाला विकल्प माना जाएगा.

इस स्क्रीनशॉट में, सामान्य किए गए स्कोर के हिसाब से टॉप चार काउंटी दिखाई गई हैं. इस उदाहरण में, जनसंख्या की कुल संख्या को जान-बूझकर शामिल नहीं किया गया है.

ज़िले के हिसाब से विश्लेषण: सबसे व्यस्त कमर्शियल ज़ोन ढूंढना

क्लार्क काउंटी की पहचान करने के बाद, अब हमें ज़ूम इन करके उन पिन कोड का पता लगाना है जहां सबसे ज़्यादा व्यावसायिक गतिविधि होती है. हमारी मौजूदा कॉफ़ी शॉप के डेटा के आधार पर, हमें पता है कि परफ़ॉर्मेंस तब बेहतर होती है, जब कॉफ़ी शॉप किसी ऐसी जगह पर हो जहां बड़े ब्रैंड की दुकानें ज़्यादा हों. इसलिए, हम इस जानकारी का इस्तेमाल, ज़्यादा फ़ुट ट्रैफ़िक के प्रॉक्सी के तौर पर करेंगे.

इस क्वेरी में, Places Insights में मौजूद brands टेबल का इस्तेमाल किया गया है. इसमें कुछ ब्रैंड के बारे में जानकारी होती है. इस टेबल से

क्वेरी की जा सकती है, ताकि इस्तेमाल किए जा सकने वाले ब्रैंड की सूची देखी जा सके. सबसे पहले, हम टारगेट किए जाने वाले ब्रैंड की सूची बनाते हैं. इसके बाद, इस सूची को जगहों की अहम जानकारी वाले मुख्य डेटासेट के साथ जोड़ते हैं. इससे हमें यह पता चलता है कि क्लार्क काउंटी के हर पिन कोड में, इन खास स्टोर में से कितने स्टोर आते हैं.

ऐसा करने का सबसे असरदार तरीका, दो चरणों वाला यह तरीका है:

- सबसे पहले, हम हर पिन कोड में मौजूद ब्रैंड की संख्या का पता लगाने के लिए, तेज़ी से और बिना किसी भौगोलिक जानकारी के एग्रीगेशन करेंगे.

- इसके बाद, हम उन नतीजों को सार्वजनिक डेटासेट से जोड़ेंगे, ताकि विज़ुअलाइज़ेशन के लिए मैप की सीमाएं मिल सकें.

postal_code_names फ़ील्ड का इस्तेमाल करके ब्रैंड की संख्या गिनना

पहली क्वेरी, गिनती करने के मुख्य लॉजिक को लागू करती है. यह क्लार्क काउंटी में मौजूद जगहों के लिए फ़िल्टर करता है. इसके बाद, postal_code_names ऐरे को अननेस्ट करता है, ताकि पिन कोड के हिसाब से ब्रैंड की संख्या को ग्रुप किया जा सके.

WITH brand_names AS (

-- First, select the chains we are interested in by name

SELECT

id,

name

FROM

`places_insights___us.brands`

WHERE

name IN ('7-Eleven', 'CVS', 'Walgreens', 'Subway Restaurants', "McDonald's")

)

SELECT WITH AGGREGATION_THRESHOLD

postal_code,

COUNT(*) AS total_brand_count

FROM

`places_insights___us.places` AS places_table,

-- Unnest the built-in postal code and brand ID arrays

UNNEST(places_table.postal_code_names) AS postal_code,

UNNEST(places_table.brand_ids) AS brand_id

JOIN

brand_names

ON brand_names.id = brand_id

WHERE

-- Filter directly on the administrative area fields in the places table

places_table.administrative_area_level_2_name = 'Clark County'

AND places_table.administrative_area_level_1_name = 'Nevada'

GROUP BY

postal_code

ORDER BY

total_brand_count DESC

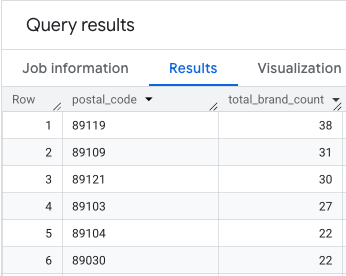

आउटपुट में, पिन कोड और उनके हिसाब से ब्रैंड की संख्या वाली टेबल मिलती है.

मैपिंग के लिए पिन कोड की ज्यामिति अटैच करना

अब हमारे पास गिनती है. इसलिए, हम विज़ुअलाइज़ेशन के लिए ज़रूरी पॉलीगॉन शेप पा सकते हैं. यह दूसरी क्वेरी, हमारी पहली क्वेरी को लेती है और उसे brand_counts_by_zip नाम के कॉमन टेबल एक्सप्रेशन (सीटीई) में रैप करती है. इसके बाद, इसके नतीजों को सार्वजनिक geo_us_boundaries.zip_codes table से जोड़ती है. इससे, पहले से कैलकुलेट की गई संख्याओं में ज्यामिति को आसानी से जोड़ा जा सकता है.

WITH brand_counts_by_zip AS (

-- This will be the entire query from the previous step, without the final ORDER BY (excluded for brevity).

. . .

)

-- Now, join the aggregated results to the boundaries table

SELECT

counts.postal_code,

counts.total_brand_count,

-- Simplify the geometry for faster rendering in maps

ST_SIMPLIFY(zip_boundaries.zip_code_geom, 100) AS geography

FROM

brand_counts_by_zip AS counts

JOIN

`bigquery-public-data.geo_us_boundaries.zip_codes` AS zip_boundaries

ON counts.postal_code = zip_boundaries.zip_code

ORDER BY

counts.total_brand_count DESC

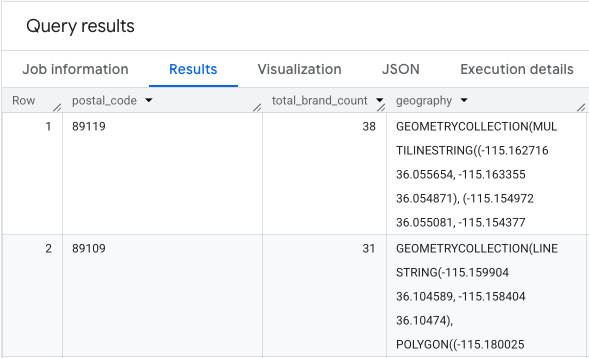

आउटपुट में पिन कोड, उनके ब्रैंड की संख्या, और पिन कोड की ज्यामिति की एक टेबल होती है.

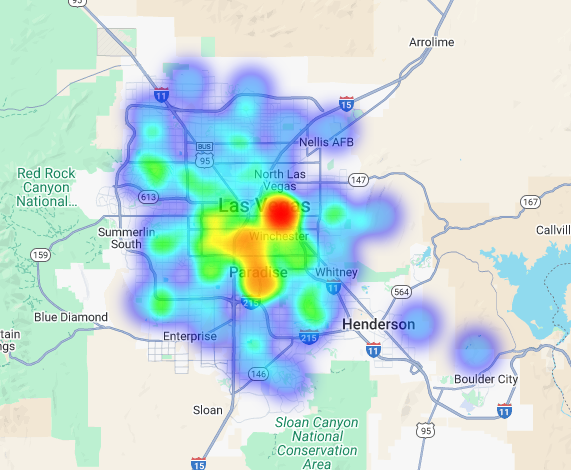

हम इस डेटा को हीटमैप के तौर पर विज़ुअलाइज़ कर सकते हैं. गहरे लाल रंग वाले इलाके, हमारे टारगेट किए गए ब्रैंड की ज़्यादा मौजूदगी दिखाते हैं. इससे हमें लास वेगास के सबसे ज़्यादा व्यावसायिक क्षेत्रों के बारे में पता चलता है.

हाइपर-लोकल विश्लेषण: अलग-अलग ग्रिड एरिया को स्कोर करना

लास वेगास के सामान्य इलाके की पहचान करने के बाद, अब बारी है बारीकी से विश्लेषण करने की. यहां हम अपने कारोबार से जुड़ी खास जानकारी को शामिल करते हैं. हम जानते हैं कि एक अच्छी कॉफ़ी शॉप, उन कारोबारों के आस-पास होती है जहां सुबह और दोपहर के समय ज़्यादा भीड़ होती है.

हमारी अगली क्वेरी में, हम ज़्यादा जानकारी मांग रहे हैं. इसकी शुरुआत, लास वेगास के मेट्रोपॉलिटन इलाके में बारीक हेक्सागोनल ग्रिड बनाने से होती है. इसके लिए, स्टैंडर्ड H3 जियोस्पेशल इंडेक्स (रिज़ॉल्यूशन 8 पर) का इस्तेमाल किया जाता है, ताकि इलाके का माइक्रो-लेवल पर विश्लेषण किया जा सके. क्वेरी में सबसे पहले, उन सभी कारोबारों की पहचान की जाती है जो सोमवार को सुबह 10 बजे से दोपहर 2 बजे तक खुले रहते हैं.

इसके बाद, हम हर जगह के टाइप के हिसाब से स्कोर असाइन करते हैं. हमारे लिए, आस-पास मौजूद रेस्टोरेंट, सुविधा स्टोर से ज़्यादा अहम है. इसलिए, इसे ज़्यादा मल्टीप्लायर मिलता है. इससे हमें हर छोटे इलाके के लिए, कस्टम suitability_score मिलता है.

इस छोटे से हिस्से में, वज़न के हिसाब से स्कोरिंग लॉजिक के बारे में बताया गया है. इसमें, कारोबार के खुले होने के समय की जांच के लिए, पहले से कैलकुलेट किए गए फ़्लैग (is_open_monday_window) का रेफ़रंस दिया गया है:

. . .

(

COUNTIF('restaurant' IN UNNEST(types) AND is_open_monday_window) * 8 +

COUNTIF('convenience_store' IN UNNEST(types) AND is_open_monday_window) * 3 +

COUNTIF('bar' IN UNNEST(types) AND is_open_monday_window) * 7 +

COUNTIF('tourist_attraction' IN UNNEST(types) AND is_open_monday_window) * 6 +

COUNTIF('casino' IN UNNEST(types) AND is_open_monday_window) * 7

) AS suitability_score

. . .

पूरी क्वेरी देखने के लिए बड़ा करें

-- This query calculates a custom 'suitability score' for different areas in the Las Vegas -- metropolitan area to identify prime commercial zones. It uses a weighted model based -- on the density of specific business types that are open during a target time window. -- Step 1: Pre-filter the dataset to only include relevant places. -- This CTE finds all places in our target localities (Las Vegas, Spring Valley, etc.) and -- adds a boolean flag 'is_open_monday_window' for those open during the target time. WITH PlacesInTargetAreaWithOpenFlag AS ( SELECT point, types, EXISTS( SELECT 1 FROM UNNEST(regular_opening_hours.monday) AS monday_hours WHERE monday_hours.start_time <= TIME '10:00:00' AND monday_hours.end_time >= TIME '14:00:00' ) AS is_open_monday_window FROM `places_insights___us.places` WHERE EXISTS ( SELECT 1 FROM UNNEST(locality_names) AS locality WHERE locality IN ('Las Vegas', 'Spring Valley', 'Paradise', 'North Las Vegas', 'Winchester') ) AND administrative_area_level_1_name = 'Nevada' ), -- Step 2: Aggregate the filtered places into H3 cells and calculate the suitability score. -- Each place's location is converted to an H3 index (at resolution 8). The query then -- calculates a weighted 'suitability_score' and individual counts for each business type -- within that cell. TileScores AS ( SELECT WITH AGGREGATION_THRESHOLD -- Convert each place's geographic point into an H3 cell index. `carto-os.carto.H3_FROMGEOGPOINT`(point, 8) AS h3_index, -- Calculate the weighted score based on the count of places of each type -- that are open during the target window. ( COUNTIF('restaurant' IN UNNEST(types) AND is_open_monday_window) * 8 + COUNTIF('convenience_store' IN UNNEST(types) AND is_open_monday_window) * 3 + COUNTIF('bar' IN UNNEST(types) AND is_open_monday_window) * 7 + COUNTIF('tourist_attraction' IN UNNEST(types) AND is_open_monday_window) * 6 + COUNTIF('casino' IN UNNEST(types) AND is_open_monday_window) * 7 ) AS suitability_score, -- Also return the individual counts for each category for detailed analysis. COUNTIF('restaurant' IN UNNEST(types) AND is_open_monday_window) AS restaurant_count, COUNTIF('convenience_store' IN UNNEST(types) AND is_open_monday_window) AS convenience_store_count, COUNTIF('bar' IN UNNEST(types) AND is_open_monday_window) AS bar_count, COUNTIF('tourist_attraction' IN UNNEST(types) AND is_open_monday_window) AS tourist_attraction_count, COUNTIF('casino' IN UNNEST(types) AND is_open_monday_window) AS casino_count FROM -- CHANGED: This now references the CTE with the expanded area. PlacesInTargetAreaWithOpenFlag -- Group by the H3 index to ensure all calculations are per-cell. GROUP BY h3_index ), -- Step 3: Find the maximum suitability score across all cells. -- This value is used in the next step to normalize the scores to a consistent scale (e.g., 0-10). MaxScore AS ( SELECT MAX(suitability_score) AS max_score FROM TileScores ) -- Step 4: Assemble the final results. -- This joins the scored tiles with the max score, calculates the normalized score, -- generates the H3 cell's polygon geometry for mapping, and orders the results. SELECT ts.h3_index, -- Generate the hexagonal polygon for the H3 cell for visualization. `carto-os.carto.H3_BOUNDARY`(ts.h3_index) AS h3_geography, ts.restaurant_count, ts.convenience_store_count, ts.bar_count, ts.tourist_attraction_count, ts.casino_count, ts.suitability_score, -- Normalize the score to a 0-10 scale for easier interpretation. ROUND( CASE WHEN ms.max_score = 0 THEN 0 ELSE (ts.suitability_score / ms.max_score) * 10 END, 2 ) AS normalized_suitability_score FROM -- A cross join is efficient here as MaxScore contains only one row. TileScores ts, MaxScore ms -- Display the highest-scoring locations first. ORDER BY normalized_suitability_score DESC;

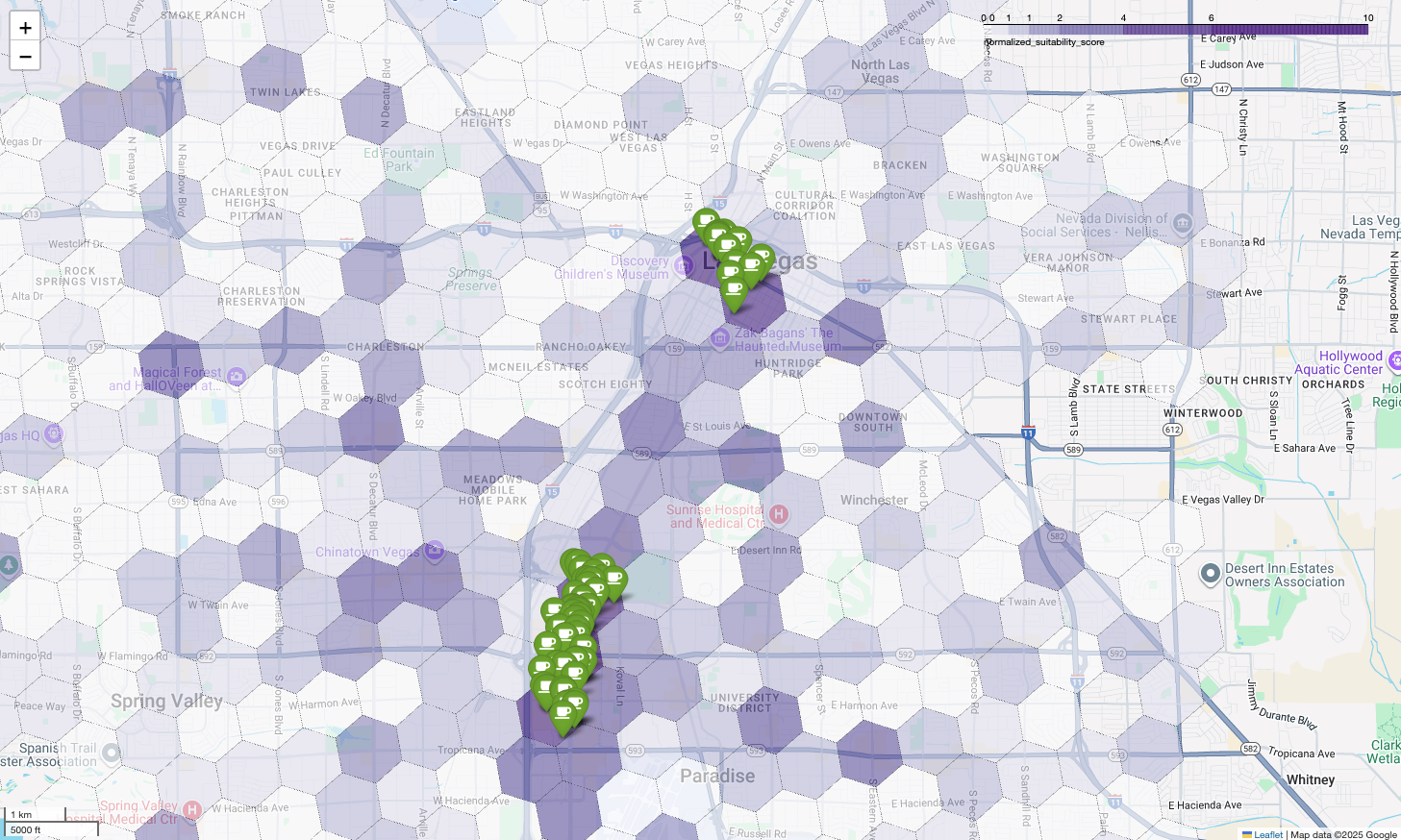

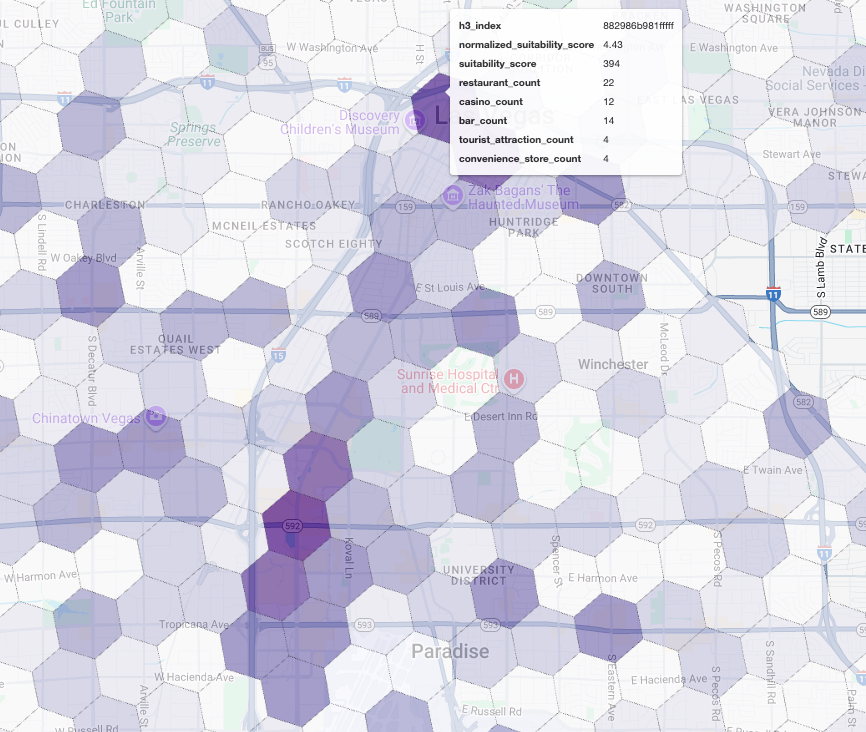

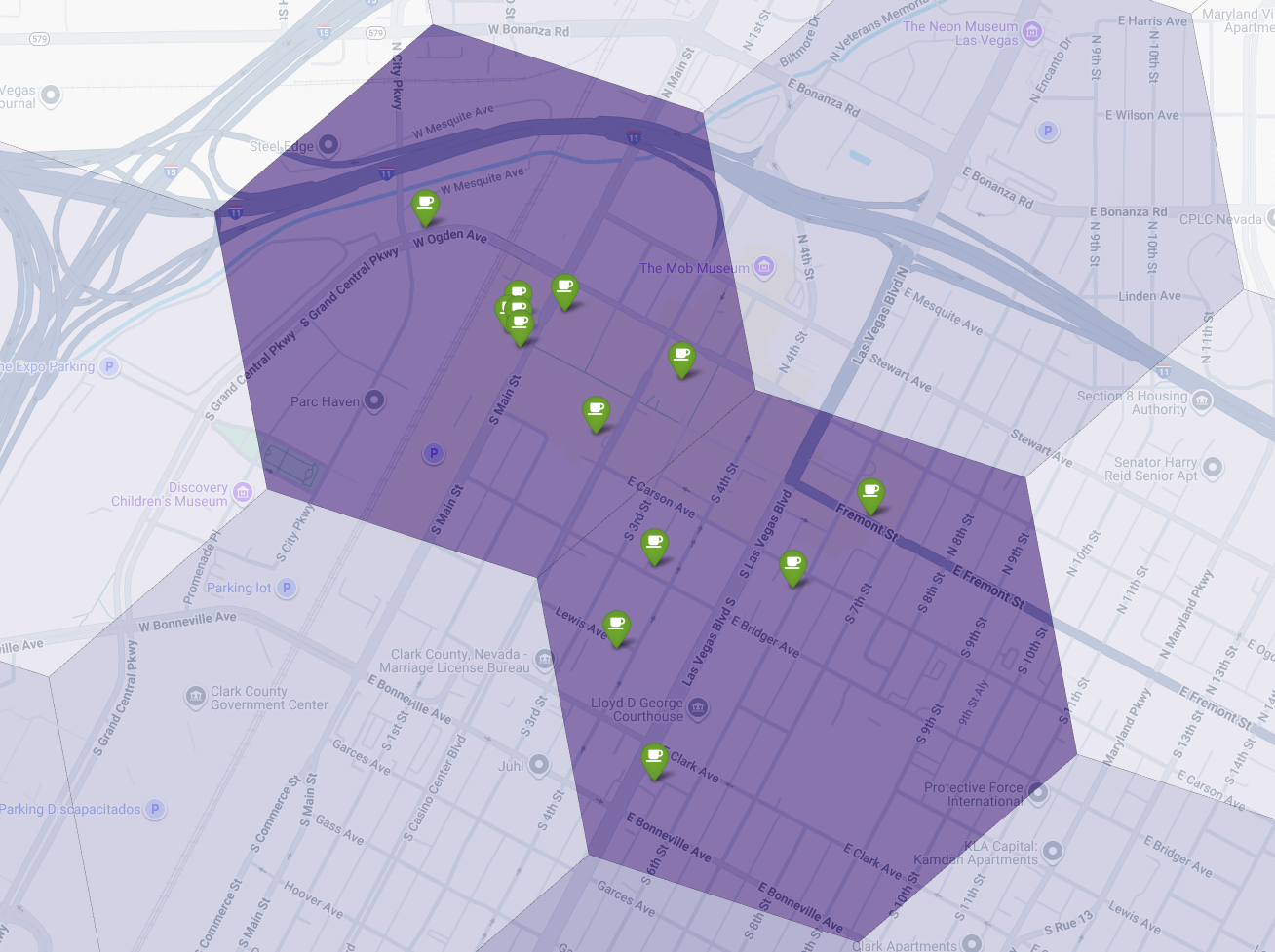

मैप पर इन स्कोर को विज़ुअलाइज़ करने से, साफ़ तौर पर पता चलता है कि कौनसी जगहें सबसे ज़्यादा लोकप्रिय हैं. सबसे गहरे बैंगनी रंग की टाइलें, मुख्य रूप से लास वेगास स्ट्रिप और डाउनटाउन के आस-पास हैं. ये ऐसे इलाके हैं जहां हमारी नई कॉफ़ी शॉप के लिए सबसे ज़्यादा संभावनाएं हैं.

प्रतिस्पर्धी कारोबार का विश्लेषण: मौजूदा कॉफ़ी शॉप की पहचान करना

हमारे सुइटेबिलिटी मॉडल ने सबसे ज़्यादा संभावना वाले ज़ोन की पहचान कर ली है. हालांकि, सिर्फ़ ज़्यादा स्कोर से सफलता की गारंटी नहीं मिलती. अब हमें इस डेटा को प्रतिस्पर्धी के डेटा के साथ ओवरले करना होगा. सबसे सही जगह वह होती है जहां कॉफ़ी शॉप की मांग ज़्यादा हो, लेकिन वहां पहले से कम कॉफ़ी शॉप मौजूद हों. ऐसा इसलिए, क्योंकि हम मार्केट में मौजूद अंतर को कम करना चाहते हैं.

इसके लिए, हम PLACES_COUNT_PER_H3 फ़ंक्शन का इस्तेमाल करते हैं. इस फ़ंक्शन को, H3 सेल के हिसाब से किसी तय भौगोलिक क्षेत्र में जगहों की संख्या दिखाने के लिए डिज़ाइन किया गया है.

सबसे पहले, हम पूरे लास वेगास मेट्रो क्षेत्र के लिए, डाइनैमिक तरीके से भौगोलिक जानकारी तय करते हैं.

हम सिर्फ़ एक इलाके पर भरोसा करने के बजाय, सार्वजनिक Overture Maps डेटासेट से क्वेरी करते हैं. इससे हमें लास वेगास और उसके आस-पास के मुख्य इलाकों की सीमाएं मिलती हैं. इसके बाद, हम इन सीमाओं को ST_UNION_AGG के साथ एक पॉलीगॉन में मर्ज कर देते हैं. इसके बाद, हम इस इलाके की जानकारी को फ़ंक्शन में पास करते हैं और उससे चालू सभी कॉफ़ी शॉप की गिनती करने के लिए कहते हैं.

इस क्वेरी में मेट्रो एरिया तय किया गया है. साथ ही, H3 सेल में कॉफ़ी शॉप की संख्या पाने के लिए फ़ंक्शन को कॉल किया गया है:

-- Define a variable to hold the combined geography for the Las Vegas metro area.

DECLARE las_vegas_metro_area GEOGRAPHY;

-- Set the variable by fetching the shapes for the five localities from Overture Maps

-- and merging them into a single polygon using ST_UNION_AGG.

SET las_vegas_metro_area = (

SELECT

ST_UNION_AGG(geometry)

FROM

`bigquery-public-data.overture_maps.division_area`

WHERE

country = 'US'

AND region = 'US-NV'

AND names.primary IN ('Las Vegas', 'Spring Valley', 'Paradise', 'North Las Vegas', 'Winchester')

);

-- Call the PLACES_COUNT_PER_H3 function with our defined area and parameters.

SELECT

*

FROM

`places_insights___us.PLACES_COUNT_PER_H3`(

JSON_OBJECT(

-- Use the metro area geography we just created.

'geography', las_vegas_metro_area,

-- Specify 'coffee_shop' as the place type to count.

'types', ["coffee_shop"],

-- Best practice: Only count places that are currently operational.

'business_status', ['OPERATIONAL'],

-- Set the H3 grid resolution to 8.

'h3_resolution', 8

)

);

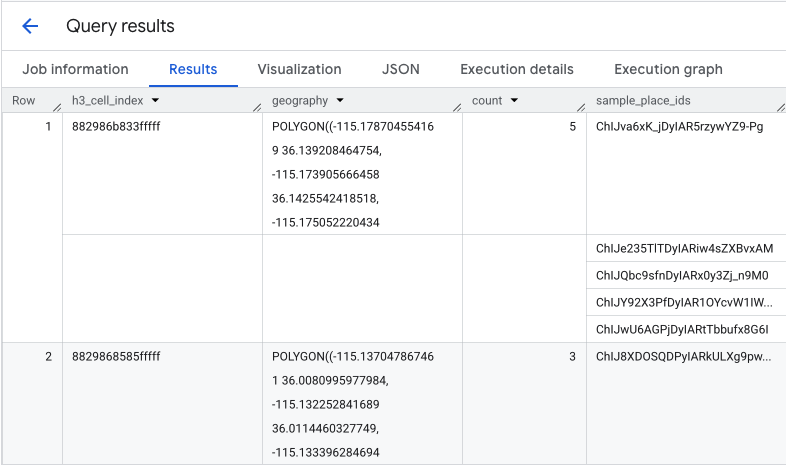

यह फ़ंक्शन एक टेबल दिखाता है. इसमें H3 सेल इंडेक्स, उसकी ज्यामिति, कॉफ़ी शॉप की कुल संख्या, और उनके प्लेस आईडी का सैंपल शामिल होता है:

कुल संख्या की जानकारी काम की होती है, लेकिन असल प्रतिस्पर्धियों को देखना ज़रूरी है.

इस चरण में, हम जगहों की अहम जानकारी वाले डेटासेट से Places API पर स्विच करते हैं. सबसे ज़्यादा नॉर्मलाइज़्ड सुटेबिलिटी स्कोर वाले सेल से sample_place_ids निकालकर, हम जगह की जानकारी देने वाले API को कॉल कर सकते हैं. इससे हमें हर प्रतिस्पर्धी के बारे में ज़्यादा जानकारी मिल सकती है. जैसे, उनका नाम, पता, रेटिंग, और जगह.

इसके लिए, पिछली क्वेरी के नतीजों की तुलना करनी होगी. पिछली क्वेरी के नतीजों के आधार पर ही, PLACES_COUNT_PER_H3 क्वेरी के लिए उपयुक्तता स्कोर जनरेट किया गया था. H3 सेल इंडेक्स का इस्तेमाल करके, कॉफ़ी शॉप की संख्या और आईडी पाए जा सकते हैं. ये आईडी, सबसे ज़्यादा नॉर्मलाइज़्ड सुटेबिलिटी स्कोर वाले सेल से मिलते हैं.

इस Python कोड से पता चलता है कि तुलना कैसे की जा सकती है.

# Isolate the Top 5 Most Suitable H3 Cells

top_suitability_cells = gdf_suitability.head(5)

# Extract the 'h3_index' values from these top 5 cells into a list.

top_h3_indexes = top_suitability_cells['h3_index'].tolist()

print(f"The top 5 H3 indexes are: {top_h3_indexes}")

# Now, we find the rows in our DataFrame where the

# 'h3_cell_index' matches one of the indexes from our top 5 list.

coffee_counts_in_top_zones = gdf_coffee_shops[

gdf_coffee_shops['h3_cell_index'].isin(top_h3_indexes)

]

अब हमारे पास उन कॉफ़ी शॉप के प्लेस आईडी की सूची है जो सबसे ज़्यादा मैच होने वाले स्कोर के साथ H3 सेल में पहले से मौजूद हैं. हर जगह के बारे में ज़्यादा जानकारी का अनुरोध किया जा सकता है.

इसके लिए, हर प्लेस आईडी के लिए सीधे तौर पर Place Details API को अनुरोध भेजा जा सकता है. इसके अलावा, कॉल करने के लिए क्लाइंट लाइब्रेरी का इस्तेमाल किया जा सकता है. सिर्फ़ ज़रूरी डेटा का अनुरोध करने के लिए, FieldMask पैरामीटर सेट करना न भूलें.

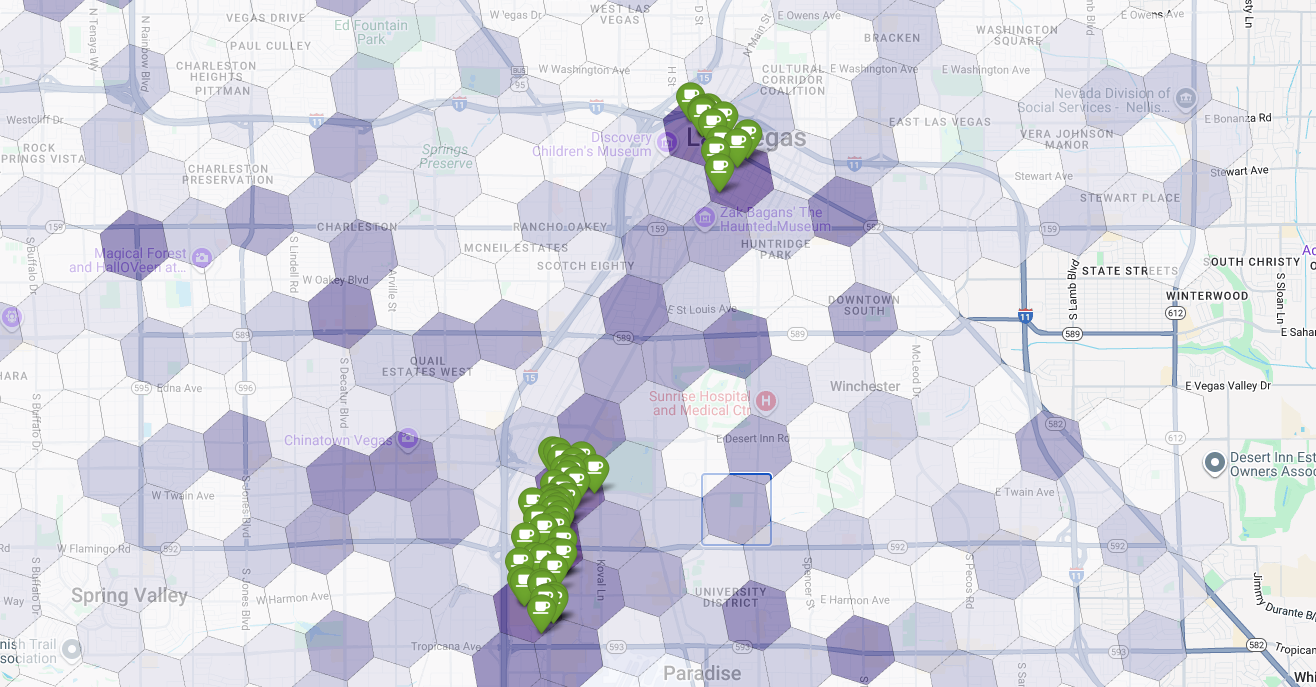

आखिर में, हम सभी को एक ही विज़ुअलाइज़ेशन में शामिल करते हैं. हम बैंगनी रंग के उपयुक्तता वाले क्लोरोप्लेथ मैप को बेस लेयर के तौर पर प्लॉट करते हैं. इसके बाद, Places API से मिली हर कॉफ़ी शॉप के लिए पिन जोड़ते हैं. इस आखिरी मैप में, हमारी पूरी जानकारी को एक नज़र में देखा जा सकता है: गहरे बैंगनी रंग वाले इलाके, संभावित जगहों को दिखाते हैं. वहीं, हरे पिन से मौजूदा बाज़ार की स्थिति का पता चलता है.

कुछ या बिना पिन वाले गहरे बैंगनी रंग के सेल ढूंढकर, हम उन जगहों का पता लगा सकते हैं जहां नया स्टोर खोलने से हमें सबसे ज़्यादा फ़ायदा होगा.

ऊपर दी गई दो सेल का सुटेबिलिटी स्कोर ज़्यादा है. हालांकि, इनमें कुछ कमियां हैं. ये कमियां, हमारी नई कॉफ़ी शॉप के लिए संभावित जगहें हो सकती हैं.

नतीजा

इस दस्तावेज़ में, हमने राज्य स्तर के सवाल कारोबार को कहां बढ़ाना है? से लेकर, डेटा पर आधारित स्थानीय जवाब तक की जानकारी दी है. अलग-अलग डेटासेट को लेयर करके और कारोबार की ज़रूरतों के हिसाब से लॉजिक लागू करके, कारोबार से जुड़े किसी बड़े फ़ैसले से जुड़े जोखिम को व्यवस्थित तरीके से कम किया जा सकता है. इस वर्कफ़्लो में, BigQuery के बड़े डेटासेट, जगहों की अहम जानकारी के डेटा, और Places API के रीयल-टाइम डेटा को एक साथ इस्तेमाल किया जाता है. इससे, किसी भी संगठन को रणनीतिक तौर पर आगे बढ़ने के लिए, लोकेशन इंटेलिजेंस का इस्तेमाल करने का एक बेहतरीन टेंप्लेट मिलता है.

अगले चरण

- इस वर्कफ़्लो को अपने कारोबार के लॉजिक, टारगेट किए गए इलाकों, और मालिकाना हक वाले डेटासेट के हिसाब से बनाएं.

- अपने मॉडल को और बेहतर बनाने के लिए, Places Insights डेटासेट में मौजूद अन्य डेटा फ़ील्ड एक्सप्लोर करें. जैसे, समीक्षाओं की संख्या, कीमत के लेवल, और उपयोगकर्ता की रेटिंग.

- इस प्रोसेस को अपने-आप होने वाली प्रोसेस में बदलें, ताकि साइट चुनने का एक इंटरनल डैशबोर्ड बनाया जा सके. इसका इस्तेमाल, नई मार्केट का आकलन करने के लिए किया जा सकता है.

दस्तावेज़ के बारे में ज़्यादा जानें:

योगदानकर्ता

हेनरिक वाल्व | DevX इंजीनियर