बैल की आवाज़.

19वीं इमेज. बैल.

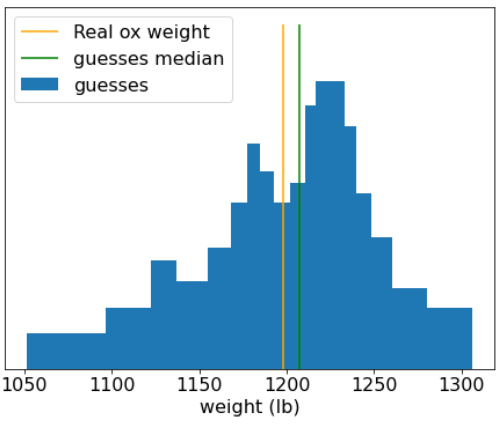

साल 1906 में, इंग्लैंड में वज़न तय करने की प्रतियोगिता आयोजित की गई थी. 787 लोगों ने बैल के वज़न का अनुमान लगाया. अलग-अलग अनुमानों के लिए, गड़बड़ी का औसत 37 पाउंड (3.1% की गड़बड़ी) था. हालांकि, अनुमान के आधार पर मिले वज़न का मीडियन, बैल के असल वज़न (1198 पाउंड) से सिर्फ़ 9 पाउंड कम था. यह सिर्फ़ 0.7% की गड़बड़ी थी.

20वीं इमेज. अलग-अलग वज़न के अनुमान का हिस्टोग्राम.

इस उदाहरण से कई लोगों की राय के बारे में पता चलता है: कुछ मामलों में, कई लोगों की राय से बहुत अच्छी जानकारी मिलती है.

गणितीय तौर पर, भीड़ की बुद्धि को सेंट्रल लिमिट थीओरम के साथ मॉडल किया जा सकता है: आम तौर पर, किसी वैल्यू और इस वैल्यू के N ग़लत अनुमान के औसत के बीच का स्क्वेयर्ड गड़बड़ी, 1/N फ़ैक्टर के साथ शून्य हो जाता है. हालांकि, अगर वैरिएबल इंडिपेंडेंट नहीं हैं, तो वैरिएंस ज़्यादा होता है.

मशीन लर्निंग में, एंसेंबल, मॉडल का एक कलेक्शन होता है. इन मॉडल से मिलने वाले अनुमान का औसत निकाला जाता है या उन्हें किसी तरह से एग्रीगेट किया जाता है. अगर एन्सेम्बल मॉडल अलग-अलग हों और किसी मॉडल की परफ़ॉर्मेंस बहुत खराब न हो, तो आम तौर पर एन्सेम्बल की क्वालिटी, हर मॉडल की क्वालिटी से बेहतर होती है. किसी एक मॉडल की तुलना में, किसी एन्सेम्बल को ट्रेनिंग और अनुमान लगाने में ज़्यादा समय लगता है. आखिरकार, आपको एक मॉडल के बजाय कई मॉडल पर ट्रेनिंग और अनुमान लगाना होगा.

आम तौर पर, किसी एन्सेम्बल के सबसे सही तरीके से काम करने के लिए, अलग-अलग मॉडल एक-दूसरे से अलग होने चाहिए. उदाहरण के लिए, एक ही तरह के 10 मॉडल (यानी कि बिल्कुल अलग नहीं) का एन्सेम्बल, अलग-अलग मॉडल से बेहतर नहीं होगा. दूसरी ओर, मॉडल को अलग-अलग बनाने पर, हो सकता है कि वे बेहतर न हों. असरदार तरीके से एसेम्बल करने के लिए, मॉडल के अलग-अलग होने और उसके सब-मॉडल की क्वालिटी के बीच संतुलन बनाना ज़रूरी है.