এটি একটি ষাঁড়।

চিত্র 19. একটি বলদ।

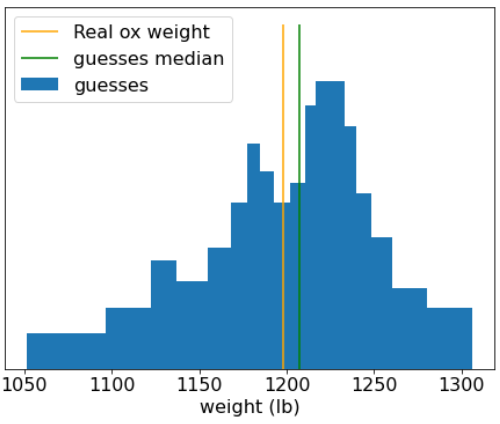

1906 সালে, ইংল্যান্ডে একটি ওজন বিচার প্রতিযোগিতা অনুষ্ঠিত হয় । 787 জন অংশগ্রহণকারী একটি ষাঁড়ের ওজন অনুমান করেছিলেন। স্বতন্ত্র অনুমানের মধ্যকার ত্রুটি ছিল 37 পাউন্ড (3.1% এর একটি ত্রুটি)। যাইহোক, অনুমানের সামগ্রিক মাঝামাঝি ষাঁড়ের প্রকৃত ওজন (1198 পাউন্ড) থেকে মাত্র 9 পাউন্ড দূরে ছিল, যা শুধুমাত্র 0.7% এর ত্রুটি ছিল।

চিত্র 20. স্বতন্ত্র ওজন অনুমানের হিস্টোগ্রাম।

এই উপাখ্যানটি জনতার বুদ্ধিকে চিত্রিত করে: কিছু পরিস্থিতিতে, সম্মিলিত মতামত খুব ভাল রায় প্রদান করে।

গাণিতিকভাবে, ভিড়ের জ্ঞান কেন্দ্রীয় সীমা উপপাদ্যের সাথে মডেল করা যেতে পারে: অনানুষ্ঠানিকভাবে, একটি মান এবং এই মানের গড় N নয়েজী অনুমানের মধ্যে বর্গক্ষেত্র ত্রুটি 1/N ফ্যাক্টর সহ শূন্যে থাকে। যাইহোক, যদি ভেরিয়েবলগুলি স্বাধীন না হয় তবে প্রকরণটি বেশি হয়।

মেশিন লার্নিং-এ, এনসেম্বল হল মডেলের একটি সংগ্রহ যার ভবিষ্যদ্বাণীগুলি গড় করা হয় (বা কোনোভাবে একত্রিত করা হয়)। যদি এনসেম্বল মডেলগুলি স্বতন্ত্রভাবে খুব খারাপ না হয়ে যথেষ্ট আলাদা হয়, তবে এনসেম্বলের গুণমান সাধারণত প্রতিটি পৃথক মডেলের মানের চেয়ে ভাল হয়। একটি ensemble একটি একক মডেল তুলনায় আরো প্রশিক্ষণ এবং অনুমান সময় প্রয়োজন. সর্বোপরি, আপনাকে একটি একক মডেলের পরিবর্তে একাধিক মডেলের প্রশিক্ষণ এবং অনুমান করতে হবে।

অনানুষ্ঠানিকভাবে, একটি ensemble সর্বোত্তম কাজ করার জন্য, পৃথক মডেলগুলি স্বাধীন হওয়া উচিত। একটি দৃষ্টান্ত হিসাবে, 10টি হুবহু একই মডেলের সমন্বয়ে গঠিত একটি ensemble (অর্থাৎ, সম্পূর্ণ স্বাধীন নয়) পৃথক মডেলের চেয়ে ভাল হবে না। অন্যদিকে, মডেলগুলিকে স্বাধীন হতে বাধ্য করার অর্থ তাদের আরও খারাপ করা হতে পারে। কার্যকরী এনসেম্বলিং এর জন্য মডেলের স্বাধীনতা এবং এর সাব-মডেলের মানের মধ্যে ভারসাম্য খুঁজে বের করতে হবে।