Android z rozwiązaniem AI

Usprawnij działanie aplikacji na Androida dzięki generatywnej AI

Dowiedz się, jak szybciej tworzyć aplikacje na Androida za pomocą Google

Na tej ścieżce dowiesz się, jak za pomocą technologii Google tworzyć bardziej angażujące aplikacje na Androida przy mniejszym nakładzie pracy. W następnych sekcjach utworzysz i ulepszisz hipotetyczną aplikację do przygotowywania posiłków – będzie to aplikacja zastępcza, która może być podobna do aplikacji, nad którą pracujesz obecnie jako deweloper aplikacji na Androida.

Dowiedz się, jak korzystać z Gemini w Android Studio, aby szybciej się uczyć i tworzyć aplikacje, jak używać Firebase do tworzenia warstw pamięci i logowania w aplikacji, jak stosować Gemini do tworzenia w aplikacji najnowocześniejszych funkcji generatywnej AI oraz jak korzystać z narzędzi takich jak Zdalna konfiguracja Firebase, Google Analytics i Crashlytics, aby wspierać aplikację w produkcji.

Dowiedz się, jak korzystać z Gemini w Android Studio, aby szybciej się uczyć i tworzyć aplikacje, jak używać Firebase do tworzenia warstw pamięci i logowania w aplikacji, jak stosować Gemini do tworzenia w aplikacji najnowocześniejszych funkcji generatywnej AI oraz jak korzystać z narzędzi takich jak Zdalna konfiguracja Firebase, Google Analytics i Crashlytics, aby wspierać aplikację w produkcji.

Pobudź swoją kreatywność dzięki Gemini w Android Studio

Tworzenie aplikacji na Androida jest teraz jeszcze łatwiejsze dzięki Gemini w Android Studio – Twojemu asystentowi programistycznemu opartym na AI.

Gemini w Android Studio integruje AI bezpośrednio z IDE, z którego korzystasz na co dzień, aby ułatwić i przyspieszyć tworzenie wysokiej jakości aplikacji na Androida. Pomaga Ci w tym przez cały cykl życia oprogramowania. Oznacza to, że możesz szybciej poznawać nowe koncepcje, łatwiej tworzyć prototypy i więcej czasu poświęcać na istotne części aplikacji.

Na początku tworzenia aplikacji na Androida dowiedz się, jak Gemini w Android Studio może przyspieszyć proces tworzenia.

Gemini w Android Studio integruje AI bezpośrednio z IDE, z którego korzystasz na co dzień, aby ułatwić i przyspieszyć tworzenie wysokiej jakości aplikacji na Androida. Pomaga Ci w tym przez cały cykl życia oprogramowania. Oznacza to, że możesz szybciej poznawać nowe koncepcje, łatwiej tworzyć prototypy i więcej czasu poświęcać na istotne części aplikacji.

Na początku tworzenia aplikacji na Androida dowiedz się, jak Gemini w Android Studio może przyspieszyć proces tworzenia.

Uczenie się Androida jest łatwiejsze dzięki pomocy AI

Jeśli dopiero zaczynasz korzystać z Androida lub konkretnych obszarów związanych z programowaniem na Androida, Gemini w Android Studio może być nieocenionym narzędziem do nauki.

- Szybkie uzyskiwanie odpowiedzi na pytania: możesz zadawać Gemini pytania dotyczące podstawowych pojęć związanych z Androidem, konkretnych interfejsów API lub sprawdzonych metod bezpośrednio w oknie czatu w Android Studio. Możesz na przykład zapytać „Co to jest ciemny motyw?” lub „Jakie jest najlepsze miejsce na ustawienie lokalizacji na Androidzie?”.

- Otrzymywanie przykładów kodu i wskazówek: Gemini może generować fragmenty kodu i zapewniać wskazówki dotyczące implementowania różnych funkcji, takich jak dodawanie obsługi aparatu czy tworzenie bazy danych Room. Możesz nawet poprosić o kod w języku Kotlin lub konkretnie w Jetpack Compose.

- Interpretowanie błędów i znajdowanie ich rozwiązań: jeśli napotkasz błędy kompilacji lub synchronizacji, możesz poprosić Gemini o wyjaśnienie i sugestie dotyczące ich rozwiązania. Gemini może też pomagać w analizowaniu raportów o awariach z Raportów o jakości aplikacji, podając podsumowania i zalecając dalsze działania.

Ulepszone korzyści dla zespołów dzięki Gemini w Studio dla firm

Indywidualna wersja Gemini w Android Studio jest bezpłatna w wersji testowej.

Jednak w przypadku rozwoju w środowiskach dużych zespołów o wymagających zasadach ochrony prywatności i zarządzania Gemini w Studio dla firm oferuje dodatkowe korzyści, w tym ulepszone funkcje ochrony prywatności, zabezpieczeń i dostosowywania kodu. Można go też używać w ramach środków na Google Cloud.

Wraz z Gemini Code Assist te narzędzia umożliwiają zespołom korzystanie z możliwości AI z pewną ręką, zaspokajają też najważniejsze potrzeby związane z prywatnością, bezpieczeństwem i zarządzaniem.

Jednak w przypadku rozwoju w środowiskach dużych zespołów o wymagających zasadach ochrony prywatności i zarządzania Gemini w Studio dla firm oferuje dodatkowe korzyści, w tym ulepszone funkcje ochrony prywatności, zabezpieczeń i dostosowywania kodu. Można go też używać w ramach środków na Google Cloud.

Wraz z Gemini Code Assist te narzędzia umożliwiają zespołom korzystanie z możliwości AI z pewną ręką, zaspokajają też najważniejsze potrzeby związane z prywatnością, bezpieczeństwem i zarządzaniem.

Elementy składowe Firebase w aplikacji

Wspólne funkcje stosowane w procesie tworzenia aplikacji, takie jak przechowywanie w chmurze, uwierzytelnianie użytkowników i zgłaszanie awarii, są niezbędnymi komponentami podczas tworzenia i eksploatacji aplikacji.

Firebase upraszcza proces tworzenia aplikacji na Androida, udostępniając te podstawowe elementy, dzięki czemu nie musisz wdrażać własnego backendu.

Firebase upraszcza proces tworzenia aplikacji na Androida, udostępniając te podstawowe elementy, dzięki czemu nie musisz wdrażać własnego backendu.

Cloud Firestore

Jeśli na przykład tworzysz aplikację do przygotowywania potraw, musisz przechowywać przepisy, plany posiłków i listy składników poza urządzeniem (na wypadek, gdyby użytkownik zmienił telefon). Możesz zapisać te dane w Cloud Firestore.

Cloud Firestore to skalowalna baza danych NoSQL w chmurze oferowana przez Firebase i Google Cloud. Umożliwia ona synchronizację danych w czasie rzeczywistym w aplikacji klienta za pomocą odbiorców w czasie rzeczywistym. Zapewnia też obsługę offline na urządzeniach mobilnych i w internecie, co zapewnia responsywność aplikacji niezależnie od dostępności sieci. Łatwo integruje się z innymi usługami Firebase i Google Cloud, w tym z Cloud Functions.

Cloud Firestore to skalowalna baza danych NoSQL w chmurze oferowana przez Firebase i Google Cloud. Umożliwia ona synchronizację danych w czasie rzeczywistym w aplikacji klienta za pomocą odbiorców w czasie rzeczywistym. Zapewnia też obsługę offline na urządzeniach mobilnych i w internecie, co zapewnia responsywność aplikacji niezależnie od dostępności sieci. Łatwo integruje się z innymi usługami Firebase i Google Cloud, w tym z Cloud Functions.

Authentication

Uwierzytelnianie użytkowników jest niezbędne, aby umożliwić użytkownikom, którzy zmieniają urządzenia, dostęp do ich danych. Dzięki temu inni nie będą mieć do nich dostępu.

Uwierzytelnianie Firebase to potężne narzędzie, które upraszcza dodawanie uwierzytelniania użytkowników w aplikacjach na Androida. Udostępnia on usługi backendowe i pakiet SDK z gotowymi bibliotekami interfejsu użytkownika, które obsługują różne metody uwierzytelniania, m.in. logowanie za pomocą adresu e-mail i hasła, uwierzytelnianie za pomocą numeru telefonu oraz integrację z popularnymi dostawcami tożsamości sfederowanej, takimi jak Google, Facebook i Twitter.

Uwierzytelnianie Firebase to potężne narzędzie, które upraszcza dodawanie uwierzytelniania użytkowników w aplikacjach na Androida. Udostępnia on usługi backendowe i pakiet SDK z gotowymi bibliotekami interfejsu użytkownika, które obsługują różne metody uwierzytelniania, m.in. logowanie za pomocą adresu e-mail i hasła, uwierzytelnianie za pomocą numeru telefonu oraz integrację z popularnymi dostawcami tożsamości sfederowanej, takimi jak Google, Facebook i Twitter.

Zgłaszanie awarii

Monitorowanie błędów i awarii jest niezbędne, aby zapewnić stabilność i skuteczność aplikacji. Aplikacja, która się zawiesza, frustruje użytkowników i zostaje odinstalowana.

Firebase Crashlytics to narzędzie do zgłaszania awarii w czasie rzeczywistym, które ułatwia śledzenie i rozwiązywanie problemów ze stabilnością, które obniżają jakość aplikacji. Oszczędza czas potrzebny na rozwiązywanie problemów dzięki inteligentnemu grupowaniu awarii i wskazywaniu okoliczności, które do nich prowadzą.

Zarówno Cloud Firestore, jak i Firebase Authentication oferują obszerne bezpłatne poziomy. Jeśli jednak Twoja aplikacja wymaga większej puli lub zaawansowanych funkcji tych usług, musisz wykupić płatny abonament. Nie martw się jednak – możesz pokryć te koszty za pomocą środków z Google Cloud. Crashlytics jest bezpłatny niezależnie od tego, jak często z niego korzystasz.

Aby dowiedzieć się więcej o innych rozwiązaniach Firebase, odwiedź witrynę Firebase.

Firebase Crashlytics to narzędzie do zgłaszania awarii w czasie rzeczywistym, które ułatwia śledzenie i rozwiązywanie problemów ze stabilnością, które obniżają jakość aplikacji. Oszczędza czas potrzebny na rozwiązywanie problemów dzięki inteligentnemu grupowaniu awarii i wskazywaniu okoliczności, które do nich prowadzą.

Zarówno Cloud Firestore, jak i Firebase Authentication oferują obszerne bezpłatne poziomy. Jeśli jednak Twoja aplikacja wymaga większej puli lub zaawansowanych funkcji tych usług, musisz wykupić płatny abonament. Nie martw się jednak – możesz pokryć te koszty za pomocą środków z Google Cloud. Crashlytics jest bezpłatny niezależnie od tego, jak często z niego korzystasz.

Aby dowiedzieć się więcej o innych rozwiązaniach Firebase, odwiedź witrynę Firebase.

scope.launch { val response = model.generateContent( "Create a shopping list with $cuisineStyle ingredients") }

W przypadku przykładowej aplikacji z przepisami Gemini 2.0 Flash może utworzyć listę zakupów ze składnikami do dania z określonego rodzaju kuchni. Możesz nawet poprosić model o wygenerowanie ciągu JSON, który można łatwo przeanalizować w aplikacji, aby wyświetlić go w interfejsie. Aby wygenerować listę, wywołaj funkcję generateContent() z promptem tekstowym.

Aby dowiedzieć się więcej, zapoznaj się z przewodnikiem dla programistów aplikacji na Androida.

Aby dowiedzieć się więcej, zapoznaj się z przewodnikiem dla programistów aplikacji na Androida.

Generatywna AI na Androidzie

Integrację generatywnej AI w naszej aplikacji do przygotowywania posiłków na Androida można przeprowadzić na różne sposoby. Oto krótkie omówienie każdej z nich:

Gemini Nano na Androidzie

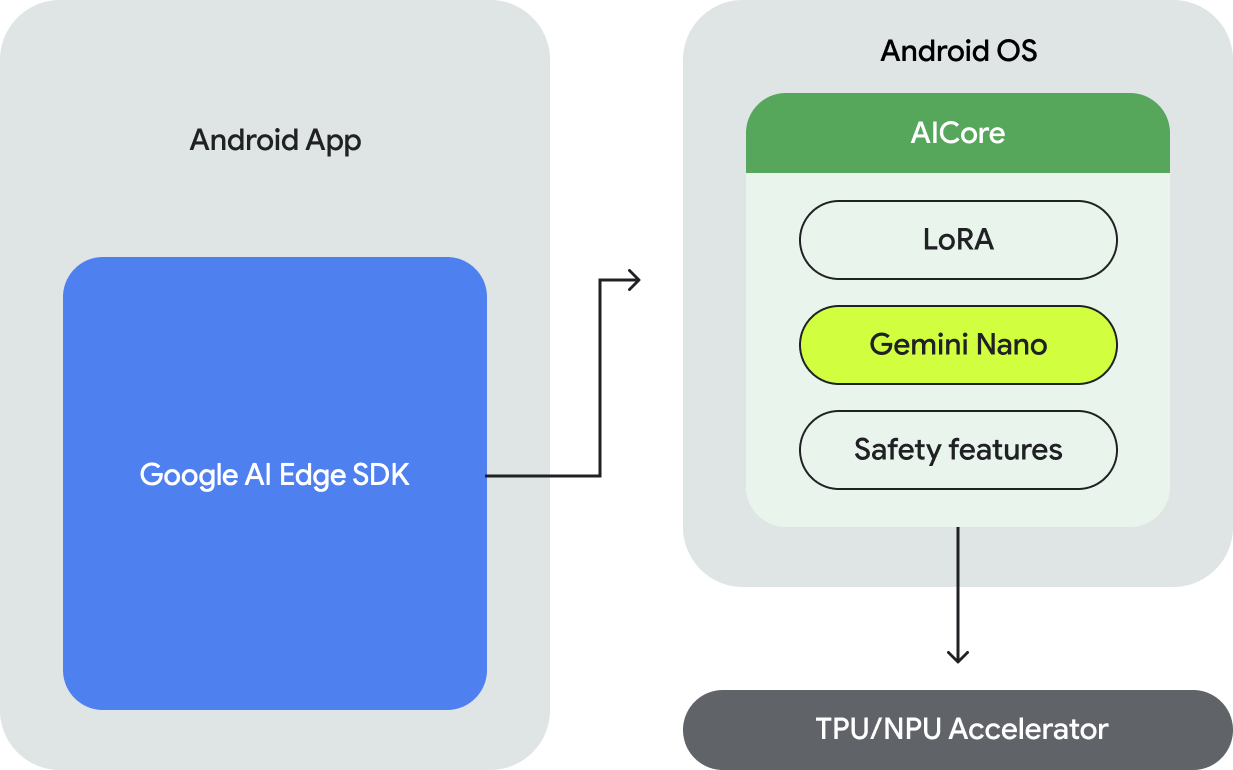

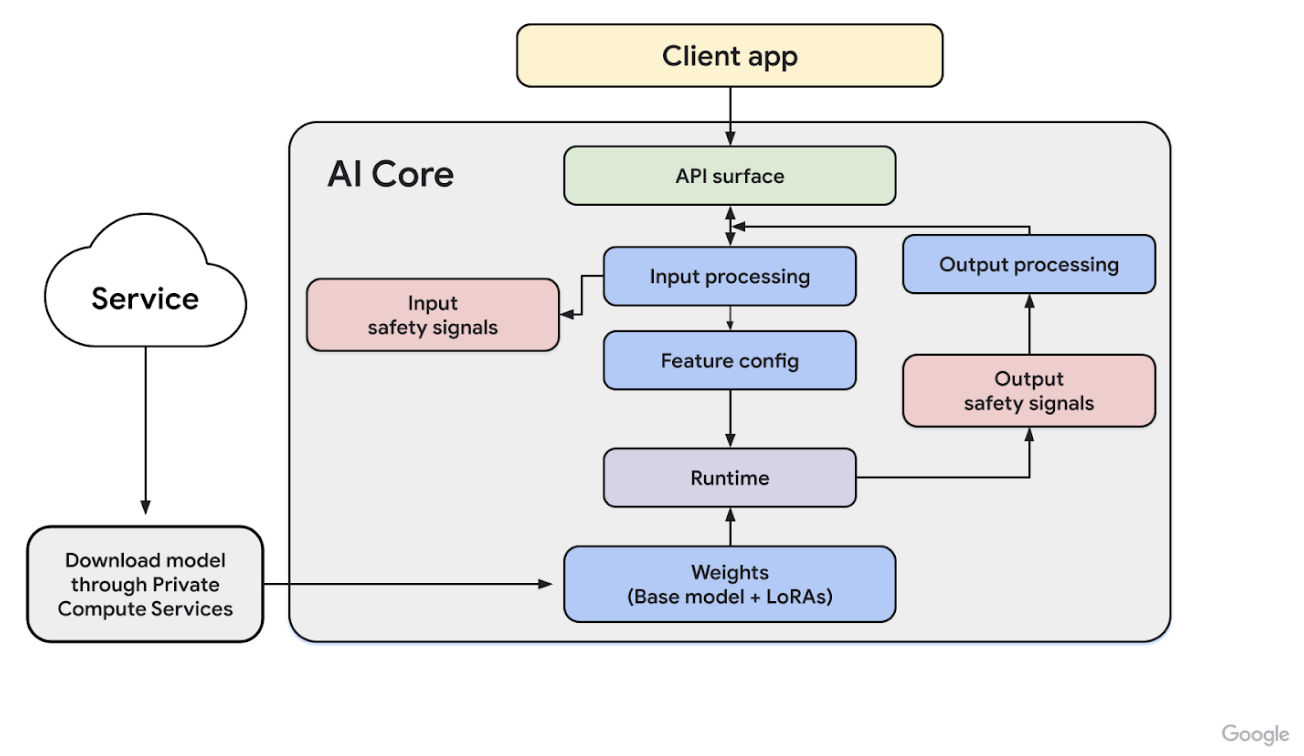

Gemini Nano to model z rodziny Gemini zoptymalizowany do działania na urządzeniu. Jest ona bezpośrednio zintegrowana z systemem Android za pomocą AICore. Możesz go używać do korzystania z generatywnej AI bez konieczności łączenia się z siecią ani wysyłania danych do chmury.

AI na urządzeniu to świetna opcja w przypadku zastosowań, w których najważniejsze są niskie opóźnienia, niskie koszty i zabezpieczenia dotyczące prywatności. Na przykład w aplikacji do planowania posiłków Gemini Nano może sugerować pomysły na dania na podstawie różnych kuchni i historii posiłków użytkownika.

Więcej informacji o architekturze technicznej Gemini Nano znajdziesz w dokumentacji Androida.

Aby eksperymentować z Gemini Nano w swojej aplikacji, zapoznaj się z poniżej podanymi informacjami o Gemini Nano na urządzeniu z eksperymentalnym Google AI Edge SDK.

AI na urządzeniu to świetna opcja w przypadku zastosowań, w których najważniejsze są niskie opóźnienia, niskie koszty i zabezpieczenia dotyczące prywatności. Na przykład w aplikacji do planowania posiłków Gemini Nano może sugerować pomysły na dania na podstawie różnych kuchni i historii posiłków użytkownika.

Więcej informacji o architekturze technicznej Gemini Nano znajdziesz w dokumentacji Androida.

Aby eksperymentować z Gemini Nano w swojej aplikacji, zapoznaj się z poniżej podanymi informacjami o Gemini Nano na urządzeniu z eksperymentalnym Google AI Edge SDK.

Imagen i Gemini Pro oraz Flash: modele Google GenAI w chmurze

Modele generatywnej AI zoptymalizowane pod kątem działania w chmurze są zazwyczaj bardziej wydajne niż modele AI na urządzeniu.

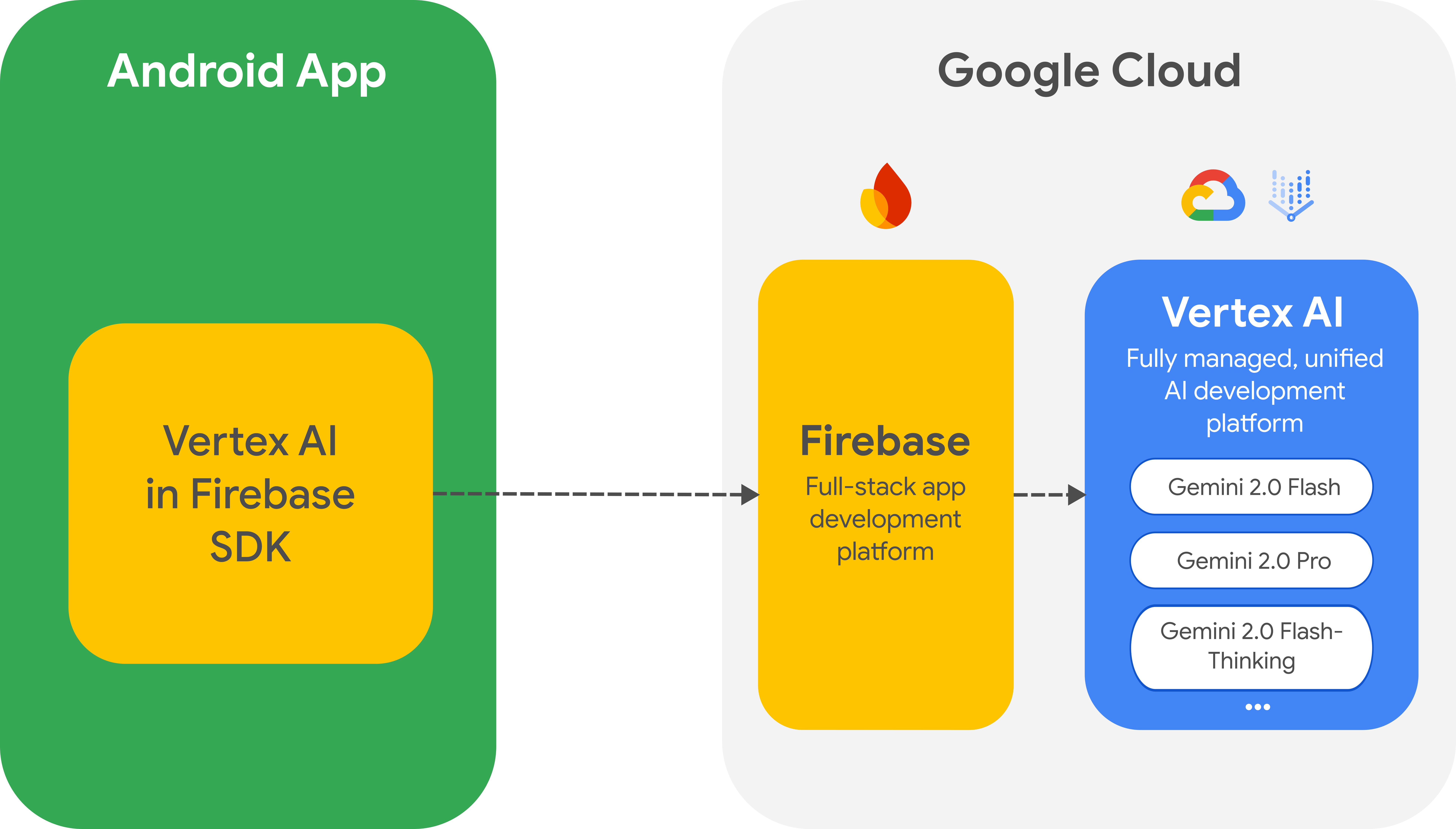

Jeśli jesteś deweloperem Androida, możesz korzystać z Vertex AI w Firebase, aby szybko wdrażać funkcje generatywnej AI w swojej aplikacji na Androida. Do zadań związanych z generowaniem tekstu możesz używać modeli Gemini Pro i Flash, a do zadań związanych z generowaniem obrazów – modelu Imagen.

Jeśli jesteś deweloperem Androida, możesz korzystać z Vertex AI w Firebase, aby szybko wdrażać funkcje generatywnej AI w swojej aplikacji na Androida. Do zadań związanych z generowaniem tekstu możesz używać modeli Gemini Pro i Flash, a do zadań związanych z generowaniem obrazów – modelu Imagen.

Gemini Pro i Flash

Rodzina modeli AI Gemini Pro i Flash to modele multimodalne, które mogą wykonywać wiele zadań. Modele te przyjmują dane wejściowe w postaci obrazu, dźwięku i filmu, a następnie generują dane wyjściowe w formacie JSON, XML lub CSV. Najnowsze modele Gemini mogą nawet generować multimodalne dane wyjściowe, takie jak dźwięk i obrazy.

Na przykład w aplikacji do przygotowywania posiłków możesz użyć modelu Gemini, aby utworzyć listę zakupów z składnikami do konkretnego rodzaju kuchni.

Możesz też pokryć koszty tych wywołań do modeli Gemini z wykorzystaniem środków na Google Cloud.

Aby dowiedzieć się, jak używać w aplikacji modeli Gemini hostowanych w chmurze, zapoznaj się z poniższym krokiem dotyczącym Gemini w Vertex AI w Firebase.

Na przykład w aplikacji do przygotowywania posiłków możesz użyć modelu Gemini, aby utworzyć listę zakupów z składnikami do konkretnego rodzaju kuchni.

Możesz też pokryć koszty tych wywołań do modeli Gemini z wykorzystaniem środków na Google Cloud.

Aby dowiedzieć się, jak używać w aplikacji modeli Gemini hostowanych w chmurze, zapoznaj się z poniższym krokiem dotyczącym Gemini w Vertex AI w Firebase.

Imagen 3

Imagen 3 to najnowszy model Google do generowania obrazów. Możesz uzyskać do niego dostęp za pomocą Vertex AI w Firebase, co pozwoli Ci szybko i bezproblemowo dodać do aplikacji na Androida funkcje generowania obrazów.

Na przykład w aplikacji do przygotowywania posiłków możesz użyć modelu Imagen 3 do generowania ilustracji przepisów.

Koszt może być pokrywany przez Twoje środki w Google Cloud.

Aby dowiedzieć się, jak korzystać z modelu Imagen 3 w aplikacji, przeczytaj poniższy krok dotyczący generowania obrazów za pomocą tego modelu.

Na przykład w aplikacji do przygotowywania posiłków możesz użyć modelu Imagen 3 do generowania ilustracji przepisów.

Koszt może być pokrywany przez Twoje środki w Google Cloud.

Aby dowiedzieć się, jak korzystać z modelu Imagen 3 w aplikacji, przeczytaj poniższy krok dotyczący generowania obrazów za pomocą tego modelu.

Integracja backendu

Możesz też dodać funkcje generatywnej AI za pomocą integracji z backendem:

- Genkit to platforma typu open source, która upraszcza tworzenie, wdrażanie i monitorowanie aplikacji opartych na AI.

- Aby zaspokoić bardziej zaawansowane potrzeby związane z MLOps, Vertex AI w Google Cloud oferuje w pełni zarządzane usługi oraz bogatą ofertę modeli w bazie modeli Vertex AI. Możesz też wykorzystać środki Google Cloud na pokrycie kosztów tych usług.

Rozwiązania niestandardowe na urządzeniu

Jeśli chcesz przeprowadzać wnioskowanie AI na urządzeniu oprócz Gemini Nano, możesz też eksperymentować z LiteRT i MediaPipe:

Aby dowiedzieć się więcej o ofercie generatywnej AI na Androida, przeczytaj sekcję AI w dokumentacji Androida.

- LiteRT (dawniej TFLite) to wydajne środowisko wykonawcze Google do korzystania z AI na urządzeniu, które zostało zaprojektowane pod kątem efektywnego uruchamiania modeli uczenia maszynowego bezpośrednio na urządzeniach.

- MediaPipe to platforma typu open source, która umożliwia programistom tworzenie potoku uczenia maszynowego do przetwarzania danych multimedialnych, takich jak wideo i dźwięk, w czasie rzeczywistym.

Aby dowiedzieć się więcej o ofercie generatywnej AI na Androida, przeczytaj sekcję AI w dokumentacji Androida.

Eksperymentalny dostęp do Gemini Nano na urządzeniu

Pakiet Google AI Edge SDK umożliwia deweloperom aplikacji na Androida integrację z funkcjami generatywnej AI na urządzeniu Gemini Nano i eksperymentowanie z nimi w celu ulepszania aplikacji.

Oto, jak zacząć:

- Dołącz do grupy aicore-experimental w Google

- Dołącz do programu testowania Androida AICore

. Po wykonaniu tych czynności nazwa aplikacji AICore w Sklepie Play (w sekcji zarządzania aplikacjami i urządzeniami) powinna zmienić się z „Android AICore” na „Android AICore (beta)”.

- Wykonaj te czynności, aby sprawdzić, czy pliki APK i binarne zostały prawidłowo pobrane na urządzenie.

- Następnie zaktualizuj konfigurację Gradle aplikacji, dodając tę zależność:

implementation("com.google.ai.edge.aicore:aicore:0.0.1-exp01")

Upewnij się, że minimalna wersja pakietu SDK została ustawiona na 31.

implementation("com.google.ai.edge.aicore:aicore:0.0.1-exp01")

Następnie możesz skonfigurować model, aby kontrolować jego odpowiedzi. Polega to na podaniu kontekstu i opcjonalnym ustawieniu tych parametrów:

- Temperatura: określa poziom losowości. Wyższe wartości powodują większą różnorodność wyników.

- Top K: określa liczbę tokenów o najwyższym priorytecie, które mają być brane pod uwagę podczas generowania danych wyjściowych.

- Liczba kandydatów: określa maksymalną liczbę odpowiedzi do zwrócenia.

- Maksymalna liczba tokenów wyjściowych: określa maksymalną długość odpowiedzi.

val generationConfig = generationConfig { context = ApplicationProvider.getApplicationContext() temperature = 0.2f topK = 16 maxOutputTokens = 256 }

utworzyć opcjonalną funkcję

downloadCallback. Ta funkcja wywołania zwrotnego służy do pobierania modelu. Zwraca też komunikaty, które można wykorzystać do debugowania.

Wygeneruj obiekt GenerativeModel za pomocą wcześniej utworzonych konfiguracji generowania i opcjonalnego pobierania.

val downloadConfig = DownloadConfig(downloadCallback) val generativeModel = GenerativeModel( generationConfig = generationConfig, downloadConfig = downloadConfig // optional )

Na koniec uruchom wnioskowanie, przekazując prompt do modelu. Upewnij się, że funkcja

W ramach przykładowej aplikacji do przygotowywania posiłków Gemini Nano może zainspirować do stworzenia dania, sugerując różne rodzaje kuchni i dania, które różnią się od historii posiłków.

GenerativeModel.generateContent() znajduje się w odpowiednim zakresie współbieżnej funkcji, ponieważ jest to funkcja zawieszania. W ramach przykładowej aplikacji do przygotowywania posiłków Gemini Nano może zainspirować do stworzenia dania, sugerując różne rodzaje kuchni i dania, które różnią się od historii posiłków.

scope.launch { val input = "Suggest different types of cuisines and easy to cook dishes that are not $recentMealList" val response = generativeModel.generateContent(input) print(response.text) }

Model Gemini Nano ma maksymalny limit tokenów wejściowych wynoszący 12 000. Więcej informacji o dostępie do eksperymentalnej wersji Gemini Nano znajdziesz w sekcji Gemini Nano w dokumentacji Androida.

Gemini w Vertex AI w Firebase

Korzystanie z Vertex AI w Firebase umożliwia tworzenie funkcji opartych na generatywnej AI przy użyciu modeli Gemini Cloud, a także płynne wdrażanie i zarządzanie ekosystemem Firebase.

dependencies { ... // Import the BoM for the Firebase platform implementation(platform("com.google.firebase:firebase-bom:" )) // Add the dependency for the Vertex AI in Firebase library // When using the BoM, you don't specify versions in Firebase // library dependencies implementation("com.google.firebase:firebase-vertexai") }

Zacznij od eksperymentowania z promptami w Vertex AI Studio. Jest to interaktywny interfejs do projektowania promptów i tworzenia prototypów. Możesz przesyłać pliki, aby testować prompty z tekstem i obrazami, oraz zapisywać prompty, aby wrócić do nich później.

Gdy zechcesz wywołać interfejs API Gemini z aplikacji, skonfiguruj Firebase i pakiet SDK zgodnie z instrukcjami w przewodniku Vertex AI w Firebase.

Następnie dodaj do projektu zależność Gradle:

Gdy zechcesz wywołać interfejs API Gemini z aplikacji, skonfiguruj Firebase i pakiet SDK zgodnie z instrukcjami w przewodniku Vertex AI w Firebase.

Następnie dodaj do projektu zależność Gradle:

val generativeModel = Firebase.vertexAI .generativeModel( "gemini-2.0-flash", generationConfig = generationConfig { responseMimeType = "application/json" responseSchema = jsonSchema } )

Teraz możesz wywoływać interfejs Gemini API z kodu Kotlina. Najpierw zainicjuj usługę Vertex AI i utwórz instancję „GenerativeModel”:

scope.launch { val response = model.generateContent(" Create a shopping list with $cuisineStyle ingredients") }

W przypadku przykładowej aplikacji z przepisami Gemini 2.0 Flash może utworzyć listę zakupów ze składnikami do dania z określonego rodzaju kuchni. Możesz nawet poprosić model o wygenerowanie ciągu JSON, który można łatwo przeanalizować w aplikacji, aby wyświetlić go w interfejsie. Aby wygenerować listę, wywołaj funkcję generateContent() z promptem tekstowym.

Aby dowiedzieć się więcej, zapoznaj się z przewodnikiem dla programistów aplikacji na Androida.

Aby dowiedzieć się więcej, zapoznaj się z przewodnikiem dla programistów aplikacji na Androida.

Imagen 3 do generowania obrazów

Imagen 3 jest dostępny w Vertex AI w Firebase, dzięki czemu możesz bezproblemowo zintegrować generowanie obrazów z aplikacją na Androida. Imagen 3 to nasz najbardziej zaawansowany model generowania obrazów. Tworzy on obrazy wysokiej jakości z wyjątkowo szczegółowymi detalami, minimalnymi artefaktami i realistycznymi efektami oświetlenia, wyznaczając nowy standard w generowaniu obrazów.

Na przykład Imagen 3 może umożliwić użytkownikom generowanie własnych awatarów profilowych lub tworzenie zasobów do zilustrowania istniejących przepływów ekranu. W przypadku aplikacji do przygotowywania posiłków możesz użyć Imagen 3 do generowania obrazów na ekranie z przepisem.

Obraz wygenerowany przez Imagen 3 na podstawie promptu: ilustracja w stylu rysunkowym przedstawiająca blat kuchenny z pięknymi składnikami na śródziemnomorski posiłek.

Na przykład Imagen 3 może umożliwić użytkownikom generowanie własnych awatarów profilowych lub tworzenie zasobów do zilustrowania istniejących przepływów ekranu. W przypadku aplikacji do przygotowywania posiłków możesz użyć Imagen 3 do generowania obrazów na ekranie z przepisem.

Obraz wygenerowany przez Imagen 3 na podstawie promptu: ilustracja w stylu rysunkowym przedstawiająca blat kuchenny z pięknymi składnikami na śródziemnomorski posiłek.

dependencies { implementation(platform("com.google.firebase:firebase-bom:33.10.0")) implementation("com.google.firebase:firebase-vertexai") }

Integracja Imagen 3 jest podobna do uzyskiwania dostępu do modelu Gemini za pomocą Vertex AI w Firebase.

Zacznij od dodania zależności Gradle do projektu Androida:

Zacznij od dodania zależności Gradle do projektu Androida:

val imageModel = Firebase.vertexAI.imagenModel( modelName = "imagen-3.0-generate-001", generationConfig = ImagenGenerationConfig( imageFormat = ImagenImageFormat.jpeg(compresssionQuality = 75), addWatermark = true, numberOfImages = 1, aspectRatio = ImagenAspectRatio.SQUARE_1x1 )

Następnie w kodzie Kotlina utwórz instancję „ImageModel” przez przekazanie nazwy modelu i opcjonalnie konfiguracji modelu:

val imageResponse = imageModel.generateImages( prompt = "A cartoon style illustration of a top overview of a kitchen countertop with beautiful ingredients for a $cuisineStyle meal." )

Na koniec wygeneruj obraz, wywołując funkcję „generateImages()” z promptem tekstowym:

val image = imageResponse.images.first() val uiImage = image.asBitmap()

Pobierz wygenerowany obraz z elementu „imageResponse” i wyświetl go jako bitmapę:

Więcej informacji o używaniu Imagen 3 znajdziesz na blogu dla deweloperów aplikacji na Androida i w dokumentacji dla deweloperów aplikacji na Androida.

Przygotowanie do wdrożenia wersji produkcyjnej za pomocą Firebase

Po zaimplementowaniu w aplikacji funkcji generatywnej AI wykonaj te ważne czynności, zanim wdrożysz aplikację w wersji produkcyjnej:

- Aby zapobiec nadużyciom interfejsu API, wdrocz sprawdzanie aplikacji Firebase za pomocą Play Integrity.

- Aby móc dynamicznie aktualizować model i wersję AI, użyj Zdalnej konfiguracji Firebase do konfiguracji sterowanej przez serwer.

- Utwórz mechanizmy opinii za pomocą Google Analytics, aby ocenić wpływ i zebrać opinie użytkowników na temat odpowiedzi AI.