Google이 Google 포토에서 검색을 지원하는 최첨단 이미지 분류 모델을 개발한 방법을 알아보세요. 컨볼루셔널 신경망에 관한 단기집중과정을 통해 자체 이미지 분류기를 빌드하여 고양이 사진과 개 사진을 구분합니다.

기본 요건

머신러닝 단기집중과정 또는 이에 상응하는 ML 기초 과정

프로그래밍 기본사항 숙련도 및 Python 코딩 경험

소개

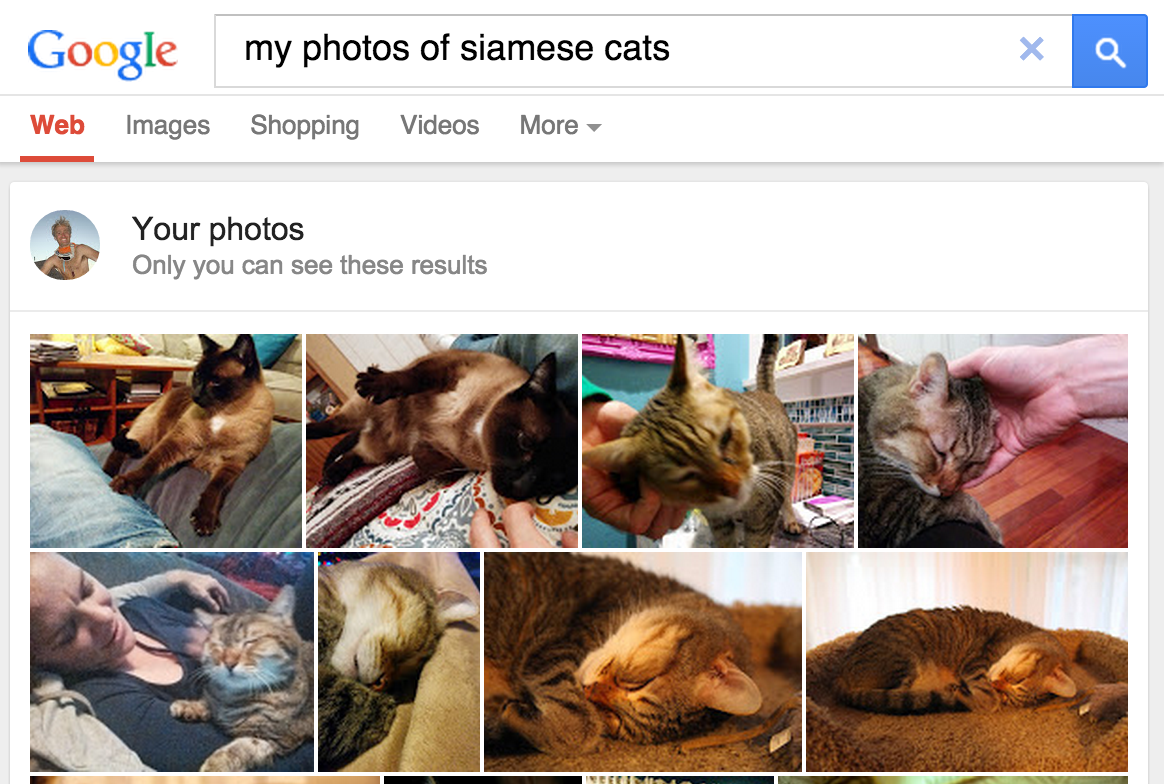

2013년 5월, Google은 개인 사진 검색을 출시하여 사용자가 이미지에 있는 객체를 기반으로 라이브러리에서 사진을 검색할 수 있도록 했습니다.

그림 1. 샴고양이를 Google 포토로 검색하면

상품이 배송됩니다.

그림 1. 샴고양이를 Google 포토로 검색하면

상품이 배송됩니다.

이후 2015년에 Google 포토에 도입된 이 기능은 컴퓨터 비전 소프트웨어가 인간의 표준에 따라 이미지를 분류해 여러 가지 방식으로 가치를 더할 수 있다는 개념 증명이라는 혁신적인 개념으로 널리 인식되고 있습니다.

- 사용자는 더 이상 이미지 콘텐츠를 분류하기 위해 '해변'과 같은 라벨로 태그를 지정할 필요가 없습니다. 수백 또는 수천 개의 이미지 집합을 관리할 때 수작업이 필요하지 않게 되기 때문입니다.

- 사용자는 새로운 방법으로 사진 컬렉션을 살펴볼 수 있습니다. 검색어를 사용해 태그한 적이 없는 객체로 사진을 찾을 수 있습니다. 예를 들어 '야자수'를 검색하면 배경에 야자수가 있는 휴가 사진을 모두 표시할 수 있습니다.

- 소프트웨어는 최종 사용자가 인지할 수 없는 분류적 분류 (예: 샴 고양이와 아비시니안 고양이 구분)를 할 수 있으며, 이를 통해 사용자의 도메인 지식을 효과적으로 강화할 수 있습니다.

이미지 분류 작동 방식

이미지 분류는 지도 학습 문제입니다. 지도 학습에서는 대상 클래스 집합 (이미지에서 식별할 객체)을 정의하고 라벨이 있는 예시 사진을 사용하여 모델을 인식하도록 모델을 학습시킵니다. 초기 컴퓨터 비전 모델은 원시 픽셀 데이터를 모델에 대한 입력으로 사용했습니다. 하지만 그림 2와 같이 원시 픽셀 데이터만으로는 이미지에서 캡처된 객체의 수많은 변형을 포함할 수 있을 만큼 안정적인 표현을 제공하지 않습니다. 객체의 위치, 객체 뒤의 배경, 주변 조명, 카메라 각도, 카메라 초점은 모두 원시 픽셀 데이터의 변동을 유발할 수 있습니다. 이러한 차이는 픽셀 RGB 값의 가중 평균을 사용하여 수정할 수 없을 정도로 현저합니다.

그림 2. 왼쪽: 고양이를 다양한 자세로 촬영한 후 다양한 배경화면과 조명 조건을 사용해 고양이를 캡처할 수 있습니다. 오른쪽: 이러한 다양성을 고려하기 위해 픽셀 데이터를 평균화해도 유의미한 정보가 생성되지 않습니다.

그림 2. 왼쪽: 고양이를 다양한 자세로 촬영한 후 다양한 배경화면과 조명 조건을 사용해 고양이를 캡처할 수 있습니다. 오른쪽: 이러한 다양성을 고려하기 위해 픽셀 데이터를 평균화해도 유의미한 정보가 생성되지 않습니다.

객체를 더 유연하게 모델링하기 위해 기존 컴퓨터 비전 모델은 색상 히스토그램, 질감, 도형과 같은 픽셀 데이터에서 파생된 새로운 특성을 추가했습니다. 이 접근 방식의 단점은 조정해야 할 입력이 너무 많아 특성 추출이 큰 부담이 되었다는 점입니다. 고양이 분류기의 경우, 가장 관련성이 높은 색상은 무엇인가요? 형태 정의는 얼마나 유연해야 하나요? 특성을 정밀하게 조정해야 했기 때문에 강력한 모델을 빌드하는 것이 매우 어려웠고 정확성이 떨어졌습니다.