Questo glossario definisce i termini relativi all'intelligenza artificiale.

A

ablazione

Una tecnica per valutare l'importanza di una caratteristica o di un componente rimuovendolo temporaneamente da un modello. Quindi, riaddestra il modello senza quella funzionalità o componente e, se il modello riaddestrato ha prestazioni significativamente peggiori, la funzionalità o il componente rimossi erano probabilmente importanti.

Ad esempio, supponiamo di addestrare un modello di classificazione su 10 funzionalità e di ottenere una precisione dell'88% sul set di test. Per controllare l'importanza della prima funzionalità, puoi eseguire di nuovo l'addestramento del modello utilizzando solo le altre nove funzionalità. Se il modello riaddestrato ha prestazioni significativamente peggiori (ad esempio, precisione del 55%), la funzionalità rimossa era probabilmente importante. Al contrario, se il modello riaddestrato funziona altrettanto bene, allora questa funzionalità probabilmente non era così importante.

L'ablazione può anche contribuire a determinare l'importanza di:

- Componenti più grandi, ad esempio un intero sottosistema di un sistema ML più grande

- Processi o tecniche, ad esempio un passaggio di pre-elaborazione dei dati

In entrambi i casi, osserverai come cambia (o non cambia) il rendimento del sistema dopo aver rimosso il componente.

Test A/B

Un modo statistico per confrontare due (o più) tecniche: la A e la B. In genere, la A è una tecnica esistente, mentre la B è una nuova tecnica. Il test A/B non solo determina quale tecnica ha un rendimento migliore, ma anche se la differenza è statisticamente significativa.

In genere, i test A/B confrontano una singola metrica su due tecniche. Ad esempio, come si confronta l'accuratezza del modello per due tecniche? Tuttavia, il test A/B può anche confrontare un numero finito di metriche.

chip dell'acceleratore

Una categoria di componenti hardware specializzati progettati per eseguire i calcoli chiave necessari per gli algoritmi di deep learning.

I chip di accelerazione (o semplicemente acceleratori) possono aumentare notevolmente la velocità e l'efficienza delle attività di addestramento e inferenza rispetto a una CPU generica. Sono ideali per l'addestramento di reti neurali e attività simili ad alta intensità di calcolo.

Ecco alcuni esempi di chip di accelerazione:

- Tensor Processing Unit (TPU) di Google con hardware dedicato per il deep learning.

- Le GPU di NVIDIA, inizialmente progettate per l'elaborazione grafica, sono progettate per consentire l'elaborazione parallela, che può aumentare in modo significativo la velocità di elaborazione.

accuracy

Il numero di previsioni di classificazione corrette diviso per il numero totale di previsioni. Ossia:

Ad esempio, un modello che ha effettuato 40 previsioni corrette e 10 errate avrebbe un'accuratezza pari a:

La classificazione binaria fornisce nomi specifici per le diverse categorie di previsioni corrette e previsioni errate. Pertanto, la formula dell'accuratezza per la classificazione binaria è la seguente:

dove:

- TP è il numero di veri positivi (previsioni corrette).

- TN è il numero di veri negativi (previsioni corrette).

- FP è il numero di falsi positivi (previsioni errate).

- FN è il numero di falsi negativi (previsioni errate).

Confronta e contrapponi l'accuratezza con la precisione e il richiamo.

Per saperne di più, consulta Classificazione: accuratezza, richiamo, precisione e metriche correlate in Machine Learning Crash Course.

azione

Nel reinforcement learning, il meccanismo mediante il quale l'agente passa da uno stato all'altro dell'ambiente. L'agente sceglie l'azione utilizzando una policy.

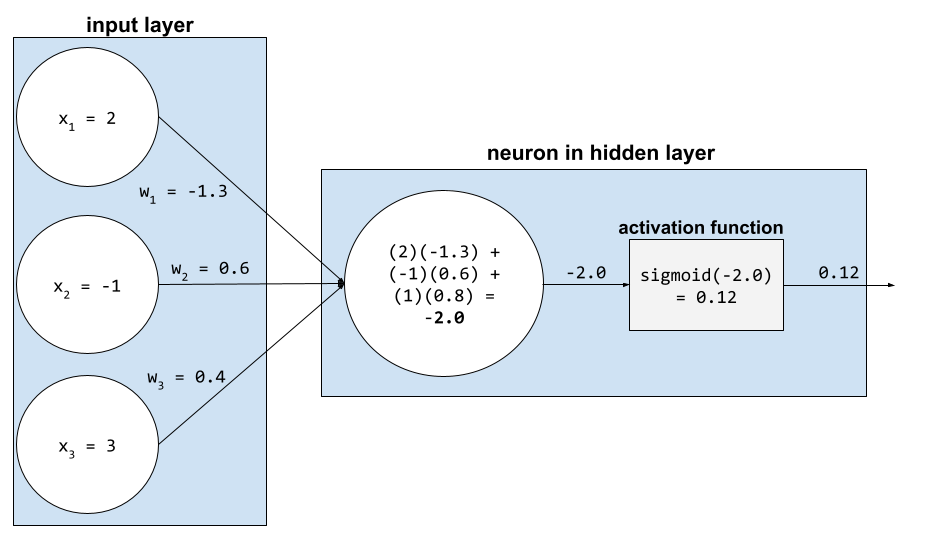

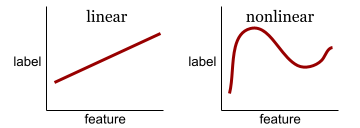

funzione di attivazione

Una funzione che consente alle reti neurali di apprendere relazioni non lineari (complesse) tra le caratteristiche e l'etichetta.

Le funzioni di attivazione più comuni includono:

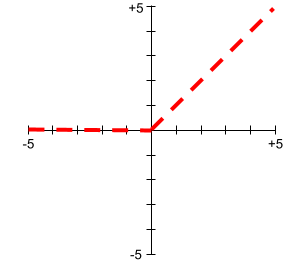

I grafici delle funzioni di attivazione non sono mai singole linee rette. Ad esempio, il grafico della funzione di attivazione ReLU è costituito da due rette:

Un grafico della funzione di attivazione sigmoide è il seguente:

Per saperne di più, consulta Reti neurali: funzioni di attivazione in Machine Learning Crash Course.

apprendimento attivo

Un approccio di addestramento in cui l'algoritmo sceglie alcuni dei dati da cui apprende. L'apprendimento attivo è particolarmente utile quando gli esempi etichettati sono scarsi o costosi da ottenere. Anziché cercare ciecamente una gamma diversificata di esempi etichettati, un algoritmo di apprendimento attivo cerca selettivamente la gamma particolare di esempi di cui ha bisogno per l'apprendimento.

AdaGrad

Un sofisticato algoritmo di discesa del gradiente che ridimensiona i gradienti di ogni parametro, assegnando di fatto a ogni parametro un tasso di apprendimento indipendente. Per una spiegazione completa, vedi Adaptive Subgradient Methods for Online Learning and Stochastic Optimization.

adattamento

Sinonimo di ottimizzazione o ottimizzazione avanzata.

agente

Software in grado di ragionare sugli input multimodali dell'utente per pianificare ed eseguire azioni per suo conto.

Nel reinforcement learning, un agente è l'entità che utilizza una policy per massimizzare il rendimento previsto ottenuto dalla transizione tra gli stati dell'ambiente.

agentico

La forma aggettivale di agente. Il termine "agente" si riferisce alle qualità che possiedono gli agenti (come l'autonomia).

workflow agentico

Un processo dinamico in cui un agente pianifica ed esegue autonomamente azioni per raggiungere un obiettivo. Il processo può comportare ragionamenti, l'invocazione di strumenti esterni e l'autocorrezione del piano.

clustering agglomerativo

Vedi clustering gerarchico.

AI slop

Output di un sistema di AI generativa che privilegia la quantità rispetto alla qualità. Ad esempio, una pagina web con contenuti di bassa qualità generati dall'AI è piena di contenuti di bassa qualità generati dall'AI e prodotti a basso costo.

rilevamento di anomalie

Il processo di identificazione degli outlier. Ad esempio, se la media per una determinata caratteristica è 100 con una deviazione standard di 10, il rilevamento di anomalie dovrebbe segnalare un valore di 200 come sospetto.

AR

Abbreviazione di realtà aumentata.

area sotto la curva PR

Vedi AUC PR (area sotto la curva PR).

area sotto la curva ROC

Consulta la sezione AUC (Area sotto la curva ROC).

intelligenza artificiale generale

Un meccanismo non umano che dimostra un ampio spettro di capacità di risoluzione dei problemi, creatività e adattabilità. Ad esempio, un programma che dimostra un'intelligenza artificiale generale potrebbe tradurre testi, comporre sinfonie ed eccellere in giochi che non sono ancora stati inventati.

intelligenza artificiale

Un programma o un modello non umano in grado di risolvere attività sofisticate. Ad esempio, un programma o un modello che traduce il testo o un programma o un modello che identifica le malattie dalle immagini radiologiche mostrano entrambi intelligenza artificiale.

Formalmente, il machine learning è un sottocampo dell'intelligenza artificiale. Tuttavia, negli ultimi anni, alcune organizzazioni hanno iniziato a utilizzare i termini intelligenza artificiale e machine learning in modo intercambiabile.

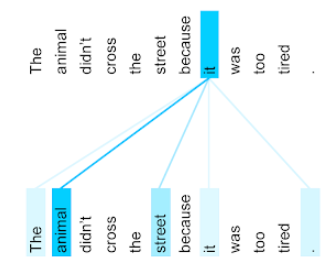

Attention,

Un meccanismo utilizzato in una rete neurale che indica l'importanza di una determinata parola o parte di una parola. L'attenzione comprime la quantità di informazioni di cui un modello ha bisogno per prevedere il token/la parola successivi. Un tipico meccanismo di attenzione potrebbe consistere in una somma ponderata su un insieme di input, in cui il peso per ogni input viene calcolato da un'altra parte della rete neurale.

Fai riferimento anche a auto-attenzione e auto-attenzione multi-head, che sono i componenti di base dei Transformer.

Per ulteriori informazioni sull'auto-attenzione, consulta LLM: che cos'è un modello linguistico di grandi dimensioni? in Machine Learning Crash Course.

attributo

Sinonimo di funzionalità.

Nell'equità del machine learning, gli attributi si riferiscono spesso a caratteristiche relative agli individui.

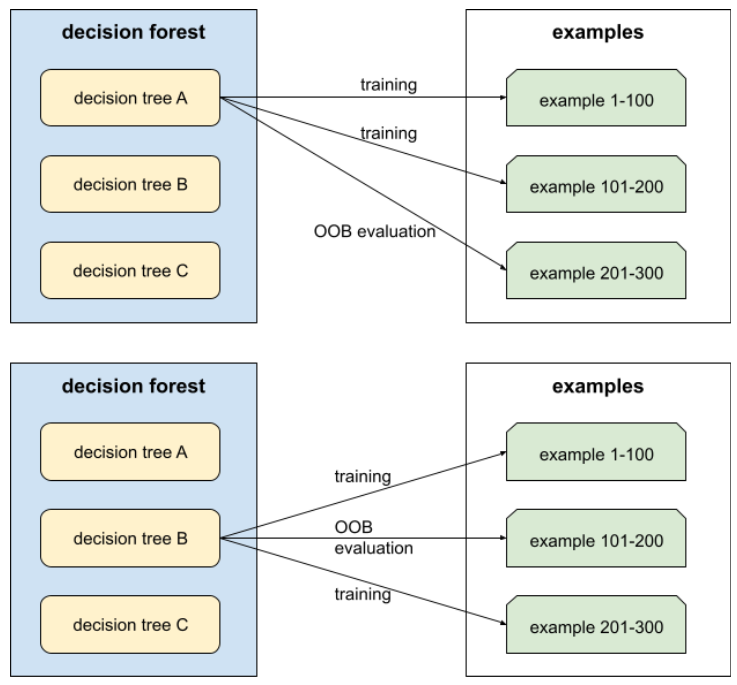

campionamento degli attributi

Una tattica per l'addestramento di una foresta decisionale in cui ogni albero decisionale considera solo un sottoinsieme casuale di possibili caratteristiche durante l'apprendimento della condizione. In genere, per ogni nodo viene campionato un sottoinsieme diverso di funzionalità. Al contrario, quando si addestra un albero decisionale senza campionamento degli attributi, vengono prese in considerazione tutte le funzionalità possibili per ogni nodo.

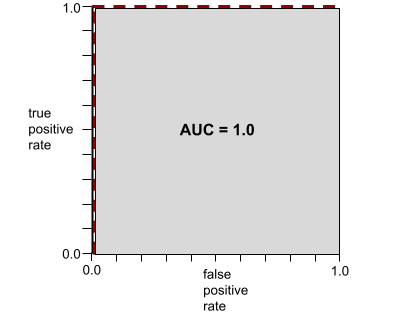

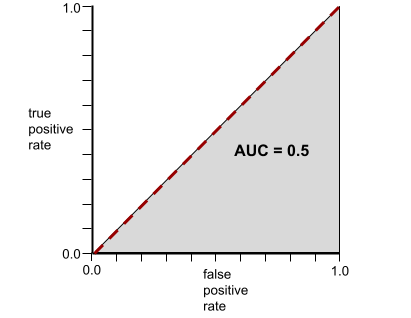

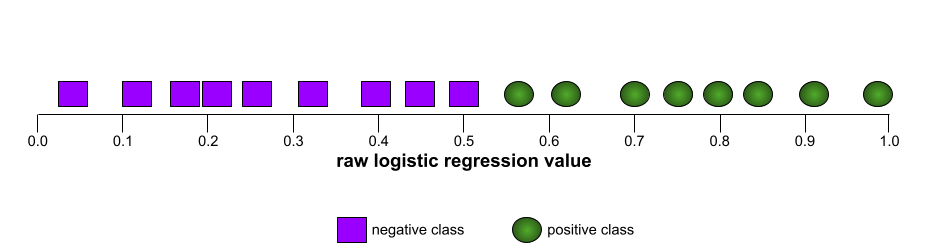

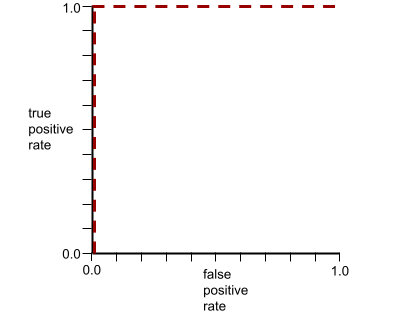

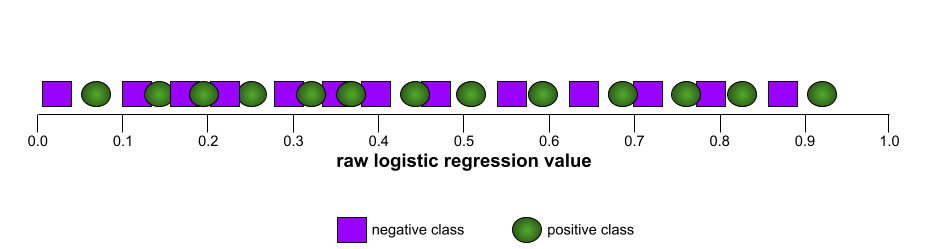

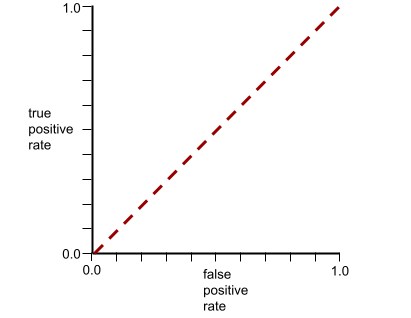

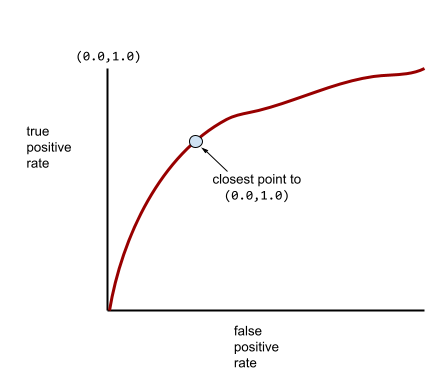

AUC (area sotto la curva ROC)

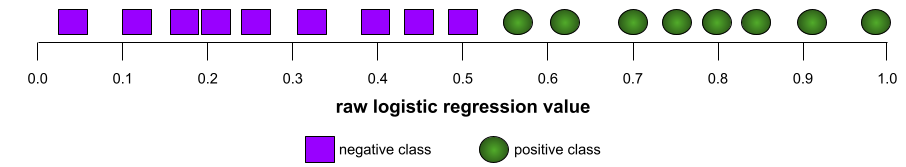

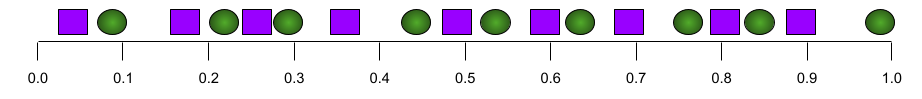

Un numero compreso tra 0,0 e 1,0 che rappresenta la capacità di un modello di classificazione binaria di separare le classi positive dalle classi negative. Più l'AUC è vicino a 1,0, migliore è la capacità del modello di separare le classi tra loro.

Ad esempio, la seguente illustrazione mostra un modello di classificazione che separa perfettamente le classi positive (ovali verdi) da quelle negative (rettangoli viola). Questo modello perfetto in modo non realistico ha un'AUC pari a 1,0:

Al contrario, la seguente illustrazione mostra i risultati per un modello di classificazione che ha generato risultati casuali. Questo modello ha un AUC di 0,5:

Sì, il modello precedente ha un'AUC di 0,5, non di 0.

La maggior parte dei modelli si trova a metà strada tra i due estremi. Ad esempio, il seguente modello separa in qualche modo i positivi dai negativi e pertanto ha un'AUC compresa tra 0,5 e 1,0:

L'AUC ignora qualsiasi valore impostato per la soglia di classificazione. L'AUC, invece, prende in considerazione tutte le possibili soglie di classificazione.

Per saperne di più, consulta Classificazione: ROC e AUC in Machine Learning Crash Course.

realtà aumentata

Una tecnologia che sovrappone un'immagine generata al computer alla visualizzazione del mondo reale di un utente, fornendo così una visualizzazione composita.

autoencoder

Un sistema che impara a estrarre le informazioni più importanti dall'input. Gli autoencoder sono una combinazione di un encoder e di un decoder. Gli autoencoder si basano sul seguente processo in due passaggi:

- L'encoder mappa l'input in un formato (intermedio) a dimensioni inferiori (in genere) con perdita.

- Il decodificatore crea una versione con perdita dell'input originale mappando il formato a dimensionalità inferiore al formato dell'input originale a dimensionalità superiore.

Gli autoencoder vengono addestrati end-to-end facendo in modo che il decodificatore tenti di ricostruire l'input originale dal formato intermedio dell'encoder nel modo più fedele possibile. Poiché il formato intermedio è più piccolo (con meno dimensioni) rispetto al formato originale, l'autoencoder è costretto a imparare quali informazioni nell'input sono essenziali e l'output non sarà perfettamente identico all'input.

Ad esempio:

- Se i dati di input sono un'immagine, la copia non esatta sarà simile all'immagine originale, ma leggermente modificata. Forse la copia non esatta rimuove il rumore dal grafico originale o riempie alcuni pixel mancanti.

- Se i dati di input sono di tipo testuale, un autoencoder genererà un nuovo testo che imita (ma non è identico a) il testo originale.

Vedi anche autoencoder variazionali.

valutazione automatica

Utilizzo di software per valutare la qualità dell'output di un modello.

Quando l'output del modello è relativamente semplice, uno script o un programma può confrontare l'output del modello con una risposta di riferimento. Questo tipo di valutazione automatica è talvolta chiamato valutazione programmatica. Metriche come ROUGE o BLEU sono spesso utili per la valutazione programmatica.

Quando l'output del modello è complesso o non ha una risposta giusta, a volte la valutazione automatica viene eseguita da un programma ML separato chiamato valutatore automatico.

Contrasto con la valutazione umana.

bias di automazione

Quando un decisore umano favorisce i consigli forniti da un sistema decisionale automatizzato rispetto alle informazioni create senza automazione, anche quando il sistema decisionale automatizzato commette errori.

Per saperne di più, consulta Equità: tipi di bias in Machine Learning Crash Course.

AutoML

Qualsiasi processo automatizzato per la creazione di modelli di machine learning. AutoML può svolgere automaticamente attività come le seguenti:

- Cerca il modello più appropriato.

- Ottimizza gli iperparametri.

- Prepara i dati (inclusa l'esecuzione del feature engineering).

- Esegui il deployment del modello risultante.

AutoML è utile per i data scientist perché può far risparmiare tempo e impegno nello sviluppo di pipeline di machine learning e migliorare l'accuratezza delle previsioni. È utile anche ai non esperti, in quanto rende più accessibili le complicate attività di machine learning.

Per saperne di più, consulta Machine Learning automatizzato (AutoML) in Machine Learning Crash Course.

valutazione automatica

Un meccanismo ibrido per giudicare la qualità dell'output di un modello di AI generativa che combina la valutazione umana con la valutazione automatica. Un sistema di valutazione automatica è un modello ML addestrato su dati creati tramite valutazione umana. Idealmente, un sistema di valutazione automatica impara a imitare un valutatore umano.Sono disponibili valutatori automatici predefiniti, ma i migliori sono ottimizzati in modo specifico per l'attività che stai valutando.

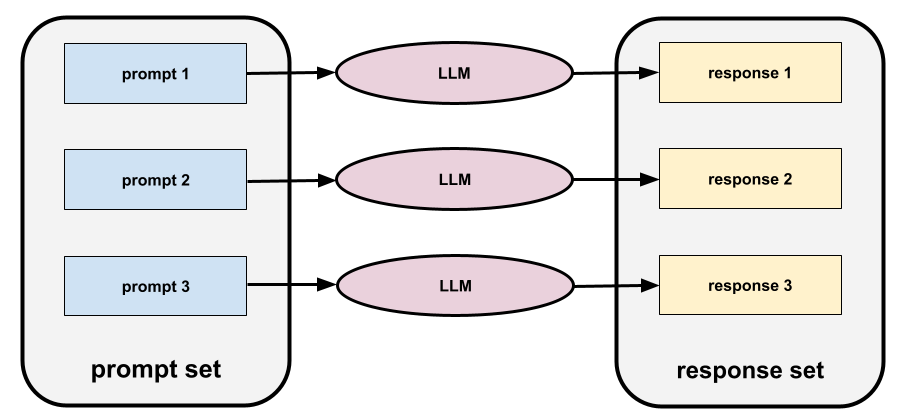

modello autoregressivo

Un modello che deduce una previsione in base alle proprie previsioni precedenti. Ad esempio, i modelli linguistici autoregressivi prevedono il successivo token in base ai token previsti in precedenza. Tutti i modelli linguistici di grandi dimensioni basati su Transformer sono autoregressivi.

Al contrario, i modelli di immagini basati su GAN di solito non sono autoregressivi, in quanto generano un'immagine in un singolo passaggio in avanti e non in modo iterativo in passaggi. Tuttavia, alcuni modelli di generazione delle immagini sono autoregressivi perché generano un'immagine in più passaggi.

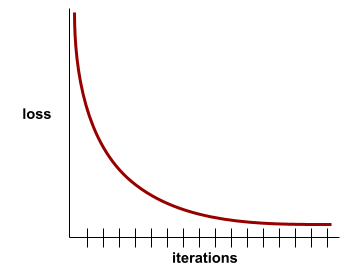

perdita ausiliaria

Una funzione di perdita, utilizzata insieme alla funzione di perdita principale di un modello di rete neurale, che contribuisce ad accelerare l'addestramento durante le prime iterazioni, quando i pesi vengono inizializzati in modo casuale.

Le funzioni di perdita ausiliari inviano gradienti efficaci ai livelli precedenti. Ciò facilita la convergenza durante l'addestramento combattendo il problema di scomparsa del gradiente.

precisione media a k

Una metrica per riassumere il rendimento di un modello su un singolo prompt che genera risultati classificati, ad esempio un elenco numerato di consigli di libri. La precisione media a k è la media dei valori di precisione a k per ogni risultato pertinente. La formula per la precisione media a k è quindi:

\[{\text{average precision at k}} = \frac{1}{n} \sum_{i=1}^n {\text{precision at k for each relevant item} } \]

dove:

- \(n\) è il numero di elementi pertinenti nell'elenco.

Contrasto con il richiamo a k.

axis-aligned condition

In un albero decisionale, una condizione

che coinvolge una sola caratteristica. Ad esempio, se area

è una funzionalità, la seguente è una condizione allineata all'asse:

area > 200

Contrasto con la condizione obliqua.

B

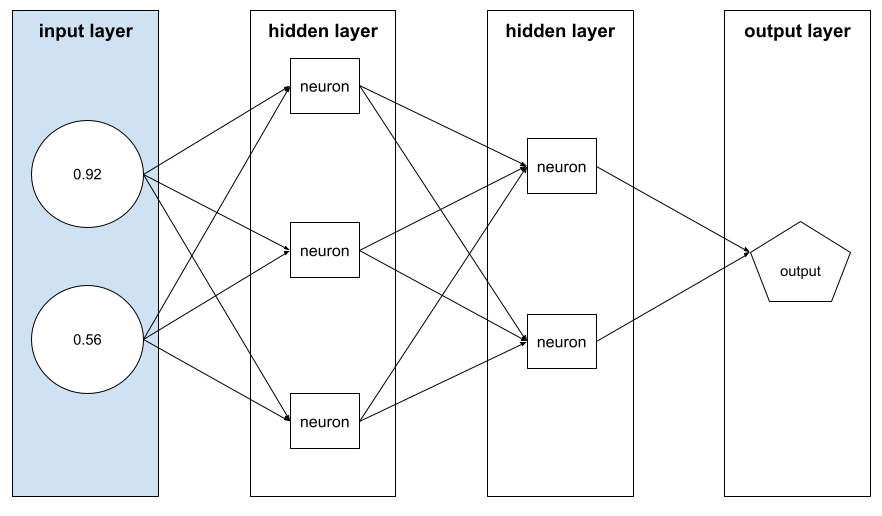

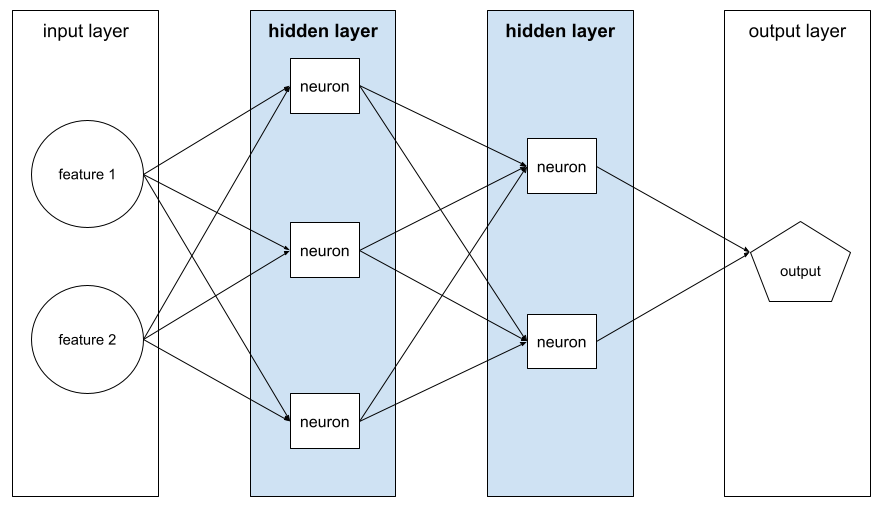

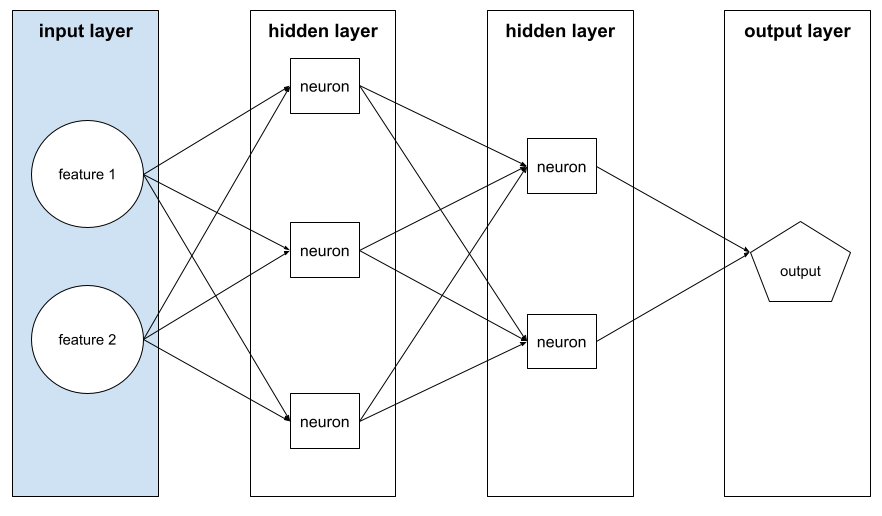

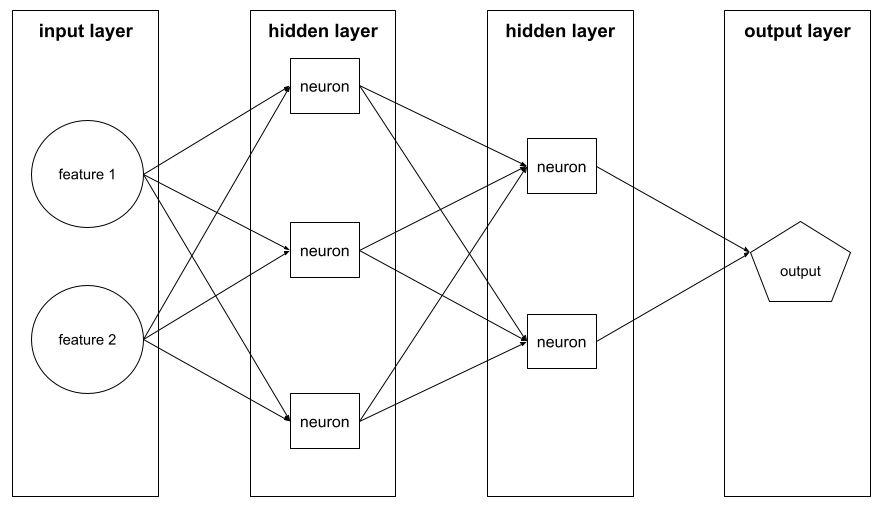

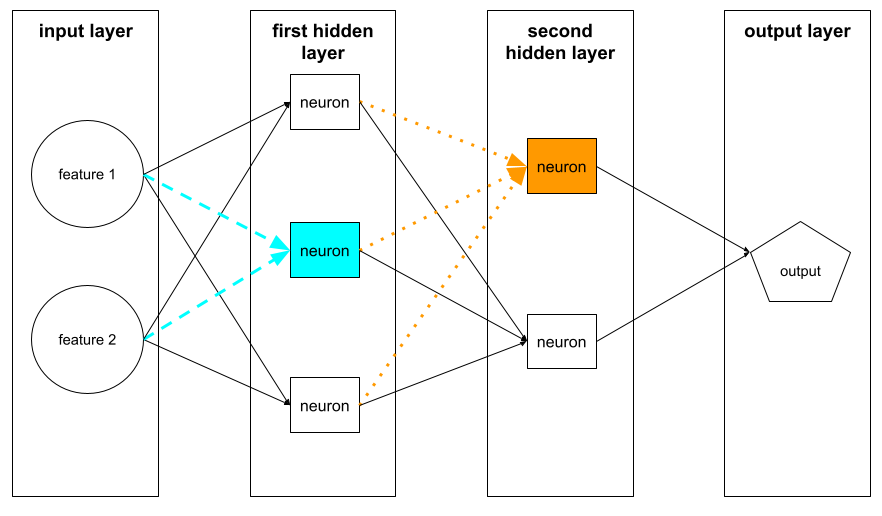

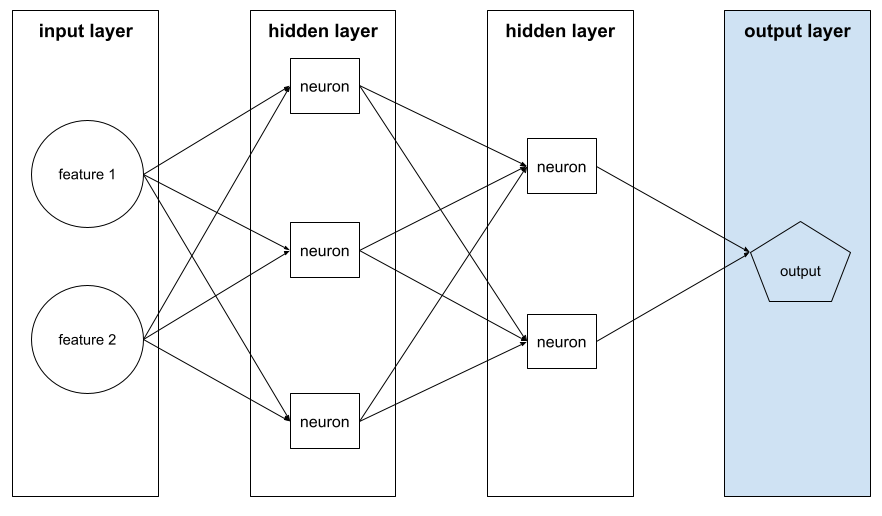

backpropagation

L'algoritmo che implementa la discesa del gradiente nelle reti neurali.

L'addestramento di una rete neurale prevede molte iterazioni del seguente ciclo a due passaggi:

- Durante la propagazione in avanti, il sistema elabora un batch di esempi per generare una o più previsioni. Il sistema confronta ogni previsione con ogni valore dell'etichetta. La differenza tra la previsione e il valore dell'etichetta è la perdita per quell'esempio. Il sistema aggrega le perdite per tutti gli esempi per calcolare la perdita totale per il batch corrente.

- Durante la passata all'indietro (retropropagazione), il sistema riduce la perdita modificando i pesi di tutti i neuroni in tutti gli strati nascosti.

Le reti neurali spesso contengono molti neuroni in molti strati nascosti. Ciascuno di questi neuroni contribuisce alla perdita complessiva in modi diversi. La retropropagazione determina se aumentare o diminuire i pesi applicati a particolari neuroni.

Il tasso di apprendimento è un moltiplicatore che controlla il grado in cui ogni passaggio all'indietro aumenta o diminuisce ogni peso. Un tasso di apprendimento elevato aumenterà o diminuirà ogni peso più di un tasso di apprendimento basso.

In termini di calcolo, la retropropagazione implementa la regola della catena del calcolo. ovvero la retropropagazione calcola la derivata parziale dell'errore rispetto a ogni parametro.

Anni fa, i professionisti dell'ML dovevano scrivere codice per implementare la retropropagazione. Le moderne API ML come Keras ora implementano la backpropagation per te. Finalmente.

Per saperne di più, consulta la sezione Reti neurali di Machine Learning Crash Course.

bagging

Un metodo per addestrare un ensemble in cui ogni modello costituente viene addestrato su un sottoinsieme casuale di esempi di addestramento campionati con reinserimento. Ad esempio, una foresta casuale è un insieme di alberi decisionali addestrati con il bagging.

Il termine bagging è l'abbreviazione di bootstrap aggregating.

Per saperne di più, consulta la sezione Foreste casuali del corso Decision Forests.

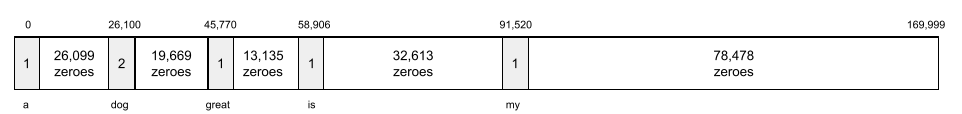

bag of words

Una rappresentazione delle parole in una frase o in un passaggio, indipendentemente dall'ordine. Ad esempio, il bag of words rappresenta le tre frasi seguenti in modo identico:

- il cane salta

- salta il cane

- dog jumps the

Ogni parola viene mappata a un indice in un vettore sparso, in cui il vettore ha un indice per ogni parola del vocabolario. Ad esempio, la frase the dog jumps viene mappata in un vettore delle caratteristiche con valori diversi da zero nei tre indici corrispondenti alle parole the, dog e jumps. Il valore diverso da zero può essere uno dei seguenti:

- Un 1 per indicare la presenza di una parola.

- Un conteggio del numero di volte in cui una parola compare nel sacchetto. Ad esempio, se la frase fosse il cane marrone è un cane con il pelo marrone, sia marrone che cane sarebbero rappresentati come 2, mentre le altre parole sarebbero rappresentate come 1.

- Un altro valore, ad esempio il logaritmo del conteggio del numero di volte in cui una parola appare nel bag.

base di riferimento

Un modello utilizzato come punto di riferimento per confrontare il rendimento di un altro modello (in genere, uno più complesso). Ad esempio, un modello di regressione logistica può fungere da buona base di riferimento per un modello profondo.

Per un problema specifico, la baseline aiuta gli sviluppatori di modelli a quantificare il rendimento minimo previsto che un nuovo modello deve raggiungere per essere utile.

modello di base

Un modello preaddestrato che può fungere da punto di partenza per l'ottimizzazione per svolgere attività o applicazioni specifiche.

Vedi anche modello preaddestrato e modello di base.

batch

L'insieme di esempi utilizzati in un'iterazione di addestramento . La dimensione del batch determina il numero di esempi in un batch.

Per una spiegazione di come un batch si relaziona a un'epoca, consulta la sezione epoca.

Per saperne di più, consulta Regressione lineare: iperparametri in Machine Learning Crash Course.

inferenza batch

Il processo di inferenza delle previsioni su più esempi senza etichetta suddivisi in sottoinsiemi più piccoli ("batch").

L'inferenza batch può sfruttare le funzionalità di parallelizzazione dei chip acceleratori. ovvero più acceleratori possono dedurre simultaneamente le previsioni su batch diversi di esempi senza etichetta, aumentando notevolmente il numero di inferenze al secondo.

Per saperne di più, consulta Sistemi ML di produzione: inferenza statica e dinamica in Machine Learning Crash Course.

normalizzazione batch

Normalizzazione dell'input o dell'output delle funzioni di attivazione in un livello nascosto. La normalizzazione dei batch può offrire i seguenti vantaggi:

- Rendere le reti neurali più stabili proteggendo dai pesi anomali.

- Consente tassi di apprendimento più elevati, che possono accelerare l'addestramento.

- Ridurre l'overfitting.

dimensione del batch

Il numero di esempi in un batch. Ad esempio, se la dimensione del batch è 100, il modello elabora 100 esempi per iterazione.

Di seguito sono riportate le strategie più comuni per le dimensioni del batch:

- Discesa stocastica del gradiente (SGD), in cui la dimensione del batch è 1.

- Batch completo, in cui la dimensione del batch è il numero di esempi nell'intero set di addestramento. Ad esempio, se il set di addestramento contiene un milione di esempi, la dimensione del batch sarà di un milione di esempi. Il caricamento completo del batch è in genere una strategia inefficiente.

- Mini-batch in cui la dimensione del batch è generalmente compresa tra 10 e 1000. Il mini-batch è in genere la strategia più efficiente.

Per ulteriori informazioni, consulta le seguenti risorse:

- Sistemi ML di produzione: inferenza statica e dinamica in Machine Learning Crash Course.

- Guida pratica per l'ottimizzazione del deep learning.

Rete neurale bayesiana

Una rete neurale probabilistica che tiene conto dell'incertezza nei pesi e negli output. Un modello di regressione di rete neurale standard in genere prevede un valore scalare; ad esempio, un modello standard prevede un prezzo della casa di 853.000. Al contrario, una rete neurale bayesiana prevede una distribuzione di valori; ad esempio, un modello bayesiano prevede un prezzo della casa di 853.000 con una deviazione standard di 67.200.

Una rete neurale bayesiana si basa sul teorema di Bayes per calcolare le incertezze nelle ponderazioni e nelle previsioni. Una rete neurale bayesiana può essere utile quando è importante quantificare l'incertezza, ad esempio nei modelli correlati ai prodotti farmaceutici. Le reti neurali bayesiane possono anche contribuire a prevenire l'overfitting.

Ottimizzazione bayesiana

Una tecnica di modello di regressione probabilistica per ottimizzare le funzioni obiettivo computazionalmente costose ottimizzando invece un surrogato che quantifica l'incertezza utilizzando una tecnica di apprendimento bayesiano. Poiché l'ottimizzazione bayesiana è di per sé molto costosa, viene solitamente utilizzata per ottimizzare attività costose da valutare che hanno un numero ridotto di parametri, ad esempio la selezione degli iperparametri.

Equazione di Bellman

Nell'apprendimento per rinforzo, la seguente identità è soddisfatta dalla funzione Q ottimale:

\[Q(s, a) = r(s, a) + \gamma \mathbb{E}_{s'|s,a} \max_{a'} Q(s', a')\]

Gli algoritmi di apprendimento per rinforzo applicano questa identità per creare l'apprendimento Q utilizzando la seguente regola di aggiornamento:

\[Q(s,a) \gets Q(s,a) + \alpha \left[r(s,a) + \gamma \displaystyle\max_{\substack{a_1}} Q(s',a') - Q(s,a) \right] \]

Oltre al reinforcement learning, l'equazione di Bellman ha applicazioni nella programmazione dinamica. Consulta la voce di Wikipedia relativa all'equazione di Bellman.

BERT (Bidirectional Encoder Representations from Transformers)

Un'architettura del modello per la rappresentazione del testo. Un modello BERT addestrato può fungere da parte di un modello più grande per la classificazione del testo o altre attività di ML.

BERT ha le seguenti caratteristiche:

- Utilizza l'architettura Transformer e si basa quindi sull'auto-attenzione.

- Utilizza la parte encoder del Transformer. Il compito dell'encoder è produrre buone rappresentazioni di testo, anziché eseguire un'attività specifica come la classificazione.

- È bidirezionale.

- Utilizza la mascheratura per l'addestramento non supervisionato.

Le varianti di BERT includono:

Consulta la pagina Open Sourcing BERT: State-of-the-Art Pre-training for Natural Language Processing per una panoramica di BERT.

bias (etica/equità)

1. Stereotipare, mostrare preconcetti o favoritismi verso determinate cose, persone o gruppi rispetto ad altri. Questi bias possono influire sulla raccolta e sull'interpretazione dei dati, sulla progettazione di un sistema e sul modo in cui gli utenti interagiscono con un sistema. Le forme di questo tipo di bias includono:

- bias di automazione

- Bias di conferma

- Bias dello sperimentatore

- bias di attribuzione di gruppo

- bias implicito

- Bias di affinità

- Bias di omogeneità del gruppo esterno

2. Errore sistematico introdotto da una procedura di campionamento o reporting. Le forme di questo tipo di bias includono:

- Bias di copertura

- Bias di non risposta

- Bias di partecipazione

- bias di segnalazione

- bias di campionamento

- Bias di selezione

Da non confondere con il termine di bias nei modelli di machine learning o con il bias di previsione.

Per saperne di più, consulta Equità: tipi di bias in Machine Learning Crash Course.

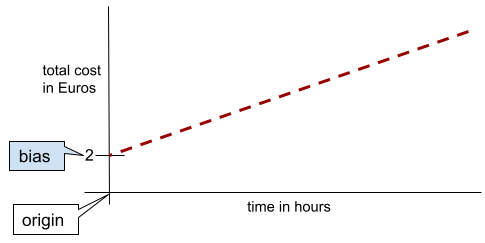

bias (matematica) o termine di bias

Un'intercettazione o un offset da un'origine. Il bias è un parametro nei modelli di machine learning, che è simboleggiato da uno dei seguenti:

- b

- w0

Ad esempio, il bias è il b nella seguente formula:

In una semplice retta bidimensionale, il bias indica semplicemente l'intercetta sull'asse y. Ad esempio, la pendenza della retta nell'illustrazione seguente è 2.

Il bias esiste perché non tutti i modelli iniziano dall'origine (0,0). Ad esempio, supponiamo che l'ingresso in un parco divertimenti costi 2 euro e che vengano addebitati 0,50 euro per ogni ora di permanenza di un cliente. Pertanto, un modello che mappa il costo totale ha una distorsione di 2 perché il costo più basso è di 2 euro.

Il bias non deve essere confuso con il bias in etica ed equità o con il bias di previsione.

Per saperne di più, consulta Regressione lineare in Machine Learning Crash Course.

bidirezionale

Termine utilizzato per descrivere un sistema che valuta il testo che precede e segue una sezione di testo di destinazione. Al contrario, un sistema unidirezionale valuta solo il testo che precede una sezione di testo target.

Ad esempio, considera un modello linguistico mascherato che deve determinare le probabilità per la parola o le parole che rappresentano la sottolineatura nella seguente domanda:

Qual è il tuo _____?

Un modello linguistico unidirezionale dovrebbe basare le sue probabilità solo sul contesto fornito dalle parole "Che", "cosa" e "è". Al contrario, un modello linguistico bidirezionale potrebbe acquisire contesto anche da "con" e "te", il che potrebbe aiutarlo a generare previsioni migliori.

modello linguistico bidirezionale

Un modello linguistico che determina la probabilità che un determinato token sia presente in una determinata posizione in un estratto di testo in base al testo precedente e successivo.

bigram

Un n-gramma in cui N=2.

classificazione binaria

Un tipo di attività di classificazione che prevede una delle due classi reciprocamente esclusive:

Ad esempio, i seguenti due modelli di machine learning eseguono ciascuno la classificazione binaria:

- Un modello che determina se i messaggi email sono spam (la classe positiva) o non spam (la classe negativa).

- Un modello che valuta i sintomi medici per determinare se una persona ha una determinata malattia (la classe positiva) o non ha quella malattia (la classe negativa).

Contrasta con la classificazione multiclasse.

Vedi anche regressione logistica e soglia di classificazione.

Per saperne di più, consulta la sezione Classificazione di Machine Learning Crash Course.

condizione binaria

In un albero decisionale, una condizione che ha solo due possibili risultati, in genere sì o no. Ad esempio, la seguente è una condizione binaria:

temperature >= 100

Contrasto con la condizione non binaria.

Per saperne di più, consulta la sezione Tipi di condizioni del corso Decision Forests.

binning

Sinonimo di raggruppamento.

modello black box

Un modello il cui "ragionamento" è impossibile o difficile da comprendere per gli esseri umani. Ciò significa che, anche se gli esseri umani possono vedere come i prompt influenzano le risposte, non possono determinare esattamente come un modello black box determina la risposta. In altre parole, un modello a scatola nera non ha interpretabilità.

La maggior parte dei modelli di deep learning e dei modelli linguistici di grandi dimensioni sono scatole nere.

BLEU (Bilingual Evaluation Understudy)

Una metrica compresa tra 0,0 e 1,0 per valutare le traduzioni automatiche, ad esempio dallo spagnolo al giapponese.

Per calcolare un punteggio, BLEU in genere confronta la traduzione di un modello ML (testo generato) con la traduzione di un esperto umano (testo di riferimento). Il grado di corrispondenza tra gli n-grammi nel testo generato e nel testo di riferimento determina il punteggio BLEU.

Il documento originale su questa metrica è BLEU: a Method for Automatic Evaluation of Machine Translation.

Vedi anche BLEURT.

BLEURT (Bilingual Evaluation Understudy from Transformers)

Una metrica per valutare le traduzioni automatiche da una lingua all'altra, in particolare da e verso l'inglese.

Per le traduzioni da e verso l'inglese, BLEURT è più in linea con le valutazioni umane rispetto a BLEU. A differenza di BLEU, BLEURT enfatizza le somiglianze semantiche (di significato) e può ospitare la parafrasi.

BLEURT si basa su un modello linguistico di grandi dimensioni preaddestrato (BERT per l'esattezza) che viene poi ottimizzato sul testo di traduttori umani.

Il documento originale su questa metrica è BLEURT: Learning Robust Metrics for Text Generation.

Boolean Questions (BoolQ)

Un set di dati per valutare la competenza di un LLM nel rispondere a domande con risposta sì o no. Ognuna delle sfide nel set di dati è composta da tre componenti:

- Una query

- Un passaggio che implica la risposta alla query.

- La risposta corretta, che è sì o no.

Ad esempio:

- Query: ci sono centrali nucleari in Michigan?

- Passaggio: ...tre centrali nucleari forniscono al Michigan circa il 30% della sua elettricità.

- Risposta corretta: sì

I ricercatori hanno raccolto le domande da query di ricerca Google anonimizzate e aggregate e poi hanno utilizzato le pagine di Wikipedia per basare le informazioni.

Per saperne di più, consulta BoolQ: Exploring the Surprising Difficulty of Natural Yes/No Questions.

BoolQ è un componente dell'ensemble SuperGLUE.

BoolQ

Abbreviazione di Boolean Questions.

aumentare

Una tecnica di machine learning che combina in modo iterativo un insieme di modelli di classificazione semplici e non molto accurati (definiti "classificatori deboli") in un modello di classificazione con elevata accuratezza (un "classificatore forte") mediante l'assegnazione di un peso maggiore agli esempi che il modello sta attualmente classificando in modo errato.

Per ulteriori informazioni, consulta la sezione Gradient Boosted Decision Trees? del corso Decision Forests.

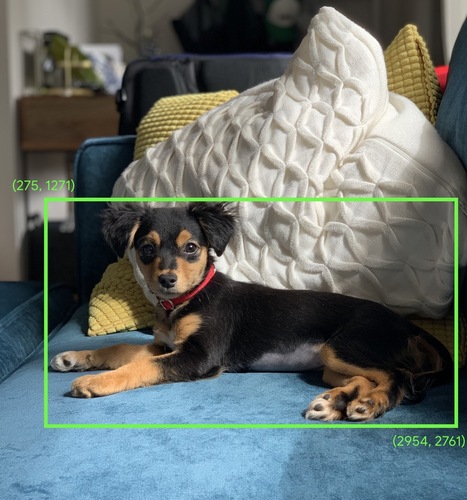

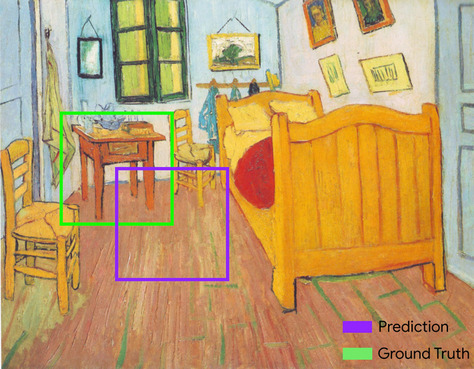

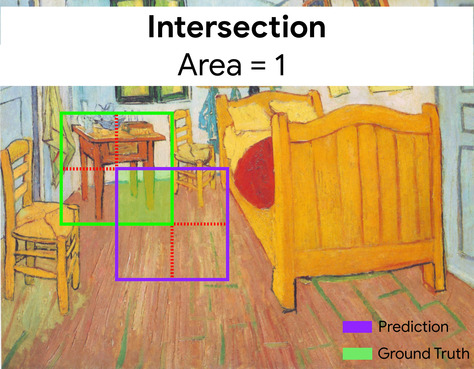

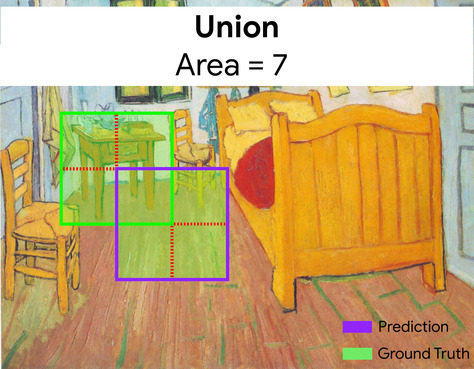

riquadro di delimitazione

In un'immagine, le coordinate (x, y) di un rettangolo attorno a un'area di interesse, ad esempio il cane nell'immagine seguente.

trasmissione

Espandere la forma di un operando in un'operazione matematica con matrici a dimensioni compatibili per l'operazione. Ad esempio, l'algebra lineare richiede che i due operandi in un'operazione di addizione matriciale abbiano le stesse dimensioni. Di conseguenza, non puoi aggiungere una matrice di forma (m, n) a un vettore di lunghezza n. La trasmissione consente questa operazione espandendo virtualmente il vettore di lunghezza n in una matrice di forma (m, n) replicando gli stessi valori in ogni colonna.

Per ulteriori dettagli, consulta la seguente descrizione del broadcasting in NumPy.

il bucketing

Conversione di una singola caratteristica in più caratteristiche binarie chiamate bucket o bin, in genere in base a un intervallo di valori. La caratteristica troncata è in genere una caratteristica continua.

Ad esempio, anziché rappresentare la temperatura come una singola caratteristica continua in virgola mobile, potresti dividere gli intervalli di temperature in bucket discreti, ad esempio:

- <= 10 gradi Celsius corrisponde al bucket "freddo".

- 11-24 gradi Celsius rientrano nella categoria "temperato".

- >= 25 gradi Celsius rientrerebbe nel bucket "caldo".

Il modello tratterà ogni valore nello stesso bucket in modo identico. Ad esempio, i valori 13 e 22 si trovano entrambi nel bucket temperato, quindi il modello tratta i due valori in modo identico.

Per saperne di più, consulta la sezione Dati numerici: Binning in Machine Learning Crash Course.

C

livello di calibrazione

Un aggiustamento post-previsione, in genere per tenere conto del bias di previsione. Le previsioni e le probabilità aggiustate devono corrispondere alla distribuzione di un insieme osservato di etichette.

generazione di candidati

Il set iniziale di consigli scelti da un sistema di consigli. Ad esempio, considera una libreria che offre 100.000 titoli. La fase di generazione dei candidati crea un elenco molto più piccolo di libri adatti a un determinato utente, ad esempio 500. Ma anche 500 libri sono troppi da consigliare a un utente. Le fasi successive e più costose di un sistema di consigli (come l'assegnazione del punteggio e il riposizionamento) riducono questi 500 a un insieme di consigli molto più piccolo e utile.

Per ulteriori informazioni, consulta la panoramica della generazione di candidati nel corso sui sistemi di raccomandazione.

campionamento dei candidati

Un'ottimizzazione in fase di addestramento che calcola una probabilità per tutte le etichette positive, utilizzando, ad esempio, softmax, ma solo per un campione casuale di etichette negative. Ad esempio, dato un esempio etichettato beagle e dog, il campionamento dei candidati calcola le probabilità previste e i termini di perdita corrispondenti per:

- beagle

- cane

- un sottoinsieme casuale delle classi negative rimanenti (ad esempio, gatto, lecca-lecca, recinzione).

L'idea è che le classi negative possono imparare da un rinforzo negativo meno frequente, a condizione che le classi positive ricevano sempre un rinforzo positivo adeguato, e questo è effettivamente osservato empiricamente.

Il campionamento dei candidati è più efficiente dal punto di vista computazionale rispetto agli algoritmi di addestramento che calcolano le previsioni per tutte le classi negative, in particolare quando il numero di classi negative è molto elevato.

dati categorici

Caratteristiche con un insieme specifico di valori possibili. Ad esempio,

considera una funzionalità categorica denominata traffic-light-state, che può

avere solo uno dei seguenti tre valori possibili:

redyellowgreen

Rappresentando traffic-light-state come una caratteristica categorica,

un modello può apprendere

i diversi impatti di red, green e yellow sul comportamento del conducente.

Le caratteristiche categoriche sono a volte chiamate caratteristiche discrete.

Contrasto con i dati numerici.

Per saperne di più, consulta la sezione Utilizzo dei dati categorici di Machine Learning Crash Course.

modello linguistico causale

Sinonimo di modello linguistico unidirezionale.

Consulta la sezione Modello linguistico bidirezionale per confrontare i diversi approcci direzionali nella modellazione del linguaggio.

CB

Abbreviazione di CommitmentBank.

centroide

Il centro di un cluster determinato da un algoritmo K-means o K-medie. Ad esempio, se k è 3, l'algoritmo k-means o k-medie trova 3 centroidi.

Per saperne di più, consulta la sezione Algoritmi di clustering del corso Clustering.

clustering basato sui centroidi

Una categoria di algoritmi di clustering che organizzano i dati in cluster non gerarchici. k-means è l'algoritmo di clustering basato sui centroidi più utilizzato.

Contrasto con gli algoritmi di clustering gerarchico.

Per saperne di più, consulta la sezione Algoritmi di clustering del corso Clustering.

prompting chain-of-thought

Una tecnica di prompt engineering che incoraggia un modello linguistico di grandi dimensioni (LLM) a spiegare il suo ragionamento, passo dopo passo. Ad esempio, considera il seguente prompt, prestando particolare attenzione alla seconda frase:

Quante forze G sperimenterebbe un conducente in un'auto che passa da 0 a 96 km/h in 7 secondi? Nella risposta, mostra tutti i calcoli pertinenti.

La risposta dell'LLM probabilmente:

- Mostra una sequenza di formule di fisica, inserendo i valori 0, 60 e 7 nei punti appropriati.

- Spiega perché ha scelto queste formule e cosa significano le varie variabili.

La Chain-of-Thought Prompting costringe l'LLM a eseguire tutti i calcoli, il che potrebbe portare a una risposta più corretta. Inoltre, il prompting chain-of-thought consente all'utente di esaminare i passaggi dell'LLM per determinare se la risposta è sensata o meno.

Punteggio F di n-grammi di caratteri (ChrF)

Una metrica per valutare i modelli di traduzione automatica. L'F-score degli n-grammi di caratteri determina il grado di sovrapposizione degli n-grammi nel testo di riferimento con gli n-grammi nel testo generato di un modello ML.

Il punteggio F di n-grammi di caratteri è simile alle metriche delle famiglie ROUGE e BLEU, tranne per il fatto che:

- Il punteggio F degli n-grammi di caratteri opera sugli n-grammi di caratteri.

- ROUGE e BLEU operano su n-grammi di parole o token.

chat

I contenuti di un dialogo bot e utente con un sistema di ML, in genere un modello linguistico di grandi dimensioni. L'interazione precedente in una chat (ciò che hai digitato e come ha risposto il modello linguistico di grandi dimensioni) diventa il contesto per le parti successive della chat.

Un chatbot è un'applicazione di un modello linguistico di grandi dimensioni (LLM).

posto di blocco

Dati che acquisiscono lo stato dei parametri di un modello durante l'addestramento o al termine dell'addestramento. Ad esempio, durante l'addestramento, puoi:

- Interrompere l'addestramento, intenzionalmente o a causa di determinati errori.

- Acquisisci il checkpoint.

- In un secondo momento, ricarica il checkpoint, possibilmente su un hardware diverso.

- Riavvia l'addestramento.

Scelta di alternative plausibili (COPA)

Un set di dati per valutare la capacità di un LLM di identificare la migliore tra due risposte alternative a una premessa. Ciascuna delle sfide nel set di dati è composta da tre componenti:

- Una premessa, che in genere è un'affermazione seguita da una domanda

- Due possibili risposte alla domanda posta nella premessa, una delle quali è corretta e l'altra errata

- La risposta corretta

Ad esempio:

- Premessa:l'uomo si è rotto un dito del piede. Qual è stata la CAUSA?

- Risposte possibili:

- Ha un buco nel calzino.

- Gli è caduto un martello sul piede.

- Risposta corretta: 2

COPA è un componente dell'ensemble SuperGLUE.

classe

Una categoria a cui può appartenere un'etichetta. Ad esempio:

- In un modello di classificazione binaria che rileva lo spam, le due classi potrebbero essere spam e non spam.

- In un modello di classificazione multi-classe che identifica le razze di cani, le classi potrebbero essere barboncino, beagle, carlino e così via.

Un modello di classificazione prevede una classe. Al contrario, un modello di regressione prevede un numero anziché una classe.

Per saperne di più, consulta la sezione Classificazione di Machine Learning Crash Course.

set di dati bilanciato per classe

Un set di dati contenente etichette categoriche in cui il numero di istanze di ogni categoria è approssimativamente uguale. Ad esempio, considera un set di dati botanici la cui etichetta binaria può essere pianta autoctona o pianta non autoctona:

- Un set di dati con 515 piante autoctone e 485 piante non autoctone è un set di dati bilanciato per classe.

- Un set di dati con 875 piante autoctone e 125 piante non autoctone è un set di dati con classi sbilanciate.

Non esiste una linea di demarcazione formale tra i set di dati bilanciati per classe e i set di dati sbilanciati per classe. La distinzione diventa importante solo quando un modello addestrato su un set di dati con forte squilibrio di classe non riesce a convergere. Per ulteriori dettagli, consulta Dataset: dataset sbilanciati in Machine Learning Crash Course.

modello di classificazione

Un modello la cui previsione è una classe. Ad esempio, i seguenti sono tutti modelli di classificazione:

- Un modello che prevede la lingua di una frase di input (francese? Spagnolo? italiano?).

- Un modello che prevede le specie di alberi (acero? Quercia? Baobab?).

- Un modello che prevede la classe positiva o negativa per una particolare condizione medica.

Al contrario, i modelli di regressione prevedono numeri anziché classi.

Due tipi comuni di modelli di classificazione sono:

soglia di classificazione

In una classificazione binaria, un numero compreso tra 0 e 1 che converte l'output non elaborato di un modello di regressione logistica in una previsione della classe positiva o della classe negativa. Tieni presente che la soglia di classificazione è un valore scelto da un essere umano, non un valore scelto dall'addestramento del modello.

Un modello di regressione logistica restituisce un valore grezzo compreso tra 0 e 1. Quindi:

- Se questo valore grezzo è maggiore della soglia di classificazione, viene prevista la classe positiva.

- Se questo valore grezzo è inferiore alla soglia di classificazione, viene prevista la classe negativa.

Ad esempio, supponiamo che la soglia di classificazione sia 0,8. Se il valore non elaborato è 0,9, il modello prevede la classe positiva. Se il valore non elaborato è 0,7, il modello prevede la classe negativa.

La scelta della soglia di classificazione influisce notevolmente sul numero di falsi positivi e falsi negativi.

Per saperne di più, consulta Soglie e matrice di confusione in Machine Learning Crash Course.

classificatore

Un termine informale per un modello di classificazione.

set di dati sbilanciato per classe

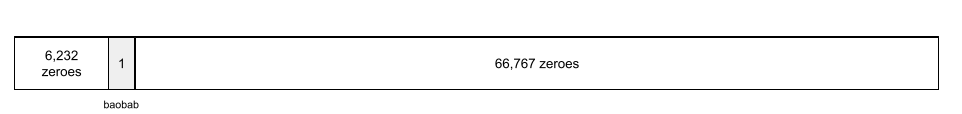

Un set di dati per una classificazione in cui il numero totale di etichette di ogni classe differisce in modo significativo. Ad esempio, considera un set di dati di classificazione binaria le cui due etichette sono suddivise come segue:

- 1.000.000 di etichette negative

- 10 etichette positive

Il rapporto tra etichette negative e positive è di 100.000 a 1, quindi si tratta di un set di dati con classi sbilanciate.

Al contrario, il seguente set di dati è bilanciato per classe perché il rapporto tra etichette negative ed etichette positive è relativamente vicino a 1:

- 517 etichette negative

- 483 etichette positive

I set di dati multiclasse possono anche essere sbilanciati. Ad esempio, il seguente set di dati di classificazione multiclasse è anche sbilanciato perché un'etichetta ha molti più esempi rispetto alle altre due:

- 1.000.000 di etichette con la classe "verde"

- 200 etichette con la classe "viola"

- 350 etichette con la classe "arancione"

L'addestramento di set di dati con classi sbilanciate può presentare sfide particolari. Per maggiori dettagli, consulta Dataset sbilanciati in Machine Learning Crash Course.

Vedi anche entropia, classe maggioritaria e classe minoritaria.

clipping

Una tecnica per gestire i valori anomali eseguendo una o entrambe le seguenti operazioni:

- Riduzione dei valori della funzionalità superiori a una soglia massima fino a tale soglia massima.

- Aumentando i valori delle funzionalità inferiori a una soglia minima fino a quella soglia minima.

Ad esempio, supponiamo che meno dello 0,5% dei valori di una determinata caratteristica rientri al di fuori dell'intervallo 40-60. In questo caso, puoi procedere come segue:

- Tronca tutti i valori superiori a 60 (la soglia massima) in modo che siano esattamente 60.

- Taglia tutti i valori inferiori a 40 (la soglia minima) in modo che siano esattamente 40.

Gli outlier possono danneggiare i modelli, a volte causando l'overflow dei pesi durante l'addestramento. Alcuni valori anomali possono anche rovinare drasticamente metriche come l'accuratezza. Il clipping è una tecnica comune per limitare i danni.

Il taglio del gradiente forza i valori del gradiente all'interno di un intervallo designato durante l'addestramento.

Per saperne di più, consulta Dati numerici: normalizzazione in Machine Learning Crash Course.

Cloud TPU

Un acceleratore hardware specializzato progettato per velocizzare i carichi di lavoro di machine learning su Google Cloud.

clustering

Raggruppare esempi correlati, in particolare durante l'apprendimento non supervisionato. Una volta raggruppati tutti gli esempi, una persona può facoltativamente fornire un significato a ogni cluster.

Esistono molti algoritmi di clustering. Ad esempio, l'algoritmo k-means raggruppa gli esempi in base alla loro vicinanza a un centroide, come nel seguente diagramma:

Un ricercatore umano potrebbe quindi esaminare i cluster e, ad esempio, etichettare il cluster 1 come "alberi nani" e il cluster 2 come "alberi di dimensioni normali".

Come altro esempio, considera un algoritmo di clustering basato sulla distanza di un esempio da un punto centrale, illustrato come segue:

Per saperne di più, consulta il corso sul clustering.

co-adattamento

Un comportamento indesiderato in cui i neuroni prevedono pattern nei dati di addestramento basandosi quasi esclusivamente sugli output di altri neuroni specifici anziché sul comportamento della rete nel suo complesso. Quando i pattern che causano la co-adattamento non sono presenti nei dati di convalida, la co-adattamento causa un overfitting. La regolarizzazione dropout riduce la co-adattamento perché il dropout garantisce che i neuroni non possano fare affidamento esclusivamente su altri neuroni specifici.

filtro collaborativo

Fare previsioni sugli interessi di un utente in base agli interessi di molti altri utenti. Il filtraggio collaborativo viene spesso utilizzato nei sistemi di suggerimenti.

Per saperne di più, consulta la sezione Filtro collaborativo del corso Recommendation Systems.

CommitmentBank (CB)

Un set di dati per valutare la competenza di un LLM nel determinare se l'autore di un passaggio crede in una clausola di destinazione all'interno di quel passaggio. Ogni voce del set di dati contiene:

- Un passaggio

- Una clausola di destinazione all'interno del passaggio

- Un valore booleano che indica se l'autore del passaggio ritiene che la clausola di destinazione

Ad esempio:

- Passaggio:che divertimento sentire ridere Artemide. È una bambina molto seria. Non sapevo che avesse il senso dell'umorismo.

- Clausola di targeting: aveva un senso dell'umorismo

- Booleano: True, il che significa che l'autore ritiene che la clausola di destinazione

CommitmentBank è un componente dell'insieme SuperGLUE.

modello compatto

Qualsiasi modello di piccole dimensioni progettato per essere eseguito su dispositivi di piccole dimensioni con risorse di calcolo limitate. Ad esempio, i modelli compatti possono essere eseguiti su cellulari, tablet o sistemi incorporati.

computing

(Sostantivo) Le risorse di calcolo utilizzate da un modello o un sistema, ad esempio potenza di elaborazione, memoria e spazio di archiviazione.

Vedi chip di accelerazione.

deviazione del concetto

Un cambiamento nella relazione tra le caratteristiche e l'etichetta. Nel tempo, la variazione del concetto riduce la qualità di un modello.

Durante l'addestramento, il modello apprende la relazione tra le funzionalità e le relative etichette nel set di addestramento. Se le etichette nel set di addestramento sono buone approssimazioni del mondo reale, il modello dovrebbe fare buone previsioni del mondo reale. Tuttavia, a causa della variazione del concetto, le previsioni del modello tendono a peggiorare nel tempo.

Ad esempio, considera un modello di classificazione binaria che prevede se un determinato modello di auto è "efficiente dal punto di vista del consumo di carburante". ovvero le caratteristiche potrebbero essere:

- peso dell'auto

- compressione del motore

- transmission type

mentre l'etichetta è:

- a basso consumo di carburante

- non a basso consumo di carburante

Tuttavia, il concetto di "auto a basso consumo di carburante" è in continua evoluzione. Un modello di auto etichettato come efficiente in termini di consumo di carburante nel 1994 sarebbe quasi certamente etichettato come non efficiente in termini di consumo di carburante nel 2024. Un modello che soffre di concept drift tende a fare previsioni sempre meno utili nel tempo.

Confronta e contrapponi con la non stazionarietà.

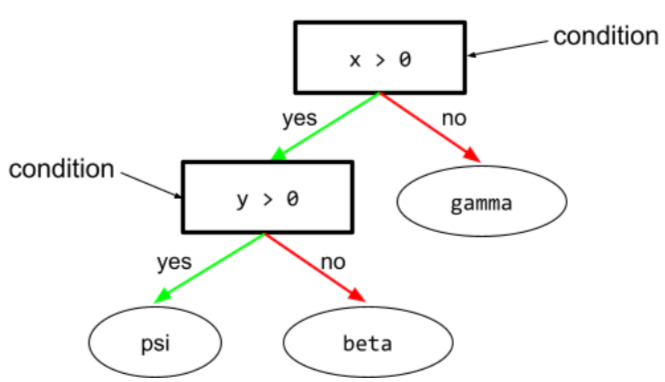

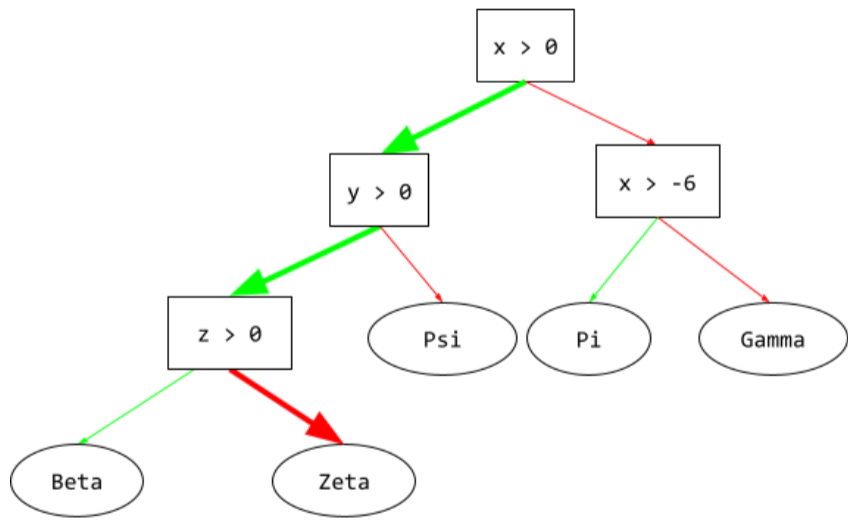

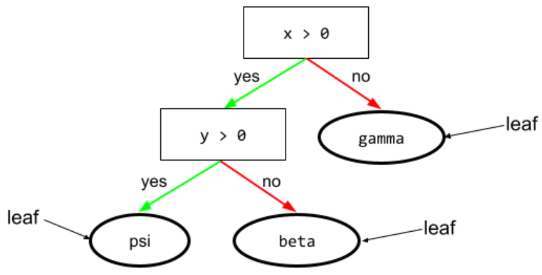

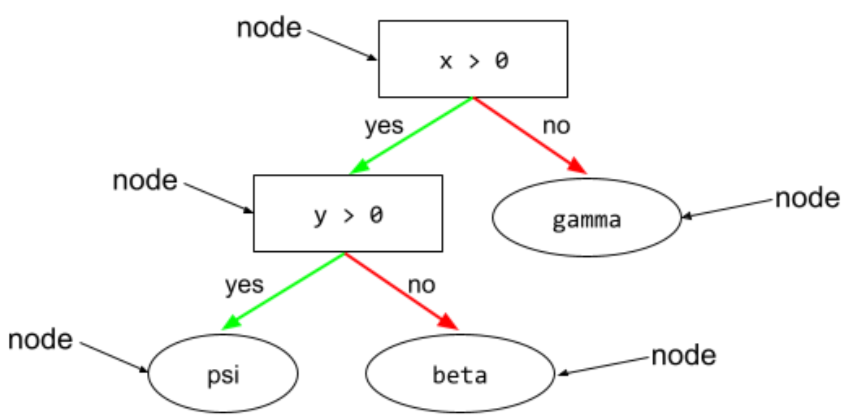

condizione

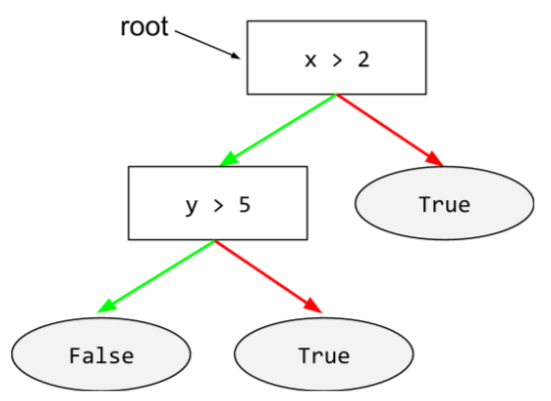

In un albero decisionale, qualsiasi nodo che esegue un test. Ad esempio, il seguente albero decisionale contiene due condizioni:

Una condizione è chiamata anche divisione o test.

Condizione di contrasto con foglia.

Vedi anche:

Per saperne di più, consulta la sezione Tipi di condizioni del corso Decision Forests.

confabulazione

Sinonimo di allucinazione.

Confabulazione è probabilmente un termine più preciso dal punto di vista tecnico rispetto ad allucinazione. Tuttavia, l'allucinazione è diventata popolare per prima.

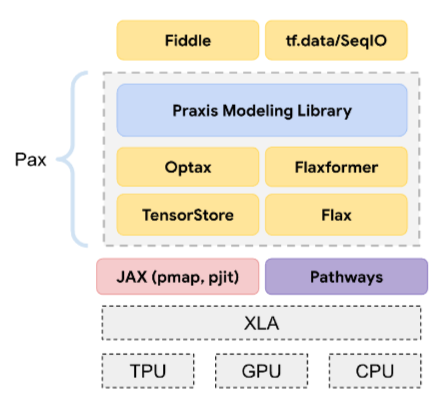

configurazione

Il processo di assegnazione dei valori iniziali delle proprietà utilizzati per addestrare un modello, inclusi:

- i livelli che compongono il modello

- la posizione dei dati

- iperparametri come:

Nei progetti di machine learning, la configurazione può essere eseguita tramite un file di configurazione speciale o utilizzando librerie di configurazione come le seguenti:

bias di conferma

La tendenza a cercare, interpretare, favorire e ricordare le informazioni in un modo che confermi le proprie convinzioni o ipotesi preesistenti. Gli sviluppatori di machine learning potrebbero raccogliere o etichettare i dati in modi che influenzano un risultato a sostegno delle loro convinzioni esistenti. Il bias di conferma è una forma di bias implicito.

Il bias dell'osservatore è una forma di bias di conferma in cui un osservatore continua ad addestrare i modelli finché un'ipotesi preesistente non viene confermata.

matrice di confusione

Una tabella NxN che riassume il numero di previsioni corrette e errate effettuate da un modello di classificazione. Ad esempio, considera la seguente matrice di confusione per un modello di classificazione binaria:

| Tumore (previsto) | Non tumorale (previsto) | |

|---|---|---|

| Tumore (dati di riferimento) | 18 (VP) | 1 (FN) |

| Non-Tumor (ground truth) | 6 (FP) | 452 (TN) |

La matrice di confusione precedente mostra quanto segue:

- Delle 19 previsioni in cui la verità di base era Tumore, il modello ne ha classificate correttamente 18 e in modo errato 1.

- Delle 458 previsioni in cui la verità di base era Non-Tumor, il modello ne ha classificate correttamente 452 e in modo errato 6.

La matrice di confusione per un problema di classificazione multiclasse può aiutarti a identificare i pattern di errori. Ad esempio, considera la seguente matrice di confusione per un modello di classificazione multiclasse a tre classi che classifica tre diversi tipi di iris (Virginica, Versicolor e Setosa). Quando i dati empirici reali erano Virginica, la matrice di confusione mostra che il modello aveva molte più probabilità di prevedere erroneamente Versicolor rispetto a Setosa:

| Setosa (previsto) | Versicolor (previsto) | Virginica (previsto) | |

|---|---|---|---|

| Setosa (dati di fatto) | 88 | 12 | 0 |

| Versicolor (dati di fatto) | 6 | 141 | 7 |

| Virginica (dati empirici reali) | 2 | 27 | 109 |

Come altro esempio, una matrice di confusione potrebbe rivelare che un modello addestrato a riconoscere le cifre scritte a mano tende a prevedere erroneamente 9 anziché 4 o 1 anziché 7.

Le matrici di confusione contengono informazioni sufficienti per calcolare una varietà di metriche di rendimento, tra cui precisione e richiamo.

analisi delle circoscrizioni

Suddivisione di una frase in strutture grammaticali più piccole ("costituenti"). Una parte successiva del sistema di ML, ad esempio un modello di comprensione del linguaggio naturale, può analizzare i costituenti più facilmente rispetto alla frase originale. Ad esempio, considera la seguente frase:

Il mio amico ha adottato due gatti.

Un analizzatore sintattico può dividere questa frase nei seguenti due costituenti:

- Il mio amico è una frase nominale.

- adopted two cats è una frase verbale.

Questi componenti possono essere ulteriormente suddivisi in componenti più piccoli. Ad esempio, il sintagma verbale

ha adottato due gatti

potrebbero essere ulteriormente suddivisi in:

- adottato è un verbo.

- due gatti è un altro sintagma nominale.

embedding contestuale del linguaggio

Un incorporamento che si avvicina alla "comprensione" di parole e frasi in modo simile a quello di una persona che parla fluentemente. Gli incorporamenti del linguaggio contestualizzato possono comprendere sintassi, semantica e contesto complessi.

Ad esempio, considera gli incorporamenti della parola inglese cow. Gli embedding precedenti, come word2vec, possono rappresentare le parole in inglese in modo che la distanza nello spazio di embedding da cow a bull sia simile alla distanza da ewe (pecora femmina) a ram (pecora maschio) o da female a male. Gli incorporamenti del linguaggio contestualizzato possono fare un ulteriore passo avanti riconoscendo che i parlanti inglesi a volte usano casualmente la parola cow per indicare sia la mucca che il toro.

finestra contestuale

Il numero di token che un modello può elaborare in un determinato prompt. Più è ampia la finestra contestuale, maggiore è la quantità di informazioni che il modello può utilizzare per fornire risposte coerenti e consistenti al prompt.

funzionalità continua

Una funzionalità in virgola mobile con un intervallo infinito di valori possibili, ad esempio temperatura o peso.

Contrasto con la funzionalità discreta.

campionamento di convenienza

Utilizzo di un set di dati non raccolti scientificamente per eseguire esperimenti rapidi. In un secondo momento, è essenziale passare a un set di dati raccolti scientificamente.

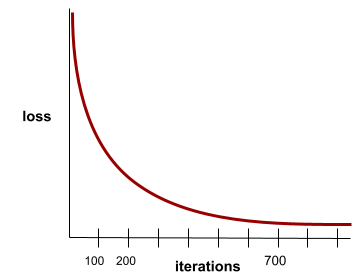

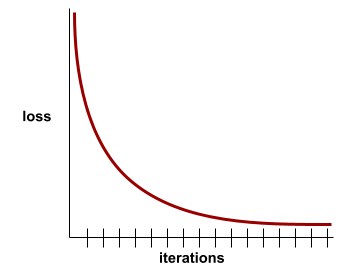

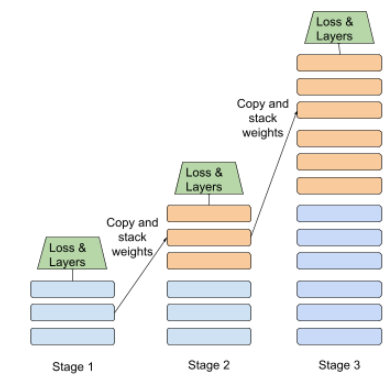

convergenza

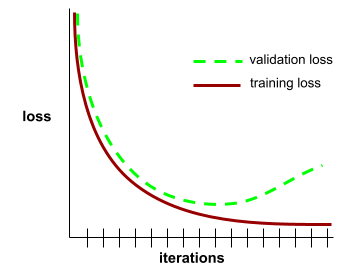

Uno stato raggiunto quando i valori di perdita cambiano molto poco o non cambiano affatto a ogni iterazione. Ad esempio, la seguente curva di perdita suggerisce la convergenza dopo circa 700 iterazioni:

Un modello converge quando un ulteriore addestramento non migliora il modello.

Nel deep learning, i valori di perdita a volte rimangono costanti o quasi per molte iterazioni prima di diminuire. Durante un lungo periodo di valori di perdita costanti, potresti avere temporaneamente una falsa sensazione di convergenza.

Vedi anche interruzione anticipata.

Per saperne di più, consulta Convergenza del modello e curve di perdita in Machine Learning Crash Course.

programmazione conversazionale

Un dialogo iterativo tra te e un modello di AI generativa allo scopo di creare software. Emetti un prompt che descrive un software. Poi, il modello utilizza questa descrizione per generare il codice. Poi, emetti un nuovo prompt per risolvere i difetti del prompt precedente o del codice generato e il modello genera il codice aggiornato. Continuate a fare avanti e indietro finché il software generato non è abbastanza buono.

Il conversation coding è essenzialmente il significato originale di vibe coding.

Contrasta con la codifica delle specifiche.

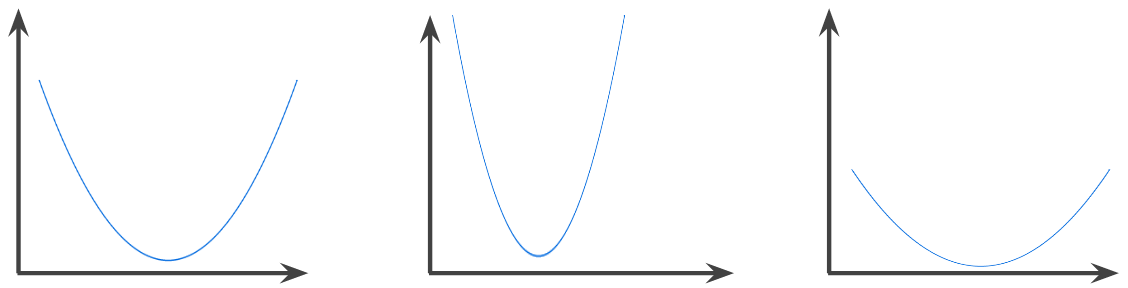

funzione convessa

Una funzione in cui la regione sopra il grafico della funzione è un insieme convesso. La funzione convessa prototipica ha una forma simile alla lettera U. Ad esempio, le seguenti sono tutte funzioni convesse:

Al contrario, la seguente funzione non è convessa. Nota come la regione sopra il grafico non sia un insieme convesso:

Una funzione strettamente convessa ha esattamente un punto di minimo locale, che è anche il punto di minimo globale. Le funzioni classiche a forma di U sono funzioni strettamente convesse. Tuttavia, alcune funzioni convesse (ad esempio le rette) non hanno forma a U.

Per saperne di più, consulta Convergenza e funzioni convesse in Machine Learning Crash Course.

ottimizzazione convessa

Il processo di utilizzo di tecniche matematiche come la discesa del gradiente per trovare il minimo di una funzione convessa. Gran parte della ricerca nel machine learning si è concentrata sulla formulazione di vari problemi come problemi di ottimizzazione convessa e sulla loro risoluzione in modo più efficiente.

Per tutti i dettagli, consulta Boyd e Vandenberghe, Convex Optimization.

insieme convesso

Un sottoinsieme dello spazio euclideo tale che una linea tracciata tra due punti qualsiasi del sottoinsieme rimanga completamente all'interno del sottoinsieme. Ad esempio, le seguenti due forme sono insiemi convessi:

Al contrario, le due forme seguenti non sono insiemi convessi:

convoluzione

In matematica, in termini semplici, una combinazione di due funzioni. Nel machine learning, una convoluzione combina il filtro convoluzionale e la matrice di input per addestrare i pesi.

Il termine "convoluzione" nel machine learning è spesso un modo abbreviato per fare riferimento all'operazione di convoluzione o al livello convoluzionale.

Senza convoluzioni, un algoritmo di machine learning dovrebbe apprendere un peso separato per ogni cella di un grande tensore. Ad esempio, un algoritmo di machine learning addestrato su immagini 2K x 2K sarebbe costretto a trovare 4 milioni di pesi separati. Grazie alle convoluzioni, un algoritmo di machine learning deve trovare i pesi solo per ogni cella del filtro convoluzionale, riducendo drasticamente la memoria necessaria per addestrare il modello. Quando viene applicato il filtro convoluzionale, viene semplicemente replicato nelle celle in modo che ognuna venga moltiplicata per il filtro.

filtro convoluzionale

Uno dei due attori in un'operazione di convoluzione. (L'altro attore è una sezione di una matrice di input.) Un filtro convoluzionale è una matrice con lo stesso rango della matrice di input, ma una forma più piccola. Ad esempio, data una matrice di input 28x28, il filtro potrebbe essere qualsiasi matrice 2D più piccola di 28x28.

Nella manipolazione fotografica, tutte le celle di un filtro convoluzionale sono in genere impostate su un pattern costante di 1 e 0. Nel machine learning, i filtri convoluzionali vengono in genere inizializzati con numeri casuali e poi la rete addestra i valori ideali.

livello convoluzionale

Uno strato di una rete neurale profonda in cui un filtro convoluzionale passa lungo una matrice di input. Ad esempio, considera il seguente filtro convoluzionale 3x3:

![Una matrice 3x3 con i seguenti valori: [[0,1,0], [1,0,1], [0,1,0]]](https://developers.google.com/static/machine-learning/glossary/images/ConvolutionalFilter33.svg?hl=it)

L'animazione seguente mostra un livello convoluzionale costituito da 9 operazioni convoluzionali che coinvolgono la matrice di input 5x5. Tieni presente che ogni operazione di convoluzione funziona su una diversa sezione 3x3 della matrice di input. La matrice 3x3 risultante (a destra) è costituita dai risultati delle 9 operazioni di convoluzione:

![Un'animazione che mostra due matrici. La prima matrice è la matrice 5x5

[[128,97,53,201,198], [35,22,25,200,195],

[37,24,28,197,182], [33,28,92,195,179], [31,40,100,192,177]].

La seconda matrice è la matrice 3x3:

[[181,303,618], [115,338,605], [169,351,560]].

La seconda matrice viene calcolata applicando il filtro

convoluzionale [[0, 1, 0], [1, 0, 1], [0, 1, 0]] a

diversi sottoinsiemi 3x3 della matrice 5x5.](https://developers.google.com/static/machine-learning/glossary/images/AnimatedConvolution.gif?hl=it)

rete neurale convoluzionale

Una rete neurale in cui almeno uno strato è uno strato convoluzionale. Una tipica rete neurale convoluzionale è costituita da una combinazione dei seguenti livelli:

Le reti neurali convoluzionali hanno ottenuto ottimi risultati in alcuni tipi di problemi, come il riconoscimento delle immagini.

operazione di convoluzione

La seguente operazione matematica in due passaggi:

- Moltiplicazione elemento per elemento del filtro convoluzionale e di una sezione di una matrice di input. (La sezione della matrice di input ha lo stesso rango e le stesse dimensioni del filtro convoluzionale.)

- Somma di tutti i valori nella matrice dei prodotti risultante.

Ad esempio, considera la seguente matrice di input 5x5:

![La matrice 5x5: [[128,97,53,201,198], [35,22,25,200,195],

[37,24,28,197,182], [33,28,92,195,179], [31,40,100,192,177]].](https://developers.google.com/static/machine-learning/glossary/images/ConvolutionalLayerInputMatrix.svg?hl=it)

Ora immagina il seguente filtro convoluzionale 2x2:

![La matrice 2x2: [[1, 0], [0, 1]]](https://developers.google.com/static/machine-learning/glossary/images/ConvolutionalLayerFilter.svg?hl=it)

Ogni operazione di convoluzione coinvolge una singola sezione 2x2 della matrice di input. Ad esempio, supponiamo di utilizzare la sezione 2x2 in alto a sinistra della matrice di input. Pertanto, l'operazione di convoluzione su questa sezione è la seguente:

![Applicazione del filtro convoluzionale [[1, 0], [0, 1]] alla sezione 2x2 in alto a sinistra

della matrice di input, ovvero [[128,97], [35,22]].

Il filtro convoluzionale lascia intatti 128 e 22, ma azzera

97 e 35. Di conseguenza, l'operazione di convoluzione produce

il valore 150 (128+22).](https://developers.google.com/static/machine-learning/glossary/images/ConvolutionalLayerOperation.svg?hl=it)

Un livello convoluzionale è costituito da una serie di operazioni convoluzionali, ognuna delle quali agisce su una sezione diversa della matrice di input.

COPA

Abbreviazione di Scelta di alternative plausibili.

costo

Sinonimo di perdita.

co-training

Un approccio di apprendimento semi-supervisionato particolarmente utile quando sono vere tutte le seguenti condizioni:

- Il rapporto tra esempi senza etichetta ed esempi con etichetta nel set di dati è elevato.

- Si tratta di un problema di classificazione (binaria o multiclasse).

- Il set di dati contiene due diversi insiemi di caratteristiche predittive indipendenti l'uno dall'altro e complementari.

Il co-training amplifica essenzialmente i segnali indipendenti in un segnale più forte. Ad esempio, considera un modello di classificazione che classifica le singole auto usate come Buone o Cattive. Un insieme di funzionalità predittive potrebbe concentrarsi su caratteristiche aggregate come l'anno, la marca e il modello dell'auto; un altro insieme di funzionalità predittive potrebbe concentrarsi su la cronologia di guida del precedente proprietario e la cronologia di manutenzione dell'auto.

L'articolo fondamentale sul co-training è Combining Labeled and Unlabeled Data with Co-Training di Blum e Mitchell.

equità controfattuale

Una metrica di equità che controlla se un modello di classificazione produce lo stesso risultato per un individuo e per un altro individuo identico al primo, tranne per uno o più attributi sensibili. La valutazione di un modello di classificazione per l'equità controfattuale è un metodo per individuare potenziali fonti di bias in un modello.

Per ulteriori informazioni, consulta una delle seguenti risorse:

- Equità: equità controfattuale in Machine Learning Crash Course.

- When Worlds Collide: Integrating Different Counterfactual Assumptions in Fairness

bias di copertura

Consulta la sezione Bias di selezione.

crash blossom

Una frase o un'espressione con un significato ambiguo. I crash blossom rappresentano un problema significativo nella comprensione del linguaggio naturale. Ad esempio, il titolo Red Tape Holds Up Skyscraper è un crash blossom perché un modello NLU potrebbe interpretare il titolo letteralmente o figurativamente.

critico

Sinonimo di Deep Q-Network.

entropia incrociata

Una generalizzazione della perdita logaritmica per problemi di classificazione multiclasse. L'entropia incrociata quantifica la differenza tra due distribuzioni di probabilità. Vedi anche perplessità.

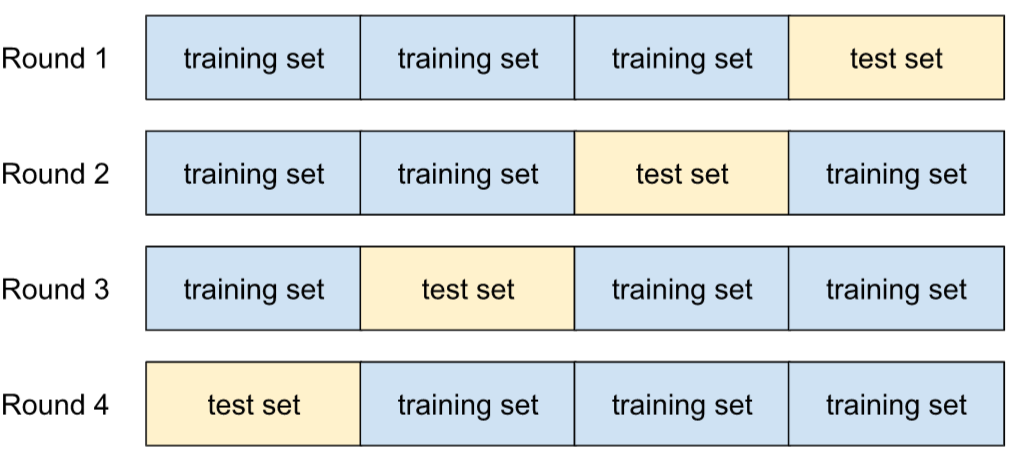

convalida incrociata

Un meccanismo per stimare il livello di generalizzazione di un modello a nuovi dati testando il modello su uno o più sottoinsiemi di dati non sovrapposti sottratti dal set di addestramento.

funzione di distribuzione cumulativa (CDF)

Una funzione che definisce la frequenza dei campioni minore o uguale a un valore target. Ad esempio, considera una distribuzione normale di valori continui. Una CDF indica che circa il 50% dei campioni deve essere inferiore o uguale alla media e che circa l'84% dei campioni deve essere inferiore o uguale a una deviazione standard sopra la media.

D

analisi dei dati

Ottenere una comprensione dei dati considerando campioni, misurazioni e visualizzazioni. L'analisi dei dati può essere particolarmente utile quando un set di dati viene ricevuto per la prima volta, prima di creare il primo modello. È fondamentale anche per comprendere gli esperimenti e risolvere i problemi del sistema.

aumento dei dati

Aumentare artificialmente l'intervallo e il numero di esempi di addestramento trasformando gli esempi esistenti per creare esempi aggiuntivi. Ad esempio, supponiamo che le immagini siano una delle tue caratteristiche, ma il tuo set di dati non contiene esempi di immagini sufficienti per consentire al modello di apprendere associazioni utili. Idealmente, dovresti aggiungere al tuo set di dati un numero sufficiente di immagini etichettate per consentire al modello di addestrarsi correttamente. Se non è possibile, l'aumento dei dati può ruotare, allungare e riflettere ogni immagine per produrre molte varianti dell'immagine originale, ottenendo così dati etichettati sufficienti per consentire un ottimo addestramento.

DataFrame

Un tipo di dati pandas popolare per rappresentare set di dati in memoria.

Un DataFrame è analogo a una tabella o a un foglio di lavoro. Ogni colonna di un DataFrame ha un nome (un'intestazione) e ogni riga è identificata da un numero univoco.

Ogni colonna di un DataFrame è strutturata come un array bidimensionale, tranne per il fatto che a ogni colonna può essere assegnato un proprio tipo di dati.

Consulta anche la pagina di riferimento di pandas.DataFrame ufficiale.

parallelismo dei dati

Un modo per scalare l'addestramento o l'inferenza che replica un intero modello su più dispositivi e poi passa un sottoinsieme dei dati di input a ciascun dispositivo. Il parallelismo dei dati può consentire l'addestramento e l'inferenza su batch di dimensioni molto grandi; tuttavia, il parallelismo dei dati richiede che il modello sia abbastanza piccolo da poter essere inserito in tutti i dispositivi.

Il parallelismo dei dati in genere accelera l'addestramento e l'inferenza.

Vedi anche parallelismo del modello.

API Dataset (tf.data)

Un'API TensorFlow di alto livello per leggere i dati e

trasformarli in un formato richiesto da un algoritmo di machine learning.

Un oggetto tf.data.Dataset rappresenta una sequenza di elementi, in cui ogni elemento contiene uno o più tensori. Un oggetto tf.data.Iterator fornisce l'accesso agli elementi di un Dataset.

set di dati

Una raccolta di dati non elaborati, comunemente (ma non esclusivamente) organizzati in uno dei seguenti formati:

- un foglio di lavoro

- un file in formato CSV (valori separati da virgola)

confine decisionale

Il separatore tra le classi apprese da un modello in un problema di classificazione binaria o multiclasse. Ad esempio, nell'immagine seguente che rappresenta un problema di classificazione binaria, il confine decisionale è la frontiera tra la classe arancione e la classe blu:

foresta decisionale

Un modello creato da più alberi decisionali. Una foresta decisionale fa una previsione aggregando le previsioni dei suoi alberi decisionali. I tipi più comuni di foreste decisionali includono foreste casuali e alberi potenziati dal gradiente.

Per ulteriori informazioni, consulta la sezione Foreste decisionali del corso sulle foreste decisionali.

soglia di decisione

Sinonimo di soglia di classificazione.

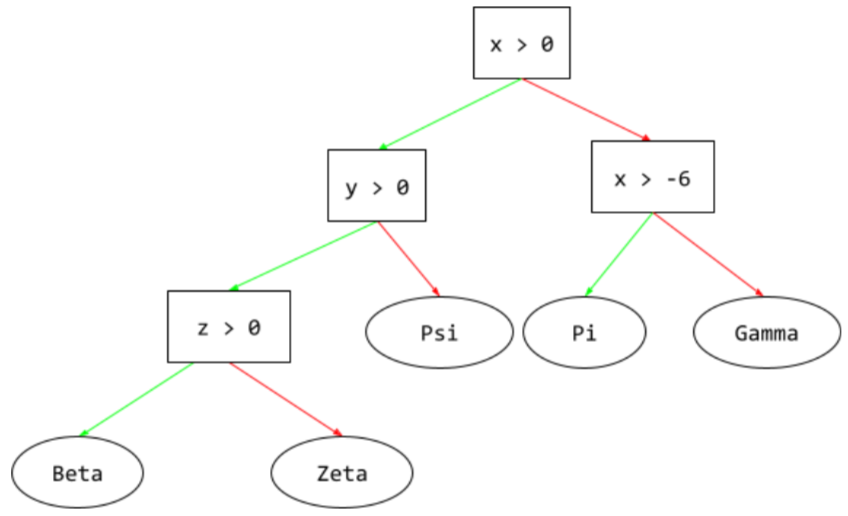

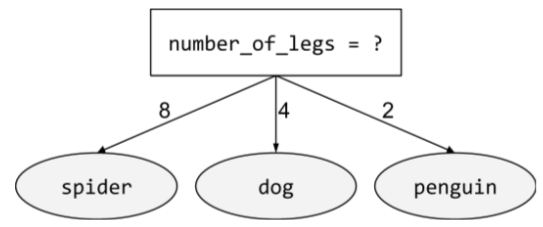

albero decisionale

Un modello di apprendimento supervisionato composto da un insieme di condizioni e foglie organizzate gerarchicamente. Ad esempio, di seguito è riportata una struttura decisionale:

decoder

In generale, qualsiasi sistema ML che esegue la conversione da una rappresentazione elaborata, densa o interna a una rappresentazione più grezza, sparsa o esterna.

I decoder sono spesso un componente di un modello più grande, in cui vengono spesso accoppiati a un encoder.

Nelle attività di sequenza-sequenza, un decoder inizia con lo stato interno generato dall'encoder per prevedere la sequenza successiva.

Consulta Transformer per la definizione di un decoder all'interno dell'architettura Transformer.

Per saperne di più, consulta Modelli linguistici di grandi dimensioni in Machine Learning Crash Course.

modello profondo

Una rete neurale contenente più di un strato nascosto.

Un modello profondo è chiamato anche rete neurale profonda.

Contrasta con il modello ampio.

per le reti neurali profonde

Sinonimo di modello profondo.

Deep Q-Network (DQN)

Nel Q-learning, una rete neurale profonda che prevede le funzioni Q.

Critico è un sinonimo di Deep Q-Network.

parità demografica

Una metrica di equità che viene soddisfatta se i risultati della classificazione di un modello non dipendono da un determinato attributo sensibile.

Ad esempio, se sia i lillipuziani che i brobdingnagiani fanno domanda all'Università di Glubbdubdrib, la parità demografica viene raggiunta se la percentuale di lillipuziani ammessi è la stessa di quella dei brobdingnagiani ammessi, indipendentemente dal fatto che un gruppo sia in media più qualificato dell'altro.

Contrasto con probabilità equalizzate e uguaglianza delle opportunità, che consentono ai risultati della classificazione aggregata di dipendere da attributi sensibili, ma non consentono ai risultati della classificazione per determinate etichette verità di riferimento specificate di dipendere da attributi sensibili. Consulta "Attacking discrimination with smarter machine learning" per una visualizzazione che esplora i compromessi quando si esegue l'ottimizzazione per la parità demografica.

Per saperne di più, consulta Equità: parità demografica in Machine Learning Crash Course.

riduzione del rumore

Un approccio comune all'apprendimento auto-supervisionato in cui:

La rimozione del rumore consente l'apprendimento da esempi non etichettati. Il set di dati originale funge da target o etichetta e i dati rumorosi da input.

Alcuni modelli linguistici mascherati utilizzano la rimozione del rumore nel seguente modo:

- Il rumore viene aggiunto artificialmente a una frase senza etichetta mascherando alcuni dei token.

- Il modello tenta di prevedere i token originali.

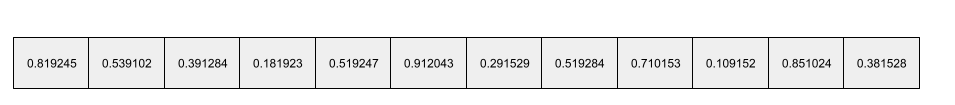

caratteristica densa

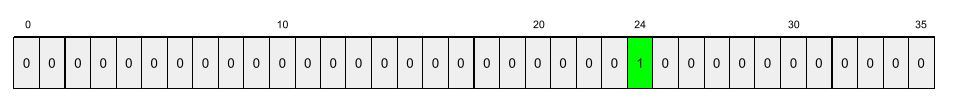

Una caratteristica in cui la maggior parte o tutti i valori sono diversi da zero, in genere un tensore di valori in virgola mobile. Ad esempio, il seguente tensore di 10 elementi è denso perché 9 dei suoi valori sono diversi da zero:

| 8 | 3 | 7 | 5 | 2 | 4 | 0 | 4 | 9 | 6 |

Contrasto con la funzionalità sparsa.

strato denso

Sinonimo di strato completamente connesso.

profondità

La somma di quanto segue in una rete neurale:

- il numero di livelli nascosti

- il numero di livelli di output, in genere 1

- il numero di eventuali strati di embedding

Ad esempio, una rete neurale con cinque strati nascosti e uno strato di output ha una profondità di 6.

Tieni presente che il livello di input non influisce sulla profondità.

rete neurale convoluzionale separabile per profondità (sepCNN)

Un'architettura di rete neurale convoluzionale basata su Inception, ma in cui i moduli Inception vengono sostituiti da convoluzioni separabili in profondità. Noto anche come Xception.

Una convoluzione separabile per profondità (abbreviata anche come convoluzione separabile) fattorizza una convoluzione 3D standard in due operazioni di convoluzione separate più efficienti dal punto di vista computazionale: prima una convoluzione separabile per profondità, con una profondità di 1 (n ✕ n ✕ 1), e poi una convoluzione puntuale, con lunghezza e larghezza di 1 (1 ✕ 1 ✕ n).

Per saperne di più, consulta Xception: Deep Learning with Depthwise Separable Convolutions.

etichetta derivata

Sinonimo di etichetta proxy.

dispositivo

Un termine sovraccarico con le seguenti due possibili definizioni:

- Una categoria di hardware in grado di eseguire una sessione TensorFlow, tra cui CPU, GPU e TPU.

- Quando si addestra un modello ML su chip acceleratori (GPU o TPU), la parte del sistema che manipola effettivamente tensori e incorporamenti. Il dispositivo funziona con chip di accelerazione. Al contrario, l'host in genere viene eseguito su una CPU.

privacy differenziale

Nell'apprendimento automatico, un approccio di anonimizzazione per proteggere i dati sensibili (ad esempio, le informazioni personali di un individuo) inclusi nel set di addestramento di un modello dall'esposizione. Questo approccio garantisce che il modello non impari o ricordi molto di una persona specifica. Ciò si ottiene campionando e aggiungendo rumore durante l'addestramento del modello per oscurare i singoli punti dati, riducendo il rischio di esporre dati di addestramento sensibili.

La privacy differenziale viene utilizzata anche al di fuori del machine learning. Ad esempio, i data scientist a volte utilizzano la privacy differenziale per proteggere la privacy individuale quando calcolano le statistiche sull'utilizzo dei prodotti per diverse categorie demografiche.

riduzione delle dimensioni

Riduzione del numero di dimensioni utilizzate per rappresentare una determinata funzionalità in un vettore delle funzionalità, in genere mediante la conversione in un vettore di incorporamento.

dimensioni

Termine sovraccarico con una delle seguenti definizioni:

Il numero di livelli di coordinate in un Tensor. Ad esempio:

- Uno scalare ha zero dimensioni, ad esempio

["Hello"]. - Un vettore ha una dimensione, ad esempio

[3, 5, 7, 11]. - Una matrice ha due dimensioni, ad esempio

[[2, 4, 18], [5, 7, 14]]. Puoi specificare in modo univoco una cella particolare in un vettore unidimensionale con una coordinata; hai bisogno di due coordinate per specificare in modo univoco una cella particolare in una matrice bidimensionale.

- Uno scalare ha zero dimensioni, ad esempio

Il numero di voci in un vettore di caratteristiche.

Il numero di elementi in un livello di incorporamento.

prompt diretto

Sinonimo di prompting zero-shot.

funzionalità discreta

Una caratteristica con un insieme finito di valori possibili. Ad esempio, una caratteristica i cui valori possono essere solo animale, vegetale o minerale è una caratteristica discreta (o categorica).

Contrasto con la caratteristica continua.

modello discriminativo

Un modello che prevede etichette da un insieme di una o più caratteristiche. Più formalmente, i modelli discriminativi definiscono la probabilità condizionale di un output in base alle funzionalità e ai pesi, ovvero:

p(output | features, weights)

Ad esempio, un modello che prevede se un'email è spam a partire da caratteristiche e pesi è un modello discriminante.

La stragrande maggioranza dei modelli di apprendimento supervisionato, inclusi i modelli di classificazione e regressione, sono modelli discriminativi.

Contrasto con il modello generativo.

discriminatore

Un sistema che determina se gli esempi sono reali o falsi.

In alternativa, il sottosistema all'interno di una rete generativa avversaria che determina se gli esempi creati dal generatore sono reali o falsi.

Per saperne di più, consulta la sezione Il discriminatore del corso sulle GAN.

impatto discriminatorio

Prendere decisioni sulle persone che influiscono in modo sproporzionato su diversi sottogruppi della popolazione. In genere si riferisce a situazioni in cui un processo decisionale algoritmico danneggia o avvantaggia alcuni sottogruppi più di altri.

Ad esempio, supponiamo che un algoritmo che determina l'idoneità di un lillipuziano a un mutuo per una casa in miniatura abbia più probabilità di classificarlo come "non idoneo" se il suo indirizzo postale contiene un determinato codice postale. Se i lillipuziani Big-Endian hanno maggiori probabilità di avere indirizzi postali con questo codice postale rispetto ai lillipuziani Little-Endian, questo algoritmo potrebbe comportare un impatto disparato.