Bu bölümde aşağıdaki üç soru ele alınmaktadır:

- Sınıf dengeli veri kümeleri ile sınıf dengesiz veri kümeleri arasındaki fark nedir?

- Dengesiz bir veri kümesini eğitmek neden zordur?

- Dengesiz veri kümelerini eğitme sorunlarının üstesinden nasıl gelebilirsiniz?

Sınıf dengeli veri kümeleri ve sınıf dengesiz veri kümeleri

Değeri pozitif sınıf veya negatif sınıf olan bir kategorik etiket içeren bir veri kümesini ele alalım. Sınıf dengeli bir veri kümesinde, pozitif sınıfların ve negatif sınıfların sayısı yaklaşık olarak eşittir. Örneğin, 235 pozitif sınıf ve 247 negatif sınıf içeren bir veri kümesi dengeli bir veri kümesidir.

Sınıf dengesizliği olan bir veri kümesinde bir etiket diğerinden çok daha yaygındır. Gerçek hayatta, sınıf dengesizliği olan veri kümeleri, sınıf dengeli veri kümelerinden çok daha yaygındır. Örneğin, kredi kartı işlemlerinden oluşan bir veri kümesinde sahtekarlık içeren satın alma işlemleri, örneklerin% 0,1'inden daha azını oluşturabilir. Benzer şekilde, tıbbi teşhis veri kümesinde nadir bir virüse yakalanan hasta sayısı, toplam örneklerin% 0,01'inden az olabilir. Sınıf dengesizliği olan bir veri kümesinde:

- Daha yaygın olan etikete çoğunluk sınıfı denir.

- Daha az yaygın olan etiket, azınlık sınıfı olarak adlandırılır.

Sınıf dengesizliği olan veri kümelerini eğitmenin zorluğu

Eğitim, pozitif sınıfı negatif sınıftan başarıyla ayıran bir model oluşturmayı amaçlar. Bunun için toplu işlemlerin yeterli sayıda hem pozitif hem de negatif sınıfa sahip olması gerekir. Bu durum, hafif sınıf dengesizliği olan bir veri kümesi üzerinde eğitim yaparken sorun oluşturmaz. Çünkü küçük gruplar bile genellikle hem pozitif sınıf hem de negatif sınıf için yeterli örnek içerir. Ancak, sınıf dengesizliğinin ciddi olduğu bir veri kümesi, uygun eğitim için yeterli sayıda azınlık sınıfı örneği içermeyebilir.

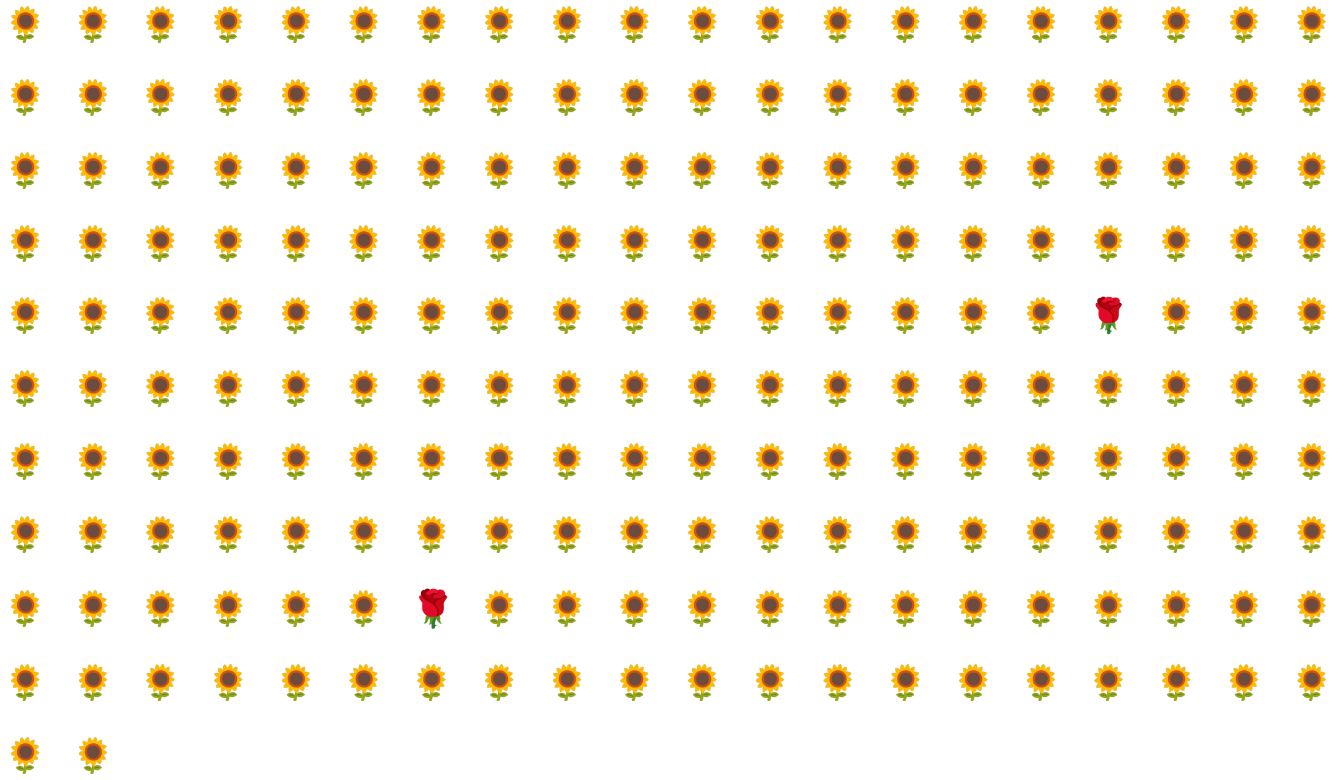

Örneğin, Şekil 6'da gösterilen sınıf dengesizliği olan veri kümesini ele alalım. Bu veri kümesinde:

- 200 etiket çoğunluk sınıfındadır.

- 2 etiket azınlık sınıfındadır.

Toplu işlem boyutu 20 ise çoğu toplu işlemde azınlık sınıfına ait örnekler yer almaz. Toplu iş boyutu 100 ise her toplu işte ortalama yalnızca bir azınlık sınıfı örneği bulunur. Bu, uygun eğitim için yeterli değildir. Çok daha büyük bir toplu iş boyutu bile modelin düzgün şekilde eğitilememesine neden olabilecek dengesiz bir oran oluşturur.

Sınıf dengesizliği olan bir veri kümesini eğitme

Eğitim sırasında bir model iki şey öğrenmelidir:

- Her sınıfın nasıl göründüğü; yani hangi özellik değerlerinin hangi sınıfa karşılık geldiği

- Her sınıfın ne kadar yaygın olduğu, yani sınıfların göreli dağılımı nedir?

Standart eğitimde bu iki hedef karıştırılır. Buna karşılık, çoğunluk sınıfını alt örnekleme ve ağırlıklandırma adı verilen aşağıdaki iki adımlı teknik, bu iki hedefi ayırarak modelin her iki hedefe de ulaşmasını sağlar.

1. adım: Çoğunluk sınıfını daha az örnekli hale getirin

Alt örnekleme, çoğunluk sınıfı örneklerinin orantısız bir şekilde düşük yüzdesi üzerinde eğitim yapmak anlamına gelir. Yani, eğitimden çok sayıda çoğunluk sınıfı örneğini çıkararak sınıf dengesizliği olan bir veri kümesini yapay olarak biraz daha dengeli hale getirirsiniz. Alt örnekleme, her grubun modeli düzgün ve verimli bir şekilde eğitmek için azınlık sınıfından yeterli örnek içerme olasılığını büyük ölçüde artırır.

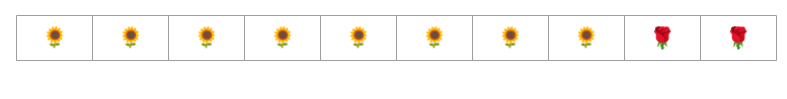

Örneğin, Şekil 6'da gösterilen dengesiz veri kümesi% 99 çoğunluk sınıfı ve% 1 azınlık sınıfı örneklerinden oluşur. Çoğunluk sınıfını 25 faktörüyle alt örnekleme, Şekil 7'de önerildiği gibi yapay olarak daha dengeli bir eğitim kümesi oluşturur (çoğunluk sınıfı% 80, azınlık sınıfı% 20).

2. adım: Alt örneklenmiş sınıfın ağırlığını artırın

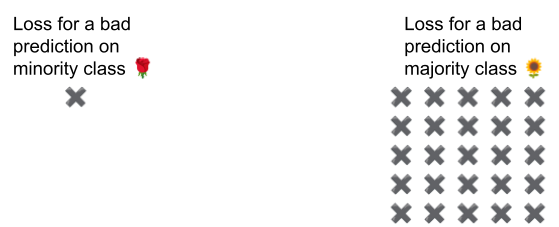

Alt örnekleme, sınıfların gerçek dünyadakinden daha dengeli olduğu yapay bir dünya göstererek modelde tahmin yanlılığına neden olur. Bu yanlılığı düzeltmek için, çoğunluk sınıflarını, örnekleme sıklığını azalttığınız faktörle "ağırlıklandırmanız" gerekir. Daha fazla ağırlık verme, çoğunluk sınıfı örneğindeki kaybı azınlık sınıfı örneğindeki kayıptan daha ağır şekilde ele almak anlamına gelir.

Örneğin, çoğunluk sınıfını 25 kat küçülttüğümüz için çoğunluk sınıfını 25 kat büyütmemiz gerekir. Yani model, çoğunluk sınıfını yanlışlıkla tahmin ettiğinde kaybı 25 hata varmış gibi ele alın (normal kaybı 25 ile çarpın).

Veri kümenizi yeniden dengelemek için ne kadar alt örnekleme ve üst ağırlıklandırma yapmalısınız? Yanıtı belirlemek için diğer hiperparametrelerle denemeler yaptığınız gibi farklı alt örnekleme ve ağırlıklandırma faktörleriyle denemeler yapmanız gerekir.

Bu tekniğin avantajları

Çoğunluk sınıfının alt örneklemesi ve ağırlığının artırılması aşağıdaki avantajları sağlar:

- Daha iyi model: Ortaya çıkan model, aşağıdakilerin ikisini de "bilir":

- Özellikler ve etiketler arasındaki bağlantı

- Sınıfların gerçek dağılımı

- Daha hızlı yakınsama: Eğitim sırasında model, azınlık sınıfını daha sık görür. Bu da modelin daha hızlı yakınsamasına yardımcı olur.