Коли модель оцінюють, показники, розраховані на основі всього набору даних для тестування чи перевірки, не завжди дають точне уявлення про її об’єктивність. Якщо модель загалом показує дуже гарні результати для більшості прикладів, це може маскувати низьку ефективність прогнозів для малої підмножини прикладів і, як наслідок, призвести до упередженості. Сукупні показники ефективності, як-от влучність, повнота й точність, не завжди допоможуть виявити ці проблеми.

Повернімося до моделі відбору кандидатів й розгляньмо кілька нових методів, які допоможуть оцінити її прогнози на упередженість з урахуванням принципу об’єктивності.

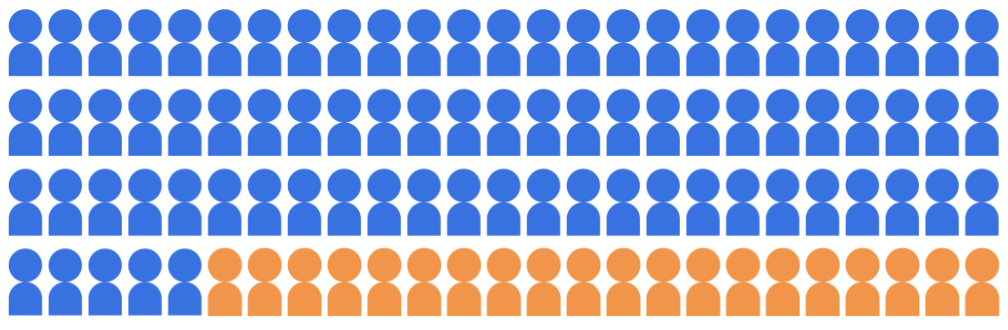

Припустімо, що класифікаційна модель відбору кандидатів відбирає для університету 20 зі 100 кандидатів, які належать до двох демографічних груп: групи більшості (синій колір, 80 студентів) і групи меншості (помаранчевий колір, 20 студентів).

Модель має відібрати кваліфікованих студентів у спосіб, справедливий для кандидатів з обох демографічних груп.

Як оцінити об’єктивність прогнозів моделі? Можна розглянути різні метрики, кожна з яких пропонує власне математичне визначення "справедливості". У наступних розділах ми детально розглянемо три показники об’єктивності: демографічну рівність, рівність можливостей і контрфактичну об’єктивність.