Questa pagina contiene i termini del glossario di Valutazione del linguaggio. Per tutti i termini del glossario, fai clic qui.

A

Attention,

Un meccanismo utilizzato in una rete neurale che indica l'importanza di una determinata parola o parte di una parola. L'attenzione comprime la quantità di informazioni di cui un modello ha bisogno per prevedere il token/la parola successiva. Un tipico meccanismo di attenzione potrebbe consistere in una somma ponderata su un insieme di input, in cui il peso per ogni input viene calcolato da un'altra parte della rete neurale.

Consulta anche l'articolo sull'auto-attenzione e sulla auto-attenzione multi-head, che sono i componenti di base dei Transformer.

Per saperne di più sull'autoattenzione, consulta LLM: che cos'è un modello linguistico di grandi dimensioni? nel corso introduttivo al machine learning.

autoencoder

Un sistema che impara a estrarre le informazioni più importanti dall'input. Gli autoencoder sono una combinazione di un encoder e di un decoder. Gli autocodificatori si basano sul seguente processo in due fasi:

- L'encoder mappa l'input a un formato (in genere) con perdita di dimensioni inferiori (intermedio).

- Il decodificatore crea una versione con perdita dell'input originale mappando il formato di dimensioni inferiori al formato di input originale di dimensioni superiori.

Gli autoencoder vengono addestrati end-to-end facendo in modo che il decodificatore cerchi di ricostruire l'input originale dal formato intermedio dell'encoder nel modo più preciso possibile. Poiché il formato intermedio è più piccolo (di dimensioni inferiori) rispetto al formato originale, l'autoencoder è costretto a imparare quali informazioni nell'input sono essenziali e l'output non sarà perfettamente identico all'input.

Ad esempio:

- Se i dati di input sono un'immagine, la copia non esatta sarà simile all'immagine originale, ma leggermente modificata. Forse la copia non esatta rimuove il rumore dalla grafica originale o completa alcuni pixel mancanti.

- Se i dati di input sono di tipo testo, un autoencoder genererà un nuovo testo che assomiglia (ma non è identico) al testo originale.

Vedi anche autoencoder variazionali.

valutazione automatica

Utilizzo di software per valutare la qualità dell'output di un modello.

Quando l'output del modello è relativamente semplice, uno script o un programma può confrontare l'output del modello con una risposta standard. Questo tipo di valutazione automatica è talvolta chiamato valutazione programmatica. Metriche come ROUGE o BLEU sono spesso utili per la valutazione programmatica.

Quando l'output del modello è complesso o non ha una sola risposta corretta, a volte la valutazione automatica viene eseguita da un programma di ML separato chiamato valutatore automatico.

È diverso dalla valutazione umana.

valutazione autore

Un meccanismo ibrido per valutare la qualità dell'output di un modello di IA generativa che combina la valutazione umana con la valutazione automatica. Un autore automatico è un modello di ML addestrato su dati creati tramite la valutazione umana. Idealmente, uno strumento di valutazione automatica impara a imitare un valutatore umano.Sono disponibili autoritratti predefiniti, ma i migliori sono ottimizzati in base all'attività che stai valutando.

modello autoregressivo

Un modello che deducono una previsione in base alle proprie predizioni precedenti. Ad esempio, i modelli linguistici autoregressivi prevedono il successivo token in base ai token previsti in precedenza. Tutti i modelli linguistici di grandi dimensioni basati su Transformer sono autoregressivi.

Al contrario, i modelli di immagini basati su GAN in genere non sono autoregressivi, poiché generano un'immagine in un unico passaggio in avanti e non in modo iterativo. Tuttavia, alcuni modelli di generazione di immagini sono autoregressivi perché generano un'immagine in più passaggi.

Precisione media a k

Una metrica per riepilogare il rendimento di un modello su un singolo prompt che genera risultati classificati, ad esempio un elenco numerato di consigli sui libri. La precisione media a k è la media dei valori di precisione a k per ogni risultato pertinente. La formula per la precisione media a k è quindi:

\[{\text{average precision at k}} = \frac{1}{n} \sum_{i=1}^n {\text{precision at k for each relevant item} } \]

dove:

- \(n\) è il numero di elementi pertinenti nell'elenco.

Confronta con il richiamo a k.

B

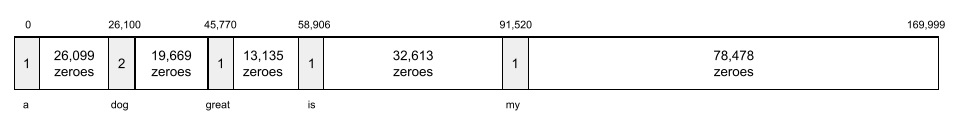

bag of words

Una rappresentazione delle parole in una frase o un passaggio, indipendentemente dall'ordine. Ad esempio, il bag of words rappresenta le seguenti tre frasi in modo identico:

- il cane salta

- salta il cane

- cane salta

Ogni parola viene associata a un indice in un vettore sparso, dove il vettore ha un indice per ogni parola del vocabolario. Ad esempio, la frase il cane salta viene mappata in un vettore di caratteristiche con valori diversi da zero nei tre indici corrispondenti alle parole il, cane e salta. Il valore diverso da zero può essere uno dei seguenti:

- Un 1 per indicare la presenza di una parola.

- Un conteggio del numero di volte in cui una parola compare nel bag. Ad esempio, se la frase fosse il cane marrone è un cane con pelo marrone, sia marrone che cane verrebbero rappresentati come 2, mentre le altre parole come 1.

- Qualche altro valore, ad esempio il logaritmo del conteggio del numero di volte che una parola compare nel bag.

BERT (Bidirectional Encoder Representations from Transformers)

Un'architettura del modello per la rappresentazione del testo. Un modello BERT addestrato può essere parte di un modello più grande per la classificazione del testo o altre attività di ML.

BERT presenta le seguenti caratteristiche:

- Utilizza l'architettura Transformer e, pertanto, si basa sull'auto-attenzione.

- Utilizza la parte encoder del Transformer. Il compito dell'codificatore è produrre buone rappresentazioni del testo, anziché eseguire un'attività specifica come la classificazione.

- È bidirezionale.

- Utilizza il mascheramento per l'addestramento non supervisionato.

Le varianti di BERT includono:

Per una panoramica di BERT, consulta Open Sourcing BERT: State-of-the-Art Pre-training for Natural Language Processing.

bidirezionale

Termine utilizzato per descrivere un sistema che valuta il testo che precede e segue una sezione di testo target. Al contrario, un sistema unidirezionale valuta solo il testo che precede una sezione di testo target.

Ad esempio, considera un modello linguistico con maschera che deve determinare le probabilità per la parola o le parole che rappresentano il tratto sottolineato nella seguente domanda:

Che cos'è il _____?

Un modello linguistico unidirezionale dovrebbe basare le sue probabilità solo sul contesto fornito dalle parole "Che cosa", "è" e "il". Al contrario, un modello linguistico bidirezionale potrebbe anche acquisire il contesto da "con" e "tu", il che potrebbe aiutare il modello a generare previsioni migliori.

modello linguistico bidirezionale

Un modello linguistico che determina la probabilità che un determinato token sia presente in una determinata posizione in un estratto di testo in base al testo precedente e successivo.

bigramma

Un n-gramma in cui N=2.

BLEU (Bilingual Evaluation Understudy)

Una metrica compresa tra 0,0 e 1,0 per valutare le traduzioni automatiche, ad esempio dallo spagnolo al giapponese.

Per calcolare un punteggio, BLEU in genere confronta la traduzione di un modello di ML (testo generato) con la traduzione di un esperto umano (testo di riferimento). Il grado di corrispondenza degli n-grammi nel testo generato e nel testo di riferimento determina il punteggio BLEU.

Il documento originale su questa metrica è BLEU: a Method for Automatic Evaluation of Machine Translation.

Vedi anche BLEURT.

BLEURT (Bilingual Evaluation Understudy from Transformers)

Una metrica per valutare le traduzioni automatiche da una lingua all'altra, in particolare verso e dall'inglese.

Per le traduzioni verso e dall'inglese, BLEURT è più in linea con le valutazioni umane rispetto a BLEU. A differenza di BLEU, BLEURT enfatizza le somiglianze semantiche (di significato) e può adattarsi al parafrasaggio.

BLEURT si basa su un modello linguistico di grandi dimensioni preaddestrato (per l'esattezza BERT) che viene poi ottimizzato sul testo di traduttori umani.

Il documento originale su questa metrica è BLEURT: Learning Robust Metrics for Text Generation.

C

modello linguistico causale

Sinonimo di modello linguistico unidirezionale.

Consulta modello linguistico bidirezionale per mettere in risalto i diversi approcci diretti nella creazione di modelli linguistici.

Chain-of-Thought Prompting

Una tecnica di progettazione di prompt che incoraggia un modello linguistico di grandi dimensioni (LLM) a spiegare il suo ragionamento passo passo. Ad esempio, considera il seguente prompt, prestando particolare attenzione alla seconda frase:

Quante forze g vengono sperimentate da un conducente in un'auto che passa da 0 a 96 km/h in 7 secondi? Nella risposta, mostra tutti i calcoli pertinenti.

La risposta dell'LLM probabilmente:

- Mostra una sequenza di formule fisiche, inserendo i valori 0, 60 e 7 nei punti appropriati.

- Spiega perché ha scelto queste formule e il significato delle varie variabili.

La Chain-of-Thought Prompting costringe l'LLM a eseguire tutti i calcoli, che potrebbero portare a una risposta più corretta. Inoltre, i prompt della catena di pensiero consentono all'utente di esaminare i passaggi dell'LLM per determinare se la risposta ha senso o meno.

chat

I contenuti di un dialogo con un sistema di ML, in genere un modello linguistico di grandi dimensioni. L'interazione precedente in una chat (ciò che hai digitato e la risposta del modello linguistico di grandi dimensioni) diventa il contesto per le parti successive della chat.

Un chatbot è un'applicazione di un modello linguistico di grandi dimensioni.

confabulazione

Sinonimo di allucinazione.

La confabulazione è probabilmente un termine tecnicamente più preciso dell'allucinazione. Tuttavia, l'allucinazione è diventata popolare per prima.

analisi delle circoscrizioni

Suddivisione di una frase in strutture grammaticali più piccole ("componenti"). Una parte successiva del sistema di ML, ad esempio un modello di comprensione del linguaggio naturale, può analizzare i componenti più facilmente della frase originale. Ad esempio, considera la seguente frase:

Un mio amico ha adottato due gatti.

Un parser di costituenti può suddividere questa frase nei seguenti due costituenti:

- Il mio amico è una frase nominale.

- ha adottato due gatti è una frase verbale.

Questi componenti possono essere ulteriormente suddivisi in componenti più piccoli. Ad esempio, la frase verbale

ha adottato due gatti

può essere ulteriormente suddiviso in:

- adopted è un verbo.

- due gatti è un'altra frase nominale.

Embedding del linguaggio contestualizzato

Un embedding che si avvicina alla "comprensione" di parole e frasi come farebbe un parlante umano fluente. Gli embedding linguistici contestualizzati possono comprendere sintassi, semantica e contesto complessi.

Ad esempio, considera gli embedding della parola inglese cow. Gli embeddings meno recenti, come word2vec, possono rappresentare le parole in inglese in modo che la distanza nello spazio di embedding da cow a bull sia simile alla distanza da ewe (pecora femmina) a ram (pecora maschio) o da female a male. Gli embedding linguistici contestualizzati possono fare un passo avanti riconoscendo che a volte gli anglofoni utilizzano la parola cow per indicare una mucca o un toro.

finestra di contesto

Il numero di token che un modello può elaborare in un determinato prompt. Maggiore è la finestra di contesto, più informazioni può utilizzare il modello per fornire risposte coerenti e coese al prompt.

arresto anomalo

Una frase o una locuzione con un significato ambiguo. I crash blossom rappresentano un problema significativo nella comprensione del linguaggio naturale. Ad esempio, il titolo La burocrazia blocca il grattacielo è un crash blossom perché un modello di NLU potrebbe interpretare il titolo in modo letterale o figurativo.

D

decodificatore

In generale, qualsiasi sistema di ML che converte da una rappresentazione interna elaborata, densa o a una rappresentazione più grezza, sparsa o esterna.

I decodificatori sono spesso un componente di un modello più grande, dove vengono spesso abbinati a un codificatore.

Nelle attività di sequenza a sequenza, un decodificatore inizia con lo stato interno generato dall'encoder per prevedere la sequenza successiva.

Consulta Transformer per la definizione di un decodificatore all'interno dell'architettura Transformer.

Per saperne di più, consulta Modelli linguistici di grandi dimensioni nel corso introduttivo al machine learning.

riduzione del rumore

Un approccio comune all'apprendimento autosupervisionato in cui:

La riduzione del rumore consente di apprendere da esempi non etichettati. Il set di dati originale funge da destinazione o etichetta e i dati con rumore come input.

Alcuni modelli linguistici con maschera utilizzano il denoising come segue:

- Il rumore viene aggiunto artificialmente a una frase non etichettata mascherando alcuni dei token.

- Il modello tenta di prevedere i token originali.

prompt diretto

Sinonimo di prompt zero-shot.

E

distanza di modifica

Una misura della somiglianza tra due stringhe di testo. Nel machine learning, la distanza di modifica è utile per i seguenti motivi:

- La distanza di modifica è facile da calcolare.

- La distanza di modifica può confrontare due stringhe note per essere simili tra loro.

- La distanza di modifica può determinare il grado di somiglianza tra stringhe diverse e una determinata stringa.

Esistono diverse definizioni della distanza di modifica, ciascuna delle quali utilizza operazioni su stringhe diverse. Per un esempio, consulta la distanza di Levenshtein.

livello di embedding

Un livello nascosto speciale che viene addestrato su una caratteristica categoriale di alta dimensione per imparare gradualmente un vettore di embedding di dimensione inferiore. Un livello di embedding consente a una rete neurale di essere addestrata in modo molto più efficiente rispetto all'addestramento solo sulla caratteristica categorica ad alta dimensione.

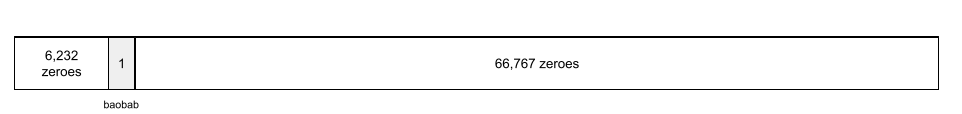

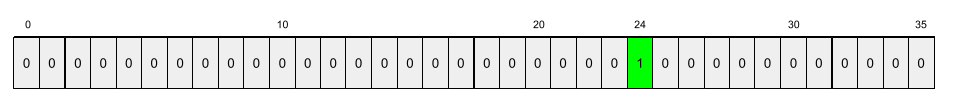

Ad esempio, la Terra ospita attualmente circa 73.000 specie di alberi. Supponiamo che la specie di albero sia una caratteristica del modello, quindi il livello di input del modello include un vettore one-hot lungo 73.000 elementi.

Ad esempio, baobab potrebbe essere rappresentato in questo modo:

Un array di 73.000 elementi è molto lungo. Se non aggiungi un livello di embedding al modello, l'addestramento richiederà molto tempo a causa della moltiplicazione di 72.999 zeri. Ad esempio, puoi scegliere che il livello di incorporamento sia costituito da 12 dimensioni. Di conseguenza, il livello di embedding apprenderà gradualmente un nuovo vettore di embedding per ogni specie di albero.

In alcuni casi, l'hashing è un'alternativa ragionevole a un livello di embedding.

Per ulteriori informazioni, consulta la sezione Embedding nel Machine Learning Crash Course.

spazio di incorporamento

Lo spazio vettoriale di dimensione d a cui vengono mappati gli elementi di uno spazio vettoriale di dimensione superiore. Lo spazio di embedding viene addestrato per acquisire una struttura significativa per l'applicazione prevista.

Il prodotto scalare di due embedding è una misura della loro somiglianza.

vettore di embedding

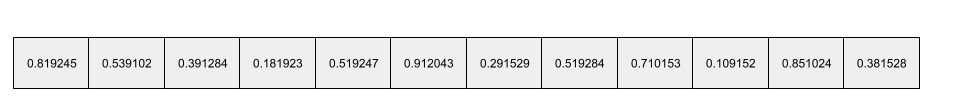

In generale, un array di numeri in virgola mobile presi da qualsiasi livello nascosto che descrivono gli input a quel livello nascosto. Spesso, un vettore di incorporamento è l'array di numeri in virgola mobile addestrato in un livello di incorporamento. Ad esempio, supponiamo che un livello di embedding debba apprendere un vettore di embedding per ciascuna delle 73.000 specie di alberi sulla Terra. Forse il seguente array è il vettore di incorporamento di un albero di baobab:

Un vettore di incorporamento non è un insieme di numeri casuali. Uno strato di incorporamento determina questi valori tramite l'addestramento, in modo simile al modo in cui una rete neurale apprende altri pesi durante l'addestramento. Ogni elemento dell'array è una valutazione in base a una caratteristica di una specie di albero. Quale elemento rappresenta la caratteristica di quale specie di albero? È molto difficile per gli esseri umani determinare se

La parte matematicamente notevole di un vettore di incorporamento è che gli elementi simili hanno insiemi simili di numeri in virgola mobile. Ad esempio, le specie di alberi simili hanno un insieme di numeri in virgola mobile più simile rispetto alle specie di alberi diverse. Le sequoie e le sequoie giganti sono specie di alberi correlate, quindi avranno un insieme di numeri con virgola mobile più simile rispetto alle sequoie e alle palme da cocco. I numeri nel vettore di embedding cambieranno ogni volta che addestrini nuovamente il modello, anche se lo fai con input identici.

codificatore

In generale, qualsiasi sistema di ML che esegue la conversione da una rappresentazione non elaborata, sparsa o esterna in una rappresentazione più elaborata, più densa o più interna.

Gli encoder sono spesso un componente di un modello più grande, dove vengono spesso abbinati a un decoder. Alcuni Transformer abbinano gli encoder ai decoder, mentre altri usano solo l'encoder o solo il decoder.

Alcuni sistemi utilizzano l'output dell'encoder come input di una rete di classificazione o regressione.

Nelle attività di sequenza a sequenza, un encoder prende una sequenza di input e restituisce uno stato interno (un vettore). Il decodificatore utilizza questo stato interno per prevedere la sequenza successiva.

Consulta Transformer per la definizione di un'encoder nell'architettura Transformer.

Per saperne di più, consulta LLM: che cos'è un modello linguistico di grandi dimensioni nel corso introduttivo al machine learning.

evals

Utilizzato principalmente come abbreviazione di valutazioni LLM. Più in generale, evals è un'abbreviazione per qualsiasi forma di valutazione.

valutazione

Il processo di misurazione della qualità di un modello o di confronto tra modelli diversi.

Per valutare un modello di machine learning supervisionato, in genere lo si confronta con un set di convalida e un set di test. La valutazione di un LLM tipicamente prevede valutazioni più ampie in termini di qualità e sicurezza.

F

prompting few-shot

Un prompt contenente più di un esempio (alcuni) che dimostri come deve rispondere il modello linguistico di grandi dimensioni. Ad esempio, il seguente prompt lungo contiene due esempi che mostrano a un modello linguistico di grandi dimensioni come rispondere a una query.

| Parti di un prompt | Note |

|---|---|

| Qual è la valuta ufficiale del paese specificato? | La domanda a cui vuoi che l'LLM risponda. |

| Francia: euro | Un esempio. |

| Regno Unito: GBP | Un altro esempio. |

| India: | La query effettiva. |

In genere, i prompt few-shot producono risultati più auspicabili rispetto ai prompt zero-shot e ai prompt one-shot. Tuttavia, la progettazione dei prompt few-shot richiede un prompt più lungo.

Il prompt few-shot è una forma di apprendimento few-shot applicata all'apprendimento basato su prompt.

Per saperne di più, consulta la sezione Progettazione dei prompt nel Machine Learning Crash Course.

Violino

Una libreria di configurazione incentrata su Python che imposta i valori di funzioni e classi senza codice o infrastruttura invasivi. Nel caso di Pax e di altri codebase di ML, queste funzioni e classi rappresentano modelli e iperparametri di addestramento.

Fiddle assume che le basi di codice di machine learning siano in genere suddivise in:

- Codice della libreria, che definisce i livelli e gli ottimizzatori.

- Il codice "collante" del set di dati, che chiama le librerie e collega tutto.

Fiddle acquisisce la struttura di chiamata del codice di collegamento in un formato non valutato e mutabile.

ottimizzazione

Un secondo passaggio di addestramento specifico per l'attività eseguito su un modello preaddestrato per perfezionarne i parametri per un caso d'uso specifico. Ad esempio, la sequenza di addestramento completa per alcuni modelli linguistici di grandi dimensioni è la seguente:

- Preaddestramento: addestrare un modello linguistico di grandi dimensioni su un vasto set di dati generale, come tutte le pagine di Wikipedia in lingua inglese.

- Ottimizzazione: addestrare il modello preaddestrato a eseguire un'attività specifica, come rispondere a query mediche. La messa a punto in genere prevede centinaia o migliaia di esempi incentrati sull'attività specifica.

Un altro esempio è la sequenza di addestramento completa per un modello di immagini di grandi dimensioni:

- Preaddestramento: addestrare un modello di immagini di grandi dimensioni su un vasto set di dati di immagini generali, come tutte le immagini di Wikimedia Commons.

- Ottimizzazione: addestrare il modello preaddestrato a eseguire un'attività specifica, come la generazione di immagini di orche.

La messa a punto può comportare qualsiasi combinazione delle seguenti strategie:

- Modifica di tutti i parametri esistenti del modello preaddestrato. Questa operazione è a volte chiamata ottimizzazione completa.

- Modifica di alcuni dei parametri esistenti del modello preaddestrato (in genere, i livelli più vicini al livello di output), mantenendo invariati gli altri parametri esistenti (in genere, i livelli più vicini al livello di input). Consulta l'ottimizzazione efficiente dei parametri.

- Aggiunta di altri livelli, in genere sopra i livelli esistenti più vicini al livello di output.

La messa a punto fine è una forma di apprendimento tramite trasferimento. Di conseguenza, la messa a punto fine potrebbe utilizzare una funzione di perdita o un tipo di modello diverso da quelli utilizzati per addestrare il modello preaddestrato. Ad esempio, potresti perfezionare un modello di immagini di grandi dimensioni preaddestrato per produrre un modello di regressione che restituisce il numero di uccelli in un'immagine di input.

Confronta e contrapponi la messa a punto fine con i seguenti termini:

Per ulteriori informazioni, consulta Ottimizzazione fine nel Machine Learning Crash Course.

Lino

Una libreria open source ad alte prestazioni per il deep learning basata su JAX. Flax fornisce funzioni per l'addestramento delle reti neurali, nonché metodi per valutarne le prestazioni.

Flaxformer

Una libreria di Transformer open source basata su Flax, progettata principalmente per l'elaborazione del linguaggio naturale e la ricerca multimodale.

G

Gemini

L'ecosistema che comprende l'IA più avanzata di Google. Gli elementi di questo ecosistema includeono:

- Vari modelli Gemini.

- L'interfaccia di conversazione interattiva di un modello Gemini. Gli utenti digitano i prompt e Gemini risponde.

- Varie API Gemini.

- Vari prodotti aziendali basati su modelli Gemini, ad esempio Gemini per Google Cloud.

Modelli Gemini

I modelli multimodali basati su Transformer all'avanguardia di Google. I modelli Gemini sono progettati appositamente per essere integrati con gli agenti.

Gli utenti possono interagire con i modelli Gemini in diversi modi, ad esempio tramite un'interfaccia di dialogo interattiva e tramite SDK.

testo generato

In generale, il testo prodotto da un modello di ML. Quando si valutano i modelli linguistici di grandi dimensioni, alcune metriche confrontano il testo generato con il testo di riferimento. Ad esempio, supponiamo che tu stia tentando di determinare l'efficacia di un modello ML per le traduzioni dal francese al fiammingo. In questo caso:

- Il testo generato è la traduzione in olandese generata dal modello di ML.

- Il testo di riferimento è la traduzione in olandese creata da un traduttore umano (o da un software).

Tieni presente che alcune strategie di valutazione non prevedono il testo di riferimento.

IA generativa

Un campo di trasformazione emergente senza definizione formale. Detto questo, la maggior parte degli esperti concorda sul fatto che i modelli di IA generativa possono creare ("generare") contenuti che soddisfano tutte le seguenti caratteristiche:

- complesso

- coerenti

- originale

Ad esempio, un modello di IA generativa può creare testi o immagini sofisticati.

Anche alcune tecnologie precedenti, tra cui le LSTM e le RNN, possono generare contenuti originali e coerenti. Alcuni esperti considerano queste tecnologie precedenti come IA generativa, mentre altri ritengono che la vera IA generativa richieda un output più complesso di quanto possano produrre queste tecnologie precedenti.

È diverso dal machine learning predittivo.

risposta ottimale

Una risposta nota per essere buona. Ad esempio, dato il seguente prompt:

2 + 2

La risposta ideale è:

4

GPT (Generative Pre-Trained Transformer)

Una famiglia di modelli linguistici di grandi dimensioni basati su Transformer sviluppati da OpenAI.

Le varianti GPT possono essere applicate a più modalità, tra cui:

- generazione di immagini (ad esempio ImageGPT)

- generazione di immagini da testo (ad esempio, DALL-E).

H

allucinazione

La produzione di output apparentemente plausibili, ma in realtà errati, da parte di un modello di IA generativa che pretende di fare un'affermazione sul mondo reale. Ad esempio, un modello di IA generativa che afferma che Barack Obama è morto nel 1865 è allucinante.

valutazione umana

Un processo in cui le persone valutano la qualità dell'output di un modello di ML, ad esempio persone bilingue che valutano la qualità di un modello di traduzione ML. La valutazione da parte di persone fisiche è particolarmente utile per giudicare i modelli che non hanno una sola risposta corretta.

È diverso dalla valutazione automatica e dalla valutazione dell'autoreattore.

I

Apprendimento contestuale

Sinonimo di prompt few-shot.

L

LaMDA (Language Model for Dialogue Applications)

Un modello linguistico di grandi dimensioni basato su Transformer sviluppato da Google e addestrato su un ampio set di dati di dialogo in grado di generare risposte di conversazione realistiche.

LaMDA: la nostra tecnologia di conversazione rivoluzionaria fornisce una panoramica.

modello linguistico

Un modello che stima la probabilità che un token o una sequenza di token si verifichi in una sequenza più lunga di token.

Per saperne di più, consulta Che cos'è un modello linguistico? nel corso introduttivo al machine learning.

modello linguistico di grandi dimensioni

Almeno un modello linguistico con un numero molto elevato di parametri. In termini più informali, qualsiasi modello linguistico basato su Transformer, come Gemini o GPT.

Per saperne di più, consulta la sezione Modelli linguistici di grandi dimensioni (LLM) nel corso introduttivo al machine learning.

spazio latente

Sinonimo di spazio di incorporamento.

Distanza di Levenshtein

Una metrica distanza di modifica che calcola il minor numero di operazioni di eliminazione, inserimento e sostituzione necessarie per sostituire una parola con un'altra. Ad esempio, la distanza di Levenshtein tra le parole "heart" e "darts" è pari a 3 perché le tre modifiche riportate di seguito sono le modifiche minime necessarie per trasformare una parola nell'altra:

- cuore → decuore (sostituisci "h" con "d")

- deart → dart (elimina "e")

- dardo → freccette (inserisci "s")

Tieni presente che la sequenza precedente non è l'unico percorso di tre modifiche.

LLM

Abbreviazione di modello linguistico di grandi dimensioni.

Valutazioni LLM (evals)

Un insieme di metriche e benchmark per valutare il rendimento dei modelli linguistici di grandi dimensioni (LLM). A livello generale, le valutazioni LLM:

- Aiuta i ricercatori a identificare le aree in cui gli LLM devono essere migliorati.

- Sono utili per confrontare diversi LLM e identificare il migliore per una determinata attività.

- Contribuisci a garantire che gli LLM siano sicuri ed etici.

Per saperne di più, consulta la sezione Modelli linguistici di grandi dimensioni (LLM) nel corso introduttivo al machine learning.

LoRA

Abbreviazione di Low-Rank Adaptability.

Adattabilità a basso ranking (LoRA)

Una tecnica di ottimizzazione efficiente dei parametri per la ottimizzazione fine che "blocca" i parametri preaddestrati del modello (in modo che non possano più essere modificati) e poi inserisce un piccolo insieme di parametri addestrabili nel modello. Questo insieme di pesi addestrabili (noti anche come "matrici di aggiornamento") è notevolmente più piccolo del modello di base e quindi è molto più veloce da addestrare.

LoRa offre i seguenti vantaggi:

- Migliora la qualità delle previsioni di un modello per il dominio in cui viene applicata la messa a punto fine.

- Esegue la messa a punto più velocemente rispetto alle tecniche che richiedono la messa a punto di tutti i parametri di un modello.

- Riduce il costo computazionale dell'inferenza consentendo la pubblicazione simultanea di più modelli specializzati che condividono lo stesso modello di base.

M

modello linguistico con maschera

Un modello linguistico che prevede la probabilità che i token candidati vengano inseriti negli spazi vuoti di una sequenza. Ad esempio, un modello linguistico mascherato può calcolare le probabilità per le parole candidate per sostituire il tratto sottolineato nella seguente frase:

Il ____ nel cappello è tornato.

La letteratura in genere utilizza la stringa "MASK" anziché un'evidenziazione. Ad esempio:

Il "MASCHERA" nel cappello è tornato.

La maggior parte dei modelli linguistici con mascheramento moderni è bidirezionale.

Precisione media a k (mAP@k)

La media statistica di tutti i punteggi di precisione media a k in un set di dati di convalida. Un utilizzo della precisione media a k è valutare la qualità dei consigli generati da un sistema di consigli.

Anche se la frase "media media" sembra ridondante, il nome della metrica è appropriato. Dopotutto, questa metrica trova la media di più valori di precisione media a k.

metaapprendimento

Un sottoinsieme del machine learning che scopre o migliora un algoritmo di apprendimento. Un sistema di metaapprendimento può anche avere lo scopo di addestrare un modello per apprendere rapidamente una nuova attività da una piccola quantità di dati o dall'esperienza acquisita in attività precedenti. In genere, gli algoritmi di metaapprendimento cercano di ottenere quanto segue:

- Migliorare o apprendere funzionalità create manualmente (ad esempio un inizializzante o un ottimizzatore).

- Essere più efficienti in termini di dati e calcolo.

- Migliorare la generalizzazione.

Il metaapprendimento è correlato all'apprendimento few-shot.

un mix di esperti

Uno schema per aumentare l'efficienza delle reti neurali utilizzando solo un sottoinsieme dei relativi parametri (noto come esperto) per elaborare un determinato token di input o esempio. Una rete di smistamento inoltra ogni token o esempio di input agli esperti appropriati.

Per maggiori dettagli, consulta uno dei seguenti documenti:

- Reti neurali estremamente grandi: il livello di combinazione di esperti con gating sparso

- Mixture-of-Experts con routing in base alla scelta dell'esperto

MMIT

Abbreviazione di adattato alle istruzioni multimodali.

modalità

Una categoria di dati di alto livello. Ad esempio, numeri, testo, immagini, video e audio sono cinque modalità diverse.

parallelismo del modello

Un modo per scalare l'addestramento o l'inferenza che inserisce parti diverse di un modello su dispositivi diversi. Il parallelismo dei modelli consente di utilizzare modelli troppo grandi per un singolo dispositivo.

Per implementare il parallelismo dei modelli, in genere un sistema esegue le seguenti operazioni:

- Suddivide il modello in parti più piccole.

- Distribuisce l'addestramento di queste parti più piccole su più processori. Ogni processore addestra la propria parte del modello.

- Combina i risultati per creare un singolo modello.

Il parallelismo dei modelli rallenta l'addestramento.

Vedi anche parallelismo dei dati.

MOE

Abbreviazione di mescola di esperti.

auto-attenzione multi-head

Un'estensione dell'attenzione autoreferenziale che applica il meccanismo di attenzione autoreferenziale più volte per ogni posizione nella sequenza di input.

I Transformer hanno introdotto l'autoattenzione multi-head.

multimodal instruction-tuned

Un modello ottimizzato per le istruzioni in grado di elaborare input oltre al testo, come immagini, video e audio.

modello multimodale

Un modello i cui input, output o entrambi includono più di una modalità. Ad esempio, prendi in considerazione un modello che prende sia un'immagine sia una didascalia di testo (due modalità) come caratteristiche e genera un punteggio che indica quanto è appropriata la didascalia di testo per l'immagine. Pertanto, gli input di questo modello sono multimodali e l'output è unimodale.

No

elaborazione del linguaggio naturale

Il campo che si occupa di insegnare ai computer a elaborare ciò che un utente ha detto o digitato utilizzando regole linguistiche. Quasi tutta l'elaborazione del linguaggio naturale moderna si basa sul machine learning.comprensione del linguaggio naturale

Un sottoinsieme dell'elaborazione del linguaggio naturale che determina le intenzioni di ciò che viene detto o digitato. La comprensione del linguaggio naturale può andare oltre l'elaborazione del linguaggio naturale per prendere in considerazione aspetti complessi del linguaggio come contesto, sarcasmo e sentiment.

N-gramma

Una sequenza ordinata di N parole. Ad esempio, truly madly è un bigramma. Poiché l'ordine è pertinente, madly truly è un bigramma diverso da truly madly.

| No | Nome o nomi per questo tipo di n-gramma | Esempi |

|---|---|---|

| 2 | bigramma o 2-gramma | to go, go to, eat lunch, eat dinner |

| 3 | trigramma o 3-gramma | ha mangiato troppo, e vissero felici e contenti, campane a stormo |

| 4 | 4 grammi | camminare nel parco, polvere nel vento, il ragazzo ha mangiato lenticchie |

Molti modelli di comprensione del linguaggio naturale si basano su N-gram per prevedere la parola successiva che l'utente digiterà o dirà. Ad esempio, supponiamo che un utente abbia digitato happily ever. Un modello di NLU basato su trigrammi probabilmente prevede che l'utente digiterà la parola dopo.

Confronta gli n-grammi con i bag of words, che sono insiemi non ordinati di parole.

Per saperne di più, consulta Modelli linguistici di grandi dimensioni nel corso introduttivo al machine learning.

NLP

Abbreviazione di elaborazione del linguaggio naturale.

NLU

Abbreviazione di comprensione del linguaggio naturale.

Nessuna risposta esatta (NORA)

Un prompt con più risposte appropriate. Ad esempio, il seguente prompt non ha una risposta giusta:

Raccontami una barzelletta sugli elefanti.

Valutare i prompt senza una risposta corretta può essere complicato.

NORA

Abbreviazione di nessuna risposta corretta.

O

prompting one-shot

Un prompt contenente un esempio che mostra come deve rispondere il modello linguistico di grandi dimensioni. Ad esempio, il seguente prompt contiene un esempio che mostra a un modello linguistico di grandi dimensioni come rispondere a una query.

| Parti di un prompt | Note |

|---|---|

| Qual è la valuta ufficiale del paese specificato? | La domanda a cui vuoi che l'LLM risponda. |

| Francia: euro | Un esempio. |

| India: | La query effettiva. |

Confronta e contrapponi i prompt una tantum con i seguenti termini:

P

Ottimizzazione efficiente dei parametri

Un insieme di tecniche per ottimizzare un grande modello linguistico preaddestrato (PLM) in modo più efficiente rispetto all'ottimizzazione completa. L'ottimizzazione in termini di parametri in genere ottimizza molti meno parametri rispetto all'ottimizzazione completa, ma in genere produce un modello linguistico di grandi dimensioni che ha un rendimento migliore (o quasi) rispetto a un modello linguistico di grandi dimensioni creato con l'ottimizzazione completa.

Confronta l'ottimizzazione efficiente dei parametri con:

L'ottimizzazione efficiente dei parametri è nota anche come ottimizzazione fine efficiente dei parametri.

pipeline

Una forma di parallelizzazione del modello in cui l'elaborazione di un modello è suddivisa in fasi consecutive e ogni fase viene eseguita su un dispositivo diverso. Mentre una fase elabora un batch, la fase precedente può lavorare sul batch successivo.

Consulta anche la sezione sull'addestramento graduale.

PLM

Abbreviazione di modello linguistico preaddestrato.

codifica posizionale

Una tecnica per aggiungere informazioni sulla posizione di un token in una sequenza all'embedding del token. I modelli di transformer utilizzano la codifica poszionale per comprendere meglio la relazione tra le diverse parti della sequenza.

Un'implementazione comune della codifica posizionale utilizza una funzione sinusoidale. Nello specifico, la frequenza e l'ampiezza della funzione sinusoidale sono determinate dalla posizione del token nella sequenza. Questa tecnica consente a un modello Transformer di imparare a prestare attenzione a parti diverse della sequenza in base alla loro posizione.

modello post-addestrato

Termine definito in modo approssimativo che in genere si riferisce a un modello preaddestrato sottoposto a qualche elaborazione post-trattamento, ad esempio una o più delle seguenti:

Precisione a k (precisione@k)

Una metrica per valutare un elenco di elementi classificati (ordinati). La precisione a k identifica la frazione dei primi k elementi nell'elenco che sono "pertinenti". Ossia:

\[\text{precision at k} = \frac{\text{relevant items in first k items of the list}} {\text{k}}\]

Il valore di k deve essere minore o uguale alla lunghezza dell'elenco restituito. Tieni presente che la lunghezza dell'elenco restituito non fa parte del calcolo.

La pertinenza è spesso soggettiva; anche gli esperti valutatori umani spesso non sono d'accordo su quali elementi sono pertinenti.

Confronta con:

modello preaddestrato

In genere, un modello già addestrato. Il termine potrebbe anche indicare un vettore di embedding addestrato in precedenza.

Il termine modello linguistico preaddestrato si riferisce in genere a un modello linguistico di grandi dimensioni già addestrato.

preaddestramento

L'addestramento iniziale di un modello su un set di dati di grandi dimensioni. Alcuni modelli pre-addestrati sono giganti goffi e in genere devono essere perfezionati tramite un addestramento aggiuntivo. Ad esempio, gli esperti di ML potrebbero preaddestrare un modello linguistico di grandi dimensioni su un vasto set di dati di testo, come tutte le pagine in inglese di Wikipedia. Dopo la pre-addestramento, il modello risultante può essere ulteriormente perfezionato tramite una delle seguenti tecniche:

- distillazione

- ottimizzazione

- Ottimizzazione delle istruzioni

- ottimizzazione efficiente dei parametri

- prompt-tuning

prompt

Qualsiasi testo inserito come input in un modello linguistico di grandi dimensioni per condizionare il modello a comportarsi in un determinato modo. I prompt possono essere brevi come una frase o lunghi a piacere (ad esempio l'intero testo di un romanzo). I prompt rientrano in più categorie, tra cui quelle riportate nella tabella seguente:

| Categoria di prompt | Esempio | Note |

|---|---|---|

| Domanda | A quale velocità può volare un piccione? | |

| Istruzione | Scrivi una poesia divertente sull'arbitraggio. | Un prompt che chiede al modello linguistico di grandi dimensioni di fare qualcosa. |

| Esempio | Tradurre il codice Markdown in HTML. Ad esempio:

Markdown: * elemento dell'elenco HTML: <ul> <li>elemento dell'elenco</li> </ul> |

La prima frase di questo prompt di esempio è un'istruzione. Il resto del prompt è l'esempio. |

| Ruolo | Spiega perché la discesa del gradiente viene utilizzata nell'addestramento del machine learning a un dottore in fisica. | La prima parte della frase è un'istruzione; la frase "a un dottorato in fisica" è la parte relativa al ruolo. |

| Input parziale da completare dal modello | Il Primo ministro del Regno Unito abita a | Un prompt di input parziale può terminare bruscamente (come in questo esempio) o con un trattino basso. |

Un modello di IA generativa può rispondere a un prompt con testo, codice, immagini, embedding, video e quasi tutto.

apprendimento basato su prompt

Una funzionalità di alcuni modelli che consente loro di adattare il loro comportamento in risposta a input di testo arbitrari (prompt). In un tipico paradigma di apprendimento basato su prompt, un modello linguistico di grandi dimensioni risponde a un prompt generando testo. Ad esempio, supponiamo che un utente inserisca il seguente prompt:

Riassumere la terza legge di moto di Newton.

Un modello in grado di apprendere in base ai prompt non è addestrato specificamente per rispondere al prompt precedente. Piuttosto, il modello "sa" molti fatti sulla fisica, molto sulle regole generali del linguaggio e molto su cosa costituiscono risposte generalmente utili. Queste informazioni sono sufficienti per fornire una risposta (si spera) utile. Ulteriori feedback umani ("Questa risposta era troppo complicata" o "Che cos'è una reazione?") consentono ad alcuni sistemi di apprendimento basati su prompt di migliorare gradualmente l'utilità delle loro risposte.

progettazione dei prompt

Sinonimo di prompt engineering.

ingegneria del prompt

L'arte di creare prompt che generano le risposte desiderate da un modello linguistico di grandi dimensioni. Gli esseri umani eseguono il prompt engineering. Scrivere prompt ben strutturati è un aspetto essenziale per garantire risposte utili da un modello linguistico di grandi dimensioni. L'ingegneria dei prompt dipende da molti fattori, tra cui:

- Il set di dati utilizzato per preaddestrare e possibilmente ottimizzare il modello linguistico di grandi dimensioni.

- La temperatura e altri parametri di decodifica utilizzati dal modello per generare le risposte.

Progettazione del prompt è un sinonimo di prompt engineering.

Per ulteriori dettagli su come scrivere prompt utili, consulta Introduzione alla progettazione dei prompt.

ottimizzazione dei prompt

Un meccanismo di ottimizzazione efficiente dei parametri che apprende un "prefisso" che il sistema antepone al prompt effettivo.

Una variante della regolazione del prompt, a volte chiamata regolazione del prefisso, consiste nell'anteporre il prefisso a ogni livello. Al contrario, la maggior parte della regolazione dei prompt aggiunge solo un prefisso al livello di input.

R

Richiamo a k (recall@k)

Una metrica per la valutazione dei sistemi che generano un elenco classificato (ordinato) di elementi. Il recupero a k identifica la frazione di elementi pertinenti nei primi k elementi in quell'elenco rispetto al numero totale di elementi pertinenti restituiti.

\[\text{recall at k} = \frac{\text{relevant items in first k items of the list}} {\text{total number of relevant items in the list}}\]

Contrasto con precisione a k.

testo di riferimento

La risposta di un esperto a un prompt. Ad esempio, se viene visualizzato il seguente prompt:

Traduci la domanda "Come ti chiami?" dall'inglese al francese.

La risposta di un esperto potrebbe essere:

Comment vous appelez-vous?

Varie metriche (ad esempio ROUGE) misurano il grado di corrispondenza tra il testo di riferimento e il testo generato di un modello di ML.

Prompt del ruolo

Componente facoltativo di un prompt che identifica un pubblico di destinazione per la risposta di un modello di IA generativa. Senza un prompt per il ruolo, un modello linguistico di grandi dimensioni fornisce una risposta che può essere o meno utile per la persona che pone le domande. Con un prompt sul ruolo, un modello linguistico di grandi dimensioni può rispondere in modo più appropriato e utile per un pubblico di destinazione specifico. Ad esempio, la parte della richiesta relativa al ruolo dei seguenti prompt è in grassetto:

- Riassumi questo documento per un dottorato in economia.

- Descrivere il funzionamento delle maree a un bambino di dieci anni.

- Spiega la crisi finanziaria del 2008. Parla come faresti con un bambino piccolo o un golden retriever.

ROUGE (Recall-Oriented Understudy for Gisting Evaluation)

Una famiglia di metriche che valutano i modelli di sintesi automatica e di traduzione automatica. Le metriche ROUGE determinano il grado in cui un testo di riferimento si sovrappone a un testo generato di un modello di ML. Ogni membro della famiglia di misurazioni ROUGE si sovrappone in modo diverso. Punteggi ROUGE più elevati indicano una maggiore somiglianza tra il testo di riferimento e il testo generato rispetto ai punteggi ROUGE più bassi.

In genere, ogni membro della famiglia ROUGE genera le seguenti metriche:

- Precisione

- Richiamo

- F1

Per dettagli ed esempi, consulta:

ROUGE-L

Un membro della famiglia ROUGE incentrato sulla lunghezza della sottosequenza comune più lunga nel testo di riferimento e nel testo generato. Le seguenti formule calcolano il richiamo e la precisione per ROUGE-L:

Puoi quindi utilizzare F1 per aggregare il recupero ROUGE-L e la precisione ROUGE-L in un'unica metrica:

ROUGE-L ignora le eventuali interruzioni di riga nel testo di riferimento e nel testo generato, pertanto la sottosequenza comune più lunga potrebbe attraversare più frasi. Quando il testo di riferimento e il testo generato includono più frasi, in genere è preferibile una variante di ROUGE-L chiamata ROUGE-Lsum. ROUGE-Lsum determina la sottosequenza comune più lunga per ogni frase in un passaggio e poi calcola la media di queste sottosequenze comuni più lunghe.

ROUGE-N

Un insieme di metriche all'interno della famiglia ROUGE che confronta gli N-gram condivisi di una determinata dimensione nel testo di riferimento e nel testo generato. Ad esempio:

- ROUGE-1 misura il numero di token condivisi nel testo di riferimento e nel testo generato.

- ROUGE-2 misura il numero di bigrammi (2-gram) condivisi nel testo di riferimento e nel testo generato.

- ROUGE-3 misura il numero di trigrammi (3-grammi) condivisi nel testo di riferimento e nel testo generato.

Puoi utilizzare le seguenti formule per calcolare il recupero e la precisione di ROUGE-N per qualsiasi membro della famiglia ROUGE-N:

Puoi quindi utilizzare F1 per aggregare il recupero di ROUGE-N e la precisione di ROUGE-N in un'unica metrica:

ROUGE-S

Una forma tollerante di ROUGE-N che consente la corrispondenza di skip-gram. In altre parole, ROUGE-N conteggia solo n-grammi che corrispondono esattamente, mentre ROUGE-S conteggia anche gli n-grammi separati da una o più parole. Ad esempio, prendi in considerazione quanto indicato di seguito.

- reference text: Nuvole bianche

- Testo generato: Nuvole bianche gonfie

Durante il calcolo di ROUGE-N, il bigramma Nuvole bianche non corrisponde Nuvole bianche gonfie. Tuttavia, quando si calcola ROUGE-S, Nuvole bianche corrisponde a Nuvole bianche gonfie.

S

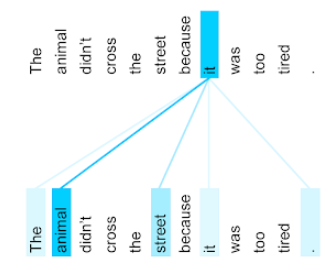

auto-attenzione (chiamato anche livello di auto-attenzione)

Un livello di rete neurale che trasforma una sequenza di embedding (ad esempio, embedding dei token) in un'altra sequenza di embedding. Ogni embedding nella sequenza di output viene costruito integrando le informazioni degli elementi della sequenza di input tramite un meccanismo di attenzione.

La parte self di self-attention si riferisce alla sequenza che si concentra su se stessa anziché su un altro contesto. L'auto-attenzione è uno dei principali componenti di base dei Transformer e utilizza la terminologia di ricerca nel dizionario, come "query", "chiave" e "valore".

Un livello di auto-attenzione inizia con una sequenza di rappresentazioni di input, una per ogni parola. La rappresentazione di input di una parola può essere un semplice embedding. Per ogni parola in una sequenza di input, la rete assegna un punteggio alla pertinenza della parola per ogni elemento dell'intera sequenza di parole. I punteggi di pertinenza determinano quanto la rappresentazione finale della parola incorpora le rappresentazioni di altre parole.

Ad esempio, considera la seguente frase:

L'animale non ha attraversato la strada perché era troppo stanco.

La seguente illustrazione (tratta da Transformer: A Novel Neural Network Architecture for Language Understanding) mostra il pattern di attenzione di un livello di auto-attenzione per il pronome it, con l'oscurità di ogni riga che indica quanto ciascuna parola contribuisce alla rappresentazione:

Il livello di auto-attenzione mette in evidenza le parole pertinenti a "esso". In questo caso, il livello di attenzione ha imparato a evidenziare le parole a cui esso potrebbe fare riferimento, assegnando il maggiore peso a animale.

Per una sequenza di n token, l'autoattenzione trasforma una sequenza di n embedding in n volte separate, una volta per ogni posizione della sequenza.

Consulta anche le sezioni attenzione e auto-attenzione multi-head.

analisi del sentiment

Utilizzo di algoritmi statistici o di machine learning per determinare l'atteggiamento complessivo (positivo o negativo) di un gruppo nei confronti di un servizio, un prodotto, un'organizzazione o un argomento. Ad esempio, utilizzando la comprensione del linguaggio naturale, un algoritmo potrebbe eseguire l'analisi del sentiment sul feedback testuale di un corso universitario per determinare il grado in cui il corso è piaciuto o meno agli studenti in generale.

Per ulteriori informazioni, consulta la guida alla classificazione del testo.

Attività di sequenza a sequenza

Un'attività che converte una sequenza di input di token in una sequenza di output di token. Ad esempio, due tipi comuni di compiti di sequenza a sequenza sono:

- Traduttori:

- Sequenza di input di esempio: "Ti amo".

- Sequenza di output di esempio: "Je t'aime."

- Risposta alle domande:

- Sequenza di input di esempio: "Mi serve la mia auto a New York?"

- Sequenza di output di esempio: "No. Tieni l'auto a casa."

skip-gram

Un n-gramma che può omettere (o "saltare") parole dal contesto originale, il che significa che le N parole potrebbero non essere state originariamente adiacenti. Più precisamente, un "n-gram con salti di k" è un n-gram per il quale possono essere state saltate fino a k parole.

Ad esempio, "la volpe marrone veloce" ha i seguenti possibili bigrammi:

- "the quick"

- "quick brown"

- "volpe marrone"

Un "2-gram con 1 salto" è una coppia di parole separate da massimo una parola. Pertanto, "la volpe marrone veloce" ha i seguenti bigrammi con 1 salto:

- "il marrone"

- "volpe veloce"

Inoltre, tutti i bigrammi sono anche bigrammi con un salto, poiché è possibile saltare meno di una parola.

Gli skip-gram sono utili per comprendere meglio il contesto circostante di una parola. Nell'esempio, "volpe" è stato associato direttamente a "rapido" nel set di 2-gram con 1 salto, ma non nel set di 2-gram.

Gli skip-gram aiutano ad addestrare i modelli di embedding delle parole.

Ottimizzazione dei prompt flessibili

Una tecnica per ottimizzare un modello linguistico di grandi dimensioni per una determinata attività, senza bisogno di una ottimizzazione fine che richiede molte risorse. Anziché riaddestrare tutti i pesi del modello, la regolazione del prompt graduale aggiusta automaticamente un prompt per raggiungere lo stesso obiettivo.

Dato un prompt di testo, la regolazione del prompt graduale tipicamente aggiunge al prompt ulteriori embedding di token e utilizza la propagazione inversa per ottimizzare l'input.

Un prompt "duro" contiene token effettivi anziché incorporamenti di token.

elemento sparso

Una caratteristica i cui valori sono prevalentemente pari a zero o vuoti. Ad esempio, una funzionalità contenente un singolo valore 1 e un milione di valori 0 è sparsa. Al contrario, una caratteristica densa ha valori che prevalentemente non sono pari a zero o vuoti.

Nel machine learning, un numero sorprendente di caratteristiche è sparso. Le caratteristiche categoriche sono in genere sparse. Ad esempio, tra le 300 possibili specie di alberi in una foresta, un singolo esempio potrebbe identificare solo un acero. In alternativa, tra i milioni di possibili video di una raccolta video, un singolo esempio potrebbe identificare solo "Casablanca".

In un modello, in genere le caratteristiche sparse vengono rappresentate con la codifica one-hot. Se la codifica one-hot è di grandi dimensioni, puoi inserire un livello di embedding sopra la codifica one-hot per una maggiore efficienza.

rappresentazione sparse

Memorizzazione solo delle posizioni degli elementi diversi da zero in una funzionalità sparsa.

Ad esempio, supponiamo che un attributo categorico denominato species identifichi le 36 specie di alberi in una determinata foresta. Supponiamo inoltre che ogni

esempio identifichi una sola specie.

Puoi utilizzare un vettore one-hot per rappresentare le specie di alberi in ogni esempio.

Un vettore one-hot conterrebbe un singolo 1 (per rappresentare la determinata specie di albero nell'esempio) e 35 1 (per rappresentare le 35 specie di alberi non presenti nell'esempio).0 Pertanto, la rappresentazione one-hot di maple potrebbe avere il seguente aspetto:

In alternativa, la rappresentazione sparsa identifica semplicemente la posizione della specie in questione. Se maple si trova in posizione 24, la rappresentazione sparsa di maple sarà semplicemente:

24

Tieni presente che la rappresentazione sparse è molto più compatta della rappresentazione one-hot.

Per ulteriori informazioni, consulta Utilizzare i dati categorici nel corso introduttivo al machine learning.

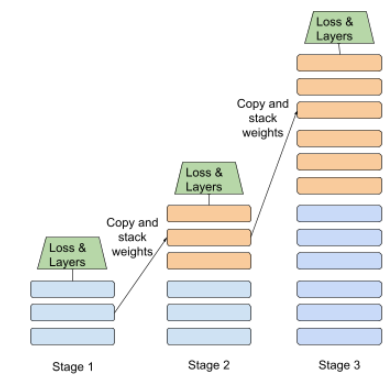

addestramento graduale

Una tattica per addestrare un modello in una sequenza di fasi distinte. L'obiettivo può essere accelerare il processo di addestramento o ottenere una qualità del modello migliore.

Di seguito è riportata un'illustrazione dell'approccio di impilamento progressivo:

- La fase 1 contiene 3 livelli nascosti, la fase 2 contiene 6 livelli nascosti e la fase 3 contiene 12 livelli nascosti.

- La fase 2 inizia l'addestramento con i pesi appresi nei 3 livelli nascosti della fase 1. La fase 3 inizia l'addestramento con i pesi appresi nei 6 livelli nascosti della fase 2.

Vedi anche pipelining.

token di sottoparola

Nei modelli linguistici, un token è una sottostringa di una parola, che può essere l'intera parola.

Ad esempio, una parola come "elencare" potrebbe essere suddivisa nei componenti "elemento" (una parola base) e "izzare" (un suffisso), ciascuno dei quali è rappresentato dal proprio token. La suddivisione delle parole non comuni in questi pezzi, chiamati sottoparole, consente ai modelli linguistici di operare sulle parti costitutive più comuni della parola, come prefissi e suffissi.

Al contrario, parole comuni come "andare" potrebbero non essere suddivise e rappresentare un singolo token.

T

T5

Un modello di apprendimento tramite trasferimento da testo a testo introdotto dall' AI di Google nel 2020. T5 è un modello encoder-decoder, basato sull'architettura Transformer, addestrato su un set di dati estremamente grande. È efficace in una serie di attività di elaborazione del linguaggio naturale, come la generazione di testo, la traduzione di lingue e la risposta a domande in modo colloquiale.

Il nome T5 deriva dalle cinque T di "Text-to-Text Transfer Transformer".

T5X

Un framework di machine learning open source progettato per creare e addestrare modelli di elaborazione del linguaggio naturale (NLP) su larga scala. T5 è implementato nel codice di base di T5X (che è basato su JAX e Flax).

temperatura

Un iperparametro che controlla il grado di casualità dell'output di un modello. Temperature più elevate generano un output più casuale, mentre temperature più basse generano un output meno casuale.

La scelta della temperatura migliore dipende dall'applicazione specifica e dalle proprietà preferite dell'output del modello. Ad esempio, probabilmente aumenteresti la temperatura quando crei un'applicazione che genera output creativo. Al contrario, probabilmente abbasserai la temperatura quando crei un modello che classifica immagini o testo per migliorare la accuratezza e la coerenza del modello.

La temperatura viene spesso utilizzata con softmax.

intervallo di testo

L'intervallo dell'indice dell'array associato a una sottosezione specifica di una stringa di testo.

Ad esempio, la parola good nella stringa Python s="Be good now" occupa

l'intervallo di testo da 3 a 6.

token

In un modello linguistico, l'unità atomica su cui il modello viene addestrato e su cui vengono effettuate le previsioni. Un token è in genere uno dei seguenti:

- una parola: ad esempio, la frase "cani come gatti" è composta da tre token di parola: "cani", "come" e "gatti".

- un carattere, ad esempio la frase "bicicletta pesce" è composta da nove token di carattere. Tieni presente che lo spazio vuoto viene conteggiato come uno dei token.

- sottoparole, in cui una singola parola può essere un singolo token o più token. Una parola composta è costituita da una parola base, un prefisso o un suffisso. Ad esempio, un modello linguistico che utilizza le sottoparole come token potrebbe considerare la parola "cani" come due token (la parola principale "cane" e il suffisso plurale "i"). Lo stesso modello linguistico potrebbe considerare la singola parola "più alto" come due sottoparole (la parola principale "alto" e il suffisso "er").

In domini diversi dai modelli linguistici, i token possono rappresentare altri tipi di unità atomiche. Ad esempio, nella visione artificiale, un token potrebbe essere un sottoinsieme di un'immagine.

Per saperne di più, consulta Modelli linguistici di grandi dimensioni nel corso introduttivo al machine learning.

accuratezza top-k

La percentuale di volte in cui un'etichetta target viene visualizzata nelle prime k poz. degli elenchi generati. Gli elenchi possono essere consigli personalizzati o un elenco di articoli ordinati in base alla funzione softmax.

La precisione Top-k è nota anche come precisione a k.

tossicità

Il grado in cui i contenuti sono offensivi, minacciosi o illeciti. Molti modelli di machine learning possono identificare e misurare la tossicità. La maggior parte di questi modelli identifica la tossicità in base a più parametri, ad esempio il livello di linguaggio illecito e il livello di linguaggio minaccioso.

Transformer

Un'architettura di reti neurali sviluppata da Google che si basa su meccanismi di auto-attenzione per trasformare una sequenza di embedding di input in una sequenza di embedding di output senza fare affidamento su convoluzioni o su reti neurali ricorrenti. Un Transformer può essere visualizzato come uno stack di livelli di auto-attenzione.

Un trasformatore può includere uno dei seguenti elementi:

- un codificatore

- un decoder

- sia un encoder che un decoder

Un encoder trasforma una sequenza di embedding in una nuova sequenza della stessa lunghezza. Un codificatore include N livelli identici, ognuno dei quali contiene due livelli secondari. Questi due sottolivelli vengono applicati a ogni posizione della sequenza di embedding di input, trasformando ogni elemento della sequenza in un nuovo embedding. Il primo sottolivello dell'encoder aggrega le informazioni di tutta la sequenza di input. Il secondo sottolivello del codificatore trasforma le informazioni aggregate in un embedding di output.

Un decodificatore trasforma una sequenza di rappresentazioni distribuite di input in una sequenza di rappresentazioni distribuite di output, eventualmente con una lunghezza diversa. Un decodificatore include anche N livelli identici con tre sottolivelli, due dei quali sono simili ai sottolivelli dell'encoder. Il terzo sottolivello del decodificatore prende l'output dell'elaboratore e applica il meccanismo di auto-attenzione per raccogliere informazioni.

Il post del blog Transformer: A Novel Neural Network Architecture for Language Understanding offre una buona introduzione ai Transformer.

Per saperne di più, consulta LLM: che cos'è un modello linguistico di grandi dimensioni? nel corso introduttivo al machine learning.

trigramma

Un n-gramma in cui N=3.

U

unidirezionale

Un sistema che valuta solo il testo che precede una sezione di testo target. Al contrario, un sistema bidirezionale valuta sia il testo che precede sia quello che segue una sezione di testo target. Per ulteriori dettagli, consulta bidirezionale.

modello linguistico unidirezionale

Un modello linguistico che basa le sue probabilità solo sui token che compaiono prima, non dopo, dei token target. È diverso dal modello linguistico bidirezionale.

V

autoencoder variazionale (VAE)

Un tipo di autoencoder che sfrutta la discrepanza tra input e output per generare versioni modificate degli input. Gli autoencoder variazionali sono utili per l'IA generativa.

I VAE si basano sull'inferenza bayesiana, una tecnica per stimare i parametri di un modello di probabilità.

M

word embedding

Rappresentazione di ogni parola in un insieme di parole all'interno di un vettore di incorporamento, ovvero rappresentazione di ogni parola come un vettore di valori a virgola mobile compresi tra 0,0 e 1,0. Le parole con significati simili hanno rappresentazioni più simili rispetto alle parole con significati diversi. Ad esempio, carote, sedano e cetrioli avranno rappresentazioni relativamente simili, molto diverse da quelle di aereo, occhiali da sole e dentifricio.

Z

prompting zero-shot

Un prompt che non fornisce un esempio di come vuoi che il modello linguistico di grandi dimensioni risponda. Ad esempio:

| Parti di un prompt | Note |

|---|---|

| Qual è la valuta ufficiale del paese specificato? | La domanda a cui vuoi che l'LLM risponda. |

| India: | La query effettiva. |

Il modello linguistico di grandi dimensioni potrebbe rispondere con uno dei seguenti elementi:

- Rupia

- INR

- ₹

- Rupia indiana

- La rupia

- La rupia indiana

Tutte le risposte sono corrette, anche se potresti preferire un determinato formato.

Confronta e contrapponi i prompt senza esempi con i seguenti termini: