این صفحه شامل اصطلاحات واژه نامه ارزیابی زبان است. برای همه اصطلاحات واژه نامه، اینجا را کلیک کنید .

الف

توجه

مکانیزمی که در شبکه عصبی استفاده می شود و اهمیت یک کلمه یا بخشی از یک کلمه را نشان می دهد. توجه، مقدار اطلاعاتی را که یک مدل برای پیشبینی رمز/کلمه بعدی نیاز دارد، فشرده میکند. یک مکانیسم توجه معمولی ممکن است شامل یک جمع وزنی بر روی مجموعهای از ورودیها باشد، جایی که وزن هر ورودی توسط بخش دیگری از شبکه عصبی محاسبه میشود.

رجوع به خود توجهی و خودتوجهی چند سر نیز شود که اجزای سازنده ترانسفورماتورها هستند.

به LLMs مراجعه کنید: مدل زبان بزرگ چیست؟ برای اطلاعات بیشتر در مورد توجه به خود، در دوره تصادف یادگیری ماشینی.

رمزگذار خودکار

سیستمی که یاد می گیرد مهم ترین اطلاعات را از ورودی استخراج کند. رمزگذارهای خودکار ترکیبی از رمزگذار و رمزگشا هستند. رمزگذارهای خودکار بر فرآیند دو مرحله ای زیر متکی هستند:

- رمزگذار ورودی را به یک قالب (معمولا) با ابعاد پایین تر (متوسط) ترسیم می کند.

- رمزگشا با نگاشت قالب با ابعاد پایین تر به فرمت ورودی با ابعاد بالاتر، یک نسخه با اتلاف از ورودی اصلی ایجاد می کند.

رمزگذارهای خودکار با تلاش رمزگشا برای بازسازی ورودی اصلی از فرمت میانی رمزگذار تا حد امکان به صورت سرتاسر آموزش داده می شوند. از آنجایی که فرمت میانی کوچکتر (بُعد پایین) از فرمت اصلی است، رمزگذار خودکار مجبور است اطلاعاتی را که در ورودی ضروری است، بیاموزد و خروجی کاملاً با ورودی یکسان نخواهد بود.

به عنوان مثال:

- اگر داده های ورودی گرافیکی باشد، کپی غیر دقیق شبیه به گرافیک اصلی است، اما تا حدودی تغییر یافته است. شاید کپی غیر دقیق، نویز را از گرافیک اصلی حذف می کند یا برخی از پیکسل های از دست رفته را پر می کند.

- اگر داده ورودی متن باشد، یک رمزگذار خودکار متن جدیدی تولید می کند که متن اصلی را تقلید می کند (اما مشابه نیست).

رمزگذارهای خودکار متغیر را نیز ببینید.

ارزیابی خودکار

استفاده از نرم افزار برای قضاوت در مورد کیفیت خروجی یک مدل.

وقتی خروجی مدل نسبتاً ساده باشد، یک اسکریپت یا برنامه میتواند خروجی مدل را با یک پاسخ طلایی مقایسه کند. این نوع ارزیابی خودکار گاهی اوقات ارزیابی برنامه ای نامیده می شود. معیارهایی مانند ROUGE یا BLEU اغلب برای ارزیابی برنامه ای مفید هستند.

هنگامی که خروجی مدل پیچیده است یا پاسخ درستی ندارد، یک برنامه ML جداگانه به نام autorater گاهی اوقات ارزیابی خودکار را انجام می دهد.

در مقابل ارزیابی انسانی .

ارزیابی نویسنده

مکانیزم ترکیبی برای قضاوت در مورد کیفیت خروجی یک مدل هوش مصنوعی مولد که ارزیابی انسانی را با ارزیابی خودکار ترکیب میکند. autorater یک مدل ML است که بر روی داده های ایجاد شده توسط ارزیابی انسانی آموزش دیده است. در حالت ایده آل، یک autorater یاد می گیرد که از یک ارزیاب انسانی تقلید کند.Autoraters از پیش ساخته شده در دسترس هستند، اما بهترین autorater ها به طور خاص برای وظیفه ای که شما ارزیابی می کنید تنظیم شده اند.

مدل خود رگرسیون

مدلی که پیش بینی را بر اساس پیش بینی های قبلی خود استنباط می کند. برای مثال، مدلهای زبان رگرسیون خودکار، نشانههای بعدی را بر اساس نشانههای پیشبینیشده قبلی پیشبینی میکنند. همه مدلهای زبان بزرگ مبتنی بر Transformer دارای رگرسیون خودکار هستند.

در مقابل، مدلهای تصویر مبتنی بر GAN معمولاً رگرسیون خودکار نیستند، زیرا آنها یک تصویر را در یک گذر به جلو و نه به صورت تکراری در مراحل تولید میکنند. با این حال، برخی از مدلهای تولید تصویر دارای رگرسیون خودکار هستند ، زیرا آنها یک تصویر را در مراحل تولید میکنند.

دقت متوسط در k

معیاری برای خلاصه کردن عملکرد یک مدل در یک اعلان واحد که نتایج رتبهبندیشدهای را ایجاد میکند، مانند فهرست شمارهدار توصیههای کتاب. میانگین دقت در k ، خوب، میانگین دقت در مقادیر k برای هر نتیجه مرتبط است. بنابراین فرمول دقت متوسط در k به صورت زیر است:

\[{\text{average precision at k}} = \frac{1}{n} \sum_{i=1}^n {\text{precision at k for each relevant item} } \]

کجا:

- \(n\) تعداد موارد مرتبط در لیست است.

کنتراست با فراخوان در k .

ب

کیسه کلمات

نمایشی از کلمات در یک عبارت یا متن، صرف نظر از ترتیب. به عنوان مثال، کیسه کلمات سه عبارت زیر را به طور یکسان نشان می دهد:

- سگ می پرد

- سگ را می پرد

- سگ می پرد

هر کلمه به یک شاخص در یک بردار پراکنده نگاشت می شود، که در آن بردار برای هر کلمه در واژگان یک شاخص دارد. به عنوان مثال، عبارت dog jumps در یک بردار ویژگی با مقادیر غیر صفر در سه شاخص مربوط به کلمات the , dog و jumps نگاشت می شود. مقدار غیر صفر می تواند یکی از موارد زیر باشد:

- A 1 برای نشان دادن وجود یک کلمه.

- تعداد دفعاتی که یک کلمه در کیسه ظاهر می شود. به عنوان مثال، اگر عبارت were the maroon dog یک سگ با خز قهوه ای است ، هر دو قهوه ای و سگ به صورت 2 نشان داده می شوند، در حالی که کلمات دیگر به عنوان 1 نمایش داده می شوند.

- مقدار دیگری مانند لگاریتم تعداد دفعاتی که یک کلمه در کیسه ظاهر می شود.

BERT (نمایش رمزگذار دوطرفه از ترانسفورماتورها)

معماری مدلی برای نمایش متن یک مدل BERT آموزش دیده می تواند به عنوان بخشی از یک مدل بزرگتر برای طبقه بندی متن یا سایر وظایف ML عمل کند.

BERT دارای ویژگی های زیر است:

- از معماری ترانسفورماتور استفاده می کند و بنابراین به خود توجهی متکی است.

- از بخش رمزگذار ترانسفورماتور استفاده می کند. وظیفه رمزگذار به جای انجام یک کار خاص مانند طبقه بندی، تولید بازنمایی متن خوب است.

- دو جهته است.

- از ماسک برای تمرینات بدون نظارت استفاده می کند.

انواع BERT عبارتند از:

برای مروری بر BERT به منبع باز BERT: پیشآموزش پیشرفته برای پردازش زبان طبیعی مراجعه کنید.

دو طرفه

اصطلاحی که برای توصیف سیستمی استفاده میشود که متنی را که هم قبل و هم بعد از یک بخش هدف از متن است، ارزیابی میکند. در مقابل، یک سیستم یک طرفه فقط متنی را که قبل از بخش هدفی از متن قرار دارد ارزیابی می کند.

به عنوان مثال، یک مدل زبان پوشانده شده را در نظر بگیرید که باید احتمالات کلمه یا کلماتی را که نشان دهنده خط زیر در سؤال زیر هستند تعیین کند:

_____ با شما چیست؟

یک مدل زبانی یک طرفه باید احتمالات خود را فقط بر اساس زمینه ارائه شده توسط کلمات "What"، "is" و "the" استوار کند. در مقابل، یک مدل زبان دوطرفه همچنین میتواند زمینه را از «با» و «شما» به دست آورد، که ممکن است به مدل کمک کند پیشبینیهای بهتری ایجاد کند.

مدل زبان دو طرفه

یک مدل زبان که احتمال وجود یک نشانه داده شده در یک مکان معین در گزیده ای از متن را بر اساس متن قبلی و بعدی تعیین می کند.

بیگرام

یک گرم N که در آن N=2 است.

BLEU (دو زبانه ارزیابی ارزشیابی)

معیاری بین 0.0 و 1.0 برای ارزیابی ترجمه های ماشینی ، به عنوان مثال، از اسپانیایی به ژاپنی.

برای محاسبه امتیاز، BLEU معمولاً ترجمه مدل ML ( متن تولید شده ) را با ترجمه متخصص انسانی ( متن مرجع ) مقایسه میکند. میزان تطابق N-گرم در متن تولید شده و متن مرجع، امتیاز BLEU را تعیین می کند.

مقاله اصلی در مورد این معیار BLEU: روشی برای ارزیابی خودکار ترجمه ماشینی است.

BLEURT را نیز ببینید.

BLEURT (دو زبانه ارزیابی از Transformers)

معیاری برای ارزیابی ترجمه های ماشینی از یک زبان به زبان دیگر، به ویژه به و از انگلیسی.

برای ترجمه به انگلیسی و از انگلیسی، BLEURT بیشتر از BLEU با رتبهبندیهای انسانی همسو میشود. برخلاف BLEU، BLEURT بر شباهتهای معنایی (معنی) تأکید میکند و میتواند تفسیر را در خود جای دهد.

BLEURT بر یک مدل زبان بزرگ از پیش آموزشدیده (دقیقا BERT ) تکیه میکند که سپس بر روی متن مترجمان انسانی تنظیم میشود .

مقاله اصلی در مورد این معیار BLEURT: یادگیری معیارهای قوی برای تولید متن است.

سی

مدل زبان علی

مترادف مدل زبان تک جهتی .

برای تضاد رویکردهای مختلف جهتگیری در مدلسازی زبان، مدل زبان دوطرفه را ببینید.

تحریک زنجیره ای از فکر

یک تکنیک مهندسی سریع که یک مدل زبان بزرگ (LLM) را تشویق می کند تا استدلال خود را گام به گام توضیح دهد. به عنوان مثال، با توجه خاص به جمله دوم، دستور زیر را در نظر بگیرید:

یک راننده چند گرم نیرو را در اتومبیلی که از 0 تا 60 مایل در ساعت در 7 ثانیه طی می کند تجربه می کند؟ در پاسخ، تمام محاسبات مربوطه را نشان دهید.

پاسخ LLM به احتمال زیاد:

- دنباله ای از فرمول های فیزیک را نشان دهید و مقادیر 0، 60 و 7 را در مکان های مناسب وصل کنید.

- توضیح دهید که چرا آن فرمول ها را انتخاب کرده است و معنی متغیرهای مختلف چیست.

تحریک زنجیرهای از فکر، LLM را مجبور میکند همه محاسبات را انجام دهد، که ممکن است به پاسخ صحیحتری منجر شود. علاوه بر این، تحریک زنجیرهای از فکر، کاربر را قادر میسازد تا مراحل LLM را برای تعیین اینکه آیا پاسخ منطقی است یا نه، بررسی کند.

چت کردن

محتویات یک گفتگوی رفت و برگشت با یک سیستم ML، معمولاً یک مدل زبان بزرگ . تعامل قبلی در یک چت (آنچه تایپ کردید و مدل زبان بزرگ چگونه پاسخ داد) زمینه ای برای بخش های بعدی گپ می شود.

چت بات یک برنامه کاربردی از یک مدل زبان بزرگ است.

confabulation

مترادف توهم .

Confabulation احتمالاً از نظر فنی دقیق تر از توهم است. با این حال، توهم ابتدا رایج شد.

تجزیه حوزه انتخابیه

تقسیم یک جمله به ساختارهای گرامری کوچکتر ("مواد تشکیل دهنده"). بخش بعدی سیستم ML، مانند یک مدل درک زبان طبیعی ، می تواند اجزای تشکیل دهنده را راحت تر از جمله اصلی تجزیه کند. برای مثال جمله زیر را در نظر بگیرید:

دوستم دو گربه را به فرزندی پذیرفت.

تجزیه کننده حوزه انتخابیه می تواند این جمله را به دو جزء زیر تقسیم کند:

- دوست من یک عبارت اسمی است.

- adopted two cats یک عبارت فعل است.

این اجزاء را می توان بیشتر به اجزای کوچکتر تقسیم کرد. مثلاً عبارت فعل

دو گربه را به فرزندی پذیرفت

را می توان بیشتر به زیر تقسیم کرد:

- اتخاذ یک فعل است.

- دو گربه یک عبارت اسمی دیگر است.

جاسازی زبان متنی

تعبیهای که به «درک» کلمات و عبارات به شیوهای نزدیک میشود که سخنرانان انسانی مسلط میتوانند. تعبیههای زبان متنی میتوانند نحو، معناشناسی و زمینه پیچیده را درک کنند.

برای مثال، تعبیههای کلمه انگلیسی cow را در نظر بگیرید. جاسازیهای قدیمیتر مانند word2vec میتوانند کلمات انگلیسی را نشان دهند به طوری که فاصله در فضای جاسازی از گاو تا گاو مشابه فاصله میش (گوسفند ماده) تا قوچ (گوسفند نر) یا از ماده تا نر است. تعبیههای زبانی متنی میتواند با درک این موضوع که انگلیسی زبانان گاهی اوقات به طور تصادفی از کلمه cow به معنای گاو یا گاو نر استفاده میکنند، قدمی فراتر بگذارند.

پنجره زمینه

تعداد نشانه هایی که یک مدل می تواند در یک دستور داده شده پردازش کند. هرچه پنجره زمینه بزرگتر باشد، مدل می تواند از اطلاعات بیشتری برای ارائه پاسخ های منسجم و منسجم به درخواست استفاده کند.

شکوفه تصادف

جمله یا عبارتی با معنای مبهم. شکوفه های تصادفی مشکل مهمی در درک زبان طبیعی ایجاد می کنند. به عنوان مثال، عنوان Red Tape Holds Up Skyscraper یک شکوفه سقوط است زیرا یک مدل NLU می تواند عنوان را به معنای واقعی کلمه یا مجازی تفسیر کند.

D

رمزگشا

به طور کلی، هر سیستم ML که از یک نمایش پردازش شده، متراکم یا داخلی به یک نمایش خام تر، پراکنده تر یا خارجی تبدیل می شود.

رمزگشاها اغلب جزء یک مدل بزرگتر هستند، جایی که اغلب با یک رمزگذار جفت می شوند.

در کارهای ترتیب به دنباله ، رمزگشا با حالت داخلی تولید شده توسط رمزگذار شروع میشود تا دنباله بعدی را پیشبینی کند.

برای تعریف رمزگشا در معماری ترانسفورماتور به Transformer مراجعه کنید.

برای اطلاعات بیشتر ، مدلهای زبان بزرگ را در دوره آموزشی تصادفی یادگیری ماشین ببینید.

حذف نویز

یک رویکرد رایج برای یادگیری خود نظارتی که در آن:

حذف نویز امکان یادگیری از نمونه های بدون برچسب را فراهم می کند. مجموعه داده اصلی به عنوان هدف یا برچسب و داده های پر سر و صدا به عنوان ورودی عمل می کند.

برخی از مدلهای زبان پوشانده از حذف نویز به صورت زیر استفاده میکنند:

- نویز به طور مصنوعی با پوشاندن برخی از نشانه ها به یک جمله بدون برچسب اضافه می شود.

- مدل سعی می کند توکن های اصلی را پیش بینی کند.

تحریک مستقیم

مترادف عبارت zero-shot prompting .

E

فاصله را ویرایش کنید

اندازه گیری شباهت دو رشته متنی به یکدیگر. در یادگیری ماشینی، ویرایش فاصله به دلایل زیر مفید است:

- محاسبه فاصله ویرایش آسان است.

- ویرایش فاصله میتواند دو رشته را که شبیه یکدیگر هستند مقایسه کند.

- فاصله ویرایش می تواند میزان شباهت رشته های مختلف به یک رشته معین را تعیین کند.

تعاریف متعددی از فاصله ویرایش وجود دارد که هر کدام از عملیات رشته های متفاوتی استفاده می کنند. برای مثال فاصله Levenshtein را ببینید.

لایه جاسازی

یک لایه مخفی ویژه که بر روی یک ویژگی طبقه بندی با ابعاد بالا آموزش می دهد تا به تدریج بردار تعبیه ابعاد پایین تر را یاد بگیرد. یک لایه جاسازی شبکه عصبی را قادر میسازد تا بسیار کارآمدتر از آموزش فقط بر روی ویژگی طبقهبندی با ابعاد بالا آموزش ببیند.

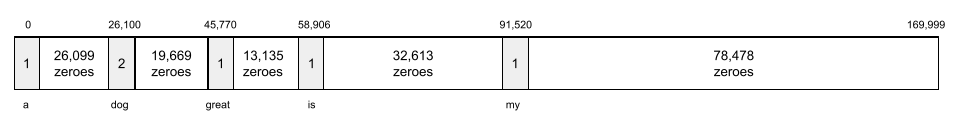

برای مثال، زمین در حال حاضر از حدود 73000 گونه درختی پشتیبانی می کند. فرض کنید گونه درختی یک ویژگی در مدل شما باشد، بنابراین لایه ورودی مدل شما شامل یک بردار یک داغ به طول 73000 عنصر است. برای مثال، شاید baobab چیزی شبیه به این نشان داده شود:

یک آرایه 73000 عنصری بسیار طولانی است. اگر یک لایه جاسازی به مدل اضافه نکنید، به دلیل ضرب 72999 صفر، آموزش بسیار وقت گیر خواهد بود. شاید لایه جاسازی را از 12 بعد انتخاب کنید. در نتیجه، لایه جاسازی به تدریج یک بردار تعبیه جدید برای هر گونه درختی را یاد می گیرد.

در شرایط خاص، هش جایگزین معقولی برای لایه جاسازی است.

برای اطلاعات بیشتر، به دوره آموزشی تصادفی آموزش ماشینی (Embeddings in Machine Learning) مراجعه کنید.

فضای تعبیه شده

فضای برداری d بعدی که از یک فضای برداری با ابعاد بالاتر مشخص می شود به آن نگاشت می شود. فضای جاسازی برای گرفتن ساختاری که برای کاربرد مورد نظر معنادار است آموزش داده شده است.

حاصل ضرب نقطه ای دو جاسازی معیاری برای تشابه آنهاست.

وکتور تعبیه شده

به طور کلی، آرایه ای از اعداد ممیز شناور گرفته شده از هر لایه پنهان که ورودی های آن لایه پنهان را توصیف می کند. اغلب، یک بردار جاسازی آرایه ای از اعداد ممیز شناور است که در یک لایه جاسازی آموزش داده شده است. برای مثال، فرض کنید یک لایه جاسازی باید یک بردار جاسازی برای هر یک از ۷۳۰۰۰ گونه درختی روی زمین بیاموزد. شاید آرایه زیر بردار جاسازی یک درخت بائوباب باشد:

بردار تعبیه شده مجموعه ای از اعداد تصادفی نیست. یک لایه جاسازی این مقادیر را از طریق آموزش تعیین می کند، مشابه روشی که یک شبکه عصبی وزن های دیگر را در طول تمرین یاد می گیرد. هر عنصر از آرایه رتبه بندی در امتداد برخی از ویژگی های یک گونه درختی است. کدام عنصر مشخصه کدام گونه درخت است؟ تشخیص آن برای انسان ها بسیار سخت است.

بخش قابل توجه ریاضی یک بردار تعبیه شده این است که موارد مشابه دارای مجموعه های مشابهی از اعداد ممیز شناور هستند. به عنوان مثال، گونه های درختی مشابه دارای مجموعه اعداد ممیز شناور مشابهی نسبت به گونه های درختی غیر مشابه هستند. سرخوودها و سکویاها گونههای درختی مرتبط هستند، بنابراین مجموعهای از اعداد شناور شبیهتری نسبت به درختهای قرمز و نخل نارگیل خواهند داشت. اعداد در بردار جاسازی با هر بار آموزش مجدد مدل تغییر خواهند کرد، حتی اگر مدل را با ورودی یکسان دوباره آموزش دهید.

رمزگذار

به طور کلی، هر سیستم ML که از یک نمایش خام، پراکنده یا خارجی به یک نمایش پردازش شده تر، متراکم تر یا داخلی تر تبدیل می شود.

رمزگذارها اغلب جزء یک مدل بزرگتر هستند، جایی که اغلب با یک رمزگشا جفت می شوند. برخی از ترانسفورماتورها انکودرها را با رمزگشاها جفت می کنند، اگرچه سایر ترانسفورماتورها فقط از رمزگذار یا فقط رمزگشا استفاده می کنند.

برخی از سیستم ها از خروجی رمزگذار به عنوان ورودی یک شبکه طبقه بندی یا رگرسیون استفاده می کنند.

در کارهای ترتیب به دنباله ، یک رمزگذار یک دنباله ورودی را می گیرد و یک حالت داخلی (بردار) را برمی گرداند. سپس رمزگشا از آن حالت داخلی برای پیش بینی دنباله بعدی استفاده می کند.

برای تعریف رمزگذار در معماری ترانسفورماتور به Transformer مراجعه کنید.

برای اطلاعات بیشتر به LLMs: What's a large language model in Machine Learning Crash Course مراجعه کنید.

ارزیابی می کند

در درجه اول به عنوان مخفف ارزیابی های LLM استفاده می شود. به طور گسترده تر، evals مخفف هر شکلی از ارزیابی است.

ارزیابی

فرآیند اندازه گیری کیفیت یک مدل یا مقایسه مدل های مختلف با یکدیگر.

برای ارزیابی یک مدل یادگیری ماشینی نظارت شده ، معمولاً آن را بر اساس یک مجموعه اعتبار سنجی و یک مجموعه آزمایش قضاوت می کنید. ارزیابی LLM معمولاً شامل ارزیابیهای کیفی و ایمنی گستردهتری است.

اف

چند شات تحریک

درخواستی که حاوی بیش از یک («چند») مثال است که نشان میدهد مدل زبان بزرگ چگونه باید پاسخ دهد. برای مثال، دستور طولانی زیر حاوی دو مثال است که یک مدل زبان بزرگ را نشان می دهد که چگونه به یک پرس و جو پاسخ دهد.

| بخش هایی از یک فرمان | یادداشت ها |

|---|---|

| واحد پول رسمی کشور مشخص شده چیست؟ | سوالی که می خواهید LLM به آن پاسخ دهد. |

| فرانسه: یورو | یک مثال. |

| بریتانیا: GBP | مثال دیگر. |

| هند: | پرس و جو واقعی |

درخواستهای چند شات معمولاً نتایج مطلوبتری نسبت به درخواستهای صفر و یک شات ایجاد میکنند. با این حال، درخواست چند شات به یک اعلان طولانیتر نیاز دارد.

درخواست چند شات شکلی از یادگیری چند شات است که برای یادگیری مبتنی بر سریع اعمال می شود.

برای اطلاعات بیشتر به مهندسی سریع در دوره تصادف یادگیری ماشین مراجعه کنید.

کمانچه

یک کتابخانه پیکربندی Python-first که مقادیر توابع و کلاسها را بدون کد یا زیرساخت مهاجم تنظیم میکند. در مورد Pax - و سایر پایگاههای کد ML - این توابع و کلاسها مدلها و فراپارامترهای آموزشی را نشان میدهند.

Fiddle فرض میکند که پایگاههای کد یادگیری ماشین معمولاً به دو دسته تقسیم میشوند:

- کد کتابخانه، که لایه ها و بهینه سازها را تعریف می کند.

- کد "چسب" مجموعه داده، که کتابخانه ها را فراخوانی می کند و همه چیز را به هم متصل می کند.

Fiddle ساختار فراخوانی کد چسب را به شکلی ارزیابی نشده و قابل تغییر به تصویر می کشد.

تنظیم دقیق

دومین پاس آموزشی ویژه کار بر روی یک مدل از پیش آموزش دیده انجام شد تا پارامترهای آن را برای یک مورد استفاده خاص اصلاح کند. به عنوان مثال، دنباله آموزش کامل برای برخی از مدل های زبان بزرگ به شرح زیر است:

- قبل از آموزش: یک مدل زبان بزرگ را بر روی یک مجموعه داده کلی گسترده، مانند تمام صفحات ویکی پدیا به زبان انگلیسی، آموزش دهید.

- تنظیم دقیق: مدل از پیش آموزش دیده را برای انجام یک کار خاص ، مانند پاسخ به سؤالات پزشکی، آموزش دهید. تنظیم دقیق معمولاً شامل صدها یا هزاران مثال متمرکز بر یک کار خاص است.

به عنوان مثال دیگر، دنباله آموزش کامل برای یک مدل تصویر بزرگ به شرح زیر است:

- قبل از آموزش: یک مدل تصویر بزرگ را بر روی یک مجموعه داده کلی تصویری گسترده، مانند تمام تصاویر موجود در Wikimedia Commons آموزش دهید.

- تنظیم دقیق: مدل از پیش آموزش دیده را برای انجام یک کار خاص ، مانند تولید تصاویر اورکا، آموزش دهید.

تنظیم دقیق می تواند شامل هر ترکیبی از استراتژی های زیر باشد:

- اصلاح تمام پارامترهای موجود مدل از پیش آموزش دیده. گاهی اوقات به آن تنظیم دقیق کامل می گویند.

- اصلاح تنها برخی از پارامترهای موجود مدل از قبل آموزش دیده (معمولاً، نزدیکترین لایه ها به لایه خروجی )، در حالی که سایر پارامترهای موجود را بدون تغییر نگه می دارد (معمولاً، لایه های نزدیک به لایه ورودی ). تنظیم کارآمد پارامتر را ببینید.

- افزودن لایههای بیشتر، معمولاً در بالای لایههای موجود که نزدیکترین لایه به لایه خروجی است.

تنظیم دقیق شکلی از یادگیری انتقالی است. به این ترتیب، تنظیم دقیق ممکن است از یک تابع تلفات متفاوت یا نوع مدل متفاوتی نسبت به مواردی که برای آموزش مدل از پیش آموزش دیده استفاده میشود، استفاده کند. به عنوان مثال، میتوانید یک مدل تصویر بزرگ از قبل آموزشدیده را برای تولید یک مدل رگرسیونی تنظیم کنید که تعداد پرندگان در یک تصویر ورودی را برمیگرداند.

تنظیم دقیق را با عبارات زیر مقایسه و مقایسه کنید:

برای اطلاعات بیشتر به تنظیم دقیق در دوره تصادف یادگیری ماشین مراجعه کنید.

کتان

یک کتابخانه منبع باز با کارایی بالا برای یادگیری عمیق که بر روی JAX ساخته شده است. Flax عملکردهایی را برای آموزش شبکه های عصبی و همچنین روش هایی برای ارزیابی عملکرد آنها ارائه می دهد.

کتان ساز

یک کتابخانه Transformer منبع باز، ساخته شده بر روی Flax ، که عمدتا برای پردازش زبان طبیعی و تحقیقات چندوجهی طراحی شده است.

جی

جوزا

این اکوسیستم شامل پیشرفته ترین هوش مصنوعی گوگل است. عناصر این اکوسیستم عبارتند از:

- مدل های مختلف جمینی .

- رابط مکالمه تعاملی به مدل Gemini . کاربران دستورات را تایپ می کنند و Gemini به آن درخواست ها پاسخ می دهد.

- API های مختلف Gemini.

- محصولات تجاری مختلف بر اساس مدل های جمینی؛ به عنوان مثال، Gemini برای Google Cloud .

مدل های جمینی

پیشرفته ترین مدل های چندوجهی مبتنی بر ترانسفورماتور گوگل. مدل های Gemini به طور خاص برای ادغام با عوامل طراحی شده اند.

کاربران می توانند با مدل های Gemini به روش های مختلفی از جمله از طریق یک رابط گفتگوی تعاملی و از طریق SDK تعامل داشته باشند.

متن تولید شده

به طور کلی، متنی که یک مدل ML خروجی می دهد. هنگام ارزیابی مدلهای زبان بزرگ، برخی از معیارها متن تولید شده را با متن مرجع مقایسه میکنند. برای مثال، فرض کنید میخواهید تعیین کنید که چگونه یک مدل ML از فرانسوی به هلندی ترجمه میشود. در این مورد:

- متن تولید شده ترجمه هلندی است که مدل ML خروجی می دهد.

- متن مرجع ترجمه هلندی است که یک مترجم انسانی (یا نرم افزار) ایجاد می کند.

توجه داشته باشید که برخی از استراتژی های ارزیابی شامل متن مرجع نیستند.

هوش مصنوعی مولد

یک میدان تحولآفرین در حال ظهور بدون تعریف رسمی. گفته میشود، اکثر کارشناسان موافق هستند که مدلهای هوش مصنوعی تولیدی میتوانند محتوایی را ایجاد کنند ("تولید") که همه موارد زیر باشد:

- مجتمع

- منسجم

- اصلی

به عنوان مثال، یک مدل هوش مصنوعی مولد می تواند مقالات یا تصاویر پیچیده ای ایجاد کند.

برخی از فناوریهای قبلی، از جمله LSTM و RNN ، میتوانند محتوای اصلی و منسجم تولید کنند. برخی از کارشناسان این فناوری های قبلی را به عنوان هوش مصنوعی مولد می دانند، در حالی که برخی دیگر احساس می کنند که هوش مصنوعی مولد واقعی به خروجی پیچیده تری نسبت به فناوری های قبلی نیاز دارد.

در مقابل ML پیش بینی .

پاسخ طلایی

پاسخی که به خوبی شناخته شده است. به عنوان مثال، با توجه به دستور زیر:

2 + 2

پاسخ طلایی امیدوارم:

4

GPT (ترانسفورماتور از پیش آموزش دیده ژنراتور)

خانواده ای از مدل های زبان بزرگ مبتنی بر Transformer که توسط OpenAI توسعه یافته است.

انواع GPT می توانند برای چندین روش اعمال شوند، از جمله:

- تولید تصویر (مثلا ImageGPT)

- تولید متن به تصویر (به عنوان مثال، DALL-E ).

اچ

توهم

تولید خروجی به ظاهر قابل قبول اما از نظر واقعی نادرست توسط یک مدل هوش مصنوعی مولد که ادعا می کند در مورد دنیای واقعی ادعا می کند. به عنوان مثال، یک مدل هوش مصنوعی مولد که ادعا می کند باراک اوباما در سال 1865 درگذشت توهم آور است.

ارزیابی انسانی

فرآیندی که در آن افراد کیفیت خروجی مدل ML را قضاوت می کنند. برای مثال، داشتن افراد دوزبانه در مورد کیفیت مدل ترجمه ML قضاوت می کنند. ارزیابی انسانی به ویژه برای قضاوت در مورد مدل هایی که پاسخ درستی ندارند مفید است.

در تضاد با ارزیابی خودکار و ارزیابی autorater .

من

یادگیری درون متنی

مترادف اعلان چند شات .

L

LaMDA (مدل زبانی برای برنامههای گفتگو)

یک مدل زبان بزرگ مبتنی بر ترانسفورماتور که توسط Google ایجاد شده است که بر روی یک مجموعه داده گفتگوی بزرگ آموزش داده شده است که می تواند پاسخ های مکالمه واقعی ایجاد کند.

LaMDA: فناوری مکالمه پیشرفت ما یک نمای کلی ارائه می دهد.

مدل زبان

مدلی که احتمال وقوع یک توکن یا دنباله ای از توکن ها را در یک دنباله طولانی تر از توکن ها تخمین می زند.

ببینید مدل زبان چیست؟ برای اطلاعات بیشتر، در دوره تصادف یادگیری ماشینی.

مدل زبان بزرگ

حداقل، یک مدل زبان دارای تعداد بسیار بالایی از پارامترها است. غیررسمی تر، هر مدل زبان مبتنی بر Transformer ، مانند Gemini یا GPT .

برای اطلاعات بیشتر، مدلهای زبان بزرگ (LLM) را در دوره آموزشی تصادفی یادگیری ماشین ببینید.

فضای نهفته

مترادف برای جاسازی فضا .

فاصله لونشتاین

اندازهگیری فاصله ویرایشی که کمترین عملیات حذف، درج و جایگزینی مورد نیاز برای تغییر یک کلمه به کلمه دیگر را محاسبه میکند. به عنوان مثال، فاصله Levenshtein بین کلمات "قلب" و "دارت" سه است زیرا سه ویرایش زیر کمترین تغییر برای تبدیل یک کلمه به کلمه دیگر است:

- قلب ← عزیز (h را با "d" جایگزین کنید)

- deart → dart (حذف "e")

- دارت → دارت (درج "s")

توجه داشته باشید که دنباله قبلی تنها مسیر سه ویرایش نیست.

LLM

مخفف مدل زبان بزرگ .

ارزیابی های LLM (ارزیابی)

مجموعهای از معیارها و معیارها برای ارزیابی عملکرد مدلهای زبان بزرگ (LLM). در سطح بالا، ارزیابی های LLM:

- به محققان کمک کنید مناطقی را که LLM نیاز به بهبود دارند شناسایی کنند.

- در مقایسه LLM های مختلف و شناسایی بهترین LLM برای یک کار خاص مفید هستند.

- کمک کنید تا مطمئن شوید که LLM ها برای استفاده ایمن و اخلاقی هستند.

برای اطلاعات بیشتر، مدلهای زبان بزرگ (LLM) را در دوره آموزشی تصادفی یادگیری ماشین ببینید.

LoRA

مخفف عبارت Low-Rank Adaptability .

سازگاری با رتبه پایین (LoRA)

یک تکنیک کارآمد از نظر پارامتر برای تنظیم دقیق که وزنهای از پیش آموزشدیدهشده مدل را منجمد میکند (به طوری که دیگر نمیتوان آنها را اصلاح کرد) و سپس مجموعه کوچکی از وزنههای قابل آموزش را در مدل قرار میدهد. این مجموعه از وزنه های قابل تمرین (همچنین به عنوان "ماتریس های به روز رسانی" شناخته می شود) به طور قابل توجهی کوچکتر از مدل پایه است و بنابراین برای تمرین بسیار سریعتر است.

LoRA مزایای زیر را ارائه می دهد:

- کیفیت پیشبینیهای مدل را برای دامنهای که تنظیم دقیق در آن اعمال میشود، بهبود میبخشد.

- تنظیم دقیقتر از تکنیکهایی که نیاز به تنظیم دقیق همه پارامترهای مدل دارند.

- هزینه محاسباتی استنتاج را با فعال کردن سرویس دهی همزمان چندین مدل تخصصی که یک مدل پایه را به اشتراک می گذارند، کاهش می دهد.

م

مدل زبان نقاب دار

یک مدل زبان که احتمال توکنهای کاندید را برای پر کردن جاهای خالی در یک دنباله پیشبینی میکند. به عنوان مثال، یک مدل زبان پوشانده میتواند احتمالات را برای کلمه(های) نامزد برای جایگزینی خط زیر در جمله زیر محاسبه کند:

____ در کلاه برگشت.

ادبیات معمولاً از رشته "MASK" به جای زیر خط استفاده می کند. به عنوان مثال:

"ماسک" در کلاه برگشت.

بیشتر مدلهای زبان نقابدار مدرن دو جهته هستند.

میانگین دقت متوسط در k (mAP@k)

میانگین آماری تمام میانگین دقت در نمره های k در یک مجموعه داده اعتبار سنجی. یکی از کاربردهای میانگین دقت در k قضاوت در مورد کیفیت توصیه های تولید شده توسط یک سیستم توصیه می باشد.

اگرچه عبارت "میانگین متوسط" اضافی به نظر می رسد، نام متریک مناسب است. از این گذشته، این متریک میانگین دقت میانگین چندگانه را در مقادیر k پیدا می کند.

متائی

زیر مجموعه ای از یادگیری ماشین که الگوریتم یادگیری را کشف یا بهبود می بخشد. یک سیستم یادگیری متا همچنین می تواند با هدف آموزش یک مدل برای یادگیری سریع یک کار جدید از مقدار کمی از داده ها یا از تجربه به دست آمده در کارهای قبلی باشد. الگوریتم های یادگیری متا به طور کلی سعی در دستیابی به موارد زیر دارند:

- ویژگی های مهندسی دستی را بهبود یا یاد بگیرید (مانند یک اولیه ساز یا بهینه ساز).

- با کارآیی بیشتر و محاسبه کارآمد باشید.

- تعمیم را بهبود بخشید.

یادگیری متا مربوط به یادگیری چند شات است.

مخلوط کارشناسان

طرحی برای افزایش بهره وری شبکه عصبی با استفاده از تنها زیر مجموعه ای از پارامترهای آن (معروف به یک متخصص ) برای پردازش یک نشانه ورودی یا مثال . یک شبکه دروازه هر یک از نشانه های ورودی یا مثال را به متخصص (های) مناسب هدایت می کند.

برای جزئیات بیشتر ، به هر یک از مقاله های زیر مراجعه کنید:

MMIT

مخفف تنظیم دستورالعمل چندمودال .

روش

یک دسته از داده های سطح بالا. به عنوان مثال ، اعداد ، متن ، تصاویر ، فیلم و صدا پنج روش مختلف هستند.

موازی گرایی

روشی برای مقیاس بندی آموزش یا استنباط که قسمت های مختلف یک مدل را در دستگاه های مختلف قرار می دهد. موازی سازی مدل مدل هایی را که خیلی بزرگ هستند برای قرار دادن در یک دستگاه واحد امکان پذیر می کند.

برای اجرای موازی سازی مدل ، یک سیستم به طور معمول موارد زیر را انجام می دهد:

- شرابها (تقسیم) مدل را به قسمت های کوچکتر.

- آموزش آن قسمت های کوچکتر را در چندین پردازنده توزیع می کند. هر پردازنده بخشی از مدل خود را آموزش می دهد.

- نتایج را برای ایجاد یک مدل واحد ترکیب می کند.

موازی سازی مدل آموزش را کند می کند.

همچنین به موازی سازی داده ها مراجعه کنید.

معلق

مخفف مخلوط متخصصان .

خودداری چند سر

گسترش توجه به خود که چندین بار برای هر موقعیت در دنباله ورودی به کار می رود.

ترانسفورماتورها با توجه به خود چند سر را معرفی کردند.

دستورالعمل چند حالته

یک مدل تنظیم شده توسط دستورالعمل که می تواند ورودی را فراتر از متن ، مانند تصاویر ، فیلم و صوتی پردازش کند.

مدل چند قسمت

مدلی که ورودی ها ، خروجی ها یا هر دو بیش از یک روش را شامل می شود. به عنوان مثال ، مدلی را در نظر بگیرید که هم یک تصویر و هم یک عنوان متن (دو روش) را به عنوان ویژگی در نظر می گیرد و یک نمره را نشان می دهد که نشان می دهد عنوان متن برای تصویر چقدر مناسب است. بنابراین ، ورودی های این مدل چند حالته هستند و خروجی آن غیرقانونی است.

ن

پردازش زبان طبیعی

زمینه آموزش رایانه ها برای پردازش آنچه کاربر گفت یا با استفاده از قوانین زبانی تایپ کرده است. تقریباً تمام پردازش زبان طبیعی مدرن به یادگیری ماشین متکی است.درک زبان طبیعی

زیر مجموعه ای از پردازش زبان طبیعی که اهداف چیزی گفته شده یا تایپ شده را تعیین می کند. درک زبان طبیعی می تواند فراتر از پردازش زبان طبیعی باشد تا جنبه های پیچیده زبان مانند زمینه ، طعنه و احساسات را در نظر بگیرد.

N-گرم

یک دنباله سفارش داده شده از n کلمات. به عنوان مثال ، واقعاً دیوانه وار 2 گرم است. از آنجا که نظم مرتبط است ، دیوانه وار واقعاً 2 گرم متفاوت از واقعاً دیوانه وار است.

| ن | نام (ها) برای این نوع n-gram | نمونه ها |

|---|---|---|

| 2 | بیگرام یا 2 گرم | برای رفتن ، رفتن ، ناهار خوردن ، شام خوردن |

| 3 | Trigram یا 3 گرم | بیش از حد ، خوشبختانه بعد از آن ، زنگ های زنگ |

| 4 | 4 گرم | در پارک قدم بزنید ، گرد و غبار در باد ، پسر عدس بخورد |

بسیاری از مدل های درک زبان طبیعی برای پیش بینی کلمه بعدی که کاربر تایپ می کند یا می گوید ، به N-Grams متکی هستند. به عنوان مثال ، فرض کنید کاربر تا به حال با خوشحالی تایپ کرده است. یک مدل NLU مبتنی بر Trigrams احتمالاً پیش بینی می کند که کاربر بعد از آن کلمه را تایپ کند.

N-Grams با کیف کلمات ، که مجموعه ای از کلمات بدون هماهنگ هستند.

برای اطلاعات بیشتر به مدل های بزرگ زبان در دوره Crash Learning Machine مراجعه کنید.

NLP

مخفف برای پردازش زبان طبیعی .

NLU

مخفف درک زبان طبیعی .

هیچ پاسخ درستی (نورا)

سریع داشتن چندین پاسخ مناسب. به عنوان مثال ، فوری زیر هیچ پاسخ درستی ندارد:

به من شوخی در مورد فیل ها بگویید.

ارزیابی پیشبرد های هیچ یک از راستا می تواند چالش برانگیز باشد.

نورا

مخفف برای هیچ کس پاسخ درستی ندارد .

O

یک شلیک کننده

سریع که حاوی یک مثال است که نشان می دهد چگونه مدل زبان بزرگ باید پاسخ دهد. به عنوان مثال ، سریع زیر حاوی یک مثال است که یک مدل زبان بزرگ را نشان می دهد که چگونه باید به یک پرس و جو پاسخ دهد.

| بخش هایی از یک سریع | یادداشت ها |

|---|---|

| ارز رسمی کشور مشخص شده چیست؟ | سوالی که می خواهید LLM به آن پاسخ دهد. |

| فرانسه: یورو | یک مثال. |

| هند: | پرس و جو واقعی |

با اصطلاحات زیر مقایسه و تضاد را با شرایط زیر مقایسه و تضاد کنید:

پ

تنظیم پارامتر

مجموعه ای از تکنیک ها برای تنظیم دقیق یک مدل بزرگ زبان از قبل آموزش دیده (PLM) با کارآمدتر از تنظیم دقیق کامل. تنظیم کارآمد پارامترها به طور معمول با ترانه های ریز و درشت بسیار کمتری نسبت به تنظیم کامل کامل ، اما به طور کلی یک مدل زبان بزرگ تولید می کند که به عنوان یک مدل زبان بزرگ ساخته شده از تنظیم کامل ، عملکرد (یا تقریباً به همین ترتیب) را نیز تولید می کند.

تنظیم و تنظیم کارآمد پارامتر با:

تنظیم کارآمد پارامتر همچنین به عنوان تنظیم دقیق پارامتر شناخته می شود.

لوله کشی

نوعی از موازی سازی مدل که در آن پردازش یک مدل به مراحل متوالی تقسیم می شود و هر مرحله بر روی یک دستگاه متفاوت اجرا می شود. در حالی که یک مرحله در حال پردازش یک دسته است ، مرحله قبل می تواند روی دسته بعدی کار کند.

همچنین آموزش صحنه را ببینید.

PLM

مخفف برای مدل زبان از پیش آموزش دیده .

رمزگذاری موضعی

تکنیکی برای اضافه کردن اطلاعات در مورد موقعیت یک توکن در دنباله ای به تعبیه توکن. مدل های ترانسفورماتور برای درک بهتر رابطه بین قسمت های مختلف دنباله از رمزگذاری موقعیتی استفاده می کنند.

اجرای مشترک رمزگذاری موقعیتی از یک عملکرد سینوسی استفاده می کند. (به طور خاص ، فرکانس و دامنه عملکرد سینوسی با موقعیت توکن در دنباله تعیین می شود.) این تکنیک یک مدل ترانسفورماتور را قادر می سازد تا بر اساس موقعیت آنها در قسمت های مختلف دنباله شرکت کند.

مدل پس از آموزش

اصطلاح کاملاً تعریف شده ای که به طور معمول به یک مدل از پیش آموزش داده شده اشاره دارد که برخی از پردازش ها را طی کرده است ، مانند یک یا چند مورد از موارد زیر:

دقت در K (Precision@k)

متریک برای ارزیابی لیست موارد رتبه بندی شده (سفارش). دقت در K کسری از اولین موارد K را در آن لیست که "مرتبط" هستند مشخص می کند. یعنی:

\[\text{precision at k} = \frac{\text{relevant items in first k items of the list}} {\text{k}}\]

مقدار k باید کمتر یا مساوی با طول لیست برگشتی باشد. توجه داشته باشید که طول لیست برگشتی بخشی از محاسبه نیست.

ارتباط اغلب ذهنی است. حتی ارزیاب های انسانی متخصص نیز اغلب با این موارد مخالف هستند.

مقایسه کنید با:

مدل از پیش آموزش داده شده

به طور معمول ، مدلی که قبلاً آموزش دیده است. این اصطلاح همچنین می تواند به معنای یک بردار تعبیه شده قبلاً آموزش دیده باشد.

اصطلاح مدل زبان از قبل آموزش دیده معمولاً به یک مدل بزرگ زبان در حال حاضر آموزش داده شده است.

قبل از آموزش

آموزش اولیه یک مدل در یک مجموعه داده بزرگ. برخی از مدل های از قبل آموزش دیده غول های دست و پا چلفتی هستند و به طور معمول باید از طریق آموزش های اضافی تصفیه شوند. به عنوان مثال ، کارشناسان ML ممکن است یک مدل زبان بزرگ را در یک مجموعه داده گسترده مانند تمام صفحات انگلیسی در ویکی پدیا از قبل ردیابی کنند. به دنبال پیش از آموزش ، مدل حاصل ممکن است از طریق هر یک از تکنیک های زیر تصحیح شود:

سریع

هر متنی که به عنوان ورودی به یک مدل زبان بزرگ وارد شده باشد تا مدل را به روشی خاص رفتار کند. اعلان ها می توانند به اندازه یک عبارت یا خودسرانه طولانی باشند (به عنوان مثال ، کل متن یک رمان). پیشبرد ها در چند دسته قرار می گیرند ، از جمله مواردی که در جدول زیر نشان داده شده است:

| دسته سریع | مثال | یادداشت ها |

|---|---|---|

| سوال | چقدر سریع می تواند کبوتر پرواز کند؟ | |

| دستورالعمل | شعر خنده دار در مورد داوری بنویسید. | سریع که از الگوی زبان بزرگ می خواهد کاری انجام دهد . |

| مثال | کد Markdown را به HTML ترجمه کنید. به عنوان مثال: Markdown: * مورد لیست html: <ul> <li> مورد لیست </li> </ul> | اولین جمله در این مثال یک دستورالعمل است. نمونه باقیمانده سریع است. |

| نقش | توضیح دهید که چرا از تبار شیب در آموزش یادگیری ماشین به دکترا در فیزیک استفاده می شود. | قسمت اول جمله یک دستورالعمل است. عبارت "به دکترای فیزیک" بخش نقش است. |

| ورودی جزئی برای تکمیل مدل | نخست وزیر انگلستان در آن زندگی می کند | یک سریع ورودی جزئی می تواند به طور ناگهانی خاتمه یابد (همانطور که این مثال انجام می دهد) یا با یک تأکید پایان می یابد. |

یک مدل هوش مصنوعی تولیدی می تواند با متن ، کد ، تصاویر ، تعبیه ها ، فیلم ها به یک سریع پاسخ دهد ... تقریباً هر چیزی.

یادگیری سریع

قابلیت برخی از مدل های خاص که آنها را قادر می سازد تا رفتار خود را در پاسخ به ورودی متن دلخواه ( PRICES ) تطبیق دهند. در یک الگوی یادگیری سریع مبتنی بر سریع ، یک مدل زبان بزرگ با تولید متن به یک سریع پاسخ می دهد. به عنوان مثال ، فرض کنید کاربر وارد سریع زیر می شود:

قانون سوم حرکت نیوتن را خلاصه کنید.

مدلی که قادر به یادگیری مبتنی بر سریع باشد ، به طور خاص برای پاسخ دادن به سریع قبلی آموزش داده نشده است. در عوض ، مدل "بسیاری از حقایق" را در مورد فیزیک ، چیزهای زیادی در مورد قوانین زبان عمومی و چیزهای زیادی در مورد آنچه که پاسخ های کلی مفید است ، می داند. این دانش برای ارائه پاسخ مفید (امیدوارم) کافی است. بازخورد اضافی انسانی ("این پاسخ خیلی پیچیده بود." یا "واکنش چیست؟") برخی از سیستم های یادگیری مبتنی بر سریع را قادر می سازد تا به تدریج سودمندی پاسخ های خود را بهبود بخشند.

طراحی سریع

مترادف برای مهندسی سریع .

مهندسی سریع

هنر ایجاد منجر به پاسخ های مورد نظر از یک مدل بزرگ زبان می شود. انسان مهندسی سریع را انجام می دهد. نوشتن مطالب خوب ساختار یافته بخش مهمی برای اطمینان از پاسخ های مفید از یک مدل زبان بزرگ است. مهندسی سریع به عوامل زیادی بستگی دارد ، از جمله:

- مجموعه داده ها برای پیش خط و احتمالاً خوب مدل زبان بزرگ استفاده می شود.

- دما و سایر پارامترهای رمزگشایی که مدل برای تولید پاسخ استفاده می کند.

طراحی سریع مترادف برای مهندسی سریع است.

برای اطلاعات بیشتر در مورد نوشتن دستورالعمل های مفید ، به مقدمه طراحی سریع مراجعه کنید.

تنظیم سریع

یک مکانیسم تنظیم کارآمد پارامتر که "پیشوند" ای را که سیستم برای فوری واقعی می آموزد ، می آموزد.

یک تغییر تنظیم سریع - بعضی اوقات به نام تنظیم پیشوند - برای پیش بینی پیشوند در هر لایه است. در مقابل ، بیشتر تنظیم سریع فقط پیشوند به لایه ورودی اضافه می کند.

آر

به یاد بیاورید در K (به یاد بیاورید@k)

متریک برای ارزیابی سیستم هایی که لیستی از موارد رتبه بندی شده (سفارش داده شده) را تولید می کنند. به یاد بیاورید در K کسری از موارد مربوطه را در اولین موارد K در آن لیست از تعداد کل موارد مربوطه برگشتی مشخص می کند.

\[\text{recall at k} = \frac{\text{relevant items in first k items of the list}} {\text{total number of relevant items in the list}}\]

تضاد با دقت در k .

متن مرجع

پاسخ یک متخصص به سریع . به عنوان مثال ، با توجه به سریع زیر:

ترجمه سوال "نام شما چیست؟" از انگلیسی به فرانسوی.

پاسخ یک متخصص ممکن است:

نظر Vous Appelez-vous؟

معیارهای مختلف (مانند Rouge ) درجه ای را که متن مرجع با متن تولید شده از مدل ML مطابقت دارد ، اندازه گیری می کنند.

نقش

بخش اختیاری از سریع که مخاطب هدف را برای پاسخ یک مدل AI تولیدی مشخص می کند. بدون فوریت نقش ، یک مدل زبان بزرگ پاسخی را ارائه می دهد که ممکن است برای شخصی که سوالات را پرسیده یا ممکن است مفید نباشد. با یک فوریت نقش ، یک مدل بزرگ زبان می تواند به روشی پاسخ دهد که مناسب تر و مفیدتر برای مخاطب هدف خاص باشد. به عنوان مثال ، بخش سریع نقش از مطالب زیر در BOLDFACE است:

- این سند را برای دکترای اقتصاد خلاصه کنید.

- توضیح دهید که چگونه جزر و مد برای یک کودک ده ساله کار می کند.

- بحران مالی سال 2008 را توضیح دهید. همانطور که ممکن است با یک کودک خردسال یا یک بازپرداخت طلایی صحبت کنید.

rouge (فراخوان محور برای ارزیابی gisting)

خانواده ای از معیارهایی که خلاصه های خودکار و مدل های ترجمه ماشین را ارزیابی می کنند. معیارهای Rouge درجه ای را تعیین می کنند که یک متن مرجع با متن تولید شده از مدل ML همپوشانی دارد. هر یک از اعضای خانواده روژ به روشی متفاوت همپوشانی دارند. نمرات بالاتر ROUGE شباهت بیشتری بین متن مرجع و متن تولید شده نسبت به نمرات Rouge پایین تر نشان می دهد.

هر یک از اعضای خانواده Rouge به طور معمول معیارهای زیر را تولید می کنند:

- دقت

- به یاد بیاورید

- F 1

برای جزئیات و مثال ، به:

Rouge-l

یکی از اعضای خانواده Rouge بر طول طولانی ترین عواقب مشترک در متن مرجع و متن تولید شده متمرکز شده است. فرمول های زیر فراخوان و دقت را برای Rouge-L محاسبه می کنند:

سپس می توانید از F 1 برای بالا بردن Rouge-L فراخوان و دقت Rouge-L در یک متریک واحد استفاده کنید:

Rouge-L هر خط جدید را در متن مرجع و متن تولید شده نادیده می گیرد ، بنابراین طولانی ترین دنباله مشترک می تواند از چندین جمله عبور کند. هنگامی که متن مرجع و متن تولید شده شامل چندین جمله است ، تنوع Rouge-L به نام Rouge-lsum به طور کلی یک معیار بهتر است. Rouge-LSUM طولانی ترین دنبال کننده مشترک برای هر جمله در یک متن را تعیین می کند و سپس میانگین آن طولانی ترین عواقب مشترک را محاسبه می کند.

roge-n

مجموعه ای از معیارهای موجود در خانواده Rouge که N-Grams مشترک با اندازه خاص را در متن مرجع و متن تولید شده مقایسه می کند. به عنوان مثال:

- Rouge-1 تعداد نشانه های مشترک را در متن مرجع و متن تولید شده اندازه گیری می کند.

- Rouge-2 تعداد Bigrams مشترک (2 گرم) را در متن مرجع و متن تولید شده اندازه گیری می کند.

- Rouge-3 تعداد TRIGRAMS مشترک (3 گرم) را در متن مرجع و متن تولید شده اندازه گیری می کند.

می توانید از فرمول های زیر برای محاسبه فراخوان Rouge-N و دقت Rouge-N برای هر یک از اعضای خانواده Rouge-N استفاده کنید:

سپس می توانید از F 1 برای بالا بردن Rouge-N فراخوان و دقت Rouge-N در یک متریک واحد استفاده کنید:

Rouge-s

یک شکل بخشنده از Rouge-N که تطبیق Skip-Gram را امکان پذیر می کند. یعنی ، Rouge-N فقط N-Grams را که دقیقاً مطابقت دارند ، شمارش می کند ، اما Rouge-S همچنین N-Grams را که با یک یا چند کلمه از هم جدا شده اند ، شمارش می کند. برای مثال موارد زیر را در نظر بگیرید:

- متن مرجع : ابرهای سفید

- متن تولید شده : ابرهای سفید کننده سفید

هنگام محاسبه Rouge-N ، ابرهای سفید 2 گرم ، با ابرهای رنگ سفید مطابقت ندارند. با این حال ، هنگام محاسبه Rouge-S ، ابرهای سفید با ابرهای رنگ سفید مطابقت دارند.

اس

خودآگاهی (که به آن لایه خود توجه نیز گفته می شود)

یک لایه شبکه عصبی که دنباله ای از تعبیه ها (به عنوان مثال ، تعبیه شده ) را به دنباله دیگری از تعبیه تبدیل می کند. هر تعبیه در دنباله خروجی با ادغام اطلاعات از عناصر دنباله ورودی از طریق مکانیسم توجه ساخته می شود.

بخشی از خود توجه به دنباله ای که در آن حضور دارد و نه به برخی از زمینه های دیگر اشاره دارد. خودآگاهی یکی از اصلی ترین بلوک های ساختمانی برای ترانسفورماتورها است و از اصطلاحات جستجوی فرهنگ لغت مانند "پرس و جو" ، "کلید" و "ارزش" استفاده می کند.

یک لایه خودآگاهی با دنباله ای از بازنمایی های ورودی ، یکی برای هر کلمه شروع می شود. بازنمایی ورودی برای یک کلمه می تواند یک تعبیه ساده باشد. برای هر کلمه در یک دنباله ورودی ، شبکه ارتباط این کلمه را با هر عنصر در کل دنباله کلمات نشان می دهد. نمرات ارتباطی تعیین می کند که نمای نهایی کلمه چقدر بازنمایی کلمات دیگر را در بر می گیرد.

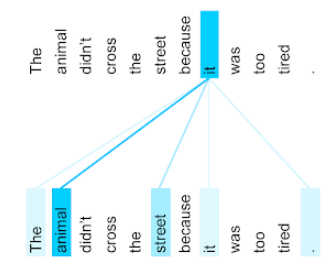

برای مثال جمله زیر را در نظر بگیرید:

حیوان از خیابان عبور نکرد زیرا خیلی خسته بود.

تصویر زیر (از Transformer: یک معماری شبکه عصبی جدید برای درک زبان ) الگوی توجه یک لایه خود را برای ضمیر آن نشان می دهد ، با تاریکی هر خط نشان می دهد که هر کلمه چقدر به بازنمایی کمک می کند:

لایه خودآگاهی کلماتی را که مربوط به "آن" است ، برجسته می کند. در این حالت ، لایه توجه آموخته است که کلماتی را که ممکن است به آن اشاره کنند ، برجسته کند و بالاترین وزن را به حیوان اختصاص دهد.

برای دنباله ای از نشانه های N ، خود توجه ، دنباله ای از تعبیه N زمان جداگانه را تغییر می دهد ، یک بار در هر موقعیت در دنباله.

همچنین به توجه و توجه خود چند سر مراجعه کنید.

تحلیل احساسات

استفاده از الگوریتم های آماری یا یادگیری ماشین برای تعیین نگرش کلی یک گروه - مثبت یا منفی - یک سرویس ، محصول ، سازمان یا موضوع را نشان می دهد. به عنوان مثال ، با استفاده از درک زبان طبیعی ، یک الگوریتم می تواند تجزیه و تحلیل احساساتی را در بازخورد متنی از یک دوره دانشگاه انجام دهد تا میزان دانش آموزان را به طور کلی دوست داشته باشد یا از این دوره استفاده کند.

برای اطلاعات بیشتر به راهنمای طبقه بندی متن مراجعه کنید.

کار توالی به توالی

وظیفه ای که یک توالی ورودی از نشانه ها را به یک توالی خروجی از نشانه ها تبدیل می کند. به عنوان مثال ، دو نوع محبوب از وظایف دنباله به دنباله عبارتند از:

- مترجمان:

- دنباله ورودی نمونه: "من تو را دوست دارم."

- دنباله خروجی نمونه: "je t'aime."

- پاسخ سوال:

- دنباله ورودی نمونه: "آیا من به ماشین خود در شهر نیویورک احتیاج دارم؟"

- دنباله خروجی نمونه: "نه. ماشین خود را در خانه نگه دارید."

پرش

N-Gram که ممکن است کلمات (یا "پرش") را از متن اصلی حذف کند ، به این معنی که ممکن است کلمات N در ابتدا مجاور نبوده باشد. به طور دقیق تر ، "k-skip-n-gram" یک n-gram است که ممکن است کلمات k از بین برود.

به عنوان مثال ، "روباه قهوه ای سریع" دارای 2 گرم ممکن است:

- "سریع"

- "قهوه ای سریع"

- "روباه قهوه ای"

"1-Skip-2-Gram" یک جفت کلمه است که حداکثر 1 کلمه بین آنها وجود دارد. بنابراین ، "روباه قهوه ای سریع" دارای 2-گرم 2-SKIP زیر است:

- "قهوه ای"

- "روباه سریع"

علاوه بر این ، تمام 2 گرم نیز 1-Skip-2-Grams هستند ، زیرا ممکن است کمتر از یک کلمه پرش شود.

Skip-Grams برای درک بیشتر در مورد یک کلمه اطراف مفید است. در مثال ، "روباه" مستقیماً در مجموعه 1-skip-2 گرم با "سریع" همراه بود ، اما در مجموعه 2 گرم نیست.

Skip-Grams به آموزش مدل های تعبیه کننده کلمه کمک می کند.

تنظیم سریع نرم

تکنیکی برای تنظیم یک مدل زبان بزرگ برای یک کار خاص ، بدون تنظیم دقیق منابع. به جای بازآفرینی تمام وزنهای موجود در مدل ، تنظیم سریع نرم به طور خودکار یک سریع را تنظیم می کند تا به همان هدف برسد.

با توجه به یک متن متنی ، تنظیم سریع نرم به طور معمول تعبیه های اضافی را به سریع اضافه می کند و از backpropagation برای بهینه سازی ورودی استفاده می کند.

سریع "سخت" حاوی نشانه های واقعی به جای تعبیه های نشانه است.

ویژگی پراکنده

ویژگی ای که مقادیر آن عمدتا صفر یا خالی است. به عنوان مثال ، یک ویژگی حاوی یک مقدار 1 و یک میلیون مقدار 0 مقدار پراکنده است. در مقابل ، یک ویژگی متراکم دارای مقادیری است که عمدتا صفر یا خالی نیستند.

در یادگیری ماشین ، تعداد غافلگیرکننده ای از ویژگی ها از ویژگی های پراکنده هستند. ویژگی های طبقه بندی شده معمولاً ویژگی های پراکنده است. به عنوان مثال ، از 300 گونه درخت ممکن در یک جنگل ، یک مثال واحد ممکن است فقط یک درخت افرا را شناسایی کند. یا از میلیون ها فیلم ممکن در یک کتابخانه ویدیویی ، یک مثال واحد ممکن است فقط "Casablanca" را مشخص کند.

در یک مدل ، شما به طور معمول ویژگی های پراکنده را با رمزگذاری یک داغ نشان می دهید. اگر رمزگذاری یک داغ بزرگ باشد ، ممکن است یک لایه تعبیه شده را در بالای رمزگذاری یک داغ برای راندمان بیشتر قرار دهید.

نمایش پراکنده

ذخیره فقط موقعیت (های) عناصر nonzero در یک ویژگی پراکنده.

به عنوان مثال ، فرض کنید یک ویژگی طبقه بندی شده به نام species 36 گونه درخت را در یک جنگل خاص مشخص می کند. بیشتر فرض کنید که هر مثال فقط یک گونه واحد را مشخص می کند.

در هر مثال می توانید از یک بردار یک داغ استفاده کنید تا گونه های درخت را نشان دهد. یک بردار یک داغ حاوی 1 (برای نشان دادن گونه های خاص درخت در آن مثال) و 35 0 ثانیه (برای نشان دادن 35 گونه درختی که در آن مثال نیست ). بنابراین ، نمایش یک داغ maple ممکن است چیزی شبیه به موارد زیر باشد:

از طرف دیگر ، نمایندگی پراکنده به سادگی موقعیت گونه های خاص را مشخص می کند. اگر maple در موقعیت 24 قرار داشته باشد ، نمایش پراکنده maple به سادگی خواهد بود:

24

توجه کنید که نمایندگی پراکنده بسیار فشرده تر از نمایندگی یک داغ است.

برای اطلاعات بیشتر به کار با داده های طبقه بندی شده در دوره Crash Learning Machine مراجعه کنید.

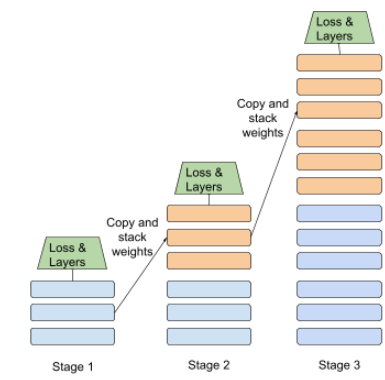

آموزش صحنه

تاکتیک آموزش یک مدل در دنباله ای از مراحل گسسته. هدف می تواند سرعت بخشیدن به روند آموزش یا دستیابی به کیفیت مدل بهتر باشد.

تصویری از رویکرد انباشت پیشرو در زیر نشان داده شده است:

- مرحله 1 شامل 3 لایه پنهان ، مرحله 2 شامل 6 لایه پنهان است و مرحله 3 حاوی 12 لایه پنهان است.

- مرحله 2 با وزنهای آموخته شده در 3 لایه پنهان مرحله 1 ، تمرین را آغاز می کند. مرحله 3 با وزنهای آموخته شده در 6 لایه پنهان مرحله 2 ، تمرین را آغاز می کند.

همچنین به لوله کشی مراجعه کنید.

زیر کلمه

در مدل های زبان ، نشانه ای که زیرزمینی از یک کلمه است ، که ممکن است کل کلمه باشد.

به عنوان مثال ، کلمه ای مانند "actionize" ممکن است در قطعات "مورد" (یک کلمه ریشه) و "ize" (پسوند) شکسته شود ، که هر یک از آنها توسط نشانه خاص خود نشان داده شده است. تقسیم کلمات غیر معمول در چنین قطعاتی ، به نام های زیر کلمات ، به مدل های زبان اجازه می دهد تا روی قسمت های تشکیل دهنده متداول تر این کلمه مانند پیشوندها و پسوندها کار کنند.

در مقابل ، کلمات متداول مانند "رفتن" ممکن است شکسته نشود و ممکن است توسط یک نشانه واحد نشان داده شود.

تی

T5

یک مدل یادگیری انتقال متن به متن که توسط Google AI در سال 2020 معرفی شده است. T5 یک مدل رمزگذار - رمزگشایی است که بر اساس معماری ترانسفورماتور ، که بر روی یک مجموعه داده بسیار بزرگ آموزش دیده است. در انواع کارهای پردازش زبان طبیعی مانند تولید متن ، ترجمه زبان و پاسخ دادن به سؤالات به صورت مکالمه مؤثر است.

T5 نام خود را از پنج T در "ترانسفورماتور انتقال متن به متن" دریافت می کند.

T5X

یک چارچوب یادگیری با منبع باز ، برای ساخت و آموزش مدلهای پردازش زبان طبیعی در مقیاس بزرگ (NLP) طراحی شده است. T5 بر روی کد T5X (که بر روی JAX و کتان ساخته شده است) پیاده سازی می شود.

دما

هیپرپارامتر که میزان تصادفی بودن خروجی یک مدل را کنترل می کند. درجه حرارت بالاتر منجر به خروجی تصادفی تر می شود ، در حالی که دمای پایین تر منجر به خروجی تصادفی کمتری می شود.

انتخاب بهترین دما به کاربرد خاص و خصوصیات ارجح خروجی مدل بستگی دارد. به عنوان مثال ، شما احتمالاً هنگام ایجاد برنامه ای که تولید خلاق را ایجاد می کند ، دما را بالا می برید. برعکس ، شما احتمالاً هنگام ساختن مدلی که تصاویر یا متن را طبقه بندی می کند ، دما را پایین می آورید تا دقت و قوام مدل را بهبود بخشید.

درجه حرارت اغلب با SoftMax استفاده می شود.

طول متن

دهانه شاخص آرایه مرتبط با یک بخش خاص از یک رشته متن. به عنوان مثال ، کلمه good در رشته Python s="Be good now" دهانه متن را از 3 تا 6 اشغال می کند.

نشانه

در یک مدل زبان ، واحد اتمی که مدل در حال آموزش است و پیش بینی می کند. یک نشانه به طور معمول یکی از موارد زیر است:

- یک کلمه - برای مثال ، عبارت "سگ ها مانند گربه ها" از سه نشانه کلمه تشکیل شده است: "سگ" ، "مانند" و "گربه".

- یک شخصیت - به عنوان مثال ، عبارت "ماهی دوچرخه" از نه نشانه شخصیت تشکیل شده است. (توجه داشته باشید که فضای خالی یکی از نشانه ها است.)

- زیرزمین ها - که در آن یک کلمه واحد می تواند یک نشانه واحد یا چند نشانه باشد. یک زیرزمین از یک کلمه ریشه ، پیشوند یا پسوند تشکیل شده است. به عنوان مثال ، یک مدل زبانی که از کلمات زیرزمینی به عنوان نشانه ها استفاده می کند ، ممکن است کلمه "سگ" را به عنوان دو نشانه مشاهده کند (کلمه ریشه "سگ" و پسوند جمع "S"). همین مدل زبان ممکن است کلمه تک "بلندتر" را به عنوان دو زیر کلمه (کلمه ریشه "بلند" و پسوند "er") مشاهده کند.

در حوزه های خارج از مدل های زبان ، نشانه ها می توانند انواع دیگر واحدهای اتمی را نشان دهند. به عنوان مثال ، در Vision Computer ، یک نشانه ممکن است زیر مجموعه یک تصویر باشد.

برای اطلاعات بیشتر به مدل های بزرگ زبان در دوره Crash Learning Machine مراجعه کنید.

دقت

درصد زمانهایی که "برچسب هدف" در اولین موقعیت K لیست های تولید شده ظاهر می شود. لیست ها می توانند توصیه های شخصی یا لیستی از موارد سفارش داده شده توسط SoftMax باشند.

دقت بالا K نیز به عنوان دقت در K شناخته می شود.

سمیت

The degree to which content is abusive, threatening, or offensive. Many machine learning models can identify and measure toxicity. Most of these models identify toxicity along multiple parameters, such as the level of abusive language and the level of threatening language.

ترانسفورماتور

A neural network architecture developed at Google that relies on self-attention mechanisms to transform a sequence of input embeddings into a sequence of output embeddings without relying on convolutions or recurrent neural networks . A Transformer can be viewed as a stack of self-attention layers.

A Transformer can include any of the following:

An encoder transforms a sequence of embeddings into a new sequence of the same length. An encoder includes N identical layers, each of which contains two sub-layers. These two sub-layers are applied at each position of the input embedding sequence, transforming each element of the sequence into a new embedding. The first encoder sub-layer aggregates information from across the input sequence. The second encoder sub-layer transforms the aggregated information into an output embedding.

A decoder transforms a sequence of input embeddings into a sequence of output embeddings, possibly with a different length. A decoder also includes N identical layers with three sub-layers, two of which are similar to the encoder sub-layers. The third decoder sub-layer takes the output of the encoder and applies the self-attention mechanism to gather information from it.

The blog post Transformer: A Novel Neural Network Architecture for Language Understanding provides a good introduction to Transformers.

See LLMs: What's a large language model? in Machine Learning Crash Course for more information.

سه گرام

An N-gram in which N=3.

U

unidirectional

A system that only evaluates the text that precedes a target section of text. In contrast, a bidirectional system evaluates both the text that precedes and follows a target section of text. See bidirectional for more details.

unidirectional language model

A language model that bases its probabilities only on the tokens appearing before , not after , the target token(s). Contrast with bidirectional language model .

V

variational autoencoder (VAE)

A type of autoencoder that leverages the discrepancy between inputs and outputs to generate modified versions of the inputs. Variational autoencoders are useful for generative AI .

VAEs are based on variational inference: a technique for estimating the parameters of a probability model.

دبلیو

جاسازی کلمه

Representing each word in a word set within an embedding vector ; that is, representing each word as a vector of floating-point values between 0.0 and 1.0. Words with similar meanings have more-similar representations than words with different meanings. For example, carrots , celery , and cucumbers would all have relatively similar representations, which would be very different from the representations of airplane , sunglasses , and toothpaste .

ز

zero-shot prompting

A prompt that does not provide an example of how you want the large language model to respond. به عنوان مثال:

| Parts of one prompt | یادداشت ها |

|---|---|

| What is the official currency of the specified country? | The question you want the LLM to answer. |

| هند: | The actual query. |

The large language model might respond with any of the following:

- روپیه

- INR

- ₹

- روپیه هند

- The rupee

- The Indian rupee

All of the answers are correct, though you might prefer a particular format.

Compare and contrast zero-shot prompting with the following terms: