इस शब्दावली में, आर्टिफ़िशियल इंटेलिजेंस से जुड़े शब्दों की परिभाषाएं दी गई हैं.

A

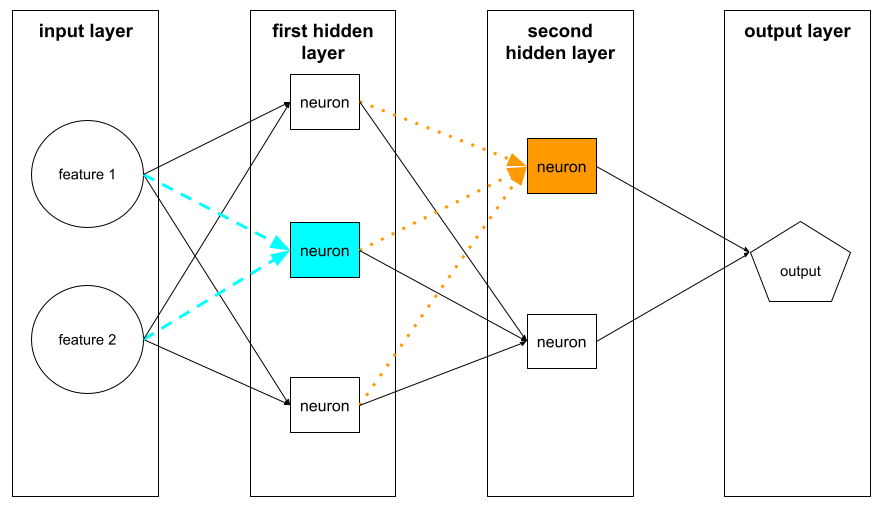

ऐब्लेशन

यह मॉडल से किसी फ़ीचर या कॉम्पोनेंट को कुछ समय के लिए हटाकर, उसकी अहमियत का आकलन करने का तरीका है. इसके बाद, उस सुविधा या कॉम्पोनेंट के बिना मॉडल को फिर से ट्रेन करें. अगर फिर से ट्रेन किया गया मॉडल पहले से काफ़ी खराब परफ़ॉर्म करता है, तो इसका मतलब है कि हटाई गई सुविधा या कॉम्पोनेंट ज़रूरी था.

उदाहरण के लिए, मान लें कि आपने 10 सुविधाओं के आधार पर क्लासिफ़िकेशन मॉडल को ट्रेन किया है. साथ ही, टेस्ट सेट पर 88% सटीकता हासिल की है. पहली सुविधा की अहमियत का पता लगाने के लिए, सिर्फ़ नौ अन्य सुविधाओं का इस्तेमाल करके मॉडल को फिर से ट्रेन किया जा सकता है. अगर फिर से ट्रेन किया गया मॉडल, पहले से काफ़ी खराब परफ़ॉर्म करता है (उदाहरण के लिए, 55% सटीक), तो इसका मतलब है कि हटाई गई सुविधा शायद ज़रूरी थी. इसके उलट, अगर फिर से ट्रेन किया गया मॉडल भी उतना ही अच्छा परफ़ॉर्म करता है, तो इसका मतलब है कि वह सुविधा शायद उतनी ज़रूरी नहीं थी.

एब्लेशन की मदद से, यह भी पता लगाया जा सकता है कि ये कितने ज़रूरी हैं:

- बड़े कॉम्पोनेंट, जैसे कि बड़े एमएल सिस्टम का पूरा सबसिस्टम

- प्रोसेस या तकनीकें, जैसे कि डेटा प्रीप्रोसेसिंग का चरण

दोनों ही मामलों में, आपको यह पता चलेगा कि कॉम्पोनेंट हटाने के बाद, सिस्टम की परफ़ॉर्मेंस में क्या बदलाव हुआ है या कोई बदलाव नहीं हुआ है.

A/B टेस्टिंग

यह आंकड़ों की मदद से, दो या उससे ज़्यादा तकनीकों की तुलना करने का तरीका है. जैसे, A और B. आम तौर पर, A एक मौजूदा तकनीक होती है और B एक नई तकनीक होती है. A/B टेस्टिंग से न सिर्फ़ यह पता चलता है कि कौनसी तकनीक बेहतर परफ़ॉर्म करती है, बल्कि यह भी पता चलता है कि क्या परफ़ॉर्मेंस में अंतर, आंकड़ों के हिसाब से अहम है.

A/B टेस्टिंग में आम तौर पर, दो तकनीकों के लिए एक मेट्रिक की तुलना की जाती है. उदाहरण के लिए, दो तकनीकों के लिए मॉडल की सटीकता की तुलना कैसे की जाती है? हालांकि, A/B टेस्टिंग में मेट्रिक की किसी भी सीमित संख्या की तुलना भी की जा सकती है.

ऐक्सलरेटर चिप

यह खास हार्डवेयर कॉम्पोनेंट की एक कैटगरी है. इसे डीप लर्निंग एल्गोरिदम के लिए ज़रूरी मुख्य कंप्यूटेशन करने के लिए डिज़ाइन किया गया है.

ऐक्सलरेटर चिप (या सिर्फ़ ऐक्सलरेटर) की मदद से, ट्रेनिंग और अनुमान लगाने के टास्क की स्पीड और क्षमता को सामान्य सीपीयू की तुलना में काफ़ी हद तक बढ़ाया जा सकता है. ये न्यूरल नेटवर्क को ट्रेनिंग देने और कंप्यूटेशनल इंटेंसिव टास्क के लिए सबसे सही हैं.

ऐक्सलरेटर चिप के उदाहरणों में ये शामिल हैं:

- डीप लर्निंग के लिए, Google की टेंसर प्रोसेसिंग यूनिट (TPU) के साथ-साथ खास हार्डवेयर.

- NVIDIA के जीपीयू. इन्हें शुरुआत में ग्राफ़िक्स प्रोसेसिंग के लिए डिज़ाइन किया गया था. हालांकि, अब इन्हें पैरलल प्रोसेसिंग के लिए डिज़ाइन किया गया है. इससे प्रोसेसिंग की स्पीड काफ़ी बढ़ सकती है.

सटीक

सही क्लासिफ़िकेशन अनुमानों की संख्या को अनुमानों की कुल संख्या से भाग देने पर यह स्कोर मिलता है. यानी:

उदाहरण के लिए, अगर किसी मॉडल ने 40 अनुमान सही लगाए और 10 अनुमान गलत लगाए, तो उसकी सटीकता इस तरह से कैलकुलेट की जाएगी:

बाइनरी क्लासिफ़िकेशन में, सही अनुमानों और गलत अनुमानों की अलग-अलग कैटगरी के लिए खास नाम दिए गए हैं. इसलिए, बाइनरी क्लासिफ़िकेशन के लिए सटीक नतीजे का फ़ॉर्मूला यह है:

कहां:

- टीपी, ट्रू पॉज़िटिव (सही अनुमान) की संख्या है.

- TN, ट्रू नेगेटिव (सही अनुमान) की संख्या है.

- एफ़पी, फ़ॉल्स पॉज़िटिव (गलत अनुमान) की संख्या होती है.

- FN, फ़ॉल्स निगेटिव (गलत अनुमान) की संख्या है.

प्रिसिज़न और रीकॉल के साथ, सटीकता की तुलना करें और इनके बीच अंतर बताएं.

ज़्यादा जानकारी के लिए, मशीन लर्निंग क्रैश कोर्स में क्लासिफ़िकेशन: सटीकता, रीकॉल, प्रेसिज़न, और इनसे जुड़ी मेट्रिक देखें.

ऐक्शन गेम

रीइन्फ़ोर्समेंट लर्निंग में, एजेंट के एनवायरमेंट की स्टेट के बीच ट्रांज़िशन करने का तरीका. एजेंट, नीति का इस्तेमाल करके कार्रवाई चुनता है.

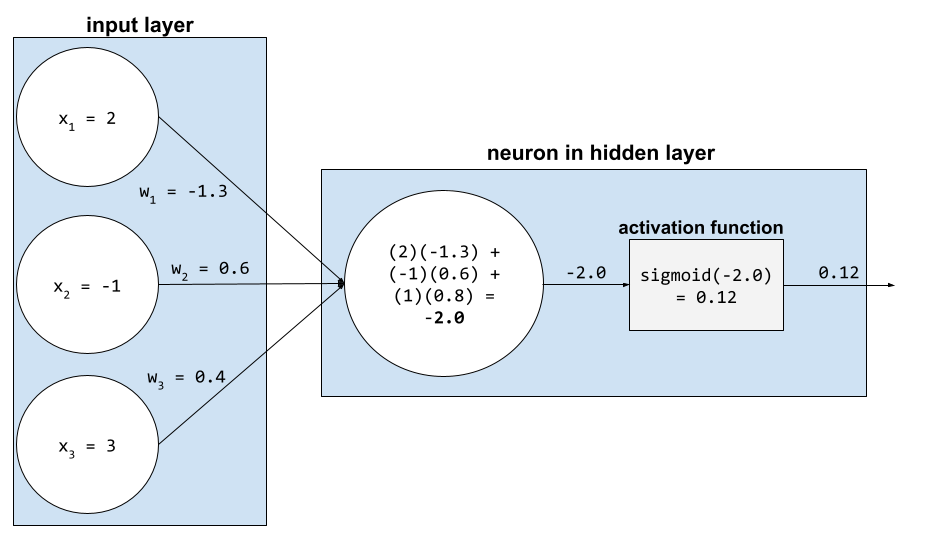

ऐक्टिवेशन फ़ंक्शन

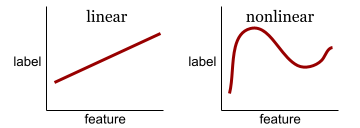

यह एक ऐसा फ़ंक्शन है जो न्यूरल नेटवर्क को सुविधाओं और लेबल के बीच नॉनलीनियर (जटिल) संबंधों को समझने में मदद करता है.

लोकप्रिय ऐक्टिवेशन फ़ंक्शन में ये शामिल हैं:

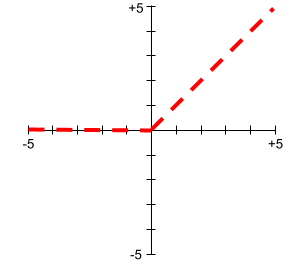

ऐक्टिवेशन फ़ंक्शन के प्लॉट कभी भी सीधी लाइनें नहीं होते. उदाहरण के लिए, ReLU ऐक्टिवेशन फ़ंक्शन के प्लॉट में दो सीधी लाइनें होती हैं:

सिगमॉइड ऐक्टिवेशन फ़ंक्शन का प्लॉट ऐसा दिखता है:

ज़्यादा जानकारी के लिए, मशीन लर्निंग क्रैश कोर्स में न्यूरल नेटवर्क: ऐक्टिवेशन फ़ंक्शन देखें.

ऐक्टिव लर्निंग

ट्रेनिंग का ऐसा तरीका जिसमें एल्गोरिदम, सीखने के लिए कुछ डेटा चुनता है. एक्टिव लर्निंग, खास तौर पर तब फ़ायदेमंद होती है, जब लेबल किए गए उदाहरण कम हों या उन्हें पाना महंगा हो. ऐक्टिव लर्निंग एल्गोरिदम, लेबल किए गए अलग-अलग उदाहरणों को खोजने के बजाय, सिर्फ़ उन उदाहरणों को खोजता है जिनकी उसे सीखने के लिए ज़रूरत होती है.

AdaGrad

यह एक बेहतर ग्रेडिएंट डिसेंट एल्गोरिदम है. यह हर पैरामीटर के ग्रेडिएंट को फिर से स्केल करता है. इससे हर पैरामीटर को एक अलग लर्निंग रेट मिलता है. पूरी जानकारी के लिए, Adaptive Subgradient Methods for Online Learning and Stochastic Optimization देखें.

अडैप्टेशन

ट्यूनिंग या फ़ाइन-ट्यूनिंग के लिए इस्तेमाल किया जाने वाला दूसरा शब्द.

एजेंट

ऐसा सॉफ़्टवेयर जो मल्टीमॉडल इनपुट के आधार पर, उपयोगकर्ता की ओर से कार्रवाइयां करने के लिए प्लान बना सकता है और उन्हें लागू कर सकता है.

रीइन्फ़ोर्समेंट लर्निंग में, एजेंट वह इकाई होती है जो नीति का इस्तेमाल करके, एनवायरमेंट की स्टेट के बीच ट्रांज़िशन से मिलने वाले अनुमानित फ़ायदे को ज़्यादा से ज़्यादा करती है.

एजेंटिक

agent का विशेषण रूप. एजेंटिक का मतलब उन क्वालिटी से है जो एजेंटों में होती हैं. जैसे, स्वायत्तता.

एजेंटिक वर्कफ़्लो

यह एक डाइनैमिक प्रोसेस है. इसमें एजेंट, किसी लक्ष्य को हासिल करने के लिए अपने-आप प्लान बनाता है और कार्रवाइयां करता है. इस प्रोसेस में, वजह बताना, बाहरी टूल इस्तेमाल करना, और अपने प्लान को खुद ठीक करना शामिल हो सकता है.

एगलोमेरेटिव क्लस्टरिंग

हैरारिकल क्लस्टरिंग देखें.

एआई स्लोप

जनरेटिव एआई सिस्टम से मिला ऐसा जवाब जिसमें क्वालिटी के बजाय क्वांटिटी पर ज़्यादा ध्यान दिया गया हो. उदाहरण के लिए, एआई स्लोप वाले वेब पेज पर, एआई से जनरेट किया गया और खराब क्वालिटी वाला कॉन्टेंट मौजूद होता है.

गड़बड़ी की पहचान करना

आउटलायर की पहचान करने की प्रोसेस. उदाहरण के लिए, अगर किसी सुविधा के लिए औसत 100 है और स्टैंडर्ड डेविएशन 10 है, तो गड़बड़ी का पता लगाने वाली सुविधा को 200 की वैल्यू को संदिग्ध के तौर पर फ़्लैग करना चाहिए.

AR

ऑगमेंटेड रिएलिटी का संक्षिप्त नाम.

पीआर कर्व के नीचे का एरिया

पीआर एयूसी (पीआर कर्व के नीचे का हिस्सा) देखें.

आरओसी कर्व के नीचे का क्षेत्र

एयूसी (आरओसी कर्व के नीचे का हिस्सा) देखें.

आर्टिफ़िशियल जनरल इंटेलिजेंस

यह एक ऐसा सिस्टम है जो इंसानों की तरह काम करता है. इसमें समस्याओं को अलग-अलग तरीकों से हल करने, क्रिएटिविटी दिखाने, और अडैप्ट करने की क्षमता होती है. उदाहरण के लिए, आर्टिफ़िशियल जनरल इंटेलिजेंस (एजीआई) वाला कोई प्रोग्राम, टेक्स्ट का अनुवाद कर सकता है, सिम्फ़नी बना सकता है, और ऐसे गेम में महारत हासिल कर सकता है जो अब तक बनाए नहीं गए हैं.

आर्टिफ़िशियल इंटेलिजेंस

ऐसा प्रोग्राम या मॉडल जो इंसानों की तरह काम करता है और मुश्किल टास्क को हल कर सकता है. उदाहरण के लिए, टेक्स्ट का अनुवाद करने वाला प्रोग्राम या मॉडल या रेडियोलॉजिकल इमेज से बीमारियों का पता लगाने वाला प्रोग्राम या मॉडल, दोनों में आर्टिफ़िशियल इंटेलिजेंस का इस्तेमाल किया जाता है.

आधिकारिक तौर पर, मशीन लर्निंग, आर्टिफ़िशियल इंटेलिजेंस का एक उप-क्षेत्र है. हालांकि, हाल के वर्षों में कुछ संगठन, आर्टिफ़िशियल इंटेलिजेंस और मशीन लर्निंग शब्दों का इस्तेमाल एक-दूसरे की जगह कर रहे हैं.

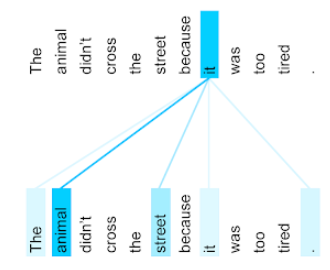

ध्यान देना

यह न्यूरल नेटवर्क में इस्तेमाल होने वाला एक ऐसा तरीका है जो किसी शब्द या शब्द के हिस्से की अहमियत के बारे में बताता है. अटेंशन, मॉडल को अगले टोकन/शब्द का अनुमान लगाने के लिए ज़रूरी जानकारी को छोटा कर देता है. आम तौर पर, अटेंशन मैकेनिज़्म में इनपुट के सेट पर वेटेड सम शामिल होता है. इसमें हर इनपुट के लिए वज़न की गिनती, न्यूरल नेटवर्क के किसी दूसरे हिस्से से की जाती है.

सेल्फ़-अटेंशन और मल्टी-हेड सेल्फ़-अटेंशन के बारे में भी जानें. ये ट्रांसफ़ॉर्मर के बुनियादी ब्लॉक हैं.

सेल्फ़-अटेंशन के बारे में ज़्यादा जानने के लिए, मशीन लर्निंग क्रैश कोर्स में एलएलएम: लार्ज लैंग्वेज मॉडल क्या होता है? देखें.

एट्रिब्यूट

feature के लिए समानार्थी शब्द.

मशीन लर्निंग में निष्पक्षता के लिए, एट्रिब्यूट का मतलब अक्सर लोगों की विशेषताओं से होता है.

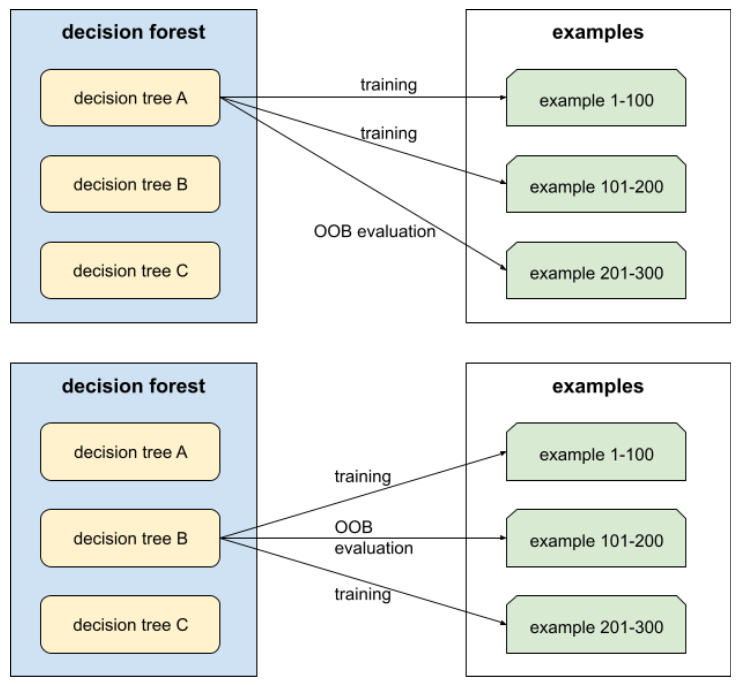

एट्रिब्यूट सैंपलिंग

यह डिसिज़न फ़ॉरेस्ट को ट्रेन करने की एक रणनीति है. इसमें हर डिसिज़न ट्री, शर्त के बारे में सीखते समय, संभावित सुविधाओं के सिर्फ़ एक रैंडम सबसेट पर विचार करता है. आम तौर पर, हर नोड के लिए, सुविधाओं का अलग सबसेट सैंपल किया जाता है. इसके उलट, एट्रिब्यूट सैंपलिंग के बिना किसी फ़ैसले वाले ट्री को ट्रेन करते समय, हर नोड के लिए सभी संभावित सुविधाओं पर विचार किया जाता है.

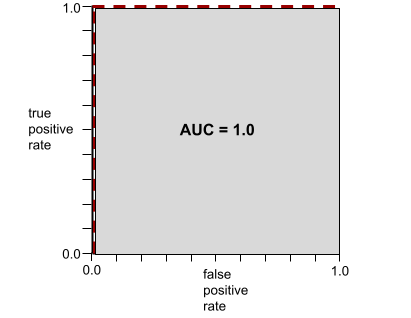

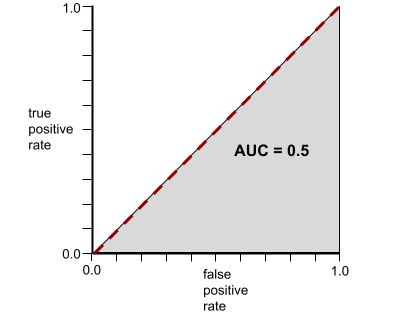

AUC (आरओसी कर्व के नीचे का हिस्सा)

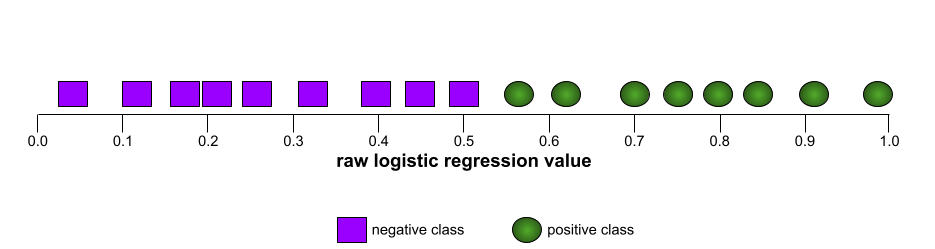

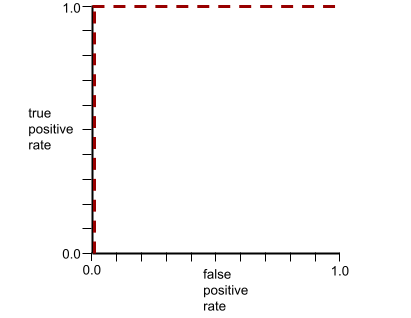

यह 0.0 से 1.0 के बीच की एक संख्या होती है. यह बाइनरी क्लासिफ़िकेशन मॉडल की, पॉज़िटिव क्लास को नेगेटिव क्लास से अलग करने की क्षमता को दिखाती है. एयूसी की वैल्यू 1.0 के जितनी ज़्यादा करीब होगी, मॉडल की परफ़ॉर्मेंस उतनी ही बेहतर होगी.

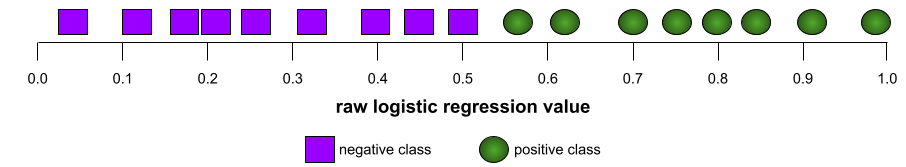

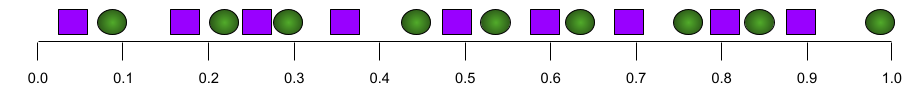

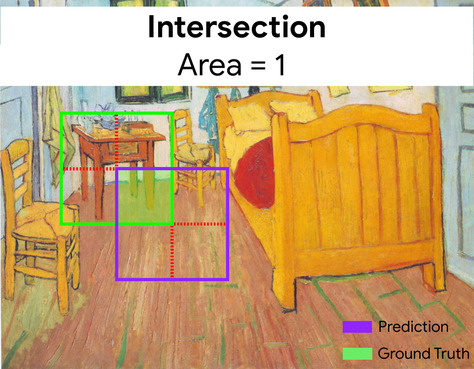

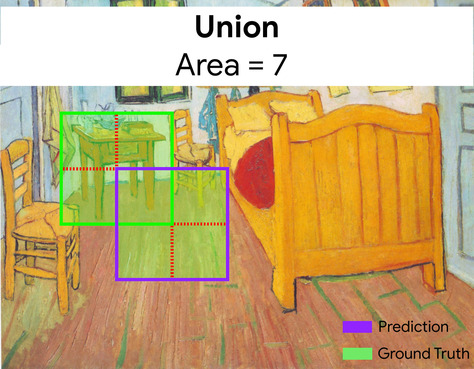

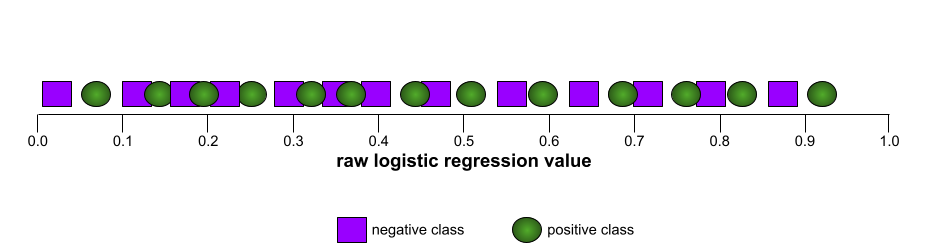

उदाहरण के लिए, इस इमेज में एक वर्गीकरण मॉडल दिखाया गया है. यह पॉज़िटिव क्लास (हरे रंग के ओवल) को नेगेटिव क्लास (बैंगनी रंग के आयत) से पूरी तरह अलग करता है. इस मॉडल का एयूसी 1.0 है, जो कि काफ़ी अच्छा है:

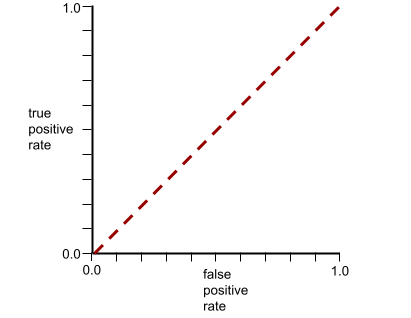

इसके उलट, यहां दिए गए उदाहरण में, क्लासिफ़िकेशन मॉडल के नतीजे दिखाए गए हैं. इस मॉडल ने रैंडम नतीजे जनरेट किए हैं. इस मॉडल का एयूसी 0.5 है:

हां, पिछले मॉडल का एयूसी 0.5 है, न कि 0.0.

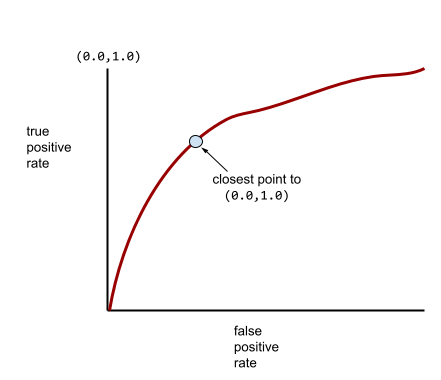

ज़्यादातर मॉडल, इन दोनों के बीच में कहीं होते हैं. उदाहरण के लिए, यहां दिया गया मॉडल, पॉज़िटिव और नेगेटिव वैल्यू को कुछ हद तक अलग करता है. इसलिए, इसका एयूसी 0.5 और 1.0 के बीच है:

एयूसी, क्लासिफ़िकेशन थ्रेशोल्ड के लिए सेट की गई किसी भी वैल्यू को अनदेखा करता है. इसके बजाय, एयूसी, क्लासिफ़िकेशन के सभी संभावित थ्रेशोल्ड पर विचार करता है.

ज़्यादा जानकारी के लिए, मशीन लर्निंग क्रैश कोर्स में क्लासिफ़िकेशन: आरओसी और एयूसी देखें.

संवर्धित वास्तविकता

यह एक ऐसी टेक्नोलॉजी है जो कंप्यूटर से जनरेट की गई इमेज को, उपयोगकर्ता को दिखने वाली असली दुनिया के ऊपर दिखाती है. इस तरह, यह कंपोज़िट व्यू उपलब्ध कराती है.

ऑटोएन्कोडर

यह एक ऐसा सिस्टम है जो इनपुट से सबसे ज़रूरी जानकारी निकालने के बारे में सीखता है. ऑटोएन्कोडर, एन्कोडर और डिकोडर का कॉम्बिनेशन होते हैं. ऑटोएनकोडर, दो चरणों वाली इस प्रोसेस पर काम करते हैं:

- एनकोडर, इनपुट को (आम तौर पर) लॉसलेस लोअर-डाइमेंशनल (इंटरमीडिएट) फ़ॉर्मैट में मैप करता है.

- डीकोडर, कम डाइमेंशन वाले फ़ॉर्मैट को ज़्यादा डाइमेंशन वाले ओरिजनल इनपुट फ़ॉर्मैट में मैप करके, ओरिजनल इनपुट की लॉस वाली वर्शन बनाता है.

ऑटोएनकोडर को शुरू से आखिर तक ट्रेन किया जाता है. इसमें डिकोडर, एनकोडर के इंटरमीडिएट फ़ॉर्मैट से ओरिजनल इनपुट को फिर से बनाने की कोशिश करता है. इंटरमीडिएट फ़ॉर्मैट, ओरिजनल फ़ॉर्मैट से छोटा (कम डाइमेंशन वाला) होता है. इसलिए, ऑटोएन्कोडर को यह सीखना पड़ता है कि इनपुट में कौनसी जानकारी ज़रूरी है. साथ ही, आउटपुट, इनपुट से पूरी तरह मेल नहीं खाएगा.

उदाहरण के लिए:

- अगर इनपुट डेटा कोई ग्राफ़िक है, तो पूरी तरह से मेल न खाने वाली कॉपी, ओरिजनल ग्राफ़िक से मिलती-जुलती होगी. हालांकि, इसमें कुछ बदलाव किए गए होंगे. ऐसा हो सकता है कि ओरिजनल ग्राफ़िक की हूबहू कॉपी न होने की वजह से, उसमें मौजूद नॉइज़ हट गया हो या कुछ छूटे हुए पिक्सल भर गए हों.

- अगर इनपुट डेटा टेक्स्ट है, तो ऑटोएनकोडर एक नया टेक्स्ट जनरेट करेगा. यह टेक्स्ट, ओरिजनल टेक्स्ट की तरह होगा, लेकिन उससे अलग होगा.

वेरिएशनल ऑटोएनकोडर के बारे में भी जानें.

अपने-आप होने वाला आकलन

सॉफ़्टवेयर का इस्तेमाल करके, मॉडल के आउटपुट की क्वालिटी का आकलन करना.

जब मॉडल का आउटपुट काफ़ी आसान हो, तब कोई स्क्रिप्ट या प्रोग्राम, मॉडल के आउटपुट की तुलना गोल्डन रिस्पॉन्स से कर सकता है. इस तरह के अपने-आप होने वाले आकलन को कभी-कभी प्रोग्रामैटिक आकलन कहा जाता है. ROUGE या BLEU जैसी मेट्रिक, प्रोग्राम के हिसाब से आकलन करने के लिए अक्सर काम की होती हैं.

जब मॉडल का आउटपुट मुश्किल होता है या कोई एक सही जवाब नहीं होता, तो कभी-कभी ऑटोरेटर नाम का एक अलग एमएल प्रोग्राम, अपने-आप आकलन करता है.

इसकी तुलना मानवीय आकलन से करें.

ऑटोमेशन बायस

जब फ़ैसला लेने वाला कोई व्यक्ति, ऑटोमेटेड फ़ैसले लेने वाले सिस्टम की ओर से दिए गए सुझावों को, बिना ऑटोमेशन के तैयार की गई जानकारी के मुकाबले ज़्यादा अहमियत देता है. ऐसा तब भी होता है, जब ऑटोमेटेड फ़ैसले लेने वाला सिस्टम गलतियां करता है.

ज़्यादा जानकारी के लिए, मशीन लर्निंग क्रैश कोर्स में निष्पक्षता: पूर्वाग्रह के टाइप देखें.

AutoML

मशीन लर्निंग मॉडल बनाने की कोई भी ऑटोमेटेड प्रोसेस. AutoML, अपने-आप ये टास्क कर सकता है:

- सबसे सही मॉडल खोजें.

- हाइपरपैरामीटर को ट्यून करें.

- डेटा तैयार करना. इसमें फ़ीचर इंजीनियरिंग करना भी शामिल है.

- इसके बाद, मॉडल को डिप्लॉय करें.

AutoML, डेटा वैज्ञानिकों के लिए फ़ायदेमंद है. इसकी मदद से, वे मशीन लर्निंग पाइपलाइन को कम समय और मेहनत में डेवलप कर सकते हैं. साथ ही, अनुमान लगाने की सटीकता को बेहतर बना सकते हैं. यह उन लोगों के लिए भी फ़ायदेमंद है जो मशीन लर्निंग के विशेषज्ञ नहीं हैं. यह मशीन लर्निंग के मुश्किल कामों को उनके लिए आसान बना देता है.

ज़्यादा जानकारी के लिए, मशीन लर्निंग क्रैश कोर्स में ऑटोमेटेड मशीन लर्निंग (AutoML) देखें.

ऑटोरेटर की परफ़ॉर्मेंस का आकलन

यह जनरेटिव एआई मॉडल के आउटपुट की क्वालिटी का आकलन करने का एक हाइब्रिड तरीका है. इसमें मैन्युअल तरीके से आकलन और ऑटोमैटिक तरीके से आकलन, दोनों शामिल होते हैं. ऑटोरेटर, एक एमएल मॉडल है. इसे मैन्युअल तरीके से किए गए आकलन से बनाए गए डेटा पर ट्रेन किया जाता है. आदर्श रूप से, ऑटोमेटेड रेटिंग देने वाला सिस्टम, मैन्युअल तरीके से रेटिंग देने वाले व्यक्ति की तरह काम करता है.पहले से तैयार किए गए ऑटोरेटर उपलब्ध हैं. हालांकि, सबसे अच्छे ऑटोरेटर को खास तौर पर उस टास्क के लिए फ़ाइन-ट्यून किया जाता है जिसका आकलन किया जा रहा है.

ऑटो-रिग्रेसिव मॉडल

ऐसा मॉडल जो अपने पिछले अनुमानों के आधार पर अनुमान लगाता है. उदाहरण के लिए, ऑटो-रिग्रेसिव भाषा मॉडल, पहले से अनुमानित किए गए टोकन के आधार पर अगले टोकन का अनुमान लगाते हैं. ट्रांसफ़ॉर्मर पर आधारित सभी लार्ज लैंग्वेज मॉडल, ऑटो-रिग्रेसिव होते हैं.

इसके उलट, GAN पर आधारित इमेज मॉडल आम तौर पर ऑटो-रिग्रेसिव नहीं होते. ऐसा इसलिए, क्योंकि वे एक ही फ़ॉरवर्ड-पास में इमेज जनरेट करते हैं, न कि चरणों में बार-बार. हालांकि, कुछ इमेज जनरेट करने वाले मॉडल ऑटो-रिग्रेसिव होते हैं, क्योंकि वे इमेज को चरणों में जनरेट करते हैं.

सहायक नुकसान

लॉस फ़ंक्शन—इसका इस्तेमाल न्यूरल नेटवर्क मॉडल के मुख्य लॉस फ़ंक्शन के साथ किया जाता है. इससे शुरुआती इटरेशन के दौरान, ट्रेनिंग की प्रोसेस को तेज़ करने में मदद मिलती है. ऐसा तब होता है, जब वेट को रैंडम तरीके से शुरू किया जाता है.

सहायक लॉस फ़ंक्शन, शुरुआती लेयर को असरदार ग्रेडिएंट देते हैं. यह वैनिशिंग ग्रेडिएंट की समस्या को कम करके, ट्रेनिंग के दौरान कन्वर्जेंस को बेहतर बनाता है.

k पर औसत प्रीसिज़न

यह एक ऐसी मेट्रिक है जो किसी एक प्रॉम्प्ट पर मॉडल की परफ़ॉर्मेंस की खास जानकारी देती है. यह मेट्रिक, रैंक किए गए नतीजे जनरेट करती है. जैसे, किताबों के सुझावों की नंबर वाली सूची. k पर औसत सटीक नतीजे, हर काम के नतीजे के लिए k पर सटीक नतीजे वैल्यू का औसत होता है. इसलिए, k पर औसत सटीक स्कोर का फ़ॉर्मूला यह है:

\[{\text{average precision at k}} = \frac{1}{n} \sum_{i=1}^n {\text{precision at k for each relevant item} } \]

कहां:

- \(n\) सूची में मौजूद काम के आइटम की संख्या है.

इसकी तुलना k पर वापस मंगाना से करें.

ऐक्सिस के साथ अलाइन होने की शर्त

डिसिज़न ट्री में, शर्त सिर्फ़ एक फ़ीचर से जुड़ी होती है. उदाहरण के लिए, अगर area

एक सुविधा है, तो ऐक्सिस के साथ अलाइन की गई शर्त यह है:

area > 200

तिरछी स्थिति के साथ कंट्रास्ट.

B

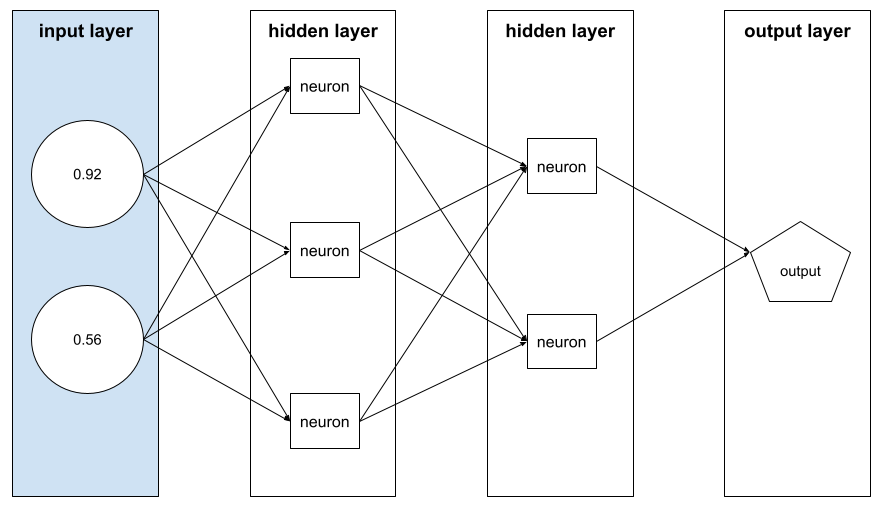

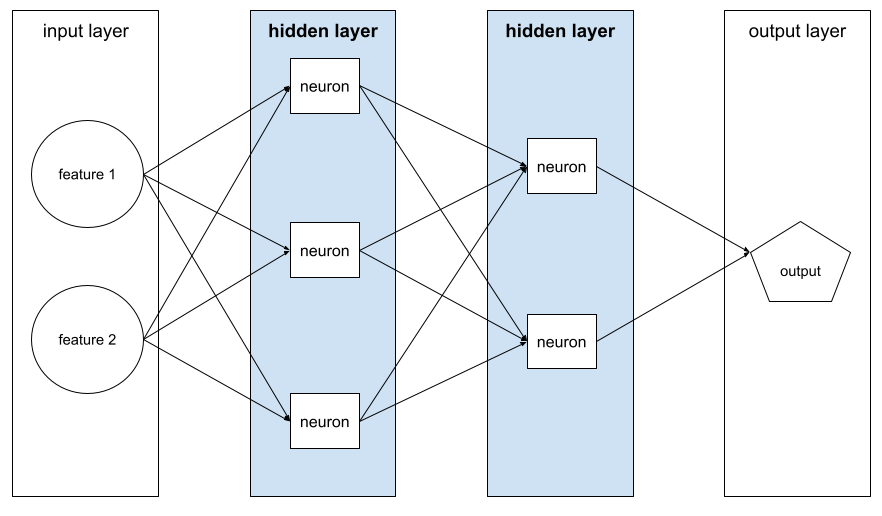

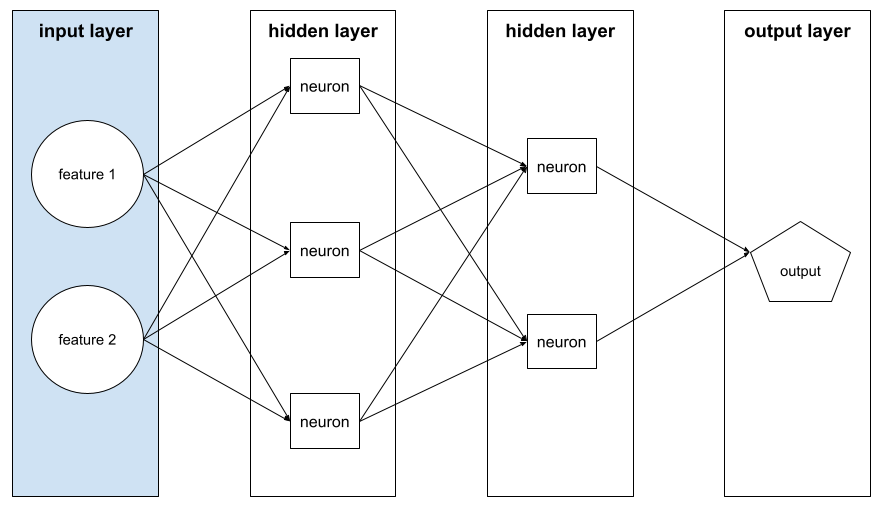

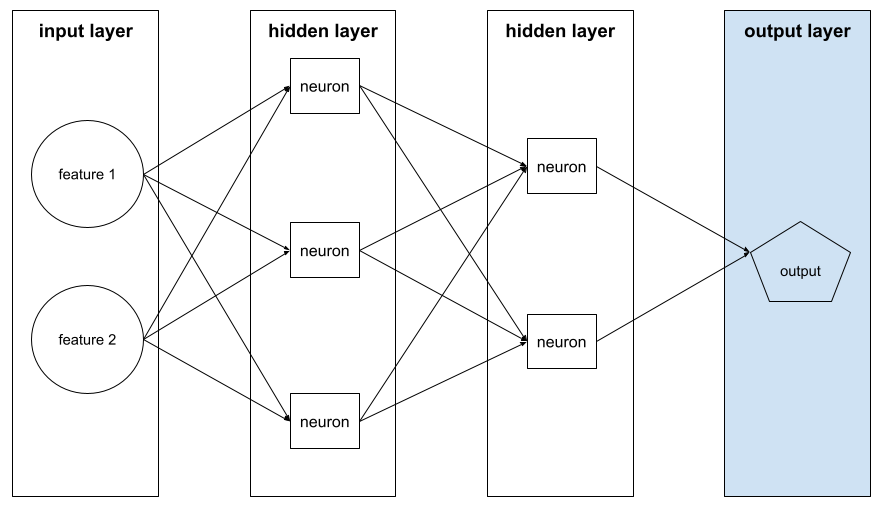

बैकप्रॉपैगेशन

यह एल्गोरिदम, न्यूरल नेटवर्क में ग्रेडिएंट डिसेंट को लागू करता है.

न्यूरल नेटवर्क को ट्रेन करने में, दो पास वाले साइकल के कई इटरेशन शामिल होते हैं. ये इटरेशन इस तरह से होते हैं:

- फ़ॉरवर्ड पास के दौरान, सिस्टम उदाहरणों के बैच को प्रोसेस करता है, ताकि अनुमान लगाया जा सके. सिस्टम, हर अनुमान की तुलना हर लेबल वैल्यू से करता है. अनुमानित वैल्यू और लेबल की वैल्यू के बीच के अंतर को उस उदाहरण के लिए लॉस कहा जाता है. सिस्टम, सभी उदाहरणों के लिए नुकसान को इकट्ठा करता है, ताकि मौजूदा बैच के लिए कुल नुकसान का हिसाब लगाया जा सके.

- बैकवर्ड पास (बैकप्रॉपैगेशन) के दौरान, सिस्टम सभी हिडन लेयर में मौजूद सभी न्यूरॉन के वेट को अडजस्ट करके, नुकसान को कम करता है.

न्यूरल नेटवर्क में, अक्सर कई हिडन लेयर में कई न्यूरॉन होते हैं. उनमें से हर न्यूरॉन, कुल नुकसान में अलग-अलग तरीके से योगदान देता है. बैकप्रॉपैगेशन से यह तय किया जाता है कि किसी न्यूरॉन पर लागू किए गए वेट को बढ़ाना है या घटाना है.

लर्निंग रेट एक मल्टीप्लायर होता है. यह कंट्रोल करता है कि हर बैकवर्ड पास, हर वेट को किस हद तक बढ़ाता या घटाता है. ज़्यादा लर्निंग रेट होने पर, हर वेट में बढ़ोतरी या गिरावट, कम लर्निंग रेट की तुलना में ज़्यादा होगी.

कैलकुलस के हिसाब से, बैकप्रॉपैगेशन में कैलकुलस का चेन रूल लागू होता है. इसका मतलब है कि बैकप्रॉपैगेशन, हर पैरामीटर के हिसाब से गड़बड़ी के आंशिक अवकलज का हिसाब लगाता है.

कुछ साल पहले, एमएल प्रैक्टिशनर को बैकप्रॉपैगेशन लागू करने के लिए कोड लिखना पड़ता था. Keras जैसे आधुनिक एमएल एपीआई, अब आपके लिए बैकप्रोपैगेशन लागू करते हैं. वाह!

ज़्यादा जानकारी के लिए, मशीन लर्निंग क्रैश कोर्स में न्यूरल नेटवर्क देखें.

बैगिंग

यह एन्सेम्बल को ट्रेन करने का एक तरीका है. इसमें हर मॉडल, ट्रेनिंग के उदाहरणों के रैंडम सबसेट पर ट्रेन होता है. इन उदाहरणों को रिप्लेसमेंट के साथ सैंपलिंग करके चुना जाता है. उदाहरण के लिए, रैंडम फ़ॉरेस्ट, बैगिंग की मदद से ट्रेन किए गए डिसिज़न ट्री का कलेक्शन होता है.

बैगिंग शब्द, बूटस्ट्रैप ऐग्रीगेटिंग का छोटा रूप है.

ज़्यादा जानकारी के लिए, फ़ैसले लेने में मदद करने वाले फ़ॉरेस्ट कोर्स में रैंडम फ़ॉरेस्ट देखें.

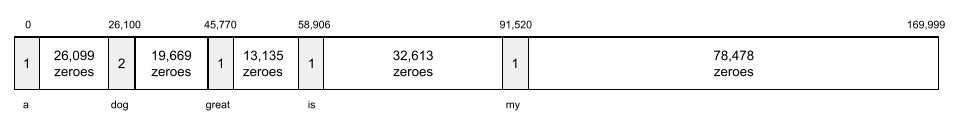

बैग ऑफ़ वर्ड्स

किसी वाक्यांश या पैसेज में मौजूद शब्दों को किसी भी क्रम में दिखाया गया हो. उदाहरण के लिए, शब्दों का बैग इन तीन वाक्यांशों को एक जैसा दिखाता है:

- कुत्ता कूदता है

- कुत्ते को कूदते हुए

- dog jumps the

हर शब्द को स्पार्स वेक्टर में मौजूद इंडेक्स पर मैप किया जाता है. इस वेक्टर में, शब्दावली के हर शब्द के लिए एक इंडेक्स होता है. उदाहरण के लिए, कुत्ता कूदता है वाक्यांश को एक ऐसे फ़ीचर वेक्टर में मैप किया जाता है जिसमें कुत्ता, कूदता, और है शब्दों से जुड़े तीन इंडेक्स पर शून्य से अलग वैल्यू होती हैं. शून्य से अलग वैल्यू इनमें से कोई भी हो सकती है:

- किसी शब्द के मौजूद होने की जानकारी देने के लिए 1.

- बैग में कोई शब्द कितनी बार दिखता है, इसकी संख्या. उदाहरण के लिए, अगर वाक्यांश मरून रंग का कुत्ता, मरून रंग के फ़र वाला कुत्ता है, तो मरून और कुत्ता, दोनों को 2 के तौर पर दिखाया जाएगा. वहीं, अन्य शब्दों को 1 के तौर पर दिखाया जाएगा.

- कोई अन्य वैल्यू, जैसे कि बैग में किसी शब्द के दिखने की संख्या का लॉगरिदम.

आधारभूत

मॉडल का इस्तेमाल, रेफ़रंस पॉइंट के तौर पर किया जाता है. इससे यह तुलना की जाती है कि कोई दूसरा मॉडल (आम तौर पर, ज़्यादा जटिल मॉडल) कैसा परफ़ॉर्म कर रहा है. उदाहरण के लिए, लॉजिस्टिक रिग्रेशन मॉडल, डीप मॉडल के लिए एक अच्छा बेसलाइन मॉडल हो सकता है.

किसी समस्या के लिए, बेसलाइन से मॉडल डेवलपर को यह तय करने में मदद मिलती है कि नए मॉडल को कम से कम कितनी परफ़ॉर्मेंस देनी चाहिए, ताकि वह उपयोगी हो सके.

बेस मॉडल

यह पहले से ट्रेन किया गया मॉडल है. इसका इस्तेमाल, फ़ाइन-ट्यूनिंग के लिए शुरुआती पॉइंट के तौर पर किया जा सकता है. इससे खास टास्क या ऐप्लिकेशन को पूरा किया जा सकता है.

प्री-ट्रेन मॉडल और फ़ाउंडेशन मॉडल के बारे में भी जानें.

बैच

एक ट्रेनिंग इटरेशन में इस्तेमाल किए गए उदाहरणों का सेट. बैच साइज़ से यह तय होता है कि किसी बैच में कितने उदाहरण होंगे.

बैच का युग से क्या संबंध है, यह जानने के लिए युग देखें.

ज़्यादा जानकारी के लिए, मशीन लर्निंग क्रैश कोर्स में लीनियर रिग्रेशन: हाइपरपैरामीटर देखें.

बैच इन्फ़रेंस

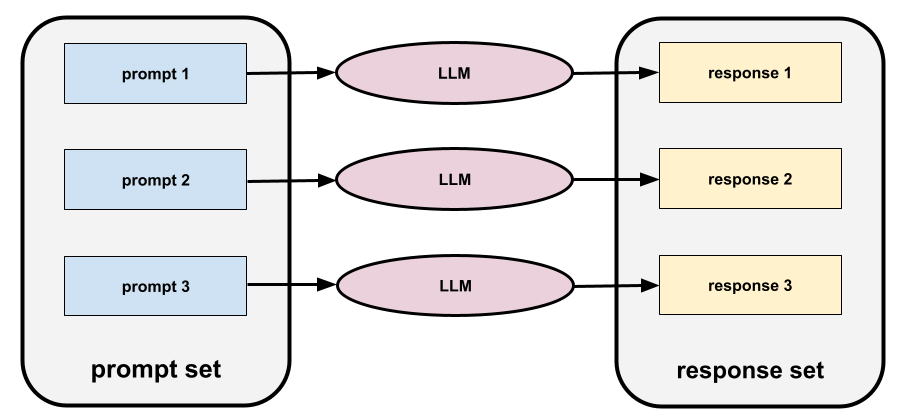

यह एक ऐसी प्रोसेस है जिसमें कई बिना लेबल वाले उदाहरणों के आधार पर अनुमान लगाया जाता है. इन उदाहरणों को छोटे-छोटे सबसेट ("बैच") में बांटा जाता है.

बैच इन्फ़रेंस, ऐक्सलरेटर चिप की पैरललाइज़ेशन सुविधाओं का फ़ायदा उठा सकता है. इसका मतलब है कि एक साथ कई ऐक्सलरेटर, बिना लेबल वाले उदाहरणों के अलग-अलग बैच के लिए अनुमान लगा सकते हैं. इससे हर सेकंड में अनुमानों की संख्या में काफ़ी बढ़ोतरी होती है.

ज़्यादा जानकारी के लिए, मशीन लर्निंग क्रैश कोर्स में प्रोडक्शन एमएल सिस्टम: स्टैटिक बनाम डाइनैमिक इन्फ़रेंस देखें.

बैच नॉर्मलाइज़ेशन

हिडन लेयर में ऐक्टिवेशन फ़ंक्शन के इनपुट या आउटपुट को नॉर्मलाइज़ करना. बैच नॉर्मलाइज़ेशन से ये फ़ायदे मिल सकते हैं:

- आउटलायर वेट से सुरक्षित रखकर, न्यूरल नेटवर्क को ज़्यादा स्टेबल बनाता है.

- इससे लर्निंग रेट बढ़ जाता है. इससे ट्रेनिंग की प्रोसेस तेज़ हो सकती है.

- ओवरफ़िटिंग को कम करें.

बैच का आकार

किसी बैच में उदाहरणों की संख्या. उदाहरण के लिए, अगर बैच का साइज़ 100 है, तो मॉडल हर इटरेशन में 100 उदाहरणों को प्रोसेस करता है.

बैच के साइज़ के लिए, यहां कुछ लोकप्रिय रणनीतियां दी गई हैं:

- स्टोकास्टिक ग्रेडिएंट डिसेंट (एसजीडी), जिसमें बैच का साइज़ 1 होता है.

- पूरा बैच, जिसमें बैच का साइज़ पूरे ट्रेनिंग सेट में मौजूद उदाहरणों की संख्या होती है. उदाहरण के लिए, अगर ट्रेनिंग सेट में 10 लाख उदाहरण शामिल हैं, तो बैच का साइज़ 10 लाख उदाहरणों का होगा. पूरे बैच को प्रोसेस करना, आम तौर पर एक असरदार रणनीति नहीं होती.

- मिनी-बैच, जिसमें बैच का साइज़ आम तौर पर 10 से 1,000 के बीच होता है. मिनी-बैच, आम तौर पर सबसे असरदार रणनीति होती है.

ज़्यादा जानकारी के लिए, यहां देखें:

- प्रोडक्शन एमएल सिस्टम: मशीन लर्निंग क्रैश कोर्स में स्टैटिक बनाम डाइनैमिक इन्फ़रेंस.

- डीप लर्निंग ट्यूनिंग प्लेबुक.

बेज़ियन न्यूरल नेटवर्क

यह एक संभाव्यता वाला न्यूरल नेटवर्क है. यह वज़न और आउटपुट में अनिश्चितता को ध्यान में रखता है. स्टैंडर्ड न्यूरल नेटवर्क रिग्रेशन मॉडल आम तौर पर, स्केलर वैल्यू का अनुमान लगाता है. उदाहरण के लिए, स्टैंडर्ड मॉडल से घर की कीमत 8,53,000 का अनुमान लगाया जाता है. इसके उलट, बेज़ियन न्यूरल नेटवर्क, वैल्यू के डिस्ट्रिब्यूशन का अनुमान लगाता है. उदाहरण के लिए, बेज़ियन मॉडल, घर की कीमत का अनुमान 8,53,000 रुपये लगाता है. इसका स्टैंडर्ड डेविएशन 67,200 रुपये है.

बेज़ियन न्यूरल नेटवर्क, वज़न और अनुमानों में अनिश्चितताओं का हिसाब लगाने के लिए, बेज़ थ्योरम पर निर्भर करता है. बेज़ियन न्यूरल नेटवर्क तब फ़ायदेमंद हो सकता है, जब अनिश्चितता को मेज़र करना ज़रूरी हो. जैसे, फ़ार्मास्यूटिकल्स से जुड़े मॉडल में. बायेसियन न्यूरल नेटवर्क, ओवरफ़िटिंग को रोकने में भी मदद कर सकते हैं.

बेज़ियन ऑप्टिमाइज़ेशन

संभाव्यता रिग्रेशन मॉडल, कंप्यूटेशनल तौर पर मुश्किल ऑब्जेक्टिव फ़ंक्शन को ऑप्टिमाइज़ करने की एक तकनीक है. इसमें, बेज़ियन लर्निंग तकनीक का इस्तेमाल करके अनिश्चितता को मापने वाले सरोगेट को ऑप्टिमाइज़ किया जाता है. बेज़ियन ऑप्टिमाइज़ेशन खुद ही बहुत महंगा होता है. इसलिए, इसका इस्तेमाल आम तौर पर उन टास्क को ऑप्टिमाइज़ करने के लिए किया जाता है जिनका आकलन करना महंगा होता है और जिनमें पैरामीटर की संख्या कम होती है. जैसे, हाइपरपैरामीटर चुनना.

बेलमैन इक्वेशन

रीइन्फ़ोर्समेंट लर्निंग में, ऑप्टिमल Q-फ़ंक्शन के लिए यह आइडेंटिटी पूरी होती है:

\[Q(s, a) = r(s, a) + \gamma \mathbb{E}_{s'|s,a} \max_{a'} Q(s', a')\]

रीइन्फ़ोर्समेंट लर्निंग एल्गोरिदम, इस आइडेंटिटी को लागू करते हैं. इससे अपडेट करने के इस नियम का इस्तेमाल करके, Q-लर्निंग बनाई जाती है:

\[Q(s,a) \gets Q(s,a) + \alpha \left[r(s,a) + \gamma \displaystyle\max_{\substack{a_1}} Q(s',a') - Q(s,a) \right] \]

रीइन्फ़ोर्समेंट लर्निंग के अलावा, बेलमैन समीकरण का इस्तेमाल डाइनैमिक प्रोग्रामिंग में भी किया जाता है. बेलमैन समीकरण के बारे में Wikipedia की जानकारी देखें.

BERT (बाईडायरेक्शनल एन्कोडर रिप्रज़ेंटेशन्स फ़्रॉम ट्रांसफ़ॉर्मर्स)

टेक्स्ट रिप्रेज़ेंटेशन के लिए मॉडल आर्किटेक्चर. ट्रेन किए गए BERT मॉडल का इस्तेमाल, टेक्स्ट क्लासिफ़िकेशन या एमएल से जुड़े अन्य कामों के लिए, बड़े मॉडल के हिस्से के तौर पर किया जा सकता है.

BERT की ये विशेषताएं हैं:

- यह Transformer आर्किटेक्चर का इस्तेमाल करता है. इसलिए, यह सेल्फ़-अटेंशन पर निर्भर करता है.

- यह Transformer के encoder हिस्से का इस्तेमाल करता है. एनकोडर का काम, टेक्स्ट को अच्छी तरह से समझना है. इसका काम, क्लासिफ़िकेशन जैसे किसी खास टास्क को पूरा करना नहीं है.

- दोतरफ़ा है.

- बिना निगरानी वाली ट्रेनिंग के लिए, मास्किंग का इस्तेमाल करता है.

BERT के वैरिएंट में ये शामिल हैं:

BERT के बारे में खास जानकारी पाने के लिए, Open Sourcing BERT: State-of-the-Art Pre-training for Natural Language Processing लेख पढ़ें.

पूर्वाग्रह (नीतिशास्त्र/निष्पक्षता)

1. किसी चीज़, व्यक्ति या ग्रुप को दूसरों से बेहतर बताना या उनके बारे में पूर्वाग्रह रखना. इन पूर्वाग्रहों से, डेटा को इकट्ठा करने और उसकी व्याख्या करने, सिस्टम के डिज़ाइन, और उपयोगकर्ताओं के सिस्टम से इंटरैक्ट करने के तरीके पर असर पड़ सकता है. इस तरह के पूर्वाग्रह के उदाहरणों में ये शामिल हैं:

- ऑटोमेशन बायस

- कंफ़र्मेशन बायस

- एक्सपेरिमेंटर का पूर्वाग्रह

- ग्रुप एट्रिब्यूशन बायस

- अनजाने में भेदभाव करना

- इन-ग्रुप बायस

- आउट-ग्रुप होमोजेनिटी बायस

2. सैंपलिंग या रिपोर्टिंग की प्रोसेस की वजह से हुई सिस्टमैटिक गड़बड़ी. इस तरह के पूर्वाग्रह के उदाहरणों में ये शामिल हैं:

- कवरेज से जुड़ा पूर्वाग्रह

- नॉन-रिस्पॉन्स बायस

- सर्वे में हिस्सा लेने से जुड़ा पूर्वाग्रह

- रिपोर्टिंग बायस

- सैंपलिंग बायस

- सैंपल चुनने में होने वाला पक्षपात

इसे मशीन लर्निंग मॉडल में मौजूद बायस टर्म या पूर्वानुमान में पक्षपात से भ्रमित न करें.

ज़्यादा जानकारी के लिए, मशीन लर्निंग क्रैश कोर्स में निष्पक्षता: पूर्वाग्रह के टाइप देखें.

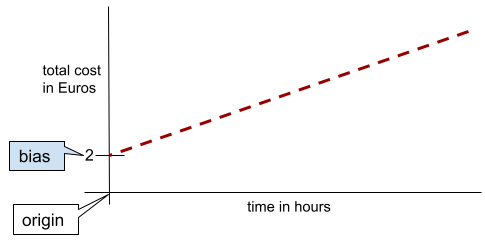

बायस (गणित) या बायस टर्म

किसी मूल बिंदु से इंटरसेप्ट या ऑफ़सेट. गड़बड़ी, मशीन लर्निंग मॉडल में एक पैरामीटर होता है. इसे इनमें से किसी भी तरीके से दिखाया जाता है:

- b

- w0

उदाहरण के लिए, इस फ़ॉर्मूले में b, बायस है:

आसान शब्दों में कहें, तो दो डाइमेंशन वाली लाइन में बायस का मतलब "y-इंटरसेप्ट" होता है. उदाहरण के लिए, इस इलस्ट्रेशन में लाइन का झुकाव 2 है.

बायस इसलिए मौजूद है, क्योंकि सभी मॉडल ओरिजिन (0,0) से शुरू नहीं होते. उदाहरण के लिए, मान लें कि किसी अम्यूज़मेंट पार्क में जाने का शुल्क 200 रुपये है.इसके अलावा, हर घंटे के लिए 50 रुपये का अतिरिक्त शुल्क लगता है. इसलिए, कुल लागत को मैप करने वाले मॉडल में 2 का पूर्वाग्रह होता है, क्योंकि सबसे कम लागत 2 यूरो है.

पूर्वाग्रह को नैतिकता और निष्पक्षता में पूर्वाग्रह या अनुमान में पूर्वाग्रह से भ्रमित नहीं होना चाहिए.

ज़्यादा जानकारी के लिए, मशीन लर्निंग क्रैश कोर्स में लीनियर रिग्रेशन देखें.

दोनों दिशाओं में काम करने वाला

इस शब्द का इस्तेमाल ऐसे सिस्टम के लिए किया जाता है जो टेक्स्ट के उस हिस्से का आकलन करता है जो टेक्स्ट के टारगेट सेक्शन से पहले और बाद में आता है. इसके उलट, यूनिडायरेक्शनल सिस्टम सिर्फ़ उस टेक्स्ट का आकलन करता है जो टेक्स्ट के टारगेट सेक्शन से पहले आता है.

उदाहरण के लिए, मास्क किए गए लैंग्वेज मॉडल पर विचार करें. इसे इस सवाल में अंडरलाइन किए गए शब्द या शब्दों की संभावनाओं का पता लगाना है:

आपको _____ क्या है?

एकतरफ़ा भाषा मॉडल को अपनी संभावनाओं को सिर्फ़ "What", "is", और "the" शब्दों से मिले कॉन्टेक्स्ट के आधार पर तय करना होगा. इसके उलट, दोनों दिशाओं में काम करने वाला भाषा मॉडल, "with" और "you" से भी कॉन्टेक्स्ट हासिल कर सकता है. इससे मॉडल को बेहतर अनुमान लगाने में मदद मिल सकती है.

दोनों भाषाओं में काम करने वाला लैंग्वेज मॉडल

यह एक लैंग्वेज मॉडल है. यह इस बात की संभावना का पता लगाता है कि किसी टेक्स्ट के चुने गए हिस्से में, कोई टोकन किसी जगह पर मौजूद है या नहीं. यह पहले और बाद के टेक्स्ट के आधार पर काम करता है.

bigram

यह एक N-ग्राम है, जिसमें N=2 है.

बाइनरी क्लासिफ़िकेशन

यह क्लासिफ़िकेशन टास्क का एक टाइप है. इसमें, दो में से किसी एक क्लास के बारे में अनुमान लगाया जाता है:

उदाहरण के लिए, यहां दिए गए दोनों मशीन लर्निंग मॉडल, बाइनरी क्लासिफ़िकेशन करते हैं:

- यह मॉडल यह तय करता है कि ईमेल मैसेज स्पैम (पॉज़िटिव क्लास) हैं या स्पैम नहीं हैं (नेगेटिव क्लास).

- एक ऐसा मॉडल जो चिकित्सा से जुड़े लक्षणों का आकलन करता है. इससे यह पता चलता है कि किसी व्यक्ति को कोई खास बीमारी (पॉज़िटिव क्लास) है या नहीं (नेगेटिव क्लास).

इसकी तुलना मल्टी-क्लास क्लासिफ़िकेशन से करें.

लॉजिस्टिक रिग्रेशन और क्लासिफ़िकेशन थ्रेशोल्ड भी देखें.

ज़्यादा जानकारी के लिए, मशीन लर्निंग क्रैश कोर्स में वर्गीकरण देखें.

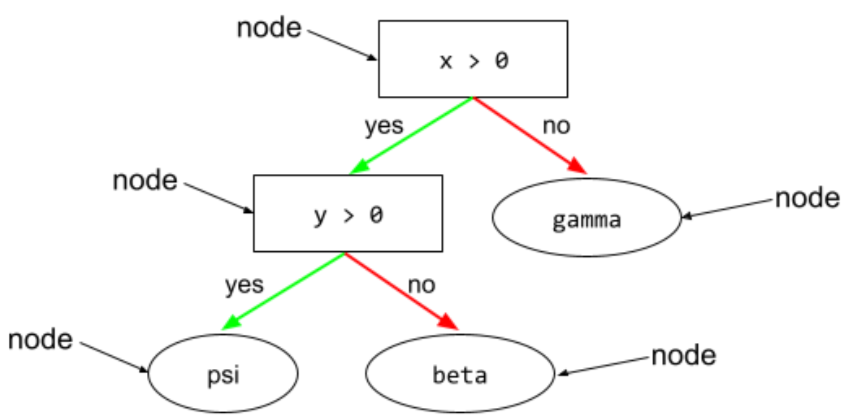

बाइनरी कंडीशन

डिसिज़न ट्री में, शर्त ऐसी होती है जिसके सिर्फ़ दो संभावित नतीजे होते हैं. आम तौर पर, हां या नहीं. उदाहरण के लिए, यहां दी गई शर्त बाइनरी शर्त है:

temperature >= 100

नॉन-बाइनरी स्थिति से अलग.

ज़्यादा जानकारी के लिए, Decision Forests कोर्स में शर्तों के टाइप देखें.

बिनिंग

बकेटिंग के लिए समानार्थी शब्द.

ब्लैक बॉक्स मॉडल

ऐसा मॉडल जिसकी "वजह" को इंसानों के लिए समझना मुश्किल हो या नामुमकिन हो. इसका मतलब है कि इंसान यह देख सकते हैं कि प्रॉम्प्ट से जवाबों पर क्या असर पड़ता है. हालांकि, इंसान यह नहीं जान सकते कि ब्लैक बॉक्स मॉडल, जवाब का फ़ैसला कैसे करता है. दूसरे शब्दों में कहें, तो ब्लैक बॉक्स मॉडल में व्याख्या करने की क्षमता नहीं होती.

ज़्यादातर डीप मॉडल और लार्ज लैंग्वेज मॉडल ब्लैक बॉक्स होते हैं.

ब्लू (बायलिंग्वल इवैल्युएशन अंडरस्टडी)

यह मेट्रिक, मशीन ट्रांसलेशन का आकलन करने के लिए 0.0 से 1.0 के बीच होती है. उदाहरण के लिए, स्पैनिश से जापानी में अनुवाद.

स्कोर का हिसाब लगाने के लिए, BLEU आम तौर पर एमएल मॉडल के अनुवाद (जनरेट किया गया टेक्स्ट) की तुलना, किसी विशेषज्ञ के अनुवाद (रेफ़रंस टेक्स्ट) से करता है. जनरेट किए गए टेक्स्ट और रेफ़रंस टेक्स्ट में N-ग्राम कितने मिलते-जुलते हैं, इससे BLEU स्कोर तय होता है.

इस मेट्रिक पर मूल पेपर BLEU: a Method for Automatic Evaluation of Machine Translation है.

BLEURT भी देखें.

BLEURT (ट्रांसफ़ॉर्मर से बाइलिंग्वल इवैलुएशन अंडरस्टडी)

यह एक मेट्रिक है. इसका इस्तेमाल, एक भाषा से दूसरी भाषा में किए गए मशीन ट्रांसलेशन का आकलन करने के लिए किया जाता है. खास तौर पर, अंग्रेज़ी से दूसरी भाषा में और दूसरी भाषा से अंग्रेज़ी में किए गए ट्रांसलेशन का आकलन करने के लिए.

अंग्रेज़ी से दूसरी भाषाओं में और दूसरी भाषाओं से अंग्रेज़ी में अनुवाद करने के लिए, BLEURT, BLEU की तुलना में, लोगों की रेटिंग के ज़्यादा करीब होता है. BLEU के उलट, BLEURT में सिमैंटिक (मतलब) समानता पर ज़ोर दिया जाता है. साथ ही, इसमें पैराफ़्रेज़िंग को शामिल किया जा सकता है.

BLEURT, पहले से ट्रेन किए गए लार्ज लैंग्वेज मॉडल (BERT) पर आधारित है. इसके बाद, इसे इंसानों की ओर से किए गए अनुवाद के टेक्स्ट के आधार पर फ़ाइन-ट्यून किया जाता है.

इस मेट्रिक पर मूल पेपर, BLEURT: Learning Robust Metrics for Text Generation है.

बूलियन सवाल (BoolQ)

एलएलएम के 'हां' या 'नहीं' में जवाब देने की क्षमता का आकलन करने के लिए डेटासेट. डेटासेट में मौजूद हर चुनौती के तीन कॉम्पोनेंट होते हैं:

- क्वेरी

- क्वेरी के जवाब के बारे में जानकारी देने वाला पैसेज.

- सही जवाब, जो हां या नहीं में से कोई एक होता है.

उदाहरण के लिए:

- सवाल: क्या मिशिगन में कोई न्यूक्लियर पावर प्लांट है?

- पैसेज: ...तीन न्यूक्लियर पावर प्लांट, मिशिगन को करीब 30% बिजली की आपूर्ति करते हैं.

- सही जवाब: हां

रिसर्च करने वालों ने, पहचान छिपाकर इकट्ठा की गई Google Search क्वेरी से सवाल इकट्ठा किए. इसके बाद, जानकारी को सही ठहराने के लिए Wikipedia पेजों का इस्तेमाल किया.

ज़्यादा जानकारी के लिए, BoolQ: Exploring the Surprising Difficulty of Natural Yes/No Questions देखें.

BoolQ, SuperGLUE का एक कॉम्पोनेंट है.

BoolQ

बूलियन सवाल के लिए संक्षिप्त नाम.

बूस्टिंग

यह एक मशीन लर्निंग तकनीक है. इसमें, क्लासिफ़िकेशन मॉडल के एक सेट को बार-बार मिलाकर, ज़्यादा सटीक क्लासिफ़िकेशन मॉडल बनाया जाता है. इस सेट में, सामान्य और कम सटीक मॉडल शामिल होते हैं. इन्हें "कमज़ोर क्लासिफ़ायर" कहा जाता है. ज़्यादा सटीक क्लासिफ़िकेशन मॉडल को "मज़बूत क्लासिफ़ायर" कहा जाता है. इसके लिए, उन उदाहरणों को ज़्यादा अहमियत दी जाती है जिन्हें मॉडल फ़िलहाल गलत तरीके से क्लासिफ़ाई कर रहा है.

ज़्यादा जानकारी के लिए, फ़ैसले लेने वाले फ़ॉरेस्ट कोर्स में ग्रैडिएंट बूस्टेड डिसिज़न ट्री क्या होते हैं? देखें.

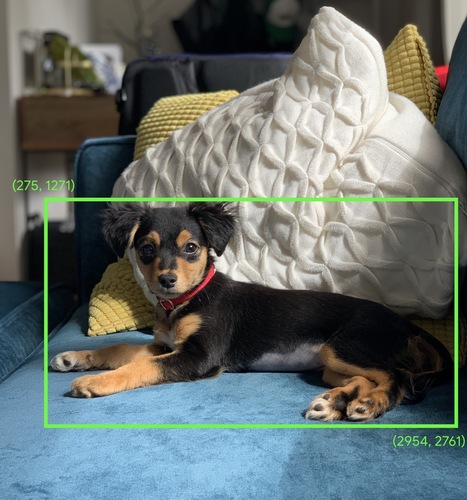

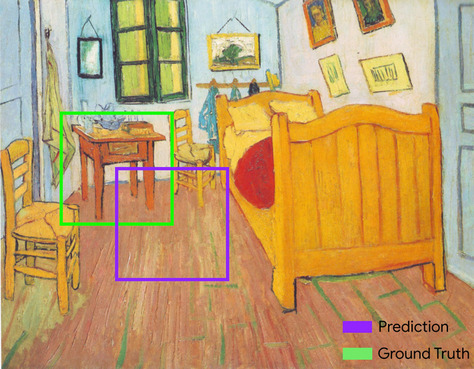

बाउंडिंग बॉक्स

किसी इमेज में, दिलचस्पी वाली जगह के आस-पास मौजूद रेक्टैंगल के (x, y) कोऑर्डिनेट. जैसे, यहां दी गई इमेज में कुत्ते के आस-पास मौजूद रेक्टैंगल के कोऑर्डिनेट.

ब्रॉडकास्ट करना

मैट्रिक्स की गणितीय संक्रिया में, ऑपरेंड के शेप को इस तरह से बढ़ाना कि वह संक्रिया के साथ काम करने वाले डाइमेंशन के साथ काम कर सके. उदाहरण के लिए, लीनियर अलजेब्रा के हिसाब से, मैट्रिक्स जोड़ने की कार्रवाई में शामिल दो ऑपरेंड के डाइमेंशन एक जैसे होने चाहिए. इसलिए, m x n डाइमेंशन वाली मैट्रिक्स को n लंबाई वाले वेक्टर में नहीं जोड़ा जा सकता. ब्रॉडकास्टिंग की मदद से, इस ऑपरेशन को इस तरह से किया जा सकता है: n लंबाई वाले वेक्टर को (m, n) शेप वाले मैट्रिक्स में वर्चुअली बड़ा किया जाता है. इसके लिए, हर कॉलम में एक ही वैल्यू को दोहराया जाता है.

ज़्यादा जानकारी के लिए, NumPy में ब्रॉडकास्टिंग के बारे में यहां दिया गया ब्यौरा देखें.

बकेटिंग

किसी एक फ़ीचर को कई बाइनरी फ़ीचर में बदलना. इन्हें आम तौर पर, वैल्यू रेंज के आधार पर बकेट या बिन कहा जाता है. आम तौर पर, काटी गई सुविधा एक लगातार चलने वाली सुविधा होती है.

उदाहरण के लिए, तापमान को एक फ़्लोटिंग-पॉइंट फ़ीचर के तौर पर दिखाने के बजाय, तापमान की रेंज को अलग-अलग बकेट में बांटा जा सकता है. जैसे:

- <= 10 डिग्री सेल्सियस को "ठंडा" बकेट में रखा जाएगा.

- 11 से 24 डिग्री सेल्सियस के बीच के तापमान को "सामान्य" बकेट में रखा जाएगा.

- >= 25 डिग्री सेल्सियस को "गर्म" बकेट में रखा जाएगा.

मॉडल, एक ही बकेट में मौजूद हर वैल्यू को एक जैसा मानेगा. उदाहरण के लिए, 13 और 22, दोनों वैल्यू को सामान्य बकेट में रखा गया है. इसलिए, मॉडल इन दोनों वैल्यू को एक जैसा मानता है.

ज़्यादा जानकारी के लिए, मशीन लर्निंग क्रैश कोर्स में संख्यात्मक डेटा: बिनिंग देखें.

C

कैलिब्रेशन लेयर

अनुमान लगाने के बाद किया गया अडजस्टमेंट. आम तौर पर, इसका इस्तेमाल अनुमान में होने वाली गड़बड़ी को ठीक करने के लिए किया जाता है. एडजस्ट किए गए अनुमान और संभावितताएं, लेबल के देखे गए सेट के डिस्ट्रिब्यूशन से मेल खानी चाहिए.

उम्मीदवार जनरेट करना

सुझावों का शुरुआती सेट, जिसे सुझाव देने वाले सिस्टम ने चुना है. उदाहरण के लिए, एक ऐसी किताबों की दुकान के बारे में सोचें जो 1,00,000 किताबें उपलब्ध कराती है. उम्मीदवार जनरेट करने के चरण में, किसी उपयोगकर्ता के लिए काम की किताबों की एक छोटी सूची बनाई जाती है. जैसे, 500 किताबें. हालांकि, किसी उपयोगकर्ता को 500 किताबों के सुझाव देना भी बहुत ज़्यादा है. सुझाव देने वाले सिस्टम के बाद के चरणों (जैसे कि स्कोरिंग और फिर से रैंक करना) में, इन 500 सुझावों को कम करके, ज़्यादा काम के सुझावों का एक छोटा सेट तैयार किया जाता है.

ज़्यादा जानकारी के लिए, Recommendation Systems कोर्स में Candidate generation overview देखें.

उम्मीदवारों का सैंपल

यह ट्रेनिंग के दौरान किया जाने वाला ऑप्टिमाइज़ेशन है. इसमें सभी पॉज़िटिव लेबल की संभावना का हिसाब लगाया जाता है. इसके लिए, उदाहरण के तौर पर सॉफ़्टमैक्स का इस्तेमाल किया जाता है. हालांकि, यह सिर्फ़ नेगेटिव लेबल के रैंडम सैंपल के लिए होता है. उदाहरण के लिए, बीगल और कुत्ता के तौर पर लेबल किए गए उदाहरण के लिए, कैंडिडेट सैंपलिंग, अनुमानित संभावनाओं और इनसे जुड़े नुकसान की शर्तों का हिसाब लगाती है. ये शर्तें इनके लिए होती हैं:

- बीगल

- dog

- बची हुई नेगेटिव क्लास का रैंडम सबसेट (उदाहरण के लिए, बिल्ली, लॉलीपॉप, बाड़).

इसका मतलब यह है कि नेगेटिव क्लास को कम बार मिलने वाले नेगेटिव रीइन्फ़ोर्समेंट से सीखा जा सकता है. हालांकि, इसके लिए यह ज़रूरी है कि पॉज़िटिव क्लास को हमेशा सही पॉज़िटिव रीइन्फ़ोर्समेंट मिले. यह बात अनुभव के आधार पर भी देखी गई है.

कैंडिडेट सैंपलिंग, ट्रेनिंग एल्गोरिदम की तुलना में ज़्यादा कंप्यूटेशनल तौर पर असरदार होती है. ट्रेनिंग एल्गोरिदम, सभी नेगेटिव क्लास के लिए अनुमान का हिसाब लगाते हैं. खास तौर पर, जब नेगेटिव क्लास की संख्या बहुत ज़्यादा होती है.

कैटगोरिकल डेटा

सुविधाएं, जिनमें संभावित वैल्यू का कोई खास सेट होता है. उदाहरण के लिए, traffic-light-state नाम की कैटगरी वाली सुविधा पर विचार करें. इसकी सिर्फ़ तीन वैल्यू हो सकती हैं:

redyellowgreen

traffic-light-state को कैटगरी के हिसाब से तय की गई सुविधा के तौर पर दिखाने से, मॉडल यह जान सकता है कि ड्राइवर के व्यवहार पर red, green, और yellow का क्या असर पड़ता है.

कैटगोरिकल फ़ीचर को कभी-कभी डिसक्रीट फ़ीचर भी कहा जाता है.

संख्यात्मक डेटा से तुलना करें.

ज़्यादा जानकारी के लिए, मशीन लर्निंग क्रैश कोर्स में कैटगरी में बांटे गए डेटा का इस्तेमाल करना लेख पढ़ें.

कैज़ल लैंग्वेज मॉडल

यह एक दिशा में काम करने वाले लैंग्वेज मॉडल का समानार्थी शब्द है.

भाषा मॉडलिंग में अलग-अलग दिशाओं वाले तरीकों की तुलना करने के लिए, दोनों दिशाओं में काम करने वाला भाषा मॉडल देखें.

CB

CommitmentBank का छोटा नाम.

सेंट्रॉइड

k-मीन्स या k-मीडियन एल्गोरिदम से तय किया गया क्लस्टर का सेंटर. उदाहरण के लिए, अगर k की वैल्यू 3 है, तो k-मीन्स या k-मीडियन एल्गोरिदम, तीन सेंट्रॉइड ढूंढता है.

ज़्यादा जानकारी के लिए, क्लस्टरिंग कोर्स में क्लस्टरिंग एल्गोरिदम देखें.

सेंट्रॉइड पर आधारित क्लस्टरिंग

यह क्लस्टरिंग एल्गोरिदम की एक कैटगरी है. यह डेटा को नॉनहायरार्किकल क्लस्टर में व्यवस्थित करता है. k-मीन्स, सेंट्रॉइड पर आधारित सबसे ज़्यादा इस्तेमाल किया जाने वाला क्लस्टरिंग एल्गोरिदम है.

हायरार्किकल क्लस्टरिंग एल्गोरिदम से तुलना करें.

ज़्यादा जानकारी के लिए, क्लस्टरिंग कोर्स में क्लस्टरिंग एल्गोरिदम देखें.

सिलसिलेवार तरीके से जवाब देने के लिए प्रॉम्प्ट तैयार करना

यह प्रॉम्प्ट इंजीनियरिंग की एक ऐसी तकनीक है जो लार्ज लैंग्वेज मॉडल (एलएलएम) को, जवाब देने के पीछे की वजह को क्रम से बताने के लिए बढ़ावा देती है. उदाहरण के लिए, इस प्रॉम्प्ट को देखें. इसमें दूसरे वाक्य पर खास ध्यान दें:

अगर कोई कार 7 सेकंड में 0 से 60 मील प्रति घंटे की रफ़्तार पकड़ लेती है, तो ड्राइवर को कितने G फ़ोर्स का अनुभव होगा? जवाब में, सभी ज़रूरी कैलकुलेशन दिखाएं.

एलएलएम का जवाब ऐसा हो सकता है:

- फ़िज़िक्स के फ़ॉर्मूलों का क्रम दिखाएं. साथ ही, सही जगहों पर 0, 60, और 7 वैल्यू डालें.

- यह भी बताएं कि उन फ़ॉर्मूलों को क्यों चुना गया और अलग-अलग वैरिएबल का क्या मतलब है.

चेन-ऑफ़-थॉट प्रॉम्प्टिंग से, एलएलएम को सभी कैलकुलेशन करनी पड़ती हैं. इससे ज़्यादा सही जवाब मिल सकता है. इसके अलावा, चेन-ऑफ़-थॉट प्रॉम्प्टिंग की मदद से उपयोगकर्ता, एलएलएम के जवाब देने के तरीके की जांच कर सकता है. इससे यह पता चलता है कि जवाब सही है या नहीं.

कैरेक्टर एन-ग्राम F-स्कोर (ChrF)

यह मशीन ट्रांसलेशन मॉडल का आकलन करने के लिए एक मेट्रिक है. वर्ण N-ग्राम F-स्कोर से यह पता चलता है कि रेफ़रंस टेक्स्ट में मौजूद N-ग्राम, एमएल मॉडल के जनरेट किए गए टेक्स्ट में मौजूद N-ग्राम से कितने मिलते-जुलते हैं.

कैरेक्टर एन-ग्राम एफ़-स्कोर, ROUGE और BLEU फ़ैमिली की मेट्रिक के जैसा ही होता है. हालांकि, इसमें ये अंतर होते हैं:

- वर्ण N-ग्राम F-स्कोर, वर्ण N-ग्राम पर काम करता है.

- ROUGE और BLEU, शब्द N-ग्राम या टोकन पर काम करते हैं.

चैट

किसी एमएल सिस्टम के साथ बातचीत का कॉन्टेंट. आम तौर पर, यह लार्ज लैंग्वेज मॉडल होता है. चैट में पिछली बातचीत (आपने क्या टाइप किया और लार्ज लैंग्वेज मॉडल ने कैसे जवाब दिया) को चैट के बाद के हिस्सों के लिए कॉन्टेक्स्ट माना जाता है.

चैटबॉट, लार्ज लैंग्वेज मॉडल का एक ऐप्लिकेशन है.

COVID-19 की जांच के लिए बनी चेकपोस्ट

ऐसा डेटा जो मॉडल के पैरामीटर की स्थिति को कैप्चर करता है. यह स्थिति, ट्रेनिंग के दौरान या ट्रेनिंग पूरी होने के बाद की हो सकती है. उदाहरण के लिए, ट्रेनिंग के दौरान ये काम किए जा सकते हैं:

- ट्रेनिंग को रोकना. ऐसा जान-बूझकर या कुछ गड़बड़ियों की वजह से किया जा सकता है.

- चेकपॉइंट कैप्चर करें.

- बाद में, चेकपॉइंट को फिर से लोड करें. ऐसा हो सकता है कि आपको अलग हार्डवेयर पर ऐसा करना पड़े.

- ट्रेनिंग को फिर से शुरू करें.

मिलते-जुलते विकल्पों का चुनाव (कोपा)

यह डेटासेट, इस बात का आकलन करने के लिए है कि एलएलएम, किसी आधार के लिए दो विकल्पों में से बेहतर जवाब की पहचान कितनी अच्छी तरह से कर सकता है. डेटासेट में मौजूद हर चुनौती में तीन कॉम्पोनेंट होते हैं:

- कोई आधार वाक्य, जो आम तौर पर एक ऐसा वाक्य होता है जिसके बाद कोई सवाल पूछा जाता है

- आधार वाक्य में पूछे गए सवाल के दो संभावित जवाब, जिनमें से एक सही है और दूसरा गलत

- सही जवाब

उदाहरण के लिए:

- आधार: आदमी के पैर की उंगली टूट गई. इसकी वजह क्या थी?

- संभावित जवाब:

- उसकी मोज़े में छेद हो गया.

- उसके पैर पर हथौड़ा गिर गया.

- सही जवाब: 2

COPA, SuperGLUE का एक कॉम्पोनेंट है.

क्लास

वह कैटगरी जिससे कोई लेबल जुड़ा हो सकता है. उदाहरण के लिए:

- स्पैम का पता लगाने वाले बाइनरी क्लासिफ़िकेशन मॉडल में, दो क्लास स्पैम और स्पैम नहीं है हो सकती हैं.

- मल्टी-क्लास क्लासिफ़िकेशन मॉडल में, कुत्ते की नस्लों की पहचान की जाती है. इसमें क्लास पूडल, बीगल, पग वगैरह हो सकती हैं.

क्लासिफ़िकेशन मॉडल किसी क्लास का अनुमान लगाता है. इसके उलट, रिग्रेशन मॉडल, क्लास के बजाय किसी संख्या का अनुमान लगाता है.

ज़्यादा जानकारी के लिए, मशीन लर्निंग क्रैश कोर्स में वर्गीकरण देखें.

क्लास-बैलेंस किया गया डेटासेट

ऐसा डेटासेट जिसमें कैटगोरिकल लेबल शामिल हों और हर कैटगरी के इंस्टेंस की संख्या लगभग बराबर हो. उदाहरण के लिए, वनस्पति विज्ञान के किसी डेटासेट पर विचार करें. इसके बाइनरी लेबल, स्थानीय पौधा या विदेशी पौधा हो सकते हैं:

- 515 स्थानीय पौधों और 485 बाहरी पौधों वाला डेटासेट, क्लास-बैलेंस वाला डेटासेट होता है.

- 875 स्थानीय पौधों और 125 बाहरी पौधों वाला डेटासेट, क्लास-इंबैलेंस वाला डेटासेट होता है.

क्लास के हिसाब से संतुलित डेटासेट और क्लास के हिसाब से असंतुलित डेटासेट के बीच कोई औपचारिक अंतर नहीं होता. इनके बीच का अंतर सिर्फ़ तब अहम हो जाता है, जब क्लास के हिसाब से बहुत ज़्यादा असंतुलित डेटासेट पर ट्रेन किया गया मॉडल, कन्वर्ज नहीं हो पाता. ज़्यादा जानकारी के लिए, मशीन लर्निंग क्रैश कोर्स में डेटासेट: असंतुलित डेटासेट देखें.

क्लासिफ़िकेशन मॉडल

ऐसा मॉडल जिसका अनुमान, क्लास होता है. उदाहरण के लिए, यहां दिए गए सभी क्लासिफ़िकेशन मॉडल हैं:

- ऐसा मॉडल जो इनपुट किए गए वाक्य की भाषा का अनुमान लगाता है (क्या यह फ़्रेंच है? स्पैनिश? इटैलियन?).

- ऐसा मॉडल जो पेड़ की प्रजातियों का अनुमान लगाता है (मेपल? ओक? बेओबैब?).

- ऐसा मॉडल जो किसी खास बीमारी के लिए पॉज़िटिव या नेगेटिव क्लास का अनुमान लगाता है.

इसके उलट, रिग्रेशन मॉडल क्लास के बजाय संख्याओं का अनुमान लगाते हैं.

आम तौर पर, क्लासिफ़िकेशन मॉडल दो तरह के होते हैं:

श्रेणी में बाँटने की सीमा

बाइनरी क्लासिफ़िकेशन में, 0 से 1 के बीच की कोई संख्या होती है. यह लॉजिस्टिक रिग्रेशन मॉडल के रॉ आउटपुट को पॉज़िटिव क्लास या नेगेटिव क्लास के अनुमान में बदलती है. ध्यान दें कि क्लासिफ़िकेशन थ्रेशोल्ड एक ऐसी वैल्यू होती है जिसे कोई व्यक्ति चुनता है. यह मॉडल ट्रेनिंग के दौरान चुनी गई वैल्यू नहीं होती.

लॉजिस्टिक रिग्रेशन मॉडल, 0 और 1 के बीच की रॉ वैल्यू दिखाता है. इसके बाद:

- अगर यह रॉ वैल्यू, क्लासिफ़िकेशन थ्रेशोल्ड से ज़्यादा है, तो पॉज़िटिव क्लास का अनुमान लगाया जाता है.

- अगर यह रॉ वैल्यू, क्लासिफ़िकेशन थ्रेशोल्ड से कम है, तो नेगेटिव क्लास का अनुमान लगाया जाता है.

उदाहरण के लिए, मान लें कि क्लासिफ़िकेशन थ्रेशोल्ड 0.8 है. अगर रॉ वैल्यू 0.9 है, तो मॉडल पॉज़िटिव क्लास का अनुमान लगाता है. अगर रॉ वैल्यू 0.7 है, तो मॉडल नेगेटिव क्लास का अनुमान लगाता है.

क्लासिफ़िकेशन थ्रेशोल्ड चुनने से, फ़ॉल्स पॉज़िटिव और फ़ॉल्स नेगेटिव की संख्या पर काफ़ी असर पड़ता है.

ज़्यादा जानकारी के लिए, मशीन लर्निंग क्रैश कोर्स में थ्रेशोल्ड और कन्फ़्यूज़न मैट्रिक्स देखें.

डेटा की कैटगरी तय करने वाला

क्लासिफ़िकेशन मॉडल के लिए इस्तेमाल किया जाने वाला सामान्य शब्द.

क्लास-इंबैलेंस वाला डेटासेट

क्लासिफ़िकेशन के लिए डेटासेट, जिसमें हर क्लास के लेबल की कुल संख्या में काफ़ी अंतर होता है. उदाहरण के लिए, बाइनरी क्लासिफ़िकेशन वाले किसी डेटासेट पर विचार करें. इसके दो लेबल इस तरह बांटे गए हैं:

- 10,00,000 नेगेटिव लेबल

- 10 पॉज़िटिव लेबल

नेगेटिव और पॉज़िटिव लेबल का अनुपात 100,000 से 1 है. इसलिए, यह क्लास-इंबैलेंस वाला डेटासेट है.

इसके उलट, यहां दिया गया डेटासेट क्लास-बैलेंस है, क्योंकि नेगेटिव लेबल और पॉज़िटिव लेबल का अनुपात 1 के आस-पास है:

- 517 नेगेटिव लेबल

- 483 पॉज़िटिव लेबल

मल्टी-क्लास डेटासेट में क्लास का बैलेंस भी बिगड़ा हो सकता है. उदाहरण के लिए, यहां दिया गया मल्टी-क्लास क्लासिफ़िकेशन डेटासेट भी क्लास के असंतुलन वाला है. ऐसा इसलिए, क्योंकि एक लेबल के उदाहरण, अन्य दो लेबल के मुकाबले काफ़ी ज़्यादा हैं:

- "green" क्लास वाले 10,00,000 लेबल

- "purple" क्लास वाले 200 लेबल

- "ऑरेंज" क्लास वाले 350 लेबल

ट्रेनिंग के लिए, क्लास-इंबैलेंस वाले डेटासेट में खास चुनौतियां आ सकती हैं. ज़्यादा जानकारी के लिए, मशीन लर्निंग क्रैश कोर्स में डेटासेट में क्लास का असंतुलित डिस्ट्रिब्यूशन देखें.

एंट्रॉपी, मेजर क्लास}, और माइनर क्लास के बारे में भी जानें.

क्लिपिंग

यह आउटलायर को मैनेज करने का एक तरीका है. इसके तहत, इनमें से कोई एक या दोनों काम किए जाते हैं:

- सुविधा की उन वैल्यू को कम करना जो ज़्यादा से ज़्यादा थ्रेशोल्ड से ज़्यादा हैं. इन वैल्यू को ज़्यादा से ज़्यादा थ्रेशोल्ड तक कम किया जाता है.

- सुविधा की उन वैल्यू को बढ़ाना जो कम से कम थ्रेशोल्ड से कम हैं, ताकि वे कम से कम थ्रेशोल्ड तक पहुंच सकें.

उदाहरण के लिए, मान लें कि किसी सुविधा के लिए, 0.5% से कम वैल्यू, 40 से 60 के बीच की सीमा से बाहर हैं. इस मामले में, ये काम किए जा सकते हैं:

- 60 से ज़्यादा की सभी वैल्यू को 60 पर सेट करें. यह ज़्यादा से ज़्यादा थ्रेशोल्ड है.

- 40 से कम (कम से कम थ्रेशोल्ड) वाली सभी वैल्यू को 40 पर सेट करें.

आउटलायर, मॉडल को नुकसान पहुंचा सकते हैं. कभी-कभी, ट्रेनिंग के दौरान वज़न ज़्यादा हो जाते हैं. कुछ आउटलायर, सटीकता जैसी मेट्रिक को भी काफ़ी हद तक खराब कर सकते हैं. क्लिपिंग, नुकसान को कम करने का एक सामान्य तरीका है.

ग्रेडिएंट क्लिपिंग, ट्रेनिंग के दौरान ग्रेडिएंट की वैल्यू को तय की गई रेंज में रखती है.

ज़्यादा जानकारी के लिए, Machine Learning Crash Course में संख्यात्मक डेटा: नॉर्मलाइज़ेशन देखें.

Cloud TPU

यह एक खास हार्डवेयर एक्सेलरेटर है. इसे Google Cloud पर मशीन लर्निंग के वर्कलोड को तेज़ी से प्रोसेस करने के लिए डिज़ाइन किया गया है.

क्लस्टरिंग

मिलते-जुलते उदाहरणों को ग्रुप करना. खास तौर पर, बिना निगरानी वाली लर्निंग के दौरान. सभी उदाहरणों को ग्रुप करने के बाद, कोई व्यक्ति हर क्लस्टर का मतलब बता सकता है.

क्लस्टरिंग के कई एल्गोरिदम मौजूद हैं. उदाहरण के लिए, k-means एल्गोरिदम, उदाहरणों को उनके सेंट्रॉइड से दूरी के आधार पर क्लस्टर करता है. जैसा कि इस डायग्राम में दिखाया गया है:

इसके बाद, रिसर्च करने वाला व्यक्ति क्लस्टर की समीक्षा कर सकता है. उदाहरण के लिए, वह क्लस्टर 1 को "छोटे पेड़" और क्लस्टर 2 को "बड़े पेड़" के तौर पर लेबल कर सकता है.

एक और उदाहरण के तौर पर, किसी सेंटर पॉइंट से उदाहरण की दूरी के आधार पर क्लस्टरिंग एल्गोरिदम पर विचार करें. इसे इस तरह दिखाया गया है:

ज़्यादा जानकारी के लिए, क्लस्टरिंग कोर्स देखें.

को-अडैप्टेशन

यह एक ऐसी समस्या है जिसमें न्यूरॉन, ट्रेनिंग डेटा में पैटर्न का अनुमान लगाते हैं. इसके लिए, वे पूरे नेटवर्क के व्यवहार पर भरोसा करने के बजाय, खास तौर पर अन्य न्यूरॉन के आउटपुट पर भरोसा करते हैं. जब पुष्टि करने के लिए इस्तेमाल किए गए डेटा में, को-अडैप्टेशन की वजह बनने वाले पैटर्न मौजूद नहीं होते हैं, तब को-अडैप्टेशन की वजह से ओवरफ़िटिंग होती है. ड्रॉपआउट रेगुलराइज़ेशन से को-अडैप्टेशन कम हो जाता है, क्योंकि ड्रॉपआउट यह पक्का करता है कि न्यूरॉन सिर्फ़ कुछ अन्य न्यूरॉन पर भरोसा न करें.

कोलैबोरेटिव फ़िल्टरिंग

कई अन्य उपयोगकर्ताओं की दिलचस्पी के आधार पर, किसी एक उपयोगकर्ता की दिलचस्पी के बारे में अनुमान लगाना. कोलैबोरेटिव फ़िल्टरिंग का इस्तेमाल अक्सर सुझाव देने वाले सिस्टम में किया जाता है.

ज़्यादा जानकारी के लिए, Recommendation Systems कोर्स में Collaborative filtering देखें.

कमिटमेंटबैंक (सीबी)

यह एक ऐसा डेटासेट है जिसका इस्तेमाल यह आकलन करने के लिए किया जाता है कि कोई एलएलएम, किसी पैसेज के लेखक के बारे में यह पता लगाने में कितना माहिर है कि वह पैसेज में मौजूद किसी टारगेट क्लॉज़ पर भरोसा करता है या नहीं. डेटासेट की हर एंट्री में यह जानकारी शामिल होती है:

- एक पैसेज

- उस पैसेज में मौजूद टारगेट क्लॉज़

- बूलियन वैल्यू, जिससे यह पता चलता है कि पैसेज के लेखक का मानना है कि टारगेट क्लॉज़

उदाहरण के लिए:

- पैसेज: अर्टमिस की हंसी सुनकर बहुत अच्छा लगा. वह बहुत गंभीर बच्ची है. मुझे नहीं पता था कि वह इतनी मज़ेदार है.

- टारगेट क्लॉज़: वह मज़ेदार थी

- बूलियन: सही है. इसका मतलब है कि लेखक का मानना है कि टारगेट क्लॉज़

CommitmentBank, SuperGLUE का एक कॉम्पोनेंट है.

कॉम्पैक्ट मॉडल

ऐसा कोई भी छोटा मॉडल जिसे कम कंप्यूटेशनल संसाधनों वाले छोटे डिवाइसों पर चलाने के लिए डिज़ाइन किया गया हो. उदाहरण के लिए, कॉम्पैक्ट मॉडल को मोबाइल फ़ोन, टैबलेट या एम्बेड किए गए सिस्टम पर चलाया जा सकता है.

कंप्यूट

(संज्ञा) किसी मॉडल या सिस्टम के लिए इस्तेमाल किए जाने वाले कंप्यूटेशनल संसाधन. जैसे, प्रोसेसिंग पावर, मेमोरी, और स्टोरेज.

ऐक्सलरेटर चिप देखें.

कॉन्सेप्ट ड्रिफ़्ट

सुविधाओं और लेबल के बीच संबंध में बदलाव. समय के साथ, कॉन्सेप्ट ड्रिफ्ट की वजह से मॉडल की क्वालिटी कम हो जाती है.

ट्रेनिंग के दौरान, मॉडल ट्रेनिंग सेट में मौजूद सुविधाओं और उनके लेबल के बीच के संबंध को समझता है. अगर ट्रेनिंग सेट में मौजूद लेबल, असल दुनिया के लिए अच्छे प्रॉक्सी हैं, तो मॉडल को असल दुनिया के लिए अच्छे अनुमान लगाने चाहिए. हालांकि, कॉन्सेप्ट ड्रिफ़्ट की वजह से, समय के साथ मॉडल के अनुमानों की क्वालिटी कम हो जाती है.

उदाहरण के लिए, बाइनरी क्लासिफ़िकेशन मॉडल पर विचार करें. यह मॉडल अनुमान लगाता है कि कोई कार मॉडल "ईंधन की कम खपत करने वाला" है या नहीं. इसका मतलब है कि ये सुविधाएं:

- कार का वज़न

- इंजन कंप्रेस करना

- ट्रांसमिशन का टाइप

जब लेबल इनमें से कोई एक हो:

- ईंधन की कम खपत

- ईंधन की खपत ज़्यादा होती है

हालांकि, "ईंधन की कम खपत करने वाली कार" की परिभाषा लगातार बदलती रहती है. साल 1994 में, जिस कार मॉडल को कम ईंधन खपत करने वाला लेबल किया गया था उसे साल 2024 में ज़्यादा ईंधन खपत करने वाला लेबल किया जाएगा. कॉन्सेप्ट ड्रिफ्ट की समस्या से जूझ रहा मॉडल, समय के साथ कम से कम काम के अनुमान लगाता है.

नॉनस्टेशनैरिटी से इसकी तुलना करें और इनके बीच अंतर बताएं.

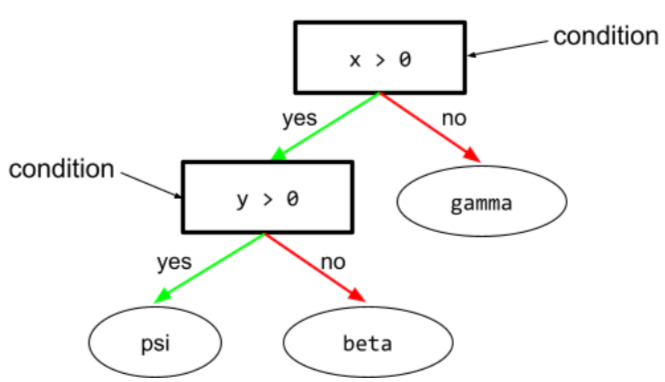

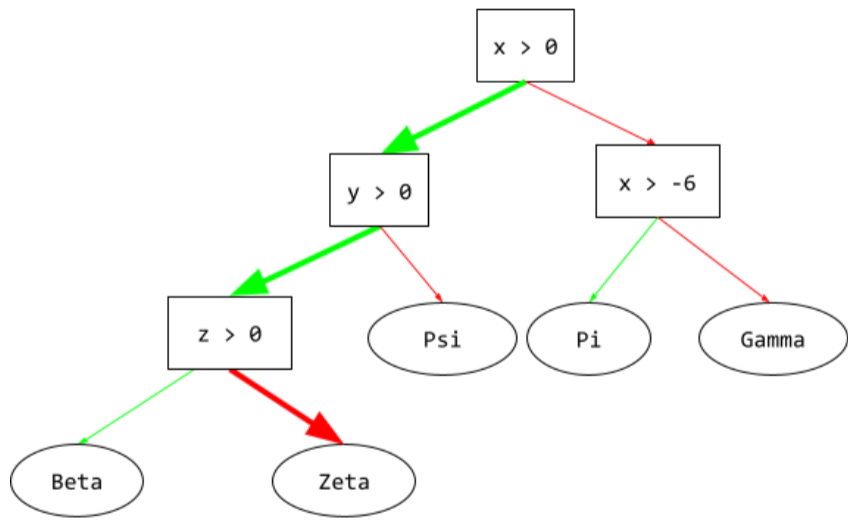

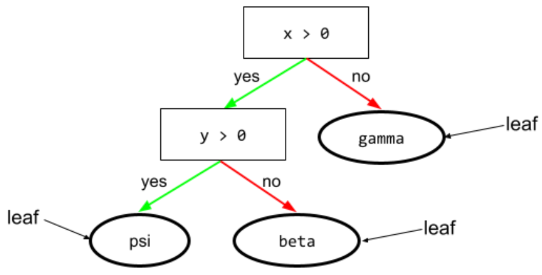

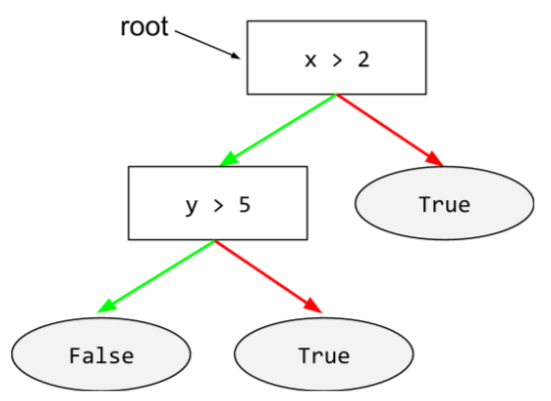

शर्त

डिसिज़न ट्री में, कोई भी नोड जो टेस्ट करता है. उदाहरण के लिए, इस फ़ैसले के ट्री में दो शर्तें शामिल हैं:

कंडीशन को स्प्लिट या टेस्ट भी कहा जाता है.

पत्ती के साथ कंट्रास्ट की स्थिति.

यह भी देखें:

ज़्यादा जानकारी के लिए, Decision Forests कोर्स में शर्तों के टाइप देखें.

झूठी बातें बनाना

गलत जानकारी के लिए समानार्थी शब्द.

तकनीकी तौर पर, 'भ्रम' शब्द की तुलना में 'झूठी जानकारी देना' ज़्यादा सटीक शब्द है. हालांकि, सबसे पहले हैलुसिनेशन की समस्या के बारे में लोगों को पता चला.

कॉन्फ़िगरेशन

मॉडल को ट्रेन करने के लिए इस्तेमाल की गई शुरुआती प्रॉपर्टी वैल्यू असाइन करने की प्रोसेस. इसमें ये शामिल हैं:

- मॉडल की कंपोज़िंग लेयर

- डेटा की जगह

- हाइपरपैरामीटर, जैसे कि:

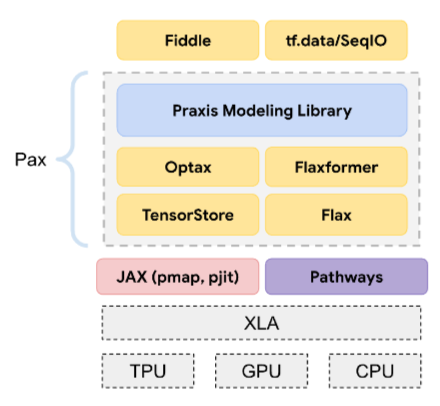

मशीन लर्निंग प्रोजेक्ट में, कॉन्फ़िगरेशन को किसी खास कॉन्फ़िगरेशन फ़ाइल के ज़रिए किया जा सकता है. इसके अलावा, यहां दी गई कॉन्फ़िगरेशन लाइब्रेरी का इस्तेमाल करके भी कॉन्फ़िगरेशन किया जा सकता है:

कंफ़र्मेशन बायस

किसी जानकारी को इस तरह से खोजना, समझना, उसके पक्ष में तर्क देना, और उसे याद रखना कि वह पहले से मौजूद मान्यताओं या अनुमानों की पुष्टि करे. मशीन लर्निंग डेवलपर, अनजाने में डेटा को इस तरह से इकट्ठा या लेबल कर सकते हैं जिससे उनके मौजूदा विचारों के मुताबिक नतीजे मिलें. कंफ़र्मेशन बायस, अचेतन पूर्वाग्रह का एक रूप है.

एक्सपेरिमेंट करने वाले व्यक्ति का पूर्वाग्रह, पुष्टि करने वाले पूर्वाग्रह का एक रूप है. इसमें एक्सपेरिमेंट करने वाला व्यक्ति, मॉडल को तब तक ट्रेनिंग देता रहता है, जब तक कि पहले से मौजूद किसी हाइपोथेसिस की पुष्टि न हो जाए.

कन्फ़्यूज़न मैट्रिक्स

यह NxN टेबल होती है. इसमें क्लासिफ़िकेशन मॉडल के सही और गलत अनुमानों की संख्या के बारे में खास जानकारी दी जाती है. उदाहरण के लिए, बाइनरी क्लासिफ़िकेशन मॉडल के लिए, यहां दी गई कन्फ़्यूज़न मैट्रिक्स देखें:

| ट्यूमर (अनुमानित) | नॉन-ट्यूमर (अनुमानित) | |

|---|---|---|

| ट्यूमर (ग्राउंड ट्रुथ) | 18 (TP) | 1 (FN) |

| ट्यूमर नहीं है (असल डेटा) | 6 (FP) | 452 (TN) |

ऊपर दी गई कन्फ़्यूज़न मैट्रिक्स में यह जानकारी दिखती है:

- ट्यूमर के 19 अनुमानों में से, मॉडल ने 18 अनुमानों को सही तरीके से और 1 अनुमान को गलत तरीके से क्लासिफ़ाई किया.

- 458 अनुमानों में से, मॉडल ने 452 अनुमानों को सही तरीके से और 6 अनुमानों को गलत तरीके से क्लासिफ़ाई किया. इन अनुमानों में, ग्राउंड ट्रुथ के तौर पर नॉन-ट्यूमर की जानकारी दी गई थी.

मल्टी-क्लास क्लासिफ़िकेशन की समस्या के लिए कन्फ़्यूज़न मैट्रिक्स की मदद से, गलतियों के पैटर्न की पहचान की जा सकती है. उदाहरण के लिए, तीन क्लास वाले मल्टी-क्लास क्लासिफ़िकेशन मॉडल के लिए, यहां दी गई कन्फ़्यूज़न मैट्रिक्स देखें. यह मॉडल, आइरिस की तीन अलग-अलग प्रजातियों (वर्जिनिका, वर्सीकलर, और सेटोसा) को कैटगरी में बांटता है. जब ग्राउंड ट्रुथ वर्जिनिका था, तब कन्फ़्यूज़न मैट्रिक्स से पता चलता है कि मॉडल ने सेटोसा के मुकाबले वर्सिकलर का अनुमान ज़्यादा गलत तरीके से लगाया:

| सेटोज़ा (अनुमानित) | वर्सीकलर (अनुमानित) | वर्जिनिका (अनुमानित) | |

|---|---|---|---|

| सेटोज़ा (ग्राउंड ट्रूथ) | 88 | 12 | 0 |

| वर्सीकलर (ग्राउंड ट्रुथ) | 6 | 141 | 7 |

| वर्जिनिका (ग्राउंड ट्रुथ) | 2 | 27 | 109 |

एक और उदाहरण के तौर पर, कन्फ़्यूज़न मैट्रिक्स से पता चल सकता है कि हाथ से लिखे गए अंकों को पहचानने के लिए ट्रेन किए गए मॉडल में, 4 की जगह 9 या 7 की जगह 1 का अनुमान लगाने की गड़बड़ी होती है.

कन्फ़्यूज़न मैट्रिक्स में, परफ़ॉर्मेंस की अलग-अलग मेट्रिक का हिसाब लगाने के लिए ज़रूरी जानकारी होती है. इनमें सटीकता और रिकॉल शामिल हैं.

चुनावी क्षेत्र की जानकारी को पार्स करना

किसी वाक्य को छोटे-छोटे व्याकरण के स्ट्रक्चर ("कॉन्स्टिट्यूएंट") में बांटना. एमएल सिस्टम का बाद वाला हिस्सा, जैसे कि नैचुरल लैंग्वेज अंडरस्टैंडिंग मॉडल, ओरिजनल वाक्य के मुकाबले कॉम्पोनेंट को ज़्यादा आसानी से पार्स कर सकता है. उदाहरण के लिए, इस वाक्य पर ध्यान दें:

मेरे दोस्त ने दो बिल्लियां गोद ली हैं.

निर्वाचन क्षेत्र के पार्सर की मदद से, इस वाक्य को इन दो हिस्सों में बांटा जा सकता है:

- My friend एक संज्ञा वाक्यांश है.

- दो बिल्लियां गोद लीं एक क्रिया वाक्यांश है.

इन कॉम्पोनेंट को छोटे-छोटे कॉम्पोनेंट में बांटा जा सकता है. उदाहरण के लिए, क्रिया का वाक्यांश

दो बिल्लियां गोद ली हैं

इन्हें और उप-विभाजित किया जा सकता है:

- adopted एक क्रिया है.

- दो बिल्लियां एक और संज्ञा वाक्यांश है.

संदर्भ के हिसाब से भाषा को एंबेड करना

एम्बेडिंग, शब्दों और वाक्यांशों को "समझने" के लिए, इंसानों की तरह काम करती है. कॉन्टेक्स्ट के हिसाब से भाषा के एम्बेडिंग, मुश्किल सिंटैक्स, सिमैंटिक, और कॉन्टेक्स्ट को समझ सकते हैं.

उदाहरण के लिए, अंग्रेज़ी शब्द cow के एम्बेडिंग पर विचार करें. word2vec जैसे पुराने एम्बेडिंग, अंग्रेज़ी शब्दों को इस तरह से दिखा सकते हैं कि एम्बेडिंग स्पेस में गाय से बैल की दूरी, भेड़ी (मादा भेड़) से भेड़ा (नर भेड़) या महिला से पुरुष की दूरी के बराबर हो. संदर्भ के हिसाब से भाषा को एंबेड करने की प्रोसेस, एक कदम आगे बढ़कर यह पहचान सकती है कि अंग्रेज़ी बोलने वाले लोग कभी-कभी cow शब्द का इस्तेमाल, गाय या बैल के लिए करते हैं.

कॉन्टेक्स्ट विंडो

किसी मॉडल के लिए, दिए गए प्रॉम्प्ट में प्रोसेस किए जा सकने वाले टोकन की संख्या. कॉन्टेक्स्ट विंडो जितनी बड़ी होगी, मॉडल उतनी ही ज़्यादा जानकारी का इस्तेमाल करके, प्रॉम्प्ट के लिए जवाब दे पाएगा.

लगातार काम करने वाली सुविधा

फ़्लोटिंग-पॉइंट सुविधा, जिसमें वैल्यू की रेंज इनफ़िनिट होती है. जैसे, तापमान या वज़न.

इसकी तुलना डिस्क्रीट फ़ीचर से करें.

आसानी से इकट्ठा किया जाने वाला सैंपल

जल्दी एक्सपेरिमेंट करने के लिए, ऐसे डेटासेट का इस्तेमाल करना जिसे वैज्ञानिक तरीके से इकट्ठा नहीं किया गया है. बाद में, वैज्ञानिक तरीके से इकट्ठा किए गए डेटासेट पर स्विच करना ज़रूरी है.

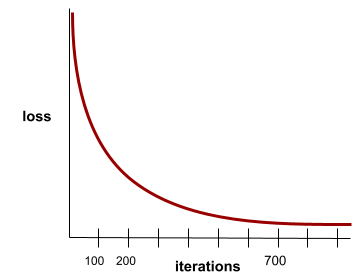

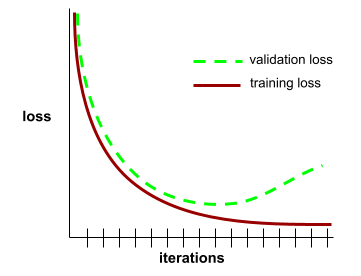

कन्वर्जेंस

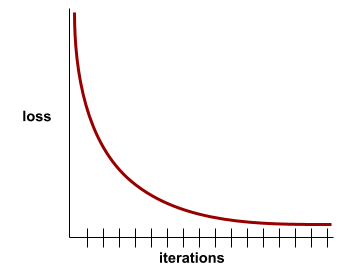

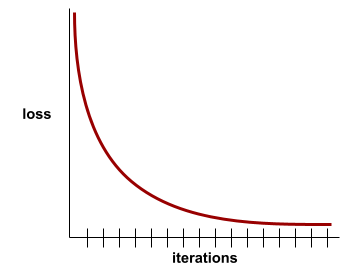

यह ऐसी स्थिति होती है, जब हर इटरेशन के साथ नुकसान की वैल्यू में बहुत कम बदलाव होता है या कोई बदलाव नहीं होता. उदाहरण के लिए, यहां दिया गया लॉस कर्व, 700 इटरेशन के आस-पास कन्वर्जेंस का सुझाव देता है:

जब ज़्यादा ट्रेनिंग देने से मॉडल में सुधार नहीं होता, तो मॉडल कन्वर्ज हो जाता है.

डीप लर्निंग में, लॉस वैल्यू कभी-कभी कई इटरेशन के लिए स्थिर रहती हैं या आखिर में कम होने से पहले लगभग स्थिर रहती हैं. लंबे समय तक नुकसान की वैल्यू में लगातार बढ़ोतरी होने पर, आपको कुछ समय के लिए कन्वर्जेंस का गलत अनुमान मिल सकता है.

अर्ली स्टॉपिंग के बारे में भी जानें.

ज़्यादा जानकारी के लिए, मशीन लर्निंग क्रैश कोर्स में मॉडल कन्वर्जेंस और लॉस कर्व देखें.

बातचीत करके कोडिंग करना

सॉफ़्टवेयर बनाने के मकसद से, जनरेटिव एआई मॉडल और आपके बीच बार-बार होने वाली बातचीत. आपने किसी सॉफ़्टवेयर के बारे में जानकारी देने वाला कोई प्रॉम्प्ट दिया हो. इसके बाद, मॉडल उस ब्यौरे का इस्तेमाल करके कोड जनरेट करता है. इसके बाद, पिछले प्रॉम्प्ट या जनरेट किए गए कोड में मौजूद कमियों को ठीक करने के लिए, एक नया प्रॉम्प्ट दिया जाता है. इसके बाद, मॉडल अपडेट किया गया कोड जनरेट करता है. जब तक जनरेट किया गया सॉफ़्टवेयर सही नहीं हो जाता, तब तक दोनों के बीच बातचीत जारी रहती है.

बातचीत कोडिंग का मतलब, वाइब कोडिंग का मूल मतलब है.

इसे स्पेसिफ़िकेशनल कोडिंग से अलग माना जाता है.

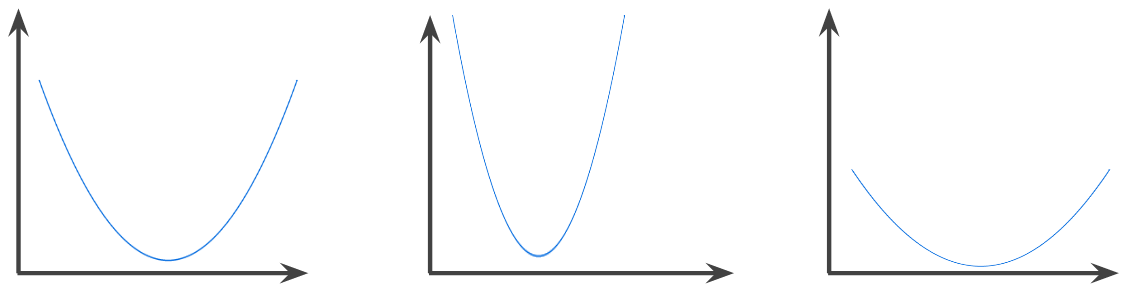

कॉन्वेक्स फ़ंक्शन

ऐसा फ़ंक्शन जिसमें फ़ंक्शन के ग्राफ़ के ऊपर का क्षेत्र, कॉन्वेक्स सेट होता है. प्रोटोटाइपिकल कॉन्वेक्स फ़ंक्शन, U अक्षर की तरह दिखता है. उदाहरण के लिए, यहां दिए गए सभी फ़ंक्शन कॉन्वेक्स फ़ंक्शन हैं:

इसके उलट, यह फ़ंक्शन कॉन्वेक्स नहीं है. ध्यान दें कि ग्राफ़ के ऊपर वाला क्षेत्र, कॉन्वेक्स सेट नहीं है:

स्ट्रिक्टली कॉन्वेक्स फ़ंक्शन में सिर्फ़ एक लोकल मिनिमम पॉइंट होता है, जो ग्लोबल मिनिमम पॉइंट भी होता है. क्लासिक यू-शेप वाले फ़ंक्शन, स्ट्रिक्टली कॉन्वेक्स फ़ंक्शन होते हैं. हालांकि, कुछ कॉन्वेक्स फ़ंक्शन (उदाहरण के लिए, सीधी लाइनें) U-आकार के नहीं होते.

ज़्यादा जानकारी के लिए, मशीन लर्निंग क्रैश कोर्स में कन्वर्जेंस और कॉन्वेक्स फ़ंक्शन देखें.

कॉन्वेक्स ऑप्टिमाइज़ेशन

कॉन्वेक्स फ़ंक्शन के सबसे छोटे मान का पता लगाने के लिए, ग्रेडिएंट डिसेंट जैसी गणितीय तकनीकों का इस्तेमाल करने की प्रोसेस. मशीन लर्निंग में, ज़्यादातर रिसर्च में अलग-अलग समस्याओं को कॉन्वेक्स ऑप्टिमाइज़ेशन की समस्याओं के तौर पर फ़ॉर्म्युलेट करने और उन समस्याओं को ज़्यादा असरदार तरीके से हल करने पर फ़ोकस किया गया है.

पूरी जानकारी के लिए, बॉयड और वैनडेनबर्गहे का कॉन्वेक्स ऑप्टिमाइज़ेशन देखें.

कॉन्वेक्स सेट

यह इयूक्लिडियन स्पेस का एक सबसेट है. इसमें सबसेट के किसी भी दो पॉइंट के बीच खींची गई लाइन, पूरी तरह से सबसेट के अंदर ही रहती है. उदाहरण के लिए, यहां दी गई दो आकृतियां कॉन्वेक्स सेट हैं:

इसके उलट, यहां दी गई दो शेप कॉन्वेक्स सेट नहीं हैं:

कनवोल्यूशन

गणित में, आम तौर पर दो फ़ंक्शन का मिश्रण. मशीन लर्निंग में, कनवोल्यूशन, कनवोल्यूशनल फ़िल्टर और इनपुट मैट्रिक्स को मिलाकर वज़न को ट्रेन करता है.

मशीन लर्निंग में "कनवोल्यूशन" शब्द का इस्तेमाल, अक्सर कनवोल्यूशनल ऑपरेशन या कनवोल्यूशनल लेयर के लिए किया जाता है.

कन्वलूशन के बिना, मशीन लर्निंग एल्गोरिदम को बड़े टेंसर में मौजूद हर सेल के लिए अलग-अलग वेट असाइन करने होंगे. उदाहरण के लिए, 2K x 2K इमेज पर ट्रेनिंग देने वाले मशीन लर्निंग एल्गोरिदम को 40 लाख अलग-अलग वेट का पता लगाना होगा. कनवोल्यूशन की वजह से, मशीन लर्निंग एल्गोरिदम को सिर्फ़ कनवोल्यूशनल फ़िल्टर के हर सेल के लिए वज़न का पता लगाना होता है. इससे मॉडल को ट्रेन करने के लिए ज़रूरी मेमोरी काफ़ी कम हो जाती है. कनवोल्यूशनल फ़िल्टर लागू होने पर, इसे सभी सेल में कॉपी कर दिया जाता है. इससे हर सेल को फ़िल्टर से गुणा किया जाता है.

कनवोल्यूशनल फ़िल्टर

कनवोल्यूशनल ऑपरेशन में शामिल दो ऐक्टर में से एक. (दूसरा ऐक्टर, इनपुट मैट्रिक्स का एक स्लाइस है.) कनवोल्यूशनल फ़िल्टर एक मैट्रिक्स होता है. इसकी रैंक, इनपुट मैट्रिक्स के बराबर होती है, लेकिन इसका आकार छोटा होता है. उदाहरण के लिए, अगर इनपुट मैट्रिक्स 28x28 है, तो फ़िल्टर कोई भी 2D मैट्रिक्स हो सकता है. हालांकि, यह 28x28 से छोटा होना चाहिए.

फ़ोटोग्राफ़िक मैनिपुलेशन में, कनवोल्यूशनल फ़िल्टर की सभी सेल को आम तौर पर एक जैसे पैटर्न में सेट किया जाता है. इसमें एक और शून्य का इस्तेमाल किया जाता है. मशीन लर्निंग में, कनवोल्यूशनल फ़िल्टर में आम तौर पर रैंडम नंबर डाले जाते हैं. इसके बाद, नेटवर्क सबसे सही वैल्यू को ट्रेन करता है.

कनवोल्यूशनल लेयर

डीप न्यूरल नेटवर्क की एक लेयर, जिसमें कनवोल्यूशनल फ़िल्टर, इनपुट मैट्रिक्स से होकर गुज़रता है. उदाहरण के लिए, यहां दिए गए 3x3 कनवोल्यूशनल फ़िल्टर को देखें:

![यह 3x3 मैट्रिक्स है. इसकी वैल्यू ये हैं: [[0,1,0], [1,0,1], [0,1,0]]](https://developers.google.com/static/machine-learning/glossary/images/ConvolutionalFilter33.svg?hl=hi)

इस ऐनिमेशन में, 5x5 इनपुट मैट्रिक्स वाली नौ कनवोल्यूशनल कार्रवाइयों से बनी कनवोल्यूशनल लेयर दिखाई गई है. ध्यान दें कि हर कनवोल्यूशनल ऑपरेशन, इनपुट मैट्रिक्स के अलग-अलग 3x3 स्लाइस पर काम करता है. इसके बाद, 3x3 मैट्रिक्स (दाईं ओर) मिलता है. इसमें नौ कनवोल्यूशनल ऑपरेशन के नतीजे शामिल होते हैं:

![इस ऐनिमेशन में दो मैट्रिक्स दिखाए गए हैं. पहला मैट्रिक्स 5x5 मैट्रिक्स है: [[128,97,53,201,198], [35,22,25,200,195], [37,24,28,197,182], [33,28,92,195,179], [31,40,100,192,177]].

दूसरी मैट्रिक्स, 3x3 मैट्रिक्स है:

[[181,303,618], [115,338,605], [169,351,560]].

दूसरी मैट्रिक्स का हिसाब लगाने के लिए, 5x5 मैट्रिक्स के अलग-अलग 3x3 सबसेट पर कनवोल्यूशनल फ़िल्टर [[0, 1, 0], [1, 0, 1], [0, 1, 0]] लागू किया जाता है.](https://developers.google.com/static/machine-learning/glossary/images/AnimatedConvolution.gif?hl=hi)

कन्वलूशनल न्यूरल नेटवर्क

एक न्यूरल नेटवर्क, जिसमें कम से कम एक लेयर कनवोल्यूशनल लेयर होती है. आम तौर पर, कनवोल्यूशनल न्यूरल नेटवर्क में यहां दी गई लेयर का कोई कॉम्बिनेशन होता है:

कनवोल्यूशनल न्यूरल नेटवर्क, इमेज की पहचान जैसी कुछ तरह की समस्याओं को हल करने में काफ़ी कारगर साबित हुए हैं.

कन्वलूशनल ऑपरेशन

गणित की यह दो चरणों वाली प्रक्रिया:

- कनवोल्यूशनल फ़िल्टर और इनपुट मैट्रिक्स के स्लाइस का एलिमेंट-वाइज़ गुणन. (इनपुट मैट्रिक्स के स्लाइस की रैंक और साइज़, कनवोल्यूशनल फ़िल्टर के बराबर होता है.)

- प्रॉडक्ट मैट्रिक्स में मौजूद सभी वैल्यू का जोड़.

उदाहरण के लिए, यहां दी गई 5x5 इनपुट मैट्रिक्स देखें:

![5x5 मैट्रिक्स: [[128,97,53,201,198], [35,22,25,200,195],

[37,24,28,197,182], [33,28,92,195,179], [31,40,100,192,177]].](https://developers.google.com/static/machine-learning/glossary/images/ConvolutionalLayerInputMatrix.svg?hl=hi)

अब इस 2x2 कनवोल्यूशनल फ़िल्टर के बारे में सोचें:

![2x2 मैट्रिक्स: [[1, 0], [0, 1]]](https://developers.google.com/static/machine-learning/glossary/images/ConvolutionalLayerFilter.svg?hl=hi)

हर कनवोल्यूशनल ऑपरेशन में, इनपुट मैट्रिक्स का एक 2x2 स्लाइस शामिल होता है. उदाहरण के लिए, मान लें कि हम इनपुट मैट्रिक्स के ऊपर-बाएं कोने पर मौजूद 2x2 स्लाइस का इस्तेमाल करते हैं. इसलिए, इस स्लाइस पर कनवोल्यूशन ऑपरेशन ऐसा दिखता है:

![इनपुट मैट्रिक्स के सबसे ऊपर बाईं ओर मौजूद 2x2 सेक्शन पर, कनवोल्यूशनल फ़िल्टर [[1, 0], [0, 1]] लागू किया गया है. यह सेक्शन [[128,97], [35,22]] है.

कनवोल्यूशनल फ़िल्टर, 128 और 22 को पहले जैसा ही रखता है. हालांकि, यह 97 और 35 को शून्य कर देता है. इसलिए, कनवोल्यूशन ऑपरेशन से 150 (128+22) वैल्यू मिलती है.](https://developers.google.com/static/machine-learning/glossary/images/ConvolutionalLayerOperation.svg?hl=hi)

कन्वलूशनल लेयर में, कन्वलूशनल कार्रवाइयों की एक सीरीज़ होती है. इनमें से हर कार्रवाई, इनपुट मैट्रिक्स के अलग-अलग स्लाइस पर काम करती है.

COPA

संभावित विकल्पों का चुनाव के लिए छोटा नाम.

लागत

loss के लिए समानार्थी शब्द.

को-ट्रेनिंग

सेमी-सुपरवाइज़्ड लर्निंग का तरीका, खास तौर पर तब काम आता है, जब ये सभी शर्तें पूरी होती हैं:

- डेटासेट में, बिना लेबल वाले उदाहरणों का अनुपात, लेबल वाले उदाहरणों के मुकाबले ज़्यादा है.

- यह एक क्लासिफ़िकेशन समस्या है (बाइनरी या मल्टी-क्लास).

- डेटासेट में अनुमान लगाने वाली सुविधाओं के दो अलग-अलग सेट होते हैं. ये एक-दूसरे से अलग होते हैं और एक-दूसरे के पूरक होते हैं.

को-ट्रेनिंग, अलग-अलग सिग्नल को मिलाकर एक बेहतर सिग्नल बनाती है. उदाहरण के लिए, कैटगरी तय करने वाले मॉडल पर विचार करें. यह मॉडल, इस्तेमाल की गई अलग-अलग कारों को अच्छी या खराब के तौर पर कैटगरी में बांटता है. अनुमान लगाने वाली सुविधाओं का एक सेट, कार की कुल विशेषताओं पर फ़ोकस कर सकता है. जैसे, कार का साल, ब्रैंड, और मॉडल. अनुमान लगाने वाली सुविधाओं का दूसरा सेट, पिछले मालिक के ड्राइविंग रिकॉर्ड और कार के रखरखाव के इतिहास पर फ़ोकस कर सकता है.

को-ट्रेनिंग पर सबसे अहम पेपर, ब्लम और मिशेल का Combining Labeled and Unlabeled Data with Co-Training है.

काउंटरफ़ैक्चुअल फ़ेयरनेस

यह एक निष्पक्षता मेट्रिक है. इससे यह पता चलता है कि क्या क्लासिफ़िकेशन मॉडल, एक व्यक्ति के लिए वही नतीजा देता है जो वह दूसरे व्यक्ति के लिए देता है. हालांकि, दूसरा व्यक्ति पहले व्यक्ति जैसा ही होता है. इसमें एक या उससे ज़्यादा संवेदनशील एट्रिब्यूट को छोड़कर, बाकी सभी एट्रिब्यूट एक जैसे होते हैं. क्लासिफ़िकेशन मॉडल का आकलन करके, यह पता लगाया जा सकता है कि मॉडल में पक्षपात के संभावित सोर्स कौनसे हैं.

ज़्यादा जानकारी के लिए, इनमें से कोई एक लेख पढ़ें:

- मशीन लर्निंग क्रैश कोर्स में, निष्पक्षता: काउंटरफ़ैक्चुअल निष्पक्षता के बारे में जानें.

- When Worlds Collide: Integrating Different Counterfactual Assumptions in Fairness

कवरेज बायस

चुने जाने का पूर्वाग्रह देखें.

क्रैश ब्लॉसम

ऐसा वाक्य या वाक्यांश जिसका मतलब साफ़ तौर पर समझ में न आ रहा हो. क्रैश ब्लॉसम, नैचुरल लैंग्वेज अंडरस्टैंडिंग में एक बड़ी समस्या पैदा करते हैं. उदाहरण के लिए, लाल फ़ीता गगनचुंबी इमारत को रोक देता है हेडलाइन, क्रैश ब्लॉसम है. ऐसा इसलिए, क्योंकि एनएलयू मॉडल इस हेडलाइन का शाब्दिक या लाक्षणिक अर्थ निकाल सकता है.

आलोचक

डीप क्यू-नेटवर्क का समानार्थी शब्द.

क्रॉस-एंट्रॉपी

यह लॉग लॉस का सामान्यीकरण है. इसका इस्तेमाल एक से ज़्यादा क्लास वाले क्लासिफ़िकेशन की समस्याओं को हल करने के लिए किया जाता है. क्रॉस-एंट्रॉपी, दो प्रायिकता बंटनों के बीच के अंतर को मेज़र करती है. perplexity भी देखें.

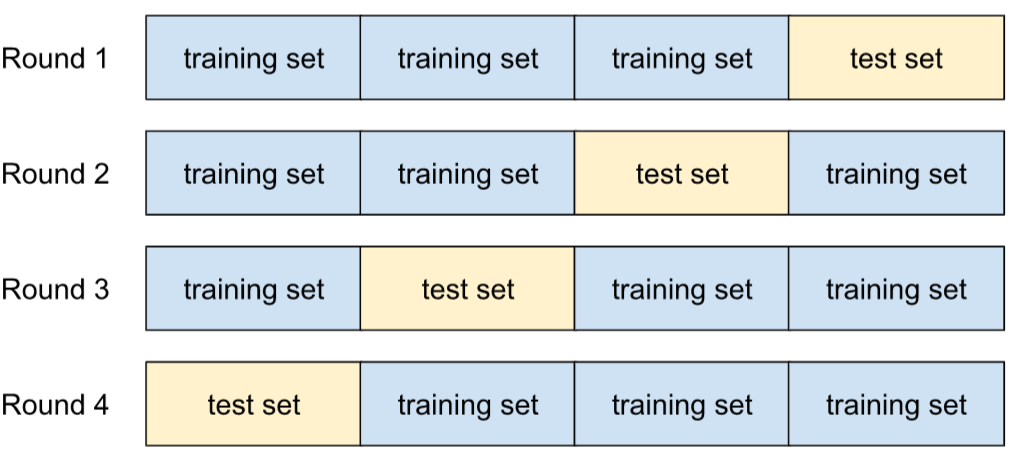

क्रॉस-वैलिडेशन

यह एक ऐसा तरीका है जिससे यह अनुमान लगाया जा सकता है कि मॉडल नए डेटा के लिए कितना सही काम करेगा. इसके लिए, मॉडल को एक या उससे ज़्यादा ऐसे डेटा सबसेट के ख़िलाफ़ टेस्ट किया जाता है जो ट्रेनिंग सेट से अलग होते हैं.

क्यूमुलेटिव डिस्ट्रीब्यूशन फ़ंक्शन (सीडीएफ़)

यह फ़ंक्शन, टारगेट वैल्यू से कम या उसके बराबर सैंपल की फ़्रीक्वेंसी तय करता है. उदाहरण के लिए, लगातार वैल्यू के सामान्य डिस्ट्रिब्यूशन पर विचार करें. सीडीएफ़ से पता चलता है कि लगभग 50% सैंपल, औसत से कम या उसके बराबर होने चाहिए. साथ ही, लगभग 84% सैंपल, औसत से एक स्टैंडर्ड डेविएशन से कम या उसके बराबर होने चाहिए.

D

डेटा का विश्लेषण

सैंपल, मेज़रमेंट, और विज़ुअलाइज़ेशन की मदद से डेटा को समझना. डेटा विश्लेषण, खास तौर पर तब काम आ सकता है, जब पहली बार कोई डेटासेट मिलता है. ऐसा पहली मॉडल बनाने से पहले किया जाता है. यह सिस्टम से जुड़ी समस्याओं को डीबग करने और एक्सपेरिमेंट को समझने में भी अहम भूमिका निभाता है.

डेटा बढ़ाना

मौजूदा उदाहरणों को बदलकर, ट्रेनिंग के उदाहरणों की रेंज और संख्या को बढ़ाना. उदाहरण के लिए, मान लें कि इमेज आपकी सुविधाओं में से एक है, लेकिन आपके डेटासेट में इमेज के ऐसे उदाहरण मौजूद नहीं हैं जिनसे मॉडल को काम के असोसिएशन के बारे में जानकारी मिल सके. हमारा सुझाव है कि आप अपने डेटासेट में, ज़रूरत के मुताबिक लेबल की गई इमेज जोड़ें, ताकि आपके मॉडल को सही तरीके से ट्रेन किया जा सके. अगर ऐसा नहीं होता है, तो डेटा ऑगमेंटेशन की मदद से, हर इमेज को घुमाया, स्ट्रेच किया, और पलटा जा सकता है. इससे ओरिजनल इमेज के कई वैरिएंट बनाए जा सकते हैं. इससे शायद लेबल किया गया इतना डेटा मिल जाए कि मॉडल को बेहतर तरीके से ट्रेन किया जा सके.

DataFrame

यह pandas का एक लोकप्रिय डेटा टाइप है. इसका इस्तेमाल मेमोरी में डेटासेट को दिखाने के लिए किया जाता है.

डेटाफ़्रेम, टेबल या स्प्रेडशीट की तरह होता है. डेटाफ़्रेम के हर कॉलम का एक नाम (हेडर) होता है. साथ ही, हर लाइन की पहचान एक यूनीक नंबर से होती है.

डेटाफ़्रेम में मौजूद हर कॉलम को 2D ऐरे की तरह स्ट्रक्चर किया जाता है. हालांकि, हर कॉलम को उसका डेटा टाइप असाइन किया जा सकता है.

आधिकारिक pandas.DataFrame रेफ़रंस पेज भी देखें.

डेटा पैरललिज़्म

यह ट्रेनिंग या अनुमान को स्केल करने का एक तरीका है. इसमें पूरे मॉडल को कई डिवाइसों पर कॉपी किया जाता है. इसके बाद, इनपुट डेटा के सबसेट को हर डिवाइस पर भेजा जाता है. डेटा पैरललिज़्म की मदद से, बहुत बड़े बैच साइज़ पर ट्रेनिंग और अनुमान लगाया जा सकता है. हालांकि, डेटा पैरललिज़्म के लिए ज़रूरी है कि मॉडल इतना छोटा हो कि वह सभी डिवाइसों पर फ़िट हो जाए.

डेटा पैरललिज़्म से, आम तौर पर ट्रेनिंग और अनुमान लगाने की प्रोसेस तेज़ हो जाती है.

मॉडल पैरललिज़्म के बारे में भी जानें.

Dataset API (tf.data)

यह डेटा को पढ़ने और उसे ऐसे फ़ॉर्म में बदलने के लिए, TensorFlow का हाई-लेवल एपीआई है जिसकी ज़रूरत मशीन लर्निंग एल्गोरिदम को होती है.

tf.data.Dataset ऑब्जेक्ट, एलिमेंट के क्रम को दिखाता है. इसमें हर एलिमेंट में एक या उससे ज़्यादा टेंसर होते हैं. tf.data.Iterator ऑब्जेक्ट, Dataset के एलिमेंट का ऐक्सेस देता है.

डेटा सेट या डेटासेट

रॉ डेटा का कलेक्शन. आम तौर पर (लेकिन सिर्फ़) इसे इनमें से किसी एक फ़ॉर्मैट में व्यवस्थित किया जाता है:

- स्प्रेडशीट

- CSV (कॉमा लगाकर अलग की गई वैल्यू) फ़ॉर्मैट वाली फ़ाइल

डिसिज़न बाउंड्री

यह बाइनरी क्लास या मल्टी-क्लास क्लासिफ़िकेशन की समस्याओं में, मॉडल से सीखी गई क्लास के बीच का सेपरेटर होता है. उदाहरण के लिए, बाइनरी क्लासिफ़िकेशन की समस्या को दिखाने वाली इस इमेज में, फ़ैसले की सीमा, ऑरेंज क्लास और नीली क्लास के बीच की सीमा है:

डिसीज़न फ़ॉरेस्ट

यह मॉडल, कई डिसिज़न ट्री से बनाया जाता है. डिसिज़न फ़ॉरेस्ट, अपने डिसिज़न ट्री की मदद से अनुमान लगाता है. फ़ैसले लेने वाले फ़ॉरेस्ट के लोकप्रिय टाइप में, रैंडम फ़ॉरेस्ट और ग्रेडिएंट बूस्टेड ट्री शामिल हैं.

ज़्यादा जानकारी के लिए, Decision Forests कोर्स में Decision Forests सेक्शन देखें.

फ़ैसले का थ्रेशोल्ड

क्लासिफ़िकेशन थ्रेशोल्ड के लिए समानार्थी शब्द.

डिसीज़न ट्री

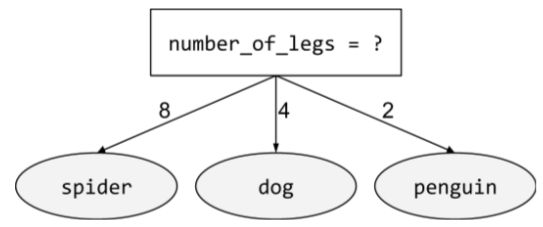

यह एक सुपरवाइज़्ड लर्निंग मॉडल है. इसमें शर्तों और लीफ़ का एक सेट होता है, जिसे क्रम से व्यवस्थित किया जाता है. उदाहरण के लिए, यहां एक फ़्लोचार्ट दिया गया है:

डिकोडर

आम तौर पर, कोई भी एमएल सिस्टम जो प्रोसेस किए गए, डेंस या इंटरनल रिप्रेजेंटेशन को ज़्यादा रॉ, स्पार्स या एक्सटर्नल रिप्रेजेंटेशन में बदलता है.

डिकोडर अक्सर किसी बड़े मॉडल का हिस्सा होते हैं. इनमें अक्सर एन्कोडर का इस्तेमाल किया जाता है.

सीक्वेंस-टू-सीक्वेंस टास्क में, डिकोडर, एन्कोडर से जनरेट की गई इंटरनल स्टेट से शुरू होता है, ताकि अगले सीक्वेंस का अनुमान लगाया जा सके.

ट्रांसफ़ॉर्मर आर्किटेक्चर में डिकोडर की परिभाषा के लिए, ट्रांसफ़ॉर्मर देखें.

ज़्यादा जानकारी के लिए, मशीन लर्निंग क्रैश कोर्स में लार्ज लैंग्वेज मॉडल देखें.

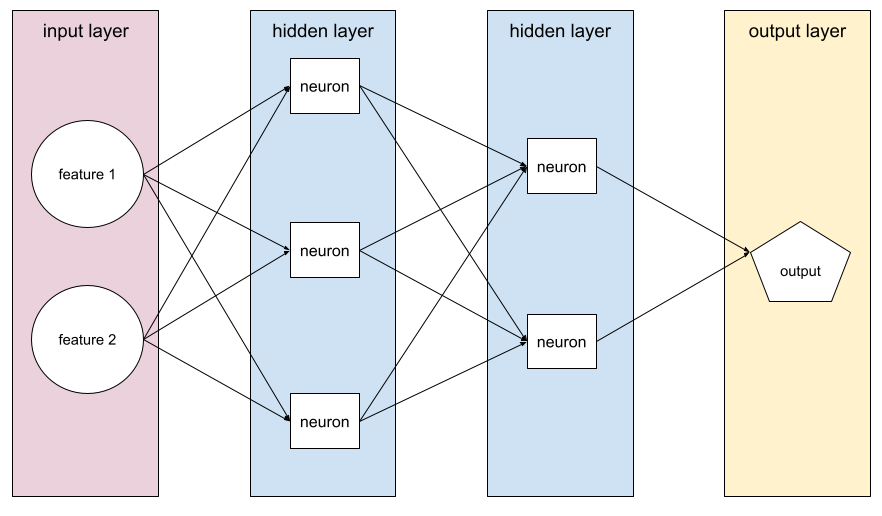

डीप मॉडल

एक न्यूरल नेटवर्क, जिसमें एक से ज़्यादा हिडन लेयर होती हैं.

डीप मॉडल को डीप न्यूरल नेटवर्क भी कहा जाता है.

वाइड मॉडल से तुलना करें.

डीप न्यूरल नेटवर्क

डीप मॉडल के लिए समानार्थी शब्द.

डीप क्यू-नेटवर्क (डीक्यूएन)

Q-लर्निंग में, डीप न्यूरल नेटवर्क Q-फ़ंक्शन का अनुमान लगाता है.

Critic, Deep Q-Network का दूसरा नाम है.

डेमोग्राफ़िक पैरिटी

यह एक निष्पक्षता मेट्रिक है. यह तब पूरी होती है, जब मॉडल के क्लासिफ़िकेशन के नतीजे, दिए गए संवेदनशील एट्रिब्यूट पर निर्भर न हों.

उदाहरण के लिए, अगर ग्लबडबड्रिब यूनिवर्सिटी में लिलीपुटियन और ब्रॉबडिंगनैगियन, दोनों आवेदन करते हैं, तो डेमोग्राफ़िक पैरिटी तब हासिल होती है, जब यूनिवर्सिटी में भर्ती किए गए लिलीपुटियन का प्रतिशत, भर्ती किए गए ब्रॉबडिंगनैगियन के प्रतिशत के बराबर हो. भले ही, एक ग्रुप औसतन दूसरे ग्रुप से ज़्यादा क्वालिफ़ाइड हो.

इसकी तुलना समान अवसर और समान संभावना से करें. ये दोनों सिद्धांत, क्लासिफ़िकेशन के कुल नतीजों को संवेदनशील एट्रिब्यूट पर निर्भर रहने की अनुमति देते हैं. हालांकि, ये सिद्धांत, ग्राउंड ट्रुथ के कुछ खास लेबल के लिए, क्लासिफ़िकेशन के नतीजों को संवेदनशील एट्रिब्यूट पर निर्भर रहने की अनुमति नहीं देते. डेमोग्राफ़िक समानता के लिए ऑप्टिमाइज़ करते समय, फ़ायदे और नुकसान के बारे में जानने के लिए, "स्मार्ट मशीन लर्निंग की मदद से भेदभाव को खत्म करना" लेख में दिया गया विज़ुअलाइज़ेशन देखें.

ज़्यादा जानकारी के लिए, मशीन लर्निंग क्रैश कोर्स में निष्पक्षता: डेमोग्राफ़िक समानता देखें.

डिनॉइज़िंग

सेल्फ़-सुपरवाइज़्ड लर्निंग का एक सामान्य तरीका, जिसमें:

- डेटासेट में नॉइज़ को आर्टिफ़िशियली जोड़ा जाता है.

- मॉडल, ग़ैर-ज़रूरी आवाज़ें कम करने की कोशिश करता है.

डीनॉइज़िंग की मदद से, बिना लेबल वाले उदाहरणों से सीखा जा सकता है. ओरिजनल डेटासेट को टारगेट या लेबल के तौर पर इस्तेमाल किया जाता है. वहीं, नॉइज़ी डेटा को इनपुट के तौर पर इस्तेमाल किया जाता है.

कुछ मास्क किए गए लैंग्वेज मॉडल, इस तरह से डीनॉइज़िंग का इस्तेमाल करते हैं:

- बिना लेबल वाले वाक्य में, कुछ टोकन को मास्क करके आर्टिफ़िशियल नॉइज़ जोड़ा जाता है.

- मॉडल, ओरिजनल टोकन का अनुमान लगाने की कोशिश करता है.

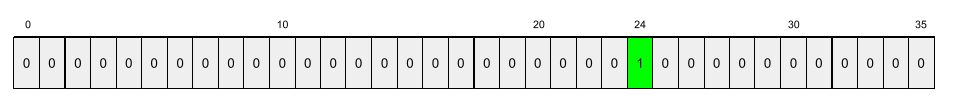

डेंस फ़ीचर

यह एक सुविधा है, जिसमें ज़्यादातर या सभी वैल्यू शून्य नहीं होती हैं. आम तौर पर, यह फ़्लोटिंग-पॉइंट वैल्यू का टेंसर होता है. उदाहरण के लिए, नीचे दिया गया 10 एलिमेंट वाला टेंसर डेंस है, क्योंकि इसकी 9 वैल्यू शून्य नहीं हैं:

| 8 | 3 | 7 | 5 | 2 | 4 | 0 | 4 | 9 | 6 |

इसकी तुलना विरल सुविधा से करें.

डेंस लेयर

पूरी तरह से कनेक्ट की गई लेयर के लिए समानार्थी शब्द.

गहराई

न्यूरल नेटवर्क में, इन वैल्यू का योग:

- छिपी हुई लेयर की संख्या

- आउटपुट लेयर की संख्या, जो आम तौर पर 1 होती है

- किसी भी embedding layers की संख्या

उदाहरण के लिए, पांच छिपी हुई लेयर और एक आउटपुट लेयर वाले न्यूरल नेटवर्क की डेप्थ 6 होती है.

ध्यान दें कि इनपुट लेयर से डेप्थ पर कोई असर नहीं पड़ता.

डेप्थवाइज़ सेपरेबल कॉन्वोलूशनल न्यूरल नेटवर्क (sepCNN)

यह कन्वलूशनल न्यूरल नेटवर्क आर्किटेक्चर, Inception पर आधारित है. हालांकि, इसमें Inception मॉड्यूल को डेप्थवाइज़ सेपरेबल कन्वलूशन से बदल दिया गया है. इसे Xception के नाम से भी जाना जाता है.

डेप्थवाइज़ सेपरेबल कनवोल्यूशन (इसे सेपरेबल कनवोल्यूशन भी कहा जाता है) एक स्टैंडर्ड 3D कनवोल्यूशन को दो अलग-अलग कनवोल्यूशन ऑपरेशन में बदल देता है. ये ऑपरेशन, कंप्यूटेशनल तौर पर ज़्यादा असरदार होते हैं: पहला, डेप्थवाइज़ कनवोल्यूशन, जिसकी डेप्थ 1 (n ✕ n ✕ 1) होती है. दूसरा, पॉइंटवाइज़ कनवोल्यूशन, जिसकी लंबाई और चौड़ाई 1 (1 ✕ 1 ✕ n) होती है.

ज़्यादा जानने के लिए, Xception: Deep Learning with Depthwise Separable Convolutions लेख पढ़ें.

डिराइव किया गया लेबल

प्रॉक्सी लेबल के लिए समानार्थी शब्द.

डिवाइस

एक ऐसा शब्द जिसके कई मतलब होते हैं. इसके दो मतलब हो सकते हैं:

- यह हार्डवेयर की एक कैटगरी है, जो TensorFlow सेशन चला सकती है. इसमें सीपीयू, जीपीयू, और TPU शामिल हैं.

- ऐक्सलरेटर चिप (GPU या TPU) पर एमएल मॉडल को ट्रेन करते समय, सिस्टम का वह हिस्सा जो टेंसर और एम्बेडिंग को मैनेज करता है. डिवाइस, ऐक्सलरेटर चिप पर काम करता है. इसके उलट, होस्ट आम तौर पर सीपीयू पर चलता है.

डिफ़रेंशियल प्राइवसी

मशीन लर्निंग में, किसी मॉडल के ट्रेनिंग सेट में शामिल किसी भी संवेदनशील डेटा (उदाहरण के लिए, किसी व्यक्ति की निजी जानकारी) को सुरक्षित रखने के लिए, पहचान छिपाने का तरीका. इस तरीके से यह पक्का किया जाता है कि मॉडल को किसी व्यक्ति के बारे में ज़्यादा जानकारी न मिले और न ही वह उसे याद रखे. मॉडल ट्रेनिंग के दौरान, सैंपलिंग और नॉइज़ जोड़ने की प्रोसेस से ऐसा किया जाता है. इससे अलग-अलग डेटा पॉइंट को छिपाने में मदद मिलती है. साथ ही, ट्रेनिंग के लिए इस्तेमाल किए गए संवेदनशील डेटा के लीक होने का जोखिम कम हो जाता है.

डिफ़रेंशियल प्राइवसी का इस्तेमाल, मशीन लर्निंग के अलावा भी किया जाता है. उदाहरण के लिए, डेटा साइंटिस्ट कभी-कभी अलग-अलग डेमोग्राफ़िक के लिए प्रॉडक्ट के इस्तेमाल के आंकड़े कैलकुलेट करते समय, व्यक्तिगत निजता को सुरक्षित रखने के लिए डिफ़रेंशियल प्राइवसी का इस्तेमाल करते हैं.

डाइमेंशन कम करना

किसी फ़ीचर वेक्टर में, किसी फ़ीचर को दिखाने के लिए इस्तेमाल किए गए डाइमेंशन की संख्या को कम करना. आम तौर पर, ऐसा एंबेडिंग वेक्टर में बदलकर किया जाता है.

आयाम

ओवरलोड किए गए ऐसे शब्द जिनकी परिभाषाएं इनमें से कोई एक हो:

किसी Tensor में कोऑर्डिनेट के लेवल की संख्या. उदाहरण के लिए:

- स्केलर में कोई डाइमेंशन नहीं होता. उदाहरण के लिए,

["Hello"]. - वेक्टर में एक डाइमेंशन होता है. उदाहरण के लिए,

[3, 5, 7, 11]. - मैट्रिक्स में दो डाइमेंशन होते हैं. उदाहरण के लिए,

[[2, 4, 18], [5, 7, 14]]. एक डाइमेंशन वाले वेक्टर में किसी सेल को यूनीक तरीके से तय करने के लिए, एक कोऑर्डिनेट की ज़रूरत होती है. वहीं, दो डाइमेंशन वाले मैट्रिक्स में किसी सेल को यूनीक तरीके से तय करने के लिए, दो कोऑर्डिनेट की ज़रूरत होती है.

- स्केलर में कोई डाइमेंशन नहीं होता. उदाहरण के लिए,

फ़ीचर वेक्टर में मौजूद एंट्री की संख्या.

एम्बेडिंग लेयर में मौजूद एलिमेंट की संख्या.

सीधे तौर पर प्रॉम्प्ट देना

ज़ीरो-शॉट प्रॉम्प्ट के लिए समानार्थी शब्द.

डिस्क्रीट सुविधा

ऐसी सुविधा जिसमें संभावित वैल्यू का एक सीमित सेट होता है. उदाहरण के लिए, ऐसी सुविधा जिसकी वैल्यू सिर्फ़ animal, vegetable या mineral हो सकती है, वह डिसक्रीट (या कैटगरी वाली) सुविधा होती है.

लगातार चलने वाली सुविधा से तुलना करें.

भेदभाव करने वाला मॉडल

यह एक मॉडल है. यह एक या उससे ज़्यादा विशेषताओं के सेट से लेबल का अनुमान लगाता है. ज़्यादा औपचारिक तौर पर, डिसक्रिमिनेटिव मॉडल, सुविधाओं और वज़न के आधार पर किसी आउटपुट की शर्त वाली संभावना को तय करते हैं. इसका मतलब है कि:

p(output | features, weights)

उदाहरण के लिए, ऐसा मॉडल जो सुविधाओं और वज़न के आधार पर यह अनुमान लगाता है कि कोई ईमेल स्पैम है या नहीं, एक भेदभाव करने वाला मॉडल है.

ज़्यादातर सुपरवाइज़्ड लर्निंग मॉडल, डिसक्रिमिनेटिव मॉडल होते हैं. इनमें क्लासिफ़िकेशन और रिग्रेशन मॉडल शामिल हैं.

इसकी तुलना जनरेटिव मॉडल से करें.

डिस्क्रिमिनेटर

यह सिस्टम यह तय करता है कि उदाहरण असली हैं या नकली.

इसके अलावा, जनरेटिव एडवर्सैरियल नेटवर्क में मौजूद वह सबसिस्टम जो यह तय करता है कि जनरेटर से बनाए गए उदाहरण असली हैं या नकली.

ज़्यादा जानकारी के लिए, GAN कोर्स में डिसक्रिमिनेटर देखें.

अलग-अलग असर

लोगों के बारे में ऐसे फ़ैसले लेना जिनसे जनसंख्या के अलग-अलग उपसमूहों पर काफ़ी असर पड़ता है. आम तौर पर, इसका मतलब ऐसी स्थितियों से होता है जहां एल्गोरिदम के आधार पर लिए गए फ़ैसले से, कुछ उपसमूहों को दूसरों की तुलना में ज़्यादा फ़ायदा या नुकसान होता है.

उदाहरण के लिए, मान लें कि एक एल्गोरिदम, किसी बौने व्यक्ति के छोटे घर के लिए लिए जाने वाले होम लोन के लिए ज़रूरी शर्तें पूरी करने की स्थिति का पता लगाता है. अगर उसके पते में कोई खास पिन कोड है, तो एल्गोरिदम उसे "ज़रूरी शर्तें पूरी नहीं करता" के तौर पर क्लासिफ़ाई कर सकता है. अगर बिग-एंडियन लिलिपुटियन के पास लिटिल-एंडियन लिलिपुटियन की तुलना में इस पिन कोड वाले ज़्यादा पते हैं, तो इस एल्गोरिदम का असर अलग-अलग हो सकता है.

अलग-अलग तरह से व्यवहार करना, इस बात पर फ़ोकस करता है कि जब एल्गोरिदम के फ़ैसले लेने की प्रोसेस में, सबग्रुप की विशेषताओं को साफ़ तौर पर इनपुट के तौर पर इस्तेमाल किया जाता है, तब असमानताएं कैसे पैदा होती हैं.

अलग-अलग तरह का व्यवहार

एल्गोरिदम के आधार पर फ़ैसला लेने की प्रोसेस में, विषयों के संवेदनशील एट्रिब्यूट को ध्यान में रखा जाता है. इससे लोगों के अलग-अलग सबग्रुप के साथ अलग-अलग व्यवहार किया जाता है.

उदाहरण के लिए, मान लें कि कोई एल्गोरिदम, बौने लोगों के लिए छोटे घर के लिए क़र्ज़ पाने की ज़रूरी शर्तें तय करता है. यह एल्गोरिदम, क़र्ज़ के लिए किए गए आवेदन में दिए गए डेटा के आधार पर यह फ़ैसला लेता है. अगर एल्गोरिदम, इनपुट के तौर पर Lilliputian के अफ़िलिएशन का इस्तेमाल Big-Endian या Little-Endian के तौर पर करता है, तो वह उस डाइमेंशन के हिसाब से अलग-अलग तरह से काम कर रहा है.

यह अलग-अलग असर से अलग है. इसमें, एल्गोरिदम के फ़ैसलों से समाज के अलग-अलग ग्रुप पर पड़ने वाले असर में अंतर पर फ़ोकस किया जाता है. भले ही, वे ग्रुप मॉडल के इनपुट हों या न हों.

डिस्टिलेशन

किसी मॉडल (जिसे टीचर कहा जाता है) के साइज़ को कम करके, उसे छोटे मॉडल (जिसे छात्र कहा जाता है) में बदलना. यह छोटा मॉडल, ओरिजनल मॉडल के अनुमानों को ज़्यादा से ज़्यादा सटीक तरीके से दोहराता है. डिस्टिलेशन फ़ायदेमंद है, क्योंकि छोटे मॉडल को बड़े मॉडल (टीचर) के मुकाबले दो मुख्य फ़ायदे मिलते हैं:

- जवाब देने में कम समय लगता है

- मेमोरी और बैटरी की खपत कम होती है

हालांकि, छात्र या छात्रा के अनुमान आम तौर पर शिक्षक के अनुमानों जितने सटीक नहीं होते.

डिस्टिलेशन, छात्र मॉडल को इस तरह से ट्रेन करता है कि वह लॉस फ़ंक्शन को कम कर सके. यह छात्र और शिक्षक मॉडल की अनुमानित वैल्यू के बीच के अंतर पर आधारित होता है.

आसवन की तुलना इन शब्दों से करें:

ज़्यादा जानकारी के लिए, मशीन लर्निंग क्रैश कोर्स में एलएलएम: फ़ाइन-ट्यूनिंग, डिस्टिलेशन, और प्रॉम्प्ट इंजीनियरिंग देखें.

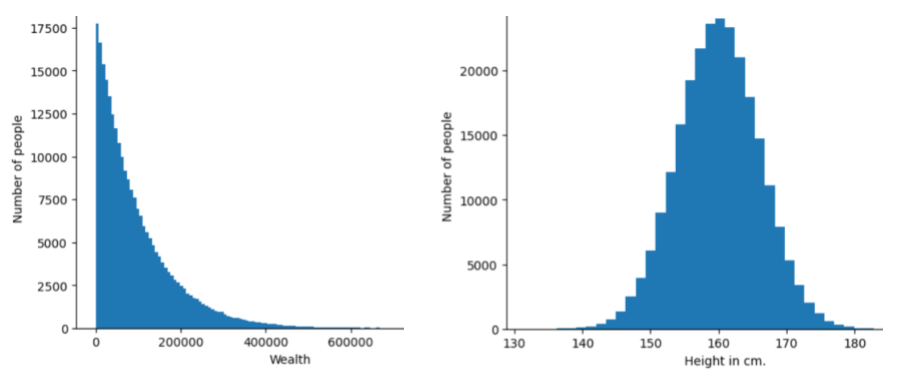

डिस्ट्रिब्यूशन

किसी विशेषता या लेबल के लिए, अलग-अलग वैल्यू कितनी बार और किस रेंज में दी गई हैं. डेटा डिस्ट्रिब्यूशन से पता चलता है कि किसी वैल्यू के होने की कितनी संभावना है.

इस इमेज में, दो अलग-अलग डिस्ट्रिब्यूशन के हिस्टोग्राम दिखाए गए हैं:

- बाईं ओर, धन और उसे रखने वाले लोगों की संख्या का पावर लॉ डिस्ट्रिब्यूशन दिखाया गया है.

- दाईं ओर, लंबाई के हिसाब से लोगों की संख्या का सामान्य डिस्ट्रिब्यूशन दिखाया गया है.

हर सुविधा और लेबल के डिस्ट्रिब्यूशन को समझने से, आपको वैल्यू को नॉर्मलाइज़ करने और आउटलायर का पता लगाने में मदद मिल सकती है.

आउट ऑफ़ डिस्ट्रिब्यूशन वाक्यांश का मतलब ऐसी वैल्यू से है जो डेटासेट में नहीं दिखती या बहुत कम दिखती है. उदाहरण के लिए, अगर किसी डेटासेट में सिर्फ़ बिल्ली की इमेज हैं, तो उसमें शनि ग्रह की इमेज को डिस्ट्रिब्यूशन से बाहर माना जाएगा.

डिविज़िव क्लस्टरिंग

हैरारिकल क्लस्टरिंग देखें.

डाउनसैंपलिंग

यह एक ऐसा शब्द है जिसके कई मतलब हो सकते हैं. इसका मतलब इनमें से कोई भी हो सकता है:

- मॉडल को ज़्यादा असरदार तरीके से ट्रेन करने के लिए, किसी सुविधा में मौजूद जानकारी को कम करना. उदाहरण के लिए, इमेज पहचानने वाले मॉडल को ट्रेनिंग देने से पहले, ज़्यादा रिज़ॉल्यूशन वाली इमेज को कम रिज़ॉल्यूशन वाले फ़ॉर्मैट में डाउनसैंपल करना.

- जिन क्लास के उदाहरण ज़्यादा मौजूद हैं उनके बहुत कम प्रतिशत पर ट्रेनिंग दी जाती है, ताकि जिन क्लास के उदाहरण कम मौजूद हैं उनके लिए मॉडल की ट्रेनिंग को बेहतर बनाया जा सके. उदाहरण के लिए, क्लास-इंबैलेंस वाले डेटासेट में, मॉडल मेजोरिटी क्लास के बारे में ज़्यादा सीखते हैं और माइनॉरिटी क्लास के बारे में कम सीखते हैं. डाउनसैंपलिंग से, ज़्यादातर और कम संख्या वाली क्लास के लिए ट्रेनिंग के डेटा को बैलेंस करने में मदद मिलती है.

ज़्यादा जानकारी के लिए, मशीन लर्निंग क्रैश कोर्स में डेटासेट: असंतुलित डेटासेट देखें.

DQN

डीप क्यू-नेटवर्क का संक्षिप्त नाम.

ड्रॉपआउट रेगुलराइज़ेशन

यह रेगुलराइज़ेशन का एक तरीका है, जो न्यूरल नेटवर्क को ट्रेन करने में मददगार होता है. ड्रॉपआउट रेगुलराइज़ेशन, किसी नेटवर्क लेयर में यूनिट की तय संख्या को एक ग्रेडिएंट स्टेप के लिए हटा देता है. जितनी ज़्यादा यूनिट हटाई जाती हैं, रेगुलराइज़ेशन उतना ही ज़्यादा होता है. यह छोटे नेटवर्क के एन्सेम्बल की नकल करने के लिए नेटवर्क को ट्रेन करने जैसा है. पूरी जानकारी के लिए, ड्रॉपआउट: न्यूरल नेटवर्क को ओवरफ़िटिंग से रोकने का आसान तरीका देखें.

डाइनैमिक

कोई काम जो अक्सर या लगातार किया जाता है. मशीन लर्निंग में, डाइनैमिक और ऑनलाइन शब्द एक-दूसरे के समानार्थी हैं. मशीन लर्निंग में, डाइनैमिक और ऑनलाइन का इस्तेमाल आम तौर पर इन कामों के लिए किया जाता है:

- डाइनैमिक मॉडल (या ऑनलाइन मॉडल) एक ऐसा मॉडल होता है जिसे बार-बार या लगातार फिर से ट्रेन किया जाता है.

- डाइनैमिक ट्रेनिंग (या ऑनलाइन ट्रेनिंग) का मतलब है कि ट्रेनिंग को बार-बार या लगातार दिया जाता है.

- डाइनैमिक इन्फ़रेंस (या ऑनलाइन इन्फ़रेंस) एक ऐसी प्रोसेस है जिसमें मांग के आधार पर अनुमान जनरेट किए जाते हैं.

डाइनैमिक मॉडल