Dieses Glossar definiert Begriffe der künstlichen Intelligenz.

A

Ablation

Eine Technik zur Bewertung der Wichtigkeit eines Feature oder einer Komponente durch vorübergehendes Entfernen aus einem Model. Anschließend trainieren Sie das Modell ohne dieses Feature oder diese Komponente neu. Wenn das neu trainierte Modell deutlich schlechter abschneidet, war das entfernte Feature oder die entfernte Komponente wahrscheinlich wichtig.

Angenommen, Sie trainieren ein Klassifizierungsmodell mit 10 Features und erreichen eine Präzision von 88% für das Test-Dataset. Um die Wichtigkeit des ersten Merkmals zu überprüfen, können Sie das Modell nur mit den neun anderen Merkmalen neu trainieren. Wenn das neu trainierte Modell deutlich schlechter abschneidet (zum Beispiel eine Genauigkeit von 55 %), dann war das entfernte Merkmal wahrscheinlich wichtig. Umgekehrt gilt: Wenn das neu trainierte Modell genauso gut abschneidet, dann war dieses Merkmal wahrscheinlich nicht so wichtig.

Mit der Ablation lässt sich auch die Bedeutung von Folgendem ermitteln:

- Größere Komponenten, wie beispielsweise ein ganzes Teilsystem eines größeren ML-Systems

- Prozesse oder Techniken, z. B. ein Schritt zur Datenvorverarbeitung

In beiden Fällen würden Sie beobachten, wie sich die Leistung des Systems verändert (oder auch nicht verändert), nachdem Sie die Komponente entfernt haben.

A/B-Tests

Eine statistische Methode zum Vergleichen von zwei (oder mehr) Techniken – A und B. Normalerweise ist A eine vorhandene und B eine neue Technik. Beim A/B-Test wird nicht nur ermittelt, welche Technik besser funktioniert, sondern auch, ob der Unterschied statistisch signifikant ist.

Beim A/B-Test wird in der Regel eine einzelne Messgröße für zwei Techniken verglichen. Wie schneidet beispielsweise die Genauigkeit des Modells für zwei Techniken ab? Bei A/B-Tests können jedoch auch eine beliebige endliche Anzahl von Messwerten verglichen werden.

Beschleunigerchip

Eine Kategorie von spezialisierten Hardwarekomponenten, die für die Ausführung wichtiger Berechnungen entwickelt wurden, die für Deep-Learning-Algorithmen erforderlich sind.

Beschleunigerchips (oder kurz Beschleuniger) können die Geschwindigkeit und Effizienz von Trainings- und Inferenzaufgaben im Vergleich zu einer Allzweck-CPU erheblich steigern. Sie eignen sich ideal für das Trainieren neuronaler Netze und ähnliche rechenintensive Aufgaben.

Beispiele für Beschleunigerchips sind:

- Googles Tensor Processing Units (TPUs) mit dedizierter Hardware für Deep Learning.

- Die GPUs von NVIDIA wurden zwar ursprünglich für die Grafikverarbeitung entwickelt, sind aber so konzipiert, dass sie die Parallelverarbeitung ermöglichen, wodurch die Verarbeitungsgeschwindigkeit deutlich erhöht werden kann.

Genauigkeit

Die Anzahl der richtigen Klassifizierungsvorhersagen, dividiert durch die Gesamtzahl der Vorhersagen. Das bedeutet:

Ein Modell, das beispielsweise 40 richtige und 10 falsche Vorhersagen getroffen hat, hätte eine Genauigkeit von:

Bei der binären Klassifizierung werden bestimmte Namen für die verschiedenen Kategorien von richtigen Vorhersagen und falschen Vorhersagen verwendet. Die Formel für die Genauigkeit bei der binären Klassifizierung lautet also:

Dabei gilt:

- TP ist die Anzahl der richtig positiven (korrekten Vorhersagen).

- TN ist die Anzahl der richtig negativen Ergebnisse (richtige Vorhersagen).

- FP ist die Anzahl der falsch positiven Ergebnisse (falsche Vorhersagen).

- FN ist die Anzahl der falsch negativen Ergebnisse (falsche Vorhersagen).

Vergleichen und kontrastieren Sie Genauigkeit mit Präzision und Recall.

Weitere Informationen finden Sie im Machine Learning Crash Course unter Classification: Accuracy, recall, precision and related metrics.

Aktion

In Reinforcement Learning , der Mechanismus, durch den die Agent Übergänge zwischen Staaten der Umfeld Die Der Agent wählt die Aktion mithilfe einer Richtlinie.

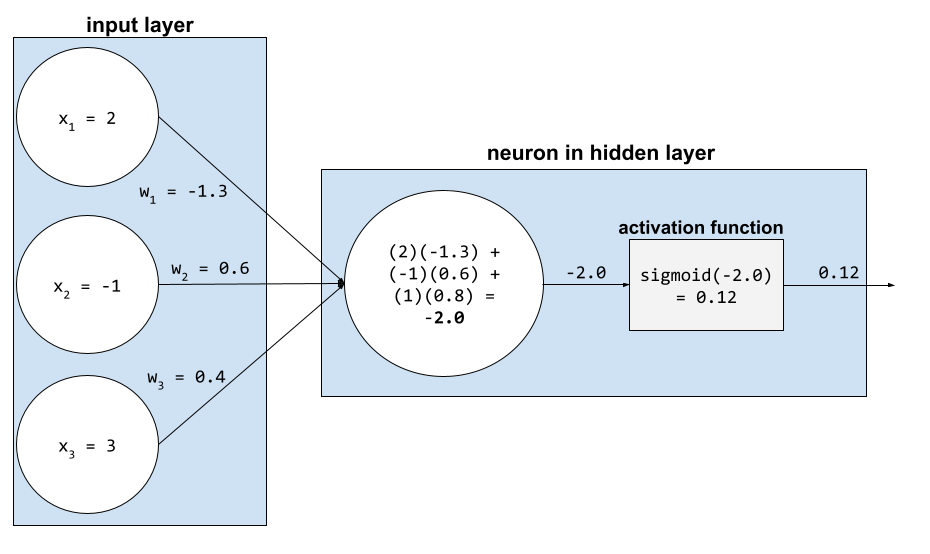

Aktivierungsfunktion

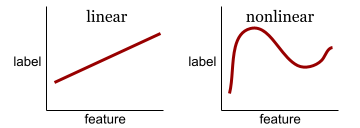

Eine Funktion, die es neuronalen Netzen ermöglicht, nichtlineare (komplexe) Beziehungen zwischen Merkmalen und der Bezeichnung zu lernen.

Beliebte Aktivierungsfunktionen sind:

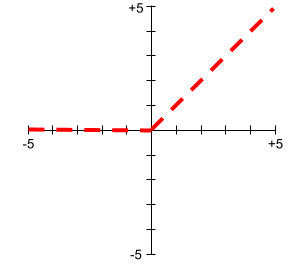

Die Diagramme von Aktivierungsfunktionen sind nie einzelne gerade Linien. Das Diagramm der ReLU-Aktivierungsfunktion besteht beispielsweise aus zwei geraden Linien:

Die Darstellung der Sigmoid-Aktivierungsfunktion sieht wie folgt aus:

Weitere Informationen finden Sie im Machine Learning Crash Course unter Neuronale Netze: Aktivierungsfunktionen.

aktives Lernen

Ein Trainingsansatz, bei dem der Algorithmus einige der Daten auswählt, aus denen er lernt. Aktives Lernen ist besonders nützlich, wenn gelabelte Beispiele selten oder teuer zu beschaffen sind. Statt blind nach einer Vielzahl von gekennzeichneten Beispielen zu suchen, sucht ein Algorithmus für aktives Lernen selektiv nach den Beispielen, die er zum Lernen benötigt.

AdaGrad

Ein ausgefeilter Gradientenabstiegsalgorithmus, der die Gradienten jedes Parameters neu skaliert und jedem Parameter effektiv eine unabhängige Lernrate zuweist. Eine ausführliche Erklärung finden Sie unter Adaptive Subgradient Methods for Online Learning and Stochastic Optimization.

Anpassung

Synonym für Optimierung oder Feinabstimmung.

Agent

Software, die multimodale Benutzereingaben analysieren kann, um Aktionen im Namen des Benutzers zu planen und auszuführen.

Beim Reinforcement Learning ist ein Agent die Einheit, die eine Richtlinie verwendet, um den erwarteten Return zu maximieren, der durch den Übergang zwischen Zuständen der Umgebung erzielt wird.

agentisch

Die Adjektivform von agent. Agentisch bezieht sich auf die Eigenschaften, die Agenten besitzen (wie zum Beispiel Autonomie).

Agenten-Workflow

Ein dynamischer Prozess, bei dem ein Agent autonom Aktionen plant und ausführt, um ein Ziel zu erreichen. Der Prozess kann das Ziehen von Schlussfolgerungen, das Aufrufen externer Tools und das selbstständige Korrigieren des Plans umfassen.

agglomerative Clusterbildung

Siehe hierarchisches Clustering.

KI-Schludrigkeit

Ausgabe eines generativen KI-Systems, bei dem die Quantität über der Qualität steht. Eine Webseite mit KI-Schrott ist beispielsweise mit billig produzierten, KI-generierten Inhalten von geringer Qualität gefüllt.

Anomalieerkennung

Der Prozess der Identifizierung von Ausreißern. Wenn der Mittelwert für ein bestimmtes Merkmal beispielsweise 100 mit einer Standardabweichung von 10 ist, sollte die Anomalieerkennung einen Wert von 200 als verdächtig kennzeichnen.

AR

Abkürzung für Augmented Reality.

Bereich unter der PR-Kurve

Weitere Informationen finden Sie unter PR AUC (Area under the PR Curve).

Fläche unter der ROC-Kurve

Siehe AUC (Fläche unter der ROC-Kurve).

allgemeine künstliche Intelligenz

Ein nicht-menschlicher Mechanismus, der einenbreites Spektrum Problemlösungsfähigkeit, Kreativität und Anpassungsfähigkeit. Ein Programm, das künstliche allgemeine Intelligenz demonstriert, könnte beispielsweise Texte übersetzen und Sinfonien komponieren.Und Sie sind hervorragend in Spielen, die noch nicht erfunden wurden.

künstliche Intelligenz

Ein nicht menschliches Programm oder Modell, das anspruchsvolle Aufgaben lösen kann. Ein Programm oder Modell, das Text übersetzt, oder ein Programm oder Modell, das Krankheiten anhand von radiologischen Bildern erkennt, sind Beispiele für künstliche Intelligenz.

Formal ist maschinelles Lernen ein Teilbereich der künstlichen Intelligenz. In den letzten Jahren haben einige Organisationen jedoch begonnen, die Begriffe künstliche Intelligenz und maschinelles Lernen synonym zu verwenden.

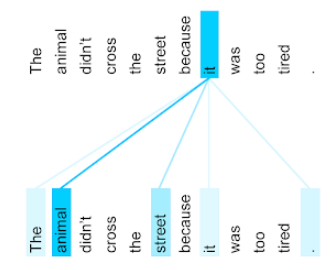

aufmerksamkeit

Ein Mechanismus, der in einem neuronalen Netzwerk verwendet wird und die Wichtigkeit eines bestimmten Wortes oder Wortteils angibt. Aufmerksamkeit komprimiert die Informationsmenge, die ein Modell benötigt, um das nächste Token/Wort vorherzusagen. Ein typischer Aufmerksamkeitsmechanismus könnte aus einer gewichteten Summe über eine Menge von Eingaben bestehen, wobei das Gewicht für jede Eingabe von einem anderen Teil des neuronalen Netzes berechnet wird.

Weitere Informationen finden Sie unter Self-Attention und Multi-Head Self-Attention, den Bausteinen von Transformern.

Weitere Informationen zur Selbstaufmerksamkeit finden Sie unter LLMs: Was ist ein großes Sprachmodell? im Machine Learning Crash Course.

Attribut

Synonym für Funktion.

Beim maschinellen Lernen beziehen sich Attribute oft auf Merkmale von Personen.

Attributstichprobe

Eine Taktik zum Trainieren eines Entscheidungsbaums, bei dem jeder Entscheidungsbaum beim Lernen der Bedingung nur eine zufällige Teilmenge der möglichen Features berücksichtigt. Im Allgemeinen wird für jeden Knoten eine andere Teilmenge von Features ausgewählt. Wenn Sie einen Entscheidungsbaum ohne Attribut-Sampling trainieren, werden dagegen alle möglichen Features für jeden Knoten berücksichtigt.

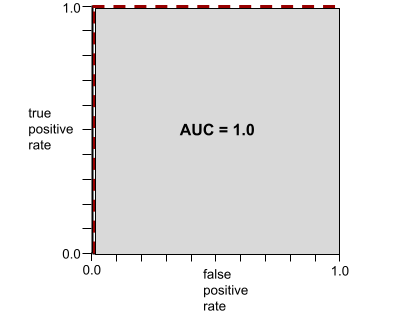

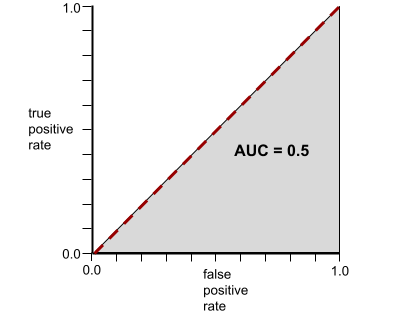

AUC (Area Under the ROC Curve, Bereich unter der ROC-Kurve)

Eine Zahl zwischen 0,0 und 1,0, die einen Wert darstellt binäre Klassifizierung die Fähigkeit des Modells zur Trennung positive Klassen aus Negativklassen Die Je näher der AUC-Wert an 1,0 liegt, desto besser ist das Modell in der Lage, die Klassen voneinander zu trennen.

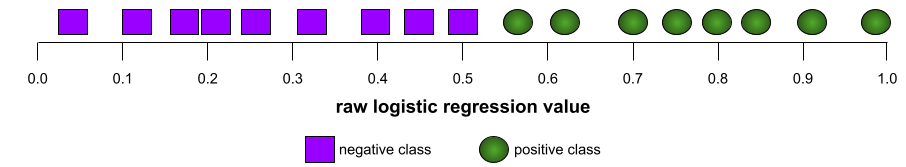

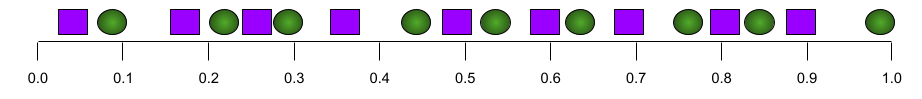

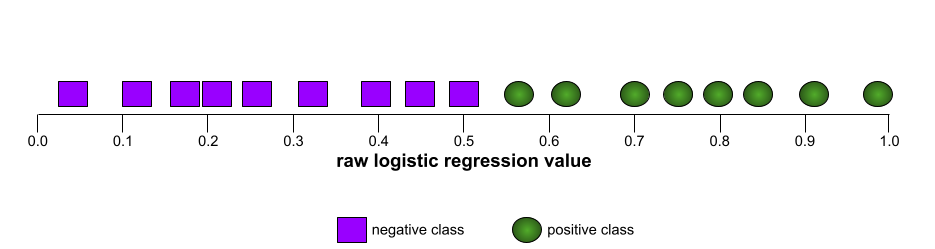

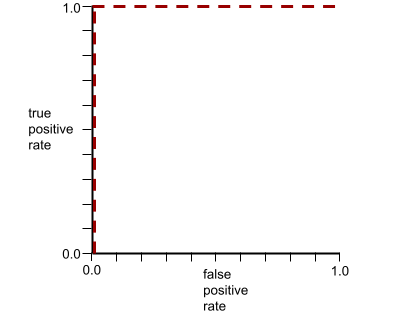

Die folgende Abbildung zeigt beispielsweise ein Klassifikationsmodell, das positive Klassen (grüne Ovale) perfekt von negativen Klassen (violette Rechtecke) trennt. Dieses unrealistisch perfekte Modell hat einen AUC-Wert von 1,0:

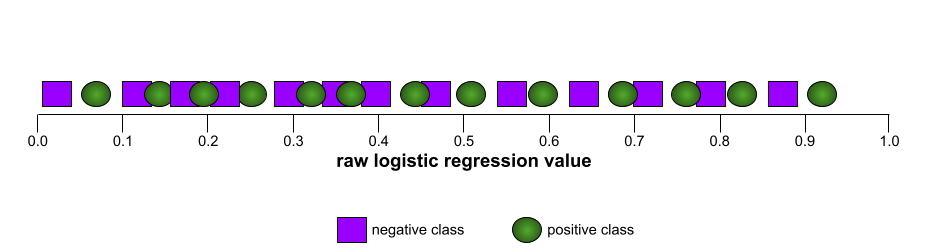

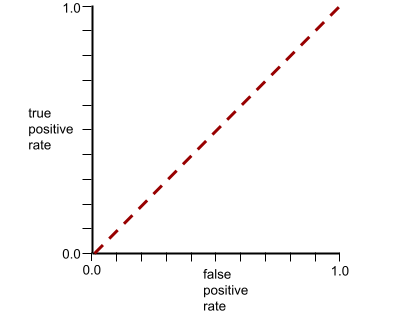

Umgekehrt zeigt die folgende Abbildung die Ergebnisse für ein Klassifikationsmodell, das zufällige Ergebnisse erzeugt hat. Dieses Modell hat einen AUC-Wert von 0,5:

Ja, das vorhergehende Modell hat einen AUC-Wert von 0,5, nicht 0,0.

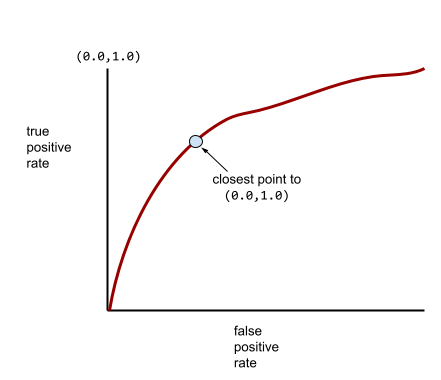

Die meisten Modelle liegen irgendwo zwischen den beiden Extremen. Das folgende Modell trennt beispielsweise Positive und Negative einigermaßen und hat daher einen AUC-Wert irgendwo zwischen 0, 5 und 1, 0:

AUC ignoriert jeden Wert, den Sie für Klassifizierungsschwelle festlegen. Stattdessen berücksichtigt AUC alle mögliche Klassifizierungsschwellenwerte.

Weitere Informationen finden Sie unter Klassifizierung: ROC und AUC im Machine Learning Crash Course.

Augmented Reality

Eine Technologie, die ein computergeneriertes Bild über die Sicht des Benutzers auf die reale Welt legt und so eine zusammengesetzte Ansicht erzeugt.

Autoencoder

Ein System, das lernt, die wichtigsten Informationen aus der Eingabe zu extrahieren. Autoencoder sind eine Kombination aus einem Encoder und einem Decoder. Autoencoder basieren auf dem folgenden zweistufigen Prozess:

- Der Encoder bildet die Eingabe auf ein (in der Regel) verlustbehaftetes, niedrigdimensionales (Zwischen-)Format ab.

- Der Decoder erstellt eine verlustbehaftete Version der ursprünglichen Eingabe, indem er das niedrigdimensionale Format dem ursprünglichen höherdimensionalen Eingabeformat zuordnet.

Autoencoder werden End-to-End trainiert, indem der Decoder versucht, die ursprüngliche Eingabe aus dem Zwischenformat des Encoders so genau wie möglich zu rekonstruieren. Da das Zwischenformat kleiner (niedriger dimensional) als das Originalformat ist, muss der Autoencoder lernen, welche Informationen in der Eingabe wichtig sind. Die Ausgabe ist daher nicht perfekt mit der Eingabe identisch.

Beispiel:

- Wenn die Eingabedaten eine Grafik sind, wäre die nicht exakte Kopie der Originalgrafik ähnlich, aber etwas modifiziert. Vielleicht werden bei der nicht exakten Kopie Rauschen aus der Originalgrafik entfernt oder fehlende Pixel ergänzt.

- Wenn die Eingabedaten Text sind, generiert ein Autoencoder neuen Text, der dem Originaltext ähnelt, aber nicht identisch ist.

Siehe auch variationale Autoencoder.

automatische Auswertung

Die Qualität der Modellausgabe mithilfe von Software beurteilen.

Wenn die Modellausgabe relativ einfach ist, kann ein Skript oder Programm die Modellausgabe mit einer Referenzantwort vergleichen. Diese Art der automatischen Auswertung wird manchmal als programmatische Auswertung bezeichnet. Messwerte wie ROUGE oder BLEU sind oft für die programmatische Bewertung nützlich.

Wenn die Modellausgabe komplex ist oder keine richtige Antwort hat, führt manchmal ein separates ML-Programm, der Autorater genannt wird, die automatische Auswertung durch.

Im Gegensatz dazu menschliche Bewertung.

Automatisierungsbias

Wenn ein menschlicher Entscheidungsträger Empfehlungen eines automatisierten Entscheidungssystems Informationen vorzieht, die ohne Automatisierung erstellt wurden, auch wenn das automatisierte Entscheidungssystem Fehler macht.

Weitere Informationen finden Sie unter Fairness: Arten von Verzerrungen im Machine Learning Crash Course.

AutoML

Jeder automatisierte Prozess zum Erstellen von Machine-Learning-Modellen. AutoML kann Aufgaben wie die folgenden automatisch ausführen:

- Suchen Sie nach dem am besten geeigneten Modell.

- Tune hyperparameter.

- Daten vorbereiten (einschließlich der Durchführung von Feature Engineering).

- Das resultierende Modell bereitstellen.

AutoML ist für Data Scientists nützlich, weil es ihnen Zeit und Aufwand bei der Entwicklung von Machine-Learning-Pipelines ersparen und die Vorhersagegenauigkeit verbessern kann. Es ist auch für Nicht-Experten nützlich, da es ihnen komplizierte Aufgaben des maschinellen Lernens zugänglicher macht.

Weitere Informationen finden Sie unter Automatisiertes maschinelles Lernen (AutoML) im Schnellkurs Maschinelles Lernen.

Bewertung durch einen automatischen Gutachter

Ein hybrider Mechanismus zur Beurteilung der Qualität der Ausgabe eines generativen KI-Modells, der menschliche Bewertung mit automatischer Bewertung kombiniert. Ein Autorater ist ein ML-Modell, das mit Daten trainiert wird, die durch menschliche Bewertung erstellt wurden. Im Idealfall lernt ein Autorater, einen menschlichen Prüfer zu imitieren.Es gibt zwar vorgefertigte automatische Bewertungssysteme, aber die besten automatischen Bewertungssysteme sind speziell auf die zu bewertende Aufgabe abgestimmt.

autoregressives Modell

Ein Modell, das eine Vorhersage auf der Grundlage seiner eigenen vorherigen Vorhersagen ableitet. Beispielsweise sagen autoregressive Sprachmodelle das nächste token auf der Grundlage der zuvor vorhergesagten Token voraus. Alle Transformer-basierten großen Sprachmodelle sind autoregressiv.

Im Gegensatz dazu sind GAN-basierte Bildmodelle in der Regel nicht autoregressiv, da sie ein Bild in einem einzigen Vorwärtsdurchlauf und nicht iterativ in Schritten erzeugen. Allerdings gibt es bestimmte BildgenerierungsmodelleSind autoregressiv, weil sie ein Bild schrittweise erzeugen.

Hilfsverlust

Eine Verlustfunktion, die in Verbindung mit der Hauptverlustfunktion eines neuronalen Netzwerks Modells verwendet wird und dazu beiträgt, das Training in den frühen Iterationen zu beschleunigen, wenn die Gewichte zufällig initialisiert werden.

Hilfsverlustfunktionen übertragen effektive Gradienten auf die früheren Ebenen. Dies erleichtert die Konvergenz während des Trainings, indem das Problem des verschwindenden Gradienten behoben wird.

mittlere Präzision bei k

Ein Messwert zur Zusammenfassung der Leistung eines Modells bei einem einzelnen Prompt, der sortierte Ergebnisse generiert, z. B. eine nummerierte Liste mit Buchempfehlungen. Die durchschnittliche Precision bei k ist der Durchschnitt der Precision bei k-Werte für jedes relevante Ergebnis. Die Formel für die durchschnittliche Precision bei k lautet daher:

\[{\text{average precision at k}} = \frac{1}{n} \sum_{i=1}^n {\text{precision at k for each relevant item} } \]

Dabei gilt:

- \(n\) ist die Anzahl der relevanten Elemente in der Liste.

Im Gegensatz dazu steht Recall at k.

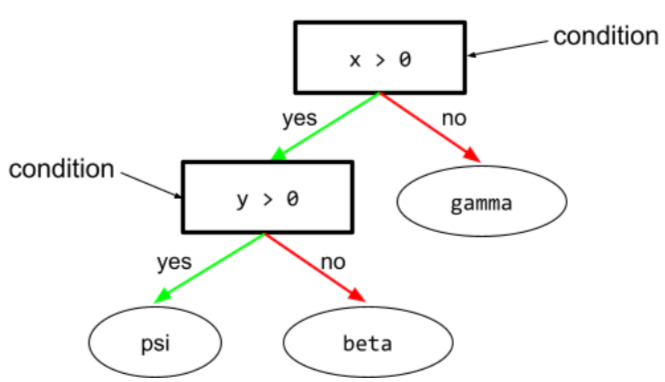

achsenparalleler Zustand

In einem Entscheidungsbaum ist eine Bedingung, die nur ein einzelnes Attribut umfasst. Wenn area beispielsweise ein Merkmal ist, ist Folgendes eine achsenorientierte Bedingung:

area > 200

Vergleich mit schiefer Bedingung.

B

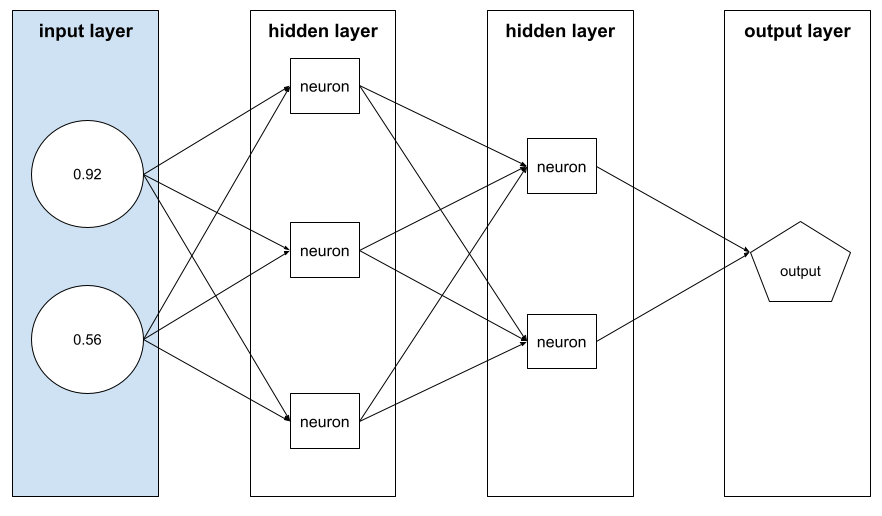

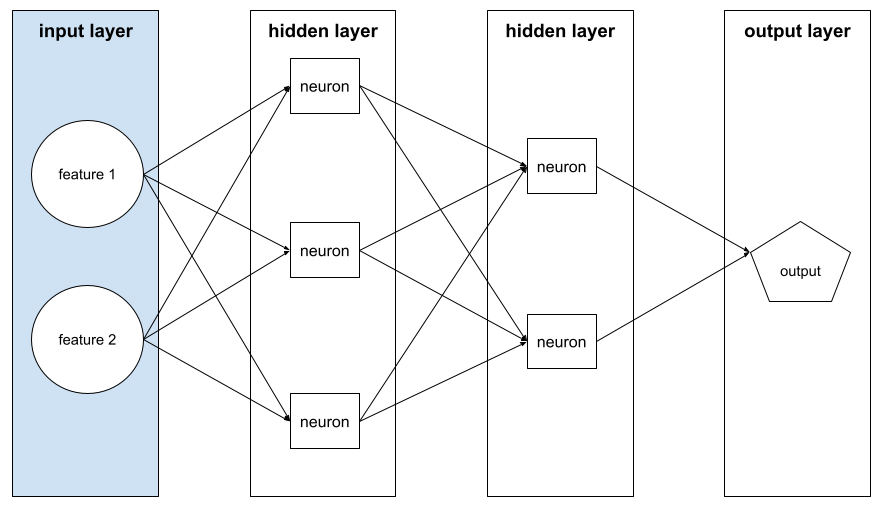

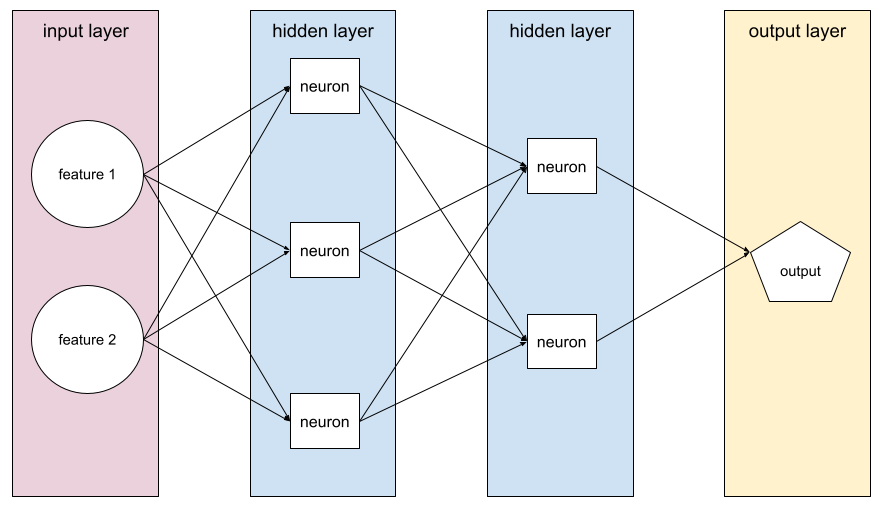

Rückpropagation

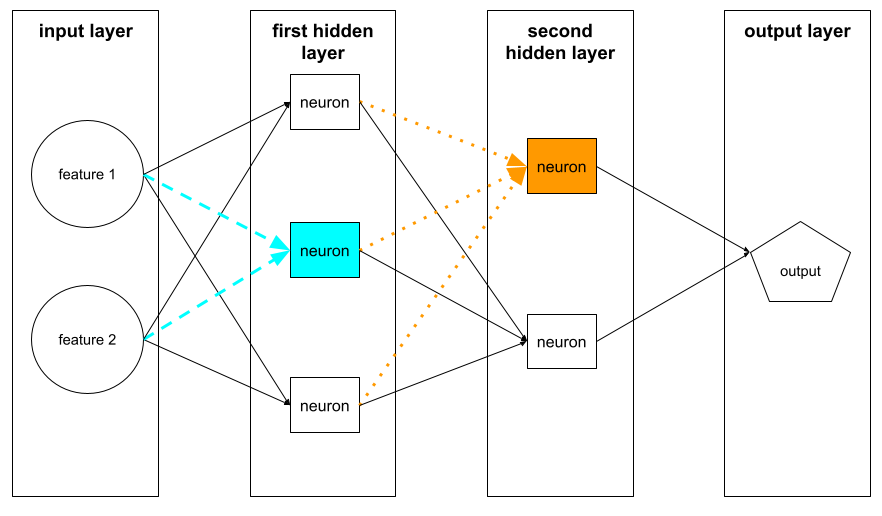

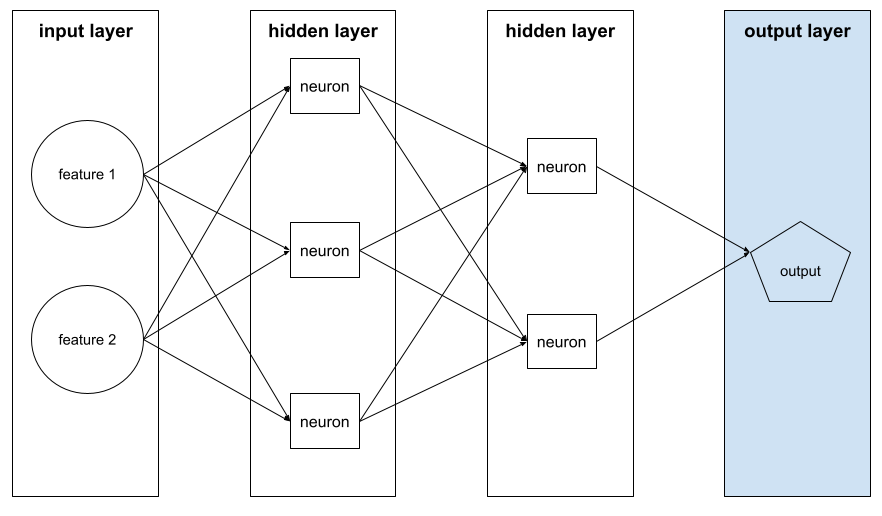

Der Algorithmus, der den Gradientenabstieg in neuronalen Netzwerken implementiert.

Das Trainieren eines neuronalen Netzwerks umfasst viele Wiederholungen des folgenden Zwei-Pass-Zyklus:

- Während des Forward Pass verarbeitet das System einen Batch von Beispielen, um Vorhersagen zu treffen. Das System vergleicht jede Vorhersage mit jedem Label-Wert. Die Differenz zwischen der Vorhersage und dem Labelwert ist der Verlust für dieses Beispiel. Das System fasst die Verluste für alle Beispiele zusammen, um den Gesamtverlust für den aktuellen Batch zu berechnen.

- Während des Rückwärtsdurchlaufs (Backpropagation) wird der Verlust durch Anpassen der Gewichte aller Neuronen in allen verborgenen Schichten reduziert.

Neuronale Netze enthalten oft viele Neuronen in vielen verborgenen Schichten. Jedes dieser Neuronen trägt auf unterschiedliche Weise zum Gesamtdelta bei. Bei der Backpropagation wird ermittelt, ob die Gewichte, die auf bestimmte Neuronen angewendet werden, erhöht oder verringert werden müssen.

Die Lernrate ist ein Multiplikator, der steuert, in welchem Maße jeder Backward-Pass jedes Gewicht erhöht oder verringert. Bei einer großen Lernrate wird jedes Gewicht stärker erhöht oder verringert als bei einer kleinen Lernrate.

In der Analysis wird bei der Backpropagation die Kettenregel> angewendet. Bei der Backpropagation wird die partielle Ableitung des Fehlers in Bezug auf jeden Parameter berechnet.

Vor Jahren mussten ML-Anwender noch Code schreiben, um die Rückpropagation zu implementieren. Moderne ML-APIs wie Keras implementieren jetzt die Backpropagation für Sie. Geschafft!

Weitere Informationen finden Sie im Machine Learning Crash Course unter Neuronale Netze.

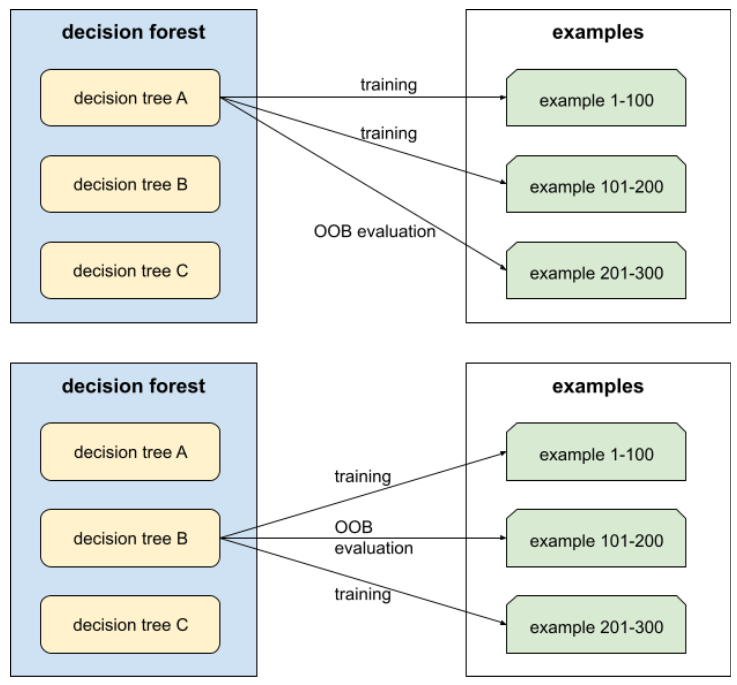

Bagging

Eine Methode zum Trainieren eines Ensembles, bei dem jedes Modell mit einer zufälligen Teilmenge von Trainingsbeispielen mit Zurücklegen trainiert wird. Ein Random Forest ist beispielsweise eine Sammlung von Entscheidungsbäumen, die mit Bagging trainiert wurden.

Der Begriff bagging ist eine Kurzform von bootstrap aggregating.

Weitere Informationen finden Sie unter Random forests im Kurs Decision Forests.

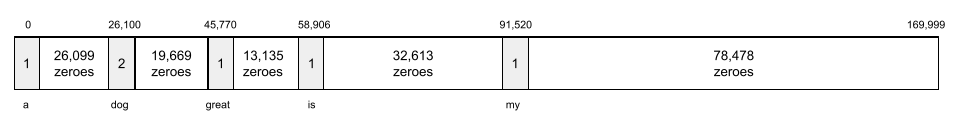

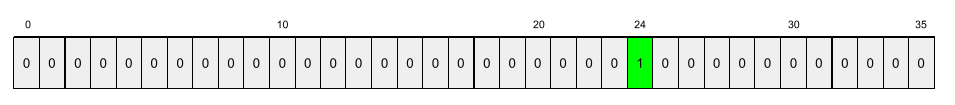

Wortschatz

Eine Darstellung der Wörter in einem Ausdruck oder Abschnitt, unabhängig von der Reihenfolge. Beispielsweise werden die folgenden drei Wortgruppen im Bag-of-Words-Modell identisch dargestellt:

- Der Hund springt.

- springt über den Hund

- Hund springt

Jedes Wort wird einem Index in einem dünnbesetzten Vektor zugeordnet, wobei der Vektor einen Index für jedes Wort im Vokabular hat. Der Ausdruck the dog jumps wird beispielsweise in einen Feature-Vektor mit Werten ungleich null an den drei Indexen abgebildet, die den Wörtern the, dog und jumps entsprechen. Der Wert ungleich null kann einer der folgenden sein:

- Eine 1, um das Vorhandensein eines Wortes anzugeben.

- Die Anzahl der Vorkommen eines Worts im Bag. Wenn der Ausdruck beispielsweise Der kastanienbraune Hund ist ein Hund mit kastanienbraunem Fell lautet, werden sowohl kastanienbraun als auch Hund als 2 dargestellt, während die anderen Wörter als 1 dargestellt werden.

- Ein anderer Wert, wie zum Beispiel der Logarithmus der Anzahl der Vorkommen eines Wortes im Beutel.

baseline

Ein Modell, das als Referenzpunkt für den Vergleich der Leistung eines anderen Modells (in der Regel eines komplexeren) verwendet wird. Ein logistisches Regressionsmodell kann beispielsweise als gute Baseline für ein Deep-Learning-Modell dienen.

Für ein bestimmtes Problem hilft die Baseline den Modellentwicklern, die minimale erwartete Leistung zu quantifizieren, die ein neues Modell erreichen muss, damit es nützlich ist.

Basismodell

Ein vortrainiertes Modell, das als Ausgangspunkt für Feinabstimmung dienen kann, um spezifische Aufgaben oder Anwendungen zu bewältigen.

Siehe auch Vortrainiertes Modell und Foundation Model.

Batch

Die Menge der Beispiele, die in einer Trainingsiteration verwendet werden. Die Batchgröße bestimmt die Anzahl der Beispiele in einem Batch.

Eine Erklärung, wie ein Batch mit einer Epoche zusammenhängt, finden Sie unter epoch.

Weitere Informationen finden Sie unter Lineare Regression: Hyperparameter im Machine Learning Crash Course.

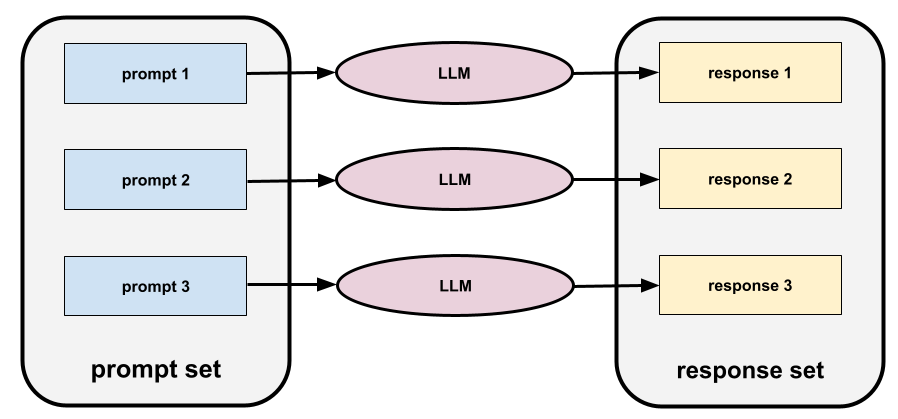

Batchinferenz

Der Prozess des Ableitens von Vorhersagen für mehrere unbeschriftete Beispiele, die in kleinere Teilmengen („Batches“) unterteilt sind.

Bei der Batch-Inferenz können die Parallelisierungsfunktionen von Beschleunigerchips genutzt werden. Das bedeutet, dass mehrere Beschleuniger gleichzeitig Vorhersagen für verschiedene Batches von ungelabelten Beispielen ableiten können, was die Anzahl der Inferenzen pro Sekunde erheblich steigert.

Weitere Informationen finden Sie im Machine Learning Crash Course unter Production ML systems: Static versus dynamic inference.

Batchnormalisierung

Normalisieren der Eingabe oder Ausgabe der Aktivierungsfunktionen in einer verborgenen Ebene. Die Batch-Normalisierung kann folgende Vorteile bieten:

- Neuronale Netze werden stabiler, indem sie vor Ausreißer-Gewichten geschützt werden.

- Höhere Lernraten aktivieren, um das Training zu beschleunigen.

- Reduziere Overfitting.

Batchgröße

Die Anzahl der Beispiele in einem Batch. Wenn die Batchgröße beispielsweise 100 ist, verarbeitet das Modell 100 Beispiele pro Iteration.

Im Folgenden finden Sie einige beliebte Strategien für die Batchgröße:

- Stochastic Gradient Descent (SGD), bei der die Batchgröße 1 ist.

- Vollständiger Batch, bei dem die Batchgröße der Anzahl der Beispiele im gesamten Trainingsset entspricht. Wenn der Trainingssatz beispielsweise eine Million Beispiele enthält, beträgt die Batchgröße eine Million Beispiele. Die Verarbeitung des gesamten Batches ist in der Regel eine ineffiziente Strategie.

- Minibatch, bei dem die Batchgröße in der Regel zwischen 10 und 1.000 liegt. Die Mini-Batch-Strategie ist in der Regel die effizienteste.

Weitere Informationen finden Sie hier:

- ML-Produktionssysteme: Statische und dynamische Inferenz im Crashkurs zum maschinellen Lernen.

- Deep Learning Tuning Playbook.

Bayessches neuronales Netzwerk

Ein probabilistisches neuronales Netzwerk, das die Unsicherheit bei Gewichtungen und Ausgaben berücksichtigt. Ein Standardmodell für die Regression mit neuronalen Netzen sagt in der Regel einen Skalarwert vorher, z. B. einen Immobilienpreis von 853.000. Im Gegensatz dazu sagt ein bayessches neuronales Netzwerk eine Verteilung von Werten vorher. Ein bayessches Modell sagt beispielsweise einen Hauspreis von 853.000 € mit einer Standardabweichung von 67.200 € vorher.

Ein bayessches neuronales Netzwerk verwendet das Bayes'sche Theorem, um Unsicherheiten bei Gewichten und Vorhersagen zu berechnen. Ein bayessches neuronales Netzwerk kann nützlich sein, wenn es wichtig ist, Unsicherheit zu quantifizieren, z. B. in Modellen, die sich auf Pharmazeutika beziehen. Bayessche neuronale Netze können auch dazu beitragen, eine Überanpassung zu verhindern.

Bayes'sche Optimierung

Probabilistische Regressionsmodelle sind eine Technik zur Optimierung rechenintensiver Zielfunktionen. Dabei wird stattdessen ein Surrogat optimiert, das die Unsicherheit mithilfe einer bayesschen Lernmethode quantifiziert. Da die bayessche Optimierung selbst sehr aufwendig ist, wird sie in der Regel verwendet, um Aufgaben zu optimieren, die nur wenige Parameter haben und deren Auswertung aufwendig ist, z. B. die Auswahl von Hyperparametern.

Bellman-Gleichung

Im Reinforcement Learning gilt die folgende Identität für die optimale Q-Funktion:

\[Q(s, a) = r(s, a) + \gamma \mathbb{E}_{s'|s,a} \max_{a'} Q(s', a')\]

Algorithmen für bestärkendes Lernen wenden diese Identität an, um Q-Learning mit der folgenden Aktualisierungsregel zu erstellen:

\[Q(s,a) \gets Q(s,a) + \alpha \left[r(s,a) + \gamma \displaystyle\max_{\substack{a_1}} Q(s',a') - Q(s,a) \right] \]

Über das Reinforcement Learning hinaus findet die Bellman-Gleichung auch Anwendung in der dynamischen Programmierung. Siehe den Wikipedia-Eintrag zur Bellman-Gleichung.

BERT (Bidirectional Encoder Representations from Transformers)

Eine Modellarchitektur für die Darstellung von Text. Ein trainiertes BERT-Modell kann als Teil eines größeren Modells für die Textklassifizierung oder andere ML-Aufgaben dienen.

BERT hat die folgenden Eigenschaften:

- Verwendet die Transformer-Architektur und basiert daher auf Self-Attention.

- Verwendet den Encoder des Transformers. Die Aufgabe des Encoders besteht darin, gute Textdarstellungen zu erstellen, anstatt eine bestimmte Aufgabe wie die Klassifizierung auszuführen.

- Ist bidirektional.

- Verwendet Maskierung für unbeaufsichtigtes Training.

Zu den Varianten von BERT gehören:

Eine Übersicht über BERT finden Sie unter BERT als Open Source-Modell: Hochmodernes Training im Voraus für die natürliche Sprachverarbeitung.

Bias (Ethik/Fairness)

1. Stereotypisierung, Vorurteile oder Bevorzugung bestimmter Dinge, Personen oder Gruppen gegenüber anderen. Diese Verzerrungen können sich auf die Erhebung und Interpretation von Daten, das Design eines Systems und die Interaktion von Nutzern mit einem System auswirken. Beispiele für diese Art von Bias:

- Automation Bias

- Bestätigungsfehler

- Experimentatorverzerrung

- Gruppenattributionsbias

- implizite Voreingenommenheit

- Gruppenintern

- Verzerrung der Homogenität der Außengruppe

2. Systematischer Fehler, der durch ein Sampling- oder Reportingverfahren eingeführt wird. Beispiele für diese Art von Bias:

- Coverage Bias

- Schweigeverzerrung

- Teilnahme-Bias

- Reporting Bias

- Stichprobenverzerrung

- Stichproben-Bias

Nicht zu verwechseln mit dem Bias-Term in Modellen für maschinelles Lernen oder dem Vorhersage-Bias.

Weitere Informationen finden Sie im Machine Learning Crash Course unter Fairness: Types of bias.

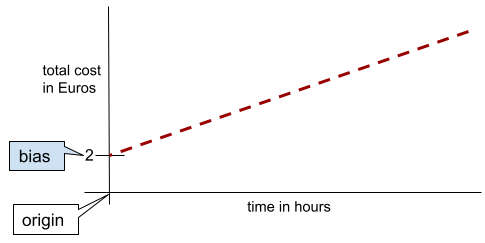

Bias (mathematisch) oder Bias-Term

Ein Achsenabschnitt oder ein Offset von einem Ursprung. Bias ist ein Parameter in Modellen für maschinelles Lernen, der durch einen der folgenden Werte symbolisiert wird:

- b

- w0

Bias ist beispielsweise das b in der folgenden Formel:

In einer einfachen zweidimensionalen Linie bedeutet Bias einfach „y-Achsenabschnitt“. In der folgenden Abbildung ist der Bias der Linie beispielsweise 2.

Bias ist vorhanden, da nicht alle Modelle am Ursprung (0,0) beginnen. Ein Beispiel: Der Eintritt in einen Vergnügungspark kostet 2 € und jede Stunde, die ein Kunde dort verbringt, kostet zusätzlich 0,50 €. Ein Modell, das die Gesamtkosten abbildet, hat daher einen Bias von 2, da die niedrigsten Kosten 2 € betragen.

Verzerrung ist nicht mit Bias in Ethik und Fairness oder Vorhersagebias zu verwechseln.

Weitere Informationen finden Sie im Machine Learning Crash Course unter Lineare Regression.

bidirektional

Ein Begriff, der ein System beschreibt, das den Text bewertet, der einem Zielabschnitt des Texts vorangeht und folgt. Im Gegensatz dazu wird bei einem unidirektionalen System nur der Text ausgewertet, der einem Zielabschnitt des Texts vorangeht.

Betrachten wir beispielsweise ein maskiertes Sprachmodell, das die Wahrscheinlichkeiten für das Wort oder die Wörter bestimmen muss, die in der folgenden Frage unterstrichen sind:

Was ist los mit dir?

Ein unidirektionales Sprachmodell müsste seine Wahrscheinlichkeiten nur auf den Kontext stützen, der durch die Wörter „What“, „is“ und „the“ bereitgestellt wird. Ein bidirektionales Sprachmodell könnte dagegen auch Kontext aus „mit“ und „Sie“ gewinnen, was dem Modell helfen könnte, bessere Vorhersagen zu treffen.

Bidirektionales Sprachmodell

Ein Sprachmodell, das die Wahrscheinlichkeit dafür bestimmt, dass ein bestimmtes Token an einer bestimmten Stelle in einem Textausschnitt vorhanden ist, basierend auf dem vorherigen und nachfolgenden Text.

Bigramm

Ein N-Gramm, in dem N=2.

Binärklassifizierung

Eine Art von Klassifizierung-Aufgabe, die eine von zwei sich gegenseitig ausschließenden Klassen vorhersagt:

- die positive Klasse

- die negative Klasse

Die folgenden beiden Modelle für maschinelles Lernen führen beispielsweise jeweils eine binäre Klassifizierung durch:

- Ein Modell, das bestimmt, ob E-Mail-Nachrichten Spam (die positive Klasse) oder kein Spam (die negative Klasse) sind.

- Ein Modell, das medizinische Symptome auswertet, um festzustellen, ob eine Person eine bestimmte Krankheit hat (die positive Klasse) oder nicht hat (die negative Klasse).

Klassifizierung mit mehreren Klassen

Weitere Informationen finden Sie unter Logistische Regression und Klassifizierungsschwellenwert.

Weitere Informationen finden Sie im Machine Learning Crash Course unter Classification.

binärer Zustand

In einem Entscheidungsbaum ist eine Bedingung mit nur zwei möglichen Ergebnissen, in der Regel Ja oder Nein. Beispiel:

temperature >= 100

Im Gegensatz dazu steht die nicht-binäre Bedingung .

Weitere Informationen finden Sie unter Typen von Bedingungen im Kurs Entscheidungsbäume.

Gruppieren

Synonym für bucketing.

Blackbox-Modell

Ein Modell, dessen „Argumentation“ für Menschen unmöglich oder schwer zu verstehen ist. Das heißt, obwohl Menschen sehen können, wie sich Prompts auf Antworten auswirken, können sie nicht genau bestimmen, wie ein Blackbox-Modell die Antwort ermittelt. Mit anderen Worten: Ein Blackbox-Modell hat keine Interpretierbarkeit.

Die meisten tiefen Modelle und großen Sprachmodelle sind Black Boxes.

BLEU (Bilingual Evaluation Understudy)

Ein Messwert zwischen 0,0 und 1,0 zur Bewertung von maschinellen Übersetzungen, z.B.aus dem Spanischen ins Japanische.

Um einen Wert zu berechnen, vergleicht BLEU in der Regel die Übersetzung eines ML-Modells (generierter Text) mit der Übersetzung eines menschlichen Experten (Referenztext). Der BLEU-Wert wird anhand des Grads der Übereinstimmung von N-Grammen im generierten Text und im Referenztext bestimmt.

Das Original-Paper zu diesem Messwert ist BLEU: a Method for Automatic Evaluation of Machine Translation.

Siehe auch BLEURT.

BLEURT (Zweisprachige Evaluations-Unterstudie aus Transformers)

Eine Metrik zur Bewertung von maschinellen Übersetzungen von einer Sprache in eine andere, insbesondere ins und aus dem Englischen.

Bei Übersetzungen ins und aus dem Englischen orientiert sich BLEURT näher an menschlichen Bewertungen als BLEU. Im Gegensatz zu BLEU betont BLEURT semantische (bedeutungsmäßige) Ähnlichkeiten und ermöglicht Paraphrasierungen.

BLEURT basiert auf einem vortrainierten Large Language Model (genauer gesagt BERT), das dann mit Text von menschlichen Übersetzern abgestimmt wird.

Die Originalveröffentlichung zu dieser Metrik ist BLEURT: Learning Robust Metrics for Text Generation.

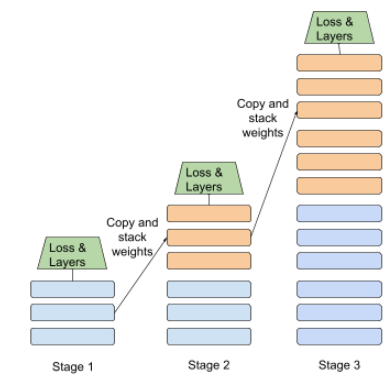

Steigerung

Eine Technik des maschinellen Lernens, die iterativ eine Reihe einfacher und nicht sehr genauer Klassifikationsmodelle (sogenannte „schwache Klassifikatoren“) zu einem Klassifikationsmodell mit hoher Genauigkeit (einem „starken Klassifikator“) kombiniert, indem die Beispiele, die das Modell aktuell falsch klassifiziert, höher gewichtet werden.

Weitere Informationen finden Sie im Kurs „Entscheidungsbäume“ im Abschnitt Gradient Boosted Decision Trees?.

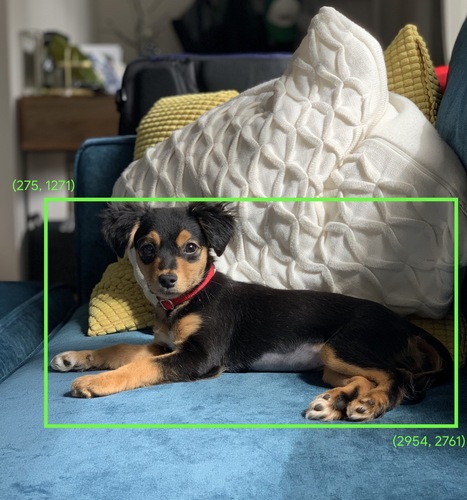

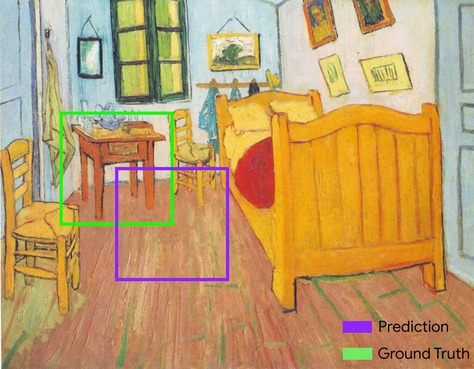

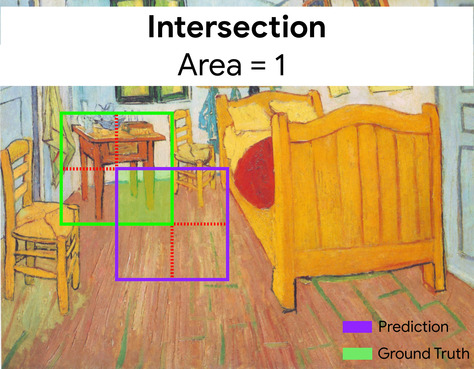

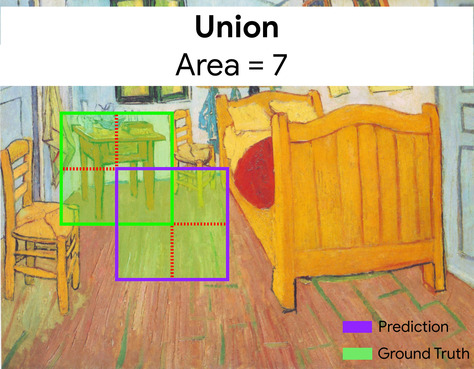

Begrenzungsrahmen

In einem Bild sind dies die (x, y)-Koordinaten eines Rechtecks um einen Bereich von Interesse, wie zum Beispiel den Hund im Bild unten.

Broadcasting

Die Form eines Operanden in einer Matrix-Mathematikoperation wird auf Dimensionen erweitert, die für diese Operation kompatibel sind. In der linearen Algebra müssen beispielsweise die beiden Operanden in einer Matrixadditionsoperation dieselben Dimensionen haben. Daher können Sie eine Matrix mit der Form (m, n) nicht zu einem Vektor der Länge n hinzufügen. Beim Broadcasting wird der Vektor der Länge n virtuell in eine Matrix der Form (m, n) erweitert, indem die gleichen Werte in jeder Spalte repliziert werden.

Weitere Informationen finden Sie in der folgenden Beschreibung zum Broadcasting in NumPy.

Bucketing

Umwandlung eines einzelnen Features in mehrere binäre Features, die als Buckets oder Klassen bezeichnet werden, in der Regel basierend auf einem Wertebereich. Das gehackte Feature ist in der Regel ein kontinuierliches Feature.

Anstatt die Temperatur beispielsweise als einzelnes kontinuierliches Gleitkomma-Feature darzustellen, können Sie Temperaturbereiche in diskrete Gruppen unterteilen, z. B.:

- <= 10 °C wäre der „kalte“ Bucket.

- 11–24 °C fallen in die Kategorie „gemäßigt“.

- Bei über 25 Grad Celsius wäre der Eimer „warm“.

Im Modell werden alle Werte im selben Bucket identisch behandelt. Die Werte 13 und 22 befinden sich beispielsweise beide im Bucket „gemäßigt“, sodass das Modell die beiden Werte identisch behandelt.

Weitere Informationen finden Sie unter Numerische Daten: Binning im Machine Learning Crash Course.

C

Kalibrierungsschicht

Eine nachträgliche Anpassung der Vorhersage, typischerweise um Vorhersageverzerrungen zu berücksichtigen. Die angepassten Vorhersagen und Wahrscheinlichkeiten sollten der Verteilung eines beobachteten Satzes von Labels entsprechen.

Kandidatengenerierung

Die erste Gruppe von Empfehlungen, die von einem Empfehlungssystem ausgewählt wurde. Nehmen wir beispielsweise eine Buchhandlung, die 100.000 Titel anbietet. In der Phase der Kandidatengenerierung wird eine viel kleinere Liste mit geeigneten Büchern für einen bestimmten Nutzer erstellt, z. B. 500. Aber selbst 500 Bücher sind viel zu viele, um sie einem Nutzer zu empfehlen. In den nachfolgenden, teureren Phasen eines Empfehlungssystems (z. B. Bewertung und Neuberechnung des Ranks) werden diese 500 Empfehlungen auf eine viel kleinere, nützlichere Menge reduziert.

Weitere Informationen finden Sie im Kurs „Empfehlungssysteme“ in der Übersicht zur Kandidatengenerierung.

Kandidatenstichprobe

Eine Optimierung zur Trainingszeit, bei der eine Wahrscheinlichkeit für alle positiven Labels berechnet wird, z. B. mit Softmax, aber nur für eine zufällige Stichprobe negativer Labels. Angenommen, ein Beispiel ist mit Beagle und Hund gekennzeichnet. Beim Kandidatensampling werden die vorhergesagten Wahrscheinlichkeiten und die entsprechenden Verlustterme für Folgendes berechnet:

- Beagle

- Hund

- eine zufällige Teilmenge der verbleibenden negativen Klassen (zum Beispiel cat, lollipop, fence).

Die Idee ist, dass die negativen Klassen aus weniger häufiger negativer Verstärkung lernen können, solange die positiven Klassen immer eine angemessene positive Verstärkung erhalten, und dies wird tatsächlich empirisch beobachtet.

Die Kandidatenstichprobe ist recheneffizienter als Trainingsalgorithmen, die Vorhersagen berechnen füralle negative Klassen, insbesondere wenn die Anzahl der negativen Klassen sehr groß ist.

kategoriale Daten

Features mit einer bestimmten Menge möglicher Werte. Nehmen wir als Beispiel ein kategoriales Feature namens traffic-light-state an, das nur einen der folgenden drei möglichen Werte haben kann:

redyellowgreen

Indem traffic-light-state als kategoriales Merkmal dargestellt wird, kann ein Modell die unterschiedlichen Auswirkungen von red, green und yellow auf das Fahrerverhalten lernen.

Kategoriale Features werden manchmal auch als diskrete Features bezeichnet.

Weitere Informationen finden Sie im Machine Learning Crash Course unter Mit kategorischen Daten arbeiten.

kausales Sprachmodell

Synonym für unidirektionales Sprachmodell.

Siehe bidirektionales Sprachmodell, um verschiedene Richtungsansätze in der Sprachmodellierung zu vergleichen.

Schwerpunkt

Das Zentrum eines Clusters, wie es durch einen k-Means oder k-Median Algorithmus bestimmt wird. Wenn beispielsweise k gleich 3 ist, findet der k-Means- oder k-Median-Algorithmus 3 Zentroide.

Weitere Informationen finden Sie unter Clustering algorithms im Clustering-Kurs.

zentroidbasiertes Clustering

Eine Kategorie von Clustering-Algorithmen, mit denen Daten in nicht hierarchischen Clustern organisiert werden. k-Means ist der am häufigsten verwendete zentroidbasierte Clustering-Algorithmus.

Kontrast zu Algorithmen für hierarchisches Clustering

Weitere Informationen finden Sie unter Clustering algorithms im Clustering-Kurs.

Chain-of-Thought Prompting

Eine Prompt-Engineering-Technik, die ein großes Sprachmodell (LLM) dazu anregt, seine Argumentation Schritt für Schritt zu erklären. Betrachten Sie beispielsweise die folgende Aufgabenstellung und achten Sie dabei besonders auf den zweiten Satz:

Wie vielen g-Kräften wäre ein Fahrer in einem Auto ausgesetzt, das in 7 Sekunden von 0 auf 60 Meilen pro Stunde beschleunigt? Zeigen Sie in der Antwort alle relevanten Berechnungen.

Die Antwort des LLM wäre wahrscheinlich:

- Zeige eine Reihe von physikalischen Formeln und setze die Werte 0, 60 und 7 an den entsprechenden Stellen ein.

- Erklären Sie, warum diese Formeln ausgewählt wurden und was die verschiedenen Variablen bedeuten.

Durch Chain-of-Thought-Prompts wird das LLM gezwungen, alle Berechnungen durchzuführen, was zu einer korrekteren Antwort führen kann. Darüber hinaus ermöglicht die Aufforderung zur Gedankenkette dem Benutzer, die Schritte des LLM zu überprüfen, um festzustellen, ob die Antwort sinnvoll ist oder nicht.

F-Wert für Zeichen-N-Gramme (ChrF)

Eine Metrik zur Bewertung von maschinellen Übersetzungsmodellen. Der F-Score für Zeichen-N-Gramme gibt an, inwieweit sich N-Gramme im Referenztext mit den N-Grammen im generierten Text eines ML-Modells überschneiden.

Der N-Gramm-F-Score für Zeichen ist ähnlich wie Metriken der ROUGE- und BLEU-Familien, mit folgender Ausnahme:

- Der F-Score für Zeichen-N-Gramme wird für Zeichen-N-Gramme berechnet.

- ROUGE und BLEU arbeiten mit word N-Grammen oder token.

Chat

Die Inhalte eines Dialogs mit einem ML-System, in der Regel einem Large Language Model. Die vorherige Interaktion in einem Chat (was Sie eingegeben haben und wie das Large Language Model reagiert hat) wird zum Kontext für nachfolgende Teile des Chats.

Ein Chatbot ist eine Anwendung eines Large Language Model.

CHECKPOINT

Daten, die den Zustand der Parameter eines Modells entweder während des Trainings oder nach Abschluss des Trainings erfassen. Zum Beispiel können Sie während des Trainings Folgendes tun:

- Das Training wird beendet, möglicherweise absichtlich oder aufgrund bestimmter Fehler.

- Kontrollpunkt sichern.

- Laden Sie den Prüfpunkt später neu, möglicherweise auf anderer Hardware.

- Das Training wird neu gestartet.

Klasse

Eine Kategorie, zu der ein Label gehören kann. Beispiel:

- In einem binären Klassifizierungsmodell, das Spam erkennt, könnten die beiden Klassen Spam und Kein Spam sein.

- In einem Klassifizierungsmodell mit mehreren Klassen, das Hunderassen identifiziert, könnten die Klassen Pudel, Beagle, Mops usw. sein.

Ein Klassifikationsmodell sagt eine Klasse voraus. Im Gegensatz dazu sagt ein Regressionsmodell eine Zahl und nicht eine Klasse voraus.

Weitere Informationen finden Sie unter Classification im Machine Learning Crash Course.

Klassenbalancierter Datensatz

Ein Dataset mit kategorialen Labels, in denen die Anzahl der Instanzen jeder Kategorie ungefähr gleich ist. Betrachten Sie beispielsweise ein botanisches Dataset, dessen binäres Label entweder einheimische Pflanze oder nicht einheimische Pflanze sein kann:

- Ein Dataset mit 515 einheimischen Pflanzen und 485 nicht einheimischen Pflanzen ist ein klassenbalanciertes Dataset.

- Ein Datensatz mit 875 einheimischen Pflanzen und 125 nichteinheimischen Pflanzen ist ein klassenungleichgewichtiger Datensatz.

Eine formale Trennlinie zwischen klassenbalancierten Datensätzen und klassenunbalancierten Datensätzen existiert nicht. Die Unterscheidung wird erst dann wichtig, wenn ein Modell, das auf einem stark klassenungleichen Datensatz trainiert wurde, nicht konvergieren kann. Weitere Informationen finden Sie im Machine Learning Crash Course unter Datasets: imbalanced datasets.

Klassifikationsmodell

Ein Modell, dessen Vorhersage eine Klasse ist. Beispiele für Klassifizierungsmodelle:

- Ein Modell, das die Sprache eines Eingabesatzes vorhersagt (Französisch? Spanisch? Italienisch?).

- Ein Modell, das Baumarten vorhersagt (Ahorn? Eiche? Baobab?).

- Ein Modell, das die positive oder negative Klassifizierung einer bestimmten Erkrankung vorhersagt.

Im Gegensatz dazu sagen Regressionsmodelle Zahlen statt Klassen voraus.

Zwei gängige Arten von Klassifizierungsmodellen sind:

Klassifizierungsschwellenwert

Bei der binären Klassifizierung wird die Rohausgabe eines logistischen Regressionsmodells in eine Vorhersage der positiven Klasse oder der negativen Klasse umgewandelt. Der Klassifizierungsschwellenwert wird von einem Menschen ausgewählt, nicht durch das Modelltraining.

Ein logistisches Regressionsmodell gibt einen Rohwert zwischen 0 und 1 aus. Dann:

- Wenn dieser Rohwert größer als der Klassifizierungsschwellenwert ist, wird die positive Klasse vorhergesagt.

- Wenn dieser Rohwert kleiner als der Klassifizierungsschwelle ist, wird die negative Klasse vorhergesagt.

Angenommen, der Klassifizierungsschwellenwert ist 0,8. Wenn der Rohwert 0,9 ist, sagt das Modell die positive Klasse vorher. Wenn der Rohwert 0,7 ist, sagt das Modell die negative Klasse vorher.

Die Wahl des Klassifizierungsschwellenwerts hat einen großen Einfluss auf die Anzahl der falsch positiven und falsch negativen Ergebnisse.

SehenSchwellenwerte und die Konfusionsmatrix Weitere Informationen finden Sie im Machine Learning Crashkurs.

Klassifikator

Umgangssprachlicher Begriff für ein Klassifizierungsmodell.

Datensatz mit unausgewogenen Klassen

Ein Datensatz für eine Klassifizierung, bei der sich die Gesamtzahl der Labels jeder Klasse signifikant unterscheidet. Betrachten wir beispielsweise einen binären Klassifizierungsdatensatz, dessen zwei Labels wie folgt aufgeteilt sind:

- 1.000.000 Labels für negative Balken

- 10 positive Labels

Das Verhältnis von negativen zu positiven Labels beträgt 100.000 zu 1. Es handelt sich also um einen Datensatz mit unausgewogenen Klassen.

Im Gegensatz dazu ist der folgende Datensatz klassenbalanciert, da das Verhältnis von negativen zu positiven Labels relativ nahe bei 1 liegt:

- 517 Labels für negative Balken

- 483 positive Labels

Auch Datensätze mit mehreren Klassen können ein Klassenungleichgewicht aufweisen. Das folgende Dataset für die Multiklassenklassifizierung ist beispielsweise auch klassenungleichgewichtig, da ein Label viel mehr Beispiele als die anderen beiden enthält:

- 1.000.000 Etiketten der Klasse „grün“

- 200 Labels mit der Klasse „Lila“

- 350 Etiketten mit der Klasse "orange"

Das Training von Datensätzen mit ungleichen Klassenverhältnissen kann besondere Herausforderungen darstellen. Weitere Informationen finden Sie unter Unausgewogene Datensätze im Machine Learning Crash Course.

Siehe auch Entropie, Mehrheitsklasse und Minderheitsklasse.

Clipping

Eine Methode zum Verarbeiten von Ausreißern, indem Sie eine oder beide der folgenden Aktionen ausführen:

- Reduzierung der feature-Werte, die einen maximalen Schwellenwert überschreiten, auf diesen maximalen Schwellenwert.

- Erhöhung von Merkmalswerten, die unterhalb eines Mindestschwellenwerts liegen, bis zu diesem Mindestschwellenwert.

Angenommen, weniger als 0,5% der Werte für ein bestimmtes Merkmal liegen außerhalb des Bereichs von 40 bis 60. In diesem Fall haben Sie folgende Möglichkeiten:

- Alle Werte über 60 (dem maximalen Schwellenwert) werden auf genau 60 begrenzt.

- Alle Werte unter 40 (dem Mindestschwellenwert) werden auf genau 40 gekürzt.

Ausreißer können Modelle beschädigen und manchmal dazu führen, dass Gewichtungen während des Trainings überlaufen. Einige Ausreißer können auch Messwerte wie die Genauigkeit erheblich beeinträchtigen. Das Abknipsen ist eine gängige Technik, um den Schaden zu begrenzen.

Gradient Clipping erzwingt Gradient-Werte innerhalb eines bestimmten Bereichs während des Trainings.

Weitere Informationen finden Sie unter Numerische Daten: Normalisierung im Machine Learning Crash Course.

Cloud TPU

Ein spezieller Hardwarebeschleuniger, der entwickelt wurde, um Arbeitslasten für maschinelles Lernen in Google Cloud zu beschleunigen.

Clustering

Zusammenfassen ähnlicher Beispiele, insbesondere beim unbeaufsichtigten Lernen. Sobald alle Beispiele gruppiert sind, kann ein Mensch optional jedem Cluster eine Bedeutung zuweisen.

Es existieren viele Clustering-Algorithmen. Der k-Means-Algorithmus gruppiert Beispiele beispielsweise anhand ihrer Nähe zu einem Schwerpunkt, wie im folgenden Diagramm dargestellt:

Ein menschlicher Forscher könnte dann die Cluster überprüfen und beispielsweise Cluster 1 als „Zwergbäume“ und Cluster 2 als „normalgroße Bäume“ bezeichnen.

Betrachten wir als weiteres Beispiel einen Clustering-Algorithmus, der auf der Distanz eines Beispiels von einem Mittelpunkt basiert und wie folgt veranschaulicht wird:

Weitere Informationen finden Sie im Kurs Clustering.

Ko-Adaptation

Ein unerwünschtes Verhalten, bei dem Neuronen Muster in Trainingsdaten vorhersagen, indem sie sich fast ausschließlich auf die Ausgaben bestimmter anderer Neuronen verlassen, anstatt auf das Verhalten des Netzwerks als Ganzes. Wenn die Muster, die eine Co-Anpassung verursachen, nicht in den Validierungsdaten vorhanden sind, führt die Co-Anpassung zu einer Überanpassung. Die Dropout-Regularisierung reduziert die Co-Anpassung, da durch Dropout sichergestellt wird, dass Neuronen nicht ausschließlich auf bestimmte andere Neuronen angewiesen sind.

kollaboratives Filtern

Vorhersagen zu den Interessen eines Nutzers basierend auf den Interessen vieler anderer Nutzer treffen. Collaborative Filtering wird häufig in Empfehlungssystemen eingesetzt.

Weitere Informationen finden Sie unter Collaborative filtering im Kurs Recommendation Systems.

Kompaktmodell

Alle kleinen Modelle, die für die Ausführung auf kleinen Geräten mit begrenzten Rechenressourcen entwickelt wurden. Kompakte Modelle können beispielsweise auf Smartphones, Tablets oder eingebetteten Systemen ausgeführt werden.

compute

(Substantiv) Die von einem Modell oder System genutzten Rechenressourcen, wie z. B. Rechenleistung, Speicher und Datenspeicher.

Weitere Informationen finden Sie unter Beschleunigerchips.

Konzeptabweichung

Eine Änderung der Beziehung zwischen den Features und dem Label. Im Laufe der Zeit verringert die Konzeptabweichung die Qualität eines Modells.

Während des Trainings lernt das Modell die Beziehung zwischen den Merkmalen und ihren Bezeichnungen im Trainingsdatensatz. Wenn die Labels im Trainingsdatensatz gute Annäherungen an die reale Welt darstellen, dann sollte das Modell gute Vorhersagen für die reale Welt treffen. Aufgrund von Konzeptdrift verschlechtert sich die Vorhersageleistung des Modells jedoch im Laufe der Zeit.

Betrachten wir beispielsweise ein binäres Klassifizierungsmodell , das vorhersagt, ob ein bestimmtes Automodell "kraftstoffsparend" ist oder nicht. Das heißt, die Merkmale könnten sein:

- Autogewicht

- Motorverdichtung

- Getriebeart

während das Etikett entweder lautet:

- kraftstoffeffizient

- nicht kraftstoffeffizient

Das Konzept des „kraftstoffeffizienten Autos“ ändert sich jedoch ständig. Ein Automodell, das 1994 als kraftstoffsparend eingestuft wurde, würde 2024 mit ziemlicher Sicherheit als nicht kraftstoffsparend eingestuft werden. Ein Modell, das unter Konzeptdrift leidet, liefert im Laufe der Zeit immer weniger nützliche Vorhersagen.

Vergleichen Sie dies mit Nicht-Stationarität.

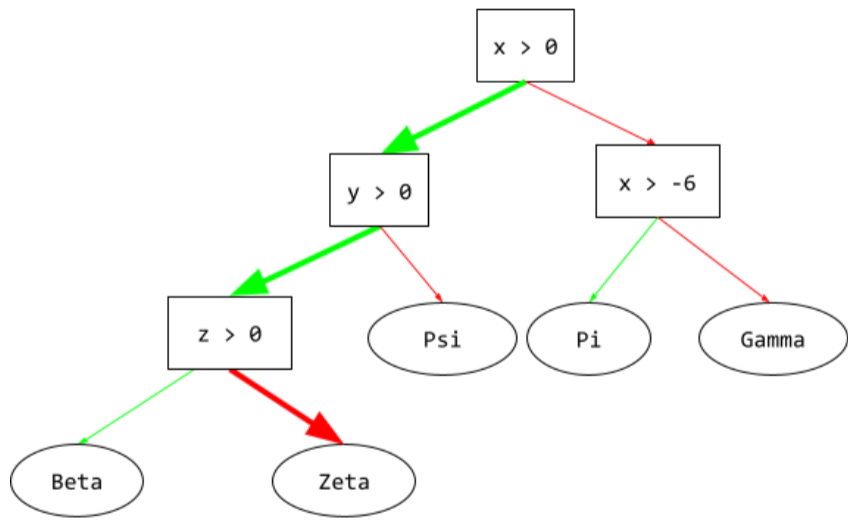

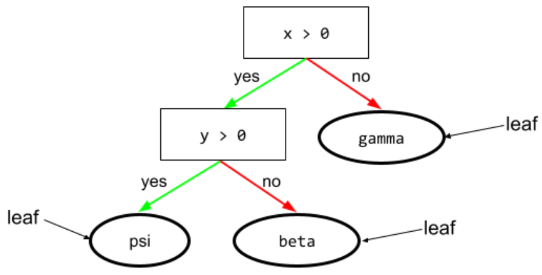

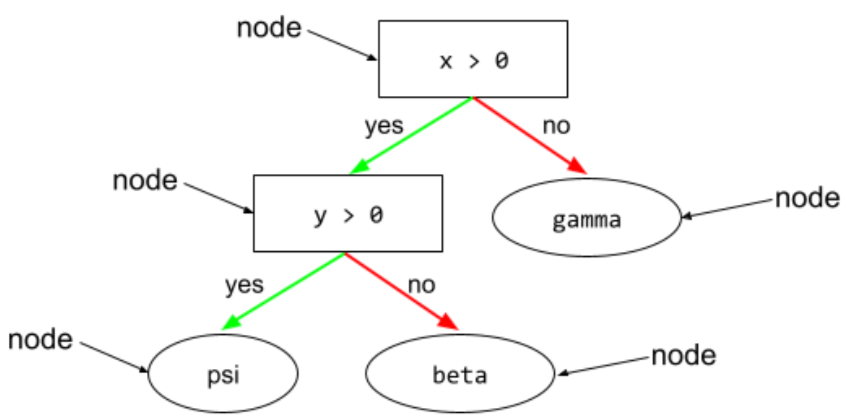

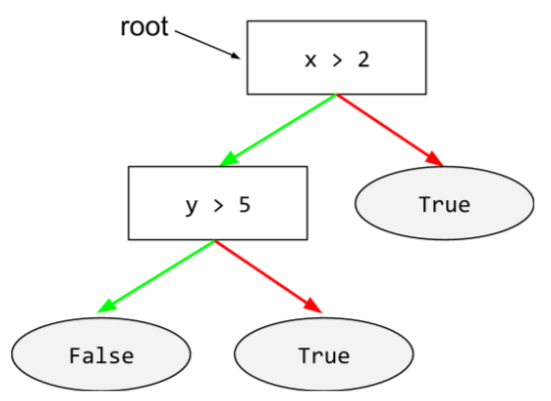

Bedingung

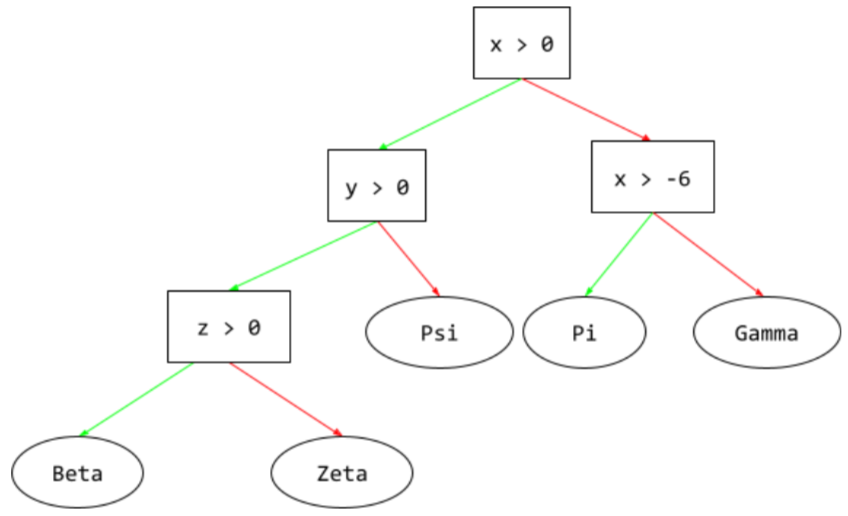

In einem Entscheidungsbaum ist jeder Knoten, in dem ein Test durchgeführt wird. Der folgende Entscheidungsbaum enthält beispielsweise zwei Bedingungen:

Eine Bedingung wird auch als Aufteilung oder Test bezeichnet.

Kontrastbedingung mit Blatt.

Siehe auch:

Weitere Informationen finden Sie im Kurs „Entscheidungsbäume“ unter Arten von Bedingungen.

Konfabulation

Synonym für Halluzination.

„Konfabulation“ ist wahrscheinlich ein technisch korrekterer Begriff als „Halluzination“. Allerdings erfreuten sich Halluzinationen zuerst großer Beliebtheit.

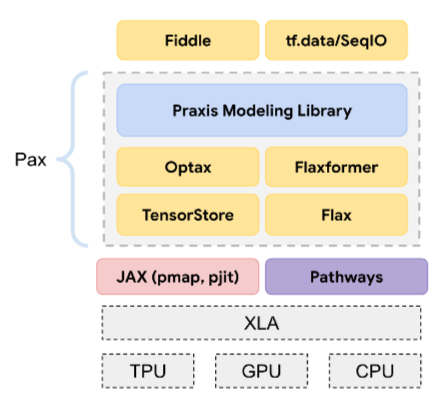

Konfiguration

Der Prozess der Zuweisung der anfänglichen Property-Werte, die zum Trainieren eines Modells verwendet werden, einschließlich:

- das Modell setzt sich aus Schichten zusammen

- der Speicherort der Daten

- Hyperparameter wie zum Beispiel:

In Machine-Learning-Projekten kann die Konfiguration über eine spezielle Konfigurationsdatei oder mithilfe von Konfigurationsbibliotheken wie den folgenden erfolgen:

Bestätigungsfehler

Die Tendenz, Informationen so zu suchen, zu interpretieren, zu bevorzugen und abzurufen, dass sie die eigenen, bereits bestehenden Überzeugungen oder Hypothesen bestätigen. Entwickler von maschinellem Lernen sammeln oder kennzeichnen möglicherweise unbeabsichtigt Daten auf eine Weise, die ein Ergebnis beeinflusst, das ihre bestehenden Überzeugungen stützt. Bestätigungsfehler ist eine Form des impliziten Vorurteils.

Experimenter Bias ist eine Form des Bestätigungsfehlers, bei dem ein Experimentator Modelle so lange trainiert, bis eine vorgefasste Hypothese bestätigt wird.

Wahrheitsmatrix

Eine NxN-Tabelle, in der die Anzahl der richtigen und falschen Vorhersagen eines Klassifizierungsmodells zusammengefasst wird. Betrachten Sie beispielsweise die folgende Konfusionsmatrix für ein binäres Klassifizierungsmodell :

| Tumor (vorhergesagt) | Nicht-Tumor (vorhergesagt) | |

|---|---|---|

| Tumor (Ground Truth) | 18 (TP) | 1 (FN) |

| Nicht-Tumor (Referenzwert) | 6 (FP) | 452 (TN) |

Die obige Wahrheitsmatrix zeigt Folgendes:

- Von den 19 Vorhersagen, bei denen die Grundwahrheit „Tumor“ war, hat das Modell 18 richtig und 1 falsch klassifiziert.

- Von den 458 Vorhersagen, bei denen die Grundwahrheit „Kein Tumor“ war, hat das Modell 452 richtig und 6 falsch klassifiziert.

Die Wahrheitsmatrix für ein Klassifizierungsproblem mit mehreren Klassen kann Ihnen helfen, Fehlermuster zu erkennen. Betrachten Sie beispielsweise die folgende Konfusionsmatrix für ein Multiklassen-Klassifikationsmodell mit drei Klassen, das drei verschiedene Schwertlilienarten (Virginica, Versicolor und Setosa) kategorisiert. Wenn die Ground Truth „Virginica“ war, zeigt die Wahrheitsmatrix, dass das Modell viel häufiger fälschlicherweise „Versicolor“ als „Setosa“ vorhergesagt hat:

| Setosa (vorhergesagt) | Versicolor (prognostiziert) | Virginica (prognostiziert) | |

|---|---|---|---|

| Setosa (Ground Truth) | 88 | 12 | 0 |

| Versicolor (Grundwahrheit) | 6 | 141 | 7 |

| Virginica (Grundwahrheit) | 2 | 27 | 109 |

Ein weiteres Beispiel: Eine Konfusionsmatrix könnte aufzeigen, dass ein Modell, das darauf trainiert wurde, handgeschriebene Ziffern zu erkennen, dazu neigt, fälschlicherweise 9 statt 4 oder fälschlicherweise 1 statt 7 vorherzusagen.

Konfusionsmatrizen enthalten genügend Informationen, um eine Vielzahl von Leistungskennzahlen zu berechnen, darunter Präzision und Recall.

Konstituentenanalyse

Einen Satz in kleinere grammatische Strukturen („Bestandteile“) unterteilen. Ein späterer Teil des ML-Systems, z. B. ein Modell für das Verständnis natürlicher Sprache, kann die Bestandteile leichter parsen als den ursprünglichen Satz. Betrachten Sie beispielsweise den folgenden Satz:

Meine Freundin hat zwei Katzen adoptiert.

Ein Constituency Parser kann diesen Satz in die folgenden zwei Bestandteile unterteilen:

- Mein Freund ist eine Nominalphrase.

- adopted two cats ist eine Verbphrase.

Diese Bestandteile können weiter in kleinere Bestandteile unterteilt werden. Zum Beispiel die Wortgruppe

zwei Katzen adoptiert

könnte weiter unterteilt werden in:

- Adopted ist ein Verb.

- zwei Katzen ist eine weitere Nominalphrase.

Kontextualisierte Spracheinbettung

Eine Einbettung, die sich dem „Verständnis“ von Wörtern und Wortgruppen durch fließend sprechende Menschen annähert. Kontextbezogene Spracheinbettungen können komplexe Syntax, Semantik und Kontext verstehen.

Betrachten Sie beispielsweise die Einbettungen des englischen Wortes cow (Kuh). Ältere Einbettungen wie word2vec können englische Wörter so darstellen, dass der Abstand im Einbettungsraum von cow zu bull ähnlich dem Abstand von ewe (weibliches Schaf) zu ram (männliches Schaf) oder von female zu male ist. Kontextbezogene Spracheinbettungen können noch einen Schritt weiter gehen, indem sie erkennen, dass englischsprachige Personen das Wort cow (Kuh) manchmal umgangssprachlich für Kuh oder Stier verwenden.

Kontextfenster

Die Anzahl der Tokens, die ein Modell in einem bestimmten Prompt verarbeiten kann. Je größer das Kontextfenster ist, desto mehr Informationen kann das Modell verwenden, um kohärente und konsistente Antworten auf den Prompt zu geben.

stetiges Feature

Ein numerisches Feature mit einem unendlichen Bereich möglicher Werte, z. B. Temperatur oder Gewicht.

Im Gegensatz dazu diskretes Merkmal.

willkürliche Stichproben

Verwendung eines Datasets, das nicht wissenschaftlich erhoben wurde, um schnelle Tests durchzuführen. Später ist es wichtig, zu einem wissenschaftlich erhobenen Dataset zu wechseln.

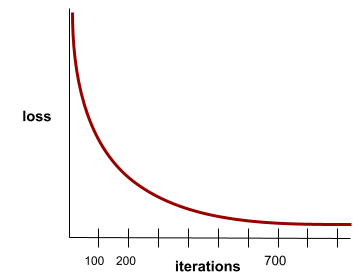

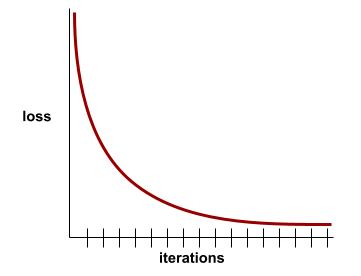

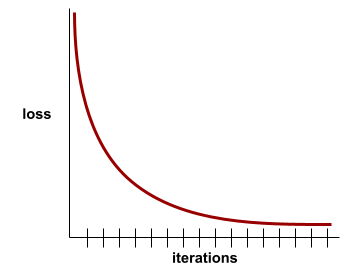

Konvergenz

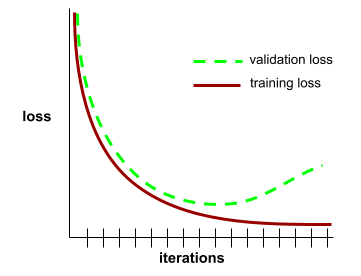

Ein Zustand, der erreicht wird, wenn sich die Verlust-Werte mit jeder Iteration nur sehr wenig oder gar nicht ändern. Die folgende Verlustkurve deutet beispielsweise auf eine Konvergenz nach etwa 700 Iterationen hin:

Ein Modell konvergiert, wenn zusätzliches Training das Modell nicht verbessert.

InDeep Learning Die Verlustwerte bleiben manchmal über viele Iterationen konstant oder nahezu konstant, bevor sie schließlich sinken. Bei einer längeren Periode konstanter Verlustwerte kann vorübergehend ein falsches Gefühl der Konvergenz entstehen.

Siehe auch vorzeitiges Stoppen.

Weitere Informationen finden Sie unter Modellkonvergenz- und Verlustkurven im Machine Learning Crash Course.

Konversationelles Programmieren

Ein iterativer Dialog zwischen Ihnen und einem generativen KI‑Modell zum Erstellen von Software. Sie geben einen Prompt ein, in dem Sie eine Software beschreiben. Anschließend verwendet das Modell diese Beschreibung, um Code zu generieren. Anschließend geben Sie einen neuen Prompt ein, um die Fehler im vorherigen Prompt oder im generierten Code zu beheben, und das Modell generiert aktualisierten Code. Sie und die KI tauschen sich so lange aus, bis die generierte Software gut genug ist.

Die Konversationscodierung entspricht im Wesentlichen der ursprünglichen Bedeutung von Vibe Coding.

Im Gegensatz zur spezifikationsbezogenen Programmierung.

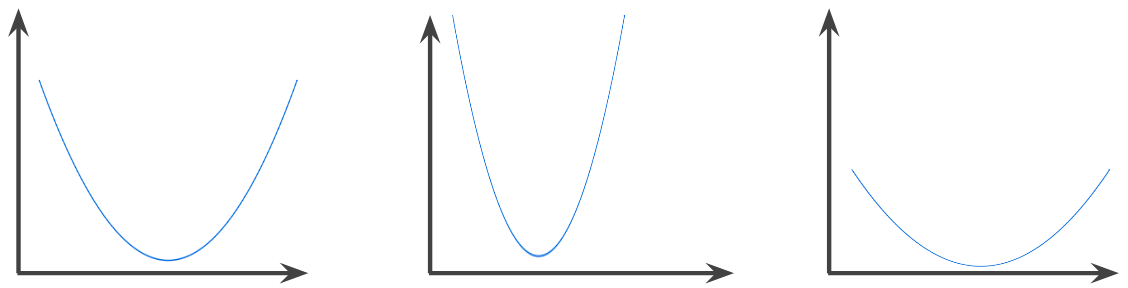

konvexe Funktion

Eine Funktion, bei der der Bereich über dem Funktionsgraphen eine konvexe Menge ist. Die prototypische konvexe Funktion hat in etwa die Form des Buchstabens U. Die folgenden Funktionen sind beispielsweise alle konvex:

Die folgende Funktion ist dagegen nicht konvex. Der Bereich über dem Diagramm ist keine konvexe Menge:

Eine streng konvexe Funktion hat genau einen lokalen Minimalpunkt, der auch der globale Minimalpunkt ist. Die klassischen U-förmigen Funktionen sind streng konvexe Funktionen. Einige konvexe Funktionen (z. B. gerade Linien) sind jedoch nicht U-förmig.

Weitere Informationen finden Sie unter Konvergenz und konvexe Funktionen im Machine Learning Crash Course.

konvexe Optimierung

Der Prozess, bei dem mathematische Verfahren wie der Gradientenabstieg verwendet werden, um das Minimum einer konvexen Funktion zu finden. Ein Großteil der Forschung im Bereich des maschinellen Lernens hat sich darauf konzentriert, verschiedene Probleme als konvexe Optimierungsprobleme zu formulieren und diese Probleme effizienter zu lösen.

Ausführliche Informationen finden Sie in Boyd und Vandenberghe, Convex Optimization.

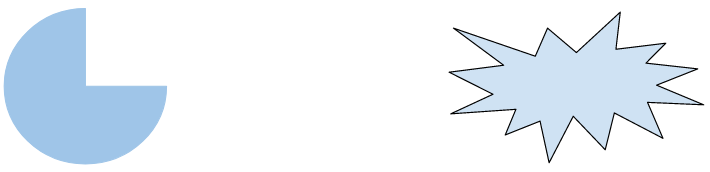

konvexe Menge

Eine Teilmenge des euklidischen Raums, in der eine Linie, die zwischen zwei beliebigen Punkten in der Teilmenge gezogen wird, vollständig innerhalb der Teilmenge verbleibt. Die folgenden beiden Formen sind beispielsweise konvexe Mengen:

Die folgenden beiden Formen sind dagegen keine konvexen Mengen:

Faltung

In der Mathematik wird damit umgangssprachlich eine Mischung aus zwei Funktionen bezeichnet. Beim maschinellen Lernen wird bei einer Faltung der Faltungsfilter mit der Eingabematrix kombiniert, um Gewichtungen zu trainieren.

Der Begriff „Faltung“ im maschinellen Lernen ist oft eine Kurzform für Faltungsoperation oder Faltungsebene.

Ohne Faltungen müsste ein Algorithmus für maschinelles Lernen ein separates Gewicht für jede Zelle in einem großen Tensor lernen. Wenn ein Algorithmus für maschinelles Lernen beispielsweise mit Bildern in der Größe 2.000 × 2.000 trainiert wird, muss er 4 Millionen separate Gewichte finden. Dank der Faltungen muss ein Algorithmus für maschinelles Lernen nur Gewichte für jede Zelle im Faltungsfilter finden. Dadurch wird der für das Trainieren des Modells erforderliche Speicherplatz erheblich reduziert. Wenn der Faltungsfilter angewendet wird, wird er einfach auf die Zellen repliziert, sodass jede Zelle mit dem Filter multipliziert wird.

Weitere Informationen finden Sie unter Einführung in Convolutional Neural Networks im Kurs Bildklassifizierung.

Faltungsfilter

Einer der beiden Operanden in einer Faltungsoperation. Der andere Akteur ist ein Ausschnitt einer Eingabematrix. Ein faltender Filter ist eine Matrix mit demselben Rang wie die Eingabematrix, aber einer kleineren Form. Bei einer 28 × 28-Eingabematrix kann der Filter beispielsweise eine beliebige 2D-Matrix sein, die kleiner als 28 × 28 ist.

Bei der fotografischen Bearbeitung werden alle Zellen in einem Faltungsfilter in der Regel auf ein konstantes Muster aus Einsen und Nullen gesetzt. Im maschinellen Lernen werden Faltungsfilter in der Regel mit Zufallszahlen initialisiert und dann werden die idealen Werte vom Netzwerk trainiert.

Weitere Informationen finden Sie im Kurs zur Bildklassifizierung unter Convolution.

Faltungsebene

Eine Schicht eines tiefen neuronalen Netzes, in der ein Faltungsfilter eine Eingabematrix durchläuft. Betrachten wir beispielsweise den folgenden 3x3 Faltungsfilter:

![Eine 3×3-Matrix mit den folgenden Werten: [[0,1,0], [1,0,1], [0,1,0]]](https://developers.google.com/static/machine-learning/glossary/images/ConvolutionalFilter33.svg?hl=de)

Die folgende Animation zeigt eine Faltungsschicht, die aus neun Faltungsvorgängen mit der 5×5-Eingabematrix besteht. Beachten Sie, dass jede Faltungsoperation auf einem anderen 3×3-Ausschnitt der Eingabematrix ausgeführt wird. Die resultierende 3×3-Matrix (rechts) besteht aus den Ergebnissen der neun Faltungsvorgänge:

![Eine Animation mit zwei Matrizen. Die erste Matrix ist die 5×5-Matrix: [[128,97,53,201,198], [35,22,25,200,195], [37,24,28,197,182], [33,28,92,195,179], [31,40,100,192,177]].

Die zweite Matrix ist die 3‑×‑3-Matrix:

[[181,303,618], [115,338,605], [169,351,560]].

Die zweite Matrix wird berechnet, indem der Faltungsfilter [[0, 1, 0], [1, 0, 1], [0, 1, 0]] auf verschiedene 3×3-Teilmengen der 5×5-Matrix angewendet wird.](https://developers.google.com/static/machine-learning/glossary/images/AnimatedConvolution.gif?hl=de)

Weitere Informationen finden Sie im Kurs „Bildklassifizierung“ unter Vollständig verbundene Ebenen.

Convolutional Neural Network (CNN)

Ein neuronales Netzwerk, in dem mindestens eine Schicht eine Faltungsschicht ist. Ein typisches Convolutional Neural Network besteht aus einer Kombination der folgenden Schichten:

Faltungsneuronale Netze haben bei bestimmten Problemstellungen, wie beispielsweise der Bilderkennung, große Erfolge erzielt.

Faltungsvorgang

Die folgende zweistufige mathematische Operation:

- Elementweise Multiplikation des Faltungsfilters und eines Ausschnitts einer Eingabematrix. Der Ausschnitt der Eingabematrix hat denselben Rang und dieselbe Größe wie der Faltungsfilter.

- Summe aller Werte in der resultierenden Produktmatrix.

Betrachten Sie beispielsweise die folgende 5×5-Eingabematrix:

![Die 5x5-Matrix: [[128,97,53,201,198], [35,22,25,200,195],

[37,24,28,197,182], [33,28,92,195,179], [31,40,100,192,177]].](https://developers.google.com/static/machine-learning/glossary/images/ConvolutionalLayerInputMatrix.svg?hl=de)

Stellen Sie sich nun den folgenden 2x2-Faltungsfilter vor:

![Die 2×2-Matrix: [[1, 0], [0, 1]]](https://developers.google.com/static/machine-learning/glossary/images/ConvolutionalLayerFilter.svg?hl=de)

Jede Faltungsoperation bezieht sich auf einen einzelnen 2x2-Ausschnitt der Eingangsmatrix. Nehmen wir beispielsweise an, wir verwenden den 2x2-Ausschnitt oben links in der Eingabematrix. Die Faltungsoperation auf diesem Ausschnitt sieht also wie folgt aus:

![Anwenden des Faltungsfilters [[1, 0], [0, 1]] auf den 2‑×‑2-Abschnitt oben links der Eingabematrix, der [[128,97], [35,22]] ist.

Der Faltungsfilter lässt die Werte 128 und 22 unverändert, setzt die Werte 97 und 35 aber auf null. Folglich ergibt die Faltungsoperation den Wert 150 (128 + 22).](https://developers.google.com/static/machine-learning/glossary/images/ConvolutionalLayerOperation.svg?hl=de)

Eine Faltungsschicht besteht aus einer Reihe von Faltungsvorgängen, die jeweils auf einen anderen Ausschnitt der Eingabematrix angewendet werden.

Kosten

Synonym für Verlust.

Co-Training

Ahalbüberwachtes Lernen Dieser Ansatz ist besonders dann nützlich, wenn alle folgenden Bedingungen erfüllt sind:

- Das Verhältnis von unbeschrifteten Beispielen zu beschrifteten Beispielen im Datensatz ist hoch.

- Dies ist ein Klassifizierungsproblem (binär oder Mehrklassen).

- DerDatensatz enthält zwei verschiedene Sätze von Vorhersagemerkmalen, die voneinander unabhängig und komplementär sind.

Beim Co-Training werden unabhängige Signale verstärkt. Nehmen wir beispielsweise ein Klassifizierungsmodell, das einzelne Gebrauchtwagen entweder als Gut oder Schlecht kategorisiert. Eine Gruppe von Vorhersage-Features kann sich auf aggregierte Merkmale wie das Jahr, die Marke und das Modell des Autos konzentrieren. Eine andere Gruppe von Vorhersage-Features kann sich auf die Fahrweise des Vorbesitzers und die Wartungshistorie des Autos konzentrieren.

Das grundlegende Paper zum Co-Training ist Combining Labeled and Unlabeled Data with Co-Training von Blum und Mitchell.

Kontrafaktische Fairness

Eine Fairnessmetrik, die prüft, ob ein Klassifikationsmodell für eine Person dasselbe Ergebnis liefert wie für eine andere Person, die mit der ersten identisch ist, außer in Bezug auf ein oder mehrere sensitive Attribute. Die Bewertung eines Klassifikationsmodells auf kontrafaktische Fairness ist eine Methode, um potenzielle Verzerrungsquellen in einem Modell aufzudecken.

Weitere Informationen finden Sie unter den folgenden Links:

- Fairness: Kontrafaktische Fairness im Crashkurs „Maschinelles Lernen“

- Wenn Welten aufeinanderprallen: Die Integration unterschiedlicher kontrafaktischer Annahmen im Kontext von Fairness

Verzerrung der Berichterstattung

Weitere Informationen finden Sie unter Stichproben-Bias.

Blütenpracht

Ein Satz oder eine Wortgruppe mit einer mehrdeutigen Bedeutung. Crash Blossoms stellen ein erhebliches Problem beim Verständnis natürlicher Sprache dar. Die Überschrift Red Tape Holds Up Skyscraper (Bürokratie verzögert Wolkenkratzer) ist beispielsweise ein Crash Blossom, da ein NLU-Modell die Überschrift wörtlich oder bildlich interpretieren könnte.

Kritiker

Synonym für Deep-Q-Netzwerk.

Cross-Entropy

Eine Verallgemeinerung von Log Loss für Klassifizierungsprobleme mit mehreren Klassen. Die Kreuzentropie quantifiziert den Unterschied zwischen zwei Wahrscheinlichkeitsverteilungen. Siehe auch Perplexity.

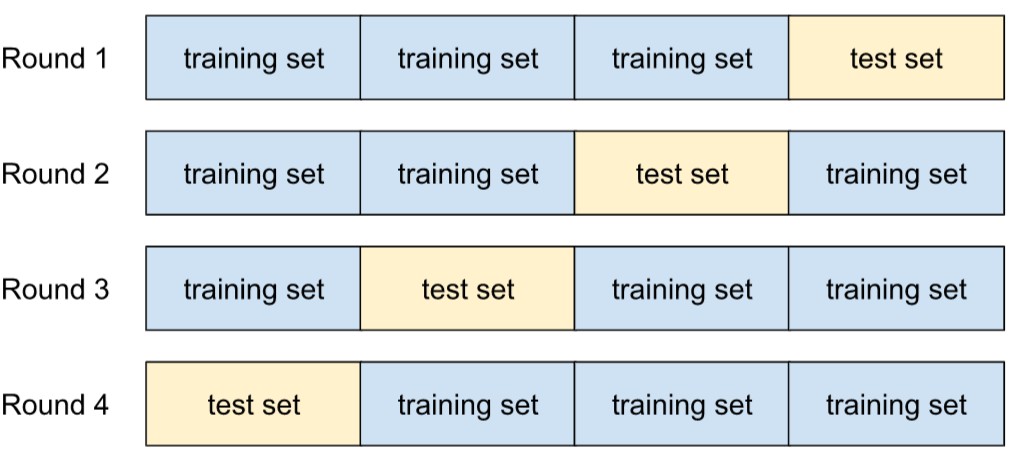

Kreuzvalidierung

Ein Mechanismus zum Schätzen, wie gut ein Modell auf neue Daten generalisiert werden kann. Dazu wird das Modell anhand von einem oder mehreren nicht überlappenden Datenteilmengen getestet, die aus dem Trainings-Dataset entfernt wurden.

Verteilungsfunktion

Eine Funktion, die die Häufigkeit von Stichproben definiert, die kleiner oder gleich einem Zielwert sind. Betrachten wir beispielsweise eine Normalverteilung kontinuierlicher Werte. Eine kumulative Verteilungsfunktion (CDF) gibt an, dass ungefähr 50% der Stichproben kleiner oder gleich dem Mittelwert sein sollten und dass ungefähr 84% der Stichproben kleiner oder gleich einer Standardabweichung über dem Mittelwert sein sollten.

D

Datenanalyse

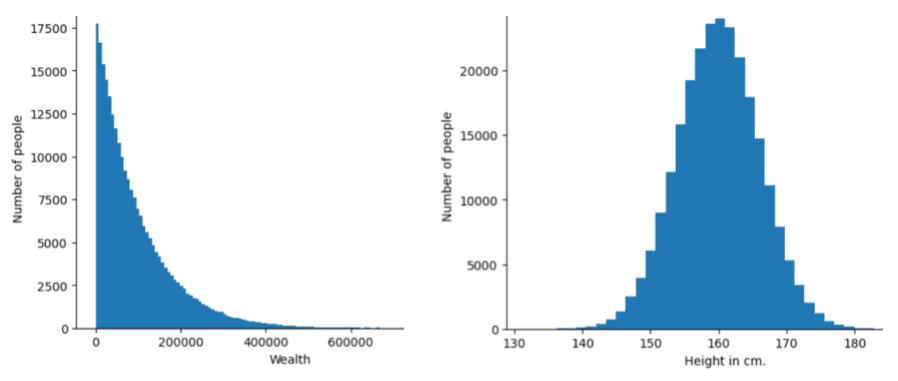

Daten anhand von Stichproben, Messungen und Visualisierungen verstehen. Eine Datenanalyse kann besonders dann nützlich sein, wenn ein Datensatz gerade erst empfangen wird, bevor man das erste Modell erstellt. Es ist außerdem unerlässlich, um Experimente zu verstehen und Probleme mit dem System zu beheben.

Datenerweiterung

Die Bandbreite und Anzahl der Trainingsbeispiele werden künstlich erhöht, indem vorhandene Beispiele transformiert werden, um zusätzliche Beispiele zu erstellen. Angenommen, Bilder sind eines Ihrer Features, aber Ihr Dataset enthält nicht genügend Bildbeispiele, damit das Modell nützliche Assoziationen lernen kann. Im Idealfall fügen Sie Ihrem Dataset genügend gelabelte Bilder hinzu, damit Ihr Modell richtig trainiert werden kann. Wenn das nicht möglich ist, kann durch Datenaugmentation jedes Bild gedreht, gestreckt und gespiegelt werden, um viele Varianten des Originalbilds zu erzeugen. So erhalten Sie möglicherweise genügend gelabelte Daten für ein hervorragendes Training.

DataFrame

Ein beliebter pandas Datentyp zur Darstellung von Datensätzen im Speicher.

Ein DataFrame ist analog zu einer Tabelle oder einer Tabellenkalkulation. Jede Spalte eines DataFrames hat einen Namen (einen Header) und jede Zeile wird durch eine eindeutige Nummer identifiziert.

Jede Spalte in einem DataFrame ist wie ein 2D-Array strukturiert, mit dem Unterschied, dass jeder Spalte ein eigener Datentyp zugewiesen werden kann.

Weitere Informationen finden Sie auf der offiziellen Referenzseite zu pandas.DataFrame.

Datenparallelität

Eine Methode zur Skalierung von Training oder Inferenz, die ein gesamtes Modell auf mehrere Geräte repliziert und dann eine Teilmenge der Eingabedaten an jedes Gerät weitergibt. Datenparallelität ermöglicht Training und Inferenz bei sehr großen Batchgrößen; allerdings setzt Datenparallelität voraus, dass das Modell klein genug ist, um auf alle Geräte zu passen.

Datenparallelität beschleunigt in der Regel das Training und die Inferenz.

Siehe auch Modellparallelität.

Dataset-API (tf.data)

Eine übergeordnete TensorFlow-API zum Lesen von Daten und zum Transformieren von Daten in ein Format, das für einen Algorithmus für maschinelles Lernen erforderlich ist.

Ein tf.data.Dataset-Objekt stellt eine Sequenz von Elementen dar, in der jedes Element einen oder mehrere Tensoren enthält. Ein tf.data.Iterator-Objekt bietet Zugriff auf die Elemente einer Dataset.

Datensatz oder Dataset

Eine Sammlung von Rohdaten, die in der Regel (aber nicht ausschließlich) in einem der folgenden Formate organisiert sind:

- eine Tabelle

- eine Datei im CSV-Format (kommagetrennte Werte)

Entscheidungsgrenze

Die Trennlinie zwischen den Klassen, die von einem Modell in binären Klassifizierungsaufgaben oder Klassifizierungsaufgaben mit mehreren Klassen gelernt werden. Im folgenden Bild, das ein binäres Klassifizierungsproblem darstellt, ist die Entscheidungsgrenze beispielsweise die Grenze zwischen der orangefarbenen und der blauen Klasse:

Entscheidungsbaumgruppe

Ein Modell, das aus mehreren Entscheidungsbäumen erstellt wurde. Bei einem Entscheidungsbaum wird eine Vorhersage getroffen, indem die Vorhersagen der einzelnen Entscheidungsbäume zusammengefasst werden. Beliebte Arten von Entscheidungsbäumen sind Random Forests und Gradient Boosted Trees.

Weitere Informationen finden Sie im Kurs „Decision Forests“ im Abschnitt Decision Forests.

Entscheidungsschwellenwert

Synonym für Klassifizierungsschwelle.

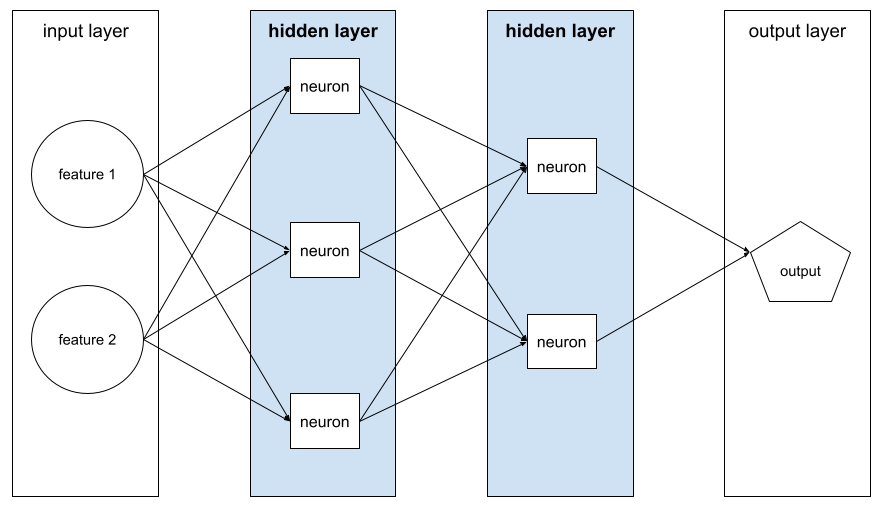

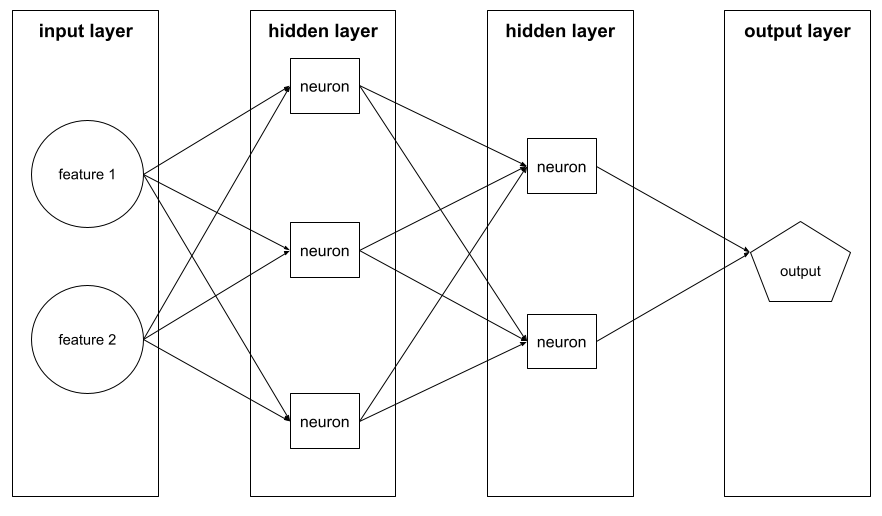

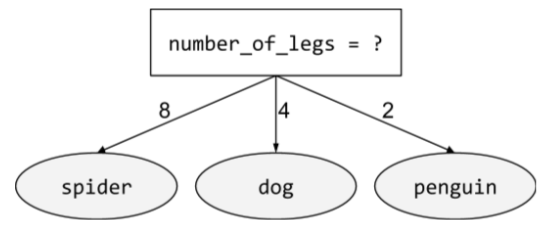

Entscheidungsbaum

Ein Modell für überwachtes Lernen, das aus einer Reihe von hierarchisch organisierten Bedingungen und Blättern besteht. Das folgende Beispiel zeigt einen Entscheidungsbaum:

Decoder

Im Allgemeinen jedes ML-System, das eine konvertierte, dichte oder interne Darstellung in eine rohere, spärliche oder externe Darstellung umwandelt.

Decoder sind oft Bestandteil eines größeren Modells, wo sie häufig mit einem Encoder gepaart werden.

Bei Sequence-to-Sequence-Aufgaben beginnt ein Decoder mit dem internen Status, der vom Encoder generiert wurde, um die nächste Sequenz vorherzusagen.

Transformer enthält die Definition eines Decoders innerhalb der Transformer-Architektur.

Weitere Informationen finden Sie unter Große Sprachmodelle im Machine Learning Crash Course.

Deep-Modell

Ein neuronales Netzwerk mit mehr als einer ausgeblendeten Ebene.

Ein Deep-Learning-Modell wird auch als neuronales Deep-Learning-Netzwerk bezeichnet.

Vergleich mit dem breiten Modell.

neuronales Deep-Learning-Netzwerk

Synonym für Deep-Learning-Modell.

Deep Q-Network (DQN)

Beim Q-Learning wird ein tiefes neuronales Netzwerk trainiert, das Q-Funktionen vorhersagt.

Critic ist ein Synonym für Deep-Q-Network.

demografische Parität

Eine Fairnessmetrik, die erfüllt ist, wenn die Ergebnisse der Klassifizierung eines Modells nicht von einem gegebenen sensitiven Attribut abhängen.

Wenn sich beispielsweise sowohl Lilliputaner als auch Brobdingnagier an der Glubbdubdrib-Universität bewerben, ist demografische Parität erreicht, wenn der Prozentsatz der zugelassenen Lilliputaner dem Prozentsatz der zugelassenen Brobdingnagier entspricht, unabhängig davon, ob eine Gruppe im Durchschnitt besser qualifiziert ist als die andere.

Im Gegensatz dazu erlauben gleichberechtigte Chancen und Chancengleichheit, dass Klassifizierungsergebnisse insgesamt von sensiblen Attributen abhängen, aber nicht, dass Klassifizierungsergebnisse für bestimmte angegebene Grundwahrheitslabels von sensiblen Attributen abhängen. Im Google Research-Blogpost zum Thema „Diskriminierung durch intelligentes maschinelles Lernen“ finden Sie eine Visualisierung, in der die Kompromisse bei der Optimierung für demografische Parität dargestellt werden.

Weitere Informationen finden Sie unter Fairness: demographic parity im Machine Learning Crash Course.

Rauschunterdrückung

Ein gängiger Ansatz für selbstüberwachtes Lernen, bei dem:

Durch Denoising kann aus Beispielen ohne Labels gelernt werden. Das ursprüngliche Dataset dient als Ziel oder Label und die verrauschten Daten als Eingabe.

Einige Masked Language Models verwenden Denoising so:

- Einem unbeschrifteten Satz wird künstlich Rauschen hinzugefügt, indem einige der Token maskiert werden.

- Das Modell versucht, die ursprünglichen Token vorherzusagen.

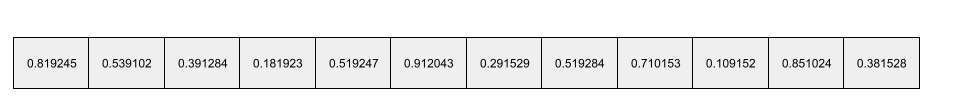

vollbesetztes Feature

Ein Feature, in dem die meisten oder alle Werte ungleich null sind, in der Regel ein Tensor mit Gleitkommawerten. Der folgende Tensor mit 10 Elementen ist beispielsweise dicht, da 9 seiner Werte ungleich null sind:

| 8 | 3 | 7 | 5 | 2 | 4 | 0 | 4 | 9 | 6 |

Im Gegensatz dazu sparse feature.

dichte Schicht

Synonym für vollständig verbundene Schicht.

Tiefe

Die Summe der folgenden Elemente in einem neuronalen Netzwerk:

- die Anzahl der ausgeblendeten Ebenen

- die Anzahl der Ausgabelayer, die in der Regel 1 ist

- die Anzahl der Einbettungsebenen

Ein neuronales Netzwerk mit fünf verborgenen Schichten und einer Ausgabeschicht hat beispielsweise eine Tiefe von 6.

Die Eingabeebene hat keinen Einfluss auf die Tiefe.

Tiefenweise separable Convolutional Neural Networks (sepCNN)

Eine Architektur für faltende neuronale Netze, die auf Inception basiert, wobei Inception-Module durch tiefenweise separable Faltungen ersetzt werden. Auch als Xception bekannt.

Eine tiefenweise separable Faltung (auch als separable Faltung abgekürzt) zerlegt eine Standard-3D-Faltung in zwei separate Faltungsoperationen, die recheneffizienter sind: erstens eine tiefenweise Faltung mit einer Tiefe von 1 (n × n × 1) und zweitens eine punktweise Faltung mit einer Länge und Breite von 1 (1 × 1 × n).

Mehr dazu erfahren Sie unter Xception: Deep Learning with Depthwise Separable Convolutions.

abgeleitete Bezeichnung

Synonym für Proxy-Label.

Gerät

Ein überladener Begriff mit folgenden zwei möglichen Definitionen:

- Eine Kategorie von Hardware, die eine TensorFlow-Sitzung ausführen kann, einschließlich CPUs, GPUs und TPUs.

- Beim Trainieren eines ML-Modells auf Beschleunigerchips (GPUs oder TPUs) ist dies der Teil des Systems, der Tensoren und Einbettungen tatsächlich verarbeitet. Das Gerät wird von Beschleunigerchips angetrieben. Im Gegensatz dazu wird der Host in der Regel auf einer CPU ausgeführt.

Differential Privacy

Beim maschinellen Lernen wird ein Anonymisierungsansatz verwendet, um alle vertraulichen Daten (z. B. personenbezogene Daten einer Person) zu schützen, die im Trainingsset eines Modells enthalten sind. Dieser Ansatz sorgt dafür, dass das Modell nicht viel über eine bestimmte Person lernt oder sich daran erinnert. Dies wird durch Sampling und Hinzufügen von Rauschen während des Modelltrainings erreicht, um einzelne Datenpunkte zu verschleiern und das Risiko zu minimieren, dass sensible Trainingsdaten offengelegt werden.

Differential Privacy wird auch außerhalb von Machine Learning eingesetzt. Data Scientists verwenden beispielsweise manchmal Differential Privacy, um den Datenschutz für Einzelpersonen zu gewährleisten, wenn sie Statistiken zur Produktnutzung für verschiedene demografische Gruppen berechnen.

Dimensionsreduktion

Die Anzahl der Dimensionen, die zur Darstellung eines bestimmten Merkmals in einem Merkmalsvektor verwendet werden, wird verringert, typischerweise durch Umwandlung in einen Einbettungsvektor.

Dimensionen

Überladener Begriff mit einer der folgenden Definitionen:

Die Anzahl der Koordinatenebenen in einem Tensor. Beispiel:

- Ein Skalar hat die Dimension Null; zum Beispiel

["Hello"]. - Ein Vektor hat eine Dimension; zum Beispiel

[3, 5, 7, 11]. - Eine Matrix hat zwei Dimensionen, z. B.

[[2, 4, 18], [5, 7, 14]]. Sie können eine bestimmte Zelle in einem eindimensionalen Vektor mit einer Koordinate eindeutig angeben. Für eine bestimmte Zelle in einer zweidimensionalen Matrix benötigen Sie zwei Koordinaten.

- Ein Skalar hat die Dimension Null; zum Beispiel

Die Anzahl der Einträge in einem Merkmalsvektor.

Die Anzahl der Elemente in einer Einbettungsschicht.

Direktes Prompting

Synonym für zero-shot prompting.

diskretes Feature

Ein Feature mit einer endlichen Menge möglicher Werte. Ein Feature, dessen Werte nur Tier, Gemüse oder Mineral sein können, ist beispielsweise ein diskretes (oder kategorisches) Feature.

Im Gegensatz dazu steht das stetige Feature.

diskriminatives Modell

Ein Modell, das Labels aus einer Gruppe von einem oder mehreren Merkmalen vorhersagt. Formaler ausgedrückt definieren diskriminative Modelle die bedingte Wahrscheinlichkeit einer Ausgabe in Abhängigkeit von den Features und Gewichtungen, d. h.:

p(output | features, weights)

Ein Modell, das anhand von Features und Gewichten vorhersagt, ob es sich bei einer E-Mail um Spam handelt, ist beispielsweise ein diskriminatives Modell.

Die überwiegende Mehrheit der überwachten Lernmodelle, einschließlich Klassifikations- und Regressionsmodelle, sind diskriminative Modelle.

Im Gegensatz dazu steht das generative Modell.

Diskriminator

Ein System, das feststellt, ob examples echt oder gefälscht sind.

Alternativ das Subsystem in einem generativen kontradiktorischen Netzwerk, das bestimmt, ob die vom Generator erstellten Beispiele echt oder gefälscht sind.

Weitere Informationen finden Sie unter Der Diskriminator im GAN-Kurs.

ungleiche Auswirkungen

Entscheidungen über Personen treffen, die sich unverhältnismäßig auf verschiedene Untergruppen der Bevölkerung auswirken. Dies bezieht sich in der Regel auf Situationen, in denen ein algorithmischer Entscheidungsprozess einigen Untergruppen mehr schadet oder nützt als anderen.

Angenommen, ein Algorithmus, der die Berechtigung eines Lilliputaners für ein Miniaturhausdarlehen bestimmt, klassifiziert ihn eher als „nicht berechtigt“, wenn seine Postanschrift eine bestimmte Postleitzahl enthält. Wenn Big-Endian-Lilliputaner mit höherer Wahrscheinlichkeit Postadressen mit dieser Postleitzahl haben als Little-Endian-Lilliputaner, kann dieser Algorithmus zu ungleichen Auswirkungen führen.

Im Gegensatz dazu konzentriert sich ungleiche Behandlung auf Ungleichheiten, die entstehen, wenn Untergruppenmerkmale explizite Eingaben für einen algorithmischen Entscheidungsprozess sind.

Ungleichbehandlung

Die sensitiven Attribute der Probanden werden in einen algorithmischen Entscheidungsprozess einbezogen, sodass verschiedene Untergruppen von Personen unterschiedlich behandelt werden.

Angenommen, ein Algorithmus ermittelt, ob Lilliputaner Anspruch auf einen Kleinsthaus-Kredit haben, basierend auf den Daten, die sie in ihrem Kreditantrag angeben. Wenn der Algorithmus die Zugehörigkeit eines Lilliputaners als Big-Endian oder Little-Endian als Eingabe verwendet, wird eine ungleiche Behandlung entlang dieser Dimension vorgenommen.

Im Gegensatz dazu konzentriert sich ungleiche Auswirkungen auf Ungleichheiten bei den gesellschaftlichen Auswirkungen algorithmischer Entscheidungen auf Untergruppen, unabhängig davon, ob diese Untergruppen Eingaben für das Modell sind.

Destillation