公平性: バイアスの評価

コレクションでコンテンツを整理

必要に応じて、コンテンツの保存と分類を行います。

モデルの評価時に、テストまたは検証全体に対して計算される指標

モデルの公平性を正確に把握できるとは限りません。

大部分の例で全体的に優れたモデル性能を発揮すると、低い

サンプルのサブセットでパフォーマンスが損なわれるため、バイアスが

学習します。パフォーマンス指標の集計値(

適合率、

再現率、

accuracy が必ずしも

これらの問題を明らかにします

入学モデルを再確認し、新しい手法をいくつか試すことができます。

をご覧ください。

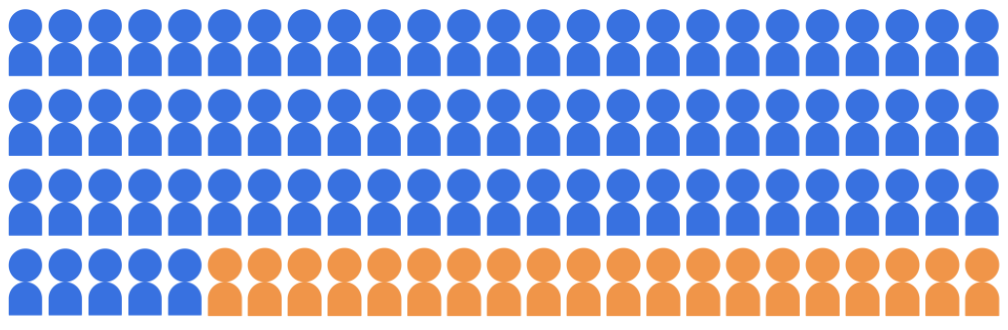

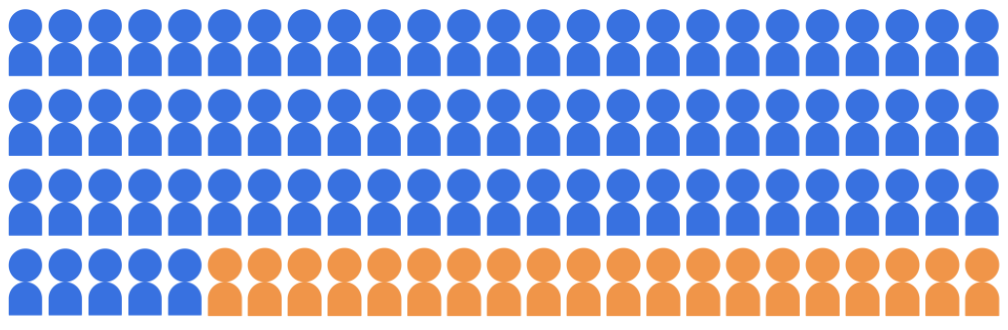

入学分類モデルにより、20 名の学生が入学を承諾すると

2 つの属性グループに属する、100 人の候補者プールから

多数派のグループ(青、生徒 80 人)とマイノリティ グループ

(オレンジ、生徒数 20 人)。

図 1. 生徒 100 人の候補プール: 80 人が所属

多数派グループ(青)で、20 人の生徒が少数派グループに所属している

(オレンジ)。

図 1. 生徒 100 人の候補プール: 80 人が所属

多数派グループ(青)で、20 人の生徒が少数派グループに所属している

(オレンジ)。

モデルは、認定資格を持つ学生を、

両方のユーザー属性グループに属します。

モデルの公平性に関する予測をどのように評価すればよいでしょうか。さまざまな

それぞれ異なった数学的表現になります

「公平性」の定義です。以降のセクションでは

具体的には、人口統計の同等性、機会の平等、

対事実的公平性です。

特に記載のない限り、このページのコンテンツはクリエイティブ・コモンズの表示 4.0 ライセンスにより使用許諾されます。コードサンプルは Apache 2.0 ライセンスにより使用許諾されます。詳しくは、Google Developers サイトのポリシーをご覧ください。Java は Oracle および関連会社の登録商標です。

最終更新日 2024-08-13 UTC。

[[["わかりやすい","easyToUnderstand","thumb-up"],["問題の解決に役立った","solvedMyProblem","thumb-up"],["その他","otherUp","thumb-up"]],[["必要な情報がない","missingTheInformationINeed","thumb-down"],["複雑すぎる / 手順が多すぎる","tooComplicatedTooManySteps","thumb-down"],["最新ではない","outOfDate","thumb-down"],["翻訳に関する問題","translationIssue","thumb-down"],["サンプル / コードに問題がある","samplesCodeIssue","thumb-down"],["その他","otherDown","thumb-down"]],["最終更新日 2024-08-13 UTC。"],[],[]]