В предыдущем разделе был представлен набор метрик модели, все из которых рассчитаны при одном пороговом значении классификации. Но если вы хотите оценить качество модели по всем возможным пороговым значениям, вам понадобятся другие инструменты.

Кривая рабочей характеристики приемника (ROC)

Кривая ROC — это визуальное представление производительности модели по всем порогам. Длинная версия названия, рабочая характеристика приемника, является пережитком радарного обнаружения времен Второй мировой войны.

Кривая ROC строится путем вычисления истинно положительного уровня (TPR) и ложноположительного уровня (FPR) при каждом возможном пороге (на практике, в выбранных интервалах), а затем построения графика TPR по FPR. Идеальная модель, которая при некотором пороге имеет TPR 1,0 и FPR 0,0, может быть представлена либо точкой в (0, 1), если все остальные пороги игнорируются, либо следующим образом:

Площадь под кривой (AUC)

Площадь под ROC-кривой (AUC) представляет собой вероятность того, что модель, если ей дать случайно выбранные положительный и отрицательный пример, оценит положительный пример выше, чем отрицательный.

Идеальная модель выше, содержащая квадрат со сторонами длиной 1, имеет площадь под кривой (AUC) 1,0. Это означает, что существует 100% вероятность того, что модель правильно ранжирует случайно выбранный положительный пример выше, чем случайно выбранный отрицательный пример. Другими словами, глядя на разброс точек данных ниже, AUC дает вероятность того, что модель поместит случайно выбранный квадрат справа от случайно выбранного круга, независимо от того, где установлен порог.

В более конкретных терминах, классификатор спама с AUC 1.0 всегда присваивает случайному спам-письму более высокую вероятность быть спамом, чем случайному легитимному письму. Фактическая классификация каждого письма зависит от выбранного вами порога.

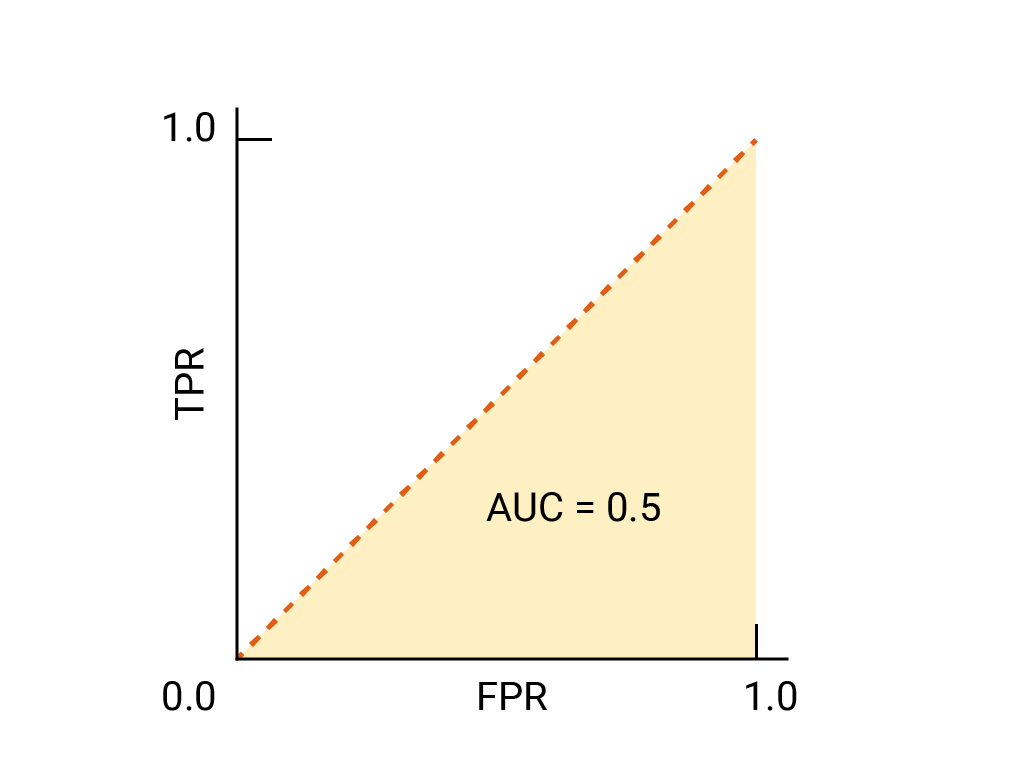

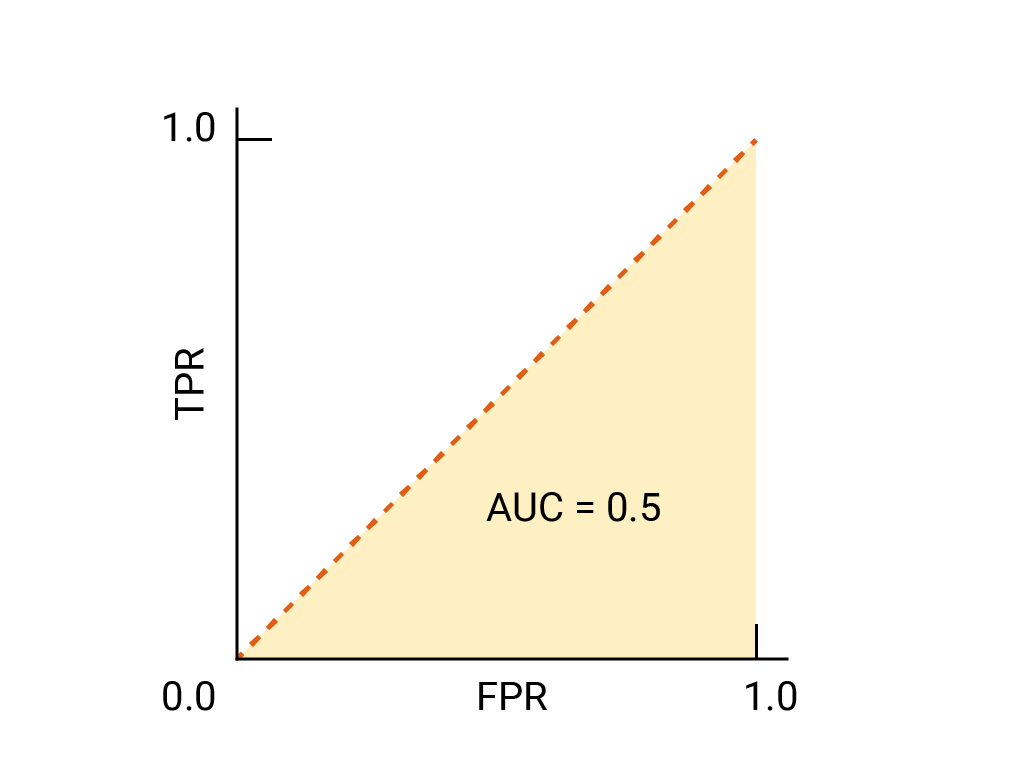

Для бинарного классификатора модель, которая работает точно так же хорошо, как случайные догадки или подбрасывания монеты, имеет ROC, представляющую собой диагональную линию от (0,0) до (1,1). AUC составляет 0,5, что представляет собой 50% вероятность правильного ранжирования случайного положительного и отрицательного примера.

В примере со спам-классификатором спам-классификатор с AUC 0,5 присваивает случайному спам-письму более высокую вероятность того, что оно является спамом, чем случайное законное письмо, только в половине случаев.

(Необязательно, расширенный) Кривая точности-полноты

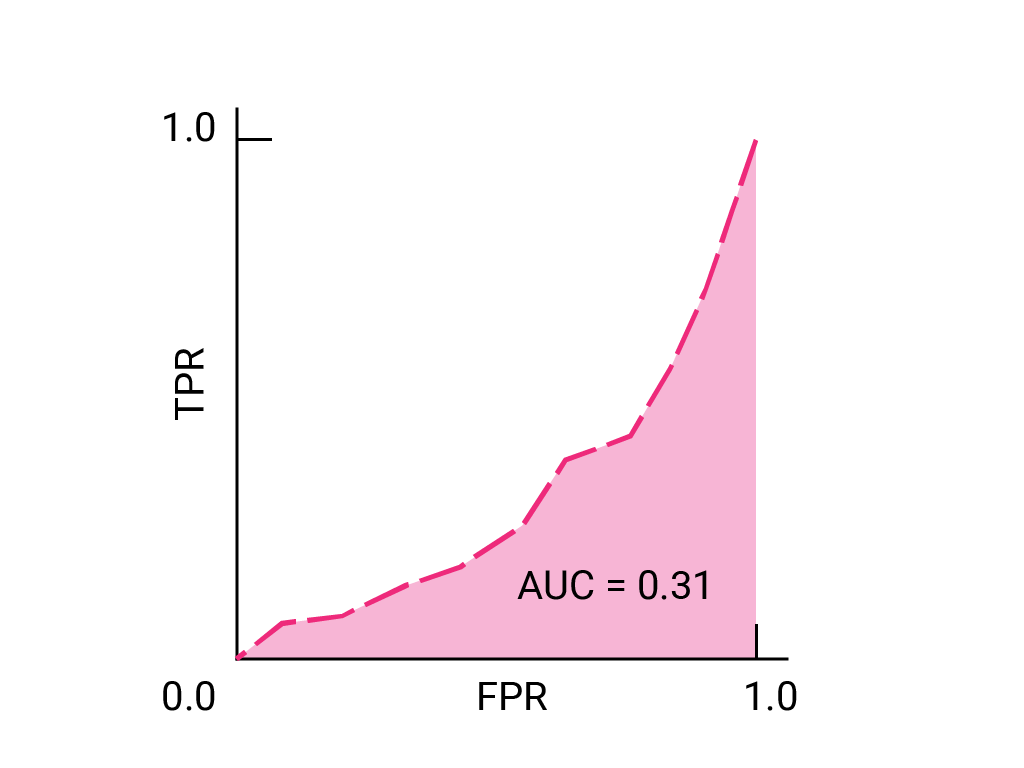

AUC и ROC хорошо подходят для сравнения моделей, когда набор данных примерно сбалансирован между классами. Когда набор данных несбалансирован, кривые точности-полноты (PRC) и площадь под этими кривыми могут предложить лучшую сравнительную визуализацию производительности модели. Кривые точности-полноты создаются путем нанесения точности на ось Y и полноты на ось X по всем пороговым значениям.

AUC и ROC для выбора модели и порогового значения

AUC — полезная мера для сравнения производительности двух разных моделей, если набор данных примерно сбалансирован. Модель с большей площадью под кривой, как правило, является лучшей.

Точки на кривой ROC, ближайшие к (0,1), представляют собой диапазон наиболее эффективных пороговых значений для данной модели. Как обсуждалось в разделах Пороговые значения , Матрица путаницы и Выбор метрики и компромиссов , выбранный вами порог зависит от того, какая метрика наиболее важна для конкретного варианта использования. Рассмотрим точки A, B и C на следующей диаграмме, каждая из которых представляет собой пороговое значение:

Если ложные срабатывания (ложные тревоги) обходятся очень дорого, может иметь смысл выбрать порог, который дает более низкий FPR, как в точке A, даже если TPR уменьшается. И наоборот, если ложные срабатывания дешевы, а ложные отрицательные (пропущенные истинные срабатывания) обходятся очень дорого, порог для точки C, который максимизирует TPR, может быть предпочтительнее. Если затраты примерно равны, точка B может предложить наилучший баланс между TPR и FPR.

Вот кривая ROC для данных, которые мы видели ранее:

Упражнение: проверьте свое понимание

(Необязательно, продвинутый) Бонусный вопрос

Представьте себе ситуацию, когда лучше позволить спаму попасть в папку «Входящие», чем отправить критически важное для бизнеса письмо в папку «Спам». Вы обучили классификатор спама для этой ситуации, где положительный класс — спам, а отрицательный — не спам. Какая из следующих точек на кривой ROC для вашего классификатора предпочтительнее?