En esta página, se incluyen los términos del glosario de evaluación de idiomas. Para ver todos los términos del glosario, haz clic aquí.

A

Attention,

Mecanismo usado en una red neuronal que indica la importancia de una palabra en particular o una parte de una palabra. La atención comprime la cantidad de información que un modelo necesita para predecir el siguiente token o palabra. Un mecanismo de atención típico puede consistir en una suma ponderada sobre un conjunto de entradas, en la que otra parte de la red neuronal calcula la ponderación de cada entrada.

Consulta también la autoatención y la autoatención de varias cabezas, que son los componentes básicos de los Transformers.

codificador automático

Un sistema que aprende a extraer la información más importante de la entrada. Los codificadores automáticos son una combinación de un codificador y un decodificador. Los codificadores automáticos se basan en el siguiente proceso de dos pasos:

- El codificador asigna la entrada a un formato (intermedio) con pérdida de dimensión baja.

- El decodificador compila una versión con pérdida de la entrada original asignando el formato de menor dimensión al formato de entrada original de mayor dimensión.

Los codificadores automáticos se entrenan de extremo a extremo haciendo que el decodificador intente reconstruir la entrada original a partir del formato intermedio del codificador lo más cerca posible. Debido a que el formato intermedio es más pequeño (de menor dimensión) que el original, el codificador automático se ve obligado a aprender qué información de la entrada es esencial, y el resultado no será perfectamente idéntico a la entrada.

Por ejemplo:

- Si los datos de entrada son un gráfico, la copia no exacta sería similar al gráfico original, pero algo modificado. Es posible que la copia no exacta quite el ruido del gráfico original o rellene algunos píxeles faltantes.

- Si los datos de entrada son texto, un codificador automático generaría texto nuevo que imitaría el texto original (pero no es idéntico al mismo).

Consulta también los codificadores automáticos variacionales.

modelo de regresión automático

model que infiere una predicción a partir de sus propias predicciones anteriores. Por ejemplo, los modelos de lenguaje de regresión automática predicen el siguiente token según los tokens que se predijeron con anterioridad. Todos los modelos grandes de lenguaje basados en Transformer son de regresión automática.

Por el contrario, los modelos de imagen basados en GAN no suelen ser autorregresivos, ya que generan una imagen en un solo pase hacia delante y no de manera iterativa en pasos. Sin embargo, algunos modelos de generación de imágenes son de regresión automáticos porque generan una imagen en pasos.

B

bolsa de palabras

Es una representación de las palabras en una frase o pasaje, sin importar el orden. Por ejemplo, una bolsa de palabras representa las siguientes tres frases de forma idéntica:

- el perro salta

- salta el perro

- perro salta el

Cada palabra se asigna a un índice en un vector disperso, donde el vector tiene un índice para cada palabra del vocabulario. Por ejemplo, la frase el perro salta se asigna a un vector de atributos con valores distintos de cero en los tres índices correspondientes a las palabras el, perro y salta. El valor distinto de cero puede ser cualquiera de los siguientes:

- Un 1 para indicar la presencia de una palabra.

- Es la cantidad de veces que una palabra aparece en la bolsa. Por ejemplo, si la frase fuera el perro granate es un perro con pelaje granate, entonces tanto negro como perro se representarían como 2, mientras que las demás palabras se representarían con un 1.

- Algún otro valor, como el logaritmo de la cantidad de veces que una palabra aparece en la bolsa

BERT (representaciones de codificador bidireccional de transformadores)

Arquitectura de modelo para la representación de texto. Un modelo BERT entrenado puede actuar como parte de un modelo más grande para la clasificación de texto, o bien otras tareas de AA.

BERT tiene las siguientes características:

- Usa la arquitectura de Transformer y, por lo tanto, se basa en la autoatención.

- Usa la parte del codificador del transformador. El trabajo del codificador es producir buenas representaciones de texto, en lugar de realizar una tarea específica como la clasificación.

- Es bidireccional.

- Usa el enmascaramiento para el entrenamiento no supervisado.

Las variantes de BERT incluyen las siguientes:

Consulta Código abierto de BERT: Entrenamiento previo de vanguardia para procesamiento de lenguaje natural para obtener una descripción general de BERT.

bidireccional

Término usado para describir un sistema que evalúa el texto que precede y sigue una sección de texto objetivo. Por el contrario, un sistema unidireccional solo evalúa el texto que antecede a una sección de texto objetivo.

Por ejemplo, considera un modelo de lenguaje enmascarado que debe determinar las probabilidades de la palabra o las palabras que representan el subrayado en la siguiente pregunta:

¿Qué _____ contigo?

Un modelo de lenguaje unidireccional tendría que basar sus probabilidades solo en el contexto proporcionado por las palabras “qué”, “es” y “el”. Por el contrario, un modelo de lenguaje bidireccional también podría obtener contexto de “con” y “tú”, lo que podría ayudar al modelo a generar mejores predicciones.

modelo de lenguaje bidireccional

Es un modelo de idioma que determina la probabilidad de que un token determinado esté presente en una ubicación determinada en un extracto de texto según el texto anterior y siguiente.

bigrama

n-grama en el que n=2.

BLEU (Bilingual Evaluation Understudy)

Una puntuación entre 0.0 y 1.0 inclusive, que indica la calidad de una traducción entre dos idiomas humanos (por ejemplo, entre inglés y ruso). Una puntuación BLEU de 1.0 indica una traducción perfecta; una puntuación BLEU de 0.0 indica una traducción terrible.

C

modelo causal de lenguaje

Sinónimo de modelo unidireccional de lenguaje.

Consulta el modelo de lenguaje bidireccional para contrastar diferentes enfoques direccionales en el modelado de lenguaje.

cadena de pensamientos

Es una técnica de ingeniería de instrucciones que fomenta que un modelo grande de lenguaje (LLM) explique su razonamiento, paso a paso. Por ejemplo, considera la siguiente instrucción y presta especial atención a la segunda oración:

¿Cuántas fuerzas g experimentaría un conductor en un automóvil que va de 0 a 96 kilómetros por hora en 7 segundos? En la respuesta, muestra todos los cálculos relevantes.

Es probable que la respuesta del LLM tenga las siguientes características:

- Muestra una secuencia de fórmulas físicas, ingresando los valores 0, 60 y 7 en los lugares adecuados.

- Explica por qué eligió esas fórmulas y qué significan las distintas variables.

La indicación de cadena de pensamiento fuerza al LLM a realizar todos los cálculos, lo que podría conducir a una respuesta más correcta. Además, las indicaciones de cadena de pensamientos permiten al usuario examinar los pasos del LLM para determinar si la respuesta tiene sentido o no.

chatear

El contenido de un diálogo de ida y vuelta con un sistema de AA, por lo general, un modelo grande de lenguaje. La interacción anterior en un chat (lo que escribiste y cómo respondió el modelo de lenguaje extenso) se convierte en el contexto para las partes posteriores del chat.

Un chatbot es una aplicación de un modelo grande de lenguaje.

confabulación

Sinónimo de alucinación.

Confabulación es probablemente un término técnicamente más preciso que alucinación. Sin embargo, la alucinación se hizo popular primero.

análisis de la circunstancia

Dividir una oración en estructuras gramaticales más pequeñas ("componentes"). Una parte posterior del sistema de AA, como un modelo de comprensión del lenguaje natural, puede analizar los componentes con mayor facilidad que la oración original. Por ejemplo, considera la siguiente oración:

Mi amigo adoptó dos gatos.

Un analizador de circunstancia puede dividir esta oración en los siguientes dos:

- My Friend es una frase nominal.

- adoptó dos gatos es una frase verbal.

Estos componentes pueden subdividirse en más pequeños. Por ejemplo, la frase verbal

adoptó dos gatos

podría subdividirse en:

- adopted es un verbo.

- two cats es otra frase nominal.

incorporación de lenguaje contextualizada

Una incorporación que se acerca a la "comprensión" de palabras y frases en formas en que los hablantes humanos nativos pueden hacerlo. Las incorporaciones de lenguaje contextualizado pueden comprender sintaxis, semántica y contexto complejos.

Por ejemplo, considera la incorporación de la palabra en inglés cow. Las incorporaciones más antiguas, como word2vec, pueden representar palabras en inglés, de modo que la distancia en el espacio de incorporación de vaca a toro sea similar a la distancia entre ewe (oveja hembra) y carnero (oveja macho) o de female a male. Las incorporaciones de lenguaje contextualizado pueden ir un paso más allá, ya que pueden reconocer que los angloparlantes a veces usan de manera casual la palabra vaca para referirse a la vaca o el toro.

ventana de contexto

La cantidad de tokens que un modelo puede procesar en una instrucción determinada. Cuanto más grande sea la ventana de contexto, más información podrá usar el modelo para proporcionar respuestas coherentes a la instrucción.

flor de cola

Oración o frase con un significado ambiguo. Un Crash blossom presenta un problema importante para la comprensión del lenguaje natural. Por ejemplo, el título La cinta roja que sostiene un rascacielos es un "crash blossom" porque un modelo CLN podría interpretar el titular de forma literal o figurada.

D

decodificador

En general, cualquier sistema de AA que convierta una representación procesada, densa o interna a una más sin procesar, dispersa o externa.

Los decodificadores suelen ser un componente de un modelo más grande, en el que suelen vincularse con un codificador.

En las tareas de secuencia a secuencia, un decodificador comienza con el estado interno que genera el codificador para predecir la siguiente secuencia.

Consulta Transformador para obtener la definición de un decodificador dentro de la arquitectura de transformadores.

reducción de ruido

Un enfoque común para el aprendizaje autosupervisado en el que se cumple lo siguiente:

La reducción de ruido permite aprender a partir de ejemplos sin etiqueta. El conjunto de datos original sirve como destino o etiqueta, y los datos ruidosos como entrada.

Algunos modelos de lenguaje enmascarados usan la reducción de ruido de la siguiente manera:

- El ruido se agrega de forma artificial a una oración sin etiqueta a través del enmascaramiento de algunos tokens.

- El modelo intenta predecir los tokens originales.

mensajes directos

Sinónimo de instrucción sin ejemplos.

E

editar distancia

Es una medida de qué tan similares son dos cadenas de texto entre sí. En el aprendizaje automático, editar la distancia es útil porque es fácil de calcular y es una manera eficaz de comparar dos strings que se sabe que son similares o encontrar strings similares a una string determinada.

Hay varias definiciones de editar distancia, cada una de ellas con diferentes operaciones de cadena. Por ejemplo, la distancia de Levenshtein considera la menor cantidad de operaciones de eliminación, inserción y sustitución.

Por ejemplo, la distancia Levenshtein entre las palabras "corazón" y "darts" es 3 porque las siguientes 3 ediciones son la menor cantidad de cambios para convertir una palabra en otra:

- corazón → deart (sustituye "h" por "d")

- deart → dart (borrar "e")

- dart → dardos (insert "s")

capa de Embedding

Una capa oculta especial que se entrena en un atributo categórico de alta dimensión para aprender gradualmente un vector de incorporación de menor dimensión. Una capa de incorporación permite que una red neuronal se entrene de manera mucho más eficiente que entrenar solo con el atributo categórico de alta dimensión.

Por ejemplo, la Tierra actualmente admite cerca de 73,000 especies de árboles. Supongamos que las especies de árbol son un atributo en tu modelo, por lo que la capa de entrada del modelo incluye un vector one-hot de 73,000 elementos de longitud.

Por ejemplo, quizás baobab se represente de la siguiente manera:

Un array de 73,000 elementos es muy largo. Si no agregas una capa de incorporación al modelo, el entrenamiento requerirá mucho tiempo debido a la multiplicación de 72,999 ceros. Quizás elijas que la capa de incorporación tenga 12 dimensiones. En consecuencia, la capa de incorporación aprenderá de forma gradual un nuevo vector de incorporación para cada especie de árbol.

En algunas situaciones, la codificación hash es una alternativa razonable a una capa de incorporación.

espacio de incorporaciones

Espacio de vector de d dimensiones al que se asignan atributos de un espacio de vector de mayor dimensión. Lo ideal sería que el espacio de incorporaciones contenga una estructura que produzca resultados matemáticos significativos. Por ejemplo, en un espacio de incorporaciones ideal, la adición y resta de incorporaciones puede resolver tareas de analogía de palabras.

El producto escalar de dos incorporaciones es la medida de su similitud.

vector de incorporación

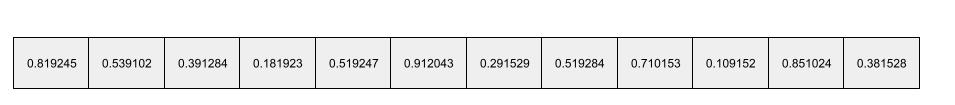

En términos generales, un array de números de punto flotante tomados de cualquier capa oculta que describe las entradas a esa capa oculta. A menudo, un vector de incorporación es el array de números de punto flotante entrenados en una capa de incorporación. Por ejemplo, supongamos que una capa de incorporación debe aprender un vector de incorporación para cada una de las 73,000 especies de árboles de la Tierra. Es posible que el siguiente array sea el vector de incorporación de un árbol baobab:

Un vector de incorporación no es un conjunto de números aleatorios. Una capa de incorporación determina estos valores a través del entrenamiento, de manera similar a la forma en que una red neuronal aprende otros pesos durante el entrenamiento. Cada elemento del array es una calificación según alguna característica de una especie de árbol. ¿Qué elemento representa la característica de qué especie de árbol? Es muy difícil de determinar para los humanos.

La parte matemáticamente notable de un vector de incorporación es que los elementos similares tienen conjuntos similares de números de punto flotante. Por ejemplo, las especies de árboles similares tienen un conjunto de números de punto flotante más parecido que las especies de árboles diferentes. Las secuoyas y las secuoyas son especies de árboles relacionados, por lo que tendrán un conjunto de números de punta flotante más similar a los de las secoyas y las secuoyas. Los números en el vector de incorporación cambiarán cada vez que se vuelva a entrenar el modelo, incluso si se vuelve a entrenar el modelo con una entrada idéntica.

codificador

En general, cualquier sistema de AA que convierta una representación sin procesar, dispersa o externa en una representación más procesada, densa o más interna.

Los codificadores suelen ser un componente de un modelo más grande, en el que se vinculan con un decodificador. Algunos Transformers vinculan codificadores con decodificadores, aunque otros Transformers usan solo el codificador o solo el decodificador.

Algunos sistemas usan la salida del codificador como entrada para una red de clasificación o regresión.

En las tareas de secuencia a secuencia, un codificador toma una secuencia de entrada y muestra un estado interno (un vector). Luego, el decodificador usa ese estado interno para predecir la siguiente secuencia.

Consulta Transformador para obtener la definición de codificador en la arquitectura de transformadores.

F

instrucciones con ejemplos limitados

Una instrucción que contiene más de un ejemplo (unos “pocos”) ejemplos que demuestran cómo debe responder el modelo grande de lenguaje. Por ejemplo, la siguiente instrucción larga contiene dos ejemplos que muestran un modelo de lenguaje extenso cómo responder a una consulta.

| Partes de un mensaje | Notas |

|---|---|

| ¿Cuál es la moneda oficial del país especificado? | La pregunta que quieres que responda el LLM. |

| Francia: EUR | Un ejemplo: |

| Reino Unido: GBP | Otro ejemplo. |

| India: | Es la consulta real. |

Las instrucciones con ejemplos limitados suelen producir más resultados deseables que las instrucciones sin ejemplos y las instrucciones con un solo ejemplo. Sin embargo, las instrucciones con ejemplos limitados requieren una instrucción más larga.

Las instrucciones con ejemplos limitados son una forma de aprendizaje con ejemplos limitados que se aplica al aprendizaje basado en instrucciones.

Violín tradicional

Una biblioteca de configuración centrada en Python que establece los valores de funciones y clases sin código ni infraestructura invasivos. En el caso de Pax y otras bases de código de AA, estas funciones y clases representan modelos y hiperparámetros de entrenamiento.

Fiddle supone que las bases de código de aprendizaje automático se suelen dividir en los siguientes elementos:

- Código de biblioteca, que define las capas y los optimizadores.

- El conjunto de datos establece un código de “unión”, que llama a las bibliotecas y conecta todo.

Fiddle captura la estructura de llamada del código de unión de una forma no evaluada y mutable.

ajuste

Un segundo pase de entrenamiento específico para una tarea que se realiza en un modelo previamente entrenado a fin de definir mejor sus parámetros para un caso de uso específico. Por ejemplo, la secuencia de entrenamiento completa para algunos modelos grandes de lenguaje es la siguiente:

- Entrenamiento previo: Entrena un modelo grande de lenguaje con un amplio conjunto de datos general, como todas las páginas de Wikipedia en inglés.

- Ajuste: Entrena el modelo previamente entrenado para que realice una tarea específica, como responder consultas médicas. Por lo general, el ajuste implica cientos o miles de ejemplos centrados en la tarea específica.

Como otro ejemplo, la secuencia de entrenamiento completa para un modelo de imagen grande es la siguiente:

- Entrenamiento previo: Entrena un modelo grande de imágenes con un amplio conjunto de datos general de imágenes, como todas las imágenes de Wikimedia Commons.

- Ajuste: Entrena el modelo previamente entrenado para que realice una tarea específica, como generar imágenes de orcas.

La optimización puede implicar cualquier combinación de las siguientes estrategias:

- Modificar todos los parámetros existentes del modelo previamente entrenado A veces, esto se denomina ajuste completo.

- Modificar solo algunos de los parámetros existentes del modelo previamente entrenado (por lo general, las capas más cercanas a la capa de salida) y mantener otros parámetros existentes sin cambios (por lo general, las capas más cercanas a la capa de entrada) Consulta Ajuste eficiente de parámetros.

- Agregar más capas, por lo general, sobre las capas existentes más cercanas a la capa de salida

El ajuste es una forma de aprendizaje por transferencia. Por lo tanto, el ajuste podría usar una función de pérdida diferente o un tipo de modelo diferente a los que se usan para entrenar el modelo previamente entrenado. Por ejemplo, puedes ajustar un modelo de imagen grande previamente entrenado para producir un modelo de regresión que devuelva la cantidad de aves en una imagen de entrada.

Compara y contrasta el ajuste con los siguientes términos:

Lino

Una biblioteca de código abierto y alto rendimiento para el aprendizaje profundo compilada sobre JAX. Flax proporciona funciones para entrenar redes neuronales y métodos para evaluar su rendimiento.

Formador de linaza

Una biblioteca de código abierto de Transformer compilada en Flax, diseñada principalmente para el procesamiento de lenguaje natural y la investigación multimodal.

G

IA generativa

Un campo transformador emergente sin definición formal. Dicho esto, la mayoría de los expertos coinciden en que los modelos de IA generativa pueden crear ("generar") contenido que acoge lo siguiente:

- complejo

- coherente

- original

Por ejemplo, un modelo de IA generativa puede crear imágenes o ensayos sofisticados.

Algunas tecnologías anteriores, como las LSTM y las RNN, también pueden generar contenido original y coherente. Algunos expertos consideran estas tecnologías anteriores como IA generativa, mientras que otros consideran que la IA generativa real requiere resultados más complejos de los que pueden producir esas tecnologías anteriores.

Compara esto con el AA predictivo.

GPT (transformador generativo previamente entrenado)

Una familia de modelos grandes de lenguaje basados en Transformer desarrolladas por OpenAI.

Las variantes de GPT se pueden aplicar a varias modalidades, incluidas las siguientes:

- generación de imágenes (por ejemplo, ImageGPT)

- generación de texto a imagen (por ejemplo, DALL-E).

H

alucinación

La producción de una salida que parece plausible, pero objetivamente incorrecta, por parte de un modelo de IA generativa que pretende hacer una aserción sobre el mundo real. Por ejemplo, un modelo de IA generativa en el que se afirma que Barack Obama murió en 1865 está alucinando.

I

aprendizaje en contexto

Sinónimo de instrucciones con ejemplos limitados.

L

LaMDA (modelo de lenguaje para aplicaciones de diálogo)

Un modelo grande de lenguaje basado en Transformer y desarrollado por Google entrenado en un conjunto de datos de diálogo grande que puede generar respuestas de conversación realistas.

LaMDA: nuestra innovadora tecnología de conversaciones proporciona una descripción general.

modelo de lenguaje

Es un model que estima la probabilidad de que un model o una secuencia de tokens se produzcan en una secuencia más larga de tokens.

modelo grande de lenguaje

Término informal sin una definición estricta que, por lo general, hace referencia a un modelo de lenguaje que tiene una gran cantidad de parámetros. Algunos modelos grandes de lenguaje contienen más de 100,000 millones de parámetros.

espacio latente

Sinónimo de espacio de incorporación.

LLM

Abreviatura de modelo grande de lenguaje.

LoRA

Abreviatura de adaptabilidad de bajo rango.

Adaptabilidad de bajo rango (LoRA)

Algoritmo para realizar un ajuste eficiente de los parámetros que ajusta solo un subconjunto de los parámetros de un modelo grande de lenguaje. LoRA proporciona los siguientes beneficios:

- Se ajusta más rápido que las técnicas que requieren el ajuste de todos los parámetros de un modelo.

- Se reduce el costo de procesamiento de la inferencia en el modelo ajustado.

Un modelo ajustado con LoRA mantiene o mejora la calidad de sus predicciones.

LoRA habilita múltiples versiones especializadas de un modelo.

M

modelo de lenguaje enmascarado

Un modelo de lenguaje que predice la probabilidad de que los tokens candidatos completen los espacios en blanco en una secuencia. Por ejemplo, un modelo de lenguaje enmascarado puede calcular probabilidades de palabras candidatas para reemplazar el subrayado en la siguiente oración:

La ____ del sombrero volvió.

En la literatura, se suele usar la cadena "MASK" en lugar de subrayado. Por ejemplo:

La "MASK" del sombrero regresó.

La mayoría de los modelos de lenguaje enmascarado modernos son bidireccionales.

metaaprendizaje

Subconjunto del aprendizaje automático que descubre o mejora un algoritmo de aprendizaje. Un sistema de metaaprendizaje también puede apuntar a entrenar un modelo para que aprenda rápidamente una tarea nueva a partir de una pequeña cantidad de datos o de la experiencia obtenida en tareas anteriores. Por lo general, los algoritmos de metaaprendizaje intentan lograr lo siguiente:

- Mejora o aprende atributos diseñados a mano (como un inicializador o un optimizador).

- Sé más eficiente en términos de datos y procesamiento.

- Mejora la generalización.

El metaaprendizaje está relacionado con el aprendizaje en pocos ejemplos.

modality

Una categoría de datos de alto nivel. Por ejemplo, los números, el texto, las imágenes, el video y el audio son cinco modalidades diferentes.

paralelismo de modelos

Es una forma de escalar el entrenamiento o la inferencia que coloca diferentes partes de un model en diferentes model. El paralelismo de modelos permite modelos que son demasiado grandes para caber en un solo dispositivo.

Por lo general, un sistema hace lo siguiente para implementar el paralelismo de modelos:

- Fragmenta (divide) el modelo en partes más pequeñas.

- Distribuye el entrenamiento de esas partes más pequeñas en múltiples procesadores. Cada procesador entrena su propia parte del modelo.

- Combina los resultados para crear un modelo único.

El paralelismo de modelos ralentiza el entrenamiento.

Consulta también paralelismo de datos.

autoatención de varias cabezas

Es una extensión de la autoatención que aplica el mecanismo de autoatención varias veces para cada posición en la secuencia de entrada.

Los Transformers presentaron la autoatención de varias cabezas.

modelo multimodal

Un modelo cuyas entradas o salidas incluyen más de una modalidad. Por ejemplo, considera un modelo que toma una imagen y una leyenda de texto (dos modalidades) como atributos, y genera una puntuación que indica qué tan apropiada es la leyenda de texto para la imagen. Por lo tanto, las entradas de este modelo son multimodales y la salida es unimodal.

N

comprensión del lenguaje natural

Determinar las intenciones de un usuario en función de lo que el usuario escribió o dijo. Por ejemplo, un motor de búsqueda utiliza la comprensión del lenguaje natural para determinar lo que un usuario busca en función de lo que escribió o dijo.

n-grama

Secuencia ordenada de n palabras. Por ejemplo, realmente loco es un 2-grama. Como el orden es relevante, loco realmente es un 2-grama diferente a realmente loco.

| N | Nombres para este tipo de n-grama | Ejemplos |

|---|---|---|

| 2 | bigrama o 2-grama | para ir, ir a, almorzar, cenar |

| 3 | trigrama o 3-grama | comí demasiado, tres ratones ciegos, las campanas suenan |

| 4 | 4-grama | caminar en el parque, tierra con el viento, el niño comió lentejas |

Muchos modelos de comprensión del lenguaje natural se basan en n-gramas para predecir la siguiente palabra que el usuario escribirá o dirá. Por ejemplo, que un usuario escribió tres tristes. Un modelo de CLN basado en trigramas probablemente predeciría que el usuario escribirá a continuación tigre.

Compara los n-gramas con la bolsa de palabras, que son conjuntos desordenados de palabras.

CLN

Abreviatura de comprensión del lenguaje natural.

O

instrucciones con un solo ejemplo

Una instrucción que contiene un ejemplo que demuestra cómo debería responder el modelo grande de lenguaje. Por ejemplo, el siguiente mensaje contiene un ejemplo que muestra un modelo grande de lenguaje cómo debería responder una consulta.

| Partes de un mensaje | Notas |

|---|---|

| ¿Cuál es la moneda oficial del país especificado? | La pregunta que quieres que responda el LLM. |

| Francia: EUR | Un ejemplo: |

| India: | Es la consulta real. |

Compara y contrasta las instrucciones de un solo ejemplo con los siguientes términos:

P

ajuste eficiente de parámetros

Es un conjunto de técnicas para ajustar un modelo de lenguaje previamente entrenado (PLM) grande de forma más eficiente que el ajuste completo. Por lo general, el ajuste eficiente de parámetros ajusta muchos menos parámetros que el ajuste completa y, por lo general, produce un modelo grande de lenguaje que funciona tan bien (o casi igual) que un modelo de lenguaje extenso compilado a partir de un ajuste completa.

Comparar y contrastar el ajuste eficiente de parámetros con lo siguiente:

El ajuste eficiente de parámetros también se conoce como ajuste eficiente de parámetros.

canalización

Una forma de paralelismo de modelos en la que el procesamiento de un modelo se divide en etapas consecutivas y cada etapa se ejecuta en un dispositivo diferente. Mientras una etapa procesa un lote, la etapa anterior puede funcionar en el siguiente lote.

Consulta también la capacitación en etapas.

PLM

Abreviatura de modelo de lenguaje previamente entrenado.

codificación posicional

Una técnica para agregar información sobre la posición de un token en una secuencia a su incorporación. Los modelos de transformador usan la codificación posicional para comprender mejor la relación entre las diferentes partes de la secuencia.

Una implementación común de la codificación posicional usa una función sinusoidal. (En concreto, la frecuencia y la amplitud de la función sinusoidal se determinan por la posición del token en la secuencia). Esta técnica permite que un modelo Transformer aprenda a asistir a diferentes partes de la secuencia según su posición.

modelo previamente entrenado

Modelos o componentes del modelo (como un vector de incorporación) que ya se entrenaron. En algunas ocasiones, proporcionarás vectores de incorporación previamente entrenados en una red neuronal. En otras ocasiones, el modelo entrenará los vectores de incorporación en lugar de basarse en las incorporaciones previamente entrenadas.

El término modelo de lenguaje previamente entrenado hace referencia a un modelo grande de lenguaje que pasó por un entrenamiento previo.

entrenamiento previo

Es el entrenamiento inicial de un modelo en un conjunto de datos grande. Algunos modelos previamente entrenados son gigantes torpes y, por lo general, deben definirse mejor con un entrenamiento adicional. Por ejemplo, los expertos en AA podrían entrenar previamente un modelo grande de lenguaje con un conjunto de datos de texto extenso, como todas las páginas en inglés de Wikipedia. Después del entrenamiento previo, el modelo resultante puede definirse aún más con cualquiera de las siguientes técnicas:

mensaje

Cualquier texto que se ingrese como entrada en un modelo grande de lenguaje para condicionar que el modelo se comporte de cierta manera. Las instrucciones pueden ser tan breves como una frase o arbitrariamente largas (por ejemplo, todo el texto de una novela). Los mensajes se dividen en varias categorías, incluidas las que se muestran en la siguiente tabla:

| Categoría del mensaje | Ejemplo | Notas |

|---|---|---|

| Pregunta | ¿Qué tan rápido puede volar una paloma? | |

| Instrucción | Escribir un poema divertido sobre el arbitraje | Un mensaje que le solicita al modelo grande de lenguaje que realice una acción. |

| Ejemplo | Traducir código de Markdown al formato HTML. Por ejemplo:

Markdown: * elemento de la lista HTML: <ul> <li>elemento de la lista</li> </ul> |

La primera oración de esta instrucción de ejemplo es una instrucción. El resto de la instrucción es el ejemplo. |

| Rol | Explica por qué se usa el descenso de gradientes en el entrenamiento de aprendizaje automático a un doctorado en Física. | La primera parte de la oración es una instrucción; la frase “para un doctorado en Física” es la parte del rol. |

| Entrada parcial para que el modelo se complete | El primer ministro del Reino Unido vive en | Una instrucción de entrada parcial puede terminar de manera abrupta (como en este ejemplo) o con un guion bajo. |

Un modelo de IA generativa puede responder a una instrucción con texto, código, imágenes, incorporaciones, videos y casi cualquier cosa.

aprendizaje basado en instrucciones

Es una función de ciertos modelos que les permite adaptar su comportamiento en respuesta a entradas de texto arbitrarias (mensajes). En un paradigma típico de aprendizaje basado en instrucciones, un modelo grande de lenguaje responde a un mensaje generando texto. Por ejemplo, supongamos que un usuario ingresa el siguiente mensaje:

Resumir la tercera ley del movimiento de Newton

Un modelo capaz de aprendizaje basado en instrucciones no está entrenado de forma específica para responder a la instrucción anterior. En cambio, el modelo "sabe" muchos hechos sobre física, reglas generales del lenguaje y mucho sobre lo que constituye respuestas que suelen ser útiles. Ese conocimiento es suficiente para proporcionar una respuesta útil. Los comentarios humanos adicionales ("Esa respuesta fue demasiado complicada" o "¿Qué es una reacción?") permiten que algunos sistemas de aprendizaje basados en instrucciones mejoren gradualmente la utilidad de sus respuestas.

diseño de mensajes

Sinónimo de ingeniería de instrucciones.

ingeniería de instrucciones

El arte de crear instrucciones que generan las respuestas deseadas de un modelo grande de lenguaje. Los seres humanos realizan ingeniería de instrucciones. Escribir instrucciones bien estructuradas es una parte esencial para garantizar respuestas útiles de un modelo grande de lenguaje. La ingeniería de instrucciones depende de muchos factores, entre los que se incluyen los siguientes:

- El conjunto de datos que se usa para entrenar previamente y, posiblemente, ajustar el modelo grande de lenguaje.

- La temperatura y otros parámetros de decodificación que usa el modelo para generar respuestas.

Consulta Introducción al diseño de instrucciones para obtener más detalles sobre cómo escribir instrucciones útiles.

Diseño de instrucciones es sinónimo de ingeniería de instrucciones.

ajuste de mensajes

Un mecanismo de ajuste eficiente de parámetros que aprende un "prefijo" que el sistema antepone al mensaje real.

Una variación del ajuste de los mensajes, a veces llamado ajuste de prefijo, es anteponer el prefijo en todas las capas. Por el contrario, la mayoría de los ajustes de mensajes solo agregan un prefijo a la capa de entrada.

R

solicitud de roles

Una parte opcional de una instrucción que identifica un público objetivo para la respuesta de un modelo de IA generativa. Sin una indicación de rol, un modelo grande de lenguaje proporciona una respuesta que puede o no ser útil para la persona que hace las preguntas. Con una instrucción de función, un modelo grande de lenguaje puede responder de una manera que sea más apropiada y útil para un público objetivo específico. Por ejemplo, la parte de la solicitud de función de las siguientes instrucciones está en negrita:

- Resume este artículo para obtener un doctorado en economía.

- Describir cómo funcionan las mareas para un niño de diez años

- Explicar la crisis financiera de 2008 Habla como lo harías con un niño pequeño o con un golden retriever.

S

autoatención (también denominada capa de autoatención)

Capa de la red neuronal que transforma una secuencia de incorporaciones (por ejemplo, incorporaciones de tokens) en otra secuencia de incorporaciones. Cada incorporación en la secuencia de salida se construye a través de la integración de información de los elementos de la secuencia de entrada a través de un mecanismo de atención.

La parte del yo de la autoatención se refiere a la secuencia que asiste a sí misma en lugar de a algún otro contexto. La autoatención es uno de los componentes básicos de los Transformers y usa terminología de búsqueda de diccionario, como "consulta", "clave" y "valor".

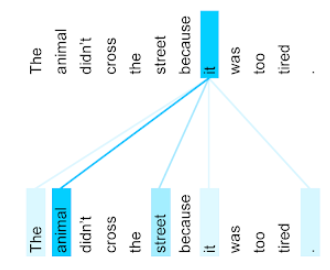

Una capa de autoatención comienza con una secuencia de representaciones de entrada, una para cada palabra. La representación de entrada de una palabra puede ser una incorporación simple. Para cada palabra en una secuencia de entrada, la red califica la relevancia de la palabra para cada elemento de la secuencia completa de palabras. Las puntuaciones de relevancia determinan en qué medida la representación final de la palabra incorpora las representaciones de otras palabras.

Por ejemplo, considera la siguiente oración:

El animal no cruzó la calle porque estaba demasiado cansado.

En la siguiente ilustración (de Transformer: A Novel Neural Network Architecture for Language Understanding), se muestra el patrón de atención de una capa de autoatención para el pronombre it. La oscuridad de cada línea indica cuánto contribuye cada palabra a la representación:

La capa de autoatención destaca las palabras que son relevantes para "ella". En este caso, la capa de atención aprendió a destacar palabras a las que sí podría referirse, asignando el peso más alto a animal.

Para una secuencia de n tokens, la autoatención transforma una secuencia de incorporaciones n veces por separado, una vez en cada posición de la secuencia.

Consulta también la atención y la autoatención de varias cabezas.

Análisis de opiniones

Uso de algoritmos estadísticos o de aprendizaje automático para determinar la actitud general de un grupo (positiva o negativa) hacia un servicio, producto, organización o tema. Por ejemplo, con comprensión del lenguaje natural, un algoritmo podría realizar un análisis de opiniones sobre la retroalimentación textual de un curso universitario para determinar en qué medida a los estudiantes les gustó o no el curso en general.

tarea de secuencia por secuencia

Una tarea que convierte una secuencia de entrada de tokens en una secuencia de salida de tokens. Por ejemplo, los dos tipos populares de tareas de secuencia a secuencia son los siguientes:

- Traductores:

- Ejemplo de secuencia de entrada: "Te amo".

- Secuencia de salida de muestra: "Je t'aime".

- Búsqueda de respuestas:

- Secuencia de entrada de muestra: "¿Necesito tener mi auto en Nueva York?".

- Secuencia de salida de muestra: "No. Mantén el auto en casa".

omitir-grama

Un n-grama que puede omitir (u "omitir") palabras del contexto original, lo que significa que las N palabras podrían no haber sido adyacentes en un principio. De manera más precisa, un "k-skip-n-grama" es un n-grama para el cual se pueden haber omitido hasta k palabras.

Por ejemplo, "el zorro marrón rápido" tiene los siguientes 2 gramos posibles:

- "el rápido"

- "marrón rápido"

- “zorro marrón”

Un "1-omitir-2-grama" es un par de palabras que tienen, como máximo, 1 palabra entre ellas. Por lo tanto, “el zorro marrón rápido” tiene los siguientes 2 gramos que se pueden omitir:

- “el marrón”

- "rápido zorro"

Además, todos los 2-gramas son también 1-omitir-2-gramas, ya que se puede omitir menos de una palabra.

Los gráficos de omisión son útiles para comprender mejor el contexto que rodea una palabra. En el ejemplo, "fox" se asoció directamente con "rápido" en el conjunto de 1-omitir-2-gramos, pero no en el conjunto de 2-gramos.

Los gramos de omisión ayudan a entrenar modelos de incorporación de palabras.

ajuste de mensajes breves

Técnica para ajustar un modelo grande de lenguaje para una tarea en particular, sin ajustes que hacen un uso intensivo de los recursos. En lugar de volver a entrenar todos los ponderaciones del modelo, el ajuste de los mensajes de texto ajusta automáticamente una instrucción para lograr el mismo objetivo.

Cuando se le proporciona una instrucción textual, el ajuste de mensajes secundarios suele agregar incorporaciones de token adicionales a la instrucción y usar propagación inversa para optimizar la entrada.

Un mensaje “hard” contiene tokens reales en lugar de incorporaciones de tokens.

atributo disperso

Un atributo cuyos valores son predominantemente cero o están vacíos. Por ejemplo, un atributo que contiene un solo valor 1 y un millón de valores 0 está disperso. Por el contrario, un atributo denso tiene valores que en su mayoría no son cero ni están vacíos.

En el aprendizaje automático, una cantidad sorprendente de atributos son atributos dispersos. Los atributos categóricos suelen ser atributos dispersos. Por ejemplo, de las 300 especies posibles de árboles en un bosque, un solo ejemplo podría identificar solo un arce. O, entre los millones de videos posibles en una biblioteca de videos, un solo ejemplo podría identificar solo "Casablanca".

Por lo general, en un modelo, representas atributos dispersos con la codificación one-hot. Si la codificación one-hot es grande, puedes colocar una capa de incorporación sobre la codificación one-hot para obtener una mayor eficiencia.

representación dispersa

Almacenar solo las posiciones de elementos distintos de cero en un atributo disperso

Por ejemplo, supongamos que un atributo categórico llamado species identifica las 36 especies de árbol en un bosque en particular. Además, supongamos que cada ejemplo identifica solo una especie.

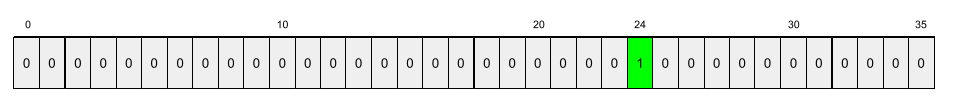

Podrías usar un vector one-hot para representar las especies arbóreas en cada ejemplo.

Un vector one-hot contendrá un solo 1 (para representar la especie arbórea particular en ese ejemplo) y 35 0 (para representar las 35 especies de árboles que no están en ese ejemplo). Por lo tanto, la representación one-hot de maple podría verse de la siguiente manera:

De manera alternativa, la representación dispersa simplemente identificaría la posición de la especie en particular. Si maple está en la posición 24, la representación dispersa de maple simplemente sería:

24

Ten en cuenta que la representación dispersa es mucho más compacta que la representación one-hot.

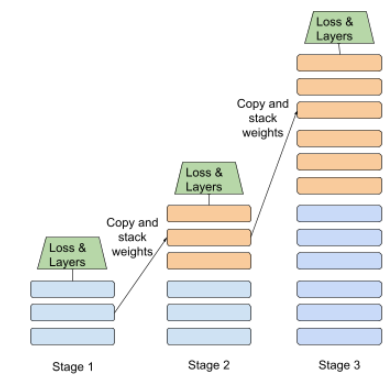

entrenamiento por etapas

Es una táctica de entrenar un modelo en una secuencia de etapas discretas. El objetivo puede ser acelerar el proceso de entrenamiento o lograr una mejor calidad del modelo.

A continuación, se muestra una ilustración del enfoque de apilado progresivo:

- La etapa 1 contiene 3 capas ocultas, la etapa 2 contiene 6 capas ocultas y la etapa 3 contiene 12 capas ocultas.

- La etapa 2 comienza con los pesos aprendidos en las 3 capas ocultas de la etapa 1. La etapa 3 comienza con los pesos aprendidos en las 6 capas ocultas de la etapa 2.

Consulta también la canalización.

token de subpalabra

En los modelos de lenguaje, un token que es una subcadena de una palabra, que puede ser la palabra completa.

Por ejemplo, una palabra como “itemize” podría dividirse en las partes “item” (una palabra raíz) y “ize” (un sufijo), cada una de las cuales está representada por su propio token. Dividir palabras poco comunes en esas partes, llamadas subpalabras, permite que los modelos de lenguaje operen en las partes constituyentes más comunes de la palabra, como los prefijos y sufijos.

Por el contrario, las palabras comunes como “asistir” podrían no dividirse y podrían estar representadas por un solo token.

T

T5

Un modelo de aprendizaje por transferencia de texto a texto presentado por la IA de Google en 2020 T5 es un modelo de codificador-decodificador, basado en la arquitectura Transformer y entrenado con un conjunto de datos extremadamente grande. Es eficaz en una variedad de tareas de procesamiento de lenguaje natural, como la generación de texto, la traducción de idiomas y la respuesta a preguntas de manera conversacional.

T5 recibe su nombre de las cinco T de "Transformador de transferencia de texto a texto".

T5X

Un framework de aprendizaje automático de código abierto diseñado para compilar y entrenar modelos de procesamiento de lenguaje natural (PLN) a gran escala. T5 se implementa en la base de código T5X (que está compilada en JAX y Flax).

temperatura

Es un hiperparámetro que controla el grado de aleatorización de la salida de un modelo. Las temperaturas más altas generan resultados más aleatorios, mientras que las temperaturas más bajas generan resultados menos aleatorios.

La elección de la mejor temperatura depende de la aplicación específica y de las propiedades preferidas de la salida del modelo. Por ejemplo, es probable que aumentes la temperatura cuando crees una aplicación que genere resultados de creatividades. Por el contrario, probablemente bajarías la temperatura cuando compiles un modelo que clasifique imágenes o texto para mejorar la precisión y coherencia del modelo.

La temperatura suele usarse con softmax.

intervalo de texto

El intervalo de índice del array asociado con una subsección específica de una cadena de texto.

Por ejemplo, la palabra good en la string s="Be good now" de Python ocupa el intervalo de texto de 3 a 6.

token

En un modelo de lenguaje, es la unidad atómica con la que se entrena el modelo y con la que se realizan predicciones. Por lo general, un token es uno de los siguientes:

- una palabra, por ejemplo, la frase “perros como gatos” consta de tres tokens de palabras: “perros”, “como” y “gatos”.

- un carácter, por ejemplo, la frase “pez bicicleta” consta de nueve tokens de caracteres. (Ten en cuenta que el espacio en blanco cuenta como uno de los tokens).

- subpalabras, en las que una sola palabra puede ser un token único o varios tokens. Una subpalabra consiste en una palabra raíz, un prefijo o un sufijo. Por ejemplo, un modelo de lenguaje que usa subpalabras como tokens podría ver la palabra “perros” como dos tokens (la palabra raíz “perro” y el sufijo plural “s”). Ese mismo modelo de lenguaje podría ver la sola palabra "taller" como dos subpalabras (la palabra raíz "tall" y el sufijo "er").

En dominios fuera de los modelos de lenguaje, los tokens pueden representar otros tipos de unidades atómicas. Por ejemplo, en visión artificial, un token puede ser un subconjunto de una imagen.

Transformador

Arquitectura de red neuronal desarrollada en Google que se basa en mecanismos de autoatención para transformar una secuencia de incorporaciones de entrada en una secuencia de incorporaciones de salida sin depender de convoluciones ni redes neuronales recurrentes. Un transformador se puede ver como una pila de capas de autoatención.

Un transformador puede incluir cualquiera de los siguientes elementos:

- un codificador

- un decodificador

- un codificador y un decodificador,

Un codificador transforma una secuencia de incorporaciones en una secuencia nueva de la misma longitud. Un codificador incluye N capas idénticas, cada una de las cuales contiene dos subcapas. Estas dos subcapas se aplican en cada posición de la secuencia de incorporación de entrada y transforman cada elemento de la secuencia en una incorporación nueva. La primera subcapa del codificador agrega información de toda la secuencia de entrada. La segunda subcapa del codificador transforma la información agregada en una incorporación de salida.

Un decodificador transforma una secuencia de incorporaciones de entrada en una secuencia de incorporaciones de salida, posiblemente con una longitud diferente. Un decodificador también incluye N capas idénticas con tres subcapas, dos de las cuales son similares a las subcapas del codificador. La tercera subcapa del decodificador toma la salida del codificador y aplica el mecanismo de autoatención para recopilar información de ella.

La entrada de blog Transformer: A Novel Neural Network Architecture for Language Understanding (Transformer: Una novedosa arquitectura de red neuronal para comprensión del lenguaje) ofrece una buena introducción a Transformers.

trigrama

n-grama en el que n=3.

U

unidireccional

Es un sistema que solo evalúa el texto que antecede a una sección de texto objetivo. Por el contrario, un sistema bidireccional evalúa el texto que precede y sigue una sección de texto objetivo. Consulta bidireccional para obtener más detalles.

modelo de lenguaje unidireccional

Un modelo de lenguaje que basa sus probabilidades solo en los tokens que aparecen antes, no después, de los tokens de destino. Compara esto con el modelo de lenguaje bidireccional.

V

codificador automático variacional (VAE)

Un tipo de codificador automático que aprovecha la discrepancia entre las entradas y las salidas para generar versiones modificadas de las entradas. Los codificadores automáticos variacionales son útiles para la IA generativa.

Los VAE se basan en la inferencia variacional: una técnica para estimar los parámetros de un modelo de probabilidad.

W

incorporación de palabras

Representar cada palabra de un conjunto de palabras dentro de un vector de incorporación; es decir, la representación de cada palabra como un vector de valores de punto flotante entre 0.0 y 1.0. Las palabras con significados similares tienen representaciones más parecidas que las palabras con significados diferentes. Por ejemplo, zanahorias, apio y pepinos tendrían representaciones relativamente similares, que serían muy diferentes a las representaciones de avión, gafas de sol y pasta de dientes.

Z

instrucciones sin ejemplos

Una instrucción que no proporciona un ejemplo de cómo quieres que responda el modelo grande de lenguaje. Por ejemplo:

| Partes de un mensaje | Notas |

|---|---|

| ¿Cuál es la moneda oficial del país especificado? | La pregunta que quieres que responda el LLM. |

| India: | Es la consulta real. |

El modelo grande de lenguaje podría responder con cualquiera de las siguientes opciones:

- Rupia

- INR

- ₹

- Rupia hindú

- La rupia

- La rupia india

Todas las respuestas son correctas, aunque es posible que prefieras un formato en particular.

Compara y contrasta la instrucción sin ejemplos con los siguientes términos: