この用語集では、AI の用語を定義します。

A

アブレーション

特徴またはコンポーネントの重要度を評価する手法。モデルから一時的に削除します。次に、その特徴やコンポーネントなしでモデルを再トレーニングします。再トレーニングしたモデルのパフォーマンスが大幅に低下した場合は、削除した特徴やコンポーネントが重要であった可能性が高いです。

たとえば、10 個の特徴で分類モデルをトレーニングし、テストセットで 88% の精度を達成したとします。最初の特徴量の重要度を確認するには、他の 9 つの特徴量のみを使用してモデルを再トレーニングします。再トレーニングされたモデルのパフォーマンスが大幅に低下した場合(精度が 55% など)、削除された特徴量は重要だった可能性があります。逆に、再トレーニングされたモデルのパフォーマンスが同程度であれば、その特徴はそれほど重要ではなかった可能性があります。

アブレーションは、次の重要度を判断するうえでも役立ちます。

- 大規模な ML システムのサブシステム全体など、より大きなコンポーネント

- データの前処理ステップなどのプロセスまたは手法

どちらの場合も、コンポーネントを削除した後にシステムのパフォーマンスがどのように変化するか(または変化しないか)を観察します。

A/B テスト

2 つ(またはそれ以上)の手法(A と B)を比較する統計的な方法。通常、A は既存の手法であり、B は新しい手法です。A/B テストでは、どの手法のパフォーマンスが優れているかだけでなく、その差が統計的に有意であるかどうかも判断できます。

A/B テストでは通常、2 つの手法で 1 つの指標を比較します。たとえば、2 つの手法でモデルの精度を比較します。ただし、A/B テストでは、有限数の指標を比較することもできます。

アクセラレータ チップ

ディープ ラーニング アルゴリズムに必要な主要な計算を実行するように設計された特殊なハードウェア コンポーネントのカテゴリ。

アクセラレータ チップ(または単にアクセラレータ)は、汎用 CPU と比較して、トレーニング タスクと推論タスクの速度と効率を大幅に向上させることができます。ニューラル ネットワークのトレーニングや、同様の計算負荷の高いタスクに最適です。

アクセラレータ チップの例:

- ディープ ラーニング専用のハードウェアを備えた Google の Tensor Processing Unit(TPU)。

- NVIDIA の GPU。当初はグラフィック処理用に設計されましたが、並列処理を可能にするように設計されており、処理速度を大幅に向上させることができます。

accuracy

分類予測の正解の数を予測の総数で割った数。具体的には、次のことが求められます。

たとえば、40 回の正しい予測と 10 回の誤った予測を行ったモデルの精度は次のようになります。

バイナリ分類では、正しい予測と正しくない予測のさまざまなカテゴリに固有の名前が付けられます。したがって、バイナリ分類の精度式は次のようになります。

ここで

詳細については、ML 集中講座の分類: 正確度、再現率、適合率、関連指標をご覧ください。

アクション

強化学習では、エージェントが環境の状態間を遷移するメカニズム。エージェントは、ポリシーを使用してアクションを選択します。

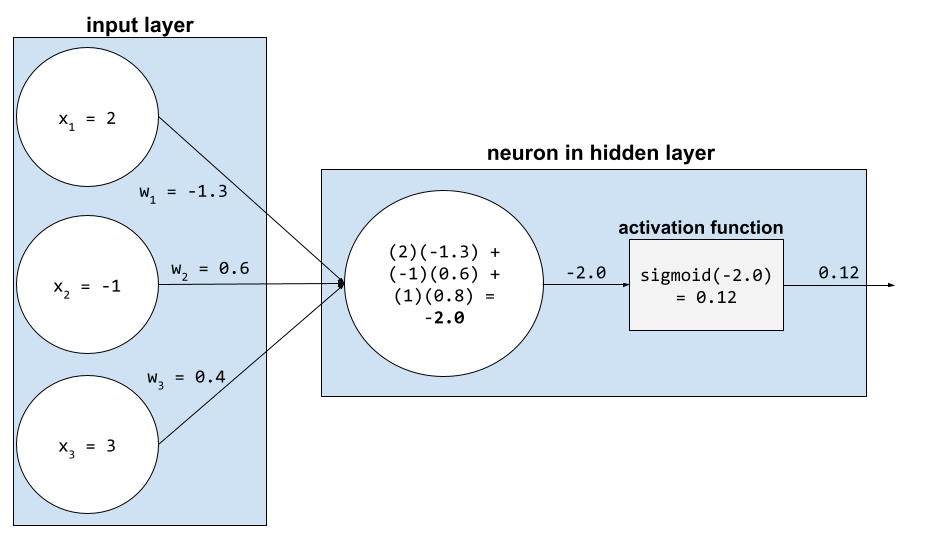

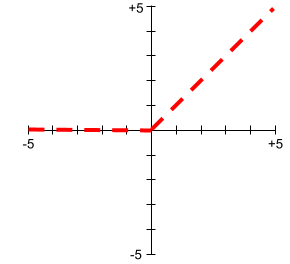

活性化関数

ニューラル ネットワークが特徴とラベルの間の非線形(複雑な)関係を学習できるようにする関数。

よく使用される活性化関数には、次のようなものがあります。

活性化関数のプロットは、単一の直線になることはありません。たとえば、ReLU 活性化関数のプロットは 2 つの直線で構成されます。

シグモイド活性化関数のプロットは次のようになります。

詳細については、ML 集中講座のニューラル ネットワーク: 活性化関数をご覧ください。

能動的学習

アルゴリズムが学習するデータの一部を選択するトレーニング アプローチ。アクティブ ラーニングは、ラベル付きの例が不足している場合や、取得に費用がかかる場合に特に有効です。能動的学習アルゴリズムは、さまざまなラベル付きの例を盲目的に探すのではなく、学習に必要な特定の範囲の例を選択的に探します。

AdaGrad

各パラメータの勾配をリスケールする高度な勾配降下アルゴリズム。各パラメータに独立した学習率を効果的に付与します。詳細については、オンライン学習と確率的最適化のための適応型サブグラディエント法をご覧ください。

適応

チューニングまたはファインチューニングと同義。

エージェント

マルチモーダル ユーザー入力について推論し、ユーザーに代わってアクションを計画して実行できるソフトウェア。

強化学習では、エージェントは ポリシーを使用して、環境の状態間の遷移から得られる期待収益を最大化するエンティティです。

エージェントの/代理人の

エージェントの形容詞形。エージェント性とは、エージェントが持つ特性(自律性など)を指します。

エージェント ワークフロー

エージェントが目標を達成するためにアクションを自律的に計画して実行する動的プロセス。このプロセスでは、推論、外部ツールの呼び出し、計画の自己修正が行われることがあります。

凝集型クラスタリング

階層型クラスタリングをご覧ください。

AI スロップ

品質よりも量を重視する生成 AI システムからの出力。たとえば、AI スロップのあるウェブページは、安価に生成された AI 生成の低品質なコンテンツで埋め尽くされています。

異常検出

外れ値を特定するプロセス。たとえば、特定の特徴の平均が 100 で標準偏差が 10 の場合、異常検出では値 200 が疑わしいと判断されます。

AR

拡張現実の略。

PR 曲線下面積

PR AUC(PR 曲線の下の面積)をご覧ください。

ROC 曲線の下の面積

AUC(ROC 曲線の下の面積)をご覧ください。

汎用人工知能

幅広い問題解決能力、創造性、適応性を示す非人間的なメカニズム。たとえば、汎用人工知能を実証するプログラムは、テキストの翻訳、交響曲の作曲、まだ発明されていないゲームでの優れたパフォーマンスを実現できます。

AI

複雑なタスクを解決できる人間以外のプログラムまたはモデル。たとえば、テキストを翻訳するプログラムやモデル、放射線画像から病気を特定するプログラムやモデルは、どちらも人工知能を備えています。

正式には、ML は AI の一分野です。しかし、近年では、人工知能と機械学習という用語を同じ意味で使用する組織も出てきています。

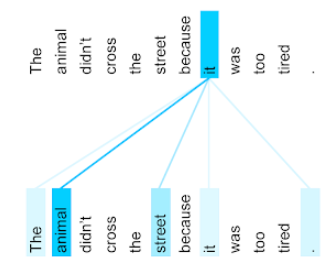

Attention、

ニューラル ネットワークで使用されるメカニズムで、特定の単語または単語の一部がどの程度重要かを示します。アテンションは、モデルが次のトークン/単語を予測するために必要な情報量を圧縮します。一般的なアテンション メカニズムは、一連の入力に対する加重和で構成されます。各入力の重みは、ニューラル ネットワークの別の部分で計算されます。

Transformer の構成要素であるセルフ アテンションとマルチヘッド セルフ アテンションもご覧ください。

セルフ アテンションの詳細については、ML 集中講座の LLM: 大規模言語モデルとはをご覧ください。

属性

feature と同義。

ML の公平性において、属性は個人に関連する特性を指すことがよくあります。

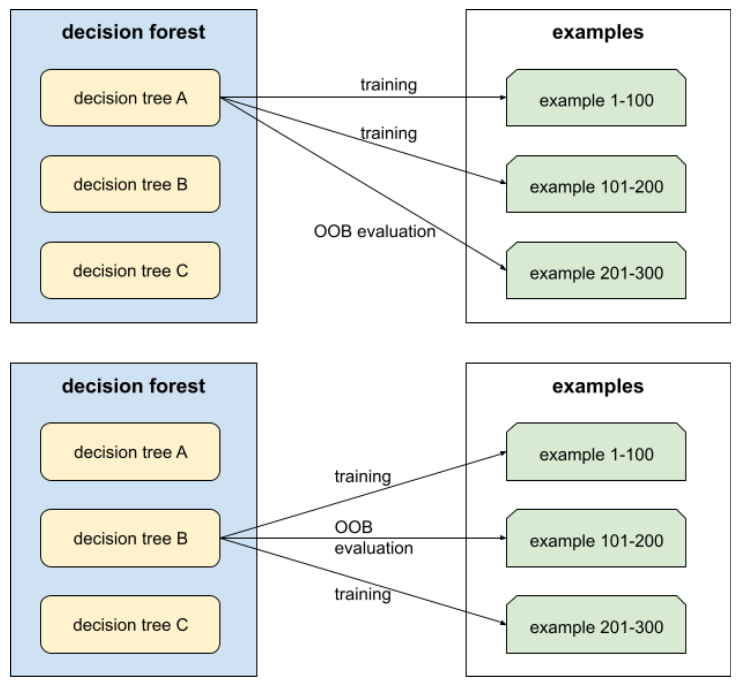

属性サンプリング

各ディシジョン ツリーが条件を学習するときに、可能な特徴のランダムなサブセットのみを考慮するディシジョン フォレストをトレーニングする戦術。通常、各ノードに対して異なる特徴量のサブセットがサンプリングされます。一方、属性サンプリングなしで決定木をトレーニングする場合、各ノードで可能なすべての特徴が考慮されます。

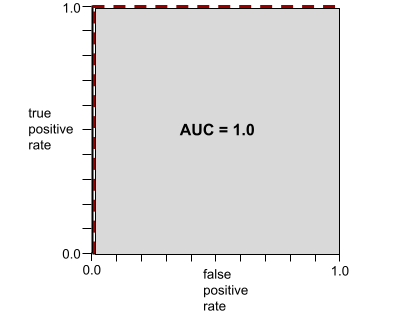

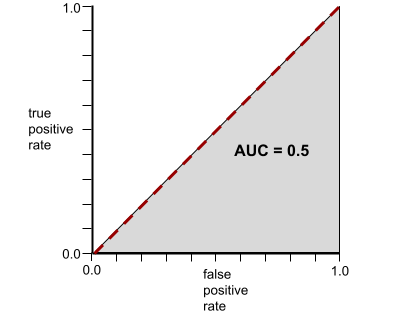

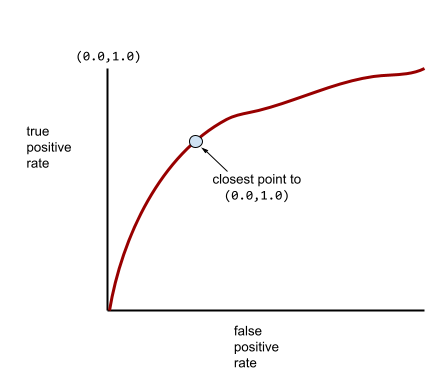

AUC(ROC 曲線の下の面積)

陽性クラスと陰性クラスを分離するバイナリ分類モデルの能力を表す 0.0 ~ 1.0 の数値。AUC が 1.0 に近いほど、クラスを互いに分離するモデルの能力が優れています。

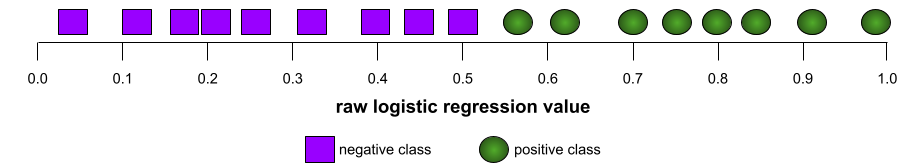

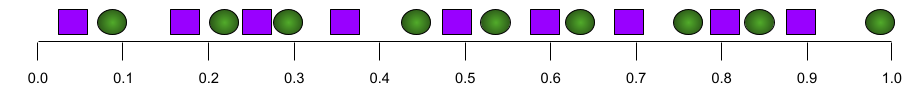

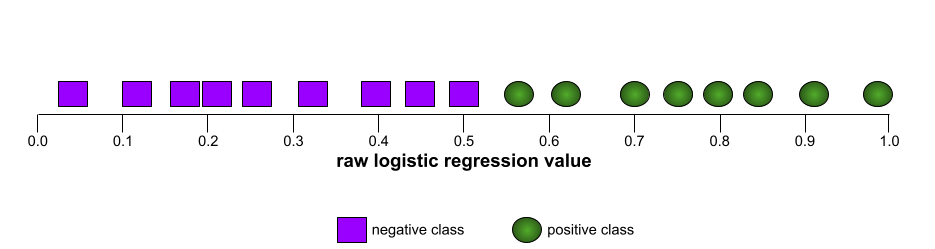

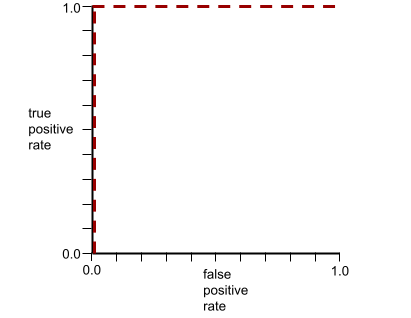

たとえば、次の図は、陽性クラス(緑色の楕円)と陰性クラス(紫色の長方形)を完全に分離する分類モデルを示しています。この非現実的な完全なモデルの AUC は 1.0 です。

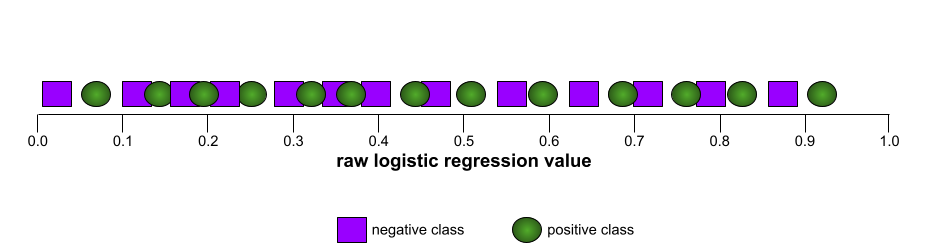

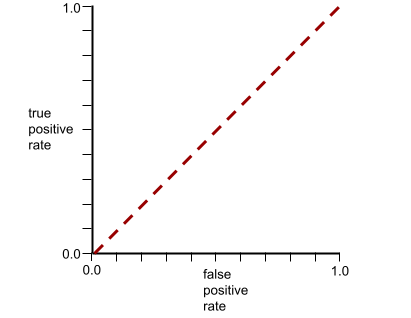

一方、次の図は、ランダムな結果を生成した分類モデルの結果を示しています。このモデルの AUC は 0.5 です。

はい。上記のモデルの AUC は 0.0 ではなく 0.5 です。

ほとんどのモデルは、この 2 つの極端なモデルの中間に位置します。たとえば、次のモデルは陽性と陰性をある程度分離するため、AUC は 0.5 ~ 1.0 の範囲になります。

AUC は、分類しきい値に設定した値を無視します。AUC は、すべての可能な分類しきい値を考慮します。

詳細については、ML 集中講座の分類: ROC と AUC をご覧ください。

拡張現実

コンピュータで生成された画像をユーザーの現実世界の視界に重ね合わせ、合成された視界を提供するテクノロジー。

オートエンコーダ

入力から最も重要な情報を抽出することを学習するシステム。オートエンコーダは、エンコーダとデコーダの組み合わせです。オートエンコーダは、次の 2 段階のプロセスに依存しています。

- エンコーダは、入力を(通常は)損失のある低次元の(中間)形式にマッピングします。

- デコーダは、低次元形式を元の高次元入力形式にマッピングして、元の入力の損失バージョンを構築します。

オートエンコーダは、エンコーダの中間形式から元の入力を可能な限り正確に再構成しようとするデコーダを使用して、エンドツーエンドでトレーニングされます。中間形式は元の形式よりも小さいため(低次元)、オートエンコーダは入力内のどの情報が不可欠かを学習する必要があり、出力は入力と完全に同じにはなりません。

次に例を示します。

- 入力データがグラフィックの場合、非完全一致のコピーは元のグラフィックと類似していますが、多少変更されています。完全なコピーではないことで、元のグラフィックからノイズが除去されたり、欠落したピクセルが補完されたりする可能性があります。

- 入力データがテキストの場合、オートエンコーダは元のテキストを模倣した(ただし、同一ではない)新しいテキストを生成します。

変分オートエンコーダもご覧ください。

自動評価

ソフトウェアを使用してモデルの出力の品質を判断する。

モデルの出力が比較的単純な場合は、スクリプトまたはプログラムでモデルの出力をゴールデン レスポンスと比較できます。このタイプの自動評価は、プログラマティック評価と呼ばれることもあります。ROUGE や BLEU などの指標は、プログラムによる評価に役立つことがよくあります。

モデルの出力が複雑な場合や、正解が 1 つではない場合は、自動採点者と呼ばれる別の ML プログラムが自動評価を行うことがあります。

人間による評価と比較してください。

自動化バイアス

自動化された意思決定システムが誤りを犯した場合でも、人間による意思決定者が自動化された意思決定システムによる推奨事項を、自動化なしで作成された情報よりも優先する場合。

詳細については、ML 集中講座の公平性: 偏りの種類をご覧ください。

AutoML

機械学習モデルを構築するための自動化されたプロセス。AutoML は、次のようなタスクを自動的に実行できます。

- 最も適切なモデルを検索します。

- ハイパーパラメータを調整します。

- データ(特徴量エンジニアリングの実行を含む)を準備します。

- 結果のモデルをデプロイします。

AutoML は、ML パイプラインの開発にかかる時間と労力を節約し、予測精度を向上させることができるため、データ サイエンティストにとって有用です。また、複雑な ML タスクをより簡単に実行できるようにすることで、専門家以外のユーザーにも役立ちます。

詳細については、ML 集中講座の自動機械学習(AutoML)をご覧ください。

自動評価

人間による評価と自動評価を組み合わせた、生成 AI モデルの出力の品質を判断するためのハイブリッド メカニズム。自動評価ツールは、人間による評価で作成されたデータでトレーニングされた ML モデルです。理想的には、自動評価ツールは人間の評価者を模倣することを学習します。事前構築済みの自動評価ツールを使用できますが、最適な自動評価ツールは、評価するタスクに合わせて特別にファインチューニングされています。

自己回帰モデル

独自の過去の予測に基づいて予測を推論するモデル。たとえば、自己回帰言語モデルは、以前に予測されたトークンに基づいて次のトークンを予測します。Transformer ベースの大規模言語モデルはすべて自動回帰です。

一方、GAN ベースの画像モデルは、通常、自己回帰ではありません。これは、画像をステップごとに反復的に生成するのではなく、1 回の順方向パスで生成するためです。ただし、一部の画像生成モデルは、画像を段階的に生成するため、自己回帰型です。

補助損失

損失関数 - ニューラル ネットワーク モデルのメインの損失関数と組み合わせて使用され、重みがランダムに初期化される初期の反復処理中にトレーニングを高速化します。

補助損失関数は、有効な勾配を前のレイヤにプッシュします。これにより、勾配消失問題に対処することで、トレーニング中の収束が容易になります。

k における平均適合率

ランク付けされた結果(書籍の推奨事項の番号付きリストなど)を生成する単一のプロンプトに対するモデルのパフォーマンスを要約する指標。k での平均適合率は、各関連結果の k での適合率の値の平均です。したがって、k における平均適合率の式は次のようになります。

\[{\text{average precision at k}} = \frac{1}{n} \sum_{i=1}^n {\text{precision at k for each relevant item} } \]

ここで

- \(n\) は、リスト内の関連アイテムの数です。

k でのリコールとのコントラスト。

軸に沿った条件

ディシジョン ツリーで、単一の特徴のみを含む条件。たとえば、area が特徴量の場合、軸に沿った条件は次のようになります。

area > 200

斜め条件も参照してください。

B

バックプロパゲーション

ニューラル ネットワークで勾配降下法を実装するアルゴリズム。

ニューラル ネットワークのトレーニングには、次の 2 パス サイクルの多くの反復が含まれます。

- フォワード パスでは、システムは バッチの例を処理して、予測を生成します。システムは、各予測を各ラベル値と比較します。予測値とラベル値の差が、その例の損失になります。システムは、すべての例の損失を集計して、現在のバッチの合計損失を計算します。

- バックワード パス(バックプロパゲーション)では、すべての隠れ層のすべてのニューロンの重みを調整することで、損失を減らします。

ニューラル ネットワークには、多くの隠れ層に多くのニューロンが含まれていることがよくあります。これらのニューロンはそれぞれ異なる方法で全体的な損失に貢献します。バックプロパゲーションは、特定のニューロンに適用される重みを増減するかどうかを決定します。

学習率は、各バックワード パスで各重みを増減させる程度を制御する乗数です。学習率が大きいほど、各重みの増減が大きくなります。

微積分の用語で言うと、バックプロパゲーションは微積分の連鎖律を実装します。つまり、バックプロパゲーションは、各パラメータに関する誤差の偏導関数を計算します。

数年前までは、ML 実務家は逆伝播を実装するためにコードを記述する必要がありました。Keras などの最新の ML API では、バックプロパゲーションが実装されています。さて、

詳細については、ML 集中講座のニューラル ネットワークをご覧ください。

バギング

各構成要素のモデルが、復元抽出されたトレーニング例のランダムなサブセットでトレーニングされるアンサンブルをトレーニングする方法。たとえば、ランダム フォレストは、バギングでトレーニングされたディシジョン ツリーのコレクションです。

バギングという用語は、ブートストラップ集計の略です。

詳細については、Decision Forests コースのランダム フォレストをご覧ください。

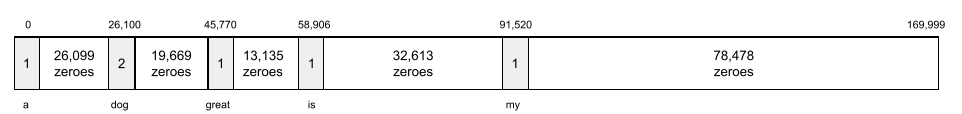

bag of words

フレーズや文章内の単語の表現。順序は関係ありません。たとえば、単語のバッグは次の 3 つのフレーズを同じように表します。

- 犬が飛び跳ねる

- 犬を飛び越える

- 犬が

各単語は、スパース ベクトルのインデックスにマッピングされます。このベクトルには、語彙内のすべての単語のインデックスが含まれます。たとえば、「犬がジャンプする」というフレーズは、単語「犬」、「が」、「ジャンプする」に対応する 3 つのインデックスにゼロ以外の値を持つ特徴ベクトルにマッピングされます。ゼロ以外の値は次のいずれかになります。

- 単語が存在することを示す 1。

- バッグ内の単語の出現回数。たとえば、フレーズが「the maroon dog is a dog with maroon fur」の場合、「maroon」と「dog」の両方が 2 として表され、他の単語は 1 として表されます。

- 単語がバッグに出現する回数の対数など、他の値。

ベースライン

別のモデル(通常はより複雑なモデル)のパフォーマンスを比較評価するための基準点として使用されるモデル。たとえば、ロジスティック回帰モデルは、ディープ ラーニング モデルの優れたベースラインとして機能します。

特定の問題に関して、ベースラインは、新しいモデルが有用であるために新しいモデルが達成する必要があるパフォーマンスの最小期待値をモデル デベロッパーが定量化するのに役立ちます。

ベースモデル

特定のタスクやアプリケーションに対応するためのファイン チューニングの出発点として使用できる事前トレーニング済みモデル。

事前トレーニング済みモデルと基盤モデルもご覧ください。

Batch

1 回のトレーニングイテレーションで使用されるサンプルのセット。バッチサイズは、バッチ内のサンプル数を決定します。

バッチとエポックの関係については、エポックをご覧ください。

詳細については、ML 集中講座の線形回帰: ハイパーパラメータをご覧ください。

バッチ推論

複数のラベルなしの例をより小さなサブセット(「バッチ」)に分割して、予測を推論するプロセス。

バッチ推論では、アクセラレータ チップの並列化機能を利用できます。つまり、複数のアクセラレータがラベルなしの例の異なるバッチで同時に予測を推論できるため、1 秒あたりの推論数が大幅に増加します。

詳細については、ML 集中講座の本番環境の ML システム: 静的推論と動的推論をご覧ください。

バッチ正規化

隠れ層の活性化関数の入力または出力を正規化します。バッチ正規化には、次のような利点があります。

- 外れ値の重みから保護することで、ニューラル ネットワークをより安定させます。

- 学習率を上げて、トレーニングを高速化できます。

- 過学習を減らします。

バッチサイズ

バッチ内のサンプルの数。たとえば、バッチサイズが 100 の場合、モデルは 1 回のイテレーションごとに 100 個の例を処理します。

一般的なバッチサイズ戦略は次のとおりです。

- バッチサイズが 1 の確率的勾配降下法(SGD)。

- フルバッチ。バッチサイズは、トレーニング セット全体のサンプル数です。たとえば、トレーニング セットに 100 万個のサンプルが含まれている場合、バッチサイズは 100 万個のサンプルになります。通常、フルバッチは非効率的な戦略です。

- バッチサイズが通常 10 ~ 1,000 の ミニバッチ。通常、ミニバッチが最も効率的な戦略です。

詳しくは以下をご覧ください。

- 機械学習集中講座の本番環境 ML システム: 静的推論と動的推論。

- ディープ ラーニング チューニング ハンドブック。

ベイズ ニューラル ネットワーク

重みと出力の不確実性を考慮する確率的ニューラル ネットワーク。標準的なニューラル ネットワーク回帰モデルは、通常、スカラー値を予測します。たとえば、標準モデルは住宅価格を 853,000 と予測します。一方、ベイズ ニューラル ネットワークは値の分布を予測します。たとえば、ベイズモデルは、住宅価格を 853,000、標準偏差を 67,200 と予測します。

ベイズ ニューラル ネットワークは、 ベイズの定理に基づいて重みと予測の不確実性を計算します。ベイズ ニューラル ネットワークは、医薬品関連のモデルなど、不確実性を定量化することが重要な場合に役立ちます。ベイズ ニューラル ネットワークは、過剰適合の防止にも役立ちます。

ベイズ最適化

ベイズ学習手法を使用して不確実性を定量化するサロゲートを最適化することで、計算コストの高い目的関数を最適化する確率回帰モデル手法。ベイズ最適化自体が非常に高価であるため、通常は、ハイパーパラメータの選択など、パラメータの数が少ない評価にコストがかかるタスクを最適化するために使用されます。

ベルマン方程式

強化学習では、最適な Q 関数によって次の恒等式が満たされます。

\[Q(s, a) = r(s, a) + \gamma \mathbb{E}_{s'|s,a} \max_{a'} Q(s', a')\]

強化学習アルゴリズムは、この恒等式を適用して、次の更新ルールを使用して Q 学習を作成します。

\[Q(s,a) \gets Q(s,a) + \alpha \left[r(s,a) + \gamma \displaystyle\max_{\substack{a_1}} Q(s',a') - Q(s,a) \right] \]

強化学習以外にも、ベルマン方程式は動的プログラミングに応用されています。 ベルマン方程式の Wikipedia エントリをご覧ください。

BERT(Bidirectional Encoder Representations from Transformers)

テキストの表現のモデル アーキテクチャ。トレーニング済みの BERT モデルは、テキスト分類やその他の ML タスク用の大規模なモデルの一部として機能します。

BERT には次の特徴があります。

- Transformer アーキテクチャを使用するため、セルフアテンションに依存します。

- Transformer のエンコーダ部分を使用します。エンコーダの役割は、分類などの特定のタスクを実行することではなく、適切なテキスト表現を生成することです。

- 双方向です。

- 教師なしトレーニングにマスキングを使用します。

BERT のバリエーションには、次のようなものがあります。

BERT の概要については、オープンソース化された BERT: 自然言語処理の最先端の事前トレーニングをご覧ください。

バイアス(倫理/公正性)

1. 特定のこと、人、グループに対する固定観念、偏見、またはえこひいき。こうしたバイアスは、データの収集と解釈、システムの設計、ユーザーがシステムを操作する方法に影響する可能性があります。このタイプのバイアスの形式には、次のようなものがあります。

2. サンプリングや報告の手順で体系的に生じたエラー。このタイプのバイアスの形式には、次のようなものがあります。

機械学習モデルのバイアス項や予測バイアスと混同しないでください。

詳細については、ML 集中講座の公平性: 偏りの種類をご覧ください。

バイアス(数学)またはバイアス項

原点からの切片またはオフセット。バイアスは、機械学習モデルのパラメータです。次のいずれかで表されます。

- b

- w0

たとえば、次の数式では、バイアスは b です。

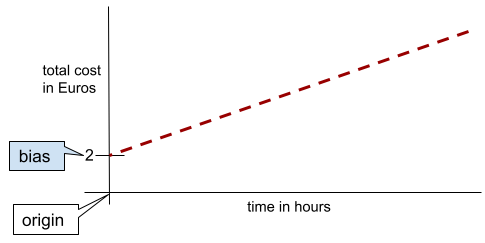

単純な 2 次元線では、バイアスは単に「y 切片」を意味します。たとえば、次の図の線のバイアスは 2 です。

バイアスが存在するのは、すべてのモデルが原点(0,0)から始まるわけではないためです。たとえば、遊園地の入場料が 2 ユーロで、滞在 1 時間ごとに 0.5 ユーロの追加料金が発生するとします。したがって、総費用をマッピングするモデルのバイアスは 2 になります。これは、最低費用が 2 ユーロであるためです。

バイアスは、倫理と公平性のバイアスや予測バイアスと混同しないでください。

詳細については、ML 集中講座の線形回帰をご覧ください。

双方向

対象のテキスト セクションの前と後の両方にあるテキストを評価するシステムを表す用語。一方、単方向のシステムは、対象のテキスト セクションの前にあるテキストのみを評価します。

たとえば、次の質問の下線部分を表す単語の確率を判断する必要があるマスク言語モデルについて考えてみましょう。

_____ はどうなっていますか?

一方向言語モデルは、「What」、「is」、「the」という単語で提供されるコンテキストのみに基づいて確率を計算する必要があります。一方、双方向言語モデルは「with」と「you」からもコンテキストを取得できるため、モデルがより適切な予測を生成するのに役立ちます。

双方向言語モデル

先行テキストと後続テキストに基づいて、テキストの抜粋内の特定の場所に特定のトークンが存在する確率を判断する言語モデル。

バイグラム

N=2 の N グラム。

バイナリ分類

2 つの相互に排他的なクラスのいずれかを予測する分類タスクの一種。

たとえば、次の 2 つの機械学習モデルはそれぞれバイナリ分類を実行します。

- メール メッセージがスパム(ポジティブ クラス)かスパムではない(ネガティブ クラス)かを判断するモデル。

- 病状を評価して、特定の病気がある(陽性クラス)か、その病気がない(陰性クラス)かを判断するモデル。

マルチクラス分類と比較してください。

詳細については、機械学習集中講座の分類をご覧ください。

バイナリ条件

決定木では、通常は yes または no の 2 つの結果のみが可能な条件。たとえば、次の条件はバイナリ条件です。

temperature >= 100

非バイナリ条件も参照してください。

詳細については、Decision Forests コースの条件のタイプをご覧ください。

ビニング

バケット化と同義。

ブラック ボックス モデル

人間の理解が不可能または困難な「推論」を行うモデル。つまり、人間はプロンプトがレスポンスにどのように影響するかを確認できますが、ブラックボックス モデルがレスポンスをどのように決定するかを正確に判断することはできません。つまり、ブラックボックス モデルには解釈可能性がありません。

ほとんどのディープモデルと大規模言語モデルはブラック ボックスです。

BLEU(Bilingual Evaluation Understudy)

機械翻訳(スペイン語から日本語など)を評価するための 0.0 ~ 1.0 の指標。

スコアを計算するために、BLEU は通常、ML モデルの翻訳(生成されたテキスト)を人間の専門家の翻訳(参照テキスト)と比較します。生成されたテキストと参照テキストの n グラムの一致度によって BLEU スコアが決まります。

この指標に関する元の論文は、BLEU: a Method for Automatic Evaluation of Machine Translation です。

BLEURT もご覧ください。

BLEURT(Bilingual Evaluation Understudy from Transformers)

ある言語から別の言語への(特に英語との間の)機械翻訳を評価するための指標。

英語との間の翻訳では、BLEURT は BLEU よりも人間の評価に近くなります。BLEU とは異なり、BLEURT は意味的類似性を重視し、言い換えに対応できます。

BLEURT は、事前トレーニングされた大規模言語モデル(正確には BERT)に依存しています。このモデルは、人間の翻訳者のテキストでファイン チューニングされています。

この指標に関する元の論文は、BLEURT: Learning Robust Metrics for Text Generation です。

ブール値の質問(BoolQ)

LLM がイエス / ノーの質問に答える能力を評価するためのデータセット。データセット内の各チャレンジには、次の 3 つのコンポーネントがあります。

- クエリ

- クエリに対する回答を暗示するパッセージ。

- 正解(はいまたはいいえ)。

次に例を示します。

- クエリ: ミシガン州に原子力発電所はありますか?

- 引用文: ...3 つの原子力発電所がミシガン州に電力を供給しており、その割合は約 30% です。

- 正解: はい

研究者は、匿名化された集計済みの Google 検索クエリから質問を収集し、Wikipedia のページを使用して情報を検証しました。

詳細については、BoolQ: Exploring the Surprising Difficulty of Natural Yes/No Questions をご覧ください。

BoolQ は、SuperGLUE アンサンブルのコンポーネントです。

BoolQ

ブール値の質問の略。

ブースト

一連の単純で精度がそれほど高くない分類モデル(「弱い分類器」と呼ばれる)を、モデルが現在誤分類している例を重み付けすることで、精度が高い分類モデル(「強い分類器」)に反復的に組み合わせる機械学習手法。

詳細については、デシジョン フォレスト コースの勾配ブースト ディシジョン ツリーとはをご覧ください。

境界ボックス

画像内の関心領域(下の画像の犬など)を囲む長方形の(x, y)座標。

ブロードキャスト

行列演算でオペランドのシェイプをその演算と互換性のあるディメンションに拡張すること。たとえば、線形代数では、行列の加算演算の 2 つのオペランドの次元が同じである必要があります。したがって、形状 (m, n) の行列を長さ n のベクトルに追加することはできません。ブロードキャストでは、長さ n のベクトルを (m, n) の形状の行列に仮想的に拡張し、各列に同じ値を複製することで、このオペレーションを有効にします。

詳しくは、NumPy のブロードキャストの説明をご覧ください。

バケット化、

通常は値の範囲に基づいて、1 つの特徴をバケットまたはビンと呼ばれる複数のバイナリ特徴に変換します。通常、切り捨てられた特徴量は連続特徴量です。

たとえば、温度を 1 つの連続した浮動小数点型の特徴量として表すのではなく、温度の範囲を次のような離散的なバケットに分割できます。

- 10 度以下は「コールド」バケットになります。

- 11 ~ 24 度の場合は「温帯」バケットになります。

- 25 度以上は「暖」バケットになります。

モデルは、同じバケット内のすべての値を同じように扱います。たとえば、値 13 と 22 はどちらも中温バケットにあるため、モデルは 2 つの値を同じように扱います。

詳細については、機械学習集中講座の数値データ: ビン分割をご覧ください。

C

キャリブレーション レイヤ

通常は予測バイアスを考慮するための、予測後の調整。調整された予測と確率は、観測されたラベルのセットの分布と一致する必要があります。

候補の生成

おすすめシステムによって選択された最初の最適化案のセット。たとえば、10 万冊の書籍を提供する書店を考えてみましょう。候補生成フェーズでは、特定のユーザーに適した書籍のリストがはるかに小さく(500 冊など)なります。しかし、500 冊もの書籍をユーザーにすすめるのは多すぎます。レコメンデーション システムの後続のより高価なフェーズ(スコアリングや再ランキングなど)では、これらの 500 個の候補が、より小さく、より有用なレコメンデーション セットに絞り込まれます。

詳細については、レコメンデーション システム コースの候補生成の概要をご覧ください。

候補サンプリング

トレーニング時に最適化を行い、たとえば softmax を使用して、すべての陽性ラベルの確率を計算しますが、陰性ラベルのランダム サンプルに対してのみ計算します。たとえば、ビーグルと犬というラベルの付いた例が与えられた場合、候補サンプリングは次の予測確率と対応する損失項を計算します。

- beagle

- 犬

- 残りのネガティブ クラスのランダムなサブセット(猫、棒付きキャンディ、フェンスなど)。

ポジティブ クラスが常に適切なポジティブ強化を受けられる限り、ネガティブ クラスは頻度の低いネガティブ強化から学習できるという考え方です。これは実際に経験的に観察されています。

候補サンプリングは、特に陰性クラスの数が非常に多い場合に、すべての陰性クラスの予測を計算するトレーニング アルゴリズムよりも計算効率が高くなります。

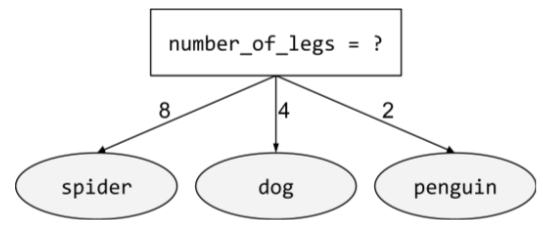

カテゴリデータ

特徴。取り得る値の特定のセットがあります。たとえば、traffic-light-state という名前のカテゴリ特徴について考えてみます。この特徴は、次の 3 つの値のいずれかしか取ることができません。

redyellowgreen

traffic-light-state をカテゴリ特徴量として表現することで、モデルは red、green、yellow が運転者の行動に与える影響の違いを学習できます。

数値データと対照的です。

詳細については、ML 集中講座のカテゴリデータの操作をご覧ください。

因果言語モデル

単一言語ペアの言語モデルと同義。

言語モデリングにおけるさまざまな方向性のアプローチを比較するには、双方向言語モデルをご覧ください。

CB

CommitmentBank の略。

centroid

k 平均法または k 中央値アルゴリズムによって決定されたクラスタの中心。たとえば、k が 3 の場合、k 平均法または k 中央値アルゴリズムは 3 つのセントロイドを見つけます。

詳細については、クラスタリング コースのクラスタリング アルゴリズムをご覧ください。

セントロイドベースのクラスタリング

データを非階層クラスタに編成するクラスタリング アルゴリズムのカテゴリ。k 平均法は、最も広く使用されている重心ベースのクラスタリング アルゴリズムです。

階層型クラスタリング アルゴリズムと比較します。

詳細については、クラスタリング コースのクラスタリング アルゴリズムをご覧ください。

Chain-of-Thought プロンプト

大規模言語モデル(LLM)に推論を段階的に説明するように促すプロンプト エンジニアリング手法。たとえば、次のプロンプトについて考えてみましょう。特に 2 番目の文に注目してください。

時速 0 マイルから時速 60 マイルまで 7 秒で加速する車に乗っているドライバーが受ける G フォースはどのくらいですか?回答には、関連する計算をすべて示してください。

LLM のレスポンスは、次のようになります。

- 物理の公式のシーケンスを表示し、適切な場所に 0、60、7 の値を代入します。

- その数式が選択された理由と、さまざまな変数の意味を説明します。

Chain-of-thought プロンプトを使用すると、LLM はすべての計算を実行する必要があるため、より正確な回答が得られる可能性があります。また、連鎖思考プロンプトを使用すると、ユーザーは LLM の手順を調べて、回答が妥当かどうかを判断できます。

文字 N グラム F スコア(ChrF)

機械翻訳モデルを評価する指標。文字 N グラム F スコアは、参照テキストの N グラムが、ML モデルの生成テキストの N グラムとどの程度重複しているかを判断します。

文字 N グラム F スコアは、ROUGE ファミリーと BLEU ファミリーの指標と似ていますが、次の点が異なります。

- 文字 N グラム F スコアは、文字 N グラムで動作します。

- ROUGE と BLEU は、単語 N グラムまたはトークンで動作します。

チャット

ML システム(通常は大規模言語モデル)とのやり取りの内容。チャットでの以前のやり取り(入力した内容と大規模言語モデルの回答)が、チャットの後続部分のコンテキストになります。

chatbot は大規模言語モデルのアプリケーションです。

チェックポイント

トレーニング中またはトレーニング完了後にモデルのパラメータの状態をキャプチャするデータ。たとえば、トレーニング中に次のことができます。

- トレーニングを停止します。これは、意図的に行う場合もあれば、特定のエラーの結果としてそうなる場合もあります。

- チェックポイントをキャプチャします。

- 後で、別のハードウェアでチェックポイントを再読み込みします。

- トレーニングを再開します。

妥当な代替案の選択(COPA)

前提に対する 2 つの回答のうち、どちらが優れているかを LLM がどの程度識別できるかを評価するためのデータセット。データセット内の各チャレンジは、次の 3 つのコンポーネントで構成されています。

- 前提(通常は質問に続くステートメント)

- 前提で提示された質問に対する 2 つの回答。1 つは正解、もう 1 つは不正解

- 正解

次に例を示します。

- 前提: 男性は足の指を骨折しました。この原因は何ですか?

- 解答例:

- 靴下に穴が開いた。

- 彼は足にハンマーを落とした。

- 正解: 2

COPA は SuperGLUE アンサンブルのコンポーネントです。

クラス

ラベルが属することができるカテゴリ。次に例を示します。

分類モデルは、クラスを予測します。一方、回帰モデルはクラスではなく数値を予測します。

詳細については、機械学習集中講座の分類をご覧ください。

クラス バランス データセット

各カテゴリのインスタンス数がほぼ等しいカテゴリカル ラベルを含むデータセット。たとえば、バイナリラベルが native plant または nonnative plant のいずれかである植物データセットを考えてみましょう。

- 515 個の在来植物と 485 個の外来植物を含むデータセットは、クラス バランス データセットです。

- 875 個の自生植物と 125 個の外来植物を含むデータセットは、クラス不均衡データセットです。

クラス バランス データセットとクラス不均衡データセットの間に明確な境界線はありません。この区別が重要になるのは、クラスの不均衡が著しいデータセットでトレーニングされたモデルが収束できない場合のみです。詳細については、ML 集中講座のデータセット: 不均衡なデータセットをご覧ください。

分類モデル

予測がクラスであるモデル。たとえば、次のモデルはすべて分類モデルです。

- 入力文の言語を予測するモデル(フランス語か、スペイン語ですか?イタリア語か、など)。

- 樹木の種類を予測するモデル(メープルか、オークか、バオバブか、など)。

- 特定の病状について、陽性クラスか陰性クラスかを予測するモデル。

一方、回帰モデルはクラスではなく数値を予測します。

一般的な分類モデルには次の 2 つがあります。

分類しきい値

バイナリ分類では、ロジスティック回帰モデルの未加工の出力を陽性クラスまたは陰性クラスのいずれかの予測に変換する 0 ~ 1 の数値。分類しきい値は、モデル トレーニングで選択された値ではなく、人間が選択する値です。

ロジスティック回帰モデルは、0 ~ 1 の範囲の生の値を出力します。以下の手順を行います。

- この生の値が分類しきい値より大きい場合、正のクラスが予測されます。

- この生の値が分類しきい値より小さい場合、負のクラスが予測されます。

たとえば、分類しきい値が 0.8 であるとします。生の値が 0.9 の場合、モデルは陽性クラスを予測します。生の値が 0.7 の場合、モデルは負のクラスを予測します。

分類しきい値の選択は、偽陽性と偽陰性の数に大きく影響します。

詳細については、ML 集中講座のしきい値と混同行列をご覧ください。

分類器

分類モデルのカジュアルな用語。

クラスの不均衡なデータセット

各クラスのラベルの総数が大きく異なる分類のデータセット。たとえば、2 つのラベルが次のように分割されているバイナリ分類データセットについて考えてみましょう。

- 1,000,000 個の負のラベル

- 10 個の正のラベル

ネガティブ ラベルとポジティブ ラベルの比率は 100,000 対 1 であるため、これはクラスの不均衡なデータセットです。

一方、次のデータセットは、ネガティブ ラベルとポジティブ ラベルの比率が 1 に比較的近いため、クラス バランスが取れています。

- 517 個の負のラベル

- 483 個の正のラベル

マルチクラス データセットは、クラスの不均衡が生じている場合もあります。たとえば、次のマルチクラス分類データセットもクラス不均衡です。これは、1 つのラベルの例が他の 2 つのラベルよりもはるかに多いためです。

- クラス「green」のラベルが 1,000,000 個

- クラス「purple」のラベルが 200 個

- クラス「orange」のラベルが 350 個

クラスの不均衡なデータセットをトレーニングすると、特別な課題が生じる可能性があります。詳細については、ML 集中講座の不均衡なデータセットをご覧ください。

クリッピング

次のいずれかまたは両方を行うことで、外れ値を処理する手法。

- 最大しきい値を超える特徴の値を最大しきい値まで減らします。

- 最小しきい値を下回る特徴量の値を、その最小しきい値まで引き上げます。

たとえば、特定の特徴の値の 0.5% 未満が 40 ~ 60 の範囲外にあるとします。この場合は、次の操作を行います。

- 60(最大しきい値)を超えるすべての値を 60 にクリップします。

- 40(最小しきい値)未満のすべての値を 40 にクリップします。

外れ値はモデルを損傷させ、トレーニング中に重みがオーバーフローすることがあります。一部の外れ値は、精度などの指標を大幅に損なう可能性があります。クリッピングは、損傷を制限する一般的な手法です。

勾配クリッピングは、トレーニング中に指定された範囲内の勾配値を強制します。

詳細については、ML 集中講座の数値データ: 正規化をご覧ください。

Cloud TPU

Google Cloud での ML ワークロードの高速化を目的として設計された特殊なハードウェア アクセラレータ。

クラスタリング

関連する例のグループ化(特に教師なし学習中)。すべての例がグループ化されたら、各クラスタに意味を付与できます。

クラスタリング アルゴリズムは多数存在します。たとえば、k 平均法アルゴリズムは、次の図のように、重心との距離に基づいて例をクラスタリングします。

その後、人間の研究者がクラスタを確認し、たとえば、クラスタ 1 に「矮性樹木」、クラスタ 2 に「成木」というラベルを付けます。

別の例として、中心点からの例の距離に基づくクラスタリング アルゴリズムについて考えてみましょう。

詳細については、クラスタリング コースをご覧ください。

共適応

ニューロンが、ネットワーク全体の動作に依存するのではなく、特定の他のニューロンの出力にほぼ完全に依存して、トレーニング データのパターンを予測する望ましくない動作。共適応を引き起こすパターンが検証データに存在しない場合、共適応によって過剰適合が発生します。ドロップアウト正則化は、ドロップアウトによってニューロンが特定の他のニューロンのみに依存できないようにするため、共適応を減らします。

コラボレーション フィルタリング

他の多くのユーザーの関心に基づいて、あるユーザーの関心について予測を行うこと。コラボレーション フィルタリングは、レコメンデーション システムでよく使用されます。

詳細については、レコメンデーション システム コースの協調フィルタリングをご覧ください。

コミットメントバンク(CB)

LLM が、ある文章の著者がその文章内のターゲット句を信じているかどうかを判断する能力を評価するためのデータセット。データセットの各エントリには次のものが含まれます。

- 文章

- その文節内のターゲット句

- パッセージの著者がターゲット句を信じているかどうかを示すブール値

次に例を示します。

- 一節: アルテミスが笑うのを聞くのは楽しい。彼女はとても真面目な子供です。彼女にユーモアのセンスがあるとは知りませんでした。

- ターゲット句: ユーモアのセンスがある

- Boolean: True。これは、著者が対象の句を信じていることを意味します。

CommitmentBank は、SuperGLUE アンサンブルのコンポーネントです。

コンパクト モデル

計算リソースが限られた小型デバイスで実行するように設計された小規模モデル。たとえば、コンパクト モデルはスマートフォン、タブレット、組み込みシステムで実行できます。

compute

(名詞)モデルまたはシステムで使用されるコンピューティング リソース(処理能力、メモリ、ストレージなど)。

アクセラレータ チップをご覧ください。

コンセプト ドリフト

特徴とラベルの関係の変化。時間の経過とともに、コンセプト ドリフトによってモデルの品質が低下します。

トレーニング中、モデルはトレーニング セット内の特徴とそのラベルの関係を学習します。トレーニング セットのラベルが現実世界の適切なプロキシである場合、モデルは現実世界の適切な予測を行うはずです。ただし、コンセプトのドリフトにより、モデルの予測は時間の経過とともに低下する傾向があります。

たとえば、特定の車種が「燃費が良い」かどうかを予測するバイナリ分類モデルについて考えてみましょう。つまり、特徴は次のようになります。

- 車の重量

- エンジンの圧縮

- transmission type

ラベルが次のいずれかである場合:

- 燃料効率が良い

- 燃費が悪い

ただし、「燃費の良い車」の概念は常に変化しています。1994 年に「燃費が良い」とラベル付けされた自動車モデルは、2024 年にはほぼ確実に「燃費が良くない」とラベル付けされるでしょう。コンセプト ドリフトが発生したモデルでは、時間の経過とともに有用な予測が少なくなる傾向があります。

非定常性と比較対照します。

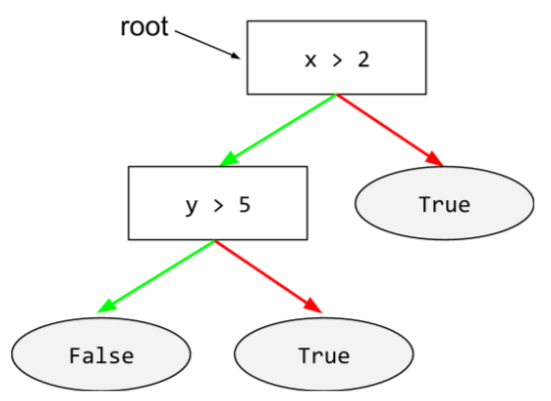

商品の状態(condition)

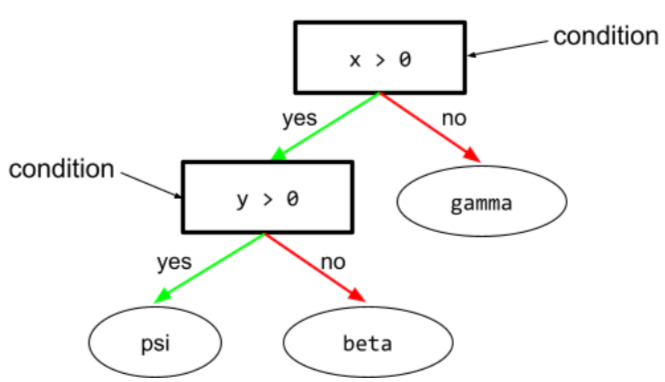

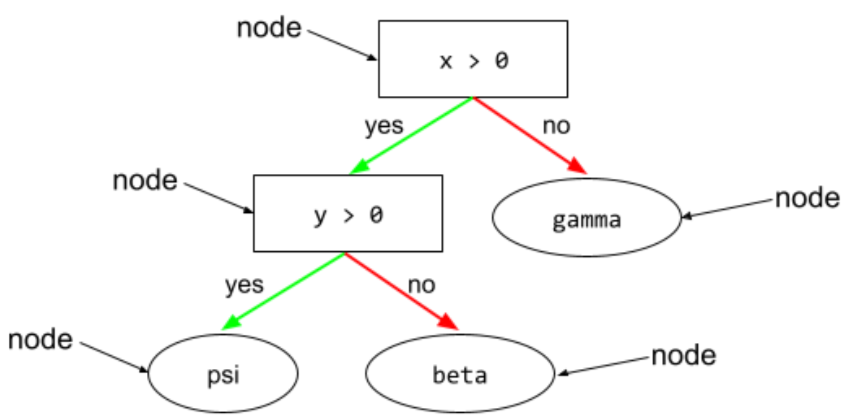

ディシジョン ツリーでは、テストを実行する任意のノード。たとえば、次のディシジョン ツリーには 2 つの条件が含まれています。

条件は、分割またはテストとも呼ばれます。

葉の条件とコントラストをつけます。

関連項目:

詳細については、Decision Forests コースの条件のタイプをご覧ください。

confabulation

ハルシネーションと同義。

幻覚よりも、技術的には「虚偽記憶」という用語の方が正確でしょう。しかし、ハルシネーションが最初に普及しました。

構成

モデルのトレーニングに使用される初期プロパティ値を割り当てるプロセス。次のものがあります。

ML プロジェクトでは、特別な構成ファイルを使用するか、次の構成ライブラリを使用して構成を行うことができます。

確証バイアス

既存の信念や仮説を裏付けるような形で情報を検索、解釈、好意的に扱い、思い出す傾向。ML デベロッパーは、既存の信念を裏付ける結果に影響を与える方法で、誤ってデータを収集したりラベル付けしたりする可能性があります。確証バイアスは、暗黙のバイアスの一種です。

テスト担当者のバイアスは、テスト担当者が既存の仮説が確証されるまでモデルのトレーニングを続ける確証バイアスの一種です。

混同行列

分類モデルが行った正しい予測と誤った予測の数をまとめた NxN の表。たとえば、バイナリ分類モデルの次の混同行列について考えてみましょう。

| 腫瘍(予測) | 腫瘍なし(予測) | |

|---|---|---|

| 腫瘍(グラウンド トゥルース) | 18(TP) | 1(FN) |

| 腫瘍なし(グラウンド トゥルース) | 6(FP) | 452(TN) |

上の混同行列は、次のことを示しています。

- グラウンド トゥルースが「腫瘍」である 19 個の予測のうち、モデルは 18 個を正しく分類し、1 個を誤って分類しました。

- グラウンド トゥルースが「Non-Tumor」である 458 件の予測のうち、モデルは 452 件を正しく分類し、6 件を誤って分類しました。

マルチクラス分類問題の混同行列は、誤りのパターンを特定するのに役立ちます。たとえば、3 つの異なるアヤメの種類(Virginica、Versicolor、Setosa)を分類する 3 クラスのマルチクラス分類モデルの次の混同行列について考えてみましょう。正解が Virginica の場合、混同行列は、モデルが Setosa よりも Versicolor を誤って予測する可能性がはるかに高いことを示しています。

| Setosa(予測) | Versicolor(予測) | Virginica(予測) | |

|---|---|---|---|

| Setosa(グラウンド トゥルース) | 88 | 12 | 0 |

| Versicolor(グラウンド トゥルース) | 6 | 141 | 7 |

| Virginica(グラウンド トゥルース) | 2 | 27 | 109 |

別の例として、手書きの数字を認識するようにトレーニングされたモデルが、4 ではなく 9 を誤って予測したり、7 ではなく 1 を誤って予測したりする傾向があることが、混同行列から明らかになることがあります。

混同行列には、適合率や再現率など、さまざまなパフォーマンス指標を計算するのに十分な情報が含まれています。

構成要素の解析

文をより小さな文法構造(「構成要素」)に分割すること。ML システムの後続部分(自然言語理解モデルなど)は、元の文よりも構成要素を簡単に解析できます。たとえば、次の文について考えてみましょう。

友人が 2 匹の猫を飼い始めました。

構成要素パーサーは、この文を次の 2 つの構成要素に分割できます。

- 「My friend」は名詞句です。

- 「adopted two cats」は動詞句です。

これらの構成要素は、さらに小さな構成要素に細分化できます。たとえば、動詞句

2 匹の猫を飼い始めた

にさらに細分化できます。

- adopted は動詞です。

- 2 匹の猫は別の名詞句です。

コンテキスト化された言語エンベディング

流暢な人間の話者が単語やフレーズを理解する方法に近い方法で単語やフレーズを「理解」するエンベディング。コンテキスト化された言語エンベディングは、複雑な構文、セマンティクス、コンテキストを理解できます。

たとえば、英語の単語「cow」のエンベディングについて考えてみましょう。word2vec などの古いエンベディングでは、cow から bull までのエンベディング空間内の距離が、ewe(雌羊)から ram(雄羊)までの距離や、female から male までの距離に似るように、英単語を表現できます。コンテキスト化された言語エンベディングは、英語話者が「cow」という単語を牛または雄牛の意味でカジュアルに使用することがあることを認識することで、さらに一歩進むことができます。

コンテキスト ウィンドウ

モデルが特定のプロンプトで処理できるトークンの数。コンテキスト ウィンドウが大きいほど、モデルはより多くの情報を使用して、プロンプトに明解で一貫性のある回答を提供できます。

連続特徴

温度や重さなど、可能な値の範囲が無限の浮動小数点特徴。

離散特徴と比較してください。

便宜的サンプリング

科学的に収集されていないデータセットを使用して、迅速な実験を行う。後で、科学的に収集されたデータセットに切り替えることが不可欠です。

収束

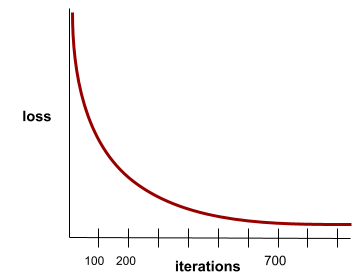

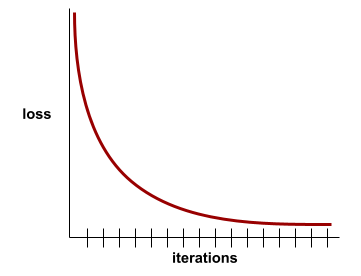

反復処理ごとに 損失値がほとんど変化しないか、まったく変化しない状態。たとえば、次の損失曲線は、約 700 回の反復で収束することを示しています。

モデルが収束するのは、追加のトレーニングを行ってもモデルが改善されない場合です。

ディープ ラーニングでは、損失値が最終的に減少するまで、多くのイテレーションで一定またはほぼ一定になることがあります。損失値が一定の期間続くと、一時的に収束したように見えることがあります。

早期停止もご覧ください。

詳細については、ML 集中講座のモデルの収束と損失曲線をご覧ください。

会話型コーディング

ソフトウェアを作成する目的で、ユーザーと生成 AI モデルの間で行われる反復的なダイアログ。ソフトウェアについて説明するプロンプトを発行します。モデルは、その説明を使用してコードを生成します。次に、前のプロンプトまたは生成されたコードの欠陥に対処する新しいプロンプトを発行すると、モデルは更新されたコードを生成します。生成されたソフトウェアが十分に良いものになるまで、2 人でやり取りを繰り返します。

会話コーディングは、基本的に vibe coding の本来の意味です。

仕様コーディングも参照してください。

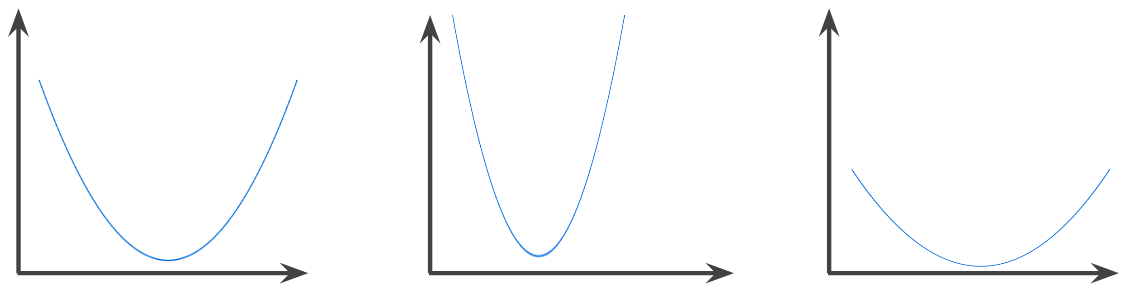

凸関数

関数のグラフの上側の領域が凸集合である関数。典型的な凸関数は、U のような形をしています。たとえば、次の関数はすべて凸関数です。

一方、次の関数は凸関数ではありません。グラフの上側の領域が凸集合ではないことに注目してください。

狭義の凸関数には、局所最小点が 1 つだけあり、それが大域最小点でもあります。従来の U 字型の関数は、厳密な凸関数です。ただし、一部の凸関数(直線など)は U 字型ではありません。

詳細については、ML 集中講座の収束と凸関数をご覧ください。

凸最適化

勾配降下法などの数学的手法を使用して、凸関数の最小値を求めるプロセス。機械学習の研究の多くは、さまざまな問題を凸最適化問題として定式化し、それらの問題をより効率的に解決することに重点を置いています。

詳細については、Boyd と Vandenberghe の Convex Optimization をご覧ください。

凸集合

ユークリッド空間のサブセット。サブセット内の任意の 2 点を結ぶ線がサブセット内に完全に収まる。たとえば、次の 2 つの形状は凸集合です。

一方、次の 2 つの形状は凸集合ではありません。

畳み込み

数学では、2 つの関数を混合したものです。機械学習では、畳み込みは畳み込みフィルタと入力行列を混合して、重みをトレーニングします。

ML における「畳み込み」という用語は、畳み込み演算または畳み込みレイヤのいずれかを指す略語としてよく使用されます。

畳み込みがない場合、機械学習アルゴリズムは大きなテンソルのすべてのセルに対して個別の重みを学習する必要があります。たとえば、2K x 2K 画像でトレーニングする機械学習アルゴリズムは、4M 個の個別の重みを見つけることを強制されます。畳み込みのおかげで、機械学習アルゴリズムは畳み込みフィルタの各セルの重みを見つけるだけで済み、モデルのトレーニングに必要なメモリが大幅に削減されます。畳み込みフィルタが適用されると、各セルがフィルタで乗算されるように、フィルタがセル全体に複製されます。

畳み込みフィルタ

畳み込み演算の 2 つのアクターの 1 つ。(もう一方のアクターは入力行列のスライスです)。畳み込みフィルタは、入力行列と同じランクを持ち、形状が小さい行列です。たとえば、28x28 の入力行列が与えられた場合、フィルタは 28x28 より小さい任意の 2D 行列になります。

写真の操作では、通常、畳み込みフィルタのすべてのセルは 1 と 0 の定数パターンに設定されます。ML では、通常、畳み込みフィルタは乱数でシードされ、ネットワークが理想的な値をトレーニングします。

畳み込みレイヤ

畳み込みフィルタが入力行列を渡すディープ ニューラル ネットワークのレイヤ。たとえば、次の 3x3 の畳み込みフィルタについて考えてみましょう。

![次の値を含む 3x3 行列: [[0,1,0], [1,0,1], [0,1,0]]](https://developers.google.com/static/machine-learning/glossary/images/ConvolutionalFilter33.svg?authuser=1&hl=ja)

次のアニメーションは、5x5 入力行列を含む 9 つの畳み込み演算で構成される畳み込みレイヤを示しています。各畳み込み演算は、入力行列の異なる 3x3 スライスで動作します。結果として得られる 3x3 行列(右側)は、9 つの畳み込み演算の結果で構成されます。

![2 つの行列を示すアニメーション。最初の行列は 5x5 行列 [[128,97,53,201,198], [35,22,25,200,195], [37,24,28,197,182], [33,28,92,195,179], [31,40,100,192,177]] です。2 番目の行列は、3x3 行列 [[181,303,618], [115,338,605], [169,351,560]] です。2 番目の行列は、5x5 行列のさまざまな 3x3 サブセットに畳み込みフィルタ [[0, 1, 0], [1, 0, 1], [0, 1, 0]] を適用して計算されます。](https://developers.google.com/static/machine-learning/glossary/images/AnimatedConvolution.gif?authuser=1&hl=ja)

畳み込みニューラル ネットワーク

少なくとも 1 つのレイヤが畳み込みレイヤであるニューラル ネットワーク。一般的な畳み込みニューラル ネットワークは、次のレイヤの組み合わせで構成されています。

畳み込みニューラル ネットワークは、画像認識などの特定の問題で大きな成功を収めています。

畳み込み演算

次の 2 段階の算術演算。

- 畳み込みフィルタと入力行列のスライスとの要素ごとの乗算。(入力行列のスライスは、畳み込みフィルタと同じランクとサイズになります)。

- 結果の積行列内のすべての値の合計。

たとえば、次の 5x5 の入力行列を考えてみましょう。

![5x5 行列: [[128,97,53,201,198], [35,22,25,200,195],

[37,24,28,197,182], [33,28,92,195,179], [31,40,100,192,177]]。](https://developers.google.com/static/machine-learning/glossary/images/ConvolutionalLayerInputMatrix.svg?authuser=1&hl=ja)

次の 2x2 畳み込みフィルタを考えてみましょう。

![2x2 マトリックス: [[1, 0], [0, 1]]](https://developers.google.com/static/machine-learning/glossary/images/ConvolutionalLayerFilter.svg?authuser=1&hl=ja)

各畳み込み演算では、入力行列の 2x2 スライスが 1 つ使用されます。たとえば、入力行列の左上の 2x2 スライスを使用するとします。したがって、このスライスの畳み込み演算は次のようになります。

![入力行列の左上 2x2 セクション([[128,97], [35,22]])に畳み込みフィルタ [[1, 0], [0, 1]] を適用します。畳み込みフィルタは 128 と 22 をそのまま残しますが、97 と 35 はゼロにします。その結果、畳み込み演算により値 150(128+22)が得られます。](https://developers.google.com/static/machine-learning/glossary/images/ConvolutionalLayerOperation.svg?authuser=1&hl=ja)

畳み込みレイヤは、一連の畳み込み演算で構成され、それぞれが入力行列の異なるスライスで動作します。

COPA

妥当な代替案の選択の略。

費用

損失と同義。

共同トレーニング

半教師あり学習アプローチは、次のすべての条件に該当する場合に特に有用です。

- データセット内のラベル付きの例に対するラベルなしの例の比率が高い。

- これは分類問題(バイナリまたはマルチクラス)です。

- データセットには、互いに独立していて補完的な 2 つの異なる予測特徴セットが含まれています。

コトレーニングは、基本的に独立したシグナルを増幅してより強力なシグナルにします。たとえば、個々の中古車を「良い」または「悪い」に分類する分類モデルについて考えてみましょう。予測機能の 1 つのセットは、車の年式、メーカー、モデルなどの集計特性に焦点を当て、予測機能の別のセットは、前の所有者の運転記録と車のメンテナンス履歴に焦点を当てます。

共トレーニングに関する重要な論文は、Blum と Mitchell による Combining Labeled and Unlabeled Data with Co-Training です。

反事実的公平性

1 つ以上の機密属性を除いて、最初の個人と同一の別の個人に対して、分類モデルが同じ結果を生成するかどうかを確認する公平性指標。反事実的公平性について分類モデルを評価することは、モデル内の潜在的なバイアスの原因を特定する 1 つの方法です。

詳しくは、次のいずれかをご覧ください。

- 機械学習集中講座の公平性: 反事実的公平性。

- When Worlds Collide: Integrating Different Counterfactual Assumptions in Fairness(英語)

カバレッジ バイアス

選択バイアスをご覧ください。

クラッシュ ブラッサム

意味が曖昧な文またはフレーズ。クラッシュ ブロッサムは、自然言語理解において重大な問題を引き起こします。たとえば、「Red Tape Holds Up Skyscraper」という見出しは、NLU モデルがこの見出しを文字どおりに解釈することも、比喩的に解釈することもできるため、クラッシュ ブロッサムです。

批評家

Deep Q-Network と同義。

交差エントロピー

対数損失をマルチクラス分類問題に一般化したものです。交差エントロピーは、2 つの確率分布間の差を定量化します。パープレキシティもご覧ください。

cross-validation

トレーニング セットから除外された 1 つ以上の重複しないデータ サブセットに対してモデルをテストすることで、モデルが新しいデータにどれだけ一般化されるかを推定するメカニズム。

累積分布関数(CDF)

目標値以下のサンプルの頻度を定義する関数。たとえば、連続値の正規分布を考えてみましょう。CDF は、サンプルの約 50% が平均値以下であり、サンプルの約 84% が平均値より 1 標準偏差大きい値以下であることを示します。

D

データ分析

サンプル、測定、可視化を考慮したデータの理解。データ分析は特に、最初のモデルを構築する前に、データセットを初めて受け取ったときに役立ちます。また、テストの理解やシステムの問題のデバッグにも不可欠です。

データの拡張

既存のサンプルを変換して追加のサンプルを作成することにより、トレーニング サンプルの範囲と数を人為的に増やすこと。たとえば、画像が特徴の 1 つであるのに、データセットにはモデルが有用な関連性を学習するのに十分な画像サンプルが含まれていないとします。理想的なのは、モデルを適切にトレーニングできるように、データセットにラベル付けされた画像を十分に追加することです。それが不可能な場合は、データ拡張によって各画像を回転、伸縮、反射して元の画像の多くのバリエーションを生成し、優れたトレーニングを可能にする十分なラベル付きデータを得ることができます。

DataFrame

メモリ内のデータセットを表す一般的な pandas データ型。

DataFrame は、テーブルやスプレッドシートに似ています。DataFrame の各列には名前(ヘッダー)があり、各行は一意の数値で識別されます。

DataFrame の各列は 2 次元配列のように構造化されていますが、各列に独自のデータ型を割り当てられる点が特徴です。

pandas.DataFrame のリファレンス ページもご覧ください。

データ並列処理

トレーニングまたは推論をスケーリングする方法の 1 つで、モデル全体を複数のデバイスに複製し、入力データのサブセットを各デバイスに渡します。データ並列処理では、非常に大きなバッチサイズでのトレーニングと推論が可能になります。ただし、モデルはすべてのデバイスに収まるほど小さくする必要があります。

通常、データ並列処理によりトレーニングと推論の速度が上がります。

モデル並列処理もご覧ください。

Dataset API(tf.data)

データを読み取り、機械学習アルゴリズムが必要とする形式に変換するための高レベルの TensorFlow API。tf.data.Dataset オブジェクトは、要素のシーケンスを表します。各要素には 1 つ以上の Tensor が含まれています。tf.data.Iterator オブジェクトは、Dataset の要素へのアクセスを提供します。

データセット

通常は(ただし限定されない)次のいずれかの形式で整理された、未加工データのコレクションです。

- スプレッドシート

- CSV(カンマ区切り値)形式のファイル

決定境界

バイナリクラスまたはマルチクラス分類問題でモデルによって学習されたクラス間の分離線。たとえば、次のバイナリ分類問題を表す画像では、決定境界はオレンジ色のクラスと青色のクラスの境界です。

デシジョン フォレスト

複数のディシジョン ツリーから作成されたモデル。ディシジョン フォレストは、ディシジョン ツリーの予測を集計して予測を行います。一般的なディシジョン フォレストには、ランダム フォレストや勾配ブースト ツリーなどがあります。

詳細については、デシジョン フォレスト コースのデシジョン フォレストのセクションをご覧ください。

決定しきい値

分類しきい値と同義。

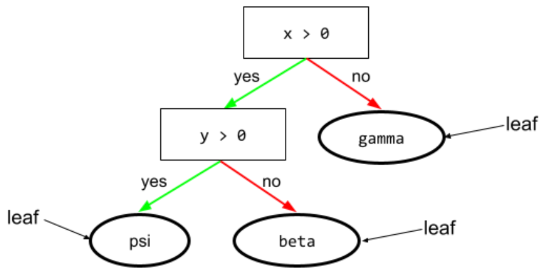

ディシジョン ツリー

階層的に編成された一連の条件とリーフで構成される教師あり学習モデル。たとえば、次の意思決定ツリーを考えます。

デコーダ

一般に、処理済み、密、内部の表現から、より未加工な、疎、外部の表現に変換する ML システム。

デコーダは多くの場合、大規模なモデルのコンポーネントであり、エンコーダと対になっています。

sequence-to-sequence(Seq2Seq)タスクでは、デコーダはエンコーダによって生成された内部状態から開始して、次のシーケンスを予測します。

Transformer アーキテクチャ内のデコーダの定義については、Transformer を参照してください。

詳細については、ML 集中講座の大規模言語モデルをご覧ください。

ディープモデル

複数の隠れ層を含むニューラル ネットワーク。

ディープモデルは、ディープ ニューラル ネットワークとも呼ばれます。

ワイドモデルと比較してください。

ネットワークでよく

ディープモデルと同義。

Deep Q-Network(DQN)

Q 学習では、Q 関数を予測するディープ ニューラル ネットワークを使用します。

Critic は、Deep Q-Network の同義語です。

人口統計学的等価性

モデルの分類結果が特定の機密属性に依存しない場合に満たされる公平性指標。

たとえば、リリパット人とブロブディンナグ人が Glubbdubdrib 大学に申し込んだ場合、リリパット人の合格率とブロブディンナグ人の合格率が同じであれば、一方のグループが他方よりも平均的に資格があるかどうかに関係なく、人口統計学的パリティが達成されます。

均等化されたオッズと機会の平等とは対照的です。これらは、分類結果の集計が機密属性に依存することを許可しますが、特定の指定されたグラウンド トゥルース ラベルの分類結果が機密属性に依存することを許可しません。人口統計学的パリティの最適化におけるトレードオフを視覚化したものについては、「よりスマートな機械学習による差別の是正」をご覧ください。

詳細については、ML 集中講座の公平性: 人口統計学的パリティをご覧ください。

ノイズ除去

自己教師あり学習の一般的なアプローチ。

ノイズ除去により、ラベルなしの例から学習できます。元のデータセットはターゲットまたはラベルとして機能し、ノイズの多いデータは入力として機能します。

一部のマスク言語モデルでは、次のようにノイズ除去を使用します。

- ノイズは、一部のトークンをマスクすることで、ラベルのない文に人工的に追加されます。

- モデルは元のトークンを予測しようとします。

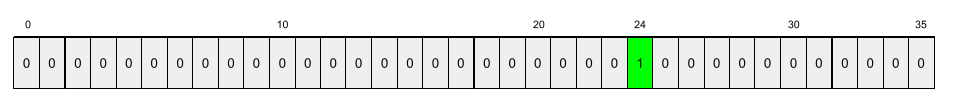

密な特徴

ほとんどまたはすべての値がゼロ以外の特徴。通常は浮動小数点値の Tensor。たとえば、次の 10 要素の Tensor は、9 つの値がゼロ以外であるため、密です。

| 8 | 3 | 7 | 5 | 2 | 4 | 0 | 4 | 9 | 6 |

スパースな特徴と比較してください。

密結合レイヤ

全結合レイヤと同義。

深さ

ニューラル ネットワーク内の次の合計:

- 隠れ層の数

- 出力レイヤの数(通常は 1)

- エンベディング レイヤの数

たとえば、隠れ層が 5 つ、出力層が 1 つのニューラル ネットワークの深さは 6 です。

入力レイヤは depth に影響しないことに注意してください。

深度方向分離畳み込みニューラル ネットワーク(sepCNN)

Inception に基づく畳み込みニューラル ネットワーク アーキテクチャ。ただし、Inception モジュールは深さ方向の分離可能な畳み込みに置き換えられています。Xception とも呼ばれます。

デプスワイズ分離畳み込み(分離畳み込みとも呼ばれます)は、標準の 3D 畳み込みを、より計算効率の高い 2 つの別々の畳み込み演算に分解します。1 つ目は深さ 1(n ✕ n ✕ 1)のデプスワイズ畳み込み、2 つ目は長さと幅が 1(1 ✕ 1 ✕ n)のポイントワイズ畳み込みです。

詳細については、Xception: Depthwise Separable Convolutions を使用したディープ ラーニングをご覧ください。

派生ラベル

プロキシ ラベルと同義。

デバイス

次の 2 つの定義が考えられるオーバーロードされた用語。

- CPU、GPU、TPU など、TensorFlow セッションを実行できるハードウェアのカテゴリ。

- アクセラレータ チップ(GPU または TPU)で ML モデルをトレーニングする場合、テンソルとエンベディングを実際に操作するシステムの部分。デバイスはアクセラレータ チップで動作します。一方、ホストは通常 CPU で実行されます。

差分プライバシー

ML において、モデルのトレーニング セットに含まれる機密データ(個人の個人情報など)が公開されないようにするための匿名化アプローチ。このアプローチにより、モデルが特定の個人について学習したり記憶したりすることがなくなります。これは、モデルのトレーニング中にサンプリングとノイズの追加を行うことで、個々のデータポイントを不明瞭にし、機密性の高いトレーニング データが漏えいするリスクを軽減します。

差分プライバシーは、ML 以外でも使用されています。たとえば、データ サイエンティストは、さまざまなユーザー層のプロダクト使用統計情報を計算する際に、個人のプライバシーを保護するために差分プライバシーを使用することがあります。

次元削減

特徴ベクトル内の特定の特徴を表すために使用される次元の数を減らします。通常は、エンベディング ベクトルに変換します。

ディメンション

次のいずれかの定義を持つオーバーロードされた用語。

Tensor 内の座標のレベル数。次に例を示します。

- スカラーにはディメンションがありません(例:

["Hello"])。 - ベクトルには 1 つのディメンションがあります(例:

[3, 5, 7, 11])。 - マトリックスには 2 つのディメンションがあります(例:

[[2, 4, 18], [5, 7, 14]])。1 次元ベクトルの特定のセルを一意に指定するには 1 つの座標を使用します。2 次元行列の特定のセルを一意に指定するには 2 つの座標が必要です。

- スカラーにはディメンションがありません(例:

特徴ベクトルのエントリ数。

エンベディング レイヤ内の要素の数。

直接プロンプト

ゼロショット プロンプトと同義。

離散特徴

取り得る値の有限集合を持つ特徴。たとえば、値が animal、vegetable、mineral のいずれかである特徴は、離散(またはカテゴリカル)特徴です。

連続特徴と比較します。

識別モデル

1 つ以上の特徴のセットからラベルを予測するモデル。より正式には、識別モデルは、特徴と重みが与えられた場合の出力の条件付き確率を定義します。つまり、次のようになります。

p(output | features, weights)

たとえば、特徴と重みからメールがスパムかどうかを予測するモデルは、識別モデルです。

分類モデルや回帰モデルなど、教師あり学習モデルの大部分は識別モデルです。

生成モデルと比較してください。

discriminator

例が本物か偽物かを判断するシステム。

または、ジェネレータによって作成された例が本物か偽物かを判断する敵対的生成ネットワーク内のサブシステム。

詳細については、GAN コースの識別器をご覧ください。

不均衡な影響

さまざまな人口サブグループに不均衡な影響を与える人に関する意思決定を行う。通常、これはアルゴリズムによる意思決定プロセスが、一部のサブグループに他のサブグループよりも大きな損害または利益をもたらす状況を指します。

たとえば、リリパット人のミニチュア住宅ローンの資格を判断するアルゴリズムで、郵送先住所に特定の郵便番号が含まれている場合、その人を「不適格」と分類する可能性が高いとします。リトル エンディアンのリリパット人よりもビッグ エンディアンのリリパット人のほうが、この郵便番号の住所を持っている可能性が高い場合、このアルゴリズムは不均衡な影響をもたらす可能性があります。

サブグループの特性がアルゴリズムによる意思決定プロセスの明示的な入力である場合に生じる不均衡に焦点を当てた不当な扱いとは対照的です。

不当な差別的取り扱い

アルゴリズムによる意思決定プロセスに被験者の機密属性を考慮し、人々のさまざまなサブグループが異なる扱いを受けるようにすること。

たとえば、リリパット人が住宅ローン申請で提供したデータに基づいて、ミニチュア住宅ローンの利用資格を判断するアルゴリズムを考えてみましょう。アルゴリズムがリリパット人の所属をビッグ エンディアンまたはリトル エンディアンとして入力に使用する場合、その次元に沿って差別的な取り扱いが行われます。

不均衡な影響(アルゴリズムによる意思決定がサブグループに及ぼす社会的影響の不均衡に焦点を当てたもの。サブグループがモデルへの入力であるかどうかは関係ない)とは対照的です。

での精製

1 つのモデル(教師と呼ばれる)のサイズを、元のモデルの予測を可能な限り忠実にエミュレートする小さなモデル(生徒と呼ばれる)に縮小するプロセス。蒸留が有用なのは、小規模なモデルには大規模なモデル(教師)よりも 2 つの大きなメリットがあるためです。

- 推論時間の短縮

- メモリとエネルギー使用量の削減

ただし、生徒の予測は通常、教師の予測ほど正確ではありません。

蒸留では、生徒モデルと教師モデルの予測の出力の差に基づいて、損失関数を最小限に抑えるように生徒モデルをトレーニングします。

蒸留と次の用語を比較対照します。

詳細については、ML 集中講座の LLM: ファインチューニング、蒸留、プロンプト エンジニアリングをご覧ください。

配信

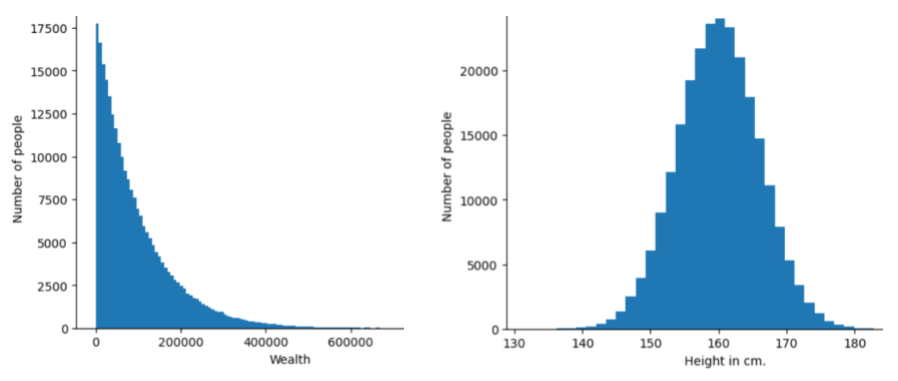

特定の特徴またはラベルの異なる値の頻度と範囲。分布は、特定の値の可能性を捉えます。

次の図は、2 つの異なる分布のヒストグラムを示しています。

- 左は、富の分布と、その富を所有する人数の関係をべき乗則で表したグラフです。

- 右側は、身長と、その身長の人の数の正規分布です。

各特徴とラベルの分布を理解すると、値を正規化して外れ値を検出する方法を判断できます。

「分布外」とは、データセットに表示されない値、または非常にまれな値を指します。たとえば、猫の画像で構成されるデータセットの場合、土星の画像は分布外と見なされます。

分割型クラスタリング

階層型クラスタリングをご覧ください。

ダウンサンプリング

次のいずれかを意味する可能性のあるオーバーロードされた用語。

- モデルをより効率的にトレーニングするために、特徴量の情報を減らすこと。たとえば、画像認識モデルをトレーニングする前に、高解像度画像を低解像度形式にダウンサンプリングします。

- 過剰に表現されたクラスの例の割合が極端に低いデータでトレーニングして、過小に表現されたクラスのモデル トレーニングを改善します。たとえば、クラスの不均衡なデータセットでは、モデルは多数派クラスについて多くを学習し、少数派クラスについては十分に学習しない傾向があります。ダウンサンプリングは、メジャー クラスとマイナー クラスのトレーニング量のバランスをとるのに役立ちます。

詳細については、ML 集中講座のデータセット: 不均衡なデータセットをご覧ください。

DQN

Deep Q-Network の略語。

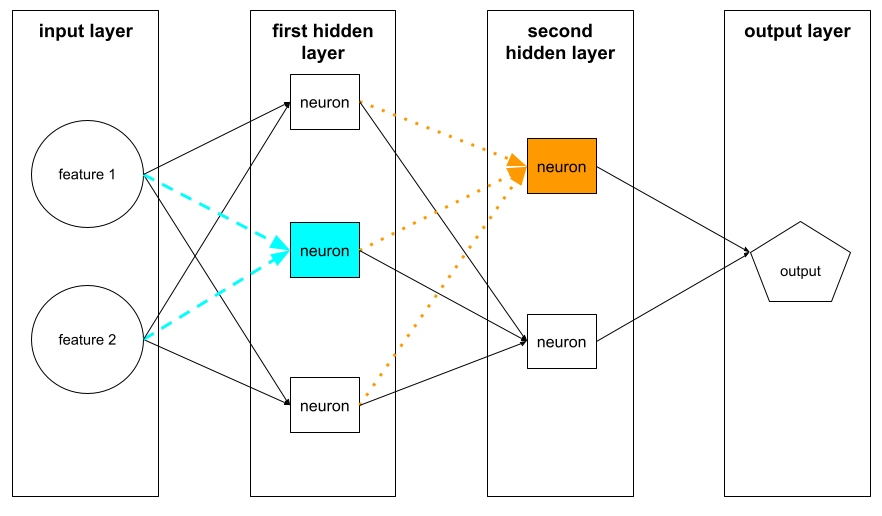

ドロップアウト正則化

ニューラル ネットワークのトレーニングに役立つ正則化の一種。ドロップアウト正則化では、単一の勾配ステップで、ネットワーク レイヤ内の固定数のユニットがランダムに選択されて削除されます。ドロップアウトするユニットが多いほど、正則化が強くなります。これは、小さなネットワークの指数関数的に大きなアンサンブルをエミュレートするようにネットワークをトレーニングするのと同様です。詳細については、Dropout: A Simple Way to Prevent Neural Networks from Overfitting をご覧ください。

動的

頻繁にまたは継続的に行われること。機械学習では、動的とオンラインという用語は同義語です。以下に、機械学習における dynamic と online の一般的な使用例を示します。

- 動的モデル(またはオンライン モデル)は、頻繁にまたは継続的に再トレーニングされるモデルです。

- 動的トレーニング(またはオンライン トレーニング)は、頻繁にまたは継続的にトレーニングを行うプロセスです。

- 動的推論(またはオンライン推論)は、オンデマンドで予測を生成するプロセスです。

動的モデル

頻繁に(継続的に)再トレーニングされるモデル。動的モデルは、進化するデータに常に適応する「生涯学習者」です。動的モデルは、オンライン モデルとも呼ばれます。

静的モデルと比較してください。

E

Eager Execution

オペレーションがすぐに実行される TensorFlow プログラミング環境。一方、グラフ実行で呼び出されたオペレーションは、明示的に評価されるまで実行されません。Eager 実行は、ほとんどのプログラミング言語のコードと同様に、命令型インターフェースです。一般に、積極的実行プログラムはグラフ実行プログラムよりもデバッグがはるかに簡単です。

早期停止

トレーニングの損失が減少を終える前にトレーニングを終了する正則化の手法。早期停止では、検証データセットの損失が上昇し始めたとき、つまり汎化性能が低下したときに、モデルのトレーニングを意図的に停止します。

早期終了との違い。

アース ムーバーズ距離(EMD)

2 つの分布の相対的な類似性の尺度。アース ムーバー距離が小さいほど、分布の類似性が高くなります。

編集距離

2 つのテキスト文字列の類似性を測定します。機械学習では、編集距離は次の理由で役立ちます。

- 編集距離は簡単に計算できます。

- 編集距離は、互いに類似していることがわかっている 2 つの文字列を比較できます。

- 編集距離を使用すると、異なる文字列が特定の文字列にどの程度類似しているかを判断できます。

編集距離にはいくつかの定義があり、それぞれ異なる文字列操作を使用します。例については、レーベンシュタイン距離をご覧ください。

Einsum 表記

2 つのテンソルを結合する方法を記述するための効率的な表記法。テンソルは、一方のテンソルの要素に他方のテンソルの要素を乗算し、その積を合計することで結合されます。Einsum 表記では、記号を使用して各テンソルの軸を識別し、同じ記号を並べ替えて新しい結果テンソルの形状を指定します。

NumPy は、一般的な Einsum 実装を提供します。

エンベディング レイヤ

高次元のカテゴリカル特徴でトレーニングし、低次元の埋め込みベクトルを徐々に学習する特別な隠れ層。埋め込みレイヤを使用すると、高次元のカテゴリ特徴のみでトレーニングするよりも、ニューラル ネットワークのトレーニングをはるかに効率的に行うことができます。

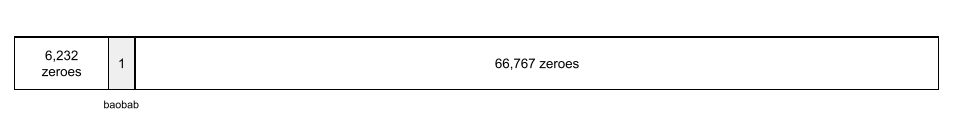

たとえば、Earth は現在約 73,000 種の樹木をサポートしています。モデルの特徴が樹種であるとします。この場合、モデルの入力レイヤには 73,000 個の要素を含むワンホット ベクトルが含まれます。たとえば、baobab は次のように表されます。

73,000 個の要素を含む配列は非常に長くなります。モデルにエンベディング レイヤを追加しないと、72,999 個のゼロを乗算するため、トレーニングに非常に時間がかかります。たとえば、エンベディング レイヤを 12 個のディメンションで構成するとします。その結果、エンベディング レイヤは各樹種の新しいエンベディング ベクトルを徐々に学習します。

状況によっては、ハッシュ化がエンベディング レイヤの妥当な代替手段となることがあります。

詳細については、ML 集中講座のエンベディングをご覧ください。

エンベディング空間

高次元ベクトル空間の特徴がマッピングされる d 次元ベクトル空間。エンベディング空間は、目的のアプリケーションにとって意味のある構造をキャプチャするようにトレーニングされます。

2 つのエンベディングのドット積は、それらの類似度の指標です。

エンベディング ベクトル

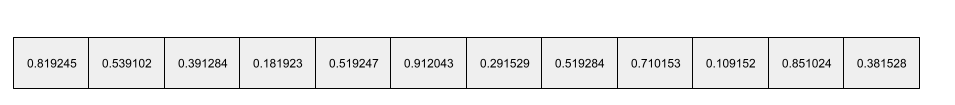

大まかに言うと、任意の 隠れ層から取得された浮動小数点数の配列で、その隠れ層への入力を記述します。通常、エンベディング ベクトルは、エンベディング レイヤでトレーニングされた浮動小数点数の配列です。たとえば、エンベディング レイヤが地球上の 73,000 種の樹木ごとにエンベディング ベクトルを学習する必要があるとします。たとえば、次の配列はバオバブのエンベディング ベクトルです。

エンベディング ベクトルは、ランダムな数値の集まりではありません。エンベディング レイヤは、トレーニング中にニューラル ネットワークが他の重みを学習する方法と同様に、トレーニングを通じてこれらの値を決定します。配列の各要素は、樹種の特性に関する評価です。どの要素がどの樹種の特性を表していますか?これは人間が判断するには非常に難しいことです。

エンベディング ベクトルの数学的に注目すべき点は、類似したアイテムには類似した浮動小数点数のセットがあることです。たとえば、類似した樹種は、類似していない樹種よりも類似した浮動小数点数のセットを持ちます。レッドウッドとセコイアは関連する樹種であるため、レッドウッドとココヤシよりも類似した浮動小数点数のセットになります。エンベディング ベクトルの数値は、同じ入力でモデルを再トレーニングした場合でも、モデルを再トレーニングするたびに変化します。

経験累積分布関数(eCDF または EDF)

実際のデータセットの実測値に基づく累積分布関数。X 軸上の任意の点における関数の値は、指定された値以下のデータセット内の観測値の割合です。

経験的リスク最小化(ERM)

トレーニング セットの損失を最小限に抑える関数を選択します。構造リスクの最小化と対照的です。

エンコーダ

一般に、未加工な、疎、外部の表現から、より加工された、密、内部の表現に変換する ML システム。

エンコーダは多くの場合、大規模なモデルのコンポーネントであり、デコーダと対になっています。Transformer にはエンコーダとデコーダを対で使用するものと、エンコーダまたはデコーダのみを単独で使用するものがあります。

一部のシステムでは、エンコーダの出力を分類ネットワークや回帰ネットワークへの入力として使用します。

sequence-to-sequence(Seq2Seq)タスクでは、エンコーダは入力シーケンスを受け取り、内部状態(ベクトル)を返します。次に、デコーダがその内部状態を使用して次のシーケンスを予測します。

Transformer アーキテクチャのエンコーダの定義については、Transformer をご覧ください。

詳細については、ML 集中講座の LLM: 大規模言語モデルとはをご覧ください。

エンドポイント

サービスにアクセスできるネットワーク アドレス指定可能な場所(通常は URL)。

自動化

個別にトレーニングされたモデルのコレクション。ここでの予測は平均化または集約されています。多くの場合、アンサンブルは単一モデルよりも優れた予測結果をもたらします。たとえば、ランダム フォレストは、複数のディシジョン ツリーから構築されたアンサンブルです。すべてのディシジョン フォレストがアンサンブルであるとは限りません。

詳細については、機械学習集中講座のランダム フォレストをご覧ください。

エントロピー

情報理論では、確率分布の予測不可能性を説明します。また、エントロピーは、各例に含まれる情報量としても定義されます。分布のエントロピーが最大になるのは、確率変数のすべての値が等しい確率で発生する場合です。

2 つの値「0」と「1」を持つセットのエントロピー(たとえば、バイナリ分類問題のラベル)は、次の式で表されます。

H = -p log p - q log q = -p log p - (1-p) * log (1-p)

ここで

- H はエントロピーです。

- p は「1」の例の割合です。

- q は「0」の例の割合です。q = (1 - p) であることに注意してください。

- log は通常 log2 です。この場合、エントロピー単位はビットです。

たとえば、次のように仮定します。

- 100 個の例に値「1」が含まれている

- 300 個の例に値「0」が含まれている

したがって、エントロピー値は次のようになります。

- p = 0.25

- q = 0.75

- H = (-0.25)log2(0.25) - (0.75)log2(0.75) = 1 例あたり 0.81 ビット

完全にバランスの取れたセット(たとえば、200 個の「0」と 200 個の「1」)のエントロピーは、例あたり 1.0 ビットになります。セットのバランスが崩れるほど、エントロピーは 0.0 に近づきます。

決定木では、エントロピーは情報ゲインの定式化に役立ち、スプリッタが分類決定木の成長中に条件を選択するのに役立ちます。

エントロピーを以下と比較します。

エントロピーは、シャノンのエントロピーと呼ばれることもあります。

詳細については、デシジョン フォレスト コースの数値特徴を使用したバイナリ分類の正確な分割ツールをご覧ください。

環境

強化学習では、エージェントを含む世界であり、エージェントがその世界の状態を観察できるようになっているものです。たとえば、表現された世界は、チェスのようなゲームや、迷路のような物理的な世界などです。エージェントが環境にアクションを適用すると、環境は状態間を遷移します。

エピソード

強化学習では、エージェントが環境を学習するために繰り返す試行のそれぞれ。

エポック

各サンプルが 1 回処理されるように、トレーニング セット全体に対するトレーニング パス全体。

エポックは N/バッチサイズ 回のトレーニング イテレーションを表します。ここで、N は例の総数です。

たとえば、次のように仮定します。

- データセットは 1,000 個の例で構成されています。

- バッチサイズは 50 個のサンプルです。

したがって、1 つのエポックには 20 回の反復が必要です。

1 epoch = (N/batch size) = (1,000 / 50) = 20 iterations

詳細については、ML 集中講座の線形回帰: ハイパーパラメータをご覧ください。

ε-greedy ポリシー

強化学習では、イプシロン確率でランダム ポリシーに従うか、それ以外の場合はグリーディ ポリシーに従うポリシー。たとえば、イプシロンが 0.9 の場合、ポリシーは 90% の確率でランダム ポリシーに従い、10% の確率でグリーディ ポリシーに従います。

エピソードを繰り返すたびに、アルゴリズムはイプシロンの値を減らし、ランダム ポリシーからグリーディー ポリシーに移行します。ポリシーをシフトすることで、エージェントはまず環境をランダムに探索し、次にランダム探索の結果を貪欲に利用します。

機会の平等

モデルが機密属性のすべての値について望ましい結果を平等に予測しているかどうかを評価する公平性指標。つまり、モデルの望ましい結果が陽性クラスである場合、すべてのグループで真陽性率が同じになることが目標となります。

機会の平等は、均等化されたオッズに関連しています。これは、すべてのグループで真陽性率と偽陽性率の両方が同じであることを必要とします。

Glubbdubdrib 大学が、リリパット人とブロブディンナグ人を厳格な数学プログラムに受け入れたとします。リリパットの高校では、数学の授業のカリキュラムが充実しており、生徒のほとんどが大学プログラムの資格を取得しています。ブロブディンナグの高校では数学の授業がまったく提供されていないため、資格のある生徒ははるかに少なくなっています。リリパット人かブロブディンナグ人かに関係なく、資格のある生徒が同じ確率で入学できる場合、国籍(リリパット人またはブロブディンナグ人)に関して「合格」という優先ラベルの機会均等性が満たされます。

たとえば、Glubbdubdrib 大学に 100 人のリリパット人と 100 人のブロブディンナグ人が応募し、次のように入学が決定されるとします。

表 1. Lilliputian の応募者(90% が資格あり)

| リードの精査が完了 | 見込みなし | |

|---|---|---|

| 承認済み | 45 | 3 |

| 不承認 | 45 | 7 |

| 合計 | 90 | 10 |

|

入学が認められた適格な学生の割合: 45/90 = 50% 入学が認められなかった不適格な学生の割合: 7/10 = 70% 入学が認められたリリパットの学生の割合: (45 + 3)/100 = 48% |

||

表 2. Brobdingnagian の応募者(10% が資格あり):

| リードの精査が完了 | 見込みなし | |

|---|---|---|

| 承認済み | 5 | 9 |

| 不承認 | 5 | 81 |

| 合計 | 10 | 90 |

|

入学を許可された資格のある学生の割合: 5/10 = 50% 入学を拒否された資格のない学生の割合: 81/90 = 90% 入学を許可されたブロブディンナグ人の学生の合計割合: (5+9)/100 = 14% |

||

上記の例では、リリパット人とブロブディンナグ人がどちらも 50% の確率で入学できるため、有資格の学生の入学機会の平等が満たされています。

機会均等性は満たされていますが、次の 2 つの公平性指標は満たされていません。

- 人口統計学的パリティ: リリパット人とブロブディンナグ人の大学への入学率が異なる。リリパット人の学生の 48% が入学するのに対し、ブロブディンナグ人の学生の入学率は 14% にすぎない。

- 均等なオッズ: リリパット人とブロブディンナグ人の両方の学生が合格する確率は同じですが、不合格となる確率も同じであるという制約は満たされていません。リリパット人の不合格率は 70% ですが、ブロブディンナグ人の不合格率は 90% です。

詳細については、ML 集中講座の公平性: 機会の平等をご覧ください。

均等オッズ

陽性クラスと陰性クラスの両方に関して、機微な属性のすべての値についてモデルが結果を平等に予測しているかどうかを評価する公平性指標。一方のクラスのみを排他的に評価するのではなく、両方のクラスを評価します。つまり、真陽性率と偽陰性率の両方が、すべてのグループで同じである必要があります。

均等オッズは、単一のクラス(正または負)のエラー率のみに焦点を当てた機会の平等に関連しています。

たとえば、Glubbdubdrib 大学がリリパット人とブロブディンナグ人を厳格な数学プログラムに受け入れているとします。リリパットの高校では、数学の授業のカリキュラムが充実しており、ほとんどの生徒が大学プログラムの資格を取得しています。ブロブディンナグの高校では数学の授業がまったく提供されていないため、資格のある生徒ははるかに少なくなっています。応募者がリリパット人であろうとブロブディンナグ人であろうと、資格があればプログラムに合格する可能性は同じであり、資格がなければ不合格になる可能性は同じである場合、均等なオッズが満たされます。

リリパット人とブロブディンナグ人がそれぞれ 100 人ずつ Glubbdubdrib 大学に入学を申し込んだとします。入学の決定は次のように行われます。

表 3: Lilliputian の応募者(90% が資格あり)

| リードの精査が完了 | 見込みなし | |

|---|---|---|

| 承認済み | 45 | 2 |

| 不承認 | 45 | 8 |

| 合計 | 90 | 10 |

|

入学が許可された資格のある学生の割合: 45/90 = 50% 入学が許可されなかった資格のない学生の割合: 8/10 = 80% 入学が許可されたリリパットの学生の合計割合: (45+2)/100 = 47% |

||

表 4. Brobdingnagian の応募者(10% が資格あり):

| リードの精査が完了 | 見込みなし | |

|---|---|---|

| 承認済み | 5 | 18 |

| 不承認 | 5 | 72 |

| 合計 | 10 | 90 |

|

入学を許可された資格のある学生の割合: 5/10 = 50% 入学を拒否された資格のない学生の割合: 72/90 = 80% 入学を許可された Brobdingnagian 学生の合計割合: (5+18)/100 = 23% |

||

リリパット人とブロブディンナグ人の両方で、合格した学生が合格する確率は 50%、不合格の学生が不合格になる確率は 80% であるため、均等なオッズが満たされています。

等しいオッズは、「Equality of Opportunity in Supervised Learning」で次のように正式に定義されています。「予測子 Ŷ が保護属性 A と結果 Y に関して等しいオッズを満たすのは、Ŷ と A が Y を条件として独立している場合です。」

Estimator

非推奨の TensorFlow API。Estimator ではなく tf.keras を使用します。

evals

主に LLM 評価の略語として使用されます。広義には、evals は、評価のあらゆる形式の略語です。

評価

モデルの品質を測定したり、異なるモデルを比較したりするプロセス。

教師あり機械学習モデルを評価するには、通常、検証セットとテストセットに対してモデルを評価します。LLM の評価では、通常、品質と安全性のより広範な評価が行われます。

完全一致

モデルの出力がグラウンド トゥルースまたは参照テキストと完全に一致するか、一致しないかのいずれかである指標。たとえば、正解が「オレンジ」の場合、完全一致を満たすモデル出力は「オレンジ」のみです。

完全一致では、出力がシーケンス(項目のランク付けされたリスト)であるモデルを評価することもできます。一般に、完全一致では、生成されたランキング リストがグラウンド トゥルースと完全に一致している必要があります。つまり、両方のリストの各項目が同じ順序になっている必要があります。ただし、グラウンド トゥルースが複数の正しいシーケンスで構成されている場合、完全一致では、モデルの出力が正しいシーケンスのいずれかと一致するだけで済みます。

例

特徴の 1 行の値と、場合によってはラベル。教師あり学習の例は、次の 2 つの一般的なカテゴリに分類されます。

- ラベル付きの例は、1 つ以上の特徴とラベルで構成されます。トレーニング中にラベル付きの例が使用されます。

- ラベルなしの例は、1 つ以上の特徴で構成されますが、ラベルはありません。ラベルなしの例は推論時に使用されます。

たとえば、天気予報が学生のテストの点数に与える影響を判断するモデルをトレーニングするとします。ラベル付きの例を 3 つ示します。

| 機能 | ラベル | ||

|---|---|---|---|

| 温度 | 湿度 | 気圧 | テストスコア |

| 15 | 47 | 998 | 良い |

| 19 | 34 | 1020 | 非常に良い |

| 18 | 92 | 1012 | 悪い |

ラベルなしの例を 3 つ示します。

| 温度 | 湿度 | 気圧 | |

|---|---|---|---|

| 12 | 62 | 1014 | |

| 21 | 47 | 1017 | |

| 19 | 41 | 1021 |

通常、データセットの行は、例の未加工のソースです。つまり、通常、例はデータセット内の列のサブセットで構成されます。また、例の特徴には、特徴交差などの合成特徴を含めることもできます。

詳細については、機械学習入門コースの教師あり学習をご覧ください。

経験再生

強化学習では、トレーニング データの時間相関を減らすために使用される DQN 手法。エージェントは、状態遷移を再生バッファに保存し、再生バッファから遷移をサンプリングしてトレーニング データを作成します。

実験者のバイアス

確証バイアスをご覧ください。

勾配爆発問題

ディープ ニューラル ネットワーク(特に再帰型ニューラル ネットワーク)の勾配が驚くほど急峻(高い)になる傾向。急な勾配は、多くの場合、ディープ ニューラル ネットワーク内の各ノードの重みに非常に大きな更新を引き起こします。

勾配爆発問題が発生したモデルは、トレーニングが困難になるか、不可能になります。グラデーション クリッピングを使用すると、この問題を軽減できます。

勾配消失問題と比較してください。

Extreme Summarization(xsum)

単一のドキュメントを要約する LLM の能力を評価するためのデータセット。データセットの各エントリは次の要素で構成されます。

- 英国放送協会(BBC)が作成したドキュメント。

- そのドキュメントの 1 文の要約。

詳しくは、詳細ではなく要約だけを教えてください。Topic-Aware Convolutional Neural Networks for Extreme Summarization。

F

F1

適合率と再現率の両方に依存する「ロールアップ」2 値分類指標。式は次のとおりです。

事実性

ML の世界では、出力が現実に基づいているモデルを表すプロパティ。事実性は指標ではなくコンセプトです。たとえば、次のようなプロンプトを大規模言語モデルに送信するとします。

食塩の化学式は何ですか?

事実性を最適化するモデルは次のように応答します。

NaCl

すべてのモデルは事実に基づいていなければならないと考えるのは当然です。ただし、次のようなプロンプトでは、生成 AI モデルは事実性ではなく創造性を最適化する必要があります。

宇宙飛行士とイモムシについての五行詩を教えて。

結果として得られるリメリックは、現実に基づいたものにはならないでしょう。

グラウンディングと比較してください。

公平性に関する制約

1 つ以上の公平性の定義が満たされるように、アルゴリズムに制約を適用すること。公平性制約の例:公平性指標

測定可能な「公平性」の数学的定義。よく使用される公平性指標には次のようなものがあります。

公平性に関する指標の多くは相互に排他的です。公平性に関する指標の不整合をご覧ください。

偽陰性(FN)

モデルが陰性クラスを誤って予測した例。たとえば、特定のメール メッセージが迷惑メールではない(ネガティブ クラス)と予測されたが、そのメール メッセージは実際には迷惑メールである場合などです。

偽陰性率

モデルが誤って陰性クラスを予測した実際の陽性例の割合。次の式は、偽陰性率を計算します。

詳細については、ML 集中講座のしきい値と混同行列をご覧ください。

偽陽性(FP)

モデルが陽性クラスを誤って予測した例。たとえば、特定のメール メッセージがスパム(ポジティブ クラス)であるとモデルが予測したが、そのメール メッセージは実際にはスパムではない。

詳細については、ML 集中講座のしきい値と混同行列をご覧ください。

偽陽性率(FPR)

モデルが陽性クラスを誤って予測した実際の陰性例の割合。次の式は、偽陽性率を計算します。

偽陽性率は、ROC 曲線の x 軸です。

詳細については、ML 集中講座の分類: ROC と AUC をご覧ください。

急速な減衰

LLM のパフォーマンスを向上させるためのトレーニング手法。高速減衰では、トレーニング中に学習率を急速に減衰させます。この戦略は、モデルがトレーニング データに過剰適合するのを防ぎ、一般化を改善するのに役立ちます。

機能

ML モデルへの入力変数。例は 1 つ以上の特徴で構成されます。たとえば、天気予報が学生のテストの点数に与える影響を判断するモデルをトレーニングするとします。次の表に、3 つの特徴と 1 つのラベルを含む 3 つの例を示します。

| 機能 | ラベル | ||

|---|---|---|---|

| 温度 | 湿度 | 気圧 | テストスコア |

| 15 | 47 | 998 | 92 |

| 19 | 34 | 1020 | 84 |

| 18 | 92 | 1012 | 87 |

ラベルとのコントラスト。

詳細については、機械学習入門コースの教師あり学習をご覧ください。

特徴クロス

カテゴリ特徴量またはバケット化された特徴量を「クロス」することで形成される合成特徴量。

たとえば、温度を次の 4 つのバケットのいずれかで表す「気分予測」モデルについて考えてみましょう。

freezingchillytemperatewarm

風速を次の 3 つのバケットのいずれかで表します。

stilllightwindy

特徴量クロスがない場合、線形モデルは上記の 7 つのバケットそれぞれで個別にトレーニングされます。したがって、モデルは、たとえば windy のトレーニングとは独立して、たとえば freezing でトレーニングされます。

または、気温と風速の特徴クロスを作成することもできます。この合成特徴には、次の 12 個の可能な値があります。

freezing-stillfreezing-lightfreezing-windychilly-stillchilly-lightchilly-windytemperate-stilltemperate-lighttemperate-windywarm-stillwarm-lightwarm-windy

特徴量クロスにより、モデルは freezing-windy の日と freezing-still の日の気分を学習できます。

それぞれに多数のバケットがある 2 つの特徴から合成特徴を作成すると、結果として得られる特徴クロスには膨大な数の組み合わせが生成されます。たとえば、ある特徴に 1,000 個のバケットがあり、別の特徴に 2,000 個のバケットがある場合、結果の特徴の交差には 2,000,000 個のバケットがあります。

正式には、クロスはデカルト積です。

特徴の交差は主に線形モデルで使用され、ニューラル ネットワークで使用されることはほとんどありません。

詳細については、ML 集中講座のカテゴリデータ: 特徴の交差をご覧ください。

2つのステップが含まれます

次の手順を含むプロセス。

- モデルのトレーニングに役立つ可能性のある特徴を特定する。

- データセットの元データを、それらの特徴量の効率的なバージョンに変換します。

たとえば、temperature が便利な機能であると判断できます。次に、バケット化を試して、モデルがさまざまな temperature 範囲から学習できる内容を最適化します。

特徴量エンジニアリングは、特徴量抽出または特徴量化と呼ばれることもあります。

詳細については、ML 集中講座の数値データ: モデルが特徴ベクトルを使用してデータを読み込む方法をご覧ください。

特徴抽出

次のいずれかの定義を持つオーバーロードされた用語。

- 別のモデルで入力として使用するために、教師なしモデルまたは事前トレーニング済みモデル(ニューラル ネットワークの隠れ層の値など)によって計算された中間特徴表現を取得します。

- 特徴量エンジニアリングと同義。

特徴の重要度

変数の重要度と同義。

機能セット

機械学習モデルがトレーニングに使用する特徴のグループ。たとえば、住宅価格を予測するモデルの単純な特徴セットは、郵便番号、物件の広さ、物件の状態で構成される場合があります。

機能仕様

tf.Example プロトコル バッファから 特徴データを抽出するために必要な情報を記述します。tf.Example プロトコル バッファはデータのコンテナにすぎないため、次の指定が必要です。

- 抽出するデータ(つまり、特徴のキー)

- データ型(float や int など)

- 長さ(固定または可変)

特徴ベクトル

例を構成する特徴値の配列。特徴ベクトルは、トレーニング時と推論時に入力されます。たとえば、2 つの離散特徴を持つモデルの特徴ベクトルは次のようになります。

[0.92, 0.56]

各サンプルは特徴ベクトルに異なる値を指定するため、次のサンプルの特徴ベクトルは次のようになります。

[0.73, 0.49]

特徴量エンジニアリングでは、特徴ベクトルで特徴をどのように表現するかを決定します。たとえば、5 つの可能な値を持つバイナリ カテゴリ特徴は、ワンホット エンコーディングで表すことができます。この場合、特定の例のフィーチャー ベクトルの部分は、次のように 4 つのゼロと 3 番目の位置の 1 つの 1.0 で構成されます。

[0.0, 0.0, 1.0, 0.0, 0.0]

別の例として、モデルが次の 3 つの特徴で構成されているとします。

- ワンホット エンコーディングで表される 5 つの可能な値を持つバイナリ カテゴリ特徴。例:

[0.0, 1.0, 0.0, 0.0, 0.0] - ワンホット エンコーディングで表される 3 つの可能な値を持つ別のバイナリ カテゴリ特徴。例:

[0.0, 0.0, 1.0] - 浮動小数点特徴。例:

8.3。

この場合、各サンプルの特徴ベクトルは 9 つの値で表されます。上記のリストの例の値が指定されている場合、特徴ベクトルは次のようになります。

0.0 1.0 0.0 0.0 0.0 0.0 0.0 1.0 8.3

詳細については、ML 集中講座の数値データ: モデルが特徴ベクトルを使用してデータを読み込む方法をご覧ください。

特徴量化

ドキュメントや動画などの入力ソースから特徴を抽出し、それらの特徴を特徴ベクトルにマッピングするプロセス。

一部の ML エキスパートは、特徴化を特徴量エンジニアリングまたは特徴抽出の同義語として使用します。

フェデレーション ラーニング

スマートフォンなどのデバイスに分散されている例を使用して ML モデルをトレーニングする分散型 ML の手法。フェデレーション ラーニングでは、デバイスのサブセットが中央のコーディネート サーバーから現在のモデルをダウンロードします。デバイスは、デバイスに保存されている例を使用して、モデルの改善を行います。デバイスは、モデルの改善(トレーニング サンプルは除く)をコーディネート サーバーにアップロードします。コーディネート サーバーでは、他の更新と集約され、改善されたグローバル モデルが生成されます。集約後、デバイスで計算されたモデルの更新は不要になるため、破棄できます。

トレーニング例はアップロードされないため、フェデレーション ラーニングは、データ収集の焦点とデータ最小化のプライバシー原則に準拠しています。

詳しくは、フェデレーション ラーニングのコミック(コミックです)をご覧ください。

フィードバック ループ

ML において、モデルの予測が同じモデルまたは別のモデルのトレーニング データに影響を与える状況。たとえば、映画をおすすめするモデルは、ユーザーが視聴する映画に影響を与え、その結果、後続の映画おすすめモデルに影響を与えます。

詳細については、ML 集中講座の本番環境の ML システム: 質問をご覧ください。

フィードフォワード ニューラル ネットワーク(FFN)

循環接続や再帰接続のないニューラル ネットワーク。たとえば、従来のディープ ニューラル ネットワークはフィードフォワード ニューラル ネットワークです。循環型の回帰型ニューラル ネットワークとは対照的です。

少数ショット学習

オブジェクト分類でよく使用される ML アプローチ。少数のトレーニング サンプルから効果的な分類モデルをトレーニングするように設計されています。

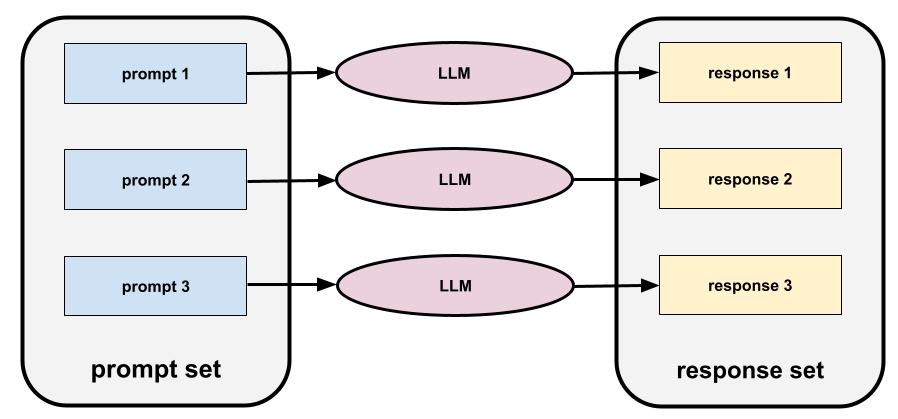

少数ショット プロンプト

大規模言語モデルにどのように回答すればよいかを示す例を複数(少数)含むプロンプト。たとえば、次の長いプロンプトには、大規模言語モデルにクエリへの回答方法を示す 2 つの例が含まれています。

| 1 つのプロンプトの構成要素 | メモ |

|---|---|

| 指定された国の公式通貨は何ですか? | LLM に回答させたい質問。 |

| フランス: EUR | 例 1: |

| 英国: GBP | 別の例。 |

| インド: | 実際のクエリ。 |

一般的に、少数ショット プロンプトは、ゼロショット プロンプトやワンショット プロンプトよりも望ましい結果が得られます。ただし、少数ショット プロンプトでは長いプロンプトが必要になります。

少数ショット プロンプトは、プロンプト ベースの学習に適用される少数ショット学習の一種です。

詳細については、ML 集中講座のプロンプト エンジニアリングをご覧ください。

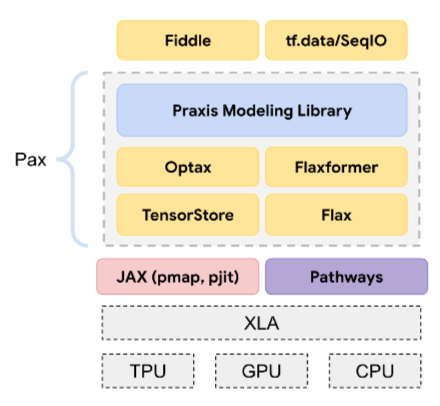

フィドル

侵入的なコードやインフラストラクチャを使用せずに、関数とクラスの値を設定する Python ファーストの構成ライブラリ。Pax などの ML コードベースの場合、これらの関数とクラスはモデルとトレーニング ハイパーパラメータを表します。

Fiddle は、ML コードベースが通常次のように分割されることを前提としています。

- レイヤとオプティマイザーを定義するライブラリ コード。

- ライブラリを呼び出してすべてを接続するデータセットの「接着剤」コード。

Fiddle は、グルーコードの呼び出し構造を評価されていない可変形式でキャプチャします。

ファインチューニング

パラメータを特定のユースケースに合わせて最適化するために、事前トレーニングされたモデルに対してさらに行うタスク固有のトレーニングです。たとえば、一部の大規模言語モデルの完全なトレーニング シーケンスは次のようになります。

- 事前トレーニング: 英語の Wikipedia ページ全体など、大規模な一般的なデータセットで大規模言語モデルをトレーニングします。

- ファイン チューニング: 医療に関する質問への回答など、特定のタスクを実行するように事前トレーニング済みモデルをトレーニングします。通常、ファインチューニングでは、特定のタスクに焦点を当てた数百または数千の例を使用します。

別の例として、大規模な画像モデルの完全なトレーニング シーケンスは次のようになります。

- 事前トレーニング: Wikimedia Commons のすべての画像など、大規模な一般的な画像データセットで大規模な画像モデルをトレーニングします。

- ファインチューニング: シャチの画像を生成するなど、特定のタスクを実行するように事前トレーニング済みモデルをトレーニングします。

ファインチューニングでは、次の戦略を任意に組み合わせることができます。

- 事前トレーニング済みモデルの既存のパラメータのすべてを変更する。これは「フル ファインチューニング」と呼ばれることもあります。

- 事前トレーニング済みモデルの既存のパラメータの一部(通常は出力レイヤに最も近いレイヤ)のみを変更し、他の既存のパラメータ(通常は入力レイヤに最も近いレイヤ)は変更しない。パラメータ効率チューニングをご覧ください。

- 通常、出力レイヤに最も近い既存のレイヤの上にレイヤを追加します。

ファインチューニングは、転移学習の一種です。そのため、ファインチューニングでは、事前トレーニング済みモデルのトレーニングに使用されたものとは異なる損失関数やモデルタイプが使用されることがあります。たとえば、事前トレーニング済みの大規模な画像モデルをファインチューニングして、入力画像内の鳥の数を返す回帰モデルを作成できます。

ファインチューニングと次の用語を比較対照します。

詳細については、ML 集中講座のファインチューニングをご覧ください。

Flash モデル

速度と低レイテンシ向けに最適化された、比較的小さな Gemini モデルのファミリー。Flash モデルは、迅速なレスポンスと高スループットが重要な幅広いアプリケーション向けに設計されています。

Flax

JAX 上に構築されたディープ ラーニング用の高パフォーマンスのオープンソース ライブラリ。Flax には、ニューラル ネットワークのトレーニング用の関数と、パフォーマンスを評価するためのメソッドが用意されています。

Flaxformer

Flax 上に構築されたオープンソースの Transformer ライブラリ。主に自然言語処理とマルチモーダル研究用に設計されています。

forget gate

セルを通過する情報の流れを調整する Long Short-Term Memory セルの部分。忘却ゲートは、セル状態から破棄する情報を決定することでコンテキストを維持します。

基盤モデル

膨大で多様なトレーニング セットでトレーニングされた、非常に大規模な事前トレーニング済みモデル。基盤モデルは、次の両方を行うことができます。

- 幅広いリクエストに適切に対応する。

- 追加のファインチューニングやその他のカスタマイズのベースモデルとして機能します。

つまり、基盤モデルは一般的な意味ですでに非常に有能ですが、特定のタスクに対してさらに有用になるようにカスタマイズできます。

成功の割合

ML モデルの生成されたテキストを評価するための指標。成功の割合は、生成されたテキスト出力の総数で「成功」した生成テキスト出力の数を割った値です。たとえば、大規模言語モデルが 10 個のコードブロックを生成し、そのうち 5 個が成功した場合、成功率は 50% になります。

成功率の指標は統計全体で広く使用されていますが、ML では主にコード生成や数学の問題などの検証可能なタスクの測定に使用されます。

full softmax

softmax と同義。

候補サンプリングと比較してください。

詳細については、ML 集中講座のニューラル ネットワーク: 多クラス分類をご覧ください。

全結合レイヤ

各ノードが後続の隠れ層のすべてのノードに接続されている隠れ層。

関数変換

関数を入力として受け取り、変換された関数を出力として返す関数。JAX は関数変換を使用します。

G

GAN

敵対的生成ネットワークの略語。

Gemini

Google の最先端 AI で構成されたエコシステム。このエコシステムの要素は次のとおりです。

- さまざまな Gemini モデル。

- Gemini モデルのインタラクティブな会話型インターフェース。ユーザーがプロンプトを入力すると、Gemini がそのプロンプトに応答します。

- さまざまな Gemini API。

- Gemini モデルに基づくさまざまなビジネス プロダクト(Gemini for Google Cloud など)。

Gemini モデル

Google の最先端の Transformer ベースのマルチモーダル モデル。Gemini モデルは、エージェントと統合するように特別に設計されています。

ユーザーは、対話型ダイアログ インターフェースや SDK など、さまざまな方法で Gemini モデルを操作できます。

Gemma

Gemini モデルの作成に使用されたものと同じ研究とテクノロジーに基づいて構築された、軽量なオープンモデルのファミリーです。Gemma モデルは複数あり、それぞれにビジョン、コード、指示の実行などの異なる機能が用意されています。詳しくは、Gemma をご覧ください。

GenAI または genAI

生成 AI の略語。

一般化

新しい未知のデータに対して正しい予測を行えるモデルの能力。汎化性能が高いモデルは、過学習しているモデルとは正反対の状態です。

詳細については、ML 集中講座の汎化をご覧ください。

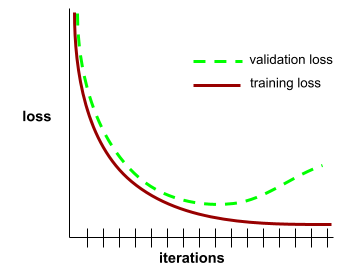

汎化曲線

トレーニング損失と検証損失の両方を反復回数の関数としてプロットします。

一般化曲線は、過適合の可能性を検出するのに役立ちます。たとえば、次の汎化曲線は、検証損失が最終的にトレーニング損失よりも大幅に高くなるため、過学習を示しています。

詳細については、ML 集中講座の汎化をご覧ください。

一般化線形モデル

最小二乗回帰モデル(ガウス ノイズに基づく)を、ポアソン ノイズやカテゴリカル ノイズなどの他のタイプのノイズに基づく他のタイプのモデルに一般化したもの。一般化線形モデルの例を次に示します。

- ロジスティック回帰

- マルチクラス回帰

- 最小二乗回帰

一般化線形モデルのパラメータは、凸最適化によって見つけることができます。

一般化線形モデルには次の特性があります。

- 最適な最小二乗回帰モデルの平均予測は、トレーニング データの平均ラベルと等しくなります。

- 最適なロジスティック回帰モデルによって予測される平均確率は、トレーニング データの平均ラベルと等しくなります。

一般化線形モデルの能力は、その特徴によって制限されます。ディープモデルとは異なり、一般化線形モデルは「新しい特徴を学習」できません。

生成されたテキスト

一般に、ML モデルが出力するテキスト。大規模言語モデルを評価する際、生成されたテキストを参照テキストと比較する指標があります。たとえば、ML モデルがフランス語からオランダ語にどれだけ効果的に翻訳できるかを判断しようとしているとします。この例の場合は、次のようになります。

- 生成されたテキストは、ML モデルが出力するオランダ語の翻訳です。

- 参照テキストは、人間の翻訳者(またはソフトウェア)が作成したオランダ語の翻訳です。

一部の評価戦略では、参照テキストは使用されません。

敵対的生成ネットワーク(GAN)

生成器がデータを作成し、識別器が作成されたデータが有効か無効かを判断する、新しいデータを作成するシステム。

詳細については、敵対的生成ネットワーク コースをご覧ください。

生成 AI

正式な定義のない、変革的な新しい分野です。ただし、ほとんどの専門家は、生成 AI モデルが次のすべての条件を満たすコンテンツを作成(「生成」)できることに同意しています。

- 複雑

- 一貫性のある

- オリジナル

生成 AI の例:

- 大規模言語モデル。高度なオリジナルのテキストを生成し、質問に答えることができます。

- 独自の画像を生成できる画像生成モデル。

- オリジナルの音楽を作曲したり、リアルな音声を生成したりできる音声と音楽の生成モデル。

- オリジナル動画を生成できる動画生成モデル。

LSTM や RNN などの以前のテクノロジーでも、オリジナルで一貫性のあるコンテンツを生成できます。これらの初期のテクノロジーを生成 AI と見なす専門家もいれば、真の生成 AI には、これらの初期のテクノロジーが生成できるよりも複雑な出力が必要だと考える専門家もいます。

予測 ML との対比。

生成モデル

実際には、次のいずれかを行うモデル。

- トレーニング データセットから新しい例を作成(生成)します。たとえば、詩のデータセットでトレーニングした生成モデルは、詩を作成できます。敵対的生成ネットワークの生成器部分は、このカテゴリに分類されます。

- 新しい例がトレーニング セットから取得されたか、トレーニング セットを作成したのと同じメカニズムで作成された確率を判断します。たとえば、英語の文で構成されるデータセットでトレーニングした後、生成モデルは新しい入力が有効な英語の文である確率を判断できます。

生成モデルは、理論的にはデータセット内の例や特定の特徴の分布を識別できます。具体的には、次のことが求められます。

p(examples)

教師なし学習モデルは生成モデルです。

識別モデルと比較してください。

ジェネレータ

新しい例を作成する敵対的生成ネットワーク内のサブシステム。

識別モデルも参照してください。

ジニ不純度

エントロピーに似た指標。スプリッタは、ジニ不純度またはエントロピーから導出された値を使用して、分類の決定木の条件を構成します。情報ゲインはエントロピーから導出されます。ジニ不純度から導出された指標に、普遍的に受け入れられている同等の用語はありません。ただし、この名前のない指標は情報ゲインと同じくらい重要です。

ジニ不純度は、ジニ係数または単にジニとも呼ばれます。

ゴールデン データセット

グラウンド トゥルースをキャプチャする手動でキュレーションされたデータのセット。チームは 1 つ以上のゴールデン データセットを使用して、モデルの品質を評価できます。

一部のゴールデン データセットは、グラウンド トゥルースのさまざまなサブドメインをキャプチャします。たとえば、画像分類用のゴールデン データセットでは、照明条件と画像解像度をキャプチャできます。

ゴールデン レスポンス

レスポンスが良好であることがわかっている。たとえば、次のようなプロンプトがあるとします。

2 + 2

理想的なレスポンスは次のとおりです。

4

Google AI Studio

Google の大規模言語モデルを使用してアプリケーションをテストし、構築するためのユーザー フレンドリーなインターフェースを提供する Google ツール。詳細については、Google AI Studio のホームページをご覧ください。

GPT(Generative Pre-trained Transformer)

OpenAI が開発した Transformer ベースの大規模言語モデルのファミリー。

GPT バリアントは、次のような複数のモダリティに適用できます。

- 画像生成(ImageGPT など)

- テキスト画像変換(DALL-E など)。

グラデーション

すべての独立変数に関する偏導関数のベクトル。ML では、勾配はモデル関数の偏導関数のベクトルです。勾配は最も急な上昇方向を指し示しています。

勾配の累積

バックプロパゲーション手法。パラメータを反復ごとに 1 回ではなく、エポックごとに 1 回だけ更新します。各ミニバッチの処理後、勾配の累積では勾配の実行合計が更新されます。次に、エポックの最後のミニバッチを処理した後、システムはすべての勾配変化の合計に基づいてパラメータを更新します。

グラデーションの累積は、トレーニングに使用可能なメモリ量と比較してバッチサイズが非常に大きい場合に便利です。メモリが問題になる場合は、バッチサイズを小さくするのが自然な傾向です。ただし、通常のバックプロパゲーションでバッチサイズを小さくすると、パラメータ更新の回数が増えます。グラデーションの累積により、モデルはメモリの問題を回避しながら効率的にトレーニングできます。

勾配ブースト(ディシジョン)ツリー(GBT)

次のようなデシジョン フォレストの一種。

- トレーニングは、グラデーション ブースティングに依存しています。

- 弱いモデルはディシジョン ツリーです。

詳細については、意思決定フォレスト コースの勾配ブースティング決定木をご覧ください。

勾配ブースティング

弱いモデルをトレーニングして、強いモデルの品質を反復的に改善(損失を削減)するトレーニング アルゴリズム。たとえば、弱いモデルは線形モデルや小さなディシジョン ツリー モデルです。強いモデルは、以前にトレーニングされた弱いモデルの合計になります。

最も単純な形式のグラデーション ブースティングでは、各イテレーションで、強力なモデルの損失勾配を予測するように弱いモデルがトレーニングされます。次に、勾配降下法と同様に、予測された勾配を減算して、強いモデルの出力を更新します。

ここで

- $F_{0}$ は、開始時の強力なモデルです。

- $F_{i+1}$ は次の強力なモデルです。

- $F_{i}$ は現在の強力なモデルです。

- $\xi$ は 0.0 ~ 1.0 の値で、収縮率と呼ばれます。これは、勾配降下法の学習率に類似しています。

- $f_{i}$ は、$F_{i}$ の損失勾配を予測するようにトレーニングされた弱いモデルです。

勾配ブースティングの最新のバリエーションでは、損失の 2 次導関数(ヘシアン)も計算に含まれます。

ディシジョン ツリーは、勾配ブースティングで弱いモデルとしてよく使用されます。勾配ブースト(ディシジョン)ツリーをご覧ください。

勾配クリッピング

勾配降下法を使用してモデルをトレーニングする際に、勾配の最大値を人工的に制限(クリッピング)することで、勾配爆発問題を軽減するために一般的に使用されるメカニズム。

勾配降下法

損失を最小限に抑えるための数学的手法。勾配降下法では、重みとバイアスを繰り返し調整し、損失を最小限に抑える最適な組み合わせを徐々に見つけます。

勾配降下法は、機械学習よりもはるかに古いものです。

詳細については、機械学習集中講座の線形回帰: 勾配降下法をご覧ください。

グラフ

TensorFlow の計算仕様。グラフ内のノードはオペレーションを表します。エッジは有向であり、オペレーションの結果(Tensor)を別のオペレーションのオペランドとして渡すことを表します。TensorBoard を使用してグラフを可視化します。

グラフ実行

プログラムが最初にグラフを構築し、そのグラフの全部または一部を実行する TensorFlow プログラミング環境。グラフ実行は、TensorFlow 1.x のデフォルトの実行モードです。

eager 実行と比較してください。

貪欲なポリシー

強化学習では、期待される収益が最も高いアクションを常に選択するポリシー。

根拠性

出力が特定のソース資料に基づいている(「グラウンディング」されている)モデルのプロパティ。たとえば、物理学の教科書全体を 大規模言語モデルの入力(「コンテキスト」)として提供するとします。次に、その大規模言語モデルに物理学の問題をプロンプトします。モデルのレスポンスにその教科書の情報が反映されている場合、そのモデルはその教科書に基づいてグラウンディングされています。グラウンディングされたモデルが常に事実に基づいたモデルであるとは限りません。たとえば、入力された物理学の教科書に誤りがある可能性があります。

グラウンド トゥルース

現実。

実際に起こったこと。

たとえば、大学 1 年生の学生が 6 年以内に卒業するかどうかを予測するバイナリ分類モデルを考えてみましょう。このモデルのグラウンド トゥルースは、その生徒が 6 年以内に実際に卒業したかどうかです。

グループ帰属バイアス

個人に当てはまることが、そのグループの全員に当てはまると仮定する。データ収集に便宜的サンプリングを使用すると、グループ アトリビューション バイアスの影響が拡大する可能性があります。代表的でないサンプルでは、現実を反映していない帰属が行われる可能性があります。

自分が属していないグループに対する均一性のバイアスと所属グループのバイアスもご覧ください。詳細については、ML 集中講座の公平性: 偏りの種類もご覧ください。

H

ハルシネーション

現実世界に関する主張をしているように見えるが、実際には誤った出力を生成 AI モデルが生成すること。たとえば、バラク オバマが 1865 年に死亡したと主張する生成 AI モデルは、ハルシネーションを起こしています。

ハッシュ ; ハッシュ化

機械学習で、カテゴリデータをバケット化するメカニズム。特に、カテゴリの数は多いが、データセットに実際に表示されるカテゴリの数が比較的少ない場合に有効です。

たとえば、地球には約 73,000 種類の樹木が生息しています。73,000 種類の樹木を 73,000 個の個別のカテゴリ バケットで表すことができます。また、データセットに実際に現れる樹種が 200 種類しかない場合は、ハッシュ関数を使用して樹種を 500 個のバケットに分割できます。

1 つのバケットに複数の樹種を含めることができます。たとえば、ハッシュ化によって、遺伝的に異なる 2 つの種であるバオバブと紅葉が同じバケットに配置される可能性があります。いずれにしても、ハッシュ化は、大規模なカテゴリカル セットを選択した数のバケットにマッピングする優れた方法です。ハッシュ化では、多数の可能な値を持つカテゴリ特徴を、値を決定論的な方法でグループ化することで、はるかに少ない数の値に変換します。

詳細については、ML 集中講座のカテゴリデータ: 語彙とワンホット エンコードをご覧ください。

ヒューリスティック

問題に対してシンプルかつ迅速に実行できる解決策。例:「ヒューリスティクスでは 86% の精度を達成しました。ディープ ニューラル ネットワークに切り替えると、精度は 98% に向上しました。」

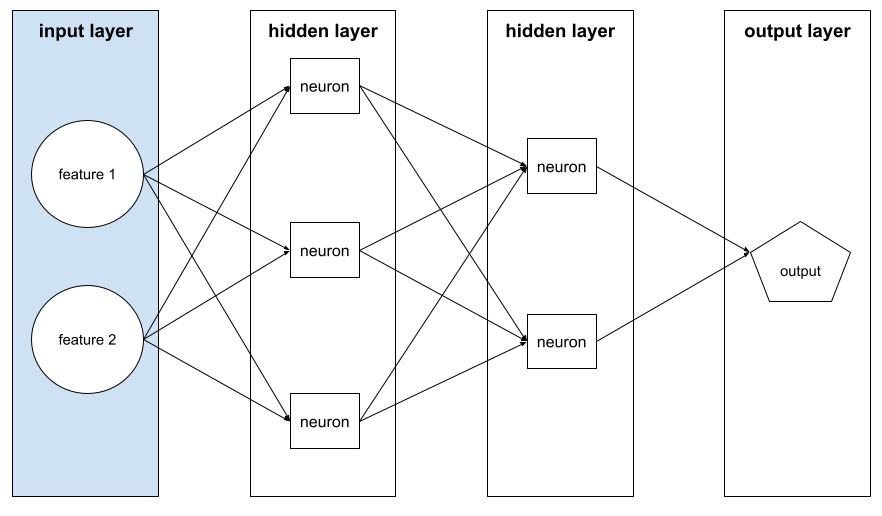

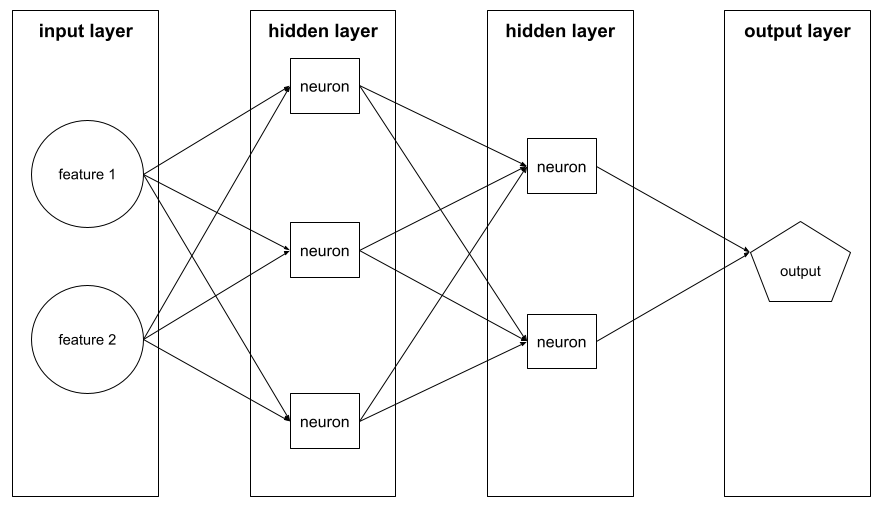

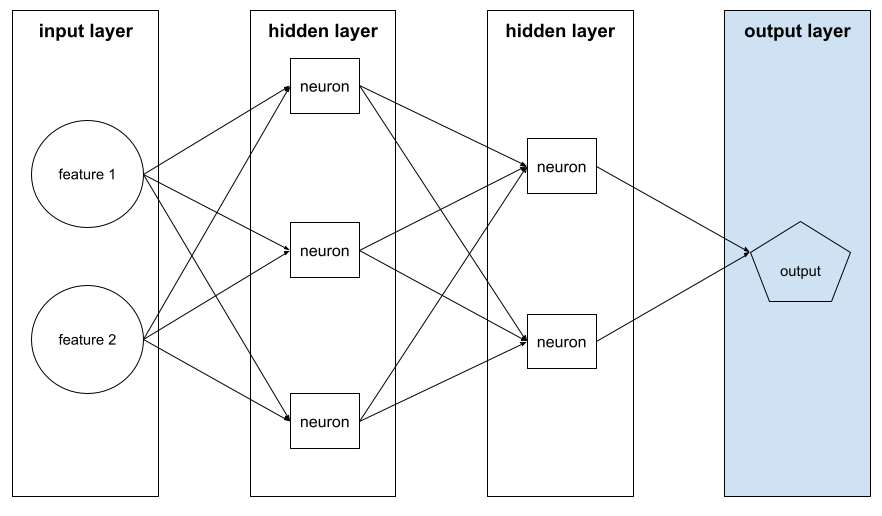

隠れ層

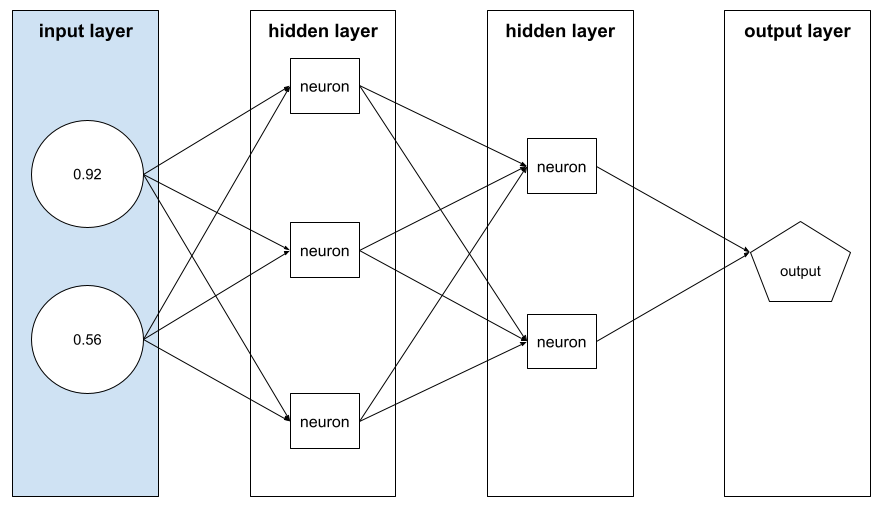

入力層(特徴)と出力層(予測)の間にあるニューラル ネットワークのレイヤ。各隠れ層は 1 つ以上のニューロンで構成されます。たとえば、次のニューラル ネットワークには 2 つの隠れ層が含まれています。1 つ目は 3 つのニューロン、2 つ目は 2 つのニューロンです。

ディープ ニューラル ネットワークには複数の隠れ層が含まれています。たとえば、上の図は、モデルに 2 つの隠れ層が含まれているため、ディープ ニューラル ネットワークです。

詳細については、ML 集中講座のニューラル ネットワーク: ノードと隠れ層をご覧ください。

階層型クラスタリング

クラスタのツリーを作成するクラスタリング アルゴリズムのカテゴリ。階層型クラスタリングは、植物分類などの階層データに適しています。階層型クラスタリング アルゴリズムには次の 2 種類があります。

- 凝集型クラスタリングでは、まずすべての例を独自のクラスタに割り当て、最も近いクラスタを繰り返し統合して階層ツリーを作成します。

- 分割型クラスタリングでは、まずすべての例を 1 つのクラスタにグループ化し、次にクラスタを階層ツリーに繰り返し分割します。

重心ベースのクラスタリングと比較してください。

詳細については、クラスタリング コースのクラスタリング アルゴリズムをご覧ください。

ヒルクライム

ML モデルの改善が止まる(「丘の頂上に達する」)まで、ML モデルを反復的に改善(「丘を登る」)するアルゴリズム。アルゴリズムの一般的な形式は次のとおりです。

- 開始モデルを構築します。

- トレーニングまたはファインチューニングの方法を少し調整して、新しい候補モデルを作成します。これには、わずかに異なるトレーニング セットや異なるハイパーパラメータを使用することが含まれる場合があります。

- 新しい候補モデルを評価し、次のいずれかの操作を行います。

- 候補モデルが開始モデルよりも優れている場合、その候補モデルが新しい開始モデルになります。この場合は、手順 1、2、3 を繰り返します。

- どのモデルも開始モデルよりも優れていない場合は、丘の頂上に達したため、反復を停止する必要があります。

ハイパーパラメータ調整のガイダンスについては、ディープ ラーニング チューニング プレイブックをご覧ください。特徴量エンジニアリングのガイダンスについては、ML 集中講座のデータ モジュールをご覧ください。

ヒンジ損失

分類用の損失関数のファミリー。各トレーニング例から可能な限り離れた決定境界を見つけるように設計されており、例と境界の間のマージンを最大化します。KSVM はヒンジ損失(または 2 乗ヒンジ損失などの関連関数)を使用します。バイナリ分類の場合、ヒンジ損失関数は次のように定義されます。

ここで、y は -1 または +1 の真のラベル、y' は分類モデルの未加工の出力です。

したがって、ヒンジ損失と(y * y')のプロットは次のようになります。

過去のバイアス

すでに世の中に存在し、データセットに組み込まれているバイアスの一種。このようなバイアスは、既存の文化的ステレオタイプ、人口統計上の不平等、特定の社会集団に対する偏見を反映する傾向があります。

たとえば、2 つの異なるコミュニティの地元の銀行から 1980 年代の過去のローン不履行データでトレーニングされた、ローン申請者がローンを不履行にするかどうかを予測する分類モデルを考えてみましょう。過去にコミュニティ A の申請者がコミュニティ B の申請者よりも 6 倍多くローンの支払いを滞納していた場合、モデルは過去のバイアスを学習し、コミュニティ A のローンの承認率が低くなる可能性があります。たとえ、コミュニティ A の滞納率が高かった過去の状況がもはや関連性がなくなったとしてもです。

詳細については、ML 集中講座の公平性: 偏りの種類をご覧ください。

ホールドアウト データ

トレーニング中に意図的に使用されなかった(「ホールドアウト」された)例。検証データセットとテストデータセットは、ホールドアウト データの例です。ホールドアウト データは、モデルがトレーニングに使用したデータ以外のデータに一般化する能力を評価するのに役立ちます。ホールドアウト セットの損失は、トレーニング セットの損失よりも、未知のデータセットの損失をより正確に推定できます。

ホスト

アクセラレータ チップ(GPU または TPU)で ML モデルをトレーニングする場合、次の両方を制御するシステムの部分:

- コードの全体的なフロー。

- 入力パイプラインの抽出と変換。

ホストは通常、アクセラレータ チップではなく CPU で実行されます。デバイスは、アクセラレータ チップ上のテンソルを操作します。

人間による評価

人が ML モデルの出力の品質を判断するプロセス。たとえば、バイリンガルの人が ML 翻訳モデルの品質を判断するなど。人間による評価は、正解が 1 つではないモデルを評価する際に特に役立ちます。

自動評価と自動評価ツールによる評価と比較してください。

人間参加型(HITL)

次のいずれかを意味する可能性のある、曖昧な定義のイディオム。

- 生成 AI の出力を批判的または懐疑的に見るポリシー。

- モデルの動作を人間が形成、評価、改善するための戦略またはシステム。人間参加型にすることで、AI は機械知能と人間知能の両方のメリットを享受できます。たとえば、AI がコードを生成し、ソフトウェア エンジニアがそれをレビューするシステムは、人間がループに関与するシステムです。

ハイパーパラメータ

モデルのトレーニングを連続して実行する際に、ユーザーまたはハイパーパラメータ チューニング サービス(Vizier など)が調整する変数。たとえば、学習率はハイパーパラメータです。1 回のトレーニング セッションの前に学習率を 0.01 に設定できます。0.01 が高すぎると判断した場合は、次のトレーニング セッションの学習率を 0.003 に設定します。

一方、パラメータは、モデルがトレーニング中に学習するさまざまな重みとバイアスです。

詳細については、ML 集中講座の線形回帰: ハイパーパラメータをご覧ください。

超平面

空間を 2 つのサブスペースに分割する境界。たとえば、2 次元では直線が超平面であり、3 次元では平面が超平面です。通常、機械学習では、超平面は高次元空間を分離する境界です。カーネル サポート ベクター マシンは、超平面を使用して正のクラスと負のクラスを分離します。多くの場合、非常に高次元の空間で分離します。

I

i.i.d.

独立同分布の略語。

画像認識

画像内のオブジェクト、パターン、コンセプトを分類するプロセス。画像認識は画像分類とも呼ばれます。

不均衡なデータセット

クラス不均衡データセットと同義。

暗黙のバイアス

自分のメンタルモデルと記憶に基づいて、関連付けや推測を自動的に行う。暗黙のバイアスは、次のものに影響する可能性があります。

- データの収集方法と分類方法。

- 機械学習システムの設計と開発の方法。

たとえば、結婚式の写真を識別する分類モデルを構築する場合、エンジニアは写真に白いドレスがあるかどうかを特徴量として使用できます。ただし、白いドレスは特定の時代や文化でのみ慣習的に着用されてきました。

確証バイアスもご覧ください。

補完

値の補完の短縮形。

公平性に関する指標の不整合

公平性の概念の中には、相互に両立せず、同時に満たすことができないものがあるという考え方。そのため、すべての ML 問題に適用できる公平性を定量化するための単一の普遍的な指標はありません。

これは落胆するようなことかもしれませんが、公平性の指標の不整合は、公平性の取り組みが無駄であることを意味するものではありません。代わりに、公平性は特定の ML 問題のコンテキストに沿って定義し、そのユースケースに固有の危害を防ぐことを目標にする必要があることを示唆しています。

公平性指標の非互換性について詳しくは、「公平性の(不)可能性について」をご覧ください。

コンテキスト内学習

少数ショット プロンプトと同義。

独立同分布(i.i.d)

変化しない分布から抽出されたデータ。抽出された各値は、以前に抽出された値に依存しません。i.i.d. は、機械学習の理想気体です。有用な数学的構成ですが、現実世界で完全に一致することはほとんどありません。たとえば、ウェブページへの訪問者の分布は、短い期間にわたって i.i.d. である可能性があります。つまり、その短い期間中は分布が変化せず、あるユーザーの訪問は一般的に別のユーザーの訪問とは独立しています。ただし、期間を拡大すると、ウェブページの訪問者の季節的な違いが現れることがあります。

非定常性もご覧ください。

個人の公平性

類似した個人が同様に分類されているかどうかを確認する公平性指標。たとえば、Brobdingnagian Academy は、成績と標準テストのスコアが同じ 2 人の生徒が同じ確率で入学できるようにすることで、個人の公平性を満たしたいと考えています。

個人の公平性は「類似性」(この場合は成績とテストの点数)の定義に完全に依存します。類似性指標で重要な情報(生徒のカリキュラムの厳しさなど)が欠落していると、新たな公平性の問題が生じる可能性があります。

個人の公平性について詳しくは、「認識による公平性」をご覧ください。

推論

従来の ML では、トレーニング済みモデルをラベルなしの例に適用して予測を行うプロセス。詳細については、ML の概要コースの教師あり学習をご覧ください。

大規模言語モデルでは、推論は、トレーニング済みのモデルを使用して、入力プロンプトに対するレスポンスを生成するプロセスです。

推論は、統計ではやや異なる意味を持ちます。詳しくは、 統計的推論に関する Wikipedia の記事をご覧ください。

推論パス

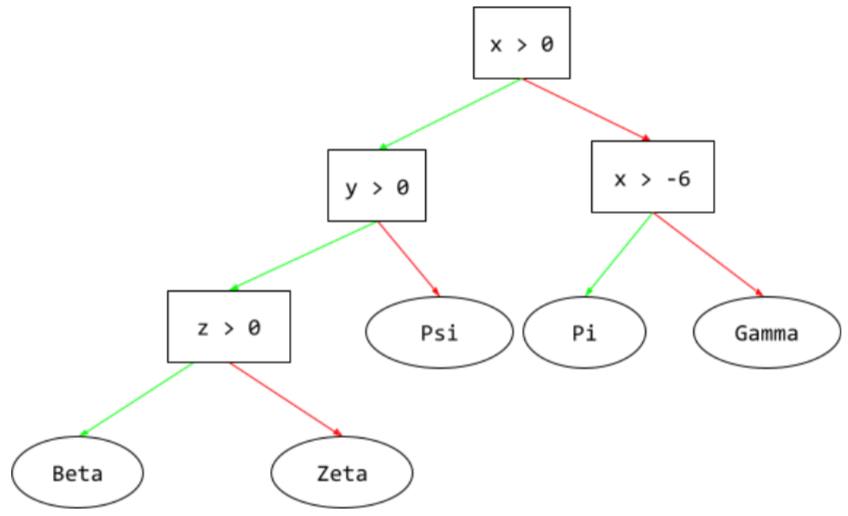

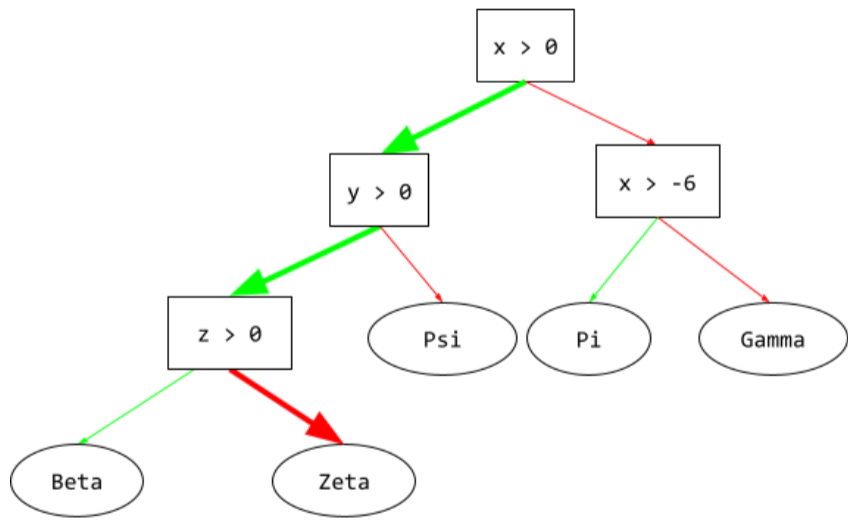

ディシジョン ツリーでは、推論中に、特定の例がルートから他の条件をたどってリーフで終了するルート。たとえば、次の決定木では、太い矢印は、次の特徴値を持つ例の推論パスを示しています。

- x = 7

- y = 12

- z = -3

次の図の推論パスは、リーフ(Zeta)に到達する前に 3 つの条件を通過します。

3 つの太い矢印は推論パスを示しています。

詳細については、デシジョン フォレスト コースのデシジョン ツリーをご覧ください。

情報利得

決定フォレストでは、ノードのエントロピーと、子ノードのエントロピーの重み付け(例の数による)された合計の差。ノードのエントロピーは、そのノード内の例のエントロピーです。

たとえば、次のエントロピー値を考えてみましょう。

- 親ノードのエントロピー = 0.6

- 16 個の関連する例を含む 1 つの子ノードのエントロピー = 0.2

- 関連する例が 24 個ある別の子ノードのエントロピー = 0.1

したがって、例の 40% は一方の子ノードにあり、60% はもう一方の子ノードにあります。そのため、次のようになります。

- 子ノードの重み付きエントロピーの合計 = (0.4 × 0.2) + (0.6 × 0.1) = 0.14

したがって、情報利得は次のようになります。

- 情報利得 = 親ノードのエントロピー - 子ノードの重み付きエントロピーの合計

- 情報利得 = 0.6 - 0.14 = 0.46

ほとんどの分割器は、情報ゲインを最大化する条件を作成しようとします。

内集団バイアス

自分のグループや自分の特性に偏見を持つこと。テスターや評価者が ML デベロッパーの友人、家族、同僚で構成されている場合、内集団バイアスによってプロダクト テストやデータセットが無効になる可能性があります。

所属グループのバイアスは、グループ帰属バイアスの一種です。自分が属していないグループに対する均一性のバイアスもご覧ください。

詳細については、ML 集中講座の公平性: 偏りの種類をご覧ください。

入力ジェネレータ

データをニューラル ネットワークに読み込むメカニズム。

入力ジェネレータは、生データをテンソルに処理するコンポーネントと考えることができます。このテンソルは、トレーニング、評価、推論用のバッチを生成するために反復処理されます。

入力レイヤ

特徴ベクトルを保持するニューラル ネットワークのレイヤ。つまり、入力レイヤはトレーニングまたは推論用の例を提供します。たとえば、次のニューラル ネットワークの入力レイヤは 2 つの特徴で構成されています。

インセット条件

ディシジョン ツリーで、アイテムのセット内の 1 つのアイテムの存在をテストする条件。たとえば、次の条件はセット内の条件です。

house-style in [tudor, colonial, cape]

推論時に、住宅スタイルの特徴の値が tudor、colonial、cape のいずれかの場合、この条件は Yes と評価されます。住宅スタイルの特徴の値がそれ以外の場合(ranch など)、この条件は No と評価されます。

通常、インセット条件は、ワンホット エンコードされた特徴をテストする条件よりも効率的なディシジョン ツリーにつながります。

インスタンス

example と同義。

指示チューニング

生成 AI モデルの指示に従う能力を向上させるファインチューニングの一種。指示チューニングでは、通常はさまざまなタスクを対象とする一連の指示プロンプトでモデルをトレーニングします。その結果、指示チューニングされたモデルは、さまざまなタスクにわたってゼロショット プロンプトに対して有用なレスポンスを生成する傾向があります。

比較対照:

解釈可能性

ML モデルの推論を人間にわかりやすい言葉で説明または提示する能力。

たとえば、ほとんどの線形回帰モデルは解釈可能性が高いです。(各特徴量のトレーニング済み重みを確認するだけで済みます)。デシジョン フォレストは解釈可能性も高いです。ただし、一部のモデルでは、解釈可能にするために高度な可視化が必要になります。

Learning Interpretability Tool(LIT)を使用して、ML モデルを解釈できます。

inter-rater agreement(採点者間の一致度)

タスクの実行時に人間の評価者が一致する頻度を測定します。評価者が一致しない場合は、タスクの手順を改善する必要がある可能性があります。アノテーター間の一致度または評価者間の信頼性とも呼ばれます。最も一般的な評価者間一致度の測定方法の 1 つである Cohen のカッパ係数もご覧ください。

詳細については、ML 集中講座のカテゴリデータ: 一般的な問題をご覧ください。

IoU(Intersection over Union)

2 つのセットの共通部分を和集合で割った値。機械学習の画像検出タスクでは、IoU を使用して、グラウンド トゥルースの境界ボックスに対するモデルの予測境界ボックスの精度を測定します。この場合、2 つのボックスの IoU は、重複する領域と合計領域の比率です。値の範囲は 0(予測境界ボックスとグラウンド トゥルース境界ボックスが重ならない)から 1(予測境界ボックスとグラウンド トゥルース境界ボックスの座標が完全に一致する)です。

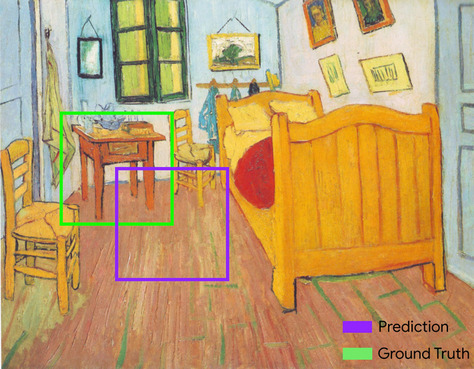

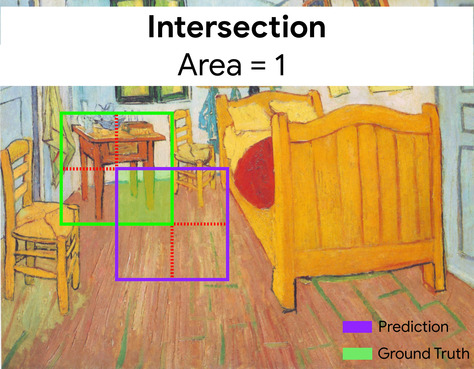

たとえば、下の画像では次のように表示されます。

- 予測された境界ボックス(モデルが絵画のナイトテーブルが配置されていると予測した場所を区切る座標)は紫色の枠で囲まれています。

- グラウンド トゥルースのバウンディング ボックス(絵画のナイトテーブルが実際に配置されている場所を区切る座標)は緑色で囲まれています。

ここで、予測とグラウンド トゥルースの境界ボックスの交差部分(左下)は 1、予測とグラウンド トゥルースの境界ボックスの結合部分(右下)は 7 であるため、IoU は \(\frac{1}{7}\)です。

IoU

IoU(Intersection over Union)の略。

アイテム マトリックス

レコメンデーション システムでは、行列分解によって生成されたエンベディング ベクトルの行列。各アイテムに関する潜在的なシグナルを保持します。アイテム マトリックスの各行には、すべてのアイテムの 1 つの潜在的特徴の値が保持されます。たとえば、映画のレコメンデーション システムについて考えてみましょう。アイテム マトリックスの各列は 1 つの映画を表します。潜在シグナルはジャンルを表すこともあれば、ジャンル、スター、映画の公開年などの要素間の複雑な相互作用を含む、解釈が難しいシグナルを表すこともあります。

アイテム マトリックスの列数は、因数分解されるターゲット マトリックスと同じです。たとえば、10,000 件の映画タイトルを評価する映画レコメンデーション システムの場合、アイテム行列には 10,000 個の列があります。

アイテム

レコメンデーション システムでは、システムが推奨するエンティティ。たとえば、ビデオ店がおすすめするアイテムは動画であり、書店がおすすめするアイテムは書籍です。

繰り返し

トレーニング中に、モデルのパラメータ(モデルの重みとバイアス)を 1 回更新すること。バッチサイズは、モデルが 1 回のイテレーションで処理するサンプル数を決定します。たとえば、バッチサイズが 20 の場合、モデルはパラメータを調整する前に 20 個の例を処理します。

ニューラル ネットワークのトレーニングでは、1 回の反復で次の 2 つのパスが実行されます。

- 単一バッチの損失を評価するフォワード パス。

- 損失と学習率に基づいてモデルのパラメータを調整するバックワード パス(バックプロパゲーション)。

詳細については、機械学習集中講座の勾配降下法をご覧ください。

J

JAX

配列計算ライブラリ。XLA(Accelerated Linear Algebra)と自動微分を組み合わせて、高性能の数値計算を実現します。JAX は、構成可能な変換を使用して高速化された数値コードを記述するためのシンプルで強力な API を提供します。JAX には次のような機能があります。

grad(自動微分)jit(ジャストインタイム コンパイル)vmap(自動ベクトル化またはバッチ処理)pmap(並列化)

JAX は、数値コードの変換を表現して構成するための言語です。Python の NumPy ライブラリに似ていますが、範囲ははるかに広くなっています。(実際、JAX の .numpy ライブラリは、機能的には同等ですが、Python NumPy ライブラリを完全に書き直したバージョンです)。

JAX は、モデルとデータを GPU と TPU アクセラレータ チップでの並列処理に適した形式に変換することで、多くの ML タスクを高速化するのに特に適しています。

Flax、Optax、Pax などの多くのライブラリは、JAX インフラストラクチャ上に構築されています。

K

Keras

一般的な Python ML API。Keras は、TensorFlow を含む複数のディープ ラーニング フレームワークで実行されます。TensorFlow では、tf.keras として使用できます。

カーネル サポート ベクター マシン(KSVM)

入力データベクトルを高次元空間にマッピングすることで、正のクラスと負のクラスの間のマージンを最大化しようとする分類アルゴリズム。たとえば、入力データセットに 100 個の特徴がある分類問題を考えてみましょう。正のクラスと負のクラスの間のマージンを最大化するために、KSVM はこれらの特徴を内部的に 100 万次元の空間にマッピングできます。KSVM は、ヒンジ損失と呼ばれる損失関数を使用します。

キーポイント

画像内の特定の要素の座標。たとえば、花の種類を区別する画像認識モデルの場合、キーポイントは各花びらの中心、茎、おしべなどになります。

k-fold 交差検証

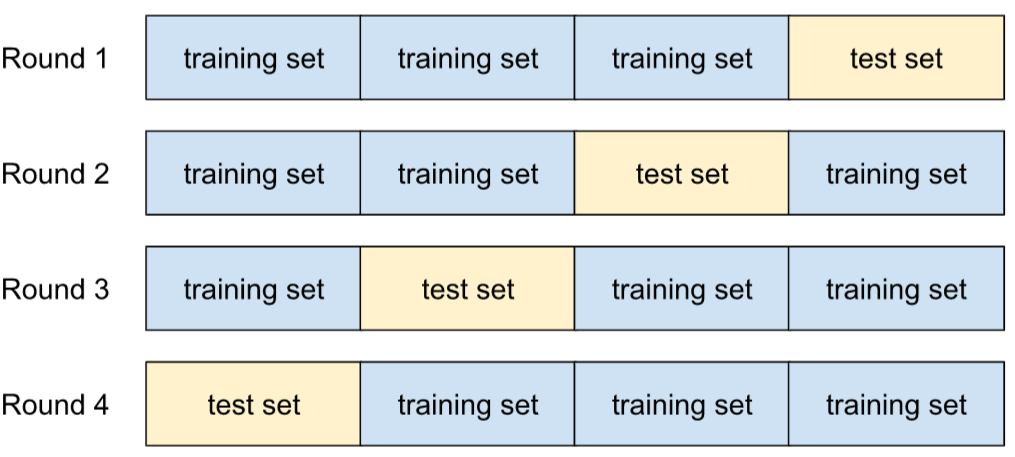

新しいデータに一般化するモデルの能力を予測するアルゴリズム。k 分割交差検定の k は、データセットのサンプルを分割する等しいグループの数を指します。つまり、モデルのトレーニングとテストを k 回行います。トレーニングとテストの各ラウンドで、異なるグループがテストセットになり、残りのすべてのグループがトレーニング セットになります。k 回のトレーニングとテストの後、選択したテスト指標の平均値と標準偏差を計算します。

たとえば、データセットが 120 個の例で構成されているとします。さらに、k を 4 に設定するとします。したがって、例をシャッフルした後、データセットを 30 個の例の 4 つの等しいグループに分割し、4 回のトレーニングとテストラウンドを実施します。

たとえば、線形回帰モデルでは平均二乗誤差(MSE)が最も意味のある指標になることがあります。したがって、4 ラウンドすべての MSE の平均と標準偏差を求めます。

k-means

教師なし学習で例をグループ化する一般的なクラスタリング アルゴリズム。k 平均法アルゴリズムは基本的に次の処理を行います。

- 最適な k 個の中心点(セントロイド)を反復的に決定します。

- 各例を最も近いセントロイドに割り当てます。同じ重心に最も近い例は、同じグループに属します。

k 平均法アルゴリズムは、各例から最も近いセントロイドまでの距離の累積二乗を最小限に抑えるようにセントロイドの位置を選択します。

たとえば、犬の高さと犬の幅の次のプロットについて考えてみましょう。

k=3 の場合、k 平均法アルゴリズムは 3 つのセントロイドを決定します。各例は最も近いセントロイドに割り当てられ、3 つのグループが生成されます。

犬用のセーターの S、M、L の理想的なサイズを決定したいと考えているメーカーを想定します。3 つのセントロイドは、そのクラスタ内の各犬の平均の高さと平均の幅を示します。そのため、セーターのサイズは、おそらくこの 3 つの重心に基づいて決めるべきでしょう。クラスタの重心は通常、クラスタ内の例ではありません。

上の図は、2 つの特徴(高さと幅)のみを持つ例の k 平均法を示しています。k 平均法では、多くの特徴にわたって例をグループ化できます。

詳細については、クラスタリング コースの k 平均法クラスタリングとはをご覧ください。

k-median

k 平均法と密接に関連するクラスタリング アルゴリズム。この 2 つの実際的な違いは次のとおりです。

- k 平均法では、セントロイド候補と各例の間の距離の二乗の合計を最小化することで、セントロイドが決定されます。

- k-median では、セントロイド候補と各例の距離の合計を最小化することでセントロイドが決定されます。

距離の定義も異なります。

- k 平均法は、セントロイドから例までのユークリッド距離に依存します。(2 次元の場合、ユークリッド距離はピタゴラスの定理を使用して斜辺を計算することを意味します)。たとえば、(2,2) と (5,-2) の間の k 平均距離は次のようになります。

- k-median は、セントロイドから例までの マンハッタン距離に依存します。この距離は、各ディメンションの絶対デルタの合計です。たとえば、(2,2) と (5,-2) の間の k-median 距離は次のようになります。

L

L0 正規化

モデル内のゼロ以外の重みの合計数にペナルティを課す正則化の一種。たとえば、ゼロ以外の重みが 11 個あるモデルは、ゼロ以外の重みが 10 個ある同様のモデルよりもペナルティが大きくなります。

L0 正則化は、L0 ノルム正則化と呼ばれることもあります。

L1 損失

実際のラベル値とモデルが予測する値の差の絶対値を計算する損失関数。たとえば、5 つの例のバッチの L1 損失の計算は次のようになります。

| 例の実際の値 | モデルの予測値 | デルタの絶対値 |

|---|---|---|

| 7 | 6 | 1 |

| 5 | 4 | 1 |

| 8 | 11 | 3 |

| 4 | 6 | 2 |

| 9 | 8 | 1 |

| 8 = L1 損失 | ||

L1 損失は、L2 損失よりも外れ値の影響を受けにくいです。

平均絶対誤差は、例ごとの L1 損失の平均です。

詳細については、ML 集中講座の線形回帰: 損失をご覧ください。

L1 正則化

正則化の一種で、重みの絶対値の合計に比例して重みにペナルティを課します。L1 正則化は、無関係な特徴やほとんど関係のない特徴の重みを正確に 0 にするのに役立ちます。重みが 0 の特徴量は、モデルから事実上削除されます。

L2 正則化と比較します。

L2 損失

実際のラベル値とモデルが予測する値の差の二乗を計算する損失関数。たとえば、5 つの例のバッチの L2 損失の計算は次のようになります。

| 例の実際の値 | モデルの予測値 | デルタの 2 乗 |

|---|---|---|

| 7 | 6 | 1 |

| 5 | 4 | 1 |

| 8 | 11 | 9 |

| 4 | 6 | 4 |

| 9 | 8 | 1 |

| 16 = L2 損失 | ||

2 乗のため、L2 損失は外れ値の影響を増幅します。つまり、L2 損失は、L1 損失よりも悪い予測に強く反応します。たとえば、前のバッチの L1 損失は 16 ではなく 8 になります。16 個のうち 9 個が 1 つの外れ値で占められています。

回帰モデルでは、通常、損失関数として L2 損失が使用されます。

平均二乗誤差は、例ごとの L2 損失の平均です。二乗損失は、L2 損失の別名です。

詳細については、ML 集中講座のロジスティック回帰: 損失と正則化をご覧ください。

L2 正則化

重みの平方の合計に比例して重みにペナルティを課す正則化の一種。L2 正則化は、外れ値の重み(正の値が大きいか負の値が小さいもの)を 0 に近づけますが、完全に 0 にはしません。値が 0 に非常に近い特徴はモデルに残りますが、モデルの予測に大きな影響を与えません。

L2 正則化は、線形モデルの一般化を常に改善します。

L1 正則化と比較してください。

詳細については、機械学習集中講座の過学習: L2 正則化をご覧ください。

ラベル

各ラベル付きの例は、1 つ以上の特徴とラベルで構成されます。たとえば、迷惑メール検出データセットでは、ラベルは「迷惑メール」または「迷惑メールではない」のいずれかになります。降雨量データセットでは、ラベルは特定の期間に降った雨の量になることがあります。

詳細については、ML の概要の教師あり学習をご覧ください。

ラベル付きの例

1 つ以上の特徴とラベルを含む例。たとえば、次の表は、住宅評価モデルのラベル付きサンプルを 3 つ示しています。各サンプルには 3 つの特徴と 1 つのラベルがあります。

| 寝室の数 | 浴室の数 | 築年数 | 住宅価格(ラベル) |

|---|---|---|---|

| 3 | 2 | 15 | $345,000 |

| 2 | 1 | 72 | $179,000 |

| 4 | 2 | 34 | $392,000 |

教師あり ML では、モデルはラベル付きの例でトレーニングされ、ラベルなしの例で予測を行います。

ラベル付きの例とラベルなしの例を比較します。

詳細については、ML の概要の教師あり学習をご覧ください。

ラベルの漏洩

特徴がラベルのプロキシであるモデル設計の欠陥。たとえば、見込み顧客が特定の商品を購入するかどうかを予測するバイナリ分類モデルを考えてみましょう。モデルの機能の 1 つが SpokeToCustomerAgent という名前のブール値であるとします。さらに、見込み顧客が実際に商品を購入した後にのみ、顧客エージェントが割り当てられるとします。トレーニング中、モデルは SpokeToCustomerAgent とラベルの関連性をすばやく学習します。

詳細については、ML 集中講座のパイプラインのモニタリングをご覧ください。

lambda

正則化率と同義。

Lambda はオーバーロードされた用語です。ここでは、正則化における用語の定義に焦点を当てます。

LaMDA(対話アプリケーション用言語モデル)

Google が開発した Transformer ベースの大規模言語モデル。大規模な会話データセットでトレーニングされており、現実的な会話の応答を生成できます。

LaMDA: Google の画期的な会話テクノロジーで概要を確認できます。

landmarks

keypoints と同義。

言語モデル

長いトークン シーケンスでトークンまたはトークン シーケンスが発生する確率を推定するモデル。

詳細については、ML 集中講座の言語モデルとはをご覧ください。

大規模言語モデル

少なくとも、非常に多くのパラメータを持つ言語モデル。より非公式には、Gemini や GPT などの Transformer ベースの言語モデル。

詳細については、ML 集中講座の大規模言語モデル(LLM)をご覧ください。

遅延

モデルが入力を処理してレスポンスを生成するまでにかかる時間。レイテンシの高いレスポンスは、レイテンシの低いレスポンスよりも生成に時間がかかります。

大規模言語モデルのレイテンシに影響する要因は次のとおりです。

- 入力トークンと出力トークンの長さ

- モデルの複雑さ

- モデルが実行されるインフラストラクチャ

レイテンシの最適化は、レスポンスがよく使いやすいアプリケーションを作成するうえで非常に重要です。

潜在空間

エンベディング空間と同義。

レイヤ

ニューラル ネットワーク内のニューロンのセット。一般的なレイヤには次の 3 種類があります。

たとえば、次の図は、入力層が 1 つ、隠れ層が 2 つ、出力層が 1 つのニューラル ネットワークを示しています。

TensorFlow では、レイヤも Python 関数であり、テンソルと構成オプションを入力として受け取り、他のテンソルを出力として生成します。

Layers API(tf.layers)

レイヤの構成としてディープ ニューラル ネットワークを構築するための TensorFlow API。Layers API を使用すると、次のようなさまざまなタイプのレイヤを構築できます。

tf.layers.Dense: 全結合レイヤ。- 畳み込みレイヤの

tf.layers.Conv2D。

Layers API は、Keras レイヤ API の規則に準拠しています。つまり、接頭辞が異なることを除き、Layers API のすべての関数は、Keras レイヤ API の対応する関数と同じ名前とシグネチャを持ちます。

leaf

ディシジョン ツリー内のエンドポイント。条件とは異なり、リーフはテストを実行しません。リーフは予測候補です。リーフは、推論パスの終端ノードでもあります。

たとえば、次のディシジョン ツリーには 3 つのリーフが含まれています。

詳細については、デシジョン フォレスト コースのデシジョン ツリーをご覧ください。

Learning Interpretability Tool(LIT)

モデルの理解とデータの可視化のための視覚的でインタラクティブなツール。

オープンソースの LIT を使用して、モデルを解釈したり、テキスト、画像、表形式のデータを可視化したりできます。

学習率

各イテレーションで重みとバイアスを調整する強度を勾配降下法アルゴリズムに伝える浮動小数点数。たとえば、学習率が 0.3 の場合、学習率が 0.1 の場合よりも 3 倍強力に重みとバイアスが調整されます。

学習率は重要なハイパーパラメータです。学習率を低く設定しすぎると、トレーニングに時間がかかりすぎます。学習率を高く設定しすぎると、勾配降下法で収束に到達するのが難しくなることがよくあります。

詳細については、ML 集中講座の線形回帰: ハイパーパラメータをご覧ください。

最小二乗回帰

レーベンシュタイン距離

ある単語を別の単語に変更するために必要な最小の削除、挿入、置換オペレーションを計算する編集距離指標。たとえば、「heart」と「darts」のレーベンシュタイン距離は 3 です。これは、一方の単語をもう一方の単語に変換するために必要な最小限の変更が次の 3 つであるためです。

- heart → deart(「h」を「d」に置き換える)

- deart → dart(「e」を削除)

- dart → darts(「s」を挿入)

上記のシーケンスは、3 つの編集の唯一のパスではありません。

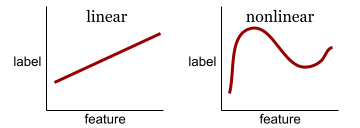

線形

加算と乗算のみで表すことができる 2 つ以上の変数間の関係。

線形関係のプロットは直線になります。

非線形と対照的です。

線形モデル

モデル。特徴量ごとに 1 つの重みを割り当てて、予測を行います。(線形モデルにはバイアスも組み込まれています)。一方、ディープモデルでは、特徴と予測の関係は一般的に非線形です。

一般的に、線形モデルはディープ モデルよりもトレーニングが容易で、解釈しやすいです。ただし、ディープモデルは特徴間の複雑な関係を学習できます。

線形回帰

次の両方が当てはまる ML モデルの一種。

線形回帰とロジスティック回帰を比較します。また、回帰と分類を比較します。

詳細については、ML 集中講座の線形回帰をご覧ください。

LIT

以前は Language Interpretability Tool と呼ばれていた Learning Interpretability Tool(LIT)の略語。

LLM

大規模言語モデルの略語。

LLM 評価

大規模言語モデル(LLM)のパフォーマンスを評価するための指標とベンチマークのセット。LLM 評価の概要は次のとおりです。

- LLM の改善が必要な領域を研究者が特定するのに役立ちます。

- さまざまな LLM を比較し、特定のタスクに最適な LLM を特定する際に役立ちます。

- LLM の使用が安全かつ倫理的であることを確認します。

詳細については、ML 集中講座の大規模言語モデル(LLM)をご覧ください。

ロジスティック回帰

確率を予測する回帰モデルの一種。ロジスティック回帰モデルには次の特徴があります。

- ラベルはカテゴリカルです。ロジスティック回帰という用語は通常、バイナリ ロジスティック回帰、つまり、2 つの値を取り得るラベルの確率を計算するモデルを指します。あまり一般的ではないバリアントである多項ロジスティック回帰は、2 つ以上の候補値を持つラベルの確率を計算します。

- トレーニング中の損失関数は 対数損失です。(2 つ以上の可能な値を持つラベルに対して、複数の Log Loss ユニットを並列に配置できます)。

- モデルはディープ ニューラル ネットワークではなく、線形アーキテクチャです。ただし、この定義の残りの部分は、カテゴリラベルの確率を予測するディープモデルにも適用されます。

たとえば、入力メールが迷惑メールであるかそうでないかの確率を計算するロジスティック回帰モデルについて考えてみましょう。推論時に、モデルが 0.72 を予測したとします。したがって、モデルは次のように推定します。

- メールが迷惑メールである可能性が 72% である。

- メールがスパムではない確率は 28% です。

ロジスティック回帰モデルは、次の 2 段階のアーキテクチャを使用します。