1. לפני שמתחילים

הקלדת קוד היא דרך מצוינת לפתח זיכרון שרירי ולהעמיק את ההבנה של החומר. העתקה והדבקה יכולות לחסוך זמן, אבל השקעה בתרגול הזה יכולה להוביל ליעילות רבה יותר ולכישורי תכנות טובים יותר בטווח הארוך.

ב-codelab הזה נסביר איך ליצור אפליקציית Android שמבצעת פילוח תמונות בזמן אמת בפיד מצלמה פעיל באמצעות זמן הריצה החדש של Google ל-TensorFlow Lite, LiteRT. תקבלו אפליקציית Android בסיסית ותוסיפו לה יכולות של פילוח תמונות. בנוסף, נסביר על שלבי העיבוד המקדים, ההסקה והעיבוד שלאחר ההסקה. תצטרכו:

- ליצור אפליקציית Android שמפלח תמונות בזמן אמת.

- שילוב של מודל LiteRT שעבר אימון מראש לחלוקת תמונות למקטעים.

- מעבדים מראש את תמונת הקלט בשביל המודל.

- משתמשים בסביבת זמן הריצה LiteRT להאצת המעבד (CPU) והמעבד הגרפי (GPU).

- הסבר על עיבוד הפלט של המודל כדי להציג את מסכת הפילוח.

- איך משנים את ההגדרה של המצלמה הקדמית.

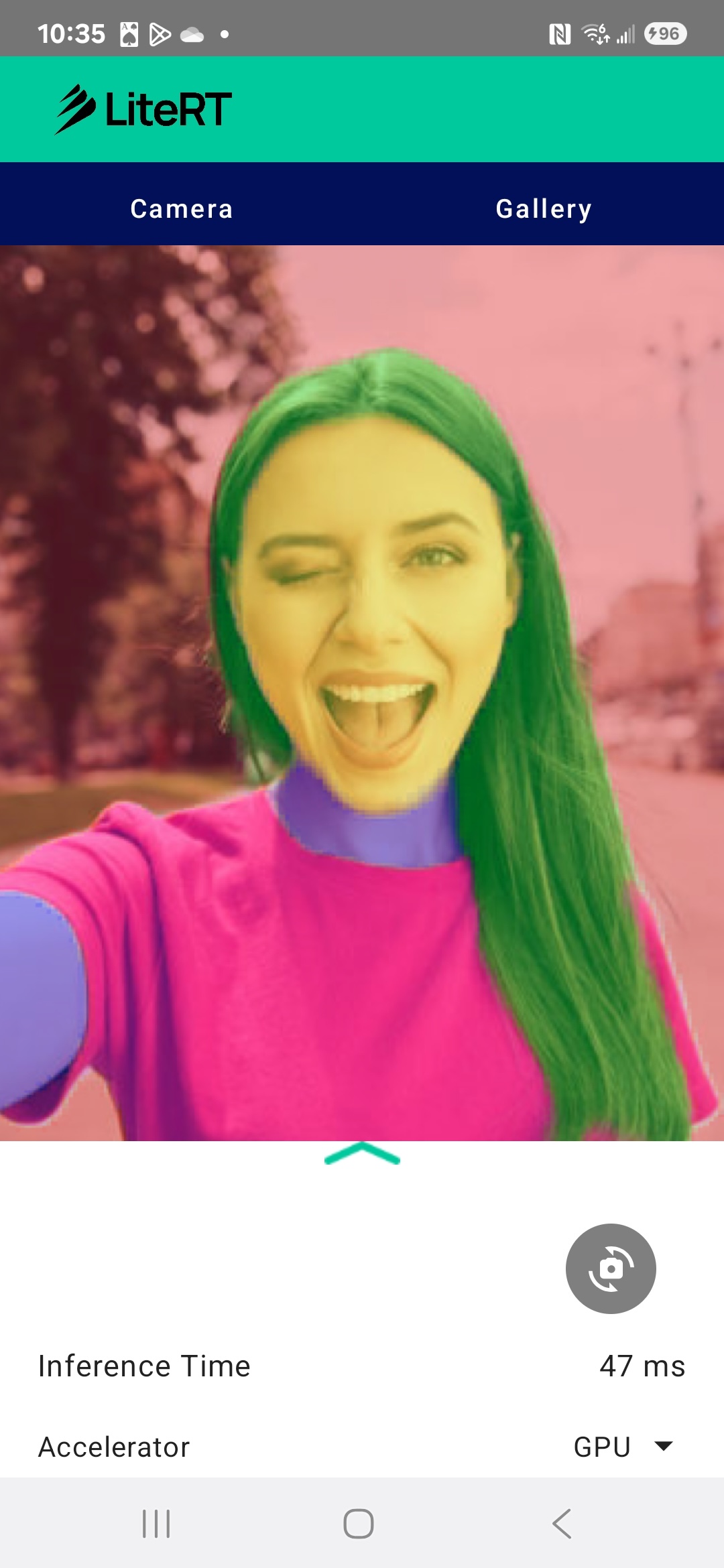

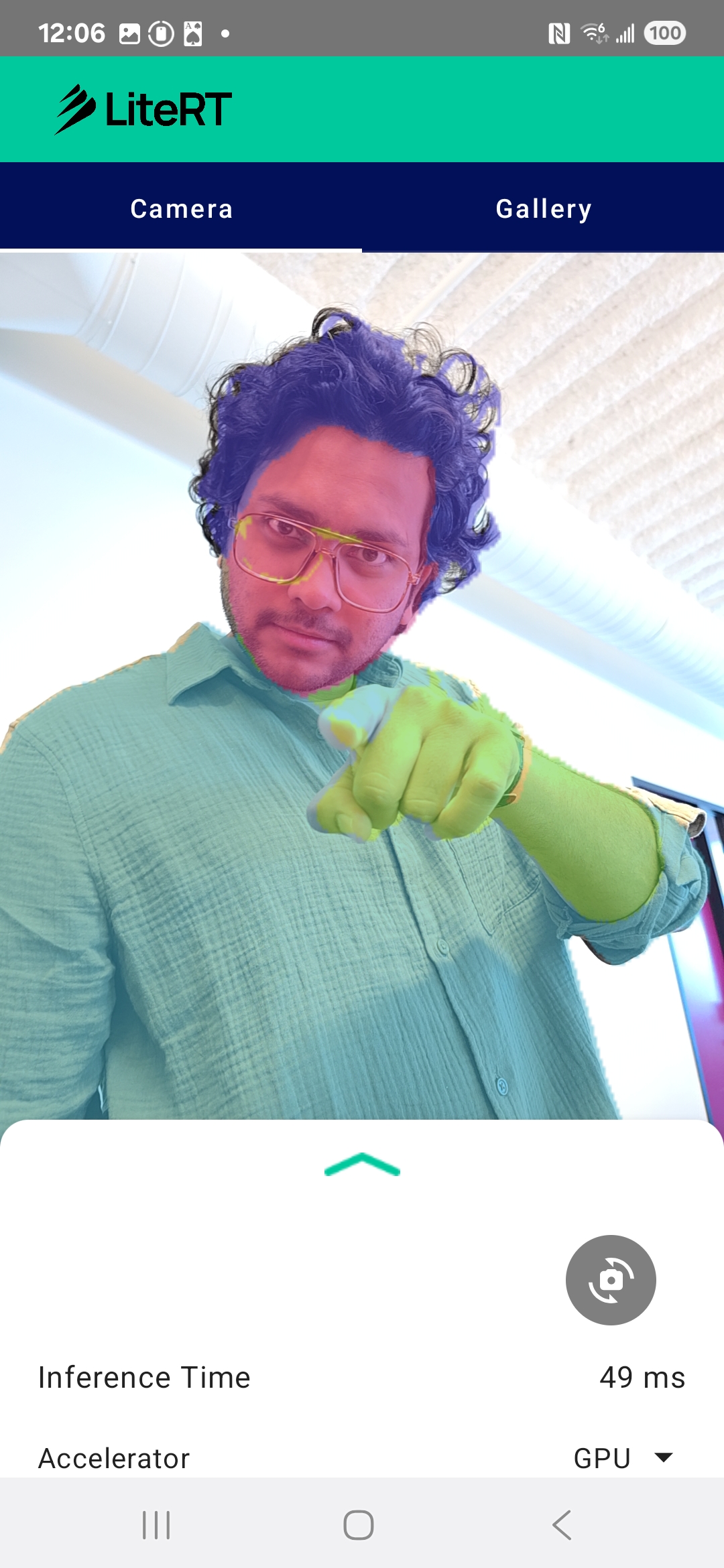

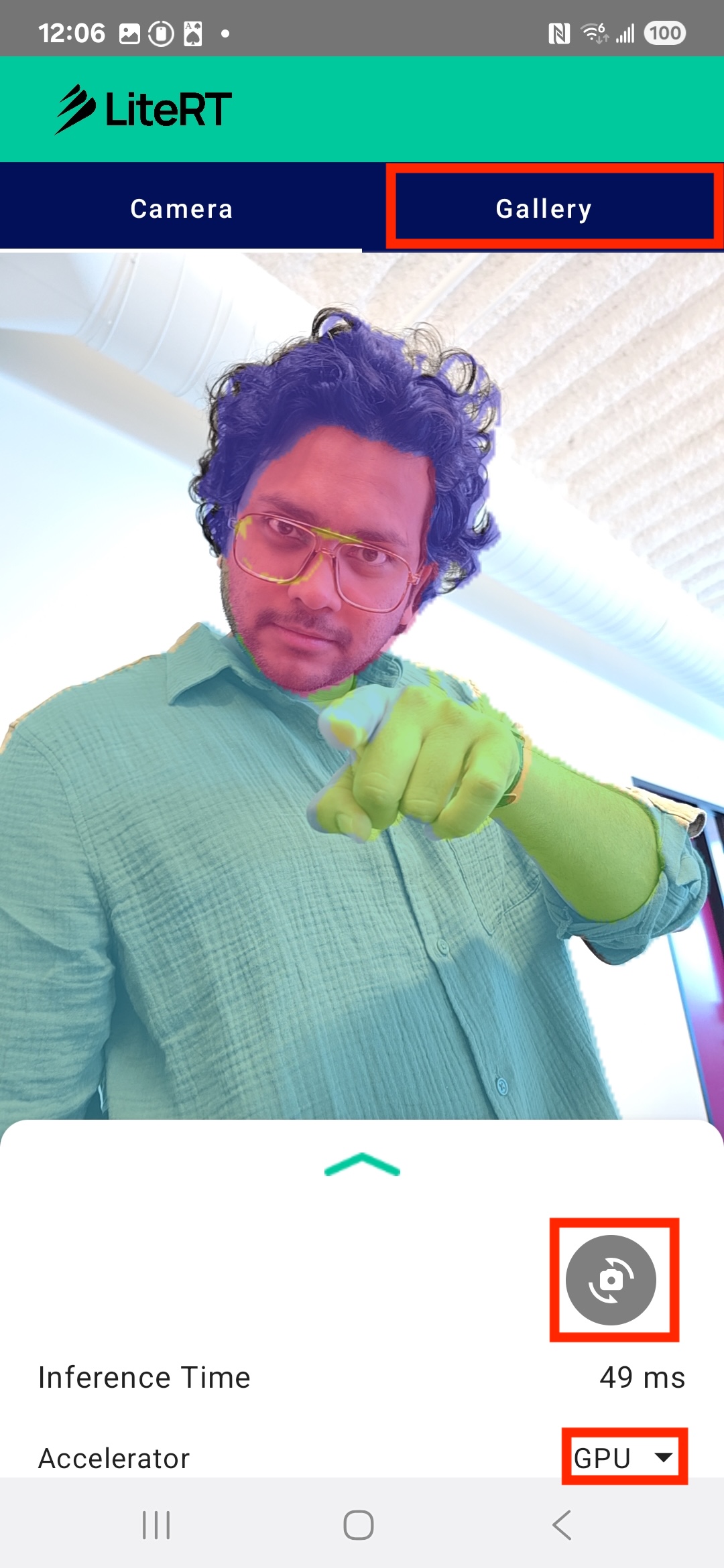

בסופו של דבר, תיצרו משהו דומה לתמונה הבאה:

דרישות מוקדמות

ה-Codelab הזה מיועד למפתחים מנוסים של אפליקציות לנייד שרוצים להתנסות בלמידת מכונה. חשוב שתכירו את:

- פיתוח ל-Android באמצעות Kotlin ו-Android Studio

- מושגים בסיסיים בעיבוד תמונה

מה תלמדו

- איך לשלב את זמן הריצה של LiteRT באפליקציית Android ואיך להשתמש בו.

- איך לבצע פילוח תמונות באמצעות מודל LiteRT שעבר אימון מראש.

- איך לעבד מראש את תמונת הקלט בשביל המודל.

- איך להריץ הסקה למודל.

- איך לעבד את הפלט של מודל סגמנטציה כדי להציג את התוצאות.

- איך משתמשים ב-CameraX לעיבוד של פיד המצלמה בזמן אמת.

הדרישות

- גרסה עדכנית של Android Studio (נבדקה בגרסה v2025.1.1).

- מכשיר Android פיזי. מומלץ לבדוק את התכונה במכשירי Galaxy ו-Pixel.

- קוד לדוגמה (מ-GitHub).

- ידע בסיסי בפיתוח ל-Android ב-Kotlin.

2. חלוקת תמונות למקטעים

פילוח תמונות הוא משימה של ראייה ממוחשבת שכוללת חלוקה של תמונה לכמה פלחים או אזורים. בניגוד לזיהוי אובייקטים, שבו מציירים תיבת תוחמת מסביב לאובייקט, בפילוח תמונות מוקצה סיווג או תווית ספציפיים לכל פיקסל בתמונה. כך אפשר לקבל הבנה מפורטת ומדויקת יותר של תוכן התמונה, ולדעת מה הצורה והגבול המדויקים של כל אובייקט.

לדוגמה, במקום לדעת ש'אדם' נמצא בתיבה, אפשר לדעת בדיוק אילו פיקסלים שייכים לאדם הזה. במדריך הזה מוסבר איך לבצע פילוח תמונות בזמן אמת במכשיר Android באמצעות מודל למידת מכונה שאומן מראש.

LiteRT: דחיפה של הקצה של למידת מכונה במכשיר

טכנולוגיה מרכזית שמאפשרת פילוח בזמן אמת באיכות גבוהה במכשירים ניידים היא LiteRT. LiteRT הוא סביבת זמן ריצה מהדור הבא של Google ל-TensorFlow Lite, עם ביצועים גבוהים. הוא מתוכנן להפיק את הביצועים הכי טובים מהחומרה הבסיסית.

הוא עושה את זה באמצעות שימוש חכם ומותאם במאיצי חומרה כמו GPU (מעבד גרפי) ו-NPU (מעבד עצבי). העברת עומס העבודה החישובי האינטנסיבי של מודל הפילוח מהמעבד לשימוש כללי למעבדים המיוחדים האלה מאפשרת ל-LiteRT להפחית באופן משמעותי את זמן ההסקה. ההאצה הזו מאפשרת להריץ מודלים מורכבים בצורה חלקה בפיד חי של המצלמה, ומרחיבה את הגבולות של מה שאפשר להשיג באמצעות למידת מכונה ישירות בטלפון. בלי רמת הביצועים הזו, פילוח בזמן אמת יהיה איטי מדי ועם שיבושים, וחוויית המשתמש לא תהיה טובה.

3. להגדרה

שכפול המאגר

קודם כל, משכפלים את המאגר של LiteRT:

git clone https://github.com/google-ai-edge/litert-samples.git

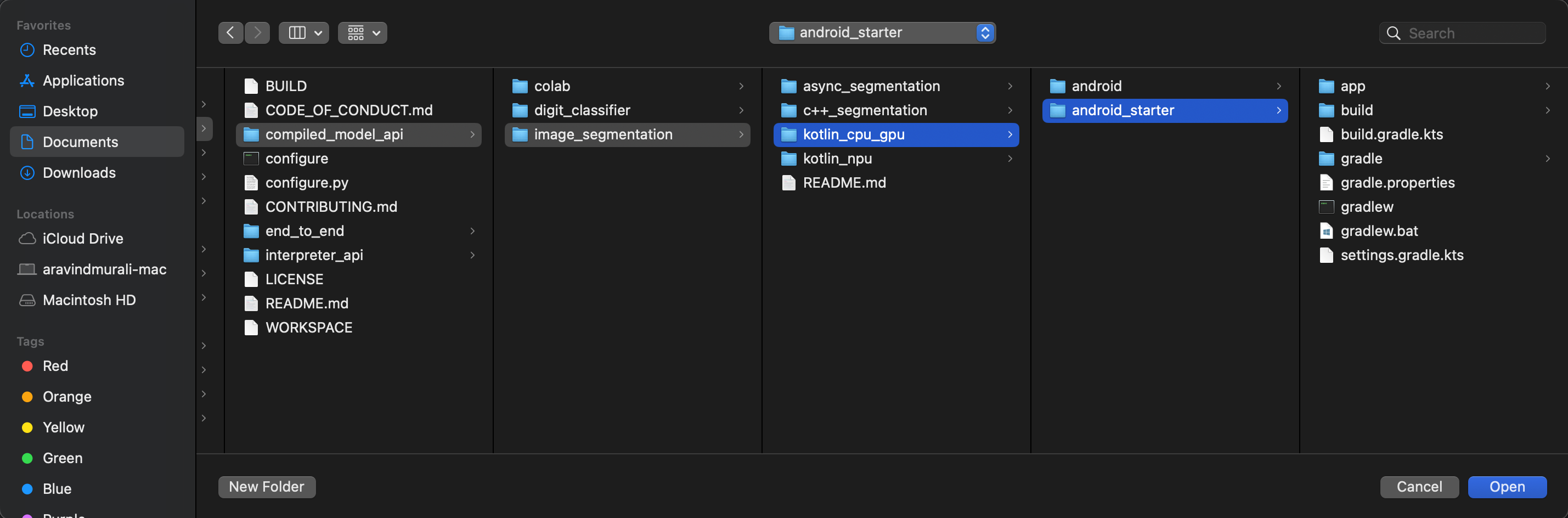

litert-samples/compiled_model_api/image_segmentation היא הספרייה עם כל המשאבים שתצטרכו. ב-Codelab הזה תצטרכו רק את פרויקט kotlin_cpu_gpu/android_starter. אם נתקעתם, כדאי לעיין בפרויקט המוגמר: kotlin_cpu_gpu/android

הערה לגבי נתיבי קבצים

במדריך הזה, נתיבי הקבצים מצוינים בפורמט של Linux/macOS. אם אתם משתמשים ב-Windows, תצטרכו לשנות את הנתיבים בהתאם.

חשוב גם להבין את ההבדל בין תצוגת הפרויקט ב-Android Studio לבין תצוגה רגילה של מערכת קבצים. תצוגת הפרויקט ב-Android Studio היא ייצוג מובנה של קובצי הפרויקט, שמאורגנים לצורך פיתוח ל-Android. נתיבי הקבצים במדריך הזה מתייחסים לנתיבים במערכת הקבצים, ולא לנתיבים בתצוגת הפרויקט ב-Android Studio.

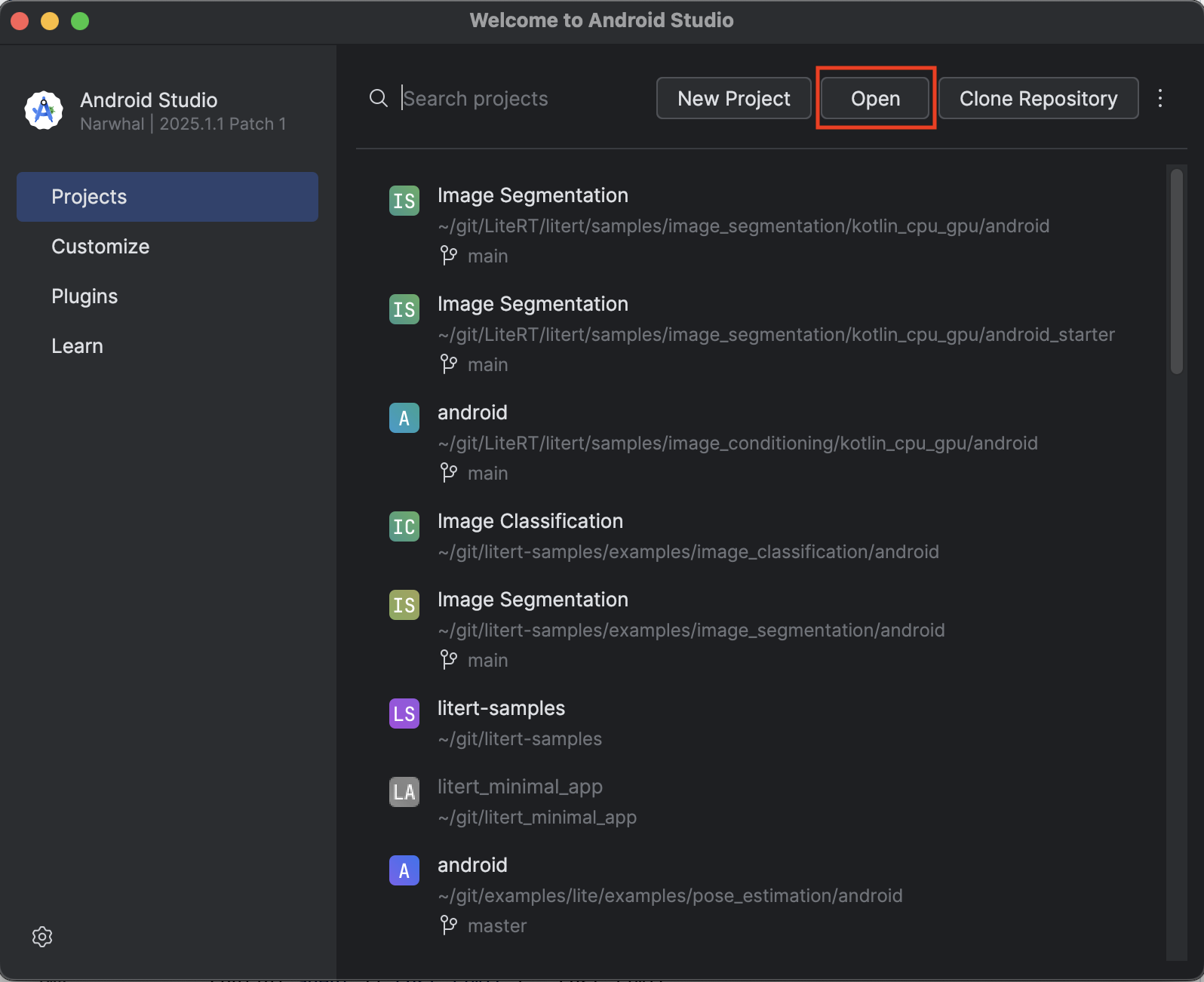

ייבוא אפליקציית המתחילים

נתחיל בייבוא אפליקציית המתחילים אל Android Studio.

- פותחים את Android Studio ובוחרים באפשרות Open (פתיחה).

- מנווטים לספרייה

kotlin_cpu_gpu/android_starterופותחים אותה.

כדי לוודא שכל התלויות זמינות לאפליקציה, צריך לסנכרן את הפרויקט עם קובצי gradle אחרי שתהליך הייבוא מסתיים.

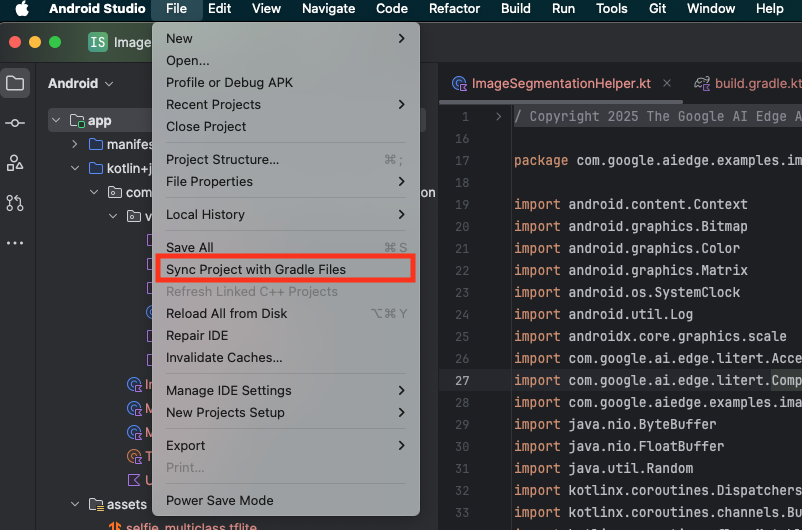

- בסרגל הכלים של Android Studio, לוחצים על Sync Project with Gradle Files (סנכרון הפרויקט עם קובצי Gradle).

- חשוב לא לדלג על השלב הזה – אם הוא לא יעבוד, לא תהיה משמעות לשאר המדריך.

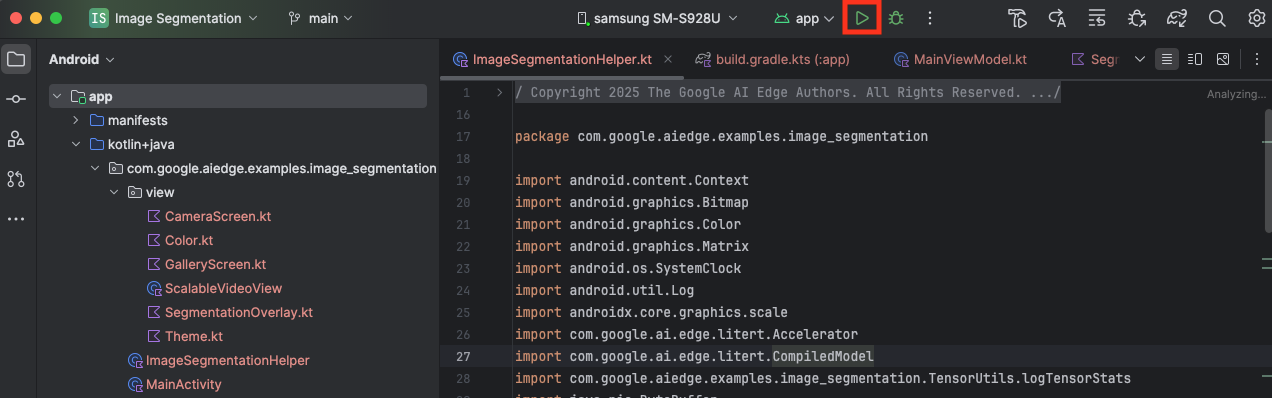

הפעלת אפליקציית המתחילים

אחרי שמייבאים את הפרויקט ל-Android Studio, אפשר להריץ את האפליקציה בפעם הראשונה.

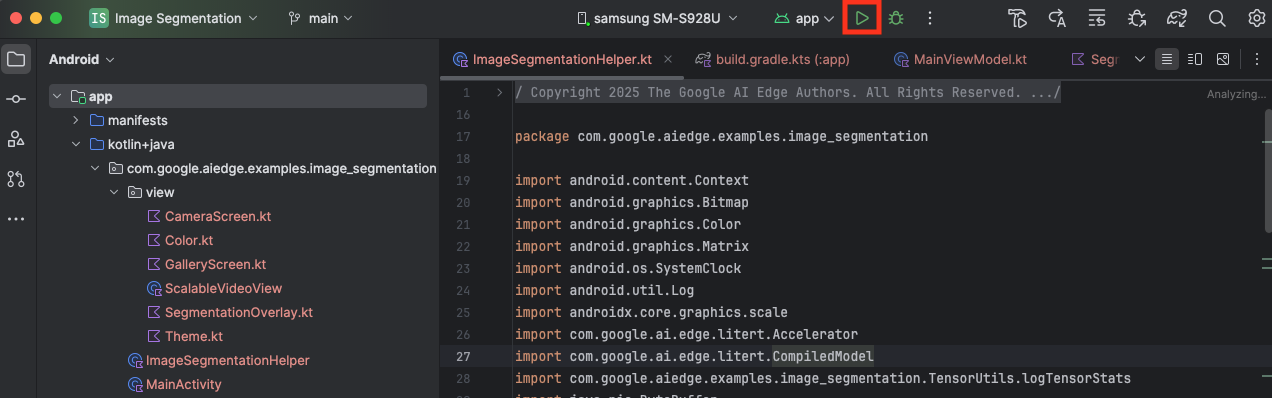

מחברים את מכשיר Android למחשב באמצעות USB ולוחצים על Run (הפעלה) בסרגל הכלים של Android Studio.

האפליקציה אמורה להיפתח במכשיר. יוצג לכם פיד חי מהמצלמה, אבל עדיין לא תתבצע פילוח. כל העריכות שתבצעו בקבצים במדריך הזה יהיו בספרייה litert-samples/compiled_model_api/image_segmentation/kotlin_cpu_gpu/android_starter/app/src/main/java/com/google/ai/edge/examples/image_segmentation (עכשיו אתם יודעים למה Android Studio משנה את המבנה שלה 😃).

תראו גם TODO תגובות בקבצים ImageSegmentationHelper.kt, MainViewModel.kt ו-view/SegmentationOverlay.kt. בשלבים הבאים תטמיעו את הפונקציונליות של פילוח התמונה על ידי מילוי ה-TODO האלה.

4. הסבר על אפליקציית המתחילים

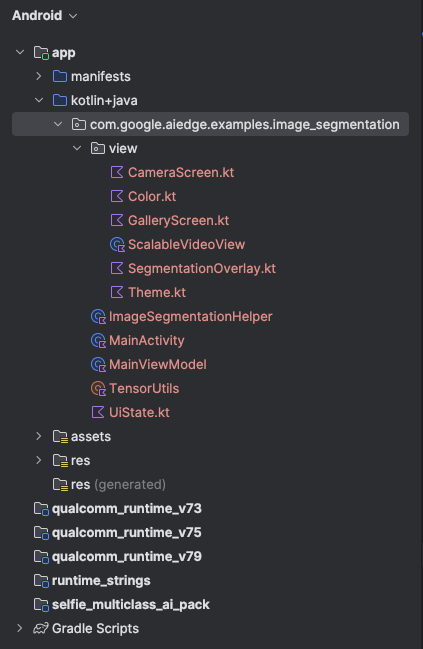

אפליקציית המתחילים כבר כוללת ממשק משתמש בסיסי ולוגיקה לטיפול במצלמה. סקירה כללית מהירה של הקבצים העיקריים:

-

app/src/main/java/com/google/ai/edge/examples/image_segmentation/MainActivity.kt: זו נקודת הכניסה הראשית של האפליקציה. הוא מגדיר את ממשק המשתמש באמצעות Jetpack Compose ומטפל בהרשאות הגישה למצלמה. -

app/src/main/java/com/google/ai/edge/examples/image_segmentation/MainViewModel.kt: ה-ViewModel הזה מנהל את מצב ממשק המשתמש ומתאם את תהליך פילוח התמונה. -

app/src/main/java/com/google/ai/edge/examples/image_segmentation/ImageSegmentationHelper.kt: כאן נוסיף את הלוגיקה המרכזית של פילוח התמונה. הוא יטפל בטעינת המודל, בעיבוד של פריימים מהמצלמה ובהרצת ההסקה. -

app/src/main/java/com/google/ai/edge/examples/image_segmentation/view/CameraScreen.kt: פונקציית ה-Composable הזו מציגה את התצוגה המקדימה של המצלמה ואת שכבת העל של חלוקת הגוף. -

app/download_model.gradle: הסקריפט הזה מוריד אתselfie_multiclass.tflite. זהו מודל פילוח תמונות של TensorFlow Lite שעבר אימון מראש, ובו נשתמש.

5. הסבר על LiteRT והוספת יחסי תלות

עכשיו נוסיף לאפליקציית המתחילים את הפונקציונליות של פילוח התמונה.

1. הוספת התלות ב-LiteRT

קודם כל, צריך להוסיף את הספרייה LiteRT לפרויקט. זהו השלב הראשון והחשוב בהפעלת למידת מכונה במכשיר באמצעות זמן הריצה המותאם של Google.

פותחים את הקובץ app/build.gradle.kts ומוסיפים את השורה הבאה לבלוק dependencies:

// LiteRT for on-device ML

implementation(libs.litert)

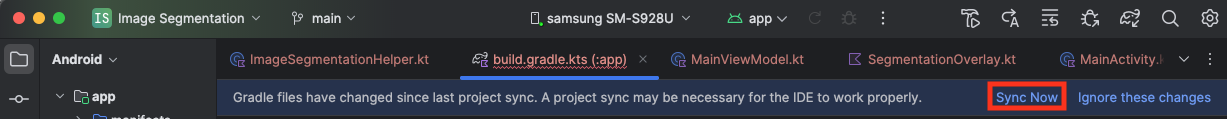

אחרי שמוסיפים את התלות, מסנכרנים את הפרויקט עם קובצי Gradle על ידי לחיצה על הלחצן Sync Now (סנכרון עכשיו) שמופיע בפינה השמאלית העליונה של Android Studio.

2. הסבר על ממשקי API מרכזיים של LiteRT

פתיחה ImageSegmentationHelper.kt

לפני שכותבים את קוד ההטמעה, חשוב להבין את רכיבי הליבה של LiteRT API שבהם תשתמשו. מוודאים שמייבאים מחבילת com.google.ai.edge.litert, ומוסיפים את הייבוא הבא לחלק העליון של ImageSegmentationHelper.kt:

import com.google.ai.edge.litert.Accelerator

import com.google.ai.edge.litert.CompiledModel

-

CompiledModel: זו המחלקה המרכזית לאינטראקציה עם מודל TFLite. הוא מייצג מודל שעבר קומפילציה מראש ואופטימיזציה למאיץ חומרה ספציפי (כמו המעבד או ה-GPU). הקומפילציה המוקדמת הזו היא תכונה מרכזית של LiteRT שמובילה להסקת מסקנות מהירה ויעילה יותר. -

CompiledModel.Options: משתמשים במחלקה הזו של Builder כדי להגדיר אתCompiledModel. ההגדרה הכי חשובה היא ציון של מאיץ החומרה שרוצים להשתמש בו להרצת המודל. -

Accelerator: באמצעות ה-enum הזה אפשר לבחור את החומרה להסקת מסקנות. פרויקט המתחילים כבר מוגדר לטיפול באפשרויות האלה:-

Accelerator.CPU: להרצת המודל ב-CPU של המכשיר. זו האפשרות הכי תואמת לכל המכשירים. -

Accelerator.GPU: להרצת המודל ב-GPU של המכשיר. לרוב, התהליך הזה מהיר משמעותית יותר מאשר במעבד (CPU) במודלים שמבוססים על תמונות.

-

- מאגרי קלט ופלט (

TensorBuffer): LiteRT משתמש ב-TensorBufferלקלט ולפלט של המודל. כך אתם יכולים לשלוט במדויק בזיכרון ולמנוע העתקות מיותרות של נתונים. תקבלו את המאגרים האלה ישירות ממופעCompiledModelבאמצעותmodel.createInputBuffers()ו-model.createOutputBuffers(), ואז תכתבו בהם את נתוני הקלט ותקראו מהם את התוצאות. -

model.run(): הפונקציה שמבצעת את ההסקה. מעבירים אליו את מאגרי הקלט והפלט, ו-LiteRT מטפל במשימה המורכבת של הפעלת המודל במאיץ החומרה שנבחר.

6. סיום ההטמעה הראשונית של ImageSegmentationHelper

עכשיו הגיע הזמן לכתוב קוד. תשלימו את ההטמעה הראשונית של ImageSegmentationHelper.kt. התהליך כולל הגדרה של Segmenter מחלקה פרטית להחזקת מודל LiteRT והטמעה של הפונקציה cleanup() כדי לשחרר אותו בצורה נכונה.

- משלימים את המחלקה

Segmenterואת הפונקציהcleanup(): בקובץImageSegmentationHelper.ktיש תבנית של מחלקה פרטית בשםSegmenterופונקציה בשםcleanup(). קודם כול, משלימים את המחלקהSegmenterעל ידי הגדרת בנאי שיכיל את המודל, יצירת מאפיינים למאגרי הקלט והפלט והוספת שיטהclose()לשחרור המודל. לאחר מכן, מטמיעים את הפונקציהcleanup()כדי להפעיל את ה-method החדשclose().מחליפים את המחלקהSegmenterהקיימת ואת הפונקציהcleanup()בקוד הבא: (בערך שורה 83)private class Segmenter( // Add this argument private val model: CompiledModel, private val coloredLabels: List<ColoredLabel>, ) { // Add these private vals private val inputBuffers = model.createInputBuffers() private val outputBuffers = model.createOutputBuffers() fun cleanup() { // cleanup buffers inputBuffers.forEach { it.close() } outputBuffers.forEach { it.close() } // cleanup model model.close() } } - הגדרת השיטה toAccelerator: השיטה הזו ממפה את ה-enums של קיצורי הדרך שהוגדרו בתפריט קיצורי הדרך ל-enums של קיצורי הדרך שספציפיים למודולים המיובאים של LiteRT (בערך שורה 225):

fun toAccelerator(acceleratorEnum: AcceleratorEnum): Accelerator { return when (acceleratorEnum) { AcceleratorEnum.CPU -> Accelerator.CPU AcceleratorEnum.GPU -> Accelerator.GPU } } - מאתחלים את

CompiledModel: עכשיו מוצאים את הפונקציהinitSegmenter. כאן תיצרו את מופעCompiledModelותשתמשו בו כדי ליצור מופע של המחלקהSegmenterשהגדרתם עכשיו. הקוד הזה מגדיר את המודל עם המאיץ שצוין (CPU או GPU) ומכין אותו להסקת מסקנות. מחליפים אתTODOב-initSegmenterבהטמעה הבאה (Cmd/Ctrl+f 'initSegmenter` או שורה 62 בערך):cleanup() try { withContext(singleThreadDispatcher) { val model = CompiledModel.create( context.assets, "selfie_multiclass.tflite", CompiledModel.Options(toAccelerator(acceleratorEnum)), null, ) segmenter = Segmenter(model, coloredLabels) Log.d(TAG, "Created an image segmenter") } } catch (e: Exception) { Log.i(TAG, "Create LiteRT from selfie_multiclass is failed: ${e.message}") _error.emit(e) }

7. התחלת הפילוח והעיבוד המקדים

עכשיו שיש לנו מודל, אנחנו צריכים להפעיל את תהליך הפילוח ולהכין את נתוני הקלט בשביל המודל.

פילוח לפי טריגר

תהליך הפילוח מתחיל ב-MainViewModel.kt, שמקבל מסגרות מהמצלמה.

פתיחה MainViewModel.kt

- הפעלת חלוקת הגוף מתוך פריימים של המצלמה: הפונקציות

segmentב-MainViewModelהן נקודת הכניסה למשימת חלוקת הגוף שלנו. הפונקציות האלה מופעלות בכל פעם שתמונה חדשה זמינה מהמצלמה או נבחרת מהגלריה. הפונקציות האלה קוראות לשיטהsegmentב-ImageSegmentationHelper. מחליפים אתTODOבשתי הפונקציותsegmentבטקסט הבא (שורה 107 בערך):// For ImageProxy (from CameraX) fun segment(imageProxy: ImageProxy) { segmentJob = viewModelScope.launch { imageSegmentationHelper.segment(imageProxy.toBitmap(), imageProxy.imageInfo.rotationDegrees) imageProxy.close() } } // For Bitmaps (from gallery) fun segment(bitmap: Bitmap, rotationDegrees: Int) { segmentJob = viewModelScope.launch { val argbBitmap = bitmap.copy(Bitmap.Config.ARGB_8888, true) imageSegmentationHelper.segment(argbBitmap, rotationDegrees) } }

עיבוד מקדים של התמונה

עכשיו נחזור אל ImageSegmentationHelper.kt כדי לטפל בעיבוד המקדים של התמונה.

פתיחה ImageSegmentationHelper.kt

- הטמעה של פונקציית Public

segment: הפונקציה הזו משמשת כ-wrapper שקורא לפונקציית privatesegmentבתוך המחלקהSegmenter. מחליפים אתTODOב- (~line 95):try { withContext(singleThreadDispatcher) { segmenter?.segment(bitmap, rotationDegrees)?.let { if (isActive) _segmentation.emit(it) } } } catch (e: Exception) { Log.i(TAG, "Image segment error occurred: ${e.message}") _error.emit(e) } - הטמעה של עיבוד מקדים: הפונקציה הפרטית

segmentבתוך המחלקהSegmenterהיא המקום שבו נבצע את השינויים הנדרשים בתמונת הקלט כדי להכין אותה למודל. הפעולות האלה כוללות שינוי גודל, סיבוב ונרמול של התמונה. הפונקציה הזו תקרא לפונקציה פרטית אחרתsegmentכדי לבצע את ההסקה. מחליפים אתTODOבפונקציהsegment(bitmap: Bitmap, ...)(בערך בשורה 121):val totalStartTime = SystemClock.uptimeMillis() val rotation = -rotationDegrees / 90 val (h, w) = Pair(256, 256) // Preprocessing val preprocessStartTime = SystemClock.uptimeMillis() var image = bitmap.scale(w, h, true) image = rot90Clockwise(image, rotation) val inputFloatArray = normalize(image, 127.5f, 127.5f) Log.d(TAG, "Preprocessing time: ${SystemClock.uptimeMillis() - preprocessStartTime} ms") // Inference val inferenceStartTime = SystemClock.uptimeMillis() val segmentResult = segment(inputFloatArray) Log.d(TAG, "Inference time: ${SystemClock.uptimeMillis() - inferenceStartTime} ms") Log.d(TAG, "Total segmentation time: ${SystemClock.uptimeMillis() - totalStartTime} ms") return SegmentationResult(segmentResult, SystemClock.uptimeMillis() - inferenceStartTime)

8. הסקת מסקנות ראשונית באמצעות LiteRT

אחרי העיבוד המקדים של נתוני הקלט, אפשר להריץ את ההסקה המרכזית באמצעות LiteRT.

פתיחה ImageSegmentationHelper.kt

- הטמעת הפעלת המודל: הפונקציה הפרטית

segment(inputFloatArray: FloatArray)היא המקום שבו מתבצעת אינטראקציה ישירה עם השיטהrun()של LiteRT. אנחנו כותבים את הנתונים שעברו עיבוד מראש למאגר הקלט, מריצים את המודל וקוראים את התוצאות ממאגר הפלט. מחליפים אתTODOבפונקציה הזו (בערך בשורה 188):val (h, w, c) = Triple(256, 256, 6) // MODEL EXECUTION PHASE val modelExecStartTime = SystemClock.uptimeMillis() // Write input data - measure time val bufferWriteStartTime = SystemClock.uptimeMillis() inputBuffers[0].writeFloat(inputFloatArray) val bufferWriteTime = SystemClock.uptimeMillis() - bufferWriteStartTime Log.d(TAG, "Buffer write time: $bufferWriteTime ms") // Optional tensor inspection logTensorStats("Input tensor", inputFloatArray) // Run model inference - measure time val modelRunStartTime = SystemClock.uptimeMillis() model.run(inputBuffers, outputBuffers) val modelRunTime = SystemClock.uptimeMillis() - modelRunStartTime Log.d(TAG, "Model.run() time: $modelRunTime ms") // Read output data - measure time val bufferReadStartTime = SystemClock.uptimeMillis() val outputFloatArray = outputBuffers[0].readFloat() val outputBuffer = FloatBuffer.wrap(outputFloatArray) val bufferReadTime = SystemClock.uptimeMillis() - bufferReadStartTime Log.d(TAG, "Buffer read time: $bufferReadTime ms") val modelExecTime = SystemClock.uptimeMillis() - modelExecStartTime Log.d(TAG, "Total model execution time: $modelExecTime ms") // Optional tensor inspection logTensorStats("Output tensor", outputFloatArray) // POSTPROCESSING PHASE val postprocessStartTime = SystemClock.uptimeMillis() // Process mask from model output val inferenceData = InferenceData(width = w, height = h, channels = c, buffer = outputBuffer) val mask = processImage(inferenceData) val postprocessTime = SystemClock.uptimeMillis() - postprocessStartTime Log.d(TAG, "Postprocessing time (mask creation): $postprocessTime ms") return Segmentation( listOf(Mask(mask, inferenceData.width, inferenceData.height)), coloredLabels, )

9. עיבוד תמונה (Post Processing) והצגת שכבת-העל

אחרי שמריצים את ההסקה, מקבלים פלט גולמי מהמודל. אנחנו צריכים לעבד את הפלט הזה כדי ליצור מסכת פילוח חזותית ואז להציג אותה על המסך.

פתיחה ImageSegmentationHelper.kt

- הטמעה של עיבוד הפלט: הפונקציה

processImageממירה את פלט הנקודה הצפה הגולמי מהמודל ל-ByteBufferשמייצג את מסכת הפילוח. הוא עושה את זה על ידי מציאת המחלקה עם ההסתברות הכי גבוהה לכל פיקסל. מחליפים אתTODOשלו ב- (~line 238):val mask = ByteBuffer.allocateDirect(inferenceData.width * inferenceData.height) for (i in 0 until inferenceData.height) { for (j in 0 until inferenceData.width) { val offset = inferenceData.channels * (i * inferenceData.width + j) var maxIndex = 0 var maxValue = inferenceData.buffer.get(offset) for (index in 1 until inferenceData.channels) { if (inferenceData.buffer.get(offset + index) > maxValue) { maxValue = inferenceData.buffer.get(offset + index) maxIndex = index } } mask.put(i * inferenceData.width + j, maxIndex.toByte()) } } return mask

פתיחה MainViewModel.kt

- איסוף ועיבוד של תוצאות הפילוח: עכשיו חוזרים אל

MainViewModelכדי לעבד את תוצאות הפילוח מ-ImageSegmentationHelper. ה-segmentationUiShareFlowאוסף אתSegmentationResult, ממיר את המסכה לBitmapצבעוני ומספק אותה לממשק המשתמש. מחליפים אתTODOבנכסsegmentationUiShareFlowב- (~line 63) – לא מחליפים את הקוד שכבר נמצא שם, רק ממלאים את הגוף:viewModelScope.launch { imageSegmentationHelper.segmentation .filter { it.segmentation.masks.isNotEmpty() } .map { val segmentation = it.segmentation val mask = segmentation.masks[0] val maskArray = mask.data val width = mask.width val height = mask.height val pixelSize = width * height val pixels = IntArray(pixelSize) val colorLabels = segmentation.coloredLabels.mapIndexed { index, coloredLabel -> ColorLabel(index, coloredLabel.label, coloredLabel.argb) } // Set color for pixels for (i in 0 until pixelSize) { val colorLabel = colorLabels[maskArray[i].toInt()] val color = colorLabel.getColor() pixels[i] = color } // Get image info val overlayInfo = OverlayInfo(pixels = pixels, width = width, height = height) val inferenceTime = it.inferenceTime Pair(overlayInfo, inferenceTime) } .collect { flow.emit(it) } }

פתיחה view/SegmentationOverlay.kt

השלב האחרון הוא להגדיר את שכבת-העל של הפילוח כך שתהיה בכיוון הנכון כשהמשתמש עובר למצלמה הקדמית. הפיד מהמצלמה הקדמית עובר היפוך מראה באופן טבעי, ולכן צריך להחיל את אותו היפוך אופקי על שכבת העל Bitmap כדי לוודא שהיא מיושרת בצורה נכונה עם התצוגה המקדימה של המצלמה.

- Handle Overlay Orientation: מאתרים את

TODOבקובץSegmentationOverlay.ktומחליפים אותו בקוד הבא. הקוד הזה בודק אם המצלמה הקדמית פעילה, ואם כן, הוא הופך את שכבת העלBitmapאופקית לפני שהיא מצוירת עלCanvas. (~line 42):val orientedBitmap = if (lensFacing == CameraSelector.LENS_FACING_FRONT) { // Create a matrix for horizontal flipping val matrix = Matrix().apply { preScale(-1f, 1f) } Bitmap.createBitmap(image, 0, 0, image.width, image.height, matrix, false).also { image.recycle() } } else { image }

10. הרצה ושימוש באפליקציה הסופית

השלמתם את כל השינויים הנדרשים בקוד. הגיע הזמן להריץ את האפליקציה ולראות את העבודה שלכם בפעולה.

- מריצים את האפליקציה: מחברים את מכשיר Android ולוחצים על Run (הפעלה) בסרגל הכלים של Android Studio.

- בדיקת התכונות: אחרי שהאפליקציה תופעל, אמור להופיע פיד חי מהמצלמה עם שכבת-על צבעונית של פילוח.

- החלפת מצלמות: מקישים על סמל החלפת המצלמות בחלק העליון כדי לעבור בין המצלמה הקדמית למצלמה האחורית. שימו לב איך שכבת העל מסתובבת בצורה נכונה.

- שינוי המאיץ: מקישים על הלחצן 'CPU' או 'GPU' בתחתית כדי להחליף את מאיץ החומרה. בודקים את השינוי בזמן ההסקה שמוצג בתחתית המסך. ה-GPU צריך להיות מהיר משמעותית.

- שימוש בתמונה מהגלריה: מקישים על הכרטיסייה 'גלריה' בחלק העליון כדי לבחור תמונה מגלריית התמונות במכשיר. האפליקציה תריץ פילוח על התמונה הסטטית שנבחרה.

עכשיו יש לכם אפליקציה פונקציונלית לחלוטין לפילוח תמונות בזמן אמת, שמבוססת על LiteRT!

11. מתקדם (אופציונלי): שימוש ב-NPU

מאגר הנתונים הזה מכיל גם גרסה של האפליקציה שעברה אופטימיזציה ליחידות עיבוד עצביות (NPU). הגרסה של NPU יכולה לספק שיפור משמעותי בביצועים במכשירים שיש להם NPU תואם.

כדי לנסות את הגרסה של NPU, פותחים את הפרויקט kotlin_npu/android ב-Android Studio. הקוד דומה מאוד לגרסת ה-CPU/GPU, והוא מוגדר להשתמש בנציג ה-NPU.

כדי להשתמש בנציג NPU, צריך להירשם לתוכנית הגישה המוקדמת.

12. מעולה!

יצרתם בהצלחה אפליקציית Android שמבצעת פילוח תמונות בזמן אמת באמצעות LiteRT. למדתם איך:

- משלבים את זמן הריצה של LiteRT באפליקציה ל-Android.

- טעינה והרצה של מודל פילוח תמונות של TFLite.

- מעבדים מראש את הקלט של המודל.

- מעבדים את הפלט של המודל כדי ליצור מסכת פילוח.

- משתמשים ב-CameraX כדי ליצור אפליקציית מצלמה בזמן אמת.

השלבים הבאים

- אפשר לנסות מודל אחר של פילוח תמונות.

- מתנסים בנציגי LiteRT שונים (CPU, GPU, NPU).