Glosarium ini mendefinisikan istilah kecerdasan buatan.

A

ablasi

Teknik untuk mengevaluasi pentingnya fitur atau komponen dengan menghapusnya sementara dari model. Kemudian, Anda melatih ulang model tanpa fitur atau komponen tersebut, dan jika performa model yang dilatih ulang jauh lebih buruk, maka fitur atau komponen yang dihapus kemungkinan penting.

Misalnya, Anda melatih model klasifikasi pada 10 fitur dan mencapai presisi 88% pada set pengujian. Untuk memeriksa kepentingan fitur pertama, Anda dapat melatih ulang model hanya menggunakan sembilan fitur lainnya. Jika model yang dilatih ulang berperforma jauh lebih buruk (misalnya, presisi 55%), maka fitur yang dihapus mungkin penting. Sebaliknya, jika model yang dilatih ulang memiliki performa yang sama baiknya, maka fitur tersebut mungkin tidak terlalu penting.

Ablasi juga dapat membantu menentukan pentingnya:

- Komponen yang lebih besar, seperti seluruh subsistem dari sistem ML yang lebih besar

- Proses atau teknik, seperti langkah pra-pemrosesan data

Dalam kedua kasus tersebut, Anda akan mengamati perubahan (atau tidak adanya perubahan) performa sistem setelah Anda menghapus komponen.

Pengujian A/B

Cara statistik untuk membandingkan dua (atau lebih) teknik—A dan B. Biasanya, A adalah teknik yang sudah ada, dan B adalah teknik baru. Pengujian A/B tidak hanya menentukan teknik mana yang berperforma lebih baik, tetapi juga apakah perbedaannya signifikan secara statistik.

Pengujian A/B biasanya membandingkan satu metrik pada dua teknik; misalnya, bagaimana perbandingan akurasi model untuk dua teknik? Namun, pengujian A/B juga dapat membandingkan sejumlah metrik terbatas.

chip akselerator

Kategori komponen hardware khusus yang dirancang untuk melakukan komputasi utama yang diperlukan untuk algoritma deep learning.

Chip akselerator (atau cukup akselerator) dapat meningkatkan kecepatan dan efisiensi tugas pelatihan dan inferensi secara signifikan dibandingkan dengan CPU serbaguna. VM ini ideal untuk melatih jaringan neural dan tugas intensif komputasi serupa.

Contoh chip akselerator meliputi:

- Tensor Processing Unit (TPU) Google dengan hardware khusus untuk deep learning.

- GPU NVIDIA yang, meskipun awalnya dirancang untuk pemrosesan grafis, dirancang untuk memungkinkan pemrosesan paralel, yang dapat meningkatkan kecepatan pemrosesan secara signifikan.

akurasi

Jumlah prediksi klasifikasi yang benar dibagi dengan total jumlah prediksi. Definisinya yaitu:

Misalnya, model yang membuat 40 prediksi yang benar dan 10 prediksi yang salah akan memiliki akurasi:

Klasifikasi biner memberikan nama tertentu untuk berbagai kategori prediksi yang benar dan prediksi yang salah. Jadi, rumus akurasi untuk klasifikasi biner adalah sebagai berikut:

dalam hal ini:

- TP adalah jumlah positif benar (prediksi yang benar).

- TN adalah jumlah negatif benar (prediksi yang benar).

- FP adalah jumlah positif palsu (prediksi yang salah).

- FN adalah jumlah negatif palsu (prediksi yang salah).

Bandingkan dan bedakan akurasi dengan presisi dan perolehan.

Lihat Klasifikasi: Akurasi, perolehan, presisi, dan metrik terkait di Kursus Singkat Machine Learning untuk mengetahui informasi selengkapnya.

tindakan

Dalam reinforcement learning, mekanisme yang digunakan agen untuk bertransisi antara status lingkungan. Agen memilih tindakan dengan menggunakan kebijakan.

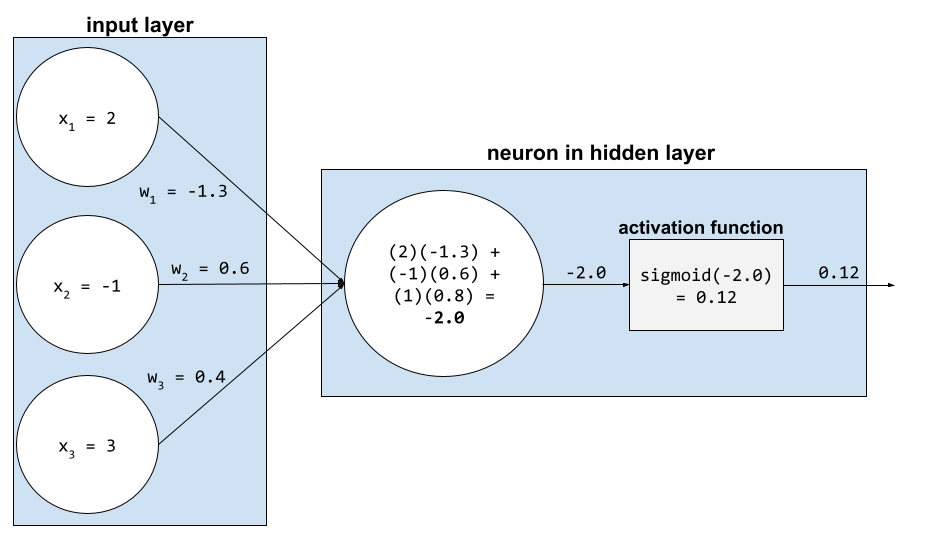

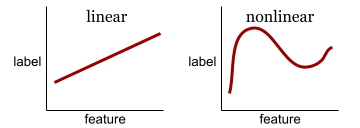

fungsi aktivasi

Fungsi yang memungkinkan jaringan neural mempelajari hubungan non-linear (kompleks) antara fitur dan label.

Fungsi aktivasi populer meliputi:

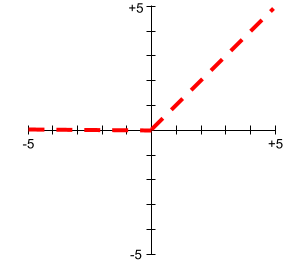

Plot fungsi aktivasi tidak pernah berupa garis lurus tunggal. Misalnya, plot fungsi aktivasi ReLU terdiri dari dua garis lurus:

Plot fungsi aktivasi sigmoid akan terlihat seperti berikut:

Lihat Jaringan neural: Fungsi aktivasi di Kursus Singkat Machine Learning untuk mengetahui informasi selengkapnya.

pembelajaran aktif

Pendekatan pelatihan yang memungkinkan algoritma memilih beberapa data yang dipelajarinya. Pembelajaran aktif sangat berharga jika contoh berlabel langka atau mahal untuk didapatkan. Daripada mencari berbagai contoh berlabel secara membabi buta, algoritma pembelajaran aktif secara selektif mencari berbagai contoh yang dibutuhkan untuk pembelajaran.

AdaGrad

Algoritma penurunan gradien mutakhir yang menskalakan ulang gradien dari tiap parameter, yang secara efektif memberikan kecepatan pembelajaran independen ke tiap parameter. Untuk penjelasan selengkapnya, lihat Adaptive Subgradient Methods for Online Learning and Stochastic Optimization.

adaptasi

Sinonim untuk penyesuaian atau penyesuaian.

agen

Software yang dapat memproses input pengguna multimodal untuk merencanakan dan mengeksekusi tindakan atas nama pengguna.

Dalam reinforcement learning, agen adalah entitas yang menggunakan kebijakan untuk memaksimalkan hasil yang diharapkan dari transisi antara status lingkungan.

agentik

Bentuk adjektif dari agen. Agentik mengacu pada kualitas yang dimiliki agen (seperti otonomi).

alur kerja agentic

Proses dinamis di mana agen secara otonom merencanakan dan mengeksekusi tindakan untuk mencapai sasaran. Prosesnya dapat melibatkan penalaran, pemanggilan alat eksternal, dan mengoreksi sendiri rencananya.

pengelompokan aglomeratif

Lihat pengelompokan hierarkis.

Kemiringan AI

Output dari sistem AI generatif yang lebih mengutamakan kuantitas daripada kualitas. Misalnya, halaman web dengan konten buatan AI yang tidak bermutu diisi dengan konten berkualitas rendah buatan AI yang diproduksi dengan murah.

deteksi anomali

Proses mengidentifikasi pencilan. Misalnya, jika rata-rata untuk fitur tertentu adalah 100 dengan standar deviasi 10, maka deteksi anomali akan menandai nilai 200 sebagai mencurigakan.

AR

Singkatan dari augmented reality.

area di bawah kurva PR

Lihat AUC PR (Area di bawah Kurva PR).

area di bawah kurva ROC

Lihat AUC (Area di bawah kurva ROC).

kecerdasan umum buatan

Mekanisme non-manusia yang menunjukkan berbagai macam kemampuan memecahkan masalah, kreativitas, dan adaptasi. Misalnya, program yang mendemonstrasikan kecerdasan umum buatan dapat menerjemahkan teks, menyusun simfoni, dan unggul dalam game yang belum ditemukan.

kecerdasan buatan

Program atau model non-manusia yang dapat menyelesaikan tugas-tugas rumit. Misalnya, program atau model yang menerjemahkan teks atau program atau model yang mengidentifikasi penyakit dari gambar radiologi keduanya menunjukkan kecerdasan buatan.

Secara formal, machine learning adalah subbidang kecerdasan buatan. Namun, dalam beberapa tahun terakhir, beberapa organisasi mulai menggunakan istilah kecerdasan buatan dan machine learning secara bergantian.

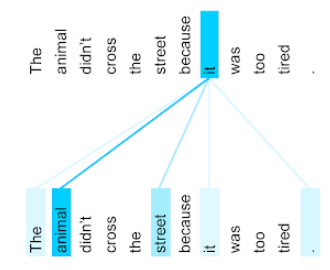

Attention,

Mekanisme yang digunakan dalam jaringan neural yang menunjukkan pentingnya kata atau bagian kata tertentu. Mekanisme perhatian memadatkan jumlah informasi yang dibutuhkan model untuk memprediksi token/kata berikutnya. Mekanisme atensi umum dapat terdiri dari jumlah berbobot atas sekumpulan input, dengan bobot untuk setiap input dihitung oleh bagian lain dari jaringan neural.

Lihat juga self-attention dan multi-head self-attention, yang merupakan blok penyusun Transformer.

Lihat LLM: Apa itu model bahasa besar? di Kursus Singkat Machine Learning untuk mengetahui informasi selengkapnya tentang self-attention.

atribut

Sinonim untuk fitur.

Dalam keadilan machine learning, atribut sering kali merujuk pada karakteristik yang berkaitan dengan individu.

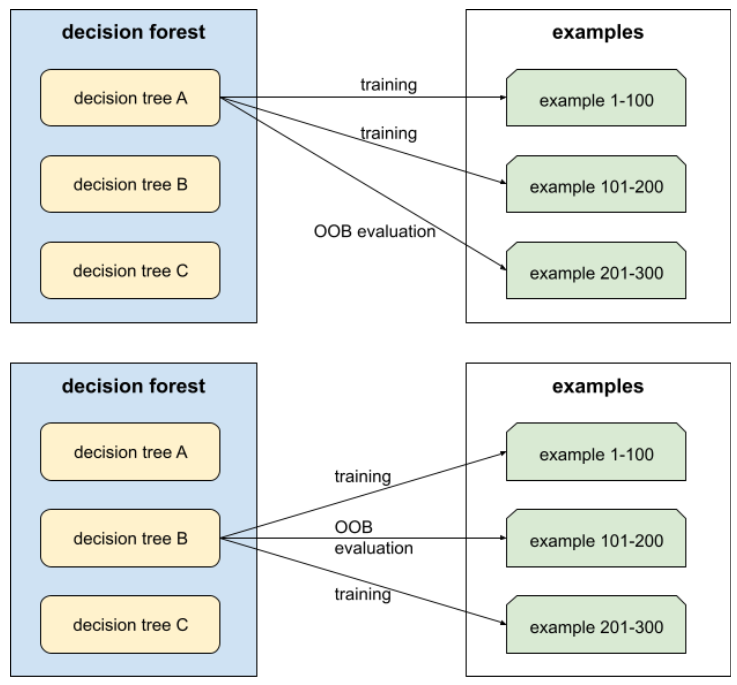

pengambilan sampel atribut

Taktik untuk melatih hutan keputusan yang setiap pohon keputusannya hanya mempertimbangkan subset acak dari fitur yang mungkin saat mempelajari kondisi. Umumnya, subset fitur yang berbeda diambil sampelnya untuk setiap node. Sebaliknya, saat melatih pohon keputusan tanpa pengambilan sampel atribut, semua fitur yang mungkin dipertimbangkan untuk setiap node.

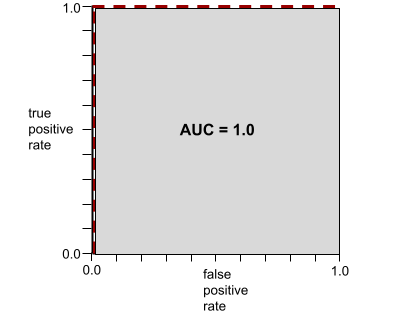

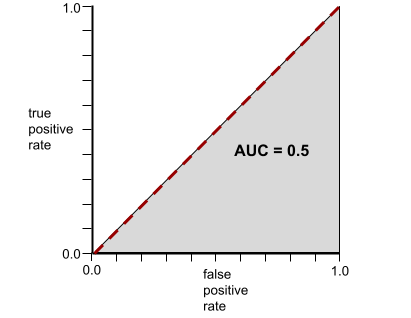

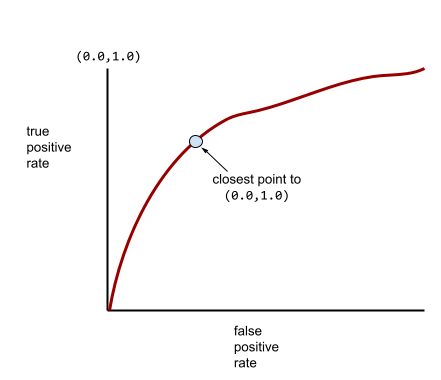

AUC (Area di bawah kurva ROC)

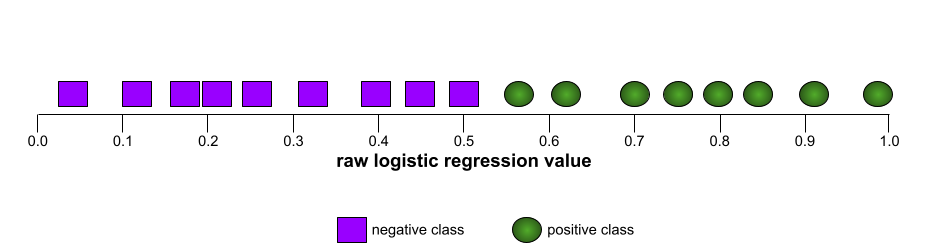

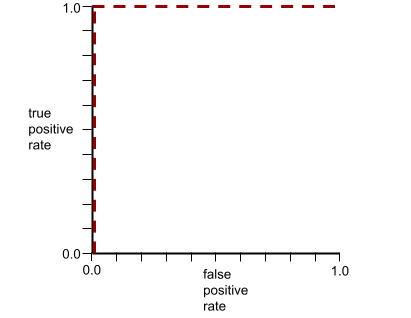

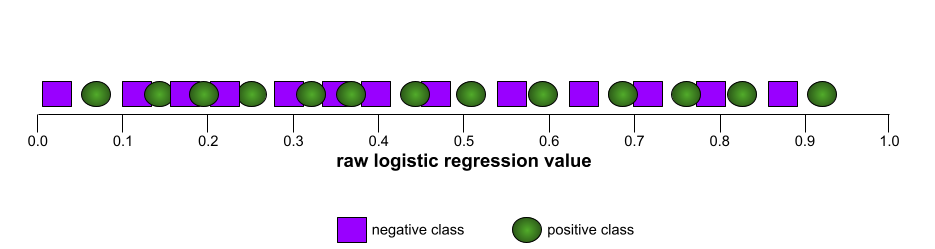

Angka antara 0,0 dan 1,0 yang merepresentasikan kemampuan model klasifikasi biner untuk memisahkan kelas positif dari kelas negatif. Semakin dekat AUC ke 1,0, semakin baik kemampuan model untuk memisahkan kelas satu sama lain.

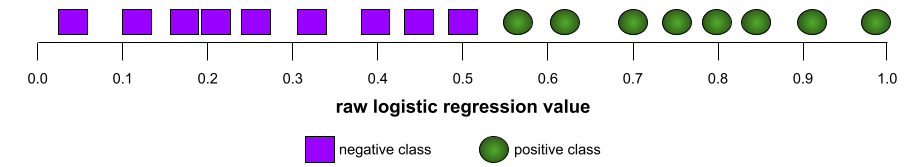

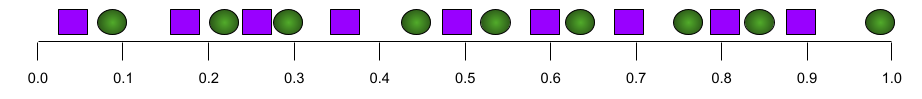

Misalnya, ilustrasi berikut menunjukkan model klasifikasi yang memisahkan kelas positif (oval hijau) dari kelas negatif (persegi panjang ungu) dengan sempurna. Model yang sempurna secara tidak realistis ini memiliki AUC 1,0:

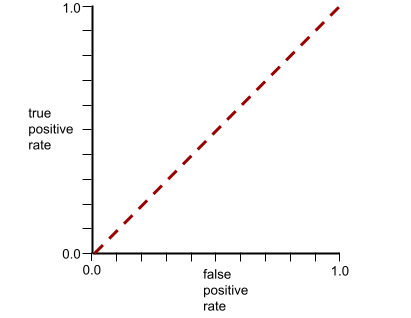

Sebaliknya, ilustrasi berikut menunjukkan hasil untuk model klasifikasi yang menghasilkan hasil acak. Model ini memiliki AUC 0,5:

Ya, model sebelumnya memiliki AUC 0,5, bukan 0,0.

Sebagian besar model berada di antara dua ekstrem tersebut. Misalnya, model berikut memisahkan positif dari negatif, dan oleh karena itu memiliki AUC antara 0,5 dan 1,0:

AUC mengabaikan nilai apa pun yang Anda tetapkan untuk nilai minimum klasifikasi. Sebagai gantinya, AUC mempertimbangkan semua kemungkinan batas klasifikasi.

Lihat Klasifikasi: KOP dan ABK di Kursus Singkat Machine Learning untuk mengetahui informasi selengkapnya.

augmented reality

Teknologi yang menempatkan gambar buatan komputer pada tampilan dunia nyata pengguna, sehingga memberikan tampilan komposit.

autoencoder

Sistem yang belajar untuk mengekstrak informasi paling penting dari input. Autoencoder adalah kombinasi encoder dan decoder. Autoencoder mengandalkan proses dua langkah berikut:

- Encoder memetakan input ke format (biasanya) lossy berdimensi lebih rendah (perantara).

- Decoder membuat versi input asli yang lossy dengan memetakan format berdimensi lebih rendah ke format input berdimensi lebih tinggi yang asli.

Autoencoder dilatih secara end-to-end dengan membuat decoder mencoba merekonstruksi input asli dari format perantara encoder sedekat mungkin. Karena format perantara lebih kecil (berdimensi lebih rendah) daripada format asli, autoencoder dipaksa untuk mempelajari informasi penting dalam input, dan output tidak akan sama persis dengan input.

Contoh:

- Jika data input berupa grafik, salinan tidak persis akan mirip dengan grafik asli, tetapi sedikit dimodifikasi. Mungkin salinan tidak persis akan menghilangkan derau dari grafik asli atau mengisi beberapa piksel yang hilang.

- Jika data input adalah teks, autoencoder akan menghasilkan teks baru yang meniru (tetapi tidak identik dengan) teks asli.

Lihat juga autoencoder variasional.

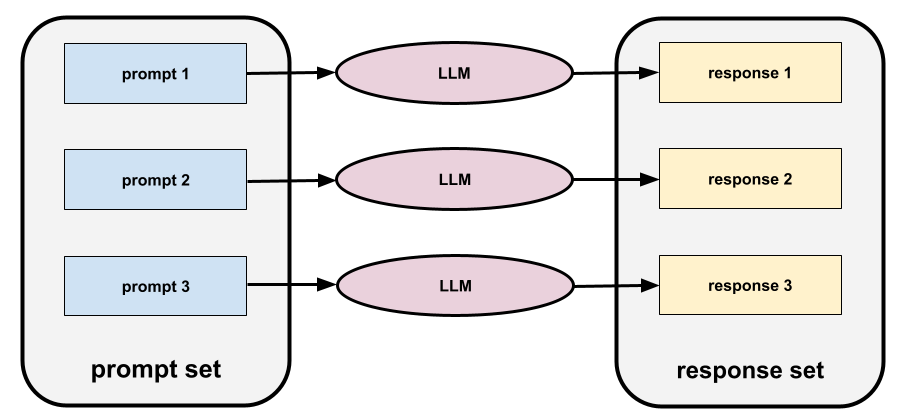

evaluasi otomatis

Menggunakan software untuk menilai kualitas output model.

Jika output model relatif sederhana, skrip atau program dapat membandingkan output model dengan respons ideal. Jenis evaluasi otomatis ini terkadang disebut evaluasi terprogram. Metrik seperti ROUGE atau BLEU sering kali berguna untuk evaluasi terprogram.

Jika output model kompleks atau tidak ada satu jawaban yang benar, program ML terpisah yang disebut penilai otomatis terkadang melakukan evaluasi otomatis.

Berbeda dengan evaluasi manual.

bias otomatisasi

Saat pengambil keputusan manusia lebih memilih rekomendasi yang dibuat oleh sistem pengambilan keputusan otomatis daripada informasi yang dibuat tanpa otomatisasi, meskipun sistem pengambilan keputusan otomatis tersebut membuat kesalahan.

Lihat Keadilan: Jenis bias di Kursus Singkat Machine Learning untuk mengetahui informasi selengkapnya.

AutoML

Proses otomatis apa pun untuk membangun model machine learning . AutoML dapat melakukan tugas seperti berikut secara otomatis:

- Cari model yang paling sesuai.

- Menyesuaikan hyperparameter.

- Siapkan data (termasuk melakukan rekayasa fitur).

- Deploy model yang dihasilkan.

AutoML berguna bagi data scientist karena dapat menghemat waktu dan upaya mereka dalam mengembangkan pipeline machine learning serta meningkatkan akurasi prediksi. Alat ini juga berguna bagi non-pakar, karena membuat tugas machine learning yang rumit lebih mudah diakses oleh mereka.

Lihat Machine Learning Otomatis (AutoML) di Kursus Singkat Machine Learning untuk mengetahui informasi selengkapnya.

evaluasi pemberi rating otomatis

Mekanisme hibrida untuk menilai kualitas output model AI generatif yang menggabungkan evaluasi manual dengan evaluasi otomatis. Penilai otomatis adalah model ML yang dilatih pada data yang dibuat oleh evaluasi manusia. Idealnya, pemberi rating otomatis belajar meniru evaluator manusia.Penilai otomatis bawaan tersedia, tetapi penilai otomatis terbaik adalah yang di-fine-tune secara khusus untuk tugas yang Anda evaluasi.

model autoregresif

Model yang menyimpulkan prediksi berdasarkan prediksi sebelumnya. Misalnya, model bahasa autoregresif memprediksi token berikutnya berdasarkan token yang diprediksi sebelumnya. Semua model bahasa besar berbasis Transformer bersifat autoregresif.

Sebaliknya, model gambar berbasis GAN biasanya tidak autoregresif karena menghasilkan gambar dalam satu penerusan ke depan dan tidak secara iteratif dalam langkah-langkah. Namun, model pembuatan gambar tertentu bersifat autoregresif karena model tersebut menghasilkan gambar secara bertahap.

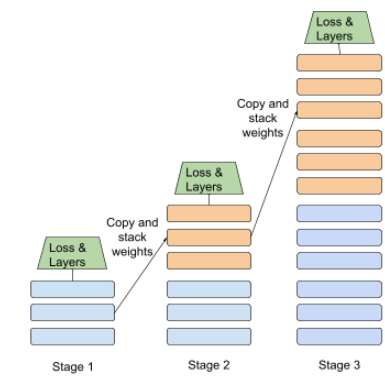

kerugian tambahan

Fungsi kerugian—yang digunakan bersama dengan jaringan neural model utama fungsi kerugian—yang membantu mempercepat pelatihan selama iterasi awal saat bobot diinisialisasi secara acak.

Fungsi kerugian tambahan mendorong gradien yang efektif ke lapisan sebelumnya. Hal ini memfasilitasi konvergensi selama pelatihan dengan mengatasi masalah gradien yang menghilang.

presisi rata-rata pada k

Metrik untuk meringkas performa model pada satu perintah yang menghasilkan hasil berperingkat, seperti daftar rekomendasi buku bernomor. Presisi rata-rata pada k, adalah rata-rata nilai presisi pada k untuk setiap hasil relevan. Oleh karena itu, rumus untuk presisi rata-rata pada k adalah:

\[{\text{average precision at k}} = \frac{1}{n} \sum_{i=1}^n {\text{precision at k for each relevant item} } \]

dalam hal ini:

- \(n\) adalah jumlah item yang relevan dalam daftar.

Berbeda dengan perolehan pada k.

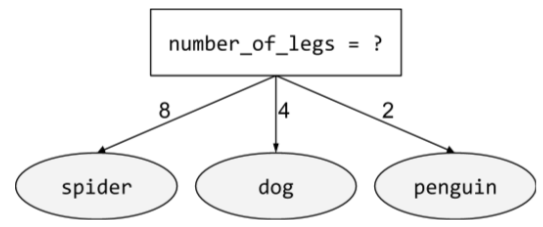

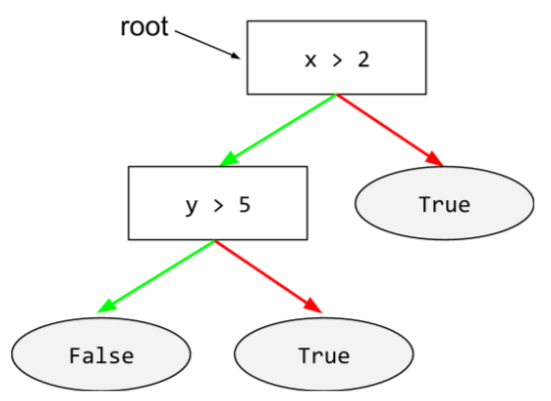

kondisi yang sejajar dengan sumbu

Dalam pohon keputusan, kondisi

yang hanya melibatkan satu fitur. Misalnya, jika area

adalah fitur, maka berikut adalah kondisi yang sejajar dengan sumbu:

area > 200

Berbeda dengan kondisi miring.

B

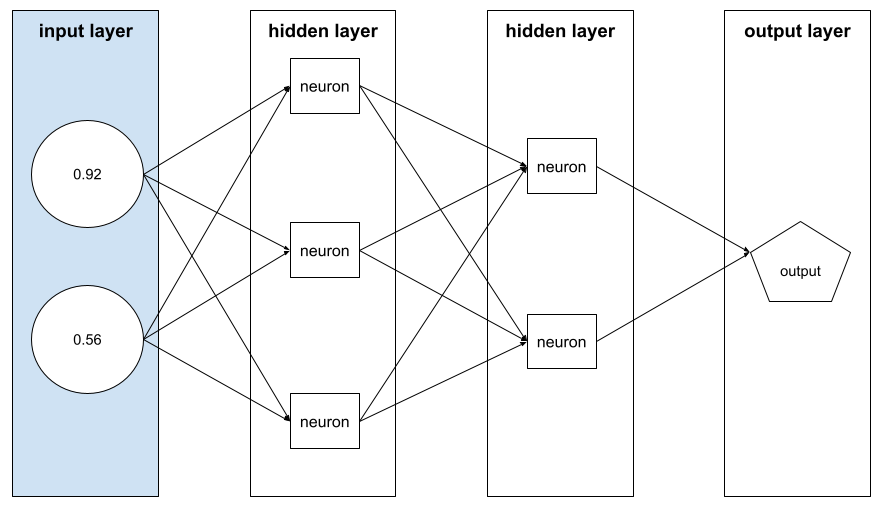

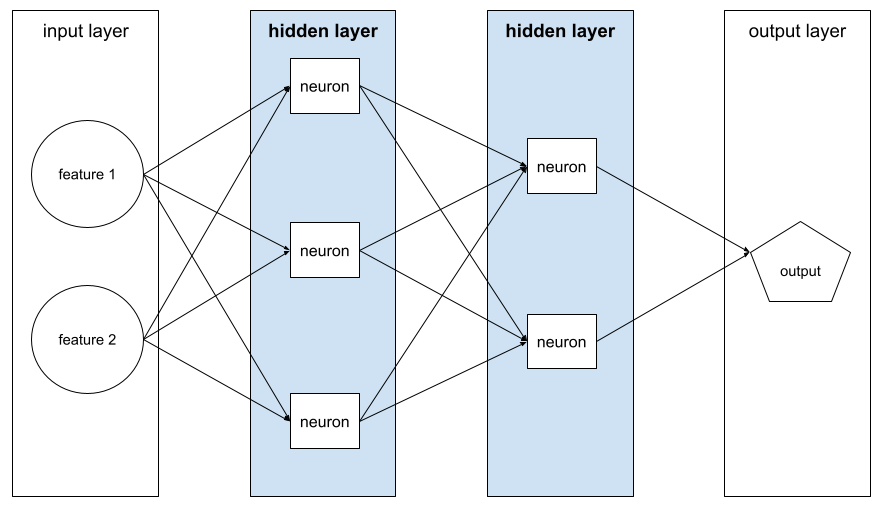

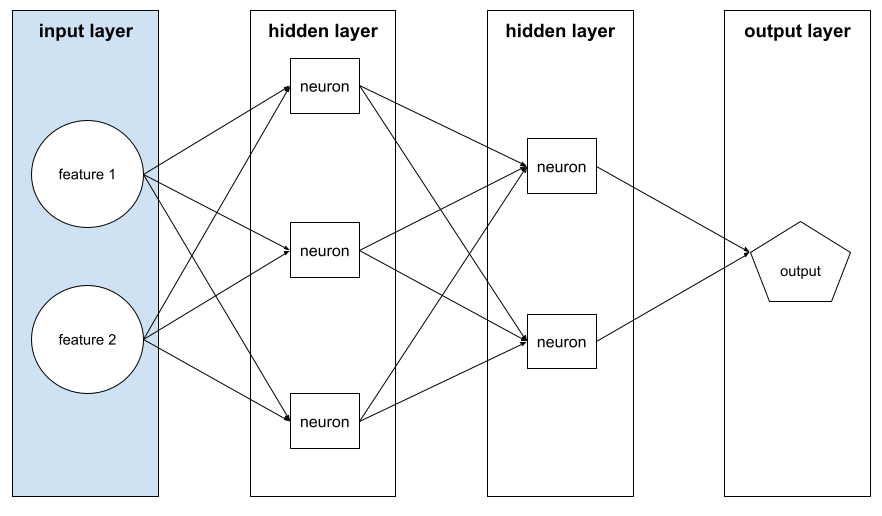

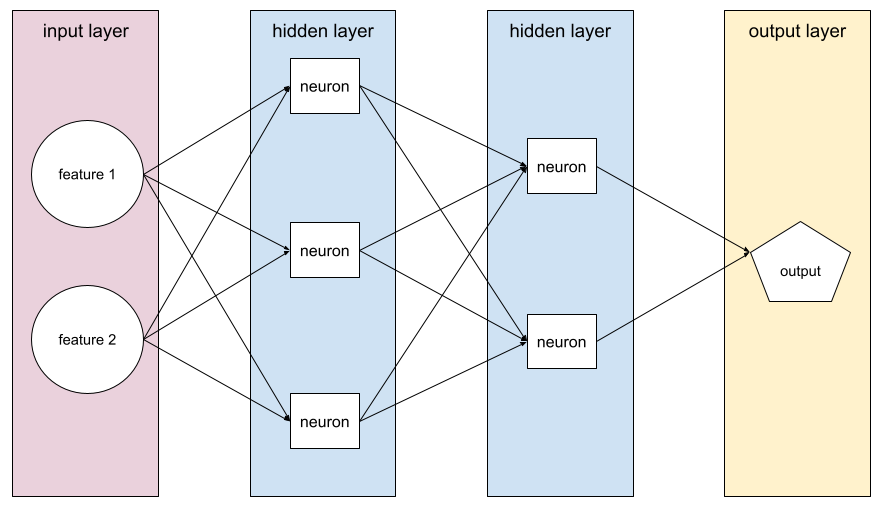

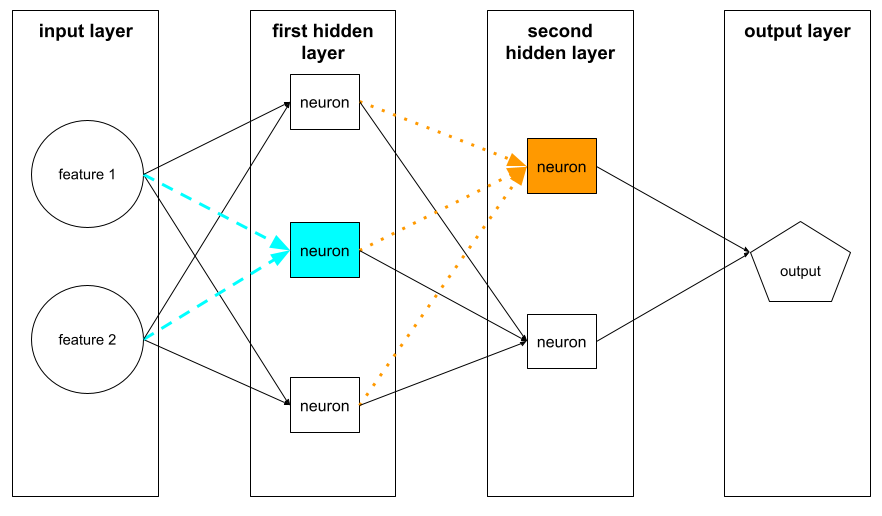

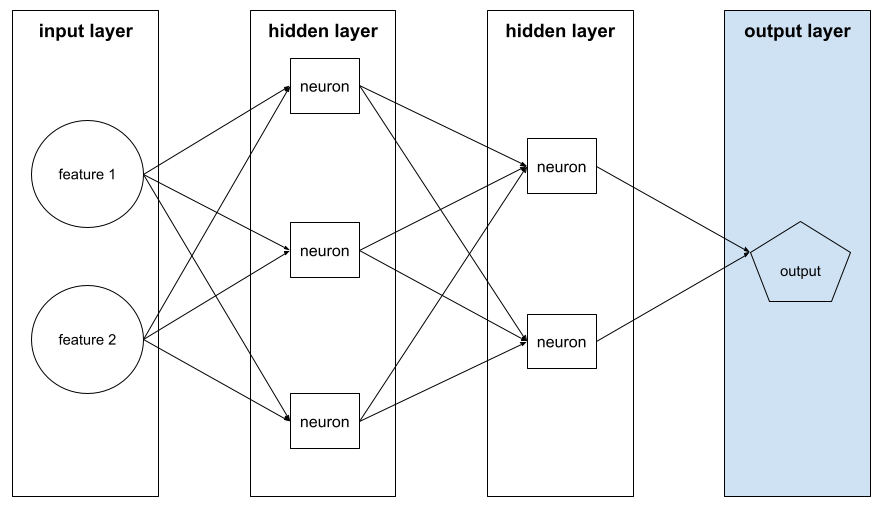

propagasi balik

Algoritma yang menerapkan penurunan gradien di jaringan neural.

Pelatihan jaringan neural melibatkan banyak iterasi dari siklus dua tahap berikut:

- Selama forward pass, sistem memproses batch contoh untuk menghasilkan prediksi. Sistem membandingkan setiap prediksi dengan setiap nilai label. Perbedaan antara prediksi dan nilai label adalah kerugian untuk contoh tersebut. Sistem menggabungkan kerugian untuk semua contoh guna menghitung total kerugian untuk batch saat ini.

- Selama backward pass (backpropagation), sistem mengurangi kerugian dengan menyesuaikan bobot semua neuron di semua lapisan tersembunyi.

Jaringan neural sering kali berisi banyak neuron di banyak lapisan tersembunyi. Setiap neuron tersebut berkontribusi pada keseluruhan kerugian dengan cara yang berbeda. Backpropagation menentukan apakah akan menambah atau mengurangi bobot yang diterapkan pada neuron tertentu.

Kecepatan pembelajaran adalah pengganda yang mengontrol tingkat kenaikan atau penurunan setiap bobot di setiap operasi backward. Kecepatan pembelajaran yang besar akan menaikkan atau menurunkan setiap bobot lebih banyak daripada kecepatan pembelajaran yang kecil.

Dalam istilah kalkulus, backpropagation mengimplementasikan aturan rantai. dari kalkulus. Artinya, backpropagation menghitung turunan parsial dari error yang terkait dengan setiap parameter.

Beberapa tahun lalu, praktisi ML harus menulis kode untuk menerapkan backpropagation. API ML modern seperti Keras kini menerapkan backpropagation untuk Anda. Fiuh!

Lihat Jaringan neural di Kursus Singkat Machine Learning untuk mengetahui informasi selengkapnya.

mengantongi

Metode untuk melatih ansambel dengan setiap model konstituen dilatih pada subset acak dari contoh pelatihan yang diambil sampelnya dengan penggantian. Misalnya, hutan acak adalah kumpulan pohon keputusan yang dilatih dengan bagging.

Istilah bagging adalah singkatan dari bootstrap aggregating.

Lihat Random forest di kursus Decision Forest untuk mengetahui informasi selengkapnya.

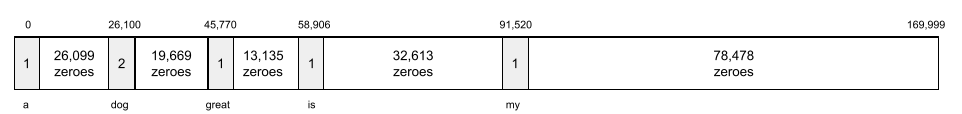

kantong kata

Representasi kata-kata dalam frasa atau bagian teks, terlepas dari urutannya. Misalnya, bag of words merepresentasikan tiga frasa berikut secara identik:

- melompat

- melompat

- melompati

Setiap kata dipetakan ke indeks dalam vektor renggang, dengan vektor memiliki indeks untuk setiap kata dalam kosakata. Misalnya, frasa the dog jumps dipetakan ke dalam vektor fitur dengan nilai bukan nol pada tiga indeks yang sesuai dengan kata-kata the, dog, dan jumps. Nilai bukan nol dapat berupa salah satu dari berikut:

- 1 untuk menunjukkan keberadaan sebuah kata.

- Jumlah frekuensi munculnya kata dalam kumpulan kata. Misalnya, jika frasanya adalah merah marun adalah dengan bulu merah marun, maka merah marun dan akan ditampilkan sebagai 2, sedangkan kata-kata lainnya akan ditampilkan sebagai 1.

- Nilai lain, seperti logaritma jumlah kemunculan suatu kata dalam bag.

dasar

Model yang digunakan sebagai titik referensi untuk membandingkan seberapa baik performa model lain (biasanya, model yang lebih kompleks). Misalnya, model regresi logistik dapat berfungsi sebagai dasar yang baik untuk model dalam.

Untuk masalah tertentu, tolok ukur membantu developer model mengukur performa minimum yang diharapkan yang harus dicapai oleh model baru agar model baru tersebut berguna.

model dasar

Model terlatih yang dapat berfungsi sebagai titik awal untuk penyesuaian guna menangani tugas atau aplikasi tertentu.

Lihat juga model terlatih dan model dasar.

batch

Kumpulan contoh yang digunakan dalam satu iterasi pelatihan. Ukuran batch menentukan jumlah contoh dalam batch.

Lihat epoch untuk penjelasan tentang hubungan batch dengan epoch.

Lihat Regresi linear: Hyperparameter di Kursus Singkat Machine Learning untuk mengetahui informasi selengkapnya.

inferensi batch

Proses menyimpulkan prediksi pada beberapa contoh tidak berlabel yang dibagi menjadi subset yang lebih kecil ("batch").

Inferensi batch dapat memanfaatkan fitur paralelisasi chip akselerator. Artinya, beberapa akselerator dapat menyimpulkan prediksi secara bersamaan pada berbagai batch contoh yang tidak berlabel, sehingga meningkatkan jumlah inferensi per detik secara signifikan.

Lihat Sistem ML produksi: Inferensi statis versus dinamis di Kursus Singkat Machine Learning untuk mengetahui informasi selengkapnya.

normalisasi batch

Menormalisasi input atau output fungsi aktivasi di lapisan tersembunyi. Normalisasi batch dapat memberikan manfaat berikut:

- Membuat jaringan neural lebih stabil dengan melindungi dari bobot pencilan.

- Aktifkan kecepatan pembelajaran yang lebih tinggi, yang dapat mempercepat pelatihan.

- Mengurangi overfitting.

ukuran batch

Jumlah contoh dalam batch. Misalnya, jika ukuran batch adalah 100, model akan memproses 100 contoh per iterasi.

Berikut adalah strategi ukuran batch yang populer:

- Penurunan Gradien Stokastik (SGD), dengan ukuran tumpukan adalah 1.

- Batch penuh, dengan ukuran batch adalah jumlah contoh dalam set pelatihan secara keseluruhan. Misalnya, jika set pelatihan berisi satu juta contoh, maka ukuran batchnya adalah satu juta contoh. Batch penuh biasanya merupakan strategi yang tidak efisien.

- Tumpukan mini dengan ukuran tumpukan biasanya antara 10 dan 1.000. Tumpukan mini biasanya merupakan strategi yang paling efisien.

Lihat informasi selengkapnya di sini:

- Sistem ML produksi: Inferensi statis versus dinamis dalam Kursus Singkat Machine Learning.

- Playbook Penyesuaian Deep Learning.

Jaringan neural Bayesian

Jaringan neural probabilistik yang memperhitungkan ketidakpastian dalam bobot dan output. Model regresi jaringan saraf standar biasanya memprediksi nilai skalar; misalnya, model standar memprediksi harga rumah sebesar 853.000. Sebaliknya, jaringan saraf Bayesian memprediksi distribusi nilai; misalnya, model Bayesian memprediksi harga rumah senilai 853.000 dengan simpangan baku 67.200.

Jaringan saraf Bayesian mengandalkan Teorema Bayes untuk menghitung ketidakpastian dalam bobot dan prediksi. Jaringan saraf Bayesian dapat berguna jika penghitungan ketidakpastian bersifat penting, seperti dalam model yang terkait dengan obat-obatan. Jaringan saraf Bayesian juga dapat membantu mencegah overfitting.

Pengoptimalan Bayesian

Teknik model regresi probabilistik untuk mengoptimalkan fungsi objektif yang mahal secara komputasi dengan mengoptimalkan pengganti yang mengukur ketidakpastian menggunakan teknik pembelajaran Bayesian. Karena pengoptimalan Bayesian itu sendiri sangat mahal, biasanya digunakan untuk mengoptimalkan tugas yang mahal untuk dievaluasi dan memiliki sejumlah kecil parameter, seperti memilih hyperparameter.

Persamaan Bellman

Dalam reinforcement learning, identitas berikut dipenuhi oleh Q-function yang optimal:

\[Q(s, a) = r(s, a) + \gamma \mathbb{E}_{s'|s,a} \max_{a'} Q(s', a')\]

Algoritma reinforcement learning menerapkan identitas ini untuk membuat Q-learning menggunakan aturan update berikut:

\[Q(s,a) \gets Q(s,a) + \alpha \left[r(s,a) + \gamma \displaystyle\max_{\substack{a_1}} Q(s',a') - Q(s,a) \right] \]

Selain reinforcement learning, persamaan Bellman memiliki penerapan pada pemrograman dinamis. Lihat entri Wikipedia untuk persamaan Bellman.

BERT (Bidirectional Encoder Representations from Transformers)

Arsitektur model untuk representasi teks. Model BERT terlatih dapat bertindak sebagai bagian dari model yang lebih besar untuk klasifikasi teks atau tugas ML lainnya.

BERT memiliki karakteristik berikut:

- Menggunakan arsitektur Transformer, dan oleh karena itu mengandalkan self-attention.

- Menggunakan bagian encoder Transformer. Tugas encoder adalah menghasilkan representasi teks yang baik, bukan melakukan tugas tertentu seperti klasifikasi.

- Bersifat dua arah.

- Menggunakan penyamaran untuk pelatihan tanpa pengawasan.

Varian BERT mencakup:

Lihat Open Sourcing BERT: State-of-the-Art Pre-training for Natural Language Processing untuk mengetahui ringkasan BERT.

bias (etika/keadilan)

1. Stereotip, prasangka, atau preferensi terhadap beberapa hal, orang, atau kelompok dibandingkan yang lain. Bias ini dapat memengaruhi pengumpulan dan interpretasi data, desain sistem, dan cara pengguna berinteraksi dengan sistem. Bentuk bias jenis ini meliputi:

- bias otomatisasi

- bias konfirmasi

- bias pelaku eksperimen

- bias atribusi kelompok

- bias implisit

- bias dalam golongan

- bias kehomogenan luar golongan

2. Error sistematis yang disebabkan oleh prosedur sampling atau pelaporan. Bentuk bias jenis ini meliputi:

Harap bedakan dengan istilah bias dalam model machine learning atau bias prediksi.

Lihat Fairness: Types of bias di Machine Learning Crash Course untuk mengetahui informasi selengkapnya.

bias (matematika) atau istilah bias

Intersep atau ofset dari asal. Bias adalah parameter dalam model machine learning, yang disimbolkan oleh salah satu dari berikut ini:

- b

- w0

Misalnya, bias bernilai b dalam formula berikut:

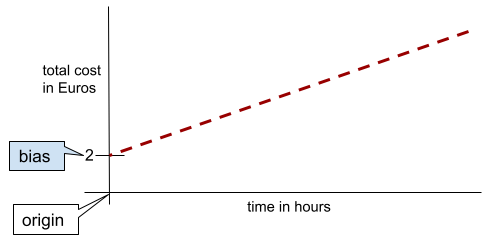

Dalam garis dua dimensi sederhana, bias hanya berarti "titik potong sumbu y". Misalnya, bias garis dalam ilustrasi berikut adalah 2.

Bias ada karena tidak semua model dimulai dari titik asal (0,0). Misalnya, anggaplah biaya masuk taman hiburan adalah 2 Euro dan biaya tambahan 0,5 Euro untuk setiap jam pelanggan berada di sana. Oleh karena itu, model yang memetakan total biaya memiliki bias 2 karena biaya terendah adalah 2 Euro.

Bias tidak boleh disamakan dengan bias dalam etika dan fairness atau bias prediksi.

Lihat Regresi Linear di Kursus Singkat Machine Learning untuk mengetahui informasi selengkapnya.

dua arah

Istilah yang digunakan untuk mendeskripsikan sistem yang mengevaluasi teks yang mendahului dan mengikuti bagian teks target. Sebaliknya, sistem unidirectional hanya mengevaluasi teks yang mendahului bagian teks target.

Misalnya, pertimbangkan model bahasa yang di-masking yang harus menentukan probabilitas untuk kata atau kata-kata yang mewakili garis bawah dalam pertanyaan berikut:

Ada apa denganmu?

Model bahasa satu arah harus mendasarkan probabilitasnya hanya pada konteks yang diberikan oleh kata-kata "What", "is", dan "the". Sebaliknya, model bahasa dua arah juga dapat memperoleh konteks dari "dengan" dan "Anda", yang dapat membantu model menghasilkan prediksi yang lebih baik.

model bahasa dua arah

Model bahasa yang menentukan probabilitas bahwa token tertentu ada di lokasi tertentu dalam kutipan teks berdasarkan teks sebelumnya dan berikutnya.

bigram

N-gram yang mana N=2.

klasifikasi biner

Jenis tugas klasifikasi yang memprediksi salah satu dari dua kelas yang saling eksklusif:

Misalnya, dua model machine learning berikut masing-masing melakukan klasifikasi biner:

- Model yang menentukan apakah pesan email adalah spam (kelas positif) atau bukan spam (kelas negatif).

- Model yang mengevaluasi gejala medis untuk menentukan apakah seseorang menderita penyakit tertentu (kelas positif) atau tidak menderita penyakit tersebut (kelas negatif).

Berbeda dengan klasifikasi multikelas.

Lihat juga regresi logistik dan nilai minimum klasifikasi.

Lihat Klasifikasi di Kursus Singkat Machine Learning untuk mengetahui informasi selengkapnya.

kondisi biner

Dalam pohon keputusan, kondisi yang hanya memiliki dua kemungkinan hasil, biasanya ya atau tidak. Misalnya, berikut adalah kondisi biner:

temperature >= 100

Berbeda dengan kondisi non-biner.

Lihat Jenis kondisi dalam kursus Decision Forests untuk mengetahui informasi selengkapnya.

pengelompokan

Sinonim untuk pengelompokan.

model kotak hitam

Model yang "alasan"nya tidak mungkin atau sulit dipahami oleh manusia. Artinya, meskipun manusia dapat melihat bagaimana perintah memengaruhi respons, manusia tidak dapat menentukan secara persis bagaimana model kotak hitam menentukan respons. Dengan kata lain, model kotak hitam tidak memiliki kemampuan interpretasi.

Sebagian besar model deep dan model bahasa besar adalah kotak hitam.

BLEU (Bilingual Evaluation Understudy)

Metrik antara 0,0 dan 1,0 untuk mengevaluasi terjemahan mesin, misalnya, dari bahasa Spanyol ke bahasa Jepang.

Untuk menghitung skor, BLEU biasanya membandingkan terjemahan model ML (teks yang dihasilkan) dengan terjemahan pakar manusia (teks referensi). Tingkat kecocokan N-gram dalam teks yang dihasilkan dan teks referensi menentukan skor BLEU.

Artikel asli tentang metrik ini adalah BLEU: a Method for Automatic Evaluation of Machine Translation.

Lihat juga BLEURT.

BLEURT (Bilingual Evaluation Understudy from Transformers)

Metrik untuk mengevaluasi terjemahan mesin dari satu bahasa ke bahasa lain, terutama ke dan dari bahasa Inggris.

Untuk terjemahan ke dan dari bahasa Inggris, BLEURT lebih selaras dengan peringkat manusia daripada BLEU. Tidak seperti BLEU, BLEURT menekankan kesamaan semantik (makna) dan dapat mengakomodasi parafrasa.

BLEURT mengandalkan model bahasa besar yang telah dilatih (BERT tepatnya) yang kemudian disesuaikan dengan teks dari penerjemah manusia.

Makalah asli tentang metrik ini adalah BLEURT: Learning Robust Metrics for Text Generation.

Pertanyaan Boolean (BoolQ)

Set data untuk mengevaluasi kemahiran LLM dalam menjawab pertanyaan ya atau tidak. Setiap tantangan dalam set data memiliki tiga komponen:

- Kueri

- Bagian yang menyiratkan jawaban atas kueri.

- Jawaban yang benar, yaitu ya atau tidak.

Contoh:

- Kueri: Apakah ada pembangkit listrik tenaga nuklir di Michigan?

- Bagian: ...tiga pembangkit listrik tenaga nuklir memasok sekitar 30% listrik untuk Michigan.

- Jawaban yang benar: Ya

Peneliti mengumpulkan pertanyaan dari kueri Google Penelusuran yang dianonimkan dan digabungkan, lalu menggunakan halaman Wikipedia untuk mendasari informasi tersebut.

Untuk mengetahui informasi selengkapnya, lihat BoolQ: Exploring the Surprising Difficulty of Natural Yes/No Questions.

BoolQ adalah komponen ansambel SuperGLUE.

BoolQ

Singkatan dari Boolean Questions.

mempercepat

Teknik machine learning yang secara berulang menggabungkan serangkaian model klasifikasi yang sederhana dan tidak terlalu akurat (disebut sebagai "pengklasifikasi lemah") menjadi model klasifikasi dengan akurasi tinggi (disebut sebagai "pengklasifikasi kuat") dengan menambahkan bobot contoh yang saat ini salah diklasifikasikan oleh model.

Lihat Pohon Keputusan Penguatan Gradien? di kursus Decision Forests untuk mengetahui informasi selengkapnya.

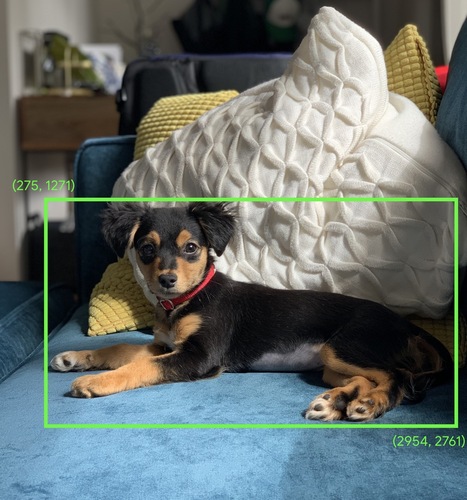

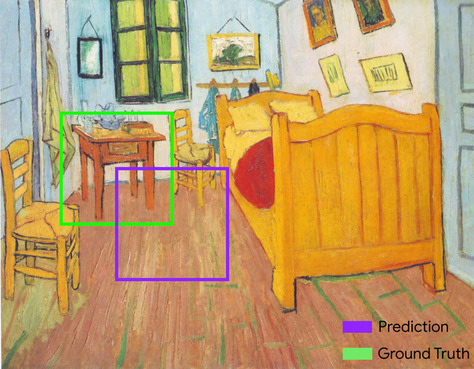

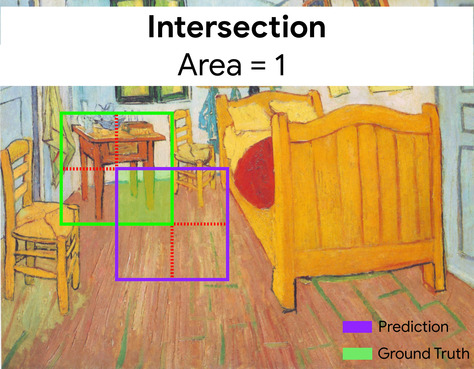

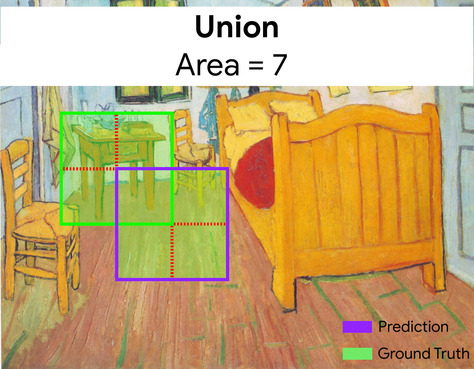

kotak pembatas

Dalam gambar, koordinat (x, y) persegi panjang di sekitar area yang diinginkan, seperti dalam gambar di bawah.

penyiaran

Memperluas bentuk operand dalam operasi matematika matriks ke dimensi yang kompatibel untuk operasi tersebut. Misalnya, aljabar linear mengharuskan dua operand dalam operasi penambahan matriks untuk memiliki dimensi yang sama. Akibatnya, Anda tidak dapat menambahkan matriks berbentuk (m, n) ke vektor yang panjangnya n. Penyiaran memungkinkan operasi ini dengan memperluas vektor sepanjang n ke matriks berbentuk (m, n) secara virtual dengan mereplikasi nilai yang sama di setiap kolom.

Lihat deskripsi penyiaran di NumPy berikut untuk detail selengkapnya.

pengelompokan

Mengonversi satu fitur menjadi beberapa fitur biner yang disebut bucket atau bin, biasanya berdasarkan rentang nilai. Fitur yang dipotong biasanya merupakan fitur berkelanjutan.

Misalnya, alih-alih merepresentasikan suhu sebagai satu fitur floating point berkelanjutan, Anda dapat membagi rentang suhu ke dalam bucket diskrit, seperti:

- <= 10 derajat Celsius akan menjadi bucket "dingin".

- 11 - 24 derajat Celsius akan menjadi kategori "sedang".

- >= 25 derajat Celsius akan menjadi kategori "hangat".

Model akan memperlakukan setiap nilai dalam bucket yang sama secara identik. Misalnya, nilai 13 dan 22 keduanya berada dalam bucket sedang, sehingga model memperlakukan kedua nilai tersebut secara identik.

Lihat Data numerik: Pengelompokan di Kursus Singkat Machine Learning untuk mengetahui informasi selengkapnya.

C

lapisan kalibrasi

Penyesuaian pascaprediksi, biasanya diperhitungkan untuk bias prediksi. Prediksi dan probabilitas yang disesuaikan harus cocok dengan distribusi set label yang diamati.

pemilihan kandidat

Kumpulan rekomendasi awal yang dipilih oleh sistem rekomendasi. Misalnya, pertimbangkan toko buku yang menawarkan 100.000 judul. Fase pembuatan kandidat membuat daftar buku yang sesuai untuk pengguna tertentu yang jauh lebih kecil, misalnya 500 buku. Namun, 500 buku tetap terlalu banyak untuk direkomendasikan kepada pengguna. Tahapan sistem rekomendasi berikutnya yang lebih mahal (seperti pemberian skor dan pemeringkatan ulang) akan mengurangi 500 rekomendasi tersebut menjadi set rekomendasi yang jauh lebih kecil dan berguna.

Lihat Ringkasan pembuatan kandidat di kursus Sistem Rekomendasi untuk mengetahui informasi selengkapnya.

sampling kandidat

Pengoptimalan waktu pelatihan yang menghitung probabilitas untuk semua label positif, menggunakan, misalnya, softmax, tetapi hanya untuk sampel label negatif acak. Misalnya, diberikan contoh yang diberi label beagle dan dog, pengambilan sampel kandidat menghitung probabilitas prediksi dan istilah kerugian yang sesuai untuk:

- beagle

- subset acak dari kelas negatif yang tersisa (misalnya, kucing, lolipop, pagar).

Idenya adalah bahwa kelas negatif dapat belajar dari penguatan negatif yang lebih jarang selama kelas positif selalu mendapatkan penguatan positif yang tepat, dan ini memang diamati secara empiris.

Sampling kandidat lebih efisien secara komputasi daripada algoritma pelatihan yang menghitung prediksi untuk semua kelas negatif, terutama jika jumlah kelas negatif sangat besar.

data kategorik

Fitur yang memiliki set kemungkinan nilai tertentu. Misalnya, pertimbangkan fitur kategoris bernama traffic-light-state, yang hanya dapat memiliki salah satu dari tiga kemungkinan nilai berikut:

redyellowgreen

Dengan merepresentasikan traffic-light-state sebagai fitur kategoris,

model dapat mempelajari

dampak yang berbeda dari red, green, dan yellow pada perilaku pengemudi.

Fitur kategorik terkadang disebut fitur diskrit.

Berbeda dengan data numerik.

Lihat Bekerja dengan data kategoris di Kursus Singkat Machine Learning untuk mengetahui informasi selengkapnya.

model bahasa kausal

Sinonim untuk model bahasa satu arah.

Lihat model bahasa dua arah untuk membedakan pendekatan dua arah yang berbeda dalam pemodelan bahasa.

CB

Singkatan dari CommitmentBank.

sentroid

Pusat cluster sebagaimana ditentukan oleh algoritma k-means atau k-median. Misalnya, jika k bernilai 3, maka algoritma k-means atau k-median akan menemukan 3 sentroid.

Lihat Algoritma pengelompokan dalam kursus Pengelompokan untuk mengetahui informasi selengkapnya.

pengelompokan berbasis sentroid

Kategori algoritma pengelompokan yang mengatur data ke dalam cluster nonhierarkis. k-means adalah algoritma pengelompokan berdasarkan sentroid yang paling banyak digunakan.

Berbeda dengan algoritma pengelompokan hierarkis.

Lihat Algoritma pengelompokan dalam kursus Pengelompokan untuk mengetahui informasi selengkapnya.

prompting chain-of-thought

Teknik rekayasa perintah yang mendorong model bahasa besar (LLM) untuk menjelaskan penalarannya, langkah demi langkah. Misalnya, perhatikan perintah berikut, dengan memberikan perhatian khusus pada kalimat kedua:

Berapa gaya gravitasi yang akan dialami pengemudi dalam mobil yang melaju dari 0 hingga 60 mil per jam dalam 7 detik? Dalam jawaban, tunjukkan semua perhitungan yang relevan.

Respons LLM kemungkinan akan:

- Tampilkan urutan rumus fisika, dengan memasukkan nilai 0, 60, dan 7 di tempat yang sesuai.

- Jelaskan alasan pemilihan formula tersebut dan arti berbagai variabelnya.

Dengan prompting chain-of-thought, LLM dipaksa untuk melakukan semua perhitungan, yang dapat menghasilkan jawaban yang lebih benar. Selain itu, perintah chain-of-thought memungkinkan pengguna memeriksa langkah-langkah LLM untuk menentukan apakah jawaban yang diberikan masuk akal atau tidak.

Skor F N-gram karakter (ChrF)

Metrik untuk mengevaluasi model terjemahan mesin. Skor F N-gram Karakter menentukan tingkat tumpang-tindih N-gram dalam teks referensi dengan N-gram dalam teks yang dihasilkan model ML.

Skor-F N-gram Karakter mirip dengan metrik dalam kelompok ROUGE dan BLEU, kecuali:

- Skor F N-gram Karakter beroperasi pada N-gram karakter.

- ROUGE dan BLEU beroperasi pada N-gram kata atau token.

chat

Isi dialog dua arah dengan sistem ML, biasanya model bahasa besar. Interaksi sebelumnya dalam chat (apa yang Anda ketik dan cara model bahasa besar merespons) menjadi konteks untuk bagian chat berikutnya.

Chatbot adalah aplikasi model bahasa besar.

pos pemeriksaan

Data yang merekam status parameter model baik selama pelatihan atau setelah pelatihan selesai. Misalnya, selama pelatihan, Anda dapat:

- Menghentikan pelatihan, mungkin secara sengaja atau mungkin sebagai akibat dari error tertentu.

- Ambil checkpoint.

- Kemudian, muat ulang titik pemeriksaan, mungkin di hardware yang berbeda.

- Mulai ulang pelatihan.

Pilihan Alternatif yang Masuk Akal (COPA)

Set data untuk mengevaluasi seberapa baik LLM dapat mengidentifikasi jawaban alternatif yang lebih baik dari dua jawaban alternatif untuk suatu premis. Setiap tantangan dalam set data terdiri dari tiga komponen:

- Premis, yang biasanya berupa pernyataan yang diikuti dengan pertanyaan

- Dua kemungkinan jawaban untuk pertanyaan yang diajukan dalam premis, salah satunya benar dan yang lainnya salah

- Jawaban yang benar

Contoh:

- Premis: Pria itu mematahkan jari kakinya. Apa PENYEBABNYA?

- Kemungkinan jawaban:

- Dia mendapatkan lubang di kausnya.

- Dia menjatuhkan palu di kakinya.

- Jawaban yang benar: 2

COPA adalah komponen ansambel SuperGLUE.

class

Kategori yang dapat dimiliki oleh label. Contoh:

- Dalam model klasifikasi biner yang mendeteksi spam, dua kelasnya mungkin adalah spam dan bukan spam.

- Dalam model klasifikasi multi-kelas yang mengidentifikasi ras, kelasnya mungkin pudel, beagle, pug, dan sebagainya.

Model klasifikasi memprediksi kelas. Sebaliknya, model regresi memprediksi angka, bukan kelas.

Lihat Klasifikasi di Kursus Singkat Machine Learning untuk mengetahui informasi selengkapnya.

set data seimbang kelas

Set data yang berisi label kategoris yang jumlah instance setiap kategorinya kira-kira sama. Misalnya, pertimbangkan set data botani yang label binernya dapat berupa tanaman asli atau tanaman non-asli:

- Kumpulan data dengan 515 tanaman asli dan 485 tanaman non-asli adalah kumpulan data yang seimbang kelasnya.

- Set data dengan 875 tanaman asli dan 125 tanaman non-asli adalah set data kelas tidak seimbang.

Tidak ada garis pemisah formal antara set data kelas seimbang dan set data kelas tidak seimbang. Perbedaan ini hanya menjadi penting saat model yang dilatih pada set data yang sangat tidak seimbang kelasnya tidak dapat menyatu. Lihat Set data: set data tidak seimbang di Kursus Singkat Machine Learning untuk mengetahui detailnya.

model klasifikasi

Model yang prediksinya adalah class. Misalnya, berikut adalah semua model klasifikasi:

- Model yang memprediksi bahasa kalimat input (Prancis? Spanyol? Italia?).

- Model yang memprediksi spesies pohon (Maple? Oak? Baobab?).

- Model yang memprediksi kelas positif atau negatif untuk kondisi medis tertentu.

Sebaliknya, model regresi memprediksi angka, bukan kelas.

Dua jenis model klasifikasi yang umum adalah:

nilai minimum klasifikasi

Dalam klasifikasi biner, angka antara 0 dan 1 yang mengonversi output mentah model regresi logistik menjadi prediksi kelas positif atau kelas negatif. Perhatikan bahwa nilai minimum klasifikasi adalah nilai yang dipilih oleh manusia, bukan nilai yang dipilih oleh pelatihan model.

Model regresi logistik menghasilkan nilai mentah antara 0 dan 1. Lalu:

- Jika nilai mentah ini lebih besar dari nilai minimum klasifikasi, maka kelas positif diprediksi.

- Jika nilai mentah ini kurang dari nilai minimum klasifikasi, maka kelas negatif diprediksi.

Misalnya, anggap batas klasifikasi adalah 0,8. Jika nilai mentahnya adalah 0,9, model memprediksi kelas positif. Jika nilai mentahnya adalah 0,7, model memprediksi kelas negatif.

Pilihan batas klasifikasi sangat memengaruhi jumlah positif palsu dan negatif palsu.

Lihat Nilai minimum dan matriks kebingungan di Kursus Singkat Machine Learning untuk mengetahui informasi selengkapnya.

pengklasifikasi

Istilah umum untuk model klasifikasi.

set data kelas tidak seimbang

Set data untuk klasifikasi dengan jumlah total label setiap kelas berbeda secara signifikan. Misalnya, pertimbangkan set data klasifikasi biner yang dua labelnya dibagi sebagai berikut:

- 1.000.000 label negatif

- 10 label positif

Rasio label negatif terhadap positif adalah 100.000 banding 1, jadi ini adalah set data kelas tidak seimbang.

Sebaliknya, set data berikut seimbang menurut kelas karena rasio label negatif terhadap label positif relatif mendekati 1:

- 517 label negatif

- 483 label positif

Set data multikelas juga dapat memiliki kelas yang tidak seimbang. Misalnya, set data klasifikasi multikelas berikut juga tidak seimbang karena satu label memiliki lebih banyak contoh daripada dua label lainnya:

- 1.000.000 label dengan class "green"

- 200 label dengan class "ungu"

- 350 label dengan class "orange"

Melatih set data kelas tidak seimbang dapat menimbulkan tantangan khusus. Lihat Kumpulan data yang tidak seimbang di Kursus Singkat Machine Learning untuk mengetahui detailnya.

Lihat juga entropi, kelas mayoritas, dan kelas minoritas.

kliping

Teknik untuk menangani pencilan dengan melakukan salah satu atau kedua hal berikut:

- Mengurangi nilai fitur yang lebih besar dari nilai maksimum hingga nilai maksimum tersebut.

- Meningkatkan nilai fitur yang kurang dari nilai minimum hingga nilai minimum tersebut.

Misalnya, anggaplah <0,5% nilai untuk fitur tertentu berada di luar rentang 40–60. Dalam hal ini, Anda dapat melakukan hal berikut:

- Klip semua nilai di atas 60 (nilai maksimum) menjadi tepat 60.

- Klip semua nilai di bawah 40 (nilai minimum) menjadi tepat 40.

Pencilan dapat merusak model, terkadang menyebabkan bobot meluap selama pelatihan. Beberapa pencilan juga dapat merusak metrik seperti akurasi secara drastis. Pemangkasan adalah teknik umum untuk membatasi kerusakan.

Pengekangan gradien memaksa nilai gradien dalam rentang yang ditentukan selama pelatihan.

Lihat Data numerik: Normalisasi di Kursus Singkat Machine Learning untuk mengetahui informasi selengkapnya.

Cloud TPU

Akselerator hardware khusus yang dirancang untuk mempercepat workload machine learning di Google Cloud.

pengelompokan

Mengelompokkan contoh yang terkait, terutama selama unsupervised learning. Setelah semua contoh dikelompokkan, manusia dapat secara opsional memberikan arti pada setiap kluster.

Banyak algoritma pengelompokan tersedia. Misalnya, algoritma k-means mengelompokkan contoh berdasarkan kedekatannya dengan sentroid, seperti pada diagram berikut:

Kemudian peneliti manusia dapat meninjau kluster dan, misalnya, memberi label kluster 1 sebagai "pohon kerdil" dan kluster 2 sebagai "pohon berukuran normal".

Sebagai contoh lain, pertimbangkan algoritma pengelompokan berdasarkan jarak contoh dari titik tengah, yang diilustrasikan sebagai berikut:

Lihat Kursus pengelompokan untuk mengetahui informasi selengkapnya.

adaptasi bersama

Perilaku yang tidak diinginkan saat neuron memprediksi pola dalam data pelatihan dengan hampir sepenuhnya mengandalkan keluaran neuron spesifik lain, bukannya mengandalkan perilaku jaringan secara keseluruhan. Jika pola yang menyebabkan adaptasi bersama tidak ada dalam data validasi, adaptasi bersama akan menyebabkan overfitting. Regularisasi dengan pelolosan mengurangi adaptasi bersama karena pelolosan memastikan bahwa neuron tidak dapat sepenuhnya mengandalkan neuron spesifik lain.

pemfilteran kolaboratif

Membuat prediksi tentang minat satu pengguna berdasarkan minat banyak pengguna lain. Pemfilteran kolaboratif sering digunakan dalam sistem rekomendasi.

Lihat Pemfilteran kolaboratif di kursus Sistem Rekomendasi untuk mengetahui informasi selengkapnya.

CommitmentBank (CB)

Set data untuk mengevaluasi kemahiran LLM dalam menentukan apakah penulis suatu bagian percaya pada klausa target dalam bagian tersebut. Setiap entri dalam set data berisi:

- Bagian

- Klausul target dalam bagian tersebut

- Nilai Boolean yang menunjukkan apakah penulis bagian tersebut meyakini klausa target

Contoh:

- Bagian: Betapa menyenangkan mendengar tawa Artemis. Dia anak yang sangat serius. Saya tidak tahu dia punya selera humor.

- Target klausa: dia memiliki selera humor

- Boolean: Benar, yang berarti penulis meyakini bahwa klausa target

CommitmentBank adalah komponen ansambel SuperGLUE.

model ringkas

Model kecil apa pun yang dirancang untuk berjalan di perangkat kecil dengan resource komputasi terbatas. Misalnya, model ringkas dapat berjalan di ponsel, tablet, atau sistem sematan.

compute

(Kata benda) Resource komputasi yang digunakan oleh model atau sistem, seperti daya pemrosesan, memori, dan penyimpanan.

Lihat chip akselerator.

penyimpangan konsep

Perubahan hubungan antara fitur dan label. Seiring waktu, penyimpangan konsep akan mengurangi kualitas model.

Selama pelatihan, model mempelajari hubungan antara fitur dan labelnya dalam set pelatihan. Jika label dalam set pelatihan adalah proxy yang baik untuk dunia nyata, maka model harus membuat prediksi dunia nyata yang baik. Namun, karena penyimpangan konsep, prediksi model cenderung menurun seiring waktu.

Misalnya, pertimbangkan model klasifikasi biner yang memprediksi apakah model mobil tertentu "hemat bahan bakar" atau tidak. Artinya, fitur tersebut dapat berupa:

- berat mobil

- kompresi mesin

- jenis transmisi

sementara labelnya adalah:

- hemat bahan bakar

- tidak hemat bahan bakar

Namun, konsep "mobil hemat bahan bakar" terus berubah. Model mobil yang diberi label hemat bahan bakar pada tahun 1994 hampir pasti akan diberi label tidak hemat bahan bakar pada tahun 2024. Model yang mengalami pergeseran konsep cenderung membuat prediksi yang semakin tidak berguna seiring waktu.

Bandingkan dan bedakan dengan nonstasioneritas.

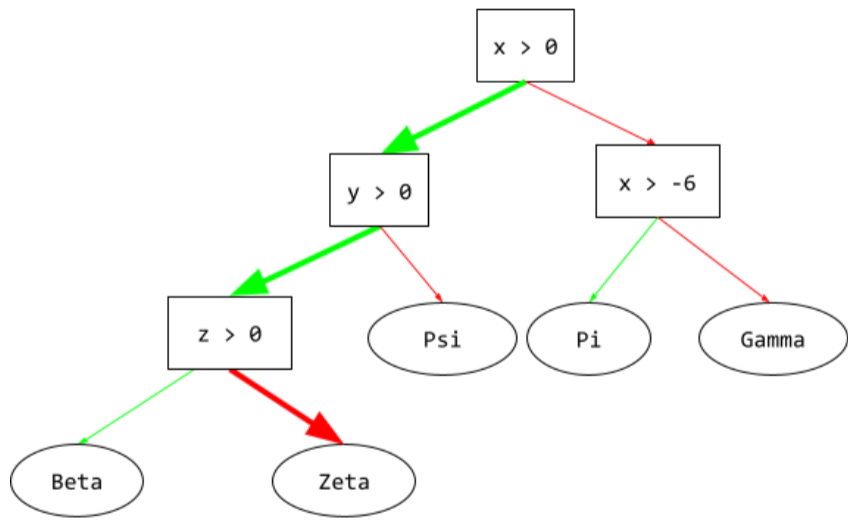

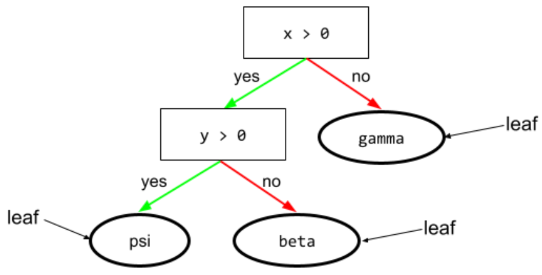

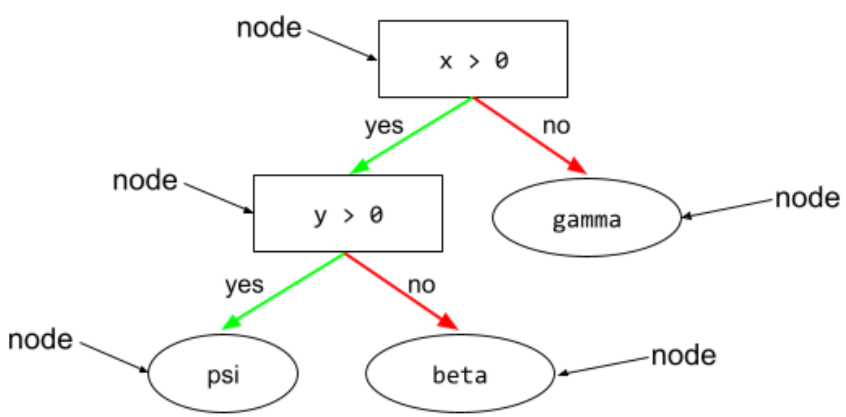

bagus

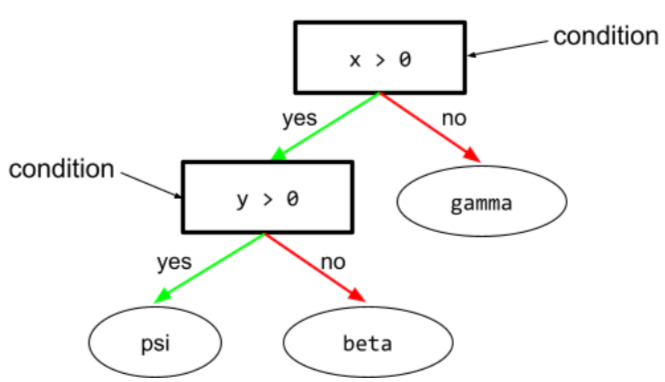

Dalam pohon keputusan, setiap node yang melakukan pengujian. Misalnya, pohon keputusan berikut berisi dua kondisi:

Kondisi juga disebut pemisahan atau pengujian.

Kondisi kontras dengan daun.

Lihat juga:

Lihat Jenis kondisi dalam kursus Decision Forests untuk mengetahui informasi selengkapnya.

konfabulasi

Sinonim untuk halusinasi.

Konfabulasi mungkin merupakan istilah yang lebih akurat secara teknis daripada halusinasi. Namun, halusinasi menjadi populer terlebih dahulu.

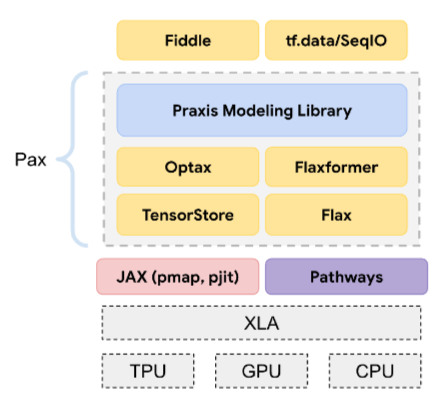

konfigurasi

Proses penetapan nilai properti awal yang digunakan untuk melatih model, termasuk:

- lapisan penyusun model

- lokasi data

- hyperparameter seperti:

Dalam project machine learning, konfigurasi dapat dilakukan melalui file konfigurasi khusus atau menggunakan library konfigurasi seperti berikut:

bias konfirmasi

Kecenderungan untuk mencari, menafsirkan, menyukai, dan mengingat informasi dengan cara yang mengonfirmasi keyakinan atau hipotesis yang sudah ada sebelumnya. Developer machine learning mungkin secara tidak sengaja mengumpulkan atau melabeli data dengan cara yang memengaruhi hasil yang mendukung keyakinan mereka yang sudah ada. Bias konfirmasi adalah bentuk bias implisit.

Bias pelaku eksperimen adalah bentuk bias konfirmasi yang mana pelaku eksperimen terus melatih model hingga hipotesis yang sudah ada sebelumnya terkonfirmasi.

matriks konfusi

Tabel NxN yang merangkum jumlah prediksi benar dan salah yang dibuat oleh model klasifikasi. Misalnya, perhatikan matriks kebingungan berikut untuk model klasifikasi biner:

| Tumor (diprediksi) | Non-Tumor (prediksi) | |

|---|---|---|

| Tumor (kebenaran nyata) | 18 (TP) | 1 (FN) |

| Non-Tumor (kebenaran nyata) | 6 (FP) | 452 (TN) |

Matriks konfusi sebelumnya menunjukkan hal berikut:

- Dari 19 prediksi yang kebenaran nyatanya adalah Tumor, model mengklasifikasikan 18 dengan benar dan 1 dengan salah.

- Dari 458 prediksi yang kebenaran nyatanya adalah Non-Tumor, model mengklasifikasikan 452 dengan benar dan 6 dengan salah.

Matriks kebingungan untuk masalah klasifikasi multi-kelas dapat membantu Anda mengidentifikasi pola kesalahan. Misalnya, pertimbangkan matriks kebingungan berikut untuk model klasifikasi multikelas 3 kelas yang mengategorikan tiga jenis iris yang berbeda (Virginica, Versicolor, dan Setosa). Jika kebenaran dasarnya adalah Virginica, matriks kebingungan menunjukkan bahwa model jauh lebih mungkin keliru memprediksi Versicolor daripada Setosa:

| Setosa (prediksi) | Versicolor (prediksi) | Virginica (diprediksi) | |

|---|---|---|---|

| Setosa (kebenaran dasar) | 88 | 12 | 0 |

| Versicolor (kebenaran nyata) | 6 | 141 | 7 |

| Virginica (kebenaran dasar) | 2 | 27 | 109 |

Sebagai contoh lain, matriks konfusi dapat mengungkapkan bahwa model yang dilatih untuk mengenali digit tulisan tangan cenderung salah memprediksi 9 bukannya 4, atau salah memprediksi 1 bukannya 7.

Matriks kebingungan berisi informasi yang cukup untuk menghitung berbagai metrik performa, termasuk presisi dan perolehan.

penguraian konstituensi

Membagi kalimat menjadi struktur tata bahasa yang lebih kecil ("konstituen"). Bagian selanjutnya dari sistem ML, seperti model natural language understanding, dapat mengurai konstituen dengan lebih mudah daripada kalimat aslinya. Misalnya, pertimbangkan kalimat berikut:

Teman saya mengadopsi dua kucing.

Parser konstituen dapat membagi kalimat ini menjadi dua konstituen berikut:

- Teman saya adalah frasa nomina.

- mengadopsi dua kucing adalah frasa kata kerja.

Konstituen ini dapat dibagi lagi menjadi konstituen yang lebih kecil. Misalnya, frasa verba

mengadopsi dua kucing

dapat dibagi lagi menjadi:

- mengadopsi adalah kata kerja.

- dua kucing adalah frasa nomina lainnya.

embedding bahasa yang dikontekstualisasi

Penyematan yang mendekati "pemahaman" kata dan frasa seperti yang dilakukan penutur manusia yang fasih. Penyematan bahasa yang dikontekstualisasi dapat memahami sintaksis, semantik, dan konteks yang kompleks.

Misalnya, pertimbangkan embedding kata cow dalam bahasa Inggris. Embedding lama seperti word2vec dapat merepresentasikan kata-kata bahasa Inggris sehingga jarak dalam ruang embedding dari cow ke bull mirip dengan jarak dari ewe (domba betina) ke ram (domba jantan) atau dari female ke male. Penyematan bahasa yang dikontekstualisasi dapat melangkah lebih jauh dengan mengenali bahwa penutur bahasa Inggris terkadang menggunakan kata cow secara kasual untuk berarti sapi betina atau sapi jantan.

jendela konteks

Jumlah token yang dapat diproses model dalam perintah tertentu. Makin besar jendela konteks, makin banyak informasi yang dapat digunakan model untuk memberikan respons yang koheren dan konsisten terhadap perintah.

fitur berkelanjutan

Fitur floating point dengan rentang nilai yang mungkin tak terbatas, seperti suhu atau berat.

Berbeda dengan fitur diskrit.

pengambilan sampel praktis

Menggunakan set data yang tidak dikumpulkan secara ilmiah untuk menjalankan eksperimen sederhana dalam waktu singkat. Pada tahapan eksperimen yang lebih dalam, gunakanlah set data yang dikumpulkan secara ilmiah.

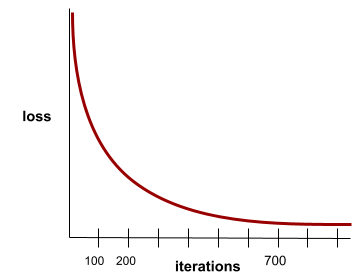

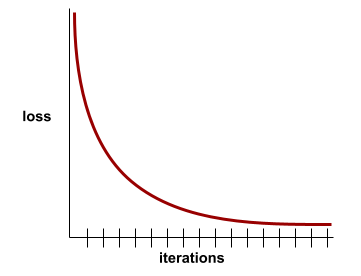

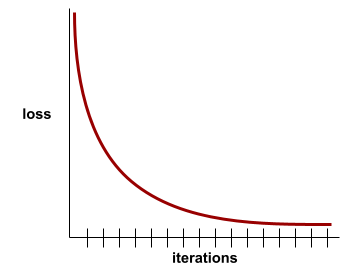

konvergensi

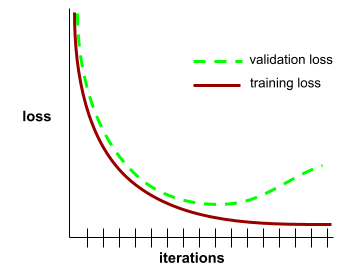

Status yang dicapai saat nilai loss berubah sangat sedikit atau tidak berubah sama sekali dengan setiap iterasi. Misalnya, kurva kerugian berikut menunjukkan konvergensi pada sekitar 700 iterasi:

Model berkonvergensi saat pelatihan tambahan tidak akan meningkatkan kualitas model.

Dalam deep learning, nilai kerugian terkadang tetap konstan atau hampir konstan selama banyak iterasi sebelum akhirnya menurun. Selama periode panjang nilai kerugian yang konstan, Anda mungkin untuk sementara mendapatkan rasa konvergensi yang salah.

Lihat juga penghentian awal.

Lihat Konvergensi model dan kurva kerugian di Kursus Singkat Machine Learning untuk mengetahui informasi selengkapnya.

pengodean percakapan

Dialog iteratif antara Anda dan model AI generatif untuk tujuan pembuatan software. Anda memberikan perintah yang mendeskripsikan beberapa software. Kemudian, model menggunakan deskripsi tersebut untuk membuat kode. Kemudian, Anda mengeluarkan perintah baru untuk mengatasi kekurangan dalam perintah sebelumnya atau dalam kode yang dibuat, dan model akan membuat kode yang diperbarui. Anda berdua terus berinteraksi sampai software yang dihasilkan cukup baik.

Coding percakapan pada dasarnya adalah arti asli dari vibe coding.

Berbeda dengan pengodean spesifikasi.

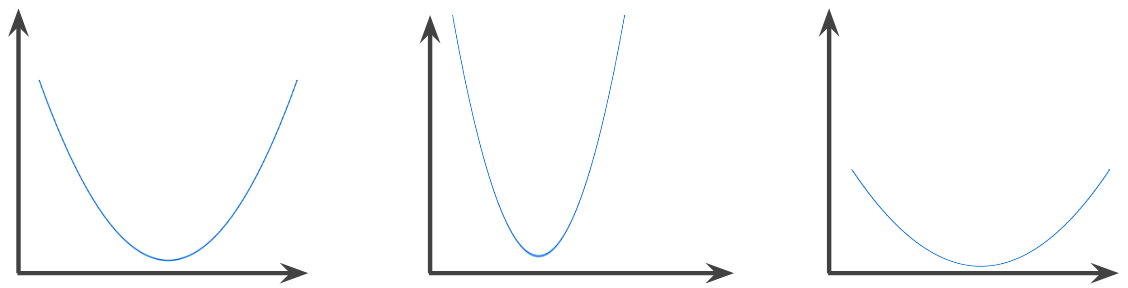

fungsi konveks

Fungsi yang mana daerah di atas grafik fungsi adalah himpunan konveks. Fungsi konveks prototipe berbentuk seperti huruf U. Misalnya, fungsi berikut adalah fungsi konveks:

Sebaliknya, fungsi berikut tidak cembung. Perhatikan bagaimana area di atas grafik bukanlah set cembung:

Fungsi konveks tegas memiliki tepat satu titik minimum lokal, yang juga merupakan titik minimum global. Fungsi berbentuk U klasik adalah fungsi konveks tegas. Namun, beberapa fungsi konveks (misalnya, garis lurus) tidak berbentuk U.

Lihat Konvergensi dan fungsi cembung di Kursus Singkat Machine Learning untuk mengetahui informasi selengkapnya.

pengoptimalan konveks

Proses penggunaan teknik matematika seperti penurunan gradien untuk menemukan nilai minimum fungsi konveks. Banyak riset dalam machine learning telah berfokus pada perumusan berbagai masalah sebagai masalah pengoptimalan konveks dan dalam pemecahan masalah tersebut secara lebih efisien.

Untuk mengetahui detail selengkapnya, lihat Boyd dan Vandenberghe, Convex Optimization.

himpunan konveks

Subkumpulan ruang Euklidean sehingga garis yang ditarik antara dua titik mana pun dalam subkumpulan tetap sepenuhnya berada dalam subkumpulan. Misalnya, dua bentuk berikut adalah himpunan cembung:

Sebaliknya, dua bentuk berikut bukan himpunan cembung:

konvolusi

Dalam matematika, secara kasual, campuran dari dua fungsi. Dalam machine learning, konvolusi mencampur saringan konvolusional dan matriks masukan untuk melatih bobot.

Istilah "konvolusi" dalam machine learning sering kali merupakan cara singkat untuk merujuk ke operasi konvolusional atau lapisan konvolusional.

Tanpa konvolusi, algoritma machine learning harus mempelajari bobot terpisah untuk setiap sel dalam tensor besar. Misalnya, algoritma machine learning yang dilatih pada gambar 2K x 2K akan dipaksa untuk menemukan 4 juta bobot terpisah. Berkat konvolusi, algoritma machine learning hanya harus menemukan bobot untuk setiap sel dalam saringan konvolusional, yang secara drastis mengurangi memori yang diperlukan untuk melatih model. Saat filter konvolusional diterapkan, filter tersebut direplikasi di seluruh sel sehingga setiap sel dikalikan dengan filter.

filter konvolusional

Salah satu dari dua komponen dalam operasi konvolusional. (Aktor lainnya adalah slice matriks input.) Filter konvolusional adalah matriks yang memiliki urutan yang sama dengan matriks input, tetapi bentuknya lebih kecil. Misalnya, dengan matriks input 28x28, filter dapat berupa matriks 2D apa pun yang lebih kecil dari 28x28.

Dalam manipulasi fotografi, semua sel dalam filter konvolusional biasanya ditetapkan ke pola konstanta satu dan nol. Dalam machine learning, filter konvolusional biasanya diisi dengan angka acak, lalu jaringan melatih nilai yang ideal.

lapisan konvolusional

Lapisan jaringan neural dalam yang mana saringan konvolusional diteruskan di semua matriks masukan. Misalnya, pertimbangkan saringan konvolusional 3x3 berikut:

![Matriks 3x3 dengan nilai berikut: [[0,1,0], [1,0,1], [0,1,0]]](https://developers.google.com/static/machine-learning/glossary/images/ConvolutionalFilter33.svg?authuser=3&hl=id)

Animasi berikut menunjukkan lapisan konvolusional yang terdiri dari 9 operasi konvolusional yang melibatkan matriks input 5x5. Perhatikan bahwa setiap operasi konvolusional bekerja pada potongan matriks input 3x3 yang berbeda. Matriks 3x3 yang dihasilkan (di sebelah kanan) terdiri dari hasil 9 operasi konvolusional:

![Animasi yang menampilkan dua matriks. Matriks pertama adalah matriks 5x5: [[128,97,53,201,198], [35,22,25,200,195], [37,24,28,197,182], [33,28,92,195,179], [31,40,100,192,177]].

Matriks kedua adalah matriks 3x3:

[[181,303,618], [115,338,605], [169,351,560]].

Matriks kedua dihitung dengan menerapkan filter konvolusional

[[0, 1, 0], [1, 0, 1], [0, 1, 0]] di berbagai

subset 3x3 dari matriks 5x5.](https://developers.google.com/static/machine-learning/glossary/images/AnimatedConvolution.gif?authuser=3&hl=id)

jaringan neural konvolusional

Jaringan neural yang setidaknya memiliki satu lapisan konvolusional. Jaringan neural konvolusional standar terdiri dari beberapa kombinasi lapisan berikut:

Jaringan neural konvolusional telah berhasil memecahkan masalah tertentu, seperti pengenalan gambar.

operasi konvolusional

Operasi matematika dua langkah berikut:

- Perkalian berbasis elemen dari saringan konvolusional dan potongan dari matriks masukan. (Potongan matriks input memiliki urutan dan ukuran yang sama dengan filter konvolusional.)

- Penjumlahan semua nilai dalam matriks produk yang dihasilkan.

Misalnya, perhatikan matriks input 5x5 berikut:

![Matriks 5x5: [[128,97,53,201,198], [35,22,25,200,195],

[37,24,28,197,182], [33,28,92,195,179], [31,40,100,192,177]].](https://developers.google.com/static/machine-learning/glossary/images/ConvolutionalLayerInputMatrix.svg?authuser=3&hl=id)

Sekarang, bayangkan filter konvolusional 2x2 berikut:

![Matriks 2x2: [[1, 0], [0, 1]]](https://developers.google.com/static/machine-learning/glossary/images/ConvolutionalLayerFilter.svg?authuser=3&hl=id)

Setiap operasi konvolusional melibatkan satu potongan 2x2 dari matriks input. Misalnya, kita menggunakan slice 2x2 di kiri atas matriks input. Jadi, operasi konvolusi pada slice ini akan terlihat seperti berikut:

![Menerapkan filter konvolusional [[1, 0], [0, 1]] ke bagian 2x2 kiri atas matriks input, yaitu [[128,97], [35,22]].

Filter konvolusional membiarkan 128 dan 22 tetap utuh, tetapi

menjadikan 97 dan 35 nol. Akibatnya, operasi konvolusi menghasilkan

nilai 150 (128+22).](https://developers.google.com/static/machine-learning/glossary/images/ConvolutionalLayerOperation.svg?authuser=3&hl=id)

Lapisan konvolusional terdiri dari serangkaian operasi konvolusional, masing-masing bekerja pada potongan matriks masukan yang berbeda.

COPA

Singkatan dari Choice of Plausible Alternatives.

biaya

Sinonim untuk loss.

pelatihan bersama

Pendekatan semi-supervised learning sangat berguna jika semua kondisi berikut terpenuhi:

- Rasio contoh tak berlabel terhadap contoh berlabel dalam set data tinggi.

- Ini adalah masalah klasifikasi (biner atau multi-kelas).

- Set data berisi dua set fitur prediktif berbeda yang independen dan saling melengkapi.

Pada dasarnya, pelatihan bersama memperkuat sinyal independen menjadi sinyal yang lebih kuat. Misalnya, pertimbangkan model klasifikasi yang mengategorikan setiap mobil bekas sebagai Baik atau Buruk. Satu set fitur prediksi dapat berfokus pada karakteristik gabungan seperti tahun, merek, dan model mobil; set fitur prediksi lainnya dapat berfokus pada catatan mengemudi pemilik sebelumnya dan riwayat perawatan mobil.

Makalah penting tentang pelatihan bersama adalah Combining Labeled and Unlabeled Data with Co-Training oleh Blum dan Mitchell.

keadilan kontrafaktual

Metrik keadilan yang memeriksa apakah model klasifikasi menghasilkan hasil yang sama untuk satu individu dengan individu lain yang identik dengan individu pertama, kecuali sehubungan dengan satu atau beberapa atribut sensitif. Mengevaluasi model klasifikasi untuk keadilan kontrafaktual adalah salah satu metode untuk menemukan potensi sumber bias dalam model.

Lihat salah satu informasi berikut untuk mengetahui informasi selengkapnya:

- Keadilan: Keadilan kontrafaktual dalam Kursus Singkat Machine Learning.

- When Worlds Collide: Integrating Different Counterfactual Assumptions in Fairness

bias cakupan

Lihat bias seleksi.

frasa ambigu

Kalimat atau frasa dengan makna ambigu. Frasa ambigu menghadirkan masalah yang signifikan dalam natural language understanding. Misalnya, judul Red Tape Holds Up Skyscraper adalah frasa ambigu karena model NLU dapat menafsirkan judul secara harfiah atau kiasan.

kritikus

Sinonim untuk Deep Q-Network.

entropi silang

Generalisasi Log Loss ke masalah klasifikasi multikelas. Entropi silang mengukur perbedaan antara dua distribusi probabilitas. Lihat juga perpleksitas.

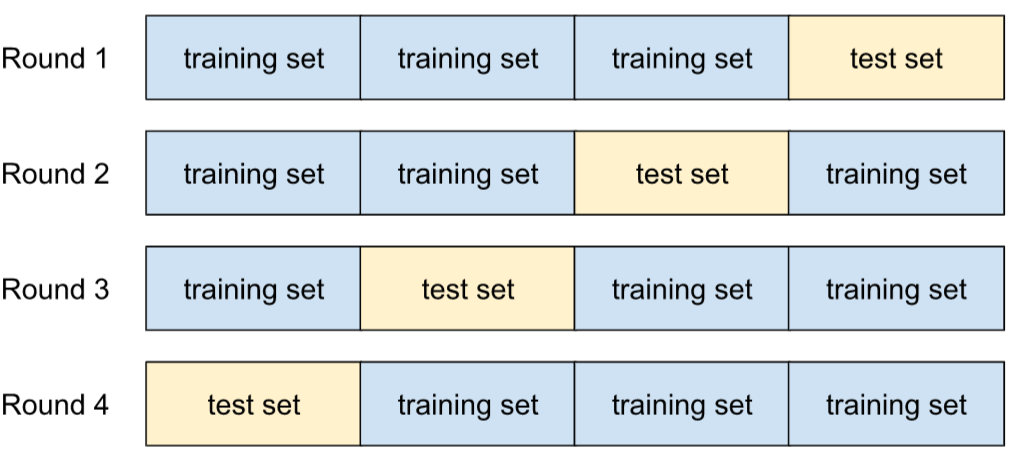

validasi silang

Mekanisme untuk memperkirakan seberapa baik model akan digeneralisasi ke data baru dengan menguji model terhadap satu atau beberapa subset data yang tidak tumpang-tindih yang tidak disertakan dari set pelatihan.

fungsi distribusi kumulatif (CDF)

Fungsi yang menentukan frekuensi sampel yang kurang dari atau sama dengan nilai target. Misalnya, pertimbangkan distribusi normal nilai berkelanjutan. CDF memberi tahu Anda bahwa sekitar 50% sampel harus kurang dari atau sama dengan rata-rata dan sekitar 84% sampel harus kurang dari atau sama dengan satu standar deviasi di atas rata-rata.

D

analisis data

Memperoleh pemahaman data dengan mempertimbangkan sampel, pengukuran, dan visualisasi. Analisis data dapat sangat berguna saat pertama kali set data diterima, sebelum membuat model yang pertama. Analisis data juga penting dalam memahami masalah eksperimen dan proses debug dengan sistem.

pengayaan data

Meningkatkan rentang dan jumlah contoh pelatihan secara artifisial dengan mengubah contoh yang ada untuk membuat contoh tambahan. Misalnya, anggaplah gambar adalah salah satu fitur Anda, tetapi set data Anda tidak berisi contoh gambar yang memadai bagi model untuk mempelajari asosiasi yang berguna. Idealnya, Anda akan menambahkan gambar berlabel yang memadai ke set data Anda agar model Anda dapat dilatih dengan benar. Jika tindakan tersebut tidak memungkinkan, pengayaan data dapat memutar, melebarkan, dan mencerminkan setiap gambar untuk memproduksi berbagai variasi dari gambar aslinya, yang mungkin menghasilkan data berlabel yang memadai agar dapat melakukan pelatihan yang sangat baik.

DataFrame

Jenis data pandas yang populer untuk merepresentasikan set data dalam memori.

DataFrame dapat dianalogikan dengan tabel atau spreadsheet. Setiap kolom DataFrame memiliki nama (header), dan setiap baris diidentifikasi oleh angka unik.

Setiap kolom dalam DataFrame disusun seperti array 2D, kecuali setiap kolom dapat diberi jenis datanya sendiri.

Lihat juga halaman referensi pandas.DataFrame resmi.

paralelisme data

Cara menskalakan pelatihan atau inferensi yang mereplikasi seluruh model ke beberapa perangkat, lalu meneruskan subset data input ke setiap perangkat. Paralelisme data dapat memungkinkan pelatihan dan inferensi pada ukuran batch yang sangat besar; namun, paralelisme data mengharuskan model cukup kecil agar dapat dimuat di semua perangkat.

Paralelisme data biasanya mempercepat pelatihan dan inferensi.

Lihat juga paralelisme model.

Dataset API (tf.data)

API TensorFlow tingkat tinggi untuk membaca data dan

mengubahnya menjadi bentuk yang diperlukan algoritma machine learning.

Objek tf.data.Dataset merepresentasikan urutan elemen, yang mana

setiap elemen berisi satu atau beberapa Tensor. Objek tf.data.Iterator

memberikan akses ke elemen Dataset.

kumpulan data atau set data (data set atau dataset)

Kumpulan data mentah, biasanya (tetapi tidak secara eksklusif) disusun dalam salah satu format berikut:

- spreadsheet

- file dalam format CSV (nilai yang dipisahkan koma)

batas keputusan

Pemisah antara kelas yang dipelajari oleh model dalam masalah klasifikasi biner atau klasifikasi multikelas. Misalnya, dalam gambar berikut yang merepresentasikan masalah klasifikasi biner, batas keputusannya adalah perbatasan antara kelas berwarna oranye dan kelas berwarna biru:

hutan keputusan

Model yang dibuat dari beberapa pohon keputusan. Hutan keputusan membuat prediksi dengan menggabungkan prediksi pohon keputusannya. Jenis hutan keputusan yang populer mencakup hutan acak dan pohon penguatan gradien.

Lihat bagian Decision Forests dalam kursus Decision Forests untuk mengetahui informasi selengkapnya.

nilai minimum keputusan

Sinonim untuk batas klasifikasi.

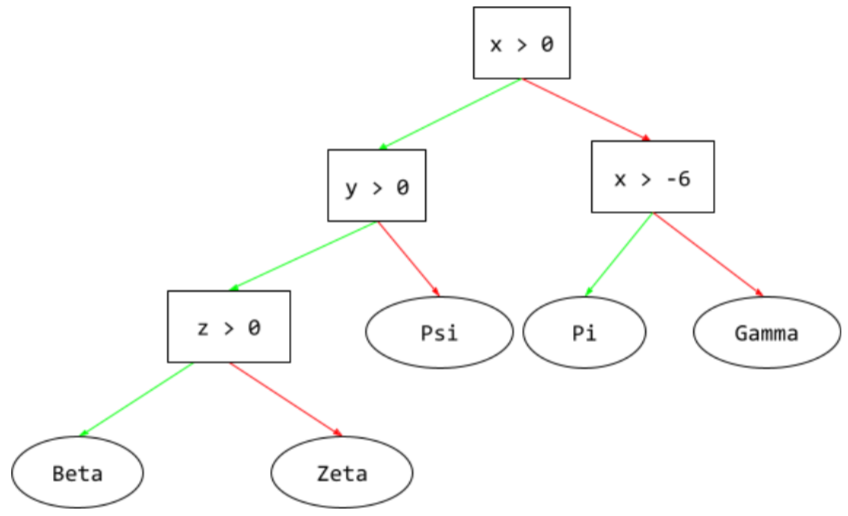

pohon keputusan

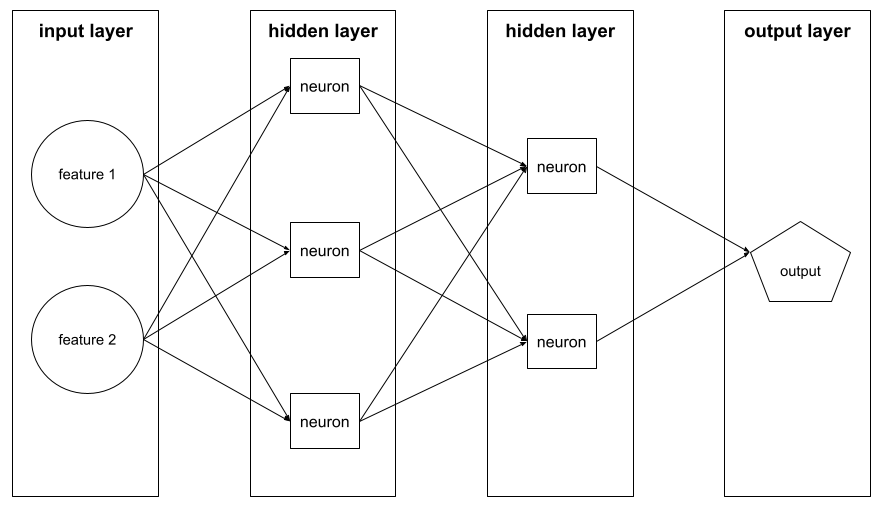

Model pembelajaran terawasi yang terdiri dari serangkaian kondisi dan daun yang disusun secara hierarkis. Misalnya, berikut adalah pohon keputusan:

decoder

Secara umum, sistem ML apa pun yang mengonversi dari representasi yang diproses, padat, atau internal ke representasi yang lebih mentah, jarang, atau eksternal.

Decoder sering kali menjadi komponen model yang lebih besar, yang sering kali dipasangkan dengan encoder.

Dalam tugas sequence-to-sequence, decoder dimulai dengan status internal yang dihasilkan oleh encoder untuk memprediksi urutan berikutnya.

Lihat Transformer untuk mengetahui definisi decoder dalam arsitektur Transformer.

Lihat Model bahasa yang besar di Kursus Singkat Machine Learning untuk mengetahui informasi selengkapnya.

deep model

Jaringan neural yang berisi lebih dari satu lapisan tersembunyi.

Model dalam juga disebut deep neural network.

Berbeda dengan model lebar.

yang sangat populer

Sinonim untuk model dalam.

Deep Q-Network (DQN)

Dalam Q-learning, jaringan neural deep learning yang memprediksi fungsi Q.

Critic adalah sinonim untuk Deep Q-Network.

paritas demografis

Metrik keadilan yang terpenuhi jika hasil klasifikasi model tidak bergantung pada atribut sensitif tertentu.

Misalnya, jika orang Lilliput dan Brobdingnag mendaftar ke Universitas Glubbdubdrib, paritas demografi tercapai jika persentase orang Lilliput yang diterima sama dengan persentase orang Brobdingnag yang diterima, terlepas dari apakah satu kelompok rata-rata lebih memenuhi syarat daripada kelompok lainnya.

Berbeda dengan peluang yang sama dan kesetaraan peluang, yang memungkinkan hasil klasifikasi secara keseluruhan bergantung pada atribut sensitif, tetapi tidak memungkinkan hasil klasifikasi untuk label kebenaran nyata tertentu bergantung pada atribut sensitif. Lihat "Menangkal diskriminasi dengan machine learning yang lebih cerdas" untuk visualisasi yang mengeksplorasi pertukaran saat mengoptimalkan kesetaraan demografis.

Lihat Keadilan: kesetaraan demografis di Kursus Singkat Machine Learning untuk mengetahui informasi selengkapnya.

pengurangan noise

Pendekatan umum untuk self-supervised learning yang:

Proses menghilangkan derau memungkinkan pembelajaran dari contoh tanpa label. Set data asli berfungsi sebagai target atau label dan data yang tidak relevan sebagai input.

Beberapa model bahasa yang disamarkan menggunakan penghilangan derau sebagai berikut:

- Derau ditambahkan secara buatan ke kalimat yang tidak berlabel dengan menyamarkan beberapa token.

- Model mencoba memprediksi token asli.

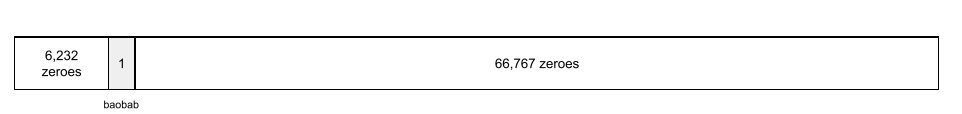

fitur padat

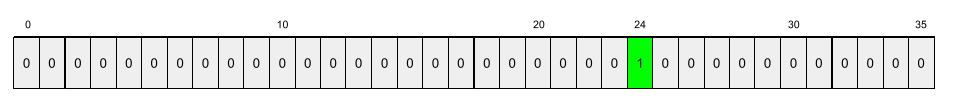

Fitur yang sebagian besar atau semua nilainya bukan nol, biasanya Tensor nilai floating point. Misalnya, Tensor 10 elemen berikut bersifat padat karena 9 nilainya bukan nol:

| 8 | 3 | 7 | 5 | 2 | 4 | 0 | 4 | 9 | 6 |

Berbeda dengan fitur renggang.

lapisan padat

Sinonim untuk lapisan terhubung sepenuhnya.

kedalaman

Jumlah berikut dalam jaringan neural:

- jumlah lapisan tersembunyi

- jumlah lapisan output, yang biasanya 1

- jumlah lapisan penyematan

Misalnya, jaringan neural dengan lima lapisan tersembunyi dan satu lapisan keluaran memiliki kedalaman 6.

Perhatikan bahwa lapisan input tidak memengaruhi kedalaman.

jaringan neural konvolusional yang dapat dipisahkan menurut kedalaman (sepCNN)

Arsitektur jaringan neural konvolusional berdasarkan Inception, tetapi modul Inception diganti dengan konvolusi yang dapat dipisahkan menurut kedalaman. Juga dikenal sebagai Xception.

Konvolusi yang dapat dipisahkan per kedalaman (juga disingkat sebagai konvolusi yang dapat dipisahkan) memfaktorkan konvolusi 3D standar menjadi dua operasi konvolusi terpisah yang lebih efisien secara komputasi: pertama, konvolusi per kedalaman, dengan kedalaman 1 (n ✕ n ✕ 1), dan kemudian, konvolusi pointwise, dengan panjang dan lebar 1 (1 ✕ 1 ✕ n).

Untuk mempelajari lebih lanjut, lihat Xception: Deep Learning with Depthwise Separable Convolutions.

label turunan

Sinonim untuk label proxy.

perangkat

Istilah yang memiliki lebih dari satu definisi dengan dua kemungkinan definisi berikut:

- Kategori hardware yang dapat menjalankan sesi TensorFlow, yang meliputi CPU, GPU, dan TPU.

- Saat melatih model ML di chip akselerator (GPU atau TPU), bagian sistem yang benar-benar memanipulasi tensor dan embedding. Perangkat berjalan di chip akselerator. Sebaliknya, host biasanya berjalan di CPU.

privasi diferensial

Dalam machine learning, pendekatan anonimisasi untuk melindungi data sensitif apa pun (misalnya, informasi pribadi seseorang) yang disertakan dalam set data pelatihan model agar tidak terekspos. Pendekatan ini memastikan bahwa model tidak mempelajari atau mengingat banyak hal tentang individu tertentu. Hal ini dilakukan dengan mengambil sampel dan menambahkan derau selama pelatihan model untuk mengaburkan titik data individual, sehingga mengurangi risiko tereksposnya data pelatihan sensitif.

Privasi diferensial juga digunakan di luar machine learning. Misalnya, ilmuwan data terkadang menggunakan privasi diferensial untuk melindungi privasi individu saat menghitung statistik penggunaan produk untuk berbagai demografi.

pengurangan dimensi

Menurunkan jumlah dimensi yang digunakan untuk merepresentasikan fitur tertentu dalam vektor fitur, biasanya dengan melakukan konversi menjadi vektor embedding.

dimensi

Istilah yang memiliki lebih dari satu definisi:

Jumlah tingkat koordinat dalam Tensor. Contoh:

- Skalar memiliki nol dimensi; misalnya,

["Hello"]. - Vektor memiliki satu dimensi; misalnya,

[3, 5, 7, 11]. - Matriks memiliki dua dimensi; misalnya,

[[2, 4, 18], [5, 7, 14]]. Anda dapat secara unik menetapkan sel tertentu dalam vektor satu dimensi dengan satu koordinat; Anda memerlukan dua koordinat untuk secara unik menetapkan sebuah sel dalam matriks dua dimensi.

- Skalar memiliki nol dimensi; misalnya,

Jumlah entri dalam vektor fitur.

Jumlah elemen dalam lapisan penyematan.

perintah langsung

Sinonim untuk zero-shot prompting.

fitur diskret

Fitur dengan set kemungkinan nilai yang terbatas. Misalnya, fitur yang nilainya hanya dapat berupa hewan, sayuran, atau mineral adalah fitur diskrit (atau kategoris).

Berbeda dengan fitur berkelanjutan.

model diskriminatif

Model yang memprediksi label dari serangkaian fitur. Secara lebih formal, model diskriminatif menentukan probabilitas bersyarat output berdasarkan fitur dan bobot; yaitu:

p(output | features, weights)

Misalnya, model yang memprediksi apakah email adalah spam dari fitur dan bobot adalah model diskriminatif.

Sebagian besar model supervised learning, termasuk model klasifikasi dan regresi, adalah model diskriminatif.

Berbeda dengan model generatif.

diskriminator

Sistem yang menentukan apakah contoh itu nyata atau palsu.

Atau, subsistem dalam jaringan adversarial generatif yang menentukan apakah contoh yang dibuat oleh generator itu nyata atau palsu.

Lihat Diskriminator dalam kursus GAN untuk mengetahui informasi selengkapnya.

dampak yang tidak seimbang

Membuat keputusan tentang orang-orang yang berdampak tidak proporsional pada subgrup populasi yang berbeda. Hal ini biasanya merujuk pada situasi ketika proses pengambilan keputusan algoritmik merugikan atau menguntungkan beberapa subgrup lebih dari subgrup lainnya.

Misalnya, algoritma yang menentukan kelayakan seorang Lilliput untuk mendapatkan pinjaman rumah miniatur lebih cenderung mengklasifikasikannya sebagai "tidak memenuhi syarat" jika alamat suratnya berisi kode pos tertentu. Jika Liliput Big-Endian lebih cenderung memiliki alamat surat dengan kode pos ini daripada Liliput Little-Endian, maka algoritma ini dapat menimbulkan dampak yang tidak setara.

Berbeda dengan perlakuan tidak setara, yang berfokus pada perbedaan yang terjadi saat karakteristik subgrup menjadi input eksplisit untuk proses pengambilan keputusan algoritma.

perlakuan yang berbeda

Memasukkan atribut sensitif subjek ke dalam proses pengambilan keputusan algoritma sehingga subgrup orang yang berbeda diperlakukan secara berbeda.

Misalnya, pertimbangkan algoritma yang menentukan kelayakan orang Lilliput untuk mendapatkan pinjaman rumah mini berdasarkan data yang mereka berikan dalam permohonan pinjaman. Jika algoritma menggunakan afiliasi Lilliputian sebagai Big-Endian atau Little-Endian sebagai input, algoritma tersebut menerapkan perlakuan berbeda di sepanjang dimensi tersebut.

Berbeda dengan dampak tidak setara, yang berfokus pada perbedaan dalam dampak sosial keputusan algoritmik pada subgrup, terlepas dari apakah subgrup tersebut merupakan input ke model atau tidak.

distilasi

Proses mengurangi ukuran satu model (dikenal sebagai pengajar) menjadi model yang lebih kecil (dikenal sebagai siswa) yang meniru prediksi model asli seakurat mungkin. Distilasi berguna karena model yang lebih kecil memiliki dua manfaat utama dibandingkan model yang lebih besar (pengajar):

- Waktu inferensi yang lebih cepat

- Mengurangi penggunaan memori dan energi

Namun, prediksi siswa biasanya tidak sebaik prediksi pengajar.

Distilasi melatih model siswa untuk meminimalkan fungsi loss berdasarkan perbedaan antara output prediksi model siswa dan model pengajar.

Bandingkan dan bedakan distilasi dengan istilah berikut:

Lihat LLM: Penyesuaian, distilasi, dan teknik perintah di Kursus Singkat Machine Learning untuk mengetahui informasi selengkapnya.

distribusi

Frekuensi dan rentang nilai yang berbeda untuk fitur atau label tertentu. Distribusi menunjukkan seberapa besar kemungkinan suatu nilai tertentu.

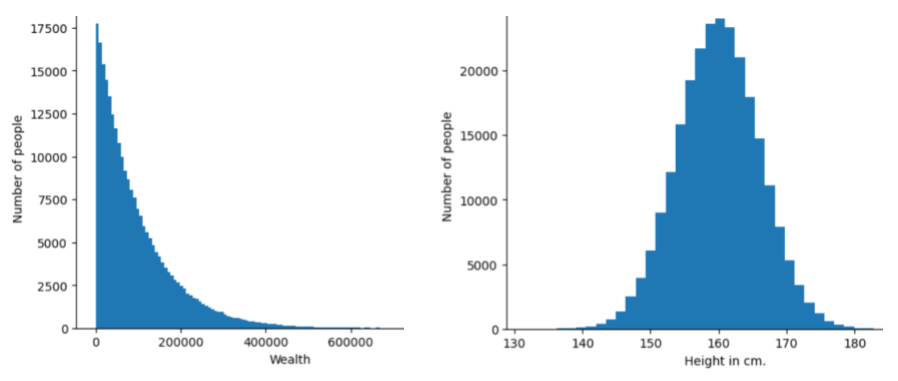

Gambar berikut menunjukkan histogram dari dua distribusi yang berbeda:

- Di sebelah kiri, distribusi hukum pangkat kekayaan versus jumlah orang yang memiliki kekayaan tersebut.

- Di sebelah kanan, distribusi normal tinggi versus jumlah orang yang memiliki tinggi tersebut.

Memahami distribusi setiap fitur dan label dapat membantu Anda menentukan cara menormalisasi nilai dan mendeteksi pencilan.

Frasa di luar distribusi mengacu pada nilai yang tidak muncul dalam set data atau sangat jarang. Misalnya, gambar planet Saturnus akan dianggap di luar distribusi untuk set data yang terdiri dari gambar kucing.

pengelompokan divisif

Lihat pengelompokan hierarkis.

penurunan/pengurangan sampel

Istilah yang memiliki lebih dari satu makna:

- Mengurangi jumlah informasi dalam fitur untuk melatih model secara lebih efisien. Misalnya, sebelum melatih model pengenalan gambar, lakukan downsampling pada gambar beresolusi tinggi ke format beresolusi lebih rendah.

- Melatih contoh kelas yang terlalu banyak direpresentasikan dengan persentase rendah dan tidak proporsional untuk meningkatkan pelatihan model pada kelas yang kurang direpresentasikan. Misalnya, dalam dataset tidak seimbang kelas, model cenderung mempelajari banyak hal tentang kelas mayoritas dan tidak cukup tentang kelas minoritas. Penurunan/pengurangan sampel membantu menyeimbangkan jumlah pelatihan pada kelas mayoritas dan minoritas.

Lihat Set data: Set data tidak seimbang di Kursus Singkat Machine Learning untuk mengetahui informasi selengkapnya.

DQN

Singkatan dari Deep Q-Network.

regularisasi dengan pelolosan

Bentuk regularisasi yang berguna dalam melatih jaringan neural. Regularisasi dengan pelolosan menghapus pilihan acak dari unit yang berjumlah tetap dalam lapisan jaringan untuk satu langkah gradien. Makin banyak unit yang dihilangkan, makin kuat regularisasinya. Hal ini dianalogikan dengan pelatihan jaringan untuk mengemulasi ansambel yang besar dari jaringan yang lebih kecil. Untuk mengetahui detail selengkapnya, lihat Pelolosan: Cara Sederhana untuk Mencegah Overfitting pada Jaringan Neural.

dinamis

Sesuatu yang dilakukan secara sering atau terus-menerus. Istilah dinamis dan online merupakan sinonim dalam machine learning. Berikut adalah penggunaan umum dinamis dan online dalam machine learning:

- Model dinamis (atau model online) adalah model yang dilatih ulang secara sering atau terus-menerus.

- Pelatihan dinamis (atau pelatihan online) adalah proses pelatihan yang dilakukan secara sering atau terus-menerus.

- Inferensi dinamis (atau inferensi online) adalah proses membuat prediksi sesuai permintaan.

model dinamis

Model yang sering (bahkan terus-menerus) dilatih ulang. Model dinamis adalah "pembelajar seumur hidup" yang terus beradaptasi dengan data yang terus berkembang. Model dinamis juga dikenal sebagai model online.

Berbeda dengan model statis.

E

eksekusi segera

Lingkungan pemrograman TensorFlow yang mana operasi dijalankan secara langsung. Sebaliknya, operasi yang disebut dengan eksekusi grafik tidak akan dijalankan sampai dievaluasi secara eksplisit. Eksekusi segera adalah antarmuka imperatif, seperti kode dalam sebagian besar bahasa pemrograman. Program eksekusi segera umumnya jauh lebih mudah untuk dilakukan debug daripada program eksekusi grafik.

penghentian awal

Metode regularisasi yang melibatkan pengakhiran pelatihan sebelum kerugian pelatihan selesai menurun. Dalam penghentian awal, Anda sengaja menghentikan pelatihan model saat kerugian pada set data validasi mulai meningkat; yaitu, saat performa generalisasi memburuk.

Berbeda dengan keluar lebih awal.

jarak pemindah tanah (EMD)

Ukuran kesamaan relatif dari dua distribusi. Makin rendah jarak penggerak tanah, makin mirip distribusinya.

jarak pengeditan

Pengukuran seberapa mirip dua string teks satu sama lain. Dalam machine learning, jarak edit berguna karena alasan berikut:

- Jarak pengeditan mudah dihitung.

- Jarak edit dapat membandingkan dua string yang diketahui serupa satu sama lain.

- Jarak pengeditan dapat menentukan tingkat kesamaan string yang berbeda dengan string tertentu.

Ada beberapa definisi jarak pengeditan, yang masing-masing menggunakan operasi string yang berbeda. Lihat Jarak Levenshtein untuk melihat contohnya.

Notasi Einsum

Notasi yang efisien untuk menjelaskan cara menggabungkan dua tensor. Tensor digabungkan dengan mengalikan elemen satu tensor dengan elemen tensor lainnya, lalu menjumlahkan hasil perkaliannya. Notasi Einsum menggunakan simbol untuk mengidentifikasi sumbu setiap tensor, dan simbol yang sama tersebut disusun ulang untuk menentukan bentuk tensor baru yang dihasilkan.

NumPy menyediakan implementasi Einsum umum.

lapisan penyematan