این واژهنامه اصطلاحات هوش مصنوعی را تعریف میکند.

الف

فرسایش

تکنیکی برای ارزیابی اهمیت یک ویژگی یا مؤلفه با حذف موقت آن از یک مدل . سپس مدل را بدون آن ویژگی یا مؤلفه مجدداً آموزش میدهید و اگر مدل آموزش مجدد شده عملکرد بهطور قابلتوجهی بدتری داشته باشد، احتمالاً ویژگی یا مؤلفه حذفشده مهم بوده است.

برای مثال، فرض کنید یک مدل طبقهبندی را با ۱۰ ویژگی آموزش میدهید و در مجموعه تست به دقت ۸۸٪ دست مییابید. برای بررسی اهمیت اولین ویژگی، میتوانید مدل را تنها با استفاده از نه ویژگی دیگر دوباره آموزش دهید. اگر مدل آموزش مجدد عملکرد بسیار بدتری داشته باشد (مثلاً ۵۵٪ دقت)، احتمالاً ویژگی حذف شده مهم بوده است. برعکس، اگر مدل آموزش مجدد عملکرد یکسانی داشته باشد، احتمالاً آن ویژگی چندان مهم نبوده است.

ابلیشن همچنین میتواند به تعیین اهمیت موارد زیر کمک کند:

- اجزای بزرگتر، مانند یک زیرسیستم کامل از یک سیستم یادگیری ماشینی بزرگتر

- فرآیندها یا تکنیکها، مانند مرحله پیشپردازش دادهها

در هر دو مورد، شما مشاهده خواهید کرد که چگونه عملکرد سیستم پس از حذف آن قطعه تغییر میکند (یا تغییر نمیکند).

تست A/B

یک روش آماری برای مقایسه دو (یا چند) تکنیک - تکنیک A و B. معمولاً تکنیک A یک تکنیک موجود و تکنیک B یک تکنیک جدید است. تست A/B نه تنها مشخص میکند که کدام تکنیک عملکرد بهتری دارد، بلکه مشخص میکند که آیا این تفاوت از نظر آماری معنادار است یا خیر.

تست A/B معمولاً یک معیار واحد را در دو تکنیک مقایسه میکند؛ برای مثال، دقت مدل برای دو تکنیک چگونه مقایسه میشود؟ با این حال، تست A/B میتواند هر تعداد محدودی از معیارها را نیز مقایسه کند.

تراشه شتابدهنده

دستهای از قطعات سختافزاری تخصصی که برای انجام محاسبات کلیدی مورد نیاز الگوریتمهای یادگیری عمیق طراحی شدهاند.

تراشههای شتابدهنده (یا به اختصار شتابدهندهها ) میتوانند سرعت و کارایی وظایف آموزش و استنتاج را در مقایسه با یک پردازندهی مرکزی همه منظوره به طور قابل توجهی افزایش دهند. آنها برای آموزش شبکههای عصبی و وظایف محاسباتی مشابه ایدهآل هستند.

نمونههایی از تراشههای شتابدهنده عبارتند از:

- واحدهای پردازش تنسور ( TPU ) گوگل با سختافزار اختصاصی برای یادگیری عمیق.

- پردازندههای گرافیکی انویدیا که اگرچه در ابتدا برای پردازش گرافیکی طراحی شده بودند، اما برای پردازش موازی نیز طراحی شدهاند که میتواند سرعت پردازش را به میزان قابل توجهی افزایش دهد.

دقت

تعداد پیشبینیهای طبقهبندی صحیح تقسیم بر تعداد کل پیشبینیها. یعنی:

برای مثال، مدلی که ۴۰ پیشبینی درست و ۱۰ پیشبینی نادرست انجام داده باشد، دقتی برابر با:

طبقهبندی دودویی نامهای خاصی را برای دستههای مختلف پیشبینیهای درست و پیشبینیهای نادرست ارائه میدهد. بنابراین، فرمول دقت برای طبقهبندی دودویی به شرح زیر است:

کجا:

- TP تعداد موارد مثبت واقعی (پیشبینیهای صحیح) است.

- TN تعداد منفیهای واقعی (پیشبینیهای صحیح) است.

- FP تعداد مثبتهای کاذب (پیشبینیهای نادرست) است.

- FN تعداد نتایج منفی کاذب (پیشبینیهای نادرست) است.

دقت را با دقت و یادآوری مقایسه و مقابله کنید.

برای اطلاعات بیشتر به بخش طبقهبندی: دقت، فراخوانی، دقت و معیارهای مرتبط در دوره فشرده یادگیری ماشین مراجعه کنید.

عمل

در یادگیری تقویتی ، مکانیزمی که عامل از طریق آن بین حالتهای محیط جابجا میشود. عامل با استفاده از یک سیاست ، عمل را انتخاب میکند.

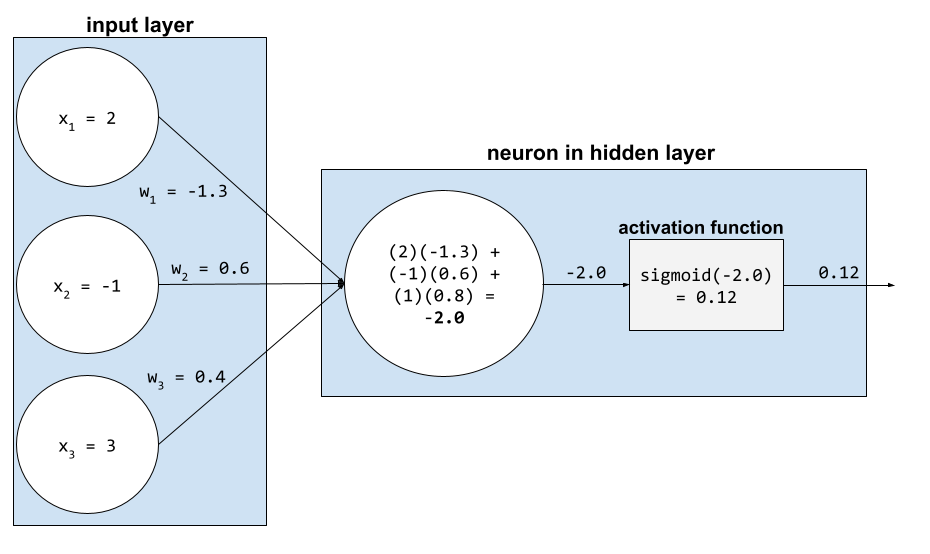

تابع فعالسازی

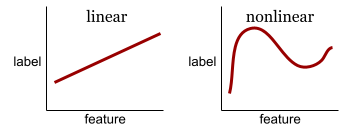

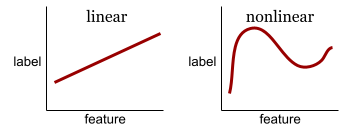

تابعی که شبکههای عصبی را قادر میسازد روابط غیرخطی (پیچیده) بین ویژگیها و برچسب را یاد بگیرند.

توابع فعالسازی محبوب عبارتند از:

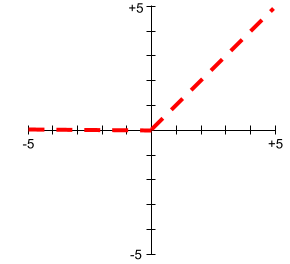

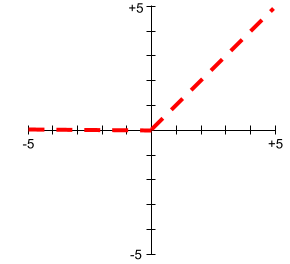

نمودارهای توابع فعالسازی هرگز به صورت خطوط مستقیم منفرد نیستند. برای مثال، نمودار تابع فعالسازی ReLU از دو خط مستقیم تشکیل شده است:

نمودار تابع فعالسازی سیگموئید به شکل زیر است:

برای اطلاعات بیشتر به بخش شبکههای عصبی: توابع فعالسازی در دوره فشرده یادگیری ماشین مراجعه کنید.

یادگیری فعال

یک رویکرد آموزشی که در آن الگوریتم برخی از دادههایی را که از آنها یاد میگیرد، انتخاب میکند . یادگیری فعال به ویژه زمانی ارزشمند است که نمونههای برچسبگذاری شده کمیاب یا گران باشند. به جای جستجوی کورکورانه طیف متنوعی از نمونههای برچسبگذاری شده، یک الگوریتم یادگیری فعال به طور انتخابی طیف خاصی از نمونههایی را که برای یادگیری نیاز دارد، جستجو میکند.

آداگراد

یک الگوریتم گرادیان نزولی پیچیده که گرادیانهای هر پارامتر را تغییر مقیاس میدهد و عملاً به هر پارامتر نرخ یادگیری مستقلی میدهد. برای توضیح کامل، به روشهای زیرگرادیان تطبیقی برای یادگیری آنلاین و بهینهسازی تصادفی مراجعه کنید.

انطباق

مترادف برای تنظیم یا تنظیم دقیق .

عامل

نرمافزاری که میتواند ورودیهای چندوجهی کاربر را به منظور برنامهریزی و اجرای اقدامات از طرف کاربر، استدلال کند.

در یادگیری تقویتی ، یک عامل، موجودیتی است که از یک سیاست برای به حداکثر رساندن بازده مورد انتظار حاصل از انتقال بین حالتهای محیط استفاده میکند.

عامل

صفت فاعل . Agentic به ویژگیهایی که فاعلها دارند (مانند خودمختاری) اشاره دارد.

گردش کار عاملی

فرآیندی پویا که در آن یک عامل به طور مستقل اقداماتی را برای دستیابی به یک هدف برنامهریزی و اجرا میکند. این فرآیند ممکن است شامل استدلال، فراخوانی ابزارهای خارجی و خوداصلاحی برنامه خود باشد.

خوشهبندی تجمعی

خوشهبندی سلسله مراتبی را ببینید.

شیب هوش مصنوعی

خروجی از یک سیستم هوش مصنوعی مولد که کمیت را بر کیفیت ترجیح میدهد. به عنوان مثال، یک صفحه وب با شیب هوش مصنوعی پر از محتوای بیکیفیت، تولید شده توسط هوش مصنوعی و ارزان است.

تشخیص ناهنجاری

فرآیند شناسایی دادههای پرت . به عنوان مثال، اگر میانگین یک ویژگی خاص ۱۰۰ با انحراف معیار ۱۰ باشد، تشخیص ناهنجاری باید مقدار ۲۰۰ را به عنوان مشکوک علامتگذاری کند.

واقعیت افزوده

مخفف واقعیت افزوده .

مساحت زیر منحنی PR

به PR AUC (مساحت زیر منحنی PR) مراجعه کنید.

مساحت زیر منحنی ROC

به AUC (مساحت زیر منحنی ROC) مراجعه کنید.

هوش عمومی مصنوعی

یک مکانیسم غیرانسانی که طیف گستردهای از حل مسئله، خلاقیت و سازگاری را نشان میدهد. برای مثال، برنامهای که هوش عمومی مصنوعی را نشان میدهد میتواند متن را ترجمه کند، سمفونی بسازد و در بازیهایی که هنوز اختراع نشدهاند، سرآمد باشد.

هوش مصنوعی

یک برنامه یا مدل غیرانسانی که میتواند وظایف پیچیده را حل کند. به عنوان مثال، برنامه یا مدلی که متن را ترجمه میکند یا برنامه یا مدلی که بیماریها را از تصاویر رادیولوژی شناسایی میکند، هر دو هوش مصنوعی را نشان میدهند.

بهطور رسمی، یادگیری ماشینی زیرمجموعهای از هوش مصنوعی است. با این حال، در سالهای اخیر، برخی سازمانها شروع به استفاده از اصطلاحات هوش مصنوعی و یادگیری ماشینی به جای یکدیگر کردهاند.

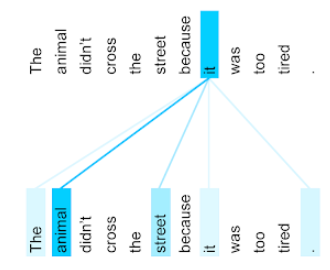

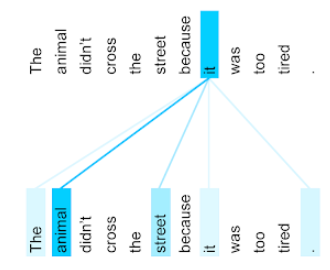

توجه

مکانیزمی که در یک شبکه عصبی استفاده میشود و اهمیت یک کلمه یا بخشی از یک کلمه خاص را نشان میدهد. توجه، میزان اطلاعاتی را که یک مدل برای پیشبینی توکن/کلمه بعدی نیاز دارد، فشرده میکند. یک مکانیزم توجه معمولی ممکن است شامل یک جمع وزنی روی مجموعهای از ورودیها باشد، که در آن وزن هر ورودی توسط بخش دیگری از شبکه عصبی محاسبه میشود.

همچنین به توجه به خود و توجه به خود چند سر ، که بلوکهای سازندهی ترانسفورماتورها هستند، اشاره کنید.

برای اطلاعات بیشتر در مورد توجه به خود، به بخش LLMها: مدل زبان بزرگ چیست؟ در دوره فشرده یادگیری ماشین مراجعه کنید.

ویژگی

مترادف ویژگی .

در انصاف یادگیری ماشین، ویژگیها اغلب به ویژگیهای مربوط به افراد اشاره دارند.

نمونهبرداری ویژگی

تاکتیکی برای آموزش یک جنگل تصمیم که در آن هر درخت تصمیم هنگام یادگیری شرط ، تنها زیرمجموعهای تصادفی از ویژگیهای ممکن را در نظر میگیرد. بهطورکلی، برای هر گره، زیرمجموعهای متفاوت از ویژگیها نمونهبرداری میشود. در مقابل، هنگام آموزش یک درخت تصمیم بدون نمونهبرداری از ویژگیها، تمام ویژگیهای ممکن برای هر گره در نظر گرفته میشود.

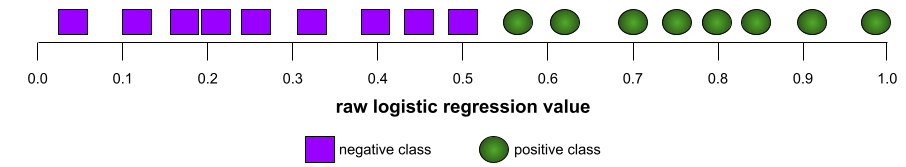

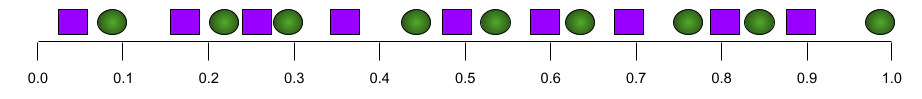

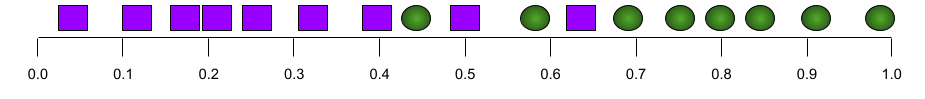

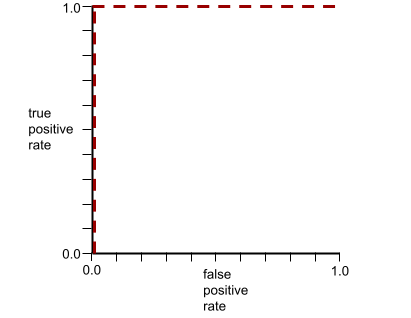

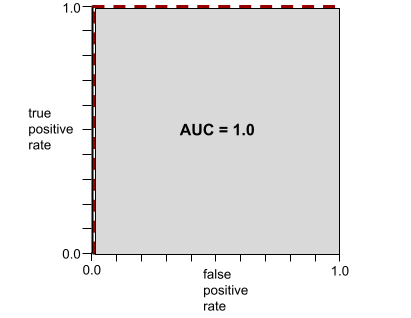

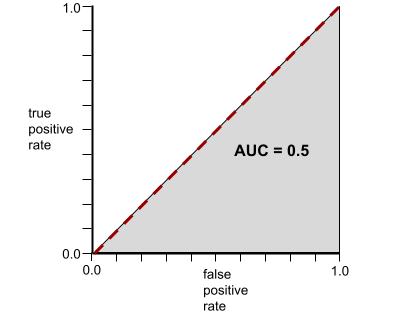

AUC (مساحت زیر منحنی ROC)

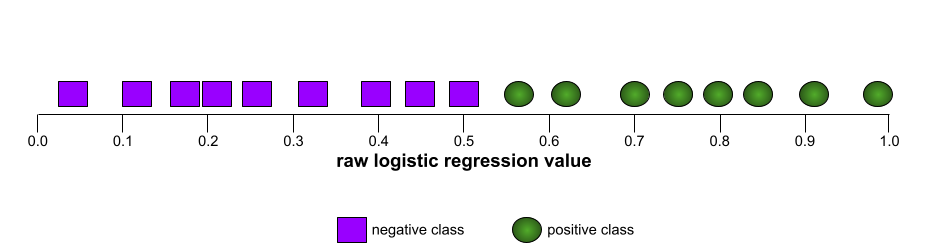

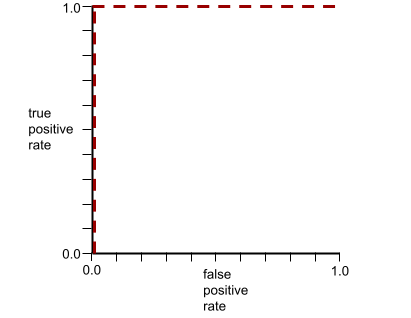

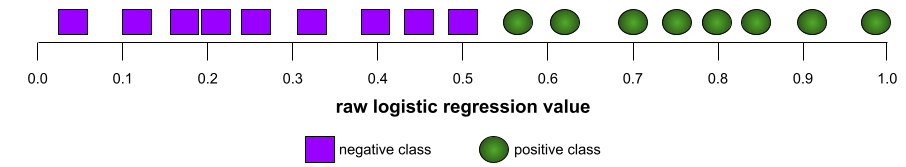

عددی بین ۰.۰ و ۱.۰ که نشاندهنده توانایی یک مدل طبقهبندی دودویی در جداسازی کلاسهای مثبت از کلاسهای منفی است. هرچه AUC به ۱.۰ نزدیکتر باشد، توانایی مدل در جداسازی کلاسها از یکدیگر بهتر است.

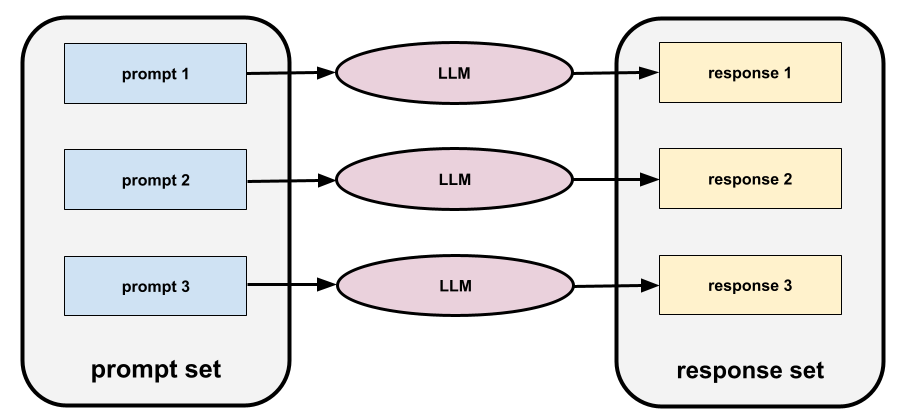

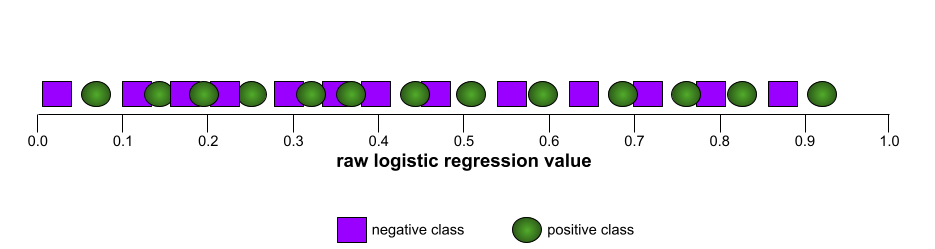

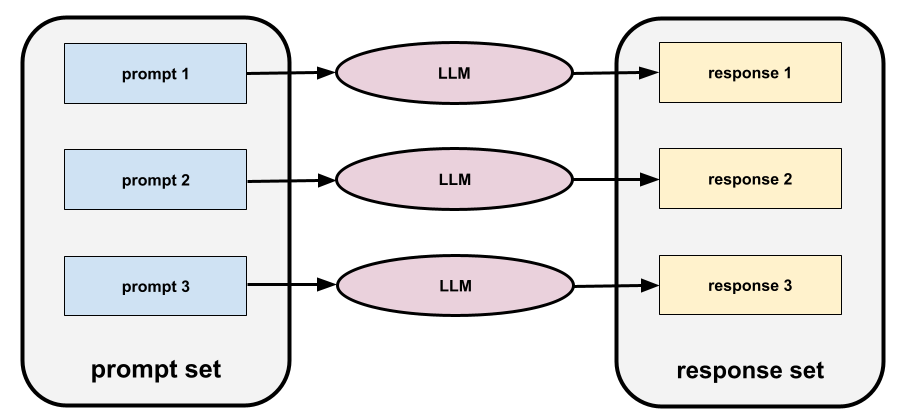

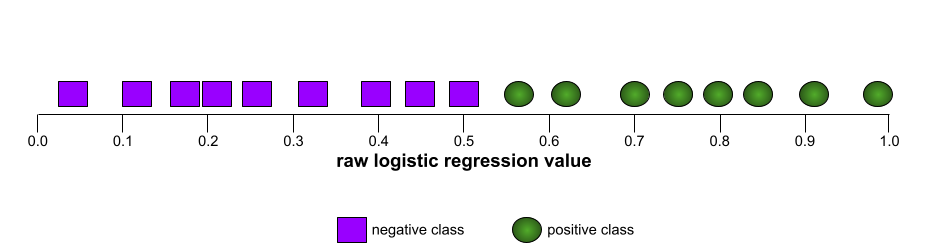

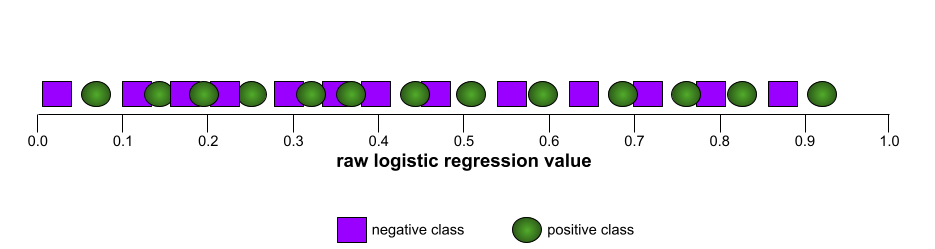

برای مثال، تصویر زیر یک مدل طبقهبندی را نشان میدهد که کلاسهای مثبت (بیضیهای سبز) را از کلاسهای منفی (مستطیلهای بنفش) به طور کامل جدا میکند. این مدل که به طور غیرواقعی بینقص است، AUC برابر با ۱.۰ دارد:

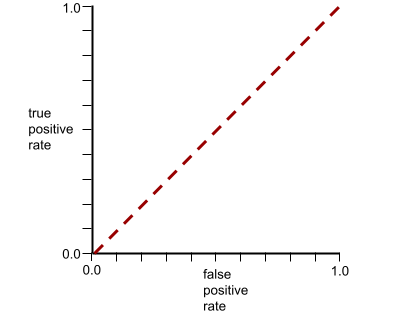

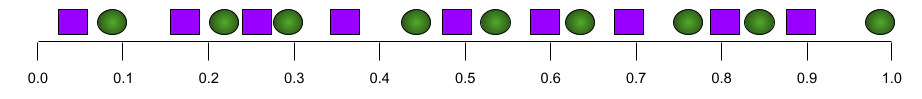

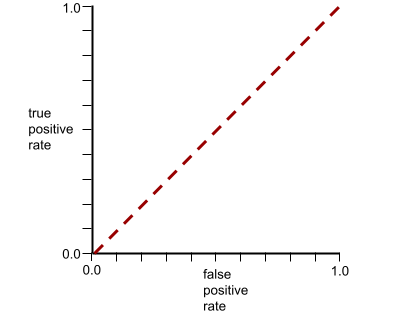

برعکس، تصویر زیر نتایج یک مدل طبقهبندی را نشان میدهد که نتایج تصادفی تولید کرده است. این مدل دارای AUC برابر با 0.5 است:

بله، مدل قبلی AUC برابر با 0.5 دارد، نه 0.0.

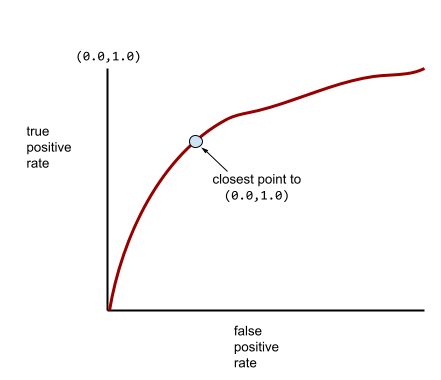

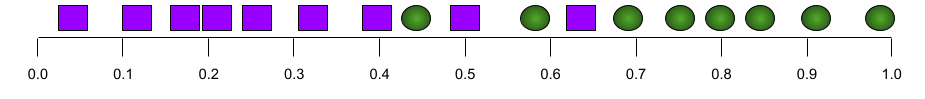

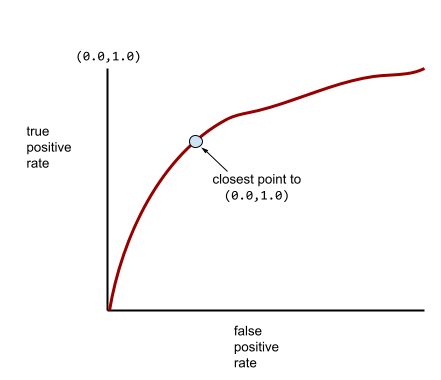

بیشتر مدلها جایی بین این دو حالت افراطی قرار دارند. برای مثال، مدل زیر تا حدودی موارد مثبت را از موارد منفی جدا میکند و بنابراین AUC آن بین 0.5 تا 1.0 است:

AUC هر مقداری را که برای آستانه طبقهبندی تعیین میکنید، نادیده میگیرد. در عوض، AUC تمام آستانههای طبقهبندی ممکن را در نظر میگیرد.

برای اطلاعات بیشتر به بخش طبقهبندی: ROC و AUC در دوره فشرده یادگیری ماشین مراجعه کنید.

واقعیت افزوده

فناوریای که یک تصویر تولید شده توسط رایانه را بر روی دیدگاه کاربر از دنیای واقعی قرار میدهد و در نتیجه یک نمای ترکیبی ارائه میدهد.

رمزگذار خودکار

سیستمی که یاد میگیرد مهمترین اطلاعات را از ورودی استخراج کند. رمزگذارهای خودکار ترکیبی از رمزگذار و رمزگشا هستند. رمزگذارهای خودکار بر فرآیند دو مرحلهای زیر متکی هستند:

- رمزگذار، ورودی را به یک فرمت (معمولاً) با ابعاد پایینتر (میانی) و از نوع اتلافی نگاشت میکند.

- رمزگشا با نگاشت فرمت با ابعاد پایینتر به فرمت ورودی با ابعاد بالاتر اصلی، یک نسخه با اتلاف از ورودی اصلی میسازد.

رمزگذارهای خودکار به صورت پیوسته آموزش داده میشوند، به این صورت که رمزگشا سعی میکند ورودی اصلی را تا حد امکان از فرمت میانی رمزگذار بازسازی کند. از آنجا که فرمت میانی کوچکتر (کمبعدتر) از فرمت اصلی است، رمزگذار خودکار مجبور است یاد بگیرد که چه اطلاعاتی در ورودی ضروری است و خروجی کاملاً با ورودی یکسان نخواهد بود.

برای مثال:

- اگر داده ورودی یک تصویر باشد، کپی غیردقیق مشابه تصویر اصلی خواهد بود، اما تا حدودی اصلاح شده است. شاید کپی غیردقیق نویز را از تصویر اصلی حذف کند یا برخی از پیکسلهای از دست رفته را پر کند.

- اگر داده ورودی متن باشد، یک رمزگذار خودکار متن جدیدی تولید میکند که از متن اصلی تقلید میکند (اما دقیقاً مشابه آن نیست).

همچنین به خودرمزگذارهای متغیر مراجعه کنید.

ارزیابی خودکار

استفاده از نرمافزار برای قضاوت در مورد کیفیت خروجی یک مدل.

وقتی خروجی مدل نسبتاً سرراست باشد، یک اسکریپت یا برنامه میتواند خروجی مدل را با یک پاسخ طلایی مقایسه کند. این نوع ارزیابی خودکار گاهی اوقات ارزیابی برنامهریزیشده نامیده میشود. معیارهایی مانند ROUGE یا BLEU اغلب برای ارزیابی برنامهریزیشده مفید هستند.

وقتی خروجی مدل پیچیده است یا هیچ پاسخ صحیحی ندارد، گاهی اوقات یک برنامه یادگیری ماشین جداگانه به نام autorater ارزیابی خودکار را انجام میدهد.

در تضاد با ارزیابی انسانی .

سوگیری اتوماسیون

وقتی یک تصمیمگیرنده انسانی، توصیههای ارائه شده توسط یک سیستم تصمیمگیری خودکار را به اطلاعات ارائه شده بدون اتوماسیون ترجیح میدهد، حتی زمانی که سیستم تصمیمگیری خودکار اشتباه کند.

برای اطلاعات بیشتر به انصاف: انواع سوگیری در دوره فشرده یادگیری ماشین مراجعه کنید.

اتوامال

هر فرآیند خودکار برای ساخت مدلهای یادگیری ماشین . AutoML میتواند به طور خودکار وظایفی مانند موارد زیر را انجام دهد:

- مناسبترین مدل را جستجو کنید.

- تنظیم ابرپارامترها .

- آمادهسازی دادهها (شامل انجام مهندسی ویژگیها ).

- مدل حاصل را مستقر کنید.

AutoML برای دانشمندان داده مفید است زیرا میتواند در زمان و تلاش آنها در توسعه خطوط لوله یادگیری ماشین صرفهجویی کند و دقت پیشبینی را بهبود بخشد. همچنین با قابل دسترستر کردن وظایف پیچیده یادگیری ماشین برای افراد غیرمتخصص، برای آنها نیز مفید است.

برای اطلاعات بیشتر به بخش یادگیری ماشین خودکار (AutoML) در دوره فشرده یادگیری ماشین مراجعه کنید.

ارزیابی خودکار

یک مکانیزم ترکیبی برای قضاوت در مورد کیفیت خروجی یک مدل هوش مصنوعی مولد که ارزیابی انسانی را با ارزیابی خودکار ترکیب میکند. یک autorater یک مدل یادگیری ماشینی است که بر روی دادههای ایجاد شده توسط ارزیابی انسانی آموزش دیده است. در حالت ایدهآل، یک autorater یاد میگیرد که از یک ارزیاب انسانی تقلید کند.ارزیابهای خودکار از پیش ساخته شده در دسترس هستند، اما بهترین ارزیابهای خودکار به طور خاص برای کاری که ارزیابی میکنید تنظیم شدهاند.

مدل خودرگرسیون

مدلی که پیشبینی را بر اساس پیشبینیهای قبلی خود استنتاج میکند. برای مثال، مدلهای زبانی خودرگرسیو، توکن بعدی را بر اساس توکنهای پیشبینیشده قبلی پیشبینی میکنند. همه مدلهای زبانی بزرگ مبتنی بر Transformer خودرگرسیو هستند.

در مقابل، مدلهای تصویر مبتنی بر GAN معمولاً خود-همبسته نیستند زیرا تصویر را در یک مسیر رو به جلو تولید میکنند و نه به صورت تکراری در مراحل مختلف. با این حال، برخی از مدلهای تولید تصویر خود-همبسته هستند زیرا تصویر را در مراحل مختلف تولید میکنند.

ضرر کمکی

یک تابع زیان - که همراه با تابع زیان اصلی مدل شبکه عصبی استفاده میشود - که به تسریع آموزش در تکرارهای اولیه، زمانی که وزنها به صورت تصادفی مقداردهی اولیه میشوند، کمک میکند.

توابع زیان کمکی، گرادیانهای مؤثر را به لایههای قبلی منتقل میکنند. این امر با مقابله با مشکل محو شدن گرادیان، همگرایی را در طول آموزش تسهیل میکند.

دقت متوسط در k

معیاری برای خلاصه کردن عملکرد یک مدل در یک درخواست واحد که نتایج رتبهبندیشده تولید میکند، مانند فهرست شمارهگذاریشدهای از توصیههای کتاب. میانگین دقت در k ، در واقع میانگین مقادیر دقت در k برای هر نتیجه مرتبط است. بنابراین فرمول میانگین دقت در k به صورت زیر است:

\[{\text{average precision at k}} = \frac{1}{n} \sum_{i=1}^n {\text{precision at k for each relevant item} } \]

کجا:

- \(n\) تعداد موارد مرتبط در لیست است.

با یادآوری در نقطه k مقایسه کنید.

وضعیت همترازی محور

در یک درخت تصمیم ، شرطی که فقط شامل یک ویژگی واحد است. برای مثال، اگر area یک ویژگی باشد، آنگاه شرط زیر یک شرط همتراز با محور است:

area > 200

با حالت مورب کنتراست ایجاد کنید.

ب

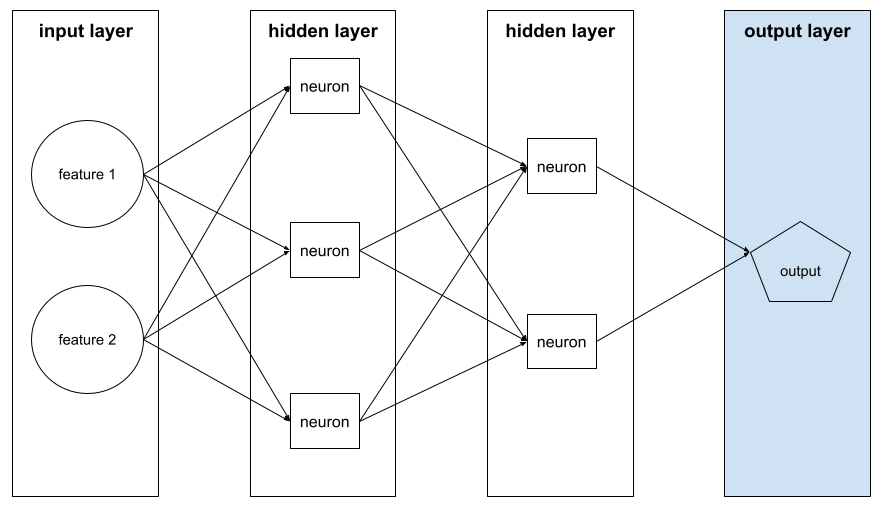

پسانتشار

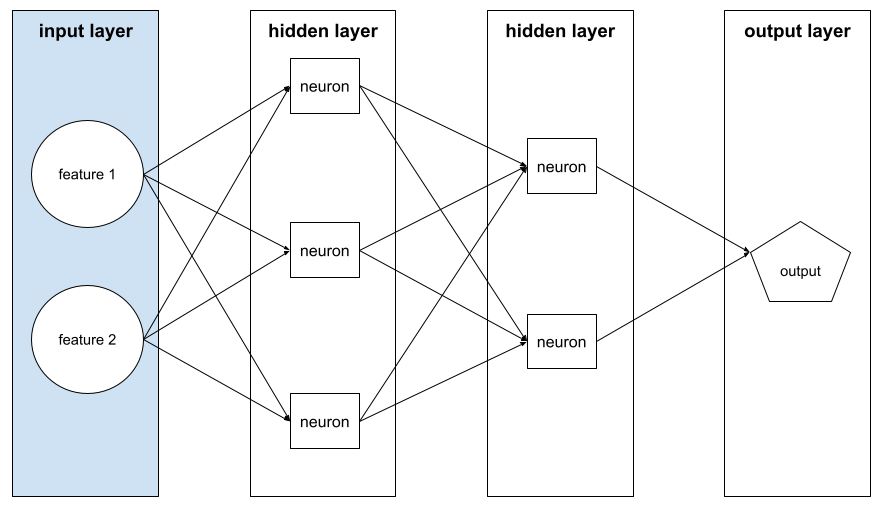

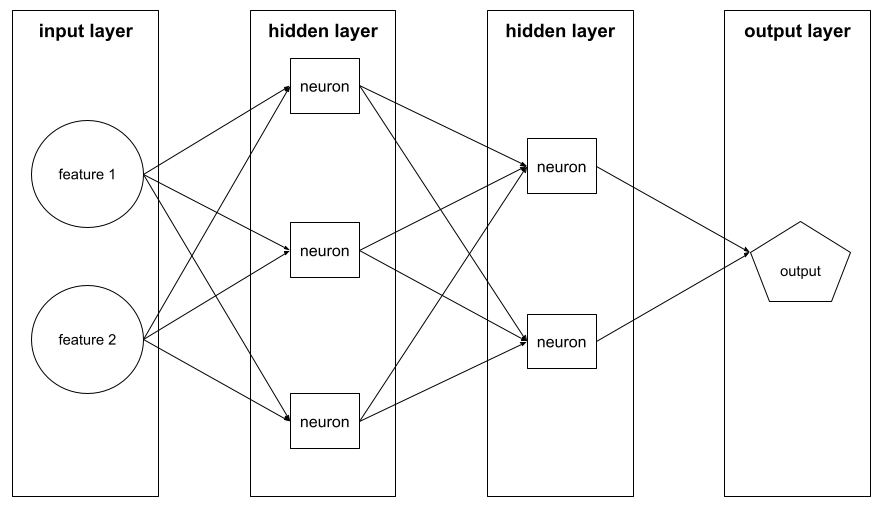

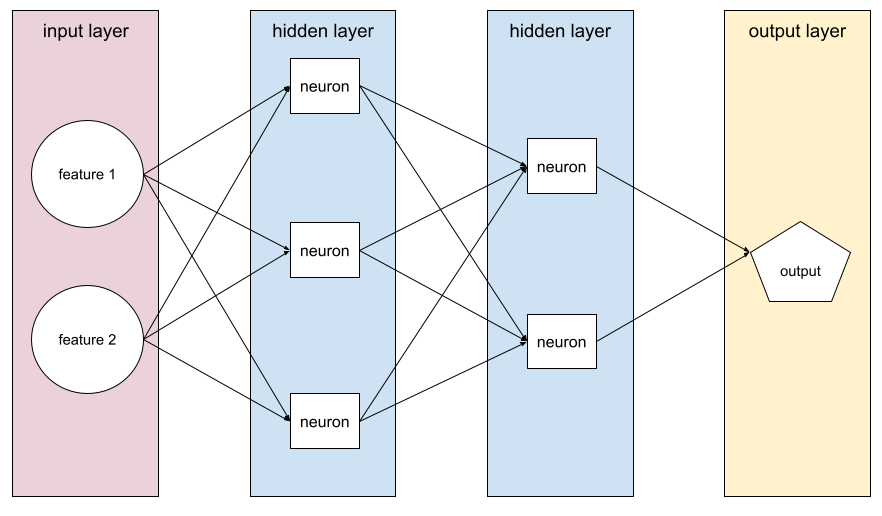

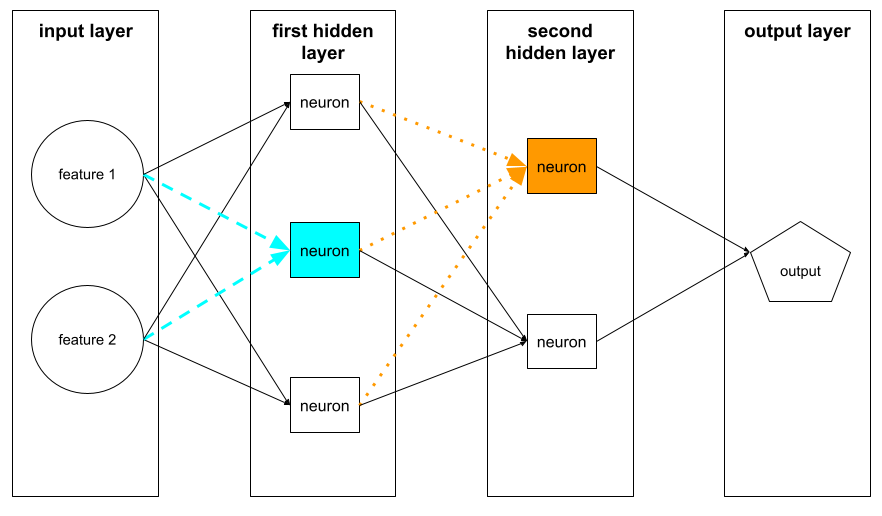

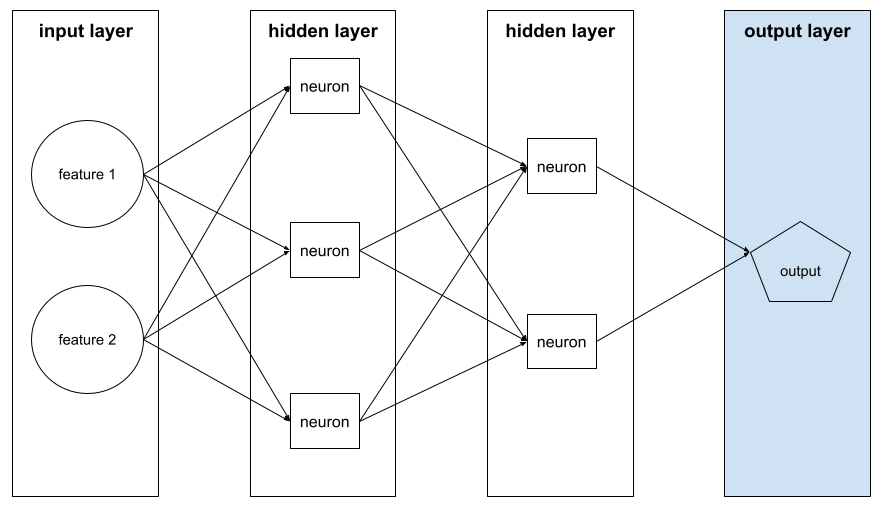

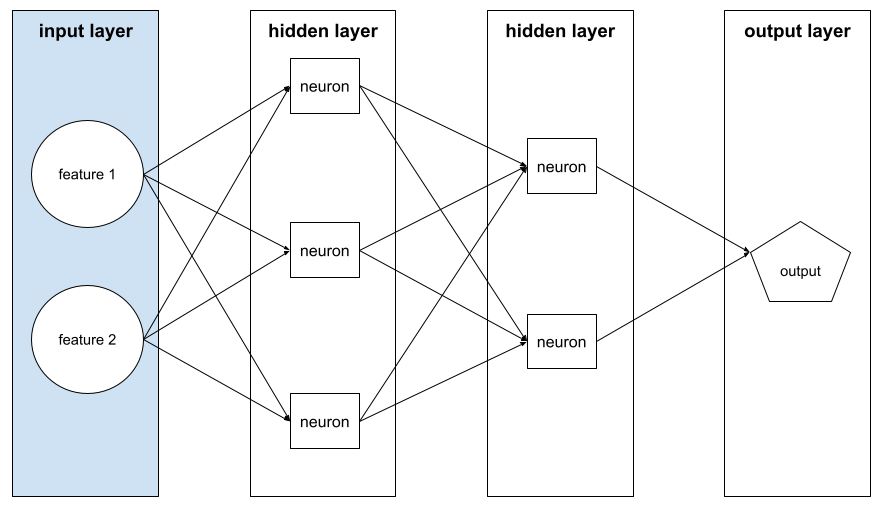

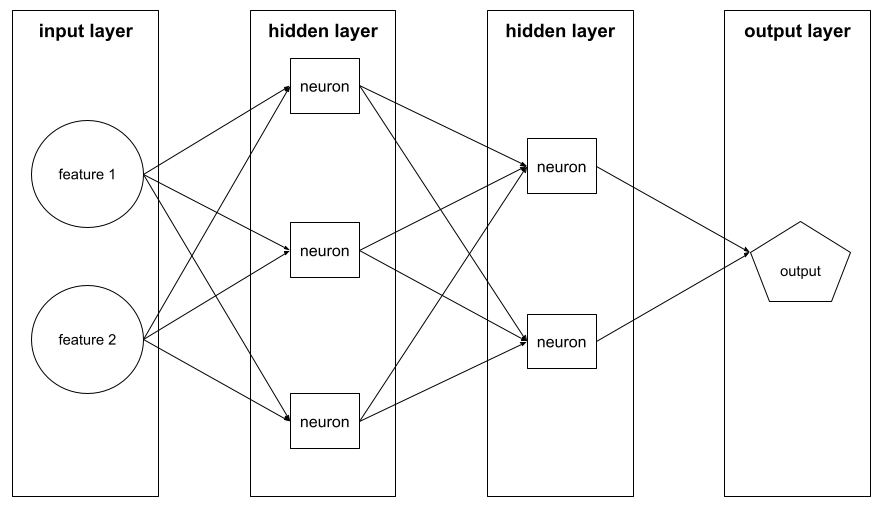

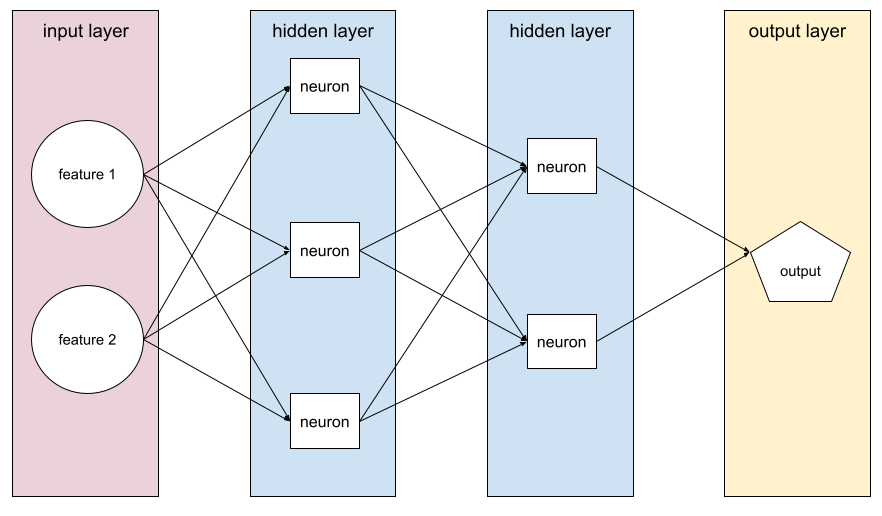

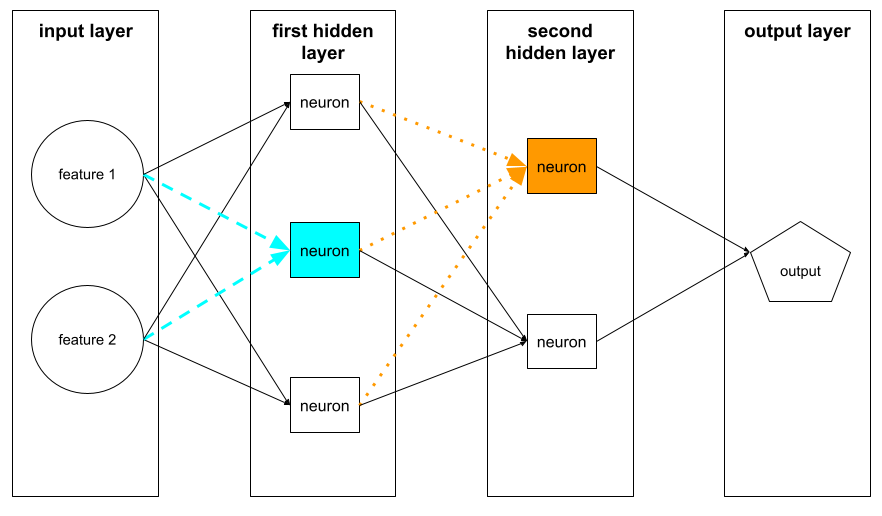

الگوریتمی که گرادیان نزولی را در شبکههای عصبی پیادهسازی میکند.

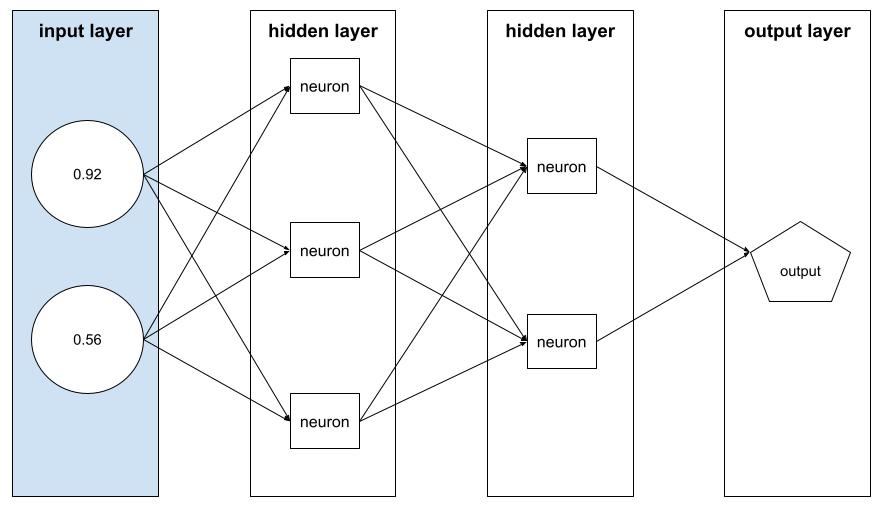

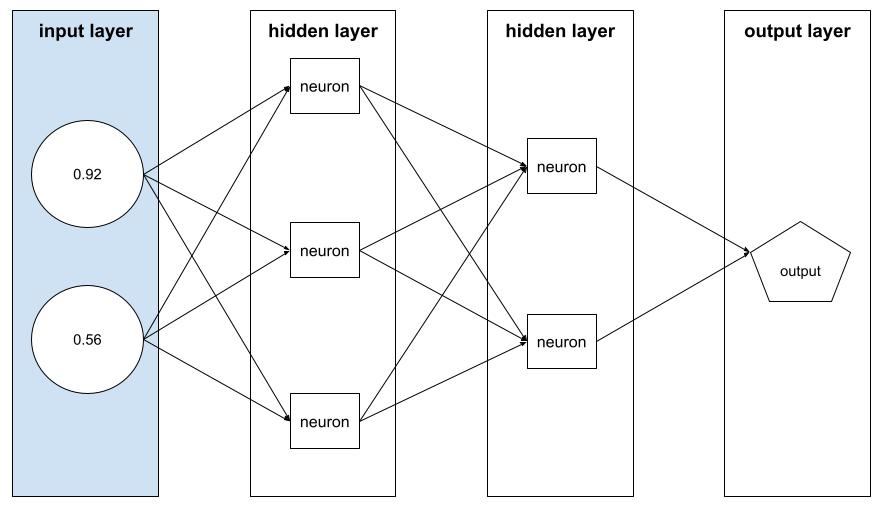

آموزش یک شبکه عصبی شامل تکرارهای زیادی از چرخه دو مرحلهای زیر است:

- در طول مرحلهی رو به جلو ، سیستم مجموعهای از مثالها را برای ارائه پیشبینی(ها) پردازش میکند. سیستم هر پیشبینی را با هر مقدار برچسب مقایسه میکند. تفاوت بین پیشبینی و مقدار برچسب، میزان زیان آن مثال است. سیستم زیانهای مربوط به تمام مثالها را جمع میکند تا کل زیان برای دسته فعلی را محاسبه کند.

- در طول فرآیند پسانتشار (backpropagation)، سیستم با تنظیم وزن تمام نورونها در تمام لایههای پنهان، تلفات را کاهش میدهد.

شبکههای عصبی اغلب شامل نورونهای زیادی در لایههای پنهان متعدد هستند. هر یک از این نورونها به روشهای مختلفی در کاهش کلی نقش دارند. پسانتشار تعیین میکند که آیا وزنهای اعمال شده به نورونهای خاص افزایش یا کاهش یابد.

نرخ یادگیری ضریبی است که میزان افزایش یا کاهش هر وزن را در هر بار عبور از الگوریتم به عقب کنترل میکند. نرخ یادگیری بزرگ، هر وزن را بیشتر از نرخ یادگیری کوچک افزایش یا کاهش میدهد.

به زبان حسابان، پسانتشار، قاعده زنجیرهای را از حسابان پیادهسازی میکند. یعنی، پسانتشار، مشتق جزئی خطا را نسبت به هر پارامتر محاسبه میکند.

سالها پیش، متخصصان یادگیری ماشین مجبور بودند برای پیادهسازی پسانتشار کد بنویسند. رابطهای برنامهنویسی کاربردی (API) مدرن یادگیری ماشین مانند Keras اکنون پسانتشار را برای شما پیادهسازی میکنند. وای!

برای اطلاعات بیشتر به بخش شبکههای عصبی در دوره فشرده یادگیری ماشین مراجعه کنید.

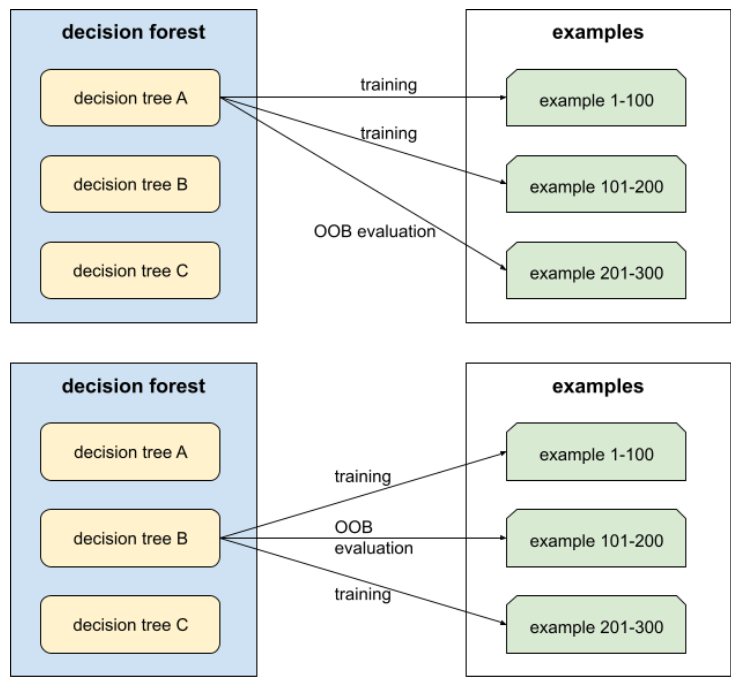

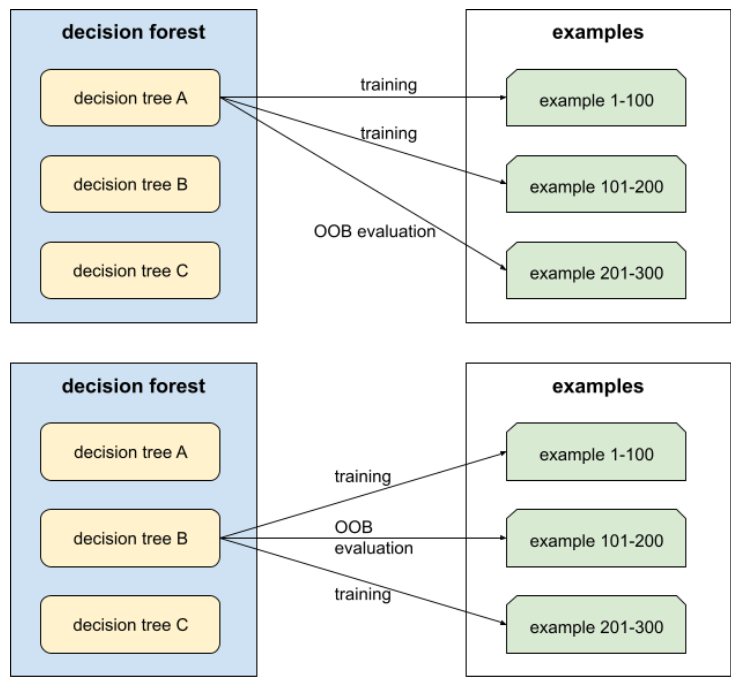

کیسه کشی

روشی برای آموزش یک مجموعه که در آن هر مدل تشکیلدهنده روی زیرمجموعهای تصادفی از نمونههای آموزشی که با جایگزینی نمونهبرداری شدهاند، آموزش میبیند. به عنوان مثال، یک جنگل تصادفی مجموعهای از درختهای تصمیم است که با روش دستهبندی آموزش دیدهاند.

اصطلاح bagging مخفف عبارت bootstrap agg regating است.

برای اطلاعات بیشتر به جنگلهای تصادفی در درس جنگلهای تصمیمگیری مراجعه کنید.

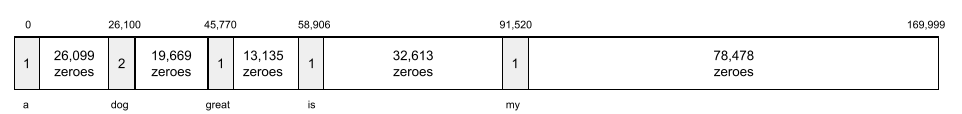

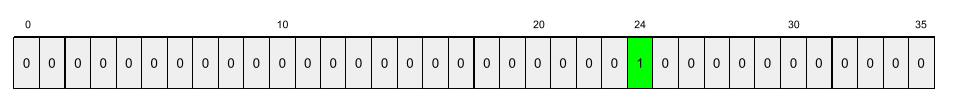

کیسه ای از کلمات

نمایش کلمات در یک عبارت یا متن، صرف نظر از ترتیب آنها. برای مثال، bag of words سه عبارت زیر را به طور یکسان نشان میدهد:

- سگ میپرد

- سگ میپرد

- سگ میپرد

هر کلمه به یک اندیس در یک بردار پراکنده نگاشت میشود، که در آن بردار برای هر کلمه در واژگان یک اندیس دارد. برای مثال، عبارت «سگ میپرد» به یک بردار ویژگی با مقادیر غیر صفر در سه اندیس مربوط به کلمات «the» ، «dog » و «jumps» نگاشت میشود. مقدار غیر صفر میتواند هر یک از موارد زیر باشد:

- عدد ۱ برای نشان دادن وجود یک کلمه.

- تعداد دفعاتی که یک کلمه در کیسه ظاهر میشود. برای مثال، اگر عبارت were the maroon dog is a dog with maroon fur باشد ، هم maroon و هم dog به صورت ۲ نمایش داده میشوند، در حالی که کلمات دیگر به صورت ۱ نمایش داده میشوند.

- مقداری دیگر، مانند لگاریتم تعداد دفعاتی که یک کلمه در کیسه ظاهر میشود.

خط پایه

مدلی که به عنوان نقطه مرجع برای مقایسه عملکرد یک مدل دیگر (معمولاً یک مدل پیچیدهتر) استفاده میشود. برای مثال، یک مدل رگرسیون لجستیک میتواند به عنوان یک مبنای خوب برای یک مدل عمیق عمل کند.

برای یک مسئله خاص، خط مبنا به توسعهدهندگان مدل کمک میکند تا حداقل عملکرد مورد انتظاری را که یک مدل جدید باید برای مفید بودن به آن دست یابد، تعیین کنند.

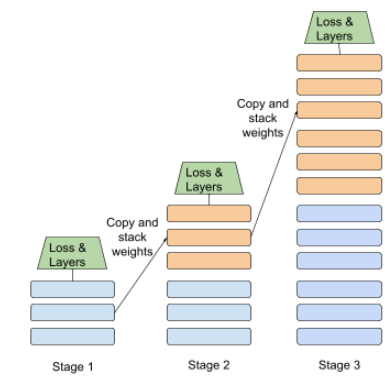

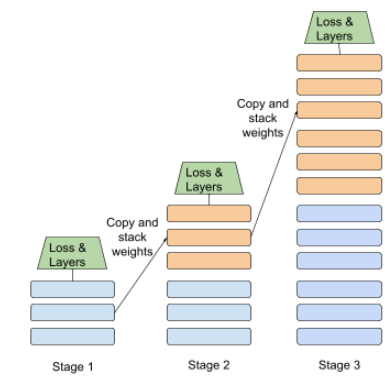

مدل پایه

یک مدل از پیش آموزشدیده که میتواند به عنوان نقطه شروع برای تنظیم دقیق جهت رسیدگی به وظایف یا برنامههای خاص عمل کند.

همچنین به مدل از پیش آموزشدیده و مدل پایه مراجعه کنید.

دستهای

مجموعه مثالهای استفاده شده در یک تکرار آموزشی. اندازه دسته، تعداد مثالها در یک دسته را تعیین میکند.

برای توضیح چگونگی ارتباط یک دسته با یک دوره، به epoch مراجعه کنید.

برای اطلاعات بیشتر به رگرسیون خطی: هایپرپارامترها در دوره فشرده یادگیری ماشین مراجعه کنید.

استنتاج دستهای

فرآیند استنباط پیشبینیها روی چندین مثال بدون برچسب که به زیرمجموعههای کوچکتر ("دستهها") تقسیم شدهاند.

استنتاج دستهای میتواند از ویژگیهای موازیسازی تراشههای شتابدهنده بهره ببرد. یعنی، چندین شتابدهنده میتوانند بهطور همزمان پیشبینیهایی را روی دستههای مختلف از نمونههای بدون برچسب استنتاج کنند و تعداد استنتاجها در ثانیه را بهطور چشمگیری افزایش دهند.

برای اطلاعات بیشتر به بخش «سیستمهای یادگیری ماشین تولیدی: استنتاج ایستا در مقابل استنتاج پویا» در دوره فشرده یادگیری ماشین مراجعه کنید.

نرمالسازی دستهای

نرمالسازی ورودی یا خروجی توابع فعالسازی در یک لایه پنهان . نرمالسازی دستهای میتواند مزایای زیر را ارائه دهد:

- با محافظت در برابر وزنهای پرت ، شبکههای عصبی را پایدارتر کنید.

- نرخ یادگیری بالاتر را فعال کنید، که میتواند آموزش را سرعت بخشد.

- بیشبرازش را کاهش دهید.

اندازه دسته

تعداد مثالها در یک دسته . برای مثال، اگر اندازه دسته ۱۰۰ باشد، مدل در هر تکرار ۱۰۰ مثال را پردازش میکند.

موارد زیر استراتژیهای رایج برای اندازه دستهای هستند:

- نزول گرادیان تصادفی (SGD) ، که در آن اندازه دسته ۱ است.

- دسته کامل، که در آن اندازه دسته برابر با تعداد مثالها در کل مجموعه آموزشی است. برای مثال، اگر مجموعه آموزشی شامل یک میلیون مثال باشد، اندازه دسته نیز یک میلیون مثال خواهد بود. دسته کامل معمولاً یک استراتژی ناکارآمد است.

- مینی-بچ که در آن اندازه هر دسته معمولاً بین ۱۰ تا ۱۰۰۰ است. مینی-بچ معمولاً کارآمدترین استراتژی است.

برای اطلاعات بیشتر به موارد زیر مراجعه کنید:

- سیستمهای یادگیری ماشینی تولیدی: استنتاج ایستا در مقابل استنتاج پویا در دوره فشرده یادگیری ماشین.

- کتابچه راهنمای تنظیم یادگیری عمیق .

شبکه عصبی بیزی

یک شبکه عصبی احتمالی که عدم قطعیت در وزنها و خروجیها را در نظر میگیرد. یک مدل رگرسیون شبکه عصبی استاندارد معمولاً یک مقدار اسکالر را پیشبینی میکند ؛ برای مثال، یک مدل استاندارد قیمت خانه ۸۵۳۰۰۰ را پیشبینی میکند. در مقابل، یک شبکه عصبی بیزی توزیع مقادیر را پیشبینی میکند؛ برای مثال، یک مدل بیزی قیمت خانه ۸۵۳۰۰۰ را با انحراف معیار ۶۷۲۰۰ پیشبینی میکند.

یک شبکه عصبی بیزی برای محاسبه عدم قطعیت در وزنها و پیشبینیها به قضیه بیز متکی است. یک شبکه عصبی بیزی میتواند در مواردی که تعیین کمیت عدم قطعیت مهم است، مانند مدلهای مربوط به داروسازی، مفید باشد. شبکههای عصبی بیزی همچنین میتوانند به جلوگیری از بیشبرازش کمک کنند.

بهینهسازی بیزی

یک تکنیک مدل رگرسیون احتمالی برای بهینهسازی توابع هدف از نظر محاسباتی پرهزینه، به جای بهینهسازی یک جایگزین که عدم قطعیت را با استفاده از یک تکنیک یادگیری بیزی کمّی میکند. از آنجایی که بهینهسازی بیزی خود بسیار پرهزینه است، معمولاً برای بهینهسازی وظایف پرهزینه برای ارزیابی که تعداد کمی پارامتر دارند، مانند انتخاب ابرپارامترها، استفاده میشود.

معادله بلمن

در یادگیری تقویتی، هویت زیر توسط تابع Q بهینه برآورده میشود:

\[Q(s, a) = r(s, a) + \gamma \mathbb{E}_{s'|s,a} \max_{a'} Q(s', a')\]

الگوریتمهای یادگیری تقویتی با استفاده از قانون بهروزرسانی زیر، این هویت را برای ایجاد یادگیری Q اعمال میکنند:

\[Q(s,a) \gets Q(s,a) + \alpha \left[r(s,a) + \gamma \displaystyle\max_{\substack{a_1}} Q(s',a') - Q(s,a) \right] \]

فراتر از یادگیری تقویتی، معادله بلمن کاربردهایی در برنامهنویسی پویا دارد. برای معادله بلمن به مدخل ویکیپدیا مراجعه کنید.

BERT (نمایشهای رمزگذار دو طرفه از ترانسفورماتورها)

یک معماری مدل برای نمایش متن. یک مدل BERT آموزشدیده میتواند به عنوان بخشی از یک مدل بزرگتر برای طبقهبندی متن یا سایر وظایف یادگیری ماشین عمل کند.

برت (BERT) ویژگیهای زیر را دارد:

- از معماری ترانسفورماتور استفاده میکند و بنابراین به خود-توجهی متکی است.

- از بخش رمزگذار ترانسفورماتور استفاده میکند. وظیفه رمزگذار تولید نمایشهای متنی خوب است، نه انجام یک کار خاص مانند طبقهبندی.

- دو طرفه است.

- از ماسک کردن برای آموزش بدون نظارت استفاده میکند.

انواع BERT عبارتند از:

- آلبرت ، که مخفف A Light BERT است.

- لابز (LABSE )

برای مرور کلی برت، به «برتِ متنباز: پیشآموزش پیشرفته برای پردازش زبان طبیعی» مراجعه کنید.

جانبداری (اخلاق/انصاف)

۱. کلیشهسازی، تعصب یا جانبداری نسبت به برخی چیزها، افراد یا گروهها نسبت به برخی دیگر. این سوگیریها میتوانند بر جمعآوری و تفسیر دادهها، طراحی سیستم و نحوه تعامل کاربران با سیستم تأثیر بگذارند. انواع این نوع سوگیری عبارتند از:

- سوگیری اتوماسیون

- سوگیری تأییدی

- سوگیری آزمایشگر

- سوگیری انتساب گروهی

- سوگیری ضمنی

- سوگیری درون گروهی

- سوگیری همگنی برونگروهی

۲. خطای سیستماتیک ناشی از یک روش نمونهگیری یا گزارشدهی. انواع این نوع سوگیری عبارتند از:

نباید با اصطلاح سوگیری در مدلهای یادگیری ماشین یا سوگیری پیشبینی اشتباه گرفته شود.

برای اطلاعات بیشتر به انصاف: انواع سوگیری در دوره فشرده یادگیری ماشین مراجعه کنید.

بایاس (ریاضی) یا اصطلاح بایاس

An intercept or offset from an origin. Bias is a parameter in machine learning models, which is symbolized by either of the following:

- ب

- w 0

For example, bias is the b in the following formula:

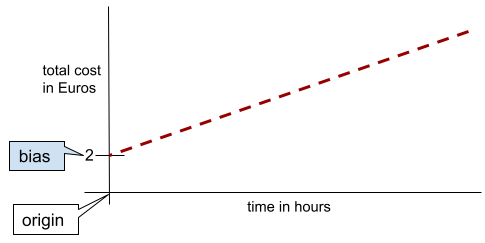

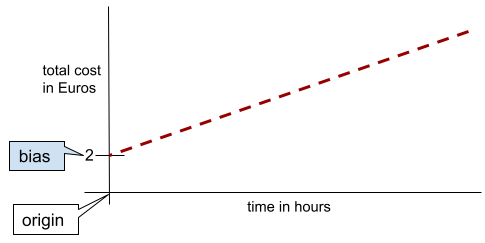

In a simple two-dimensional line, bias just means "y-intercept." For example, the bias of the line in the following illustration is 2.

Bias exists because not all models start from the origin (0,0). For example, suppose an amusement park costs 2 Euros to enter and an additional 0.5 Euro for every hour a customer stays. Therefore, a model mapping the total cost has a bias of 2 because the lowest cost is 2 Euros.

Bias is not to be confused with bias in ethics and fairness or prediction bias .

See Linear Regression in Machine Learning Crash Course for more information.

دو جهته

A term used to describe a system that evaluates the text that both precedes and follows a target section of text. In contrast, a unidirectional system only evaluates the text that precedes a target section of text.

For example, consider a masked language model that must determine probabilities for the word or words representing the underline in the following question:

What is the _____ with you?

A unidirectional language model would have to base its probabilities only on the context provided by the words "What", "is", and "the". In contrast, a bidirectional language model could also gain context from "with" and "you", which might help the model generate better predictions.

bidirectional language model

A language model that determines the probability that a given token is present at a given location in an excerpt of text based on the preceding and following text.

bigram

An N-gram in which N=2.

binary classification

A type of classification task that predicts one of two mutually exclusive classes:

- the positive class

- the negative class

For example, the following two machine learning models each perform binary classification:

- A model that determines whether email messages are spam (the positive class) or not spam (the negative class).

- A model that evaluates medical symptoms to determine whether a person has a particular disease (the positive class) or doesn't have that disease (the negative class).

Contrast with multi-class classification .

See also logistic regression and classification threshold .

See Classification in Machine Learning Crash Course for more information.

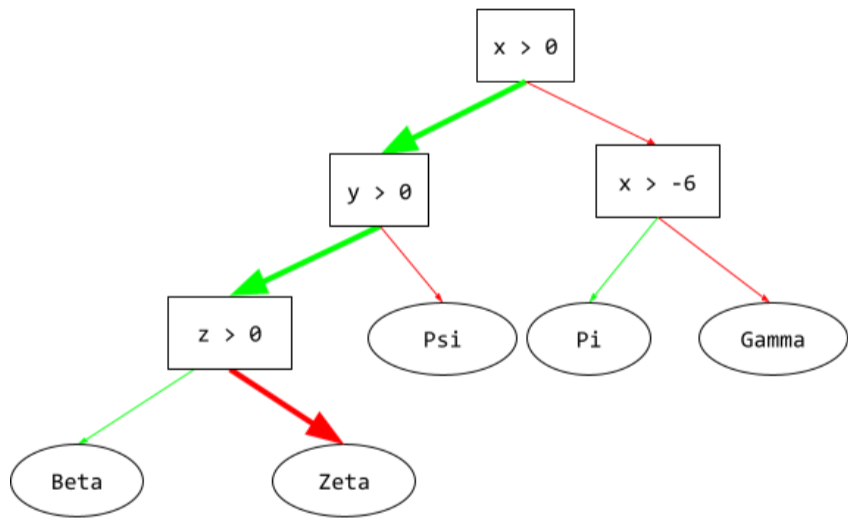

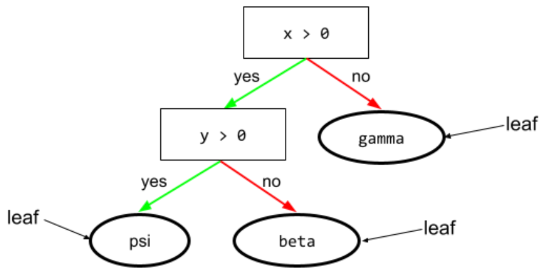

binary condition

In a decision tree , a condition that has only two possible outcomes, typically yes or no . For example, the following is a binary condition:

temperature >= 100

Contrast with non-binary condition .

See Types of conditions in the Decision Forests course for more information.

حذف کردن

Synonym for bucketing .

black box model

A model whose "reasoning" is impossible or difficult for humans to understand. That is, although humans can see how prompts affect responses , humans can't determine exactly how a black box model determines the response. In other words, a black box model is lacking interpretability .

Most deep models and large language models are black boxes.

BLEU (Bilingual Evaluation Understudy)

A metric between 0.0 and 1.0 for evaluating machine translations , for example, from Spanish to Japanese.

To calculate a score, BLEU typically compares an ML model's translation ( generated text ) to a human expert's translation ( reference text ). The degree to which N-grams in the generated text and reference text match determines the BLEU score.

The original paper on this metric is BLEU: a Method for Automatic Evaluation of Machine Translation .

See also BLEURT .

BLEURT (Bilingual Evaluation Understudy from Transformers)

A metric for evaluating machine translations from one language to another, particularly to and from English.

For translations to and from English, BLEURT aligns more closely to human ratings than BLEU . Unlike BLEU, BLEURT emphasizes semantic (meaning) similarities and can accommodate paraphrasing.

BLEURT relies on a pre-trained large language model ( BERT to be exact) that is then fine-tuned on text from human translators.

The original paper on this metric is BLEURT: Learning Robust Metrics for Text Generation .

تقویت

A machine learning technique that iteratively combines a set of simple and not very accurate classification models (referred to as "weak classifiers") into a classification model with high accuracy (a "strong classifier") by upweighting the examples that the model is currently misclassifying.

See Gradient Boosted Decision Trees? in the Decision Forests course for more information.

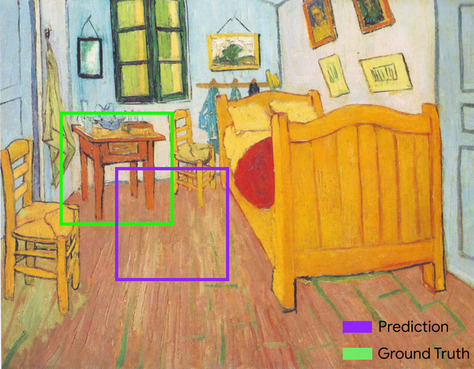

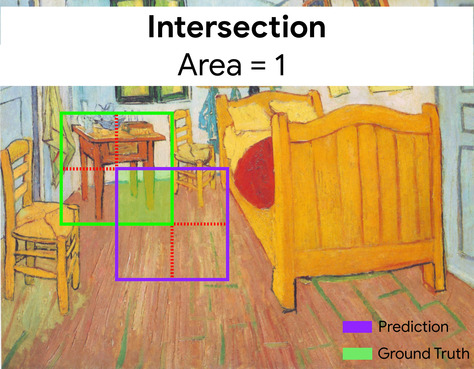

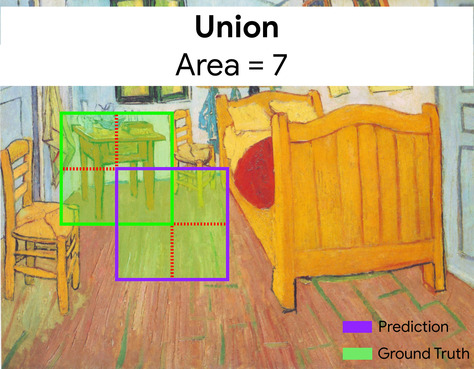

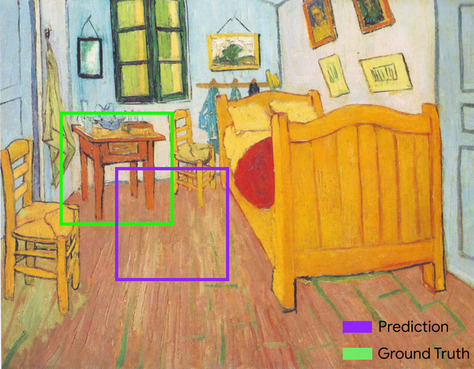

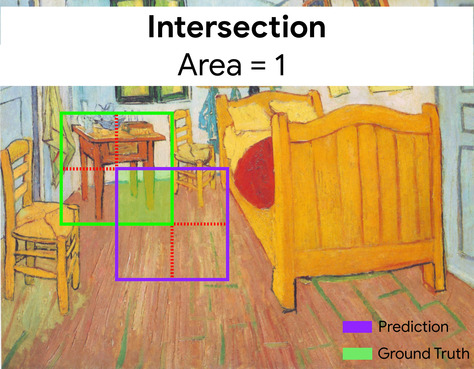

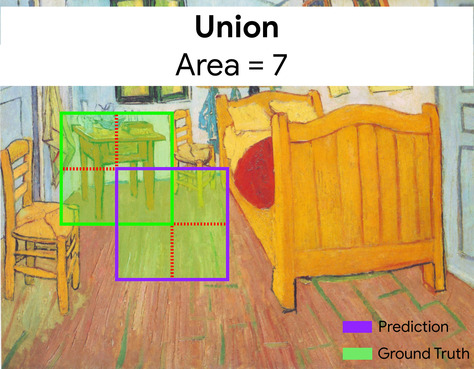

جعبه محدوده

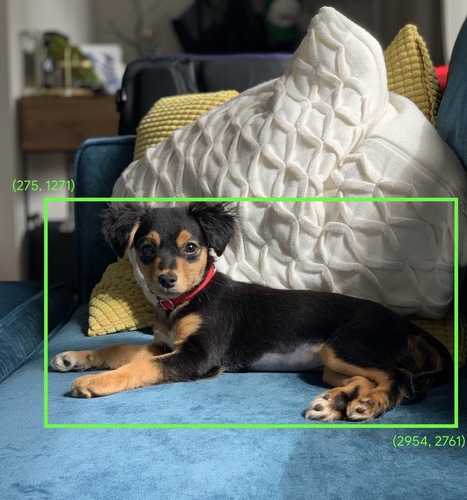

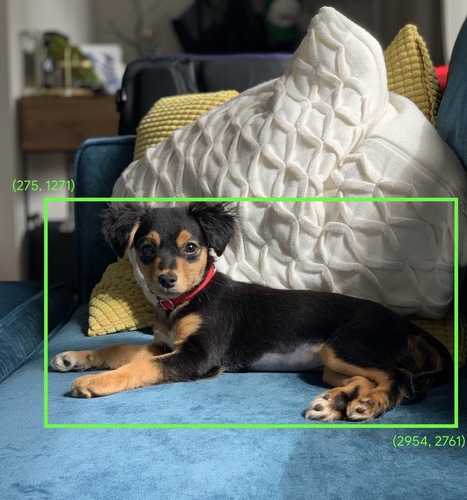

In an image, the ( x , y ) coordinates of a rectangle around an area of interest, such as the dog in the image below.

پخش

Expanding the shape of an operand in a matrix math operation to dimensions compatible for that operation. For example, linear algebra requires that the two operands in a matrix addition operation must have the same dimensions. Consequently, you can't add a matrix of shape (m, n) to a vector of length n. Broadcasting enables this operation by virtually expanding the vector of length n to a matrix of shape (m, n) by replicating the same values down each column.

See the following description of broadcasting in NumPy for more details.

سطل زدن

Converting a single feature into multiple binary features called buckets or bins , typically based on a value range. The chopped feature is typically a continuous feature .

For example, instead of representing temperature as a single continuous floating-point feature, you could chop ranges of temperatures into discrete buckets, such as:

- <= 10 degrees Celsius would be the "cold" bucket.

- 11 - 24 degrees Celsius would be the "temperate" bucket.

- >= 25 degrees Celsius would be the "warm" bucket.

The model will treat every value in the same bucket identically. For example, the values 13 and 22 are both in the temperate bucket, so the model treats the two values identically.

See Numerical data: Binning in Machine Learning Crash Course for more information.

سی

calibration layer

A post-prediction adjustment, typically to account for prediction bias . The adjusted predictions and probabilities should match the distribution of an observed set of labels.

candidate generation

The initial set of recommendations chosen by a recommendation system . For example, consider a bookstore that offers 100,000 titles. The candidate generation phase creates a much smaller list of suitable books for a particular user, say 500. But even 500 books is way too many to recommend to a user. Subsequent, more expensive, phases of a recommendation system (such as scoring and re-ranking ) reduce those 500 to a much smaller, more useful set of recommendations.

See Candidate generation overview in the Recommendation Systems course for more information.

candidate sampling

A training-time optimization that calculates a probability for all the positive labels, using, for example, softmax , but only for a random sample of negative labels. For instance, given an example labeled beagle and dog , candidate sampling computes the predicted probabilities and corresponding loss terms for:

- beagle

- سگ

- a random subset of the remaining negative classes (for example, cat , lollipop , fence ).

The idea is that the negative classes can learn from less frequent negative reinforcement as long as positive classes always get proper positive reinforcement, and this is indeed observed empirically.

Candidate sampling is more computationally efficient than training algorithms that compute predictions for all negative classes, particularly when the number of negative classes is very large.

دادههای دستهبندیشده

Features having a specific set of possible values. For example, consider a categorical feature named traffic-light-state , which can only have one of the following three possible values:

-

red -

yellow -

green

By representing traffic-light-state as a categorical feature, a model can learn the differing impacts of red , green , and yellow on driver behavior.

Categorical features are sometimes called discrete features .

Contrast with numerical data .

See Working with categorical data in Machine Learning Crash Course for more information.

causal language model

Synonym for unidirectional language model .

See bidirectional language model to contrast different directional approaches in language modeling.

مرکز ثقل

The center of a cluster as determined by a k-means or k-median algorithm. For example, if k is 3, then the k-means or k-median algorithm finds 3 centroids.

See Clustering algorithms in the Clustering course for more information.

centroid-based clustering

A category of clustering algorithms that organizes data into nonhierarchical clusters. k-means is the most widely used centroid-based clustering algorithm.

Contrast with hierarchical clustering algorithms.

See Clustering algorithms in the Clustering course for more information.

chain-of-thought prompting

A prompt engineering technique that encourages a large language model (LLM) to explain its reasoning, step by step. For example, consider the following prompt, paying particular attention to the second sentence:

How many g forces would a driver experience in a car that goes from 0 to 60 miles per hour in 7 seconds? In the answer, show all relevant calculations.

The LLM's response would likely:

- Show a sequence of physics formulas, plugging in the values 0, 60, and 7 in appropriate places.

- Explain why it chose those formulas and what the various variables mean.

Chain-of-thought prompting forces the LLM to perform all the calculations, which might lead to a more correct answer. In addition, chain-of-thought prompting enables the user to examine the LLM's steps to determine whether or not the answer makes sense.

Character N-gram F-score (ChrF)

A metric to evaluate machine translation models. Character N-gram F-score determines the degree to which N-grams in reference text overlap the N-grams in an ML model's generated text .

Character N-gram F-score is similar to metrics in the ROUGE and BLEU families, except that:

- Character N-gram F-score operates on character N-grams.

- ROUGE and BLEU operate on word N-grams or tokens .

چت

The contents of a back-and-forth dialogue with an ML system, typically a large language model . The previous interaction in a chat (what you typed and how the large language model responded) becomes the context for subsequent parts of the chat.

A chatbot is an application of a large language model.

ایست بازرسی

Data that captures the state of a model's parameters either during training or after training is completed. For example, during training, you can:

- Stop training, perhaps intentionally or perhaps as the result of certain errors.

- Capture the checkpoint.

- Later, reload the checkpoint, possibly on different hardware.

- Restart training.

کلاس

A category that a label can belong to. For example:

- In a binary classification model that detects spam, the two classes might be spam and not spam .

- In a multi-class classification model that identifies dog breeds, the classes might be poodle , beagle , pug , and so on.

A classification model predicts a class. In contrast, a regression model predicts a number rather than a class.

See Classification in Machine Learning Crash Course for more information.

class-balanced dataset

A dataset containing categorical labels in which the number of instances of each category is approximately equal. For example, consider a botanical dataset whose binary label can be either native plant or nonnative plant :

- A dataset with 515 native plants and 485 nonnative plants is a class-balanced dataset.

- A dataset with 875 native plants and 125 nonnative plants is a class-imbalanced dataset .

A formal dividing line between class-balanced datasets and class-imbalanced datasets doesn't exist. The distinction only becomes important when a model trained on a highly class-imbalanced dataset can't converge. See Datasets: imbalanced datasets in Machine Learning Crash Course for details.

classification model

A model whose prediction is a class . For example, the following are all classification models:

- A model that predicts an input sentence's language (French? Spanish? Italian?).

- A model that predicts tree species (Maple? Oak? Baobab?).

- A model that predicts the positive or negative class for a particular medical condition.

In contrast, regression models predict numbers rather than classes.

Two common types of classification models are:

classification threshold

In a binary classification , a number between 0 and 1 that converts the raw output of a logistic regression model into a prediction of either the positive class or the negative class . Note that the classification threshold is a value that a human chooses, not a value chosen by model training.

A logistic regression model outputs a raw value between 0 and 1. Then:

- If this raw value is greater than the classification threshold, then the positive class is predicted.

- If this raw value is less than the classification threshold, then the negative class is predicted.

For example, suppose the classification threshold is 0.8. If the raw value is 0.9, then the model predicts the positive class. If the raw value is 0.7, then the model predicts the negative class.

The choice of classification threshold strongly influences the number of false positives and false negatives .

See Thresholds and the confusion matrix in Machine Learning Crash Course for more information.

طبقه بندی کننده

A casual term for a classification model .

class-imbalanced dataset

A dataset for a classification in which the total number of labels of each class differs significantly. For example, consider a binary classification dataset whose two labels are divided as follows:

- 1,000,000 negative labels

- 10 positive labels

The ratio of negative to positive labels is 100,000 to 1, so this is a class-imbalanced dataset.

In contrast, the following dataset is class-balanced because the ratio of negative labels to positive labels is relatively close to 1:

- 517 negative labels

- 483 positive labels

Multi-class datasets can also be class-imbalanced. For example, the following multi-class classification dataset is also class-imbalanced because one label has far more examples than the other two:

- 1,000,000 labels with class "green"

- 200 labels with class "purple"

- 350 labels with class "orange"

Training class-imbalanced datasets can present special challenges. See Imbalanced datasets in Machine Learning Crash Course for details.

See also entropy , majority class , and minority class .

برش

A technique for handling outliers by doing either or both of the following:

- Reducing feature values that are greater than a maximum threshold down to that maximum threshold.

- Increasing feature values that are less than a minimum threshold up to that minimum threshold.

For example, suppose that <0.5% of values for a particular feature fall outside the range 40–60. In this case, you could do the following:

- Clip all values over 60 (the maximum threshold) to be exactly 60.

- Clip all values under 40 (the minimum threshold) to be exactly 40.

Outliers can damage models, sometimes causing weights to overflow during training. Some outliers can also dramatically spoil metrics like accuracy . Clipping is a common technique to limit the damage.

Gradient clipping forces gradient values within a designated range during training.

See Numerical data: Normalization in Machine Learning Crash Course for more information.

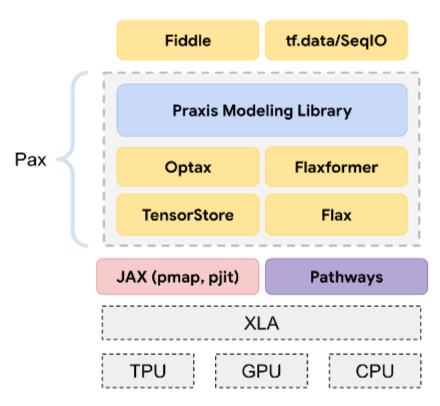

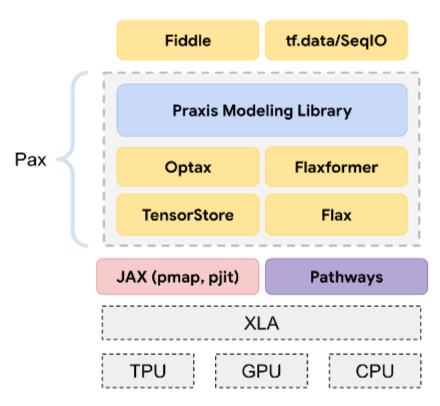

TPU ابری

A specialized hardware accelerator designed to speed up machine learning workloads on Google Cloud.

خوشهبندی

Grouping related examples , particularly during unsupervised learning . Once all the examples are grouped, a human can optionally supply meaning to each cluster.

Many clustering algorithms exist. For example, the k-means algorithm clusters examples based on their proximity to a centroid , as in the following diagram:

A human researcher could then review the clusters and, for example, label cluster 1 as "dwarf trees" and cluster 2 as "full-size trees."

As another example, consider a clustering algorithm based on an example's distance from a center point, illustrated as follows:

See the Clustering course for more information.

co-adaptation

An undesirable behavior in which neurons predict patterns in training data by relying almost exclusively on outputs of specific other neurons instead of relying on the network's behavior as a whole. When the patterns that cause co-adaptation are not present in validation data, then co-adaptation causes overfitting . Dropout regularization reduces co-adaptation because dropout ensures neurons cannot rely solely on specific other neurons.

فیلترینگ مشارکتی

Making predictions about the interests of one user based on the interests of many other users. Collaborative filtering is often used in recommendation systems .

See Collaborative filtering in the Recommendation Systems course for more information.

مدل جمع و جور

Any small model designed to run on small devices with limited computational resources. For example, compact models can run on mobile phones, tablets, or embedded systems.

محاسبه

(Noun) The computational resources used by a model or system, such as processing power, memory, and storage.

See accelerator chips .

concept drift

A shift in the relationship between features and the label. Over time, concept drift reduces a model's quality.

During training, the model learns the relationship between the features and their labels in the training set. If the labels in the training set are good proxies for the real-world, then the model should make good real world predictions. However, due to concept drift, the model's predictions tend to degrade over time.

For example, consider a binary classification model that predicts whether or not a certain car model is "fuel efficient." That is, the features could be:

- car weight

- engine compression

- transmission type

while the label is either:

- سوخت کارآمد

- not fuel efficient

However, the concept of "fuel efficient car" keeps changing. A car model labeled fuel efficient in 1994 would almost certainly be labeled not fuel efficient in 2024. A model suffering from concept drift tends to make less and less useful predictions over time.

Compare and contrast with nonstationarity .

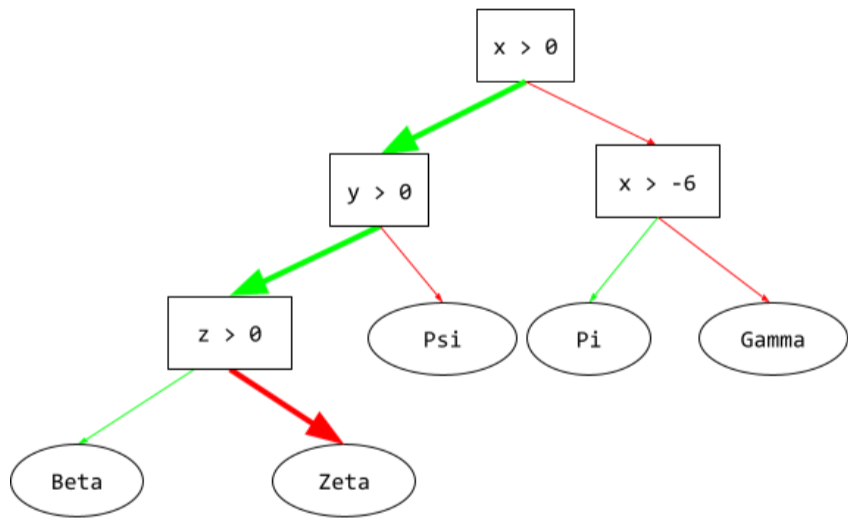

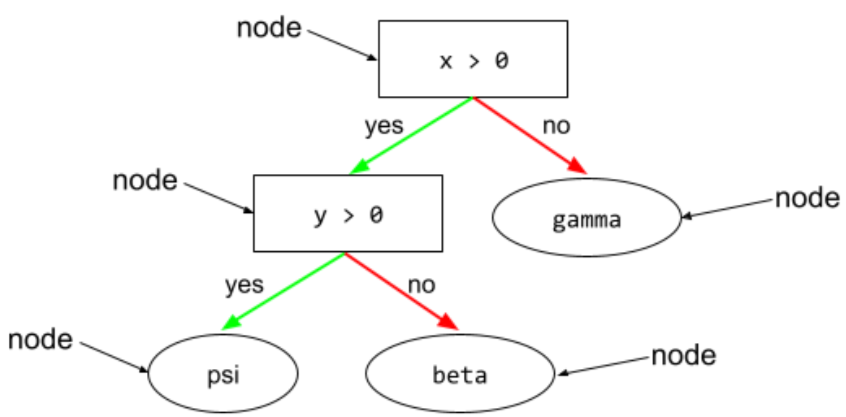

وضعیت

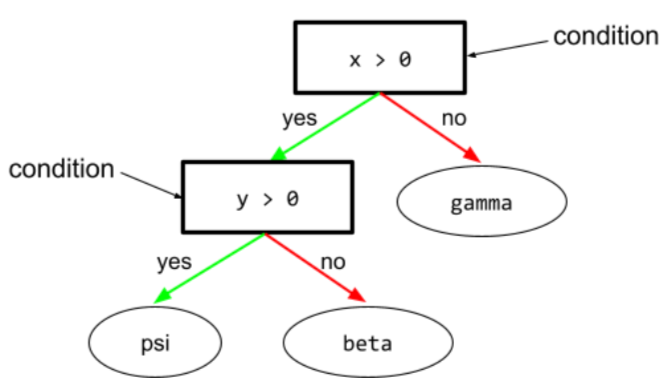

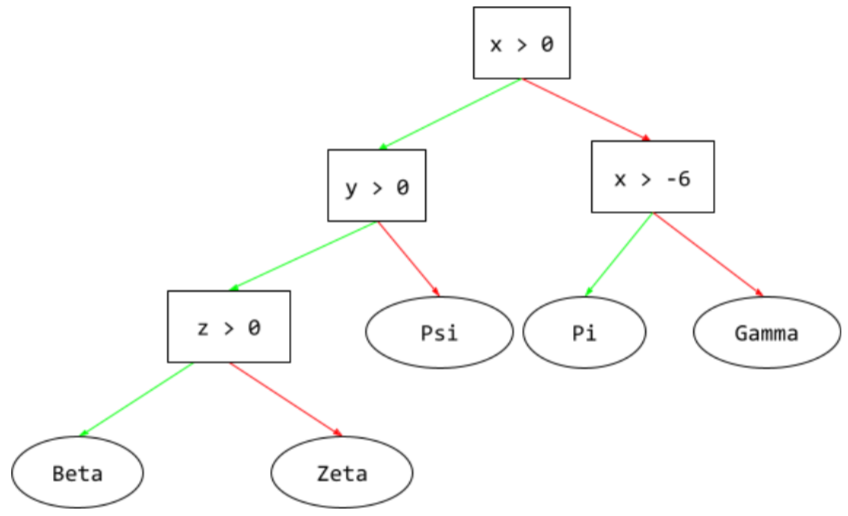

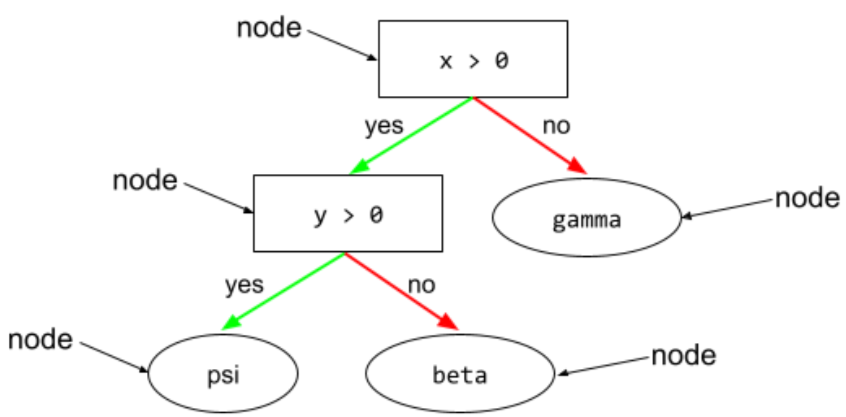

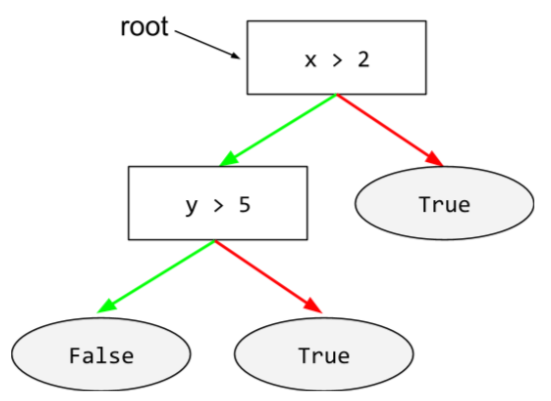

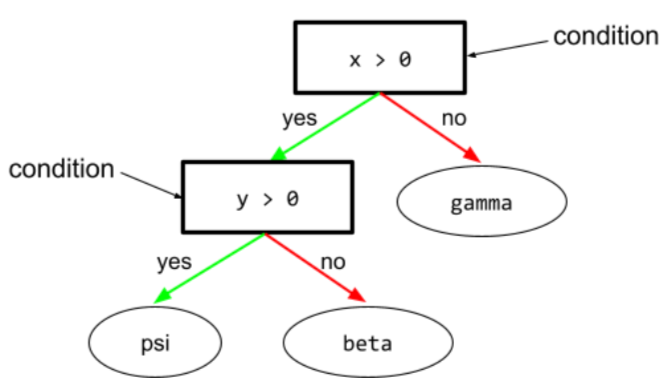

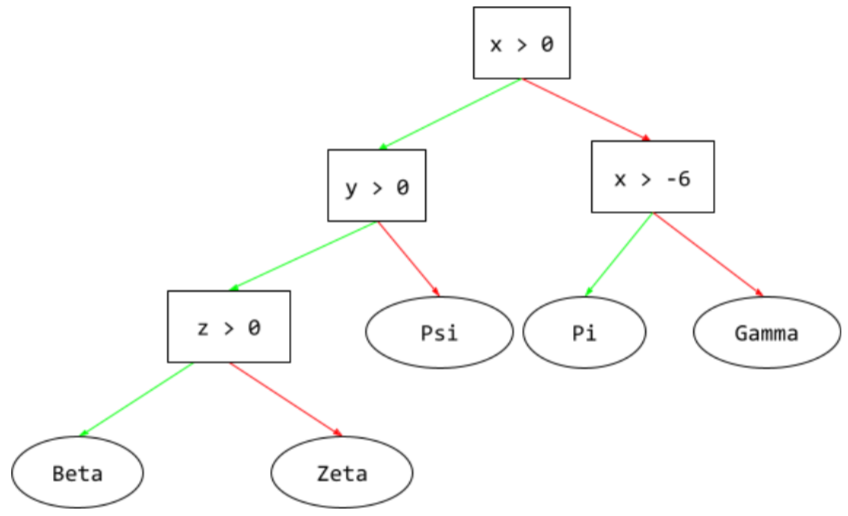

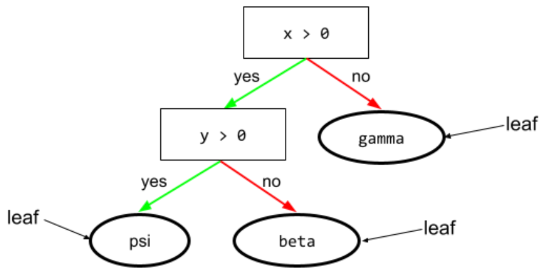

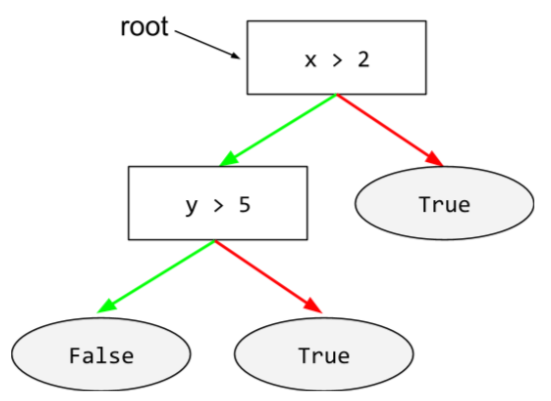

In a decision tree , any node that performs a test. For example, the following decision tree contains two conditions:

A condition is also called a split or a test.

Contrast condition with leaf .

همچنین ببینید:

See Types of conditions in the Decision Forests course for more information.

افسانه سازی

Synonym for hallucination .

Confabulation is probably a more technically accurate term than hallucination. However, hallucination became popular first.

پیکربندی

The process of assigning the initial property values used to train a model, including:

- the model's composing layers

- the location of the data

- hyperparameters such as:

In machine learning projects, configuration can be done through a special configuration file or using configuration libraries such as the following:

سوگیری تأییدی

The tendency to search for, interpret, favor, and recall information in a way that confirms one's pre-existing beliefs or hypotheses. Machine learning developers may inadvertently collect or label data in ways that influence an outcome supporting their existing beliefs. Confirmation bias is a form of implicit bias .

Experimenter's bias is a form of confirmation bias in which an experimenter continues training models until a pre-existing hypothesis is confirmed.

ماتریس سردرگمی

An NxN table that summarizes the number of correct and incorrect predictions that a classification model made. For example, consider the following confusion matrix for a binary classification model:

| Tumor (predicted) | Non-Tumor (predicted) | |

|---|---|---|

| Tumor (ground truth) | 18 (TP) | 1 (FN) |

| Non-Tumor (ground truth) | 6 (FP) | 452 (TN) |

The preceding confusion matrix shows the following:

- Of the 19 predictions in which ground truth was Tumor, the model correctly classified 18 and incorrectly classified 1.

- Of the 458 predictions in which ground truth was Non-Tumor, the model correctly classified 452 and incorrectly classified 6.

The confusion matrix for a multi-class classification problem can help you identify patterns of mistakes. For example, consider the following confusion matrix for a 3-class multi-class classification model that categorizes three different iris types (Virginica, Versicolor, and Setosa). When the ground truth was Virginica, the confusion matrix shows that the model was far more likely to mistakenly predict Versicolor than Setosa:

| Setosa (predicted) | Versicolor (predicted) | Virginica (predicted) | |

|---|---|---|---|

| Setosa (ground truth) | ۸۸ | ۱۲ | 0 |

| Versicolor (ground truth) | ۶ | ۱۴۱ | ۷ |

| Virginica (ground truth) | ۲ | ۲۷ | ۱۰۹ |

As yet another example, a confusion matrix could reveal that a model trained to recognize handwritten digits tends to mistakenly predict 9 instead of 4, or mistakenly predict 1 instead of 7.

Confusion matrixes contain sufficient information to calculate a variety of performance metrics, including precision and recall .

constituency parsing

Dividing a sentence into smaller grammatical structures ("constituents"). A later part of the ML system, such as a natural language understanding model, can parse the constituents more easily than the original sentence. For example, consider the following sentence:

My friend adopted two cats.

A constituency parser can divide this sentence into the following two constituents:

- My friend is a noun phrase.

- adopted two cats is a verb phrase.

These constituents can be further subdivided into smaller constituents. For example, the verb phrase

adopted two cats

could be further subdivided into:

- adopted is a verb.

- two cats is another noun phrase.

contextualized language embedding

An embedding that comes close to "understanding" words and phrases in ways that fluent human speakers can. Contextualized language embeddings can understand complex syntax, semantics, and context.

For example, consider embeddings of the English word cow . Older embeddings such as word2vec can represent English words such that the distance in the embedding space from cow to bull is similar to the distance from ewe (female sheep) to ram (male sheep) or from female to male . Contextualized language embeddings can go a step further by recognizing that English speakers sometimes casually use the word cow to mean either cow or bull.

context window

The number of tokens a model can process in a given prompt . The larger the context window, the more information the model can use to provide coherent and consistent responses to the prompt.

continuous feature

A floating-point feature with an infinite range of possible values, such as temperature or weight.

Contrast with discrete feature .

نمونهگیری در دسترس

Using a dataset not gathered scientifically in order to run quick experiments. Later on, it's essential to switch to a scientifically gathered dataset.

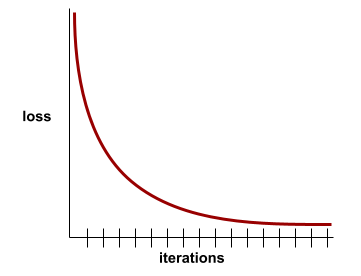

همگرایی

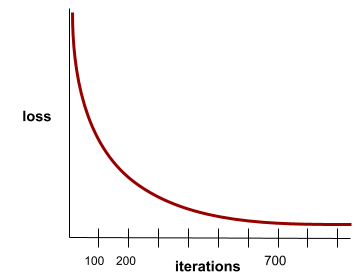

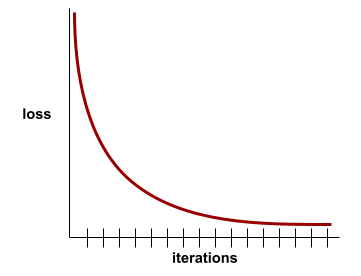

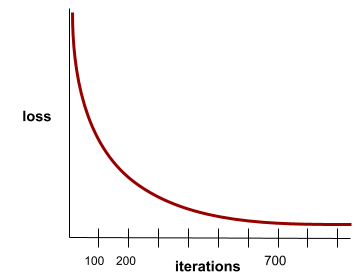

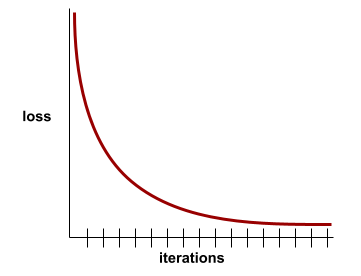

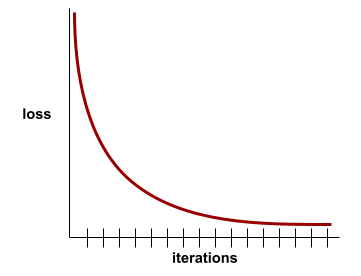

A state reached when loss values change very little or not at all with each iteration . For example, the following loss curve suggests convergence at around 700 iterations:

A model converges when additional training won't improve the model.

In deep learning , loss values sometimes stay constant or nearly so for many iterations before finally descending. During a long period of constant loss values, you may temporarily get a false sense of convergence.

See also early stopping .

See Model convergence and loss curves in Machine Learning Crash Course for more information.

conversational coding

An iterative dialog between you and a generative AI model for the purpose of creating software. You issue a prompt describing some software. Then, the model uses that description to generate code. Then, you issue a new prompt to address the flaws in the previous prompt or in the generated code, and the model generates updated code. You two keep going back and forth until the generated software is good enough.

Conversation coding is essentially the original meaning of vibe coding .

Contrast with specificational coding .

تابع محدب

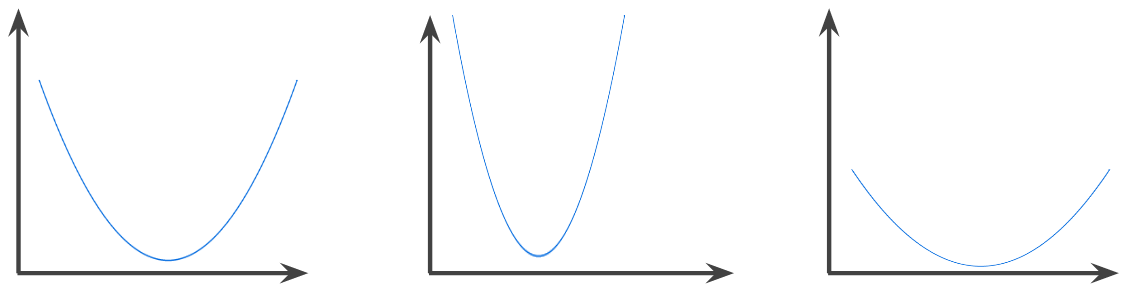

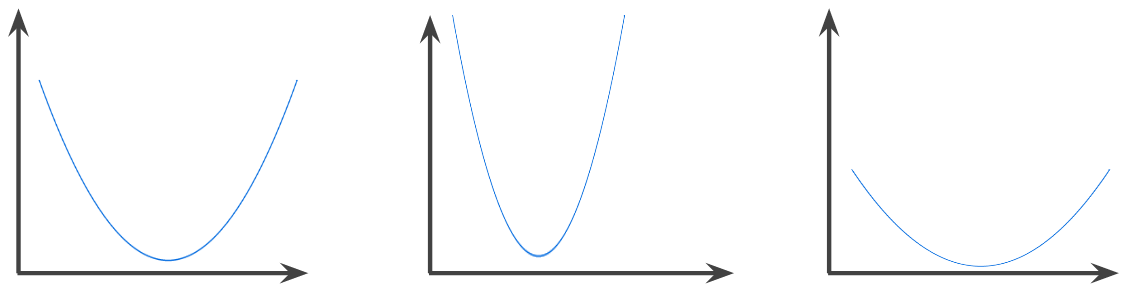

A function in which the region above the graph of the function is a convex set . The prototypical convex function is shaped something like the letter U . For example, the following are all convex functions:

In contrast, the following function is not convex. Notice how the region above the graph is not a convex set:

A strictly convex function has exactly one local minimum point, which is also the global minimum point. The classic U-shaped functions are strictly convex functions. However, some convex functions (for example, straight lines) are not U-shaped.

See Convergence and convex functions in Machine Learning Crash Course for more information.

بهینهسازی محدب

The process of using mathematical techniques such as gradient descent to find the minimum of a convex function . A great deal of research in machine learning has focused on formulating various problems as convex optimization problems and in solving those problems more efficiently.

For complete details, see Boyd and Vandenberghe, Convex Optimization .

مجموعه محدب

A subset of Euclidean space such that a line drawn between any two points in the subset remains completely within the subset. For instance, the following two shapes are convex sets:

In contrast, the following two shapes are not convex sets:

کانولوشن

In mathematics, casually speaking, a mixture of two functions. In machine learning, a convolution mixes the convolutional filter and the input matrix in order to train weights .

The term "convolution" in machine learning is often a shorthand way of referring to either convolutional operation or convolutional layer .

Without convolutions, a machine learning algorithm would have to learn a separate weight for every cell in a large tensor . For example, a machine learning algorithm training on 2K x 2K images would be forced to find 4M separate weights. Thanks to convolutions, a machine learning algorithm only has to find weights for every cell in the convolutional filter , dramatically reducing the memory needed to train the model. When the convolutional filter is applied, it is simply replicated across cells such that each is multiplied by the filter.

See Introducing Convolutional Neural Networks in the Image Classification course for more information.

convolutional filter

One of the two actors in a convolutional operation . (The other actor is a slice of an input matrix.) A convolutional filter is a matrix having the same rank as the input matrix, but a smaller shape. For example, given a 28x28 input matrix, the filter could be any 2D matrix smaller than 28x28.

In photographic manipulation, all the cells in a convolutional filter are typically set to a constant pattern of ones and zeroes. In machine learning, convolutional filters are typically seeded with random numbers and then the network trains the ideal values.

See Convolution in the Image Classification course for more information.

لایه کانولوشن

A layer of a deep neural network in which a convolutional filter passes along an input matrix. For example, consider the following 3x3 convolutional filter :

The following animation shows a convolutional layer consisting of 9 convolutional operations involving the 5x5 input matrix. Notice that each convolutional operation works on a different 3x3 slice of the input matrix. The resulting 3x3 matrix (on the right) consists of the results of the 9 convolutional operations:

![An animation showing two matrixes. The first matrix is the 5x5

matrix: [[128,97,53,201,198], [35,22,25,200,195],

[37,24,28,197,182], [33,28,92,195,179], [31,40,100,192,177]].

The second matrix is the 3x3 matrix:

[[181,303,618], [115,338,605], [169,351,560]].

The second matrix is calculated by applying the convolutional

filter [[0, 1, 0], [1, 0, 1], [0, 1, 0]] across

different 3x3 subsets of the 5x5 matrix.](https://developers.google.com/static/machine-learning/glossary/images/AnimatedConvolution.gif?authuser=1&hl=fa)

See Fully Connected Layers in the Image Classification course for more information.

شبکه عصبی کانولوشن

A neural network in which at least one layer is a convolutional layer . A typical convolutional neural network consists of some combination of the following layers:

Convolutional neural networks have had great success in certain kinds of problems, such as image recognition.

convolutional operation

The following two-step mathematical operation:

- Element-wise multiplication of the convolutional filter and a slice of an input matrix. (The slice of the input matrix has the same rank and size as the convolutional filter.)

- Summation of all the values in the resulting product matrix.

For example, consider the following 5x5 input matrix:

Now imagine the following 2x2 convolutional filter:

Each convolutional operation involves a single 2x2 slice of the input matrix. For example, suppose we use the 2x2 slice at the top-left of the input matrix. So, the convolution operation on this slice looks as follows:

A convolutional layer consists of a series of convolutional operations, each acting on a different slice of the input matrix.

هزینه

Synonym for loss .

co-training

A semi-supervised learning approach particularly useful when all of the following conditions are true:

- The ratio of unlabeled examples to labeled examples in the dataset is high.

- This is a classification problem ( binary or multi-class ).

- The dataset contains two different sets of predictive features that are independent of each other and complementary.

Co-training essentially amplifies independent signals into a stronger signal. For example, consider a classification model that categorizes individual used cars as either Good or Bad . One set of predictive features might focus on aggregate characteristics such as the year, make, and model of the car; another set of predictive features might focus on the previous owner's driving record and the car's maintenance history.

The seminal paper on co-training is Combining Labeled and Unlabeled Data with Co-Training by Blum and Mitchell.

counterfactual fairness

A fairness metric that checks whether a classification model produces the same result for one individual as it does for another individual who is identical to the first, except with respect to one or more sensitive attributes . Evaluating a classification model for counterfactual fairness is one method for surfacing potential sources of bias in a model.

See either of the following for more information:

- Fairness: Counterfactual fairness in Machine Learning Crash Course.

- When Worlds Collide: Integrating Different Counterfactual Assumptions in Fairness

coverage bias

See selection bias .

crash blossom

A sentence or phrase with an ambiguous meaning. Crash blossoms present a significant problem in natural language understanding . For example, the headline Red Tape Holds Up Skyscraper is a crash blossom because an NLU model could interpret the headline literally or figuratively.

منتقد

Synonym for Deep Q-Network .

cross-entropy

A generalization of Log Loss to multi-class classification problems . Cross-entropy quantifies the difference between two probability distributions. See also perplexity .

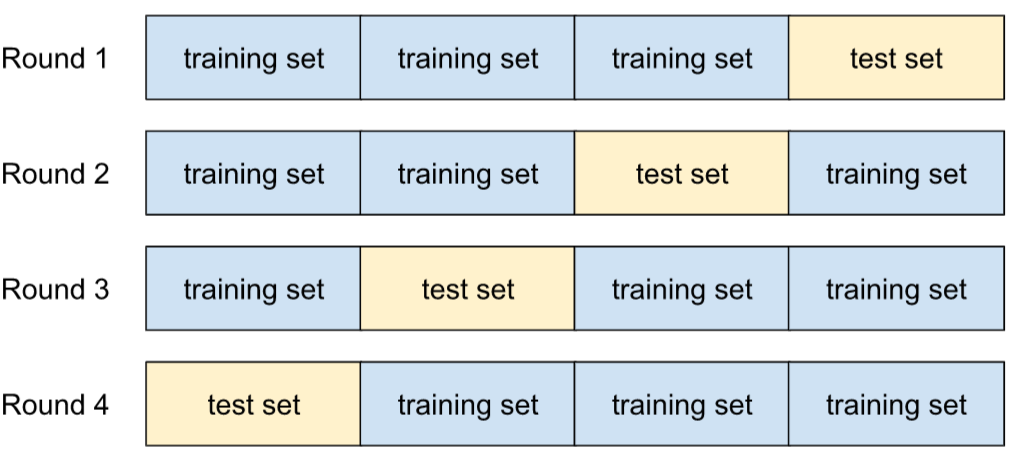

cross-validation

A mechanism for estimating how well a model would generalize to new data by testing the model against one or more non-overlapping data subsets withheld from the training set .

cumulative distribution function (CDF)

A function that defines the frequency of samples less than or equal to a target value. For example, consider a normal distribution of continuous values. A CDF tells you that approximately 50% of samples should be less than or equal to the mean and that approximately 84% of samples should be less than or equal to one standard deviation above the mean.

دی

تحلیل دادهها

Obtaining an understanding of data by considering samples, measurement, and visualization. Data analysis can be particularly useful when a dataset is first received, before one builds the first model . It is also crucial in understanding experiments and debugging problems with the system.

افزایش داده

Artificially boosting the range and number of training examples by transforming existing examples to create additional examples. For example, suppose images are one of your features , but your dataset doesn't contain enough image examples for the model to learn useful associations. Ideally, you'd add enough labeled images to your dataset to enable your model to train properly. If that's not possible, data augmentation can rotate, stretch, and reflect each image to produce many variants of the original picture, possibly yielding enough labeled data to enable excellent training.

قاب داده

A popular pandas data type for representing datasets in memory.

A DataFrame is analogous to a table or a spreadsheet. Each column of a DataFrame has a name (a header), and each row is identified by a unique number.

Each column in a DataFrame is structured like a 2D array, except that each column can be assigned its own data type.

See also the official pandas.DataFrame reference page .

data parallelism

A way of scaling training or inference that replicates an entire model onto multiple devices and then passes a subset of the input data to each device. Data parallelism can enable training and inference on very large batch sizes ; however, data parallelism requires that the model be small enough to fit on all devices.

Data parallelism typically speeds training and inference.

See also model parallelism .

Dataset API (tf.data)

A high-level TensorFlow API for reading data and transforming it into a form that a machine learning algorithm requires. A tf.data.Dataset object represents a sequence of elements, in which each element contains one or more Tensors . A tf.data.Iterator object provides access to the elements of a Dataset .

data set or dataset

A collection of raw data, commonly (but not exclusively) organized in one of the following formats:

- a spreadsheet

- a file in CSV (comma-separated values) format

مرز تصمیمگیری

The separator between classes learned by a model in a binary class or multi-class classification problems . For example, in the following image representing a binary classification problem, the decision boundary is the frontier between the orange class and the blue class:

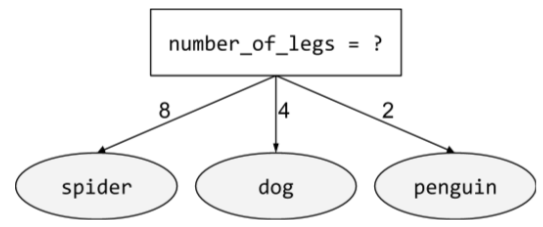

decision forest

A model created from multiple decision trees . A decision forest makes a prediction by aggregating the predictions of its decision trees. Popular types of decision forests include random forests and gradient boosted trees .

See the Decision Forests section in the Decision Forests course for more information.

decision threshold

Synonym for classification threshold .

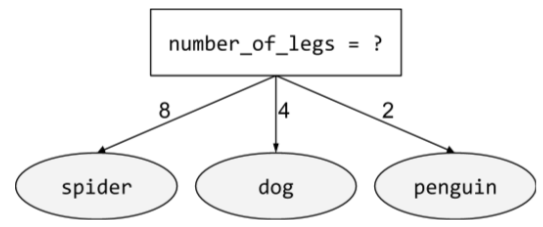

درخت تصمیم

A supervised learning model composed of a set of conditions and leaves organized hierarchically. For example, the following is a decision tree:

رمزگشا

In general, any ML system that converts from a processed, dense, or internal representation to a more raw, sparse, or external representation.

Decoders are often a component of a larger model, where they are frequently paired with an encoder .

In sequence-to-sequence tasks , a decoder starts with the internal state generated by the encoder to predict the next sequence.

Refer to Transformer for the definition of a decoder within the Transformer architecture.

See Large language models in Machine Learning Crash Course for more information.

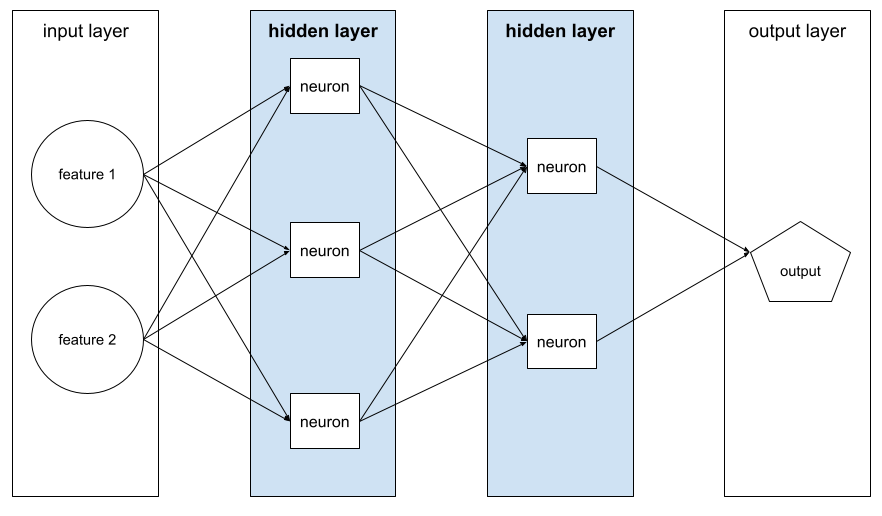

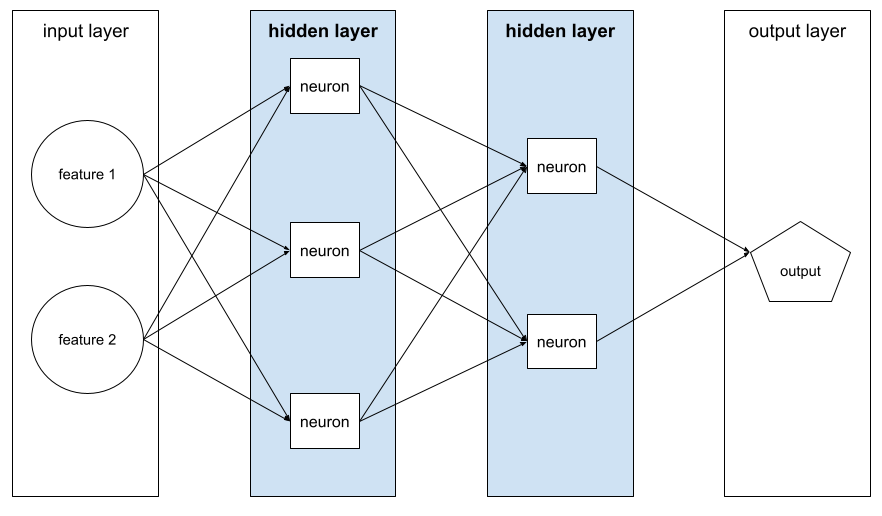

deep model

A neural network containing more than one hidden layer .

A deep model is also called a deep neural network .

Contrast with wide model .

شبکه عصبی عمیق

Synonym for deep model .

Deep Q-Network (DQN)

In Q-learning , a deep neural network that predicts Q-functions .

Critic is a synonym for Deep Q-Network.

برابری جمعیتی

A fairness metric that is satisfied if the results of a model's classification are not dependent on a given sensitive attribute .

For example, if both Lilliputians and Brobdingnagians apply to Glubbdubdrib University, demographic parity is achieved if the percentage of Lilliputians admitted is the same as the percentage of Brobdingnagians admitted, irrespective of whether one group is on average more qualified than the other.

Contrast with equalized odds and equality of opportunity , which permit classification results in aggregate to depend on sensitive attributes, but don't permit classification results for certain specified ground truth labels to depend on sensitive attributes. See "Attacking discrimination with smarter machine learning" for a visualization exploring the tradeoffs when optimizing for demographic parity.

See Fairness: demographic parity in Machine Learning Crash Course for more information.

نویززدایی

A common approach to self-supervised learning in which:

Denoising enables learning from unlabeled examples . The original dataset serves as the target or label and the noisy data as the input.

Some masked language models use denoising as follows:

- Noise is artificially added to an unlabeled sentence by masking some of the tokens.

- The model tries to predict the original tokens.

dense feature

A feature in which most or all values are nonzero, typically a Tensor of floating-point values. For example, the following 10-element Tensor is dense because 9 of its values are nonzero:

| ۸ | ۳ | ۷ | ۵ | ۲ | ۴ | 0 | ۴ | ۹ | ۶ |

Contrast with sparse feature .

لایه متراکم

Synonym for fully connected layer .

عمق

The sum of the following in a neural network :

- the number of hidden layers

- the number of output layers , which is typically 1

- the number of any embedding layers

For example, a neural network with five hidden layers and one output layer has a depth of 6.

Notice that the input layer doesn't influence depth.

depthwise separable convolutional neural network (sepCNN)

A convolutional neural network architecture based on Inception , but where Inception modules are replaced with depthwise separable convolutions. Also known as Xception.

A depthwise separable convolution (also abbreviated as separable convolution) factors a standard 3D convolution into two separate convolution operations that are more computationally efficient: first, a depthwise convolution, with a depth of 1 (n ✕ n ✕ 1), and then second, a pointwise convolution, with length and width of 1 (1 ✕ 1 ✕ n).

To learn more, see Xception: Deep Learning with Depthwise Separable Convolutions .

derived label

Synonym for proxy label .

دستگاه

An overloaded term with the following two possible definitions:

- A category of hardware that can run a TensorFlow session, including CPUs, GPUs, and TPUs .

- When training an ML model on accelerator chips (GPUs or TPUs), the part of the system that actually manipulates tensors and embeddings . The device runs on accelerator chips. In contrast, the host typically runs on a CPU.

differential privacy

In machine learning, an anonymization approach to protect any sensitive data (for example, an individual's personal information) included in a model's training set from being exposed. This approach ensures that the model doesn't learn or remember much about a specific individual. This is accomplished by sampling and adding noise during model training to obscure individual data points, mitigating the risk of exposing sensitive training data.

Differential privacy is also used outside of machine learning. For example, data scientists sometimes use differential privacy to protect individual privacy when computing product usage statistics for different demographics.

کاهش ابعاد

Decreasing the number of dimensions used to represent a particular feature in a feature vector, typically by converting to an embedding vector .

ابعاد

Overloaded term having any of the following definitions:

The number of levels of coordinates in a Tensor . For example:

- A scalar has zero dimensions; for example,

["Hello"]. - A vector has one dimension; for example,

[3, 5, 7, 11]. - A matrix has two dimensions; for example,

[[2, 4, 18], [5, 7, 14]]. You can uniquely specify a particular cell in a one-dimensional vector with one coordinate; you need two coordinates to uniquely specify a particular cell in a two-dimensional matrix.

- A scalar has zero dimensions; for example,

The number of entries in a feature vector .

The number of elements in an embedding layer .

direct prompting

Synonym for zero-shot prompting .

discrete feature

A feature with a finite set of possible values. For example, a feature whose values may only be animal , vegetable , or mineral is a discrete (or categorical) feature.

Contrast with continuous feature .

discriminative model

A model that predicts labels from a set of one or more features . More formally, discriminative models define the conditional probability of an output given the features and weights ; that is:

p(output | features, weights)

For example, a model that predicts whether an email is spam from features and weights is a discriminative model.

The vast majority of supervised learning models, including classification and regression models, are discriminative models.

Contrast with generative model .

تبعیض کننده

A system that determines whether examples are real or fake.

Alternatively, the subsystem within a generative adversarial network that determines whether the examples created by the generator are real or fake.

See The discriminator in the GAN course for more information.

تأثیر متفاوت

Making decisions about people that impact different population subgroups disproportionately. This usually refers to situations where an algorithmic decision-making process harms or benefits some subgroups more than others.

For example, suppose an algorithm that determines a Lilliputian's eligibility for a miniature-home loan is more likely to classify them as "ineligible" if their mailing address contains a certain postal code. If Big-Endian Lilliputians are more likely to have mailing addresses with this postal code than Little-Endian Lilliputians, then this algorithm may result in disparate impact.

Contrast with disparate treatment , which focuses on disparities that result when subgroup characteristics are explicit inputs to an algorithmic decision-making process.

درمان متفاوت

Factoring subjects' sensitive attributes into an algorithmic decision-making process such that different subgroups of people are treated differently.

For example, consider an algorithm that determines Lilliputians' eligibility for a miniature-home loan based on the data they provide in their loan application. If the algorithm uses a Lilliputian's affiliation as Big-Endian or Little-Endian as an input, it is enacting disparate treatment along that dimension.

Contrast with disparate impact , which focuses on disparities in the societal impacts of algorithmic decisions on subgroups, irrespective of whether those subgroups are inputs to the model.

تقطیر

The process of reducing the size of one model (known as the teacher ) into a smaller model (known as the student ) that emulates the original model's predictions as faithfully as possible. Distillation is useful because the smaller model has two key benefits over the larger model (the teacher):

- Faster inference time

- Reduced memory and energy usage

However, the student's predictions are typically not as good as the teacher's predictions.

Distillation trains the student model to minimize a loss function based on the difference between the outputs of the predictions of the student and teacher models.

Compare and contrast distillation with the following terms:

See LLMs: Fine-tuning, distillation, and prompt engineering in Machine Learning Crash Course for more information.

توزیع

The frequency and range of different values for a given feature or label . A distribution captures how likely a particular value is.

The following image shows histograms of two different distributions:

- On the left, a power law distribution of wealth versus the number of people possessing that wealth.

- On the right, a normal distribution of height versus the number of people possessing that height.

Understanding each feature and label's distribution can help you determine how to normalize values and detect outliers .

The phrase out of distribution refers to a value that doesn't appear in the dataset or is very rare. For example, an image of the planet Saturn would be considered out of distribution for a dataset consisting of cat images.

divisive clustering

See hierarchical clustering .

downsampling

Overloaded term that can mean either of the following:

- Reducing the amount of information in a feature in order to train a model more efficiently. For example, before training an image recognition model, downsampling high-resolution images to a lower-resolution format.

- Training on a disproportionately low percentage of over-represented class examples in order to improve model training on under-represented classes. For example, in a class-imbalanced dataset , models tend to learn a lot about the majority class and not enough about the minority class . Downsampling helps balance the amount of training on the majority and minority classes.

See Datasets: Imbalanced datasets in Machine Learning Crash Course for more information.

DQN

Abbreviation for Deep Q-Network .

dropout regularization

A form of regularization useful in training neural networks . Dropout regularization removes a random selection of a fixed number of the units in a network layer for a single gradient step. The more units dropped out, the stronger the regularization. This is analogous to training the network to emulate an exponentially large ensemble of smaller networks. For full details, see Dropout: A Simple Way to Prevent Neural Networks from Overfitting .

پویا

Something done frequently or continuously. The terms dynamic and online are synonyms in machine learning. The following are common uses of dynamic and online in machine learning:

- A dynamic model (or online model ) is a model that is retrained frequently or continuously.

- Dynamic training (or online training ) is the process of training frequently or continuously.

- Dynamic inference (or online inference ) is the process of generating predictions on demand.

مدل پویا

A model that is frequently (maybe even continuously) retrained. A dynamic model is a "lifelong learner" that constantly adapts to evolving data. A dynamic model is also known as an online model .

Contrast with static model .

ای

eager execution

A TensorFlow programming environment in which operations run immediately. In contrast, operations called in graph execution don't run until they are explicitly evaluated. Eager execution is an imperative interface , much like the code in most programming languages. Eager execution programs are generally far easier to debug than graph execution programs.

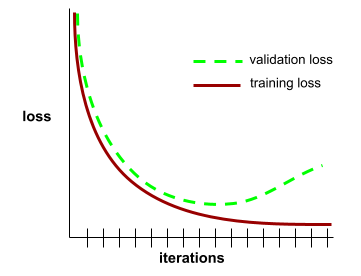

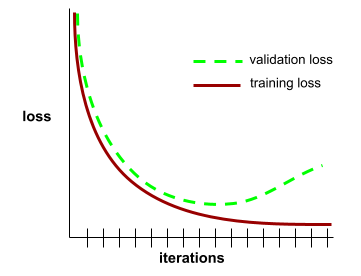

توقف زودهنگام

A method for regularization that involves ending training before training loss finishes decreasing. In early stopping, you intentionally stop training the model when the loss on a validation dataset starts to increase; that is, when generalization performance worsens.

Contrast with early exit .

earth mover's distance (EMD)

A measure of the relative similarity of two distributions . The lower the earth mover's distance, the more similar the distributions.

edit distance

A measurement of how similar two text strings are to each other. In machine learning, edit distance is useful for the following reasons:

- Edit distance is easy to compute.

- Edit distance can compare two strings known to be similar to each other.

- Edit distance can determine the degree to which different strings are similar to a given string.

Several definitions of edit distance exist, each using different string operations. See Levenshtein distance for an example.

Einsum notation

An efficient notation for describing how two tensors are to be combined. The tensors are combined by multiplying the elements of one tensor by the elements of the other tensor and then summing the products. Einsum notation uses symbols to identify the axes of each tensor, and those same symbols are rearranged to specify the shape of the new resulting tensor.

NumPy provides a common Einsum implementation.

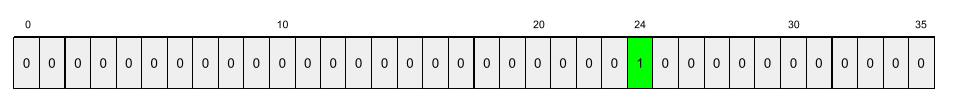

embedding layer

A special hidden layer that trains on a high-dimensional categorical feature to gradually learn a lower dimension embedding vector. An embedding layer enables a neural network to train far more efficiently than training just on the high-dimensional categorical feature.

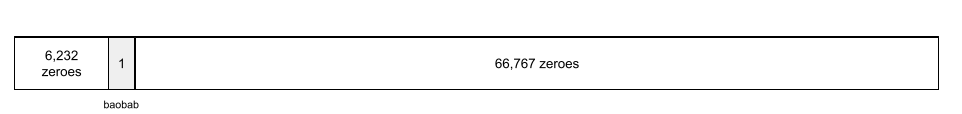

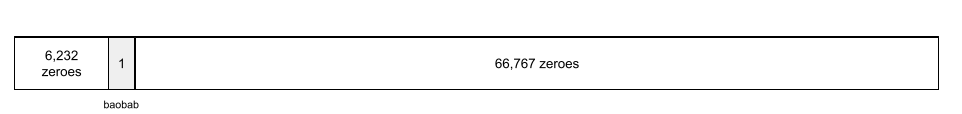

For example, Earth currently supports about 73,000 tree species. Suppose tree species is a feature in your model, so your model's input layer includes a one-hot vector 73,000 elements long. For example, perhaps baobab would be represented something like this:

A 73,000-element array is very long. If you don't add an embedding layer to the model, training is going to be very time consuming due to multiplying 72,999 zeros. Perhaps you pick the embedding layer to consist of 12 dimensions. Consequently, the embedding layer will gradually learn a new embedding vector for each tree species.

In certain situations, hashing is a reasonable alternative to an embedding layer.

See Embeddings in Machine Learning Crash Course for more information.

embedding space

The d-dimensional vector space that features from a higher-dimensional vector space are mapped to. Embedding space is trained to capture structure that is meaningful for the intended application.

The dot product of two embeddings is a measure of their similarity.

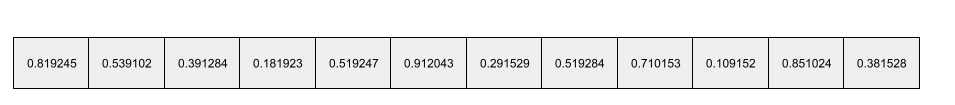

embedding vector

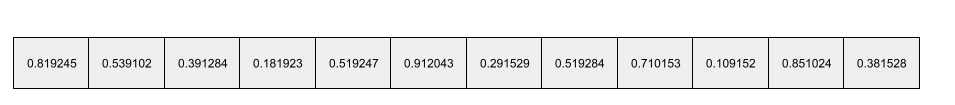

Broadly speaking, an array of floating-point numbers taken from any hidden layer that describe the inputs to that hidden layer. Often, an embedding vector is the array of floating-point numbers trained in an embedding layer. For example, suppose an embedding layer must learn an embedding vector for each of the 73,000 tree species on Earth. Perhaps the following array is the embedding vector for a baobab tree:

An embedding vector is not a bunch of random numbers. An embedding layer determines these values through training, similar to the way a neural network learns other weights during training. Each element of the array is a rating along some characteristic of a tree species. Which element represents which tree species' characteristic? That's very hard for humans to determine.

The mathematically remarkable part of an embedding vector is that similar items have similar sets of floating-point numbers. For example, similar tree species have a more similar set of floating-point numbers than dissimilar tree species. Redwoods and sequoias are related tree species, so they'll have a more similar set of floating-pointing numbers than redwoods and coconut palms. The numbers in the embedding vector will change each time you retrain the model, even if you retrain the model with identical input.

empirical cumulative distribution function (eCDF or EDF)

A cumulative distribution function based on empirical measurements from a real dataset. The value of the function at any point along the x-axis is the fraction of observations in the dataset that are less than or equal to the specified value.

empirical risk minimization (ERM)

Choosing the function that minimizes loss on the training set. Contrast with structural risk minimization .

رمزگذار

In general, any ML system that converts from a raw, sparse, or external representation into a more processed, denser, or more internal representation.

Encoders are often a component of a larger model, where they are frequently paired with a decoder . Some Transformers pair encoders with decoders, though other Transformers use only the encoder or only the decoder.

Some systems use the encoder's output as the input to a classification or regression network.

In sequence-to-sequence tasks , an encoder takes an input sequence and returns an internal state (a vector). Then, the decoder uses that internal state to predict the next sequence.

Refer to Transformer for the definition of an encoder in the Transformer architecture.

See LLMs: What's a large language model in Machine Learning Crash Course for more information.

endpoints

A network-addressable location (typically a URL) where a service can be reached.

گروه

A collection of models trained independently whose predictions are averaged or aggregated. In many cases, an ensemble produces better predictions than a single model. For example, a random forest is an ensemble built from multiple decision trees . Note that not all decision forests are ensembles.

See Random Forest in Machine Learning Crash Course for more information.

آنتروپی

In information theory , a description of how unpredictable a probability distribution is. Alternatively, entropy is also defined as how much information each example contains. A distribution has the highest possible entropy when all values of a random variable are equally likely.

The entropy of a set with two possible values "0" and "1" (for example, the labels in a binary classification problem) has the following formula:

H = -p log p - q log q = -p log p - (1-p) * log (1-p)

کجا:

- H is the entropy.

- p is the fraction of "1" examples.

- q is the fraction of "0" examples. Note that q = (1 - p)

- log is generally log 2 . In this case, the entropy unit is a bit.

For example, suppose the following:

- 100 examples contain the value "1"

- 300 examples contain the value "0"

Therefore, the entropy value is:

- p = 0.25

- q = 0.75

- H = (-0.25)log 2 (0.25) - (0.75)log 2 (0.75) = 0.81 bits per example

A set that is perfectly balanced (for example, 200 "0"s and 200 "1"s) would have an entropy of 1.0 bit per example. As a set becomes more imbalanced , its entropy moves towards 0.0.

In decision trees , entropy helps formulate information gain to help the splitter select the conditions during the growth of a classification decision tree.

Compare entropy with:

- ناخالصی جینی

- cross-entropy loss function

Entropy is often called Shannon's entropy .

See Exact splitter for binary classification with numerical features in the Decision Forests course for more information.

محیط زیست

In reinforcement learning, the world that contains the agent and allows the agent to observe that world's state . For example, the represented world can be a game like chess, or a physical world like a maze. When the agent applies an action to the environment, then the environment transitions between states.

قسمت

In reinforcement learning, each of the repeated attempts by the agent to learn an environment .

دوران

A full training pass over the entire training set such that each example has been processed once.

An epoch represents N / batch size training iterations , where N is the total number of examples.

For instance, suppose the following:

- The dataset consists of 1,000 examples.

- The batch size is 50 examples.

Therefore, a single epoch requires 20 iterations:

1 epoch = (N/batch size) = (1,000 / 50) = 20 iterations

See Linear regression: Hyperparameters in Machine Learning Crash Course for more information.

epsilon greedy policy

In reinforcement learning, a policy that either follows a random policy with epsilon probability or a greedy policy otherwise. For example, if epsilon is 0.9, then the policy follows a random policy 90% of the time and a greedy policy 10% of the time.

Over successive episodes, the algorithm reduces epsilon's value in order to shift from following a random policy to following a greedy policy. By shifting the policy, the agent first randomly explores the environment and then greedily exploits the results of random exploration.

برابری فرصتها