Checks Guardrails API artık özel önizleme kapsamında alfa sürümünde kullanılabilir. Talep formumuzu kullanarak özel önizlemeye erişim isteğinde bulunun.

Guardrails API, metnin zararlı veya güvenli olup olmadığını kontrol etmenizi sağlayan bir API'dir. Kullanıcılarınızın zararlı olabilecek içeriklere maruz kalmasını önlemek için bu API'yi üretken yapay zeka uygulamanızda kullanabilirsiniz.

Koruma duvarları nasıl kullanılır?

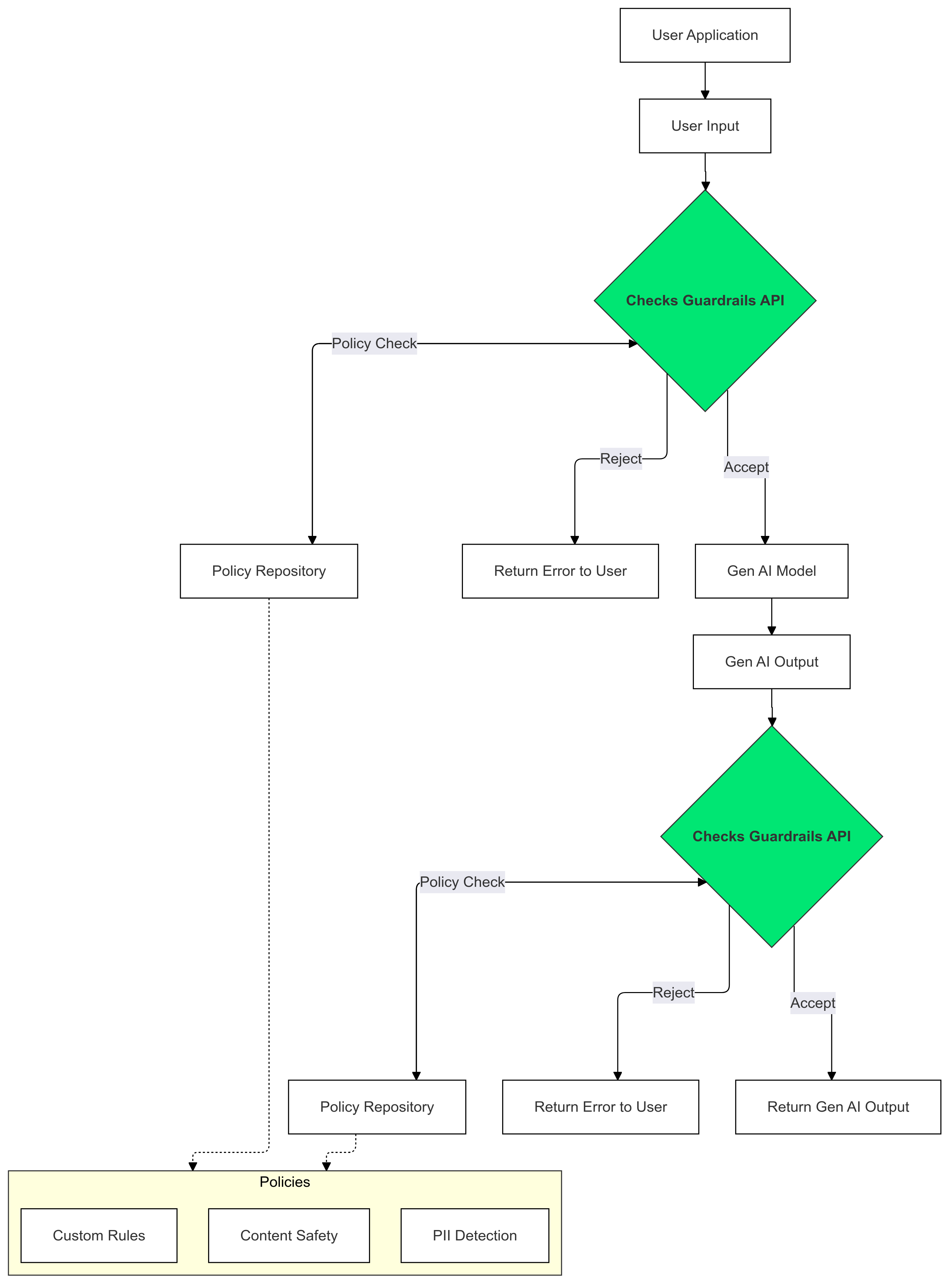

Politikalarınızı ihlal eden metinlerin varlığını tespit edip azaltmak için üretken yapay zeka giriş ve çıkışlarınızda Checks Guardrails'i kullanın.

Koruma duvarlarını neden kullanmalısınız?

LLM'ler bazen zararlı veya uygunsuz içerikler üretebilir. Guardrails API'yi üretken yapay zeka uygulamanıza entegre etmek, büyük dil modellerinin (LLM) sorumlu ve daha güvenli bir şekilde kullanılmasını sağlamak için çok önemlidir. Uygunsuz dil, ayrımcı ifadeler ve zarara yol açabilecek içerikler de dahil olmak üzere zararlı olabilecek çok çeşitli çıktıları filtreleyerek üretilen içeriklerle ilişkili riskleri azaltmanıza yardımcı olur. Bu sayede hem kullanıcılarınızı korur hem de uygulamanızın itibarını güvence altına alarak kitleniz arasında güven oluşturursunuz. Güvenlik ve sorumluluğa öncelik veren korumalar, hem yenilikçi hem de daha güvenli üretken yapay zeka uygulamaları oluşturmanıza olanak tanır.

Başlarken

Bu kılavuzda, uygulamalarınızdaki uygunsuz içerikleri tespit etmek ve filtrelemek için Guardrails API'yi kullanmayla ilgili talimatlar verilmektedir. API, nefret söylemi, şiddet ve cinsel içerikli materyaller gibi farklı türlerdeki potansiyel olarak zararlı içerikleri tanımlayabilen çeşitli önceden eğitilmiş politikalar sunar. Ayrıca, her politika için eşikler belirleyerek API'nin davranışını özelleştirebilirsiniz.

Ön koşullar

- Google Cloud projenizin Checks AI Safety Private Preview için onaylanması gerekir. Henüz yapmadıysanız ilgi alanları formumuzu kullanarak erişim isteğinde bulunun.

- Checks API'yi etkinleştirin.

- Yetkilendirme kılavuzumuzu kullanarak yetkilendirilmiş istekler gönderebildiğinizden emin olun.

Desteklenen politikalar

| Politika Adı | Politikanın açıklaması | Politika Türü API Enum Değeri |

|---|---|---|

| Tehlikeli İçerikler | Zararlı ürünlere, hizmetlere ve faaliyetlere erişimi kolaylaştıran, tanıtan veya sağlayan içerikler | DANGEROUS_CONTENT |

| Kişisel Veri (PII) İstemek ve Almak | Bir bireyin hassas kişisel bilgilerini veya verilerini isteyen ya da ifşa eden içerikler | PII_SOLICITING_RECITING |

| Taciz | Başka bir kişiye veya kişilere karşı kötü niyetli, göz korkutucu, zorbalık içeren veya taciz edici içerikler | HARASSMENT |

| Müstehcen | Müstehcen içerik | SEXUALLY_EXPLICIT |

| Nefret Söylemi | Genel olarak nefret söylemi olarak kabul edilen içerikler. | HATE_SPEECH |

| Tıbbi Bilgiler | Zararlı tıbbi tavsiyelere veya yönlendirmelere erişimi kolaylaştıran, teşvik eden ya da sağlayan içerikler yasaktır. | MEDICAL_INFO |

| Şiddet ve kan | Gerçekçi şiddet ve/veya kan içeren gereksiz açıklamalar barındıran içerikler | VIOLENCE_AND_GORE |

| Müstehcenlik ve Küfür | Kaba, küfürlü veya rahatsız edici bir dil barındıran içerik yasaktır. | OBSCENITY_AND_PROFANITY |

Kod snippet'leri

Python

pip install

google-api-python-client komutunu çalıştırarak Google API Python istemcisini yükleyin.

import logging

from google.oauth2 import service_account

from googleapiclient.discovery import build

SECRET_FILE_PATH = 'path/to/your/secret.json'

credentials = service_account.Credentials.from_service_account_file(

SECRET_FILE_PATH, scopes=['https://www.googleapis.com/auth/checks']

)

service = build('checks', 'v1alpha', credentials=credentials)

request = service.aisafety().classifyContent(

body={

'input': {

'textInput': {

'content': 'Mix, bake, cool, frost, and enjoy.',

'languageCode': 'en',

}

},

'policies': [

{'policyType': 'DANGEROUS_CONTENT'}

], # Default Checks-defined threshold is used

}

)

response = request.execute()

for policy_result in response['policyResults']:

logging.warning(

'Policy: %s, Score: %s, Violation result: %s',

policy_result['policyType'],

policy_result['score'],

policy_result['violationResult'],

)

Go

Aşağıdaki komutu çalıştırarak Checks API Go Client'ı yükleyin:

go get google.golang.org/api/checks/v1alpha.

package main

import (

"context"

"log/slog"

checks "google.golang.org/api/checks/v1alpha"

option "google.golang.org/api/option"

)

const credsFilePath = "path/to/your/secret.json"

func main() {

ctx := context.Background()

checksService, err := checks.NewService(

ctx,

option.WithEndpoint("https://checks.googleapis.com"),

option.WithCredentialsFile(credsFilePath),

option.WithScopes("https://www.googleapis.com/auth/checks"),

)

if err != nil {

// Handle error

}

req := &checks.GoogleChecksAisafetyV1alphaClassifyContentRequest{

Input: &checks.GoogleChecksAisafetyV1alphaClassifyContentRequestInputContent{

TextInput: &checks.GoogleChecksAisafetyV1alphaTextInput{

Content: "Mix, bake, cool, frost, and enjoy.",

LanguageCode: "en",

},

},

Policies: []*checks.GoogleChecksAisafetyV1alphaClassifyContentRequestPolicyConfig{

{PolicyType: "DANGEROUS_CONTENT"}, // Default Checks-defined threshold is used

},

}

classificationResults, err := checksService.Aisafety.ClassifyContent(req).Do()

if err != nil {

// Handle error

}

for _, policy := range classificationResults.PolicyResults {

slog.Info("Checks Guardrails violation: ", "Policy", policy.PolicyType, "Score", policy.Score, "Violation Result", policy.ViolationResult)

}

}

REST

Not: Bu örnekte oauth2l CLI aracı kullanılmaktadır.

YOUR_GCP_PROJECT_ID kısmını, Guardrails API'ye erişim izni verilen Google Cloud proje kimliğinizle değiştirin.

curl -X POST https://checks.googleapis.com/v1alpha/aisafety:classifyContent \

-H "$(oauth2l header --scope cloud-platform,checks)" \

-H "X-Goog-User-Project: YOUR_GCP_PROJECT_ID" \

-H "Content-Type: application/json" \

-d '{

"input": {

"text_input": {

"content": "Mix, bake, cool, frost, and enjoy.",

"language_code": "en"

}

},

"policies": [

{

"policy_type": "HARASSMENT",

"threshold": "0.5"

},

{

"policy_type": "DANGEROUS_CONTENT",

},

]

}'

Örnek yanıt

{

"policyResults": [

{

"policyType": "HARASSMENT",

"score": 0.430,

"violationResult": "NON_VIOLATIVE"

},

{

"policyType": "DANGEROUS_CONTENT",

"score": 0.764,

"violationResult": "VIOLATIVE"

},

{

"policyType": "OBSCENITY_AND_PROFANITY",

"score": 0.876,

"violationResult": "VIOLATIVE"

},

{

"policyType": "SEXUALLY_EXPLICIT",

"score": 0.197,

"violationResult": "NON_VIOLATIVE"

},

{

"policyType": "HATE_SPEECH",

"score": 0.45,

"violationResult": "NON_VIOLATIVE"

},

{

"policyType": "MEDICAL_INFO",

"score": 0.05,

"violationResult": "NON_VIOLATIVE"

},

{

"policyType": "VIOLENCE_AND_GORE",

"score": 0.964,

"violationResult": "VIOLATIVE"

},

{

"policyType": "PII_SOLICITING_RECITING",

"score": 0.0009,

"violationResult": "NON_VIOLATIVE"

}

]

}

Kullanım alanları

Guardrails API, özel ihtiyaçlarınıza ve risk toleransınıza bağlı olarak çeşitli şekillerde LLM uygulamanıza entegre edilebilir. Yaygın kullanım alanlarına ilişkin birkaç örneği aşağıda bulabilirsiniz:

Koruma bariyeri müdahalesi yok - Günlüğe kaydetme

Bu senaryoda, Guardrails API, uygulamanın davranışında herhangi bir değişiklik yapılmadan kullanılır. Ancak izleme ve denetleme amacıyla olası politika ihlalleri kaydedilmektedir. Bu bilgiler, potansiyel LLM güvenlik risklerini belirlemek için de kullanılabilir.

Python

import logging

from google.oauth2 import service_account

from googleapiclient.discovery import build

# Checks API configuration

class ChecksConfig:

def __init__(self, scope, creds_file_path):

self.scope = scope

self.creds_file_path = creds_file_path

my_checks_config = ChecksConfig(

scope='https://www.googleapis.com/auth/checks',

creds_file_path='path/to/your/secret.json',

)

def new_checks_service(config):

"""Creates a new Checks API service."""

credentials = service_account.Credentials.from_service_account_file(

config.creds_file_path, scopes=[config.scope]

)

service = build('checks', 'v1alpha', credentials=credentials)

return service

def fetch_checks_violation_results(content, context=''):

"""Fetches violation results from the Checks API."""

service = new_checks_service(my_checks_config)

request = service.aisafety().classifyContent(

body={

'context': {'prompt': context},

'input': {

'textInput': {

'content': content,

'languageCode': 'en',

}

},

'policies': [

{'policyType': 'DANGEROUS_CONTENT'},

{'policyType': 'HATE_SPEECH'},

# ... add more policies

],

}

)

response = request.execute()

return response

def fetch_user_prompt():

"""Imitates retrieving the input prompt from the user."""

return 'How do I bake a cake?'

def fetch_llm_response(prompt):

"""Imitates the call to an LLM endpoint."""

return 'Mix, bake, cool, frost, enjoy.'

def log_violations(content, context=''):

"""Checks if the content has any policy violations."""

classification_results = fetch_checks_violation_results(content, context)

for policy_result in classification_results['policyResults']:

if policy_result['violationResult'] == 'VIOLATIVE':

logging.warning(

'Policy: %s, Score: %s, Violation result: %s',

policy_result['policyType'],

policy_result['score'],

policy_result['violationResult'],

)

return False

if __name__ == '__main__':

user_prompt = fetch_user_prompt()

log_violations(user_prompt)

llm_response = fetch_llm_response(user_prompt)

log_violations(llm_response, user_prompt)

print(llm_response)

Go

package main

import (

"context"

"fmt"

"log/slog"

checks "google.golang.org/api/checks/v1alpha"

option "google.golang.org/api/option"

)

type checksConfig struct {

scope string

credsFilePath string

endpoint string

}

var myChecksConfig = checksConfig{

scope: "https://www.googleapis.com/auth/checks",

credsFilePath: "path/to/your/secret.json",

endpoint: "https://checks.googleapis.com",

}

func newChecksService(ctx context.Context, cfg checksConfig) (*checks.Service, error) {

return checks.NewService(

ctx,

option.WithEndpoint(cfg.endpoint),

option.WithCredentialsFile(cfg.credsFilePath),

option.WithScopes(cfg.scope),

)

}

func fetchChecksViolationResults(ctx context.Context, content string, context string) (*checks.GoogleChecksAisafetyV1alphaClassifyContentResponse, error) {

svc, err := newChecksService(ctx, myChecksConfig)

if err != nil {

return nil, fmt.Errorf("failed to create checks service: %w", err)

}

req := &checks.GoogleChecksAisafetyV1alphaClassifyContentRequest{

Context: &checks.GoogleChecksAisafetyV1alphaClassifyContentRequestContext{

Prompt: context,

},

Input: &checks.GoogleChecksAisafetyV1alphaClassifyContentRequestInputContent{

TextInput: &checks.GoogleChecksAisafetyV1alphaTextInput{

Content: content,

LanguageCode: "en",

},

},

Policies: []*checks.GoogleChecksAisafetyV1alphaClassifyContentRequestPolicyConfig{

{PolicyType: "DANGEROUS_CONTENT"},

{PolicyType: "HATE_SPEECH"},

// ... add more policies

},

}

response, err := svc.Aisafety.ClassifyContent(req).Do()

if err != nil {

return nil, fmt.Errorf("failed to classify content: %w", err)

}

return response, nil

}

// Imitates retrieving the input prompt from the user.

func fetchUserPrompt() string {

return "How do I bake a cake?"

}

// Imitates the call to an LLM endpoint.

func fetchLLMResponse(prompt string) string {

return "Mix, bake, cool, frost, enjoy."

}

func logViolations(ctx context.Context, content string, context string) error {

classificationResults, err := fetchChecksViolationResults(ctx, content, context)

if err != nil {

return err

}

for _, policyResult := range classificationResults.PolicyResults {

if policyResult.ViolationResult == "VIOLATIVE" {

slog.Warn("Checks Guardrails violation: ", "Policy", policyResult.PolicyType, "Score", policyResult.Score, "Violation Result", policyResult.ViolationResult)

}

}

return nil

}

func main() {

ctx := context.Background()

userPrompt := fetchUserPrompt()

err := logViolations(ctx, userPrompt, "")

if err != nil {

// Handle error

}

llmResponse := fetchLLMResponse(userPrompt)

err = logViolations(ctx, llmResponse, userPrompt)

if err != nil {

// Handle error

}

fmt.Println(llmResponse)

}

Politikaya dayalı olarak koruma engellendi

Bu örnekte, Guardrails API, güvenli olmayan kullanıcı girişlerini ve model yanıtlarını engeller. Hem önceden tanımlanmış güvenlik politikalarına (ör. nefret söylemi, tehlikeli içerik) göre kontrol eder. Bu sayede yapay zeka, zararlı olabilecek çıkışlar oluşturmaz ve kullanıcılar uygunsuz içeriklerle karşılaşmaz.

Python

from google.oauth2 import service_account

from googleapiclient.discovery import build

# Checks API configuration

class ChecksConfig:

def __init__(self, scope, creds_file_path, default_threshold):

self.scope = scope

self.creds_file_path = creds_file_path

self.default_threshold = default_threshold

my_checks_config = ChecksConfig(

scope='https://www.googleapis.com/auth/checks',

creds_file_path='path/to/your/secret.json',

default_threshold=0.6,

)

def new_checks_service(config):

"""Creates a new Checks API service."""

credentials = service_account.Credentials.from_service_account_file(

config.creds_file_path, scopes=[config.scope]

)

service = build('checks', 'v1alpha', credentials=credentials)

return service

def fetch_checks_violation_results(content, context=''):

"""Fetches violation results from the Checks API."""

service = new_checks_service(my_checks_config)

request = service.aisafety().classifyContent(

body={

'context': {'prompt': context},

'input': {

'textInput': {

'content': content,

'languageCode': 'en',

}

},

'policies': [

{

'policyType': 'DANGEROUS_CONTENT',

'threshold': my_checks_config.default_threshold,

},

{'policyType': 'HATE_SPEECH'},

# ... add more policies

],

}

)

response = request.execute()

return response

def fetch_user_prompt():

"""Imitates retrieving the input prompt from the user."""

return 'How do I bake a cake?'

def fetch_llm_response(prompt):

"""Imitates the call to an LLM endpoint."""

return 'Mix, bake, cool, frost, enjoy.'

def has_violations(content, context=''):

"""Checks if the content has any policy violations."""

classification_results = fetch_checks_violation_results(content, context)

for policy_result in classification_results['policyResults']:

if policy_result['violationResult'] == 'VIOLATIVE':

return True

return False

if __name__ == '__main__':

user_prompt = fetch_user_prompt()

if has_violations(user_prompt):

print("Sorry, I can't help you with this request.")

else:

llm_response = fetch_llm_response(user_prompt)

if has_violations(llm_response, user_prompt):

print("Sorry, I can't help you with this request.")

else:

print(llm_response)

Go

package main

import (

"context"

"fmt"

checks "google.golang.org/api/checks/v1alpha"

option "google.golang.org/api/option"

)

type checksConfig struct {

scope string

credsFilePath string

endpoint string

defaultThreshold float64

}

var myChecksConfig = checksConfig{

scope: "https://www.googleapis.com/auth/checks",

credsFilePath: "path/to/your/secret.json",

endpoint: "https://checks.googleapis.com",

defaultThreshold: 0.6,

}

func newChecksService(ctx context.Context, cfg checksConfig) (*checks.Service, error) {

return checks.NewService(

ctx,

option.WithEndpoint(cfg.endpoint),

option.WithCredentialsFile(cfg.credsFilePath),

option.WithScopes(cfg.scope),

)

}

func fetchChecksViolationResults(ctx context.Context, content string, context string) (*checks.GoogleChecksAisafetyV1alphaClassifyContentResponse, error) {

svc, err := newChecksService(ctx, myChecksConfig)

if err != nil {

return nil, fmt.Errorf("failed to create checks service: %w", err)

}

req := &checks.GoogleChecksAisafetyV1alphaClassifyContentRequest{

Context: &checks.GoogleChecksAisafetyV1alphaClassifyContentRequestContext{

Prompt: context,

},

Input: &checks.GoogleChecksAisafetyV1alphaClassifyContentRequestInputContent{

TextInput: &checks.GoogleChecksAisafetyV1alphaTextInput{

Content: content,

LanguageCode: "en",

},

},

Policies: []*checks.GoogleChecksAisafetyV1alphaClassifyContentRequestPolicyConfig{

{PolicyType: "DANGEROUS_CONTENT", Threshold: myChecksConfig.defaultThreshold},

{PolicyType: "HATE_SPEECH"}, // default Checks-defined threshold is used

// ... add more policies

},

}

response, err := svc.Aisafety.ClassifyContent(req).Do()

if err != nil {

return nil, fmt.Errorf("failed to classify content: %w", err)

}

return response, nil

}

// Imitates retrieving the input prompt from the user.

func fetchUserPrompt() string {

return "How do I bake a cake?"

}

// Imitates the call to an LLM endpoint.

func fetchLLMResponse(prompt string) string {

return "Mix, bake, cool, frost, enjoy."

}

func hasViolations(ctx context.Context, content string, context string) (bool, error) {

classificationResults, err := fetchChecksViolationResults(ctx, content, context)

if err != nil {

return false, fmt.Errorf("failed to classify content: %w", err)

}

for _, policyResult := range classificationResults.PolicyResults {

if policyResult.ViolationResult == "VIOLATIVE" {

return true, nil

}

}

return false, nil

}

func main() {

ctx := context.Background()

userPrompt := fetchUserPrompt()

hasInputViolations, err := hasViolations(ctx, userPrompt, "")

if err == nil && hasInputViolations {

fmt.Println("Sorry, I can't help you with this request.")

return

}

llmResponse := fetchLLMResponse(userPrompt)

hasOutputViolations, err := hasViolations(ctx, llmResponse, userPrompt)

if err == nil && hasOutputViolations {

fmt.Println("Sorry, I can't help you with this request.")

return

}

fmt.Println(llmResponse)

}

LLM çıkışını Guardrails'e aktarma

Aşağıdaki örneklerde, bir LLM'den gelen çıkışı Guardrails API'ye aktarıyoruz. Bu, kullanıcının algıladığı gecikmeyi azaltmak için kullanılabilir. Bu yaklaşım, eksik bağlam nedeniyle yanlış pozitiflere yol açabilir. Bu nedenle, LLM çıkışının API'yi çağırmadan önce Guardrails'in doğru bir değerlendirme yapması için yeterli bağlama sahip olması önemlidir.

Eşzamanlı Önlem Çağrıları

Python

if __name__ == '__main__':

user_prompt = fetch_user_prompt()

my_llm_model = MockModel(

user_prompt, fetch_llm_response(user_prompt)

)

llm_response = ""

chunk = ""

# Minimum number of LLM chunks needed before we will call Guardrails.

contextThreshold = 2

while not my_llm_model.finished:

chunk = my_llm_model.next_chunk()

llm_response += str(chunk)

if my_llm_model.chunkCounter > contextThreshold:

log_violations(llm_response, my_llm_model.userPrompt)

Go

func main() {

ctx := context.Background()

model := mockModel{

userPrompt: "It's a sunny day and you want to buy ice cream.",

response: []string{"What a lovely day", "to get some ice cream.", "is the shop open?"},

}

// Minimum number of LLM chunks needed before we will call Guardrails.

const contextThreshold = 2

var llmResponse string

for !model.finished {

chunk := model.nextChunk()

llmResponse += chunk + " "

if model.chunkCounter > contextThreshold {

err = logViolations(ctx, llmResponse, model.userPrompt)

if err != nil {

// Handle error

}

}

}

}

Asenkron Koruma Önlemi Çağrıları

Python

async def main():

user_prompt = fetch_user_prompt()

my_llm_model = MockModel(

user_prompt, fetch_llm_response(user_prompt)

)

llm_response = ""

chunk = ""

# Minimum number of LLM chunks needed before we will call Guardrails.

contextThreshold = 2

async for chunk in my_llm_model:

llm_response += str(chunk)

if my_llm_model.chunkCounter > contextThreshold:

log_violations(llm_response, my_llm_model.userPrompt)

asyncio.run(main())

Go

func main() {

var textChannel = make(chan string)

model := mockModel{

userPrompt: "It's a sunny day and you want to buy ice cream.",

response: []string{"What a lovely day", "to get some ice cream.", "is the shop open?"},

}

var llmResponse string

// Minimum number of LLM chunks needed before we will call Guardrails.

const contextThreshold = 2

go model.streamToChannel(textChannel)

for text := range textChannel {

llmResponse += text + " "

if model.chunkCounter > contextThreshold {

err = logViolations(ctx, llmResponse, model.userPrompt)

if err != nil {

// Handle error

}

}

}

}

SSS

Guardrails API'si için kota sınırlarıma ulaştıysam ne yapmalıyım?

Kota artışı isteğinde bulunmak için isteğinizi içeren bir e-postayı checks-support@google.com adresine gönderin. E-postanıza aşağıdaki bilgileri ekleyin:

- Google Cloud proje numaranız: Bu, hesabınızı hızlı bir şekilde tanımlamamıza yardımcı olur.

- Kullanım alanınızla ilgili ayrıntılar: Guardrails API'yi nasıl kullandığınızı açıklayın.

- İstenen kota miktarı: Ne kadar ek kotaya ihtiyacınız olduğunu belirtin.