Bir modeli eğitmek için modelin kaybını azaltacak iyi bir yola ihtiyacımız var. Yinelemeli yaklaşım, kaybı azaltmak için yaygın olarak kullanılan bir yöntemdir ve tepeden inmek kadar kolay ve verimlidir.

Kayıpyı Azaltma

Kaybı nasıl azaltabiliriz?

- Hiperparametreler, modelin eğitim şeklini ayarlamak için kullanılan yapılandırma ayarlarıdır.

- Ağırlıklar ve önyargılara göre (y - y')2 ifadesinin türevi, belirli bir örnekte kaybın nasıl değiştiğini bize bildirir

- Hesaplanması ve dışbükey olması basittir

- Bu yüzden her defasında en az kayıp yaşayacak şekilde

- Bunlara Gradyan Adımları diyoruz (Ancak aslında negatif Gradyan Adımlarıdır).

- Bu stratejiye Gradyan İniş adı verilir

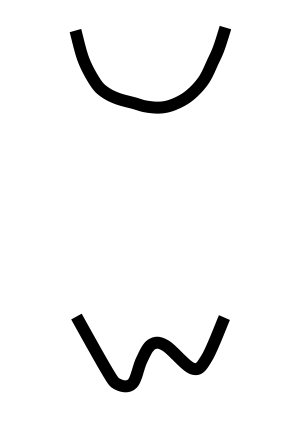

Gradyan İniş Blok Diyagramı

- Gradyan İniş Alıştırması'nı deneyin

- Egzersizi bitirdiğinizde devam etmek için oynat ▶ tuşuna basın

Ağırlık Başlatma

- Dışbükey problemlerde ağırlıklar herhangi bir yerden başlayabilir (örneğin, tüm 0 değerleri)

- Dönş.: Bir kase şeklini düşünün

- Yalnızca bir minimum

Ağırlık Başlatma

- Dışbükey problemlerde ağırlıklar herhangi bir yerden başlayabilir (örneğin, tüm 0 değerleri)

- Dönş.: Bir kase şeklini düşünün

- Yalnızca bir minimum

- Ön gölgelendirme: Sinir ağları için doğru değildir

- Dışbükey olmayan: Yumurta kasasını düşünün

- Minimum birden fazla

- İlk değerlere büyük bağımlılık

SGD ve Mini Toplu Gradyan İniş

- Her adımda veri kümesinin tamamında gradyan hesaplanabilir, ancak bu gereksizdir

- Küçük veri örneklerinde gradyan hesaplamak iyi sonuç veriyor

- Her adımda yeni bir rastgele örnek alın

- Olasılıksal Gradyan İniş: Tek seferde bir örnek

- Mini Toplu Gradyan İniş: 10-1.000'lik gruplar

- Kayıp ve gradyanların ortalaması toplu olarak alınır