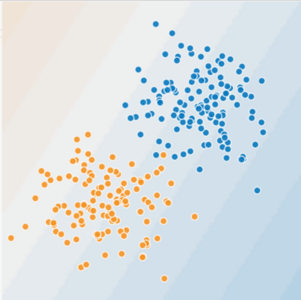

در شکل 1 و 2 موارد زیر را تصور کنید:

- نقاط آبی نشان دهنده درختان بیمار هستند.

- نقاط نارنجی نشان دهنده درختان سالم هستند.

شکل 1. آیا این یک مسئله خطی است؟

آیا می توانید خطی بکشید که درختان بیمار را از درختان سالم جدا کند؟ مطمئن. این یک مشکل خطی است. خط کامل نخواهد بود یک یا دو درخت بیمار ممکن است در سمت "سالم" باشند، اما خط شما پیش بینی خوبی خواهد بود.

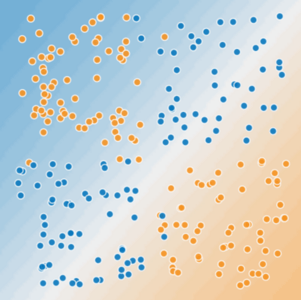

حالا به شکل زیر نگاه کنید:

شکل 2. آیا این یک مسئله خطی است؟

آیا می توانید یک خط مستقیم بکشید که درختان بیمار را از درختان سالم جدا کند؟ نه، شما نمی توانید. این یک مسئله غیر خطی است. هر خطی که بکشید پیش بینی ضعیفی از سلامت درخت خواهد بود.

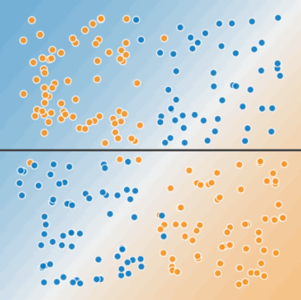

شکل 3. یک خط نمی تواند دو کلاس را از هم جدا کند.

برای حل مسئله غیرخطی نشان داده شده در شکل 2، یک متقاطع ویژگی ایجاد کنید. تلاقی ویژگی یک ویژگی مصنوعی است که با ضرب دو یا چند ویژگی ورودی در یکدیگر، غیرخطی بودن فضای ویژگی را رمزگذاری می کند. (اصطلاح متقاطع از محصول متقاطع می آید.) بیایید با عبور از \(x_1\)و \(x_2\)یک متقاطع ویژگی به نام \(x_3\) ایجاد کنیم:

ما با این متقاطع ویژگی \(x_3\) که به تازگی ساخته شده است، مانند هر ویژگی دیگری رفتار می کنیم. فرمول خطی تبدیل می شود:

یک الگوریتم خطی می تواند وزن \(w_3\)را همانطور که برای \(w_1\) و \(w_2\)یاد می گیرد، بیاموزد. به عبارت دیگر، اگرچه \(w_3\) اطلاعات غیرخطی را رمزگذاری می کند، شما نیازی به تغییر نحوه آموزش مدل خطی برای تعیین مقدار \(w_3\)ندارید.

انواع صلیب های ویژگی

ما می توانیم انواع مختلفی از ضربدرهای ویژگی ایجاد کنیم. مثلا:

-

[AXB]: تلاقی ویژگی که از ضرب مقادیر دو ویژگی تشکیل می شود. -

[A x B x C x D x E]: تلاقی مشخصه ای که از ضرب مقادیر پنج ویژگی تشکیل می شود. -

[A x A]: متقاطع مشخصه ای که از مربع کردن یک مشخصه تشکیل می شود.

به لطف نزول گرادیان تصادفی ، مدل های خطی را می توان به طور موثر آموزش داد. در نتیجه، تکمیل مدلهای خطی مقیاسشده با تلاقی ویژگیها به طور سنتی راهی کارآمد برای آموزش بر روی مجموعههای داده در مقیاس عظیم بوده است.