Explorar en Dialogflow

Haz clic en Continuar para importar nuestra muestra de respuestas en Dialogflow. Luego, sigue los pasos que se indican a continuación para implementar y probar la muestra:

- Ingresa un nombre de agente y crea un agente de Dialogflow nuevo para la muestra.

- Una vez que el agente termine de importar, haz clic en Ir al agente (Go to agent).

- En el menú de navegación principal, ve a Entrega.

- Habilita el Editor intercalado y, luego, haz clic en Implementar. El editor contiene el código de muestra.

- En el menú de navegación principal, ve a Integraciones y, luego, haz clic en Asistente de Google.

- En la ventana modal que aparece, habilita Auto-preview changes y haz clic en Test para abrir el simulador de Actions.

- En el simulador, ingresa

Talk to my test apppara probar la muestra.

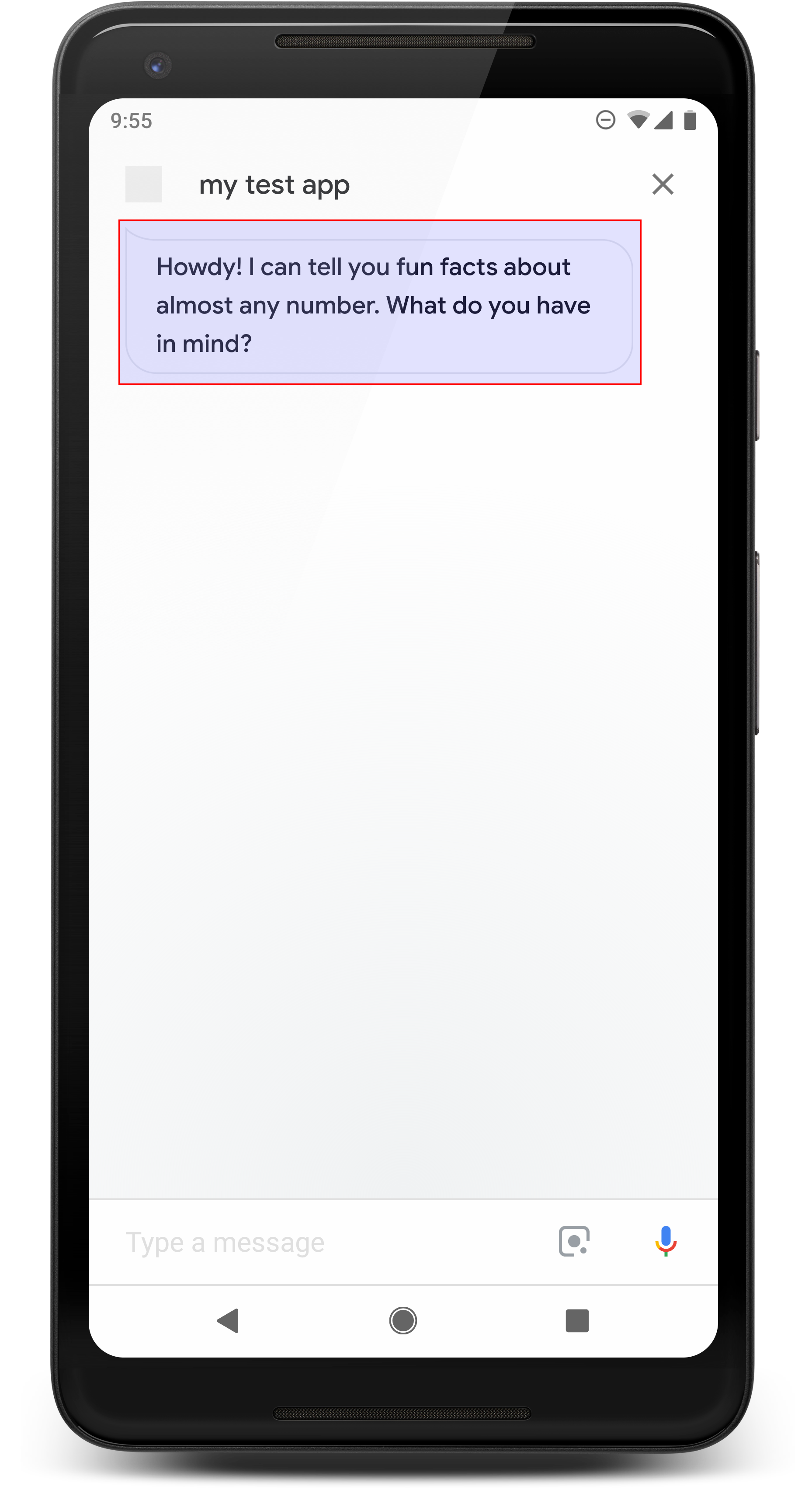

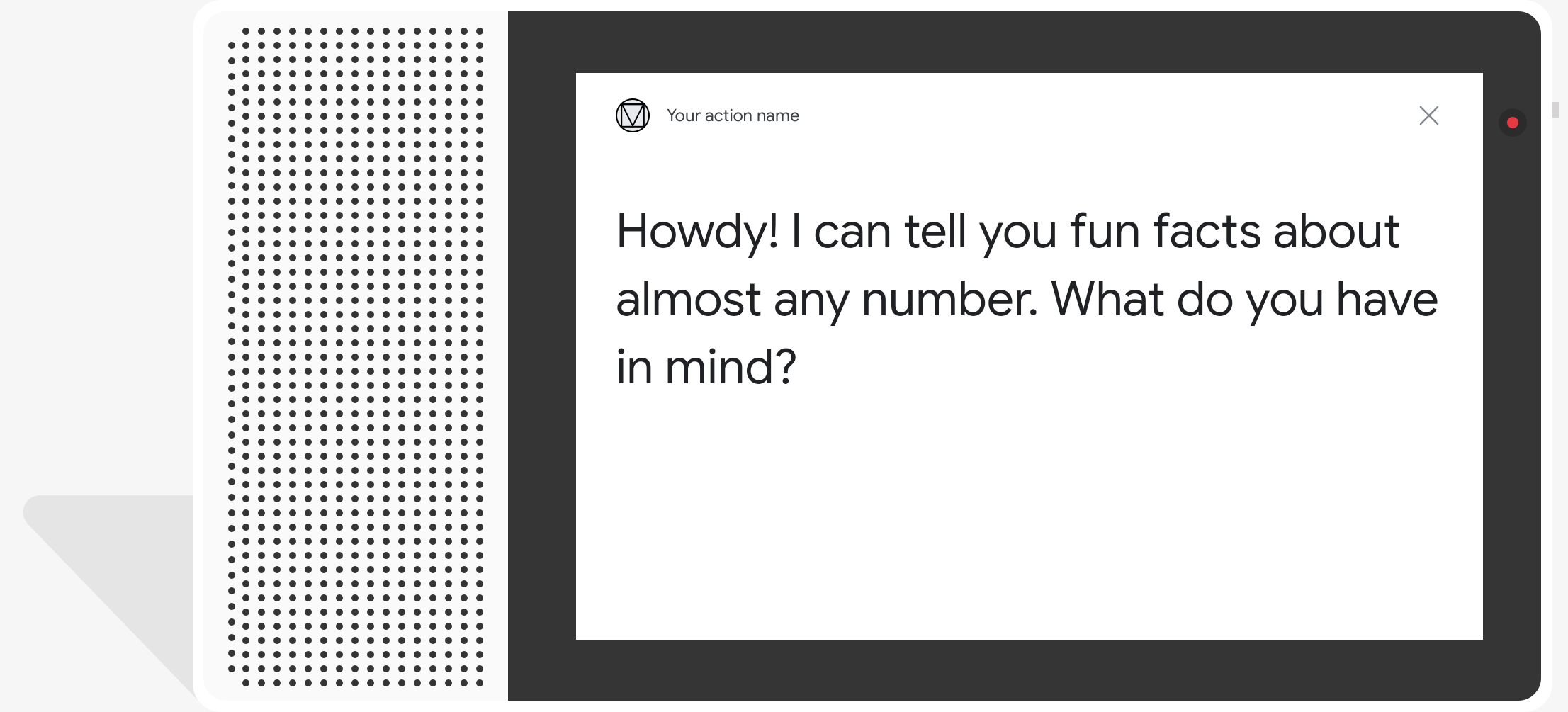

Las respuestas simples toman la forma de una burbuja de chat visualmente y usan texto a voz (TTS) o lenguaje de marcación de síntesis de voz (SSML) para el sonido.

De forma predeterminada, el texto de TTS se usa como contenido de burbujas de chat. Si el aspecto visual de ese texto satisface tus necesidades, no necesitarás especificar ningún texto de visualización para una burbuja de chat.

También puedes revisar nuestros lineamientos de diseño de conversación para aprender a incorporar estos elementos visuales en tu acción.

Propiedades

Las respuestas simples tienen los siguientes requisitos y propiedades opcionales que puedes configurar:

- Compatible en plataformas con las capacidades

actions.capability.AUDIO_OUTPUToactions.capability.SCREEN_OUTPUT. Límite de 640 caracteres por cuadro de chat. Las strings que superen el límite se truncarán en el primer salto de palabra (o espacio en blanco) antes de los 640 caracteres.

El contenido del cuadro de chat debe ser un subconjunto fonético o una transcripción completa del resultado de TTS/SSML. Esto ayuda a los usuarios a trazar un mapa de lo que estás diciendo y aumenta la comprensión en diversas condiciones.

Dos burbujas de chat por turno como máximo.

La cabeza de chat (logotipo) que envíes a Google debe tener 192 x 192 píxeles y no puede ser animada.

Código de muestra

Node.js

app.intent('Simple Response', (conv) => {

conv.ask(new SimpleResponse({

speech: `Here's an example of a simple response. ` +

`Which type of response would you like to see next?`,

text: `Here's a simple response. ` +

`Which response would you like to see next?`,

}));

});

Java

@ForIntent("Simple Response")

public ActionResponse welcome(ActionRequest request) {

ResponseBuilder responseBuilder = getResponseBuilder(request);

responseBuilder.add(

new SimpleResponse()

.setTextToSpeech(

"Here's an example of a simple response. "

+ "Which type of response would you like to see next?")

.setDisplayText(

"Here's a simple response. Which response would you like to see next?"));

return responseBuilder.build();

}

Node.js

conv.ask(new SimpleResponse({

speech: `Here's an example of a simple response. ` +

`Which type of response would you like to see next?`,

text: `Here's a simple response. ` +

`Which response would you like to see next?`,

}));

Java

ResponseBuilder responseBuilder = getResponseBuilder(request);

responseBuilder.add(

new SimpleResponse()

.setTextToSpeech(

"Here's an example of a simple response. "

+ "Which type of response would you like to see next?")

.setDisplayText(

"Here's a simple response. Which response would you like to see next?"));

return responseBuilder.build();

JSON

Ten en cuenta que el siguiente JSON describe una respuesta de webhook.

{

"payload": {

"google": {

"expectUserResponse": true,

"richResponse": {

"items": [

{

"simpleResponse": {

"textToSpeech": "Here's an example of a simple response. Which type of response would you like to see next?",

"displayText": "Here's a simple response. Which response would you like to see next?"

}

}

]

}

}

}

}

JSON

Ten en cuenta que el siguiente JSON describe una respuesta de webhook.

{

"expectUserResponse": true,

"expectedInputs": [

{

"possibleIntents": [

{

"intent": "actions.intent.TEXT"

}

],

"inputPrompt": {

"richInitialPrompt": {

"items": [

{

"simpleResponse": {

"textToSpeech": "Here's an example of a simple response. Which type of response would you like to see next?",

"displayText": "Here's a simple response. Which response would you like to see next?"

}

}

]

}

}

}

]

}

SSML y sonidos

El uso de SSML y sonidos en tus respuestas les brinda más detalles y mejora la experiencia del usuario. En los siguientes fragmentos de código, se muestra cómo crear una respuesta que use SSML:

Node.js

app.intent('SSML', (conv) => {

conv.ask(`<speak>` +

`Here are <say-as interpet-as="characters">SSML</say-as> examples.` +

`Here is a buzzing fly ` +

`<audio src="https://actions.google.com/sounds/v1/animals/buzzing_fly.ogg"></audio>` +

`and here's a short pause <break time="800ms"/>` +

`</speak>`);

conv.ask('Which response would you like to see next?');

});

Java

@ForIntent("SSML")

public ActionResponse ssml(ActionRequest request) {

ResponseBuilder responseBuilder = getResponseBuilder(request);

responseBuilder.add(

"<speak>"

+ "Here are <say-as interpet-as=\"characters\">SSML</say-as> examples."

+ "Here is a buzzing fly "

+ "<audio src=\"https://actions.google.com/sounds/v1/animals/buzzing_fly.ogg\"></audio>"

+ "and here's a short pause <break time=\"800ms\"/>"

+ "</speak>");

return responseBuilder.build();

}

Node.js

conv.ask(`<speak>` +

`Here are <say-as interpet-as="characters">SSML</say-as> examples.` +

`Here is a buzzing fly ` +

`<audio src="https://actions.google.com/sounds/v1/animals/buzzing_fly.ogg"></audio>` +

`and here's a short pause <break time="800ms"/>` +

`</speak>`);

conv.ask('Which response would you like to see next?');

Java

ResponseBuilder responseBuilder = getResponseBuilder(request);

responseBuilder.add(

"<speak>"

+ "Here are <say-as interpet-as=\"characters\">SSML</say-as> examples."

+ "Here is a buzzing fly "

+ "<audio src=\"https://actions.google.com/sounds/v1/animals/buzzing_fly.ogg\"></audio>"

+ "and here's a short pause <break time=\"800ms\"/>"

+ "</speak>");

return responseBuilder.build();

JSON

Ten en cuenta que el siguiente JSON describe una respuesta de webhook.

{

"payload": {

"google": {

"expectUserResponse": true,

"richResponse": {

"items": [

{

"simpleResponse": {

"textToSpeech": "<speak>Here are <say-as interpet-as=\"characters\">SSML</say-as> examples.Here is a buzzing fly <audio src=\"https://actions.google.com/sounds/v1/animals/buzzing_fly.ogg\"></audio>and here's a short pause <break time=\"800ms\"/></speak>"

}

},

{

"simpleResponse": {

"textToSpeech": "Which response would you like to see next?"

}

}

]

}

}

}

}

JSON

Ten en cuenta que el siguiente JSON describe una respuesta de webhook.

{

"expectUserResponse": true,

"expectedInputs": [

{

"possibleIntents": [

{

"intent": "actions.intent.TEXT"

}

],

"inputPrompt": {

"richInitialPrompt": {

"items": [

{

"simpleResponse": {

"textToSpeech": "<speak>Here are <say-as interpet-as=\"characters\">SSML</say-as> examples.Here is a buzzing fly <audio src=\"https://actions.google.com/sounds/v1/animals/buzzing_fly.ogg\"></audio>and here's a short pause <break time=\"800ms\"/></speak>"

}

},

{

"simpleResponse": {

"textToSpeech": "Which response would you like to see next?"

}

}

]

}

}

}

]

}

Consulta la documentación de referencia de SSML para obtener más información.

Biblioteca de sonido

Ofrecemos una variedad de sonidos cortos y gratuitos en nuestra biblioteca de sonidos. Estos sonidos se alojan automáticamente, por lo que solo debes incluirlos en el SSML.